Werden wir Militärrobotern eine Lizenz zum Töten geben?

Wenn sich KI-Kriegsroboter verbessern, ändert sich das Wesen des Krieges

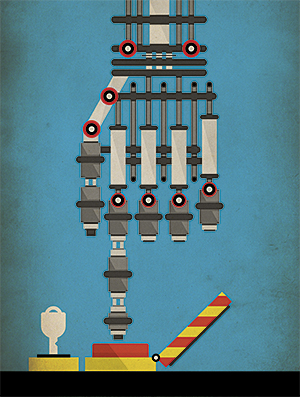

1920 schrieb der tschechische Schriftsteller Karel Čapek das Stück RUR (Rossums Universalroboter, „Rossum Universalroboter“), in dem er der Welt das Wort „Roboter“ gab. In seinem Stück beginnt alles mit künstlichen Menschen - Robotern, die in Fabriken arbeiten und preiswerte Waren herstellen. Und alles endet damit, dass Roboter die Menschheit zerstören. So wurde die langlebige Verschwörung der NF geboren: Roboter geraten außer Kontrolle und verwandeln sich in unaufhaltsame Tötungsmaschinen. Literatur und Kino des 20. Jahrhunderts liefern uns weiterhin Beispiele für Roboter, die die Welt zerstören, und Hollywood verwandelt sie ständig in Blockbuster-Franchises: The Matrix, Transformers und Terminator.In jüngster Zeit wird die Angst, Fiktion in die Realität umzusetzen, durch eine Kombination von Umständen gestützt, darunter Verbesserungen in der KI und in der Robotik, deren VerbreitungMilitärdrohnen und Bodenroboter im Irak und in Afghanistan. Die größten Mächte entwickeln intelligente Waffen mit unterschiedlichem Maß an Autonomie und Sterblichkeit. Die meisten von ihnen werden bald von Personen ferngesteuert, ohne deren Befehl der Roboter den Abzug nicht betätigen kann. Aber höchstwahrscheinlich - und einigen zufolge werden die Roboter, auch ohne Zweifel, irgendwann völlig autonom arbeiten können, und der Rubicon wird in militärischen Angelegenheiten eingeschaltet sein: Zum ersten Mal wird eine Reihe von Mikrochips und Software entscheiden, ob eine Person lebt oder stirbt.Es überrascht nicht, dass die Bedrohung durch Killerroboter, wie sie sie liebevoll nannten, zu einer leidenschaftlichen Debatte führte. Auf der anderen Seite des Streits stehen diejenigen, die befürchten, dass automatische Waffen einen allgemeinen Krieg auslösen und die Zivilisation zerstören, und diejenigen, die behaupten, dass neue Waffen nur eine weitere Klasse präzisionsgelenkter Waffen sind, die die Zahl der Opfer eher verringern als erhöhen. Im Dezember werden mehr als hundert Länder dieses Thema auf dem NATO-Abrüstungstreffen in Genf erörtern.

1920 schrieb der tschechische Schriftsteller Karel Čapek das Stück RUR (Rossums Universalroboter, „Rossum Universalroboter“), in dem er der Welt das Wort „Roboter“ gab. In seinem Stück beginnt alles mit künstlichen Menschen - Robotern, die in Fabriken arbeiten und preiswerte Waren herstellen. Und alles endet damit, dass Roboter die Menschheit zerstören. So wurde die langlebige Verschwörung der NF geboren: Roboter geraten außer Kontrolle und verwandeln sich in unaufhaltsame Tötungsmaschinen. Literatur und Kino des 20. Jahrhunderts liefern uns weiterhin Beispiele für Roboter, die die Welt zerstören, und Hollywood verwandelt sie ständig in Blockbuster-Franchises: The Matrix, Transformers und Terminator.In jüngster Zeit wird die Angst, Fiktion in die Realität umzusetzen, durch eine Kombination von Umständen gestützt, darunter Verbesserungen in der KI und in der Robotik, deren VerbreitungMilitärdrohnen und Bodenroboter im Irak und in Afghanistan. Die größten Mächte entwickeln intelligente Waffen mit unterschiedlichem Maß an Autonomie und Sterblichkeit. Die meisten von ihnen werden bald von Personen ferngesteuert, ohne deren Befehl der Roboter den Abzug nicht betätigen kann. Aber höchstwahrscheinlich - und einigen zufolge werden die Roboter, auch ohne Zweifel, irgendwann völlig autonom arbeiten können, und der Rubicon wird in militärischen Angelegenheiten eingeschaltet sein: Zum ersten Mal wird eine Reihe von Mikrochips und Software entscheiden, ob eine Person lebt oder stirbt.Es überrascht nicht, dass die Bedrohung durch Killerroboter, wie sie sie liebevoll nannten, zu einer leidenschaftlichen Debatte führte. Auf der anderen Seite des Streits stehen diejenigen, die befürchten, dass automatische Waffen einen allgemeinen Krieg auslösen und die Zivilisation zerstören, und diejenigen, die behaupten, dass neue Waffen nur eine weitere Klasse präzisionsgelenkter Waffen sind, die die Zahl der Opfer eher verringern als erhöhen. Im Dezember werden mehr als hundert Länder dieses Thema auf dem NATO-Abrüstungstreffen in Genf erörtern. Eine vom Menschen kontrollierte Drohne

Eine vom Menschen kontrollierte Drohne Eine Phalanx-Waffe, die in der Lage ist, unabhängig zu schießen. Imvergangenen Jahr kam eine solche Diskussion in die Nachrichten, als eine Gruppe führender KI-Forscher ein Verbot von "autonomen Offensivwaffen forderte, die ohne sinnvolle menschliche Kontrolle funktionieren". In einem offenen Brief an eine internationale Konferenz über KI stellte eine Gruppe von Forschern fest, dass solche Waffen zu einem internationalen Wettrüsten der KI führen und für Auftragsmorde, Destabilisierung von Nationen, Unterdrückung von Völkern und selektive Zerstörung ethnischer Gruppen eingesetzt werden könnten.Der Brief wurde von mehr als 20.000 Menschen unterzeichnet, darunter so berühmte Persönlichkeiten wie der Physiker Stephen Hawking und der Unternehmer Ilon Musk. Letzterer spendete dem Boston Institute im vergangenen Jahr 10 Millionen US-Dollar., engagiert sich für den Schutz des Lebens von Menschen vor der hypothetischen Bedrohung durch eine unfreundliche KI. Die Wissenschaftler, die das Schreiben organisierten - Stuart Russell von der University of California in Berkeley, Max Tegmark vom MIT und Toby Walsh von der University of New South Wales in Australien - erweiterten ihre Position in einem Artikel für IEEE Spectrum. In einem Szenario kann beispielsweise „eine große Anzahl kostengünstiger Mikroroboter, die von einer Person auf den Schwarzmarkt gebracht werden können, getötet werden, und Tausende oder Millionen von Menschen, die den Kriterien des Benutzers entsprechen, können töten“.Sie fügten hinzu, dass „autonome Waffen zu Massenvernichtungswaffen werden können. "Einige Länder verbieten möglicherweise seine Verwendung, während andere Länder und natürlich Terroristen es unwahrscheinlich sind, dass sie es aufgeben können."Es kann kaum gesagt werden, dass ein neues Wettrüsten, das zu intelligenten, autonomen und mobilen Tötungsmaschinen führen kann, dem Nutzen der gesamten Menschheit dienen wird. Dieses Rennen hat jedoch bereits begonnen.Autonome Waffen existieren seit mehreren Jahrzehnten, obwohl ihre seltenen Exemplare bisher hauptsächlich zur Verteidigung eingesetzt wurden. Ein Beispiel ist die Phalanx , eine computergesteuerte Waffe, die vom Radar gesteuert und auf Kriegsschiffen der US-Marine montiert wird. Sie kann die sich nähernden Raketen und Flugzeuge, die sie als Bedrohung betrachtet, automatisch erkennen, verfolgen, bewerten und abschießen. In einem vollständig autonomen Modus ist eine Beteiligung des Menschen überhaupt nicht erforderlich.Harop-Drohne zerstört ZielDoDAAM Systems demonstriert die Fähigkeiten der Super aEgis II-Roboteruhr.Vor kurzem haben Militärentwickler begonnen, offensive autonome Roboter zu entwickeln. Die Firma Israel Aerospace Industries hat Drohnen Harpyie hergestellt und Harop, was dazu führt, Radiowellen der feindlichen Luftabwehrsysteme, und sie durch die Kollision töten. Das Unternehmen behauptet, dass sich seine UAVs weltweit gut verkaufen.Das südkoreanische Unternehmen DoDAAM Systems hat die Super aEgis II Roboteruhr entwickelt. Er schießt mit einem Maschinengewehr und verwendet Computer Vision, um Ziele (Personen) in einer Entfernung von 3 km zu erkennen und zu schießen. Es wird vermutet, dass das südkoreanische Militär Tests dieser Roboter in der entmilitarisierten Zone an der Grenze zu Nordkorea durchgeführt hat. DoDAAM schonverkaufte 30 solcher Geräte an andere Länder, darunter mehrere Kunden aus dem Nahen Osten.Heutzutage gibt es nur wenige Systeme mit einem hohen Maß an Autonomie im Vergleich zu Roboterwaffen, die fast immer von Menschen gesteuert werden, insbesondere während des Schießens. Analysten sagen voraus, dass Waffen mit der Entwicklung militärischer Angelegenheiten immer autonomere Fähigkeiten haben werden."Der Krieg wird völlig anders sein und die Automatisierung wird eine Rolle spielen, wenn es auf Geschwindigkeit ankommt", sagte Peter Singer, ein Experte für Militärroboter bei der in Washington ansässigen unpolitischen Gruppe New America. Er wird lesen, dass in zukünftigen Schlachten - wie in Schlachten zwischen verschiedenen UAVs oder wenn ein automatisches Schiff auf ein automatisches U-Boot trifft - eine Waffe, die einen Bruchteil eines zweiten Vorteils hat, über den Ausgang des Kampfes entscheidet. "Es kann einen plötzlichen und intensiven Konflikt geben, in dem es einfach keine Zeit gibt, die Leute auf den neuesten Stand zu bringen, weil alles in Sekundenschnelle entschieden wird."Das US-Militär hat seine langfristigen Pläne für eine neue Art von Krieg mit unbemannten Systemen beschrieben, aber ob sie beabsichtigen, diese Systeme zu bewaffnen, ist noch unbekannt. EinAuf dem Forum der Washington Post im März wies US-Verteidigungsminister Robert Work, dessen Aufgabe es ist, sicherzustellen, dass das Pentagon mit der neuesten Technologie Schritt hält, auf die Notwendigkeit von Investitionen in KI und Roboter hin. Ihm zufolge ist die zunehmende Präsenz autonomer Systeme auf dem Schlachtfeld "unvermeidlich".In Bezug auf autonome Waffen besteht Work darauf, dass das US-Militär "der Maschine nicht die Macht geben wird, fatale Entscheidungen zu treffen". Er selbst fügte jedoch hinzu: „Wenn ein Gegner bereit zu sein scheint, solche Befugnisse zu übertragen, müssen wir mit ihm Entscheidungen über die Frage des Wettbewerbs treffen. Wir haben es noch nicht vollständig herausgefunden, aber wir denken viel darüber nach. “Wladimir Putin beobachtet während der Demonstration im letzten Jahr einen militärischen Cyborg auf einem ATVDer Erstflug des CH-5 UAV des chinesischen Unternehmens China Aerospace Science and Technology Corporation,Russland und China verfolgt eine ähnliche Strategie bei der Entwicklung unbemannter Kampfsysteme für Operationen an Land, auf See und in der Luft, die, obwohl bewaffnet, immer noch von lebenden Betreibern abhängen. Russian Platform-M ist ein kleiner Roboter mit Fernbedienung, der mit einem Kalaschnikow-Sturmgewehr und einem Granatwerfer ausgestattet ist. Es ähnelt dem US Talon SWORDS- System , einem bodengestützten Roboter, der M16 und andere im Irak getestete Waffen tragen kann. Russland baute auch ein unbemanntes Fahrzeug Uranus-9, das mit einer 30-mm-Kanone und Panzerabwehrraketen bewaffnet war. Und letztes Jahr haben die Russen Putin einen militärischen humanoiden Roboter vorgeführt.Chinas wachsendes Arsenal an Militärrobotern umfasst viele Drohnen für Angriffe und Aufklärung. CH-4 - UAV lang wirkend, erinnert an den US Predator. Divine Eagle - eine hochgelegene Drohne für die Jagd auf Stealth-Bomber. Darüber hinaus wurden Roboter mit Maschinengewehren ähnlich Platform-M und Talon SWORDS bei verschiedenen militärischen Präsentationen in China gezeigt.Diese drei Länder nähern sich der Schaffung bewaffneter Roboter und betonen mit zunehmender Autonomie gleichzeitig die Wahrung der Rolle der Menschen in ihrer Arbeit. Für das Verbot autonomer Waffen wird ein ernstes Problem auftreten: Es wird nicht unbedingt auf nahezu autonome Waffen anwendbar sein. Das Militär kann immer verdeckt bewaffnete Roboter entwickeln, die von Menschen gesteuert werden, aber auf Knopfdruck in den Offline-Modus wechseln. „Für Roboter wird es sehr schwierig sein, eine Rüstungsbeschränkungsvereinbarung aufzuerlegen“, schließt Wendell Wallach, Ethik- und Technologieexperte an der Yale University. "Der Unterschied zwischen autonomen und nicht autonomen Waffen kann nur eine Codezeile sein", sagte er auf einer Konferenz.In Filmen werden Roboter manchmal überraschend autonom, bis sie fast von Grund auf bewusst werden, was die Menschen überrascht . In der realen Welt gewinnen Roboter trotz der allgemeinen Aufregung über den Fortschritt des maschinellen Lernens allmählich Autonomie. Das gleiche kann von autonomen Waffen erwartet werden.

Eine Phalanx-Waffe, die in der Lage ist, unabhängig zu schießen. Imvergangenen Jahr kam eine solche Diskussion in die Nachrichten, als eine Gruppe führender KI-Forscher ein Verbot von "autonomen Offensivwaffen forderte, die ohne sinnvolle menschliche Kontrolle funktionieren". In einem offenen Brief an eine internationale Konferenz über KI stellte eine Gruppe von Forschern fest, dass solche Waffen zu einem internationalen Wettrüsten der KI führen und für Auftragsmorde, Destabilisierung von Nationen, Unterdrückung von Völkern und selektive Zerstörung ethnischer Gruppen eingesetzt werden könnten.Der Brief wurde von mehr als 20.000 Menschen unterzeichnet, darunter so berühmte Persönlichkeiten wie der Physiker Stephen Hawking und der Unternehmer Ilon Musk. Letzterer spendete dem Boston Institute im vergangenen Jahr 10 Millionen US-Dollar., engagiert sich für den Schutz des Lebens von Menschen vor der hypothetischen Bedrohung durch eine unfreundliche KI. Die Wissenschaftler, die das Schreiben organisierten - Stuart Russell von der University of California in Berkeley, Max Tegmark vom MIT und Toby Walsh von der University of New South Wales in Australien - erweiterten ihre Position in einem Artikel für IEEE Spectrum. In einem Szenario kann beispielsweise „eine große Anzahl kostengünstiger Mikroroboter, die von einer Person auf den Schwarzmarkt gebracht werden können, getötet werden, und Tausende oder Millionen von Menschen, die den Kriterien des Benutzers entsprechen, können töten“.Sie fügten hinzu, dass „autonome Waffen zu Massenvernichtungswaffen werden können. "Einige Länder verbieten möglicherweise seine Verwendung, während andere Länder und natürlich Terroristen es unwahrscheinlich sind, dass sie es aufgeben können."Es kann kaum gesagt werden, dass ein neues Wettrüsten, das zu intelligenten, autonomen und mobilen Tötungsmaschinen führen kann, dem Nutzen der gesamten Menschheit dienen wird. Dieses Rennen hat jedoch bereits begonnen.Autonome Waffen existieren seit mehreren Jahrzehnten, obwohl ihre seltenen Exemplare bisher hauptsächlich zur Verteidigung eingesetzt wurden. Ein Beispiel ist die Phalanx , eine computergesteuerte Waffe, die vom Radar gesteuert und auf Kriegsschiffen der US-Marine montiert wird. Sie kann die sich nähernden Raketen und Flugzeuge, die sie als Bedrohung betrachtet, automatisch erkennen, verfolgen, bewerten und abschießen. In einem vollständig autonomen Modus ist eine Beteiligung des Menschen überhaupt nicht erforderlich.Harop-Drohne zerstört ZielDoDAAM Systems demonstriert die Fähigkeiten der Super aEgis II-Roboteruhr.Vor kurzem haben Militärentwickler begonnen, offensive autonome Roboter zu entwickeln. Die Firma Israel Aerospace Industries hat Drohnen Harpyie hergestellt und Harop, was dazu führt, Radiowellen der feindlichen Luftabwehrsysteme, und sie durch die Kollision töten. Das Unternehmen behauptet, dass sich seine UAVs weltweit gut verkaufen.Das südkoreanische Unternehmen DoDAAM Systems hat die Super aEgis II Roboteruhr entwickelt. Er schießt mit einem Maschinengewehr und verwendet Computer Vision, um Ziele (Personen) in einer Entfernung von 3 km zu erkennen und zu schießen. Es wird vermutet, dass das südkoreanische Militär Tests dieser Roboter in der entmilitarisierten Zone an der Grenze zu Nordkorea durchgeführt hat. DoDAAM schonverkaufte 30 solcher Geräte an andere Länder, darunter mehrere Kunden aus dem Nahen Osten.Heutzutage gibt es nur wenige Systeme mit einem hohen Maß an Autonomie im Vergleich zu Roboterwaffen, die fast immer von Menschen gesteuert werden, insbesondere während des Schießens. Analysten sagen voraus, dass Waffen mit der Entwicklung militärischer Angelegenheiten immer autonomere Fähigkeiten haben werden."Der Krieg wird völlig anders sein und die Automatisierung wird eine Rolle spielen, wenn es auf Geschwindigkeit ankommt", sagte Peter Singer, ein Experte für Militärroboter bei der in Washington ansässigen unpolitischen Gruppe New America. Er wird lesen, dass in zukünftigen Schlachten - wie in Schlachten zwischen verschiedenen UAVs oder wenn ein automatisches Schiff auf ein automatisches U-Boot trifft - eine Waffe, die einen Bruchteil eines zweiten Vorteils hat, über den Ausgang des Kampfes entscheidet. "Es kann einen plötzlichen und intensiven Konflikt geben, in dem es einfach keine Zeit gibt, die Leute auf den neuesten Stand zu bringen, weil alles in Sekundenschnelle entschieden wird."Das US-Militär hat seine langfristigen Pläne für eine neue Art von Krieg mit unbemannten Systemen beschrieben, aber ob sie beabsichtigen, diese Systeme zu bewaffnen, ist noch unbekannt. EinAuf dem Forum der Washington Post im März wies US-Verteidigungsminister Robert Work, dessen Aufgabe es ist, sicherzustellen, dass das Pentagon mit der neuesten Technologie Schritt hält, auf die Notwendigkeit von Investitionen in KI und Roboter hin. Ihm zufolge ist die zunehmende Präsenz autonomer Systeme auf dem Schlachtfeld "unvermeidlich".In Bezug auf autonome Waffen besteht Work darauf, dass das US-Militär "der Maschine nicht die Macht geben wird, fatale Entscheidungen zu treffen". Er selbst fügte jedoch hinzu: „Wenn ein Gegner bereit zu sein scheint, solche Befugnisse zu übertragen, müssen wir mit ihm Entscheidungen über die Frage des Wettbewerbs treffen. Wir haben es noch nicht vollständig herausgefunden, aber wir denken viel darüber nach. “Wladimir Putin beobachtet während der Demonstration im letzten Jahr einen militärischen Cyborg auf einem ATVDer Erstflug des CH-5 UAV des chinesischen Unternehmens China Aerospace Science and Technology Corporation,Russland und China verfolgt eine ähnliche Strategie bei der Entwicklung unbemannter Kampfsysteme für Operationen an Land, auf See und in der Luft, die, obwohl bewaffnet, immer noch von lebenden Betreibern abhängen. Russian Platform-M ist ein kleiner Roboter mit Fernbedienung, der mit einem Kalaschnikow-Sturmgewehr und einem Granatwerfer ausgestattet ist. Es ähnelt dem US Talon SWORDS- System , einem bodengestützten Roboter, der M16 und andere im Irak getestete Waffen tragen kann. Russland baute auch ein unbemanntes Fahrzeug Uranus-9, das mit einer 30-mm-Kanone und Panzerabwehrraketen bewaffnet war. Und letztes Jahr haben die Russen Putin einen militärischen humanoiden Roboter vorgeführt.Chinas wachsendes Arsenal an Militärrobotern umfasst viele Drohnen für Angriffe und Aufklärung. CH-4 - UAV lang wirkend, erinnert an den US Predator. Divine Eagle - eine hochgelegene Drohne für die Jagd auf Stealth-Bomber. Darüber hinaus wurden Roboter mit Maschinengewehren ähnlich Platform-M und Talon SWORDS bei verschiedenen militärischen Präsentationen in China gezeigt.Diese drei Länder nähern sich der Schaffung bewaffneter Roboter und betonen mit zunehmender Autonomie gleichzeitig die Wahrung der Rolle der Menschen in ihrer Arbeit. Für das Verbot autonomer Waffen wird ein ernstes Problem auftreten: Es wird nicht unbedingt auf nahezu autonome Waffen anwendbar sein. Das Militär kann immer verdeckt bewaffnete Roboter entwickeln, die von Menschen gesteuert werden, aber auf Knopfdruck in den Offline-Modus wechseln. „Für Roboter wird es sehr schwierig sein, eine Rüstungsbeschränkungsvereinbarung aufzuerlegen“, schließt Wendell Wallach, Ethik- und Technologieexperte an der Yale University. "Der Unterschied zwischen autonomen und nicht autonomen Waffen kann nur eine Codezeile sein", sagte er auf einer Konferenz.In Filmen werden Roboter manchmal überraschend autonom, bis sie fast von Grund auf bewusst werden, was die Menschen überrascht . In der realen Welt gewinnen Roboter trotz der allgemeinen Aufregung über den Fortschritt des maschinellen Lernens allmählich Autonomie. Das gleiche kann von autonomen Waffen erwartet werden.Anthologie von Killerrobotern

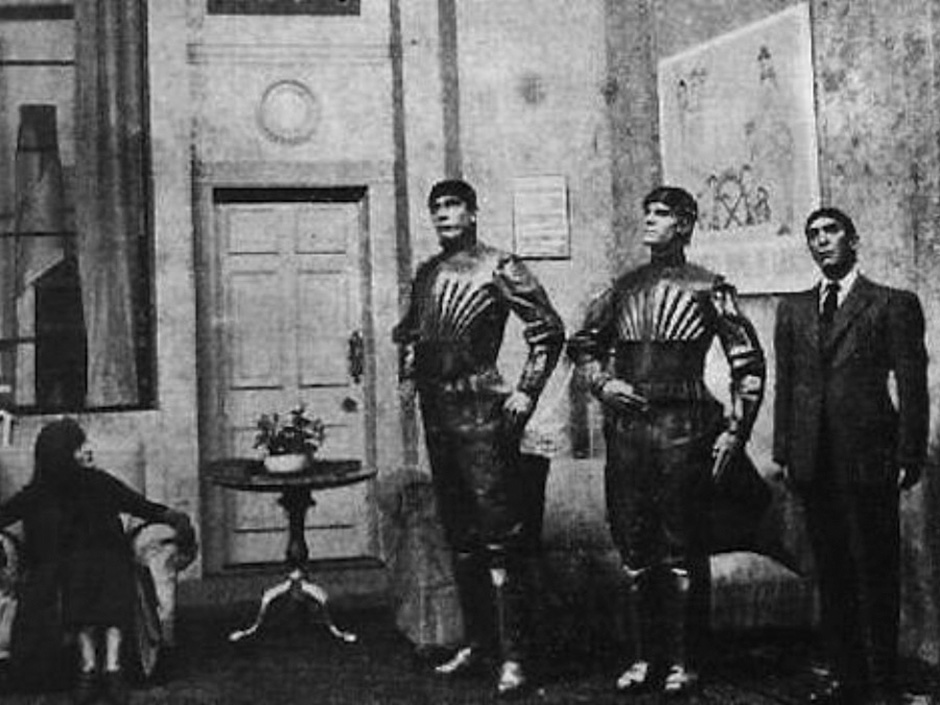

«R.U.R» 1920 – ,

«R.U.R» 1920 – , «2001: » (1968). ,

«2001: » (1968). , « » (1973).

« » (1973). « » (1982). -

« » (1982). - «» (1984). - -800

«» (1984). - -800 (1987). – , .

(1987). – , . (1999).

(1999). « » (2004). , ,

« » (2004). , , Ich, Roboter (2004). Humanoide Roboter, die die drei Gesetze der Robotik umgehen, machen in Chicago

Ich, Roboter (2004). Humanoide Roboter, die die drei Gesetze der Robotik umgehen, machen in Chicago Transformers (2007) Probleme . Eine Bande außerirdischer Roboter, angeführt von Megatron, versucht, alle Menschen zu vernichten.„Wenn Menschen von autonomen Waffen hören, repräsentieren sie oft den Terminator und sagen:„ Was haben wir getan? “, Sagt Paul Scharre, Programmmanager für zukünftige militärische Angelegenheiten in Das Zentrum der neuen amerikanischen Sicherheitsforschungsgruppe in Washington. "Aber es ist unwahrscheinlich, dass das Militär diese Art von autonomer Waffe einsetzen will." Ihm zufolge werden autonome Systeme höchstwahrscheinlich militärische Einrichtungen wie Radar, Panzer, Schiffe, U-Boote und Flugzeuge angreifen.Die Aufgabe, das Ziel zu identifizieren - festzustellen, ob ein Objekt dem Feind gehört - ist eine der kritischsten Aufgaben für die KI. Sich bewegende Ziele, Flugzeuge und Raketen haben eine Flugbahn, die verfolgt werden kann und auf deren Grundlage die Entscheidung getroffen wird, ein Objekt zum Absturz zu bringen. So funktioniert die Phalanx-Kanone auf US-Kriegsschiffen, ebenso wie das israelische Raketenabfangsystem Iron Dome. Wenn jedoch Menschen als Ziel ausgewählt werden, ist diese Identifizierung kompliziert. Selbst unter idealen Bedingungen kann die Erkennung von Objekten und Umgebungen, mit denen Menschen ständig fertig werden, für Roboter zu komplex sein.Ein Computer kann die Figur einer Person unterscheiden, selbst wenn sie sich heimlich bewegt. Für den Algorithmus ist es jedoch schwierig zu verstehen, womit Menschen beschäftigt sind und welche Absichten ihre Körpersprache und ihr Gesichtsausdruck vermitteln. Hebt ein Mann eine Waffe oder einen Rechen? Hält er eine Bombe oder ein Baby?Scarre behauptet, dass Roboterwaffen, die versuchen, ein Ziel selbst zu wählen, angesichts von Schwierigkeiten sparen. Seiner Meinung nach bleibt der beste Ansatz unter dem Gesichtspunkt der Sicherheit, Legalität und Ethik die Entwicklung solcher Taktiken und Technologien, bei denen Menschen mit Robotern zusammenarbeiten . "Das Militär kann in fortschrittliche Robotik und Automatisierung investieren, aber gleichzeitig die Person in der Kontrollkette verlassen, um Entscheidungen über Ziele zu treffen, um sicher zu sein", sagt er. „Schließlich sind die Menschen flexibler und passen sich besser an neue Situationen an, die wir möglicherweise nicht programmieren. Dies ist besonders wichtig in einem Krieg, in dem ein Gegner versucht, Ihre Systeme zu besiegen, sie auszutricksen und zu hacken. “Es überrascht nicht, dass Südkoreaner von DoDAAM ihre Uhrenroboter mit strengen Autonomieeinschränkungen herstellen. Jetzt schießen ihre Roboter erst, wenn eine Person das Ziel bestätigt und "Feuer" befiehlt. "Die ursprüngliche Version war ein automatisches Feuersystem" , sagte ein Ingenieur des Unternehmens gegenüber BBC im vergangenen Jahr . "Aber alle Kunden baten darum, Sicherheitsmaßnahmen einzubeziehen ... Sie befürchteten, dass die Waffe falsch sein könnte."Andere Experten glauben, dass der einzige Weg, um die fatalen Fehler einer autonomen Waffe, insbesondere unter Beteiligung von Zivilisten, zu vermeiden, darin besteht, geeignete Programme zu erstellen. "Wenn wir so dumm sind, dass wir uns auf dem Schlachtfeld weiterhin gegenseitig töten und wenn immer mehr Kräfte auf die Maschinen übertragen werden, können wir zumindest sicherstellen, dass sie ihre Arbeit auf ethische Weise erledigen", sagt Ronald Arkin, IT Spezialist vom Institute of Technology in Georgia.Arkin ist zuversichtlich, dass autonome Waffen wie Soldaten den Regeln der Kriegsführung und den Kriegsgesetzen, einschließlich der humanitären Völkergesetze , folgen müssenSchutz der Zivilbevölkerung und Begrenzung der Macht und der Arten zulässiger Waffen. Dies bedeutet, dass wir bestimmte moralische Eigenschaften in ihre Programme einbringen müssen, damit sie unterschiedliche Situationen verstehen und zwischen Gut und Böse unterscheiden können. Ihre Software muss einen ethischen Kompass haben.In den letzten zehn Jahren hat Arkin an einem solchen Kompass gearbeitet. Mit mathematischen und logischen Werkzeugen aus dem Bereich der Maschinenethik übersetzt er die Kriegsgesetze und die Regeln der Kriegsführung in Variablen und Operationen, die für einen Computer verständlich sind. Beispielsweise enthält eine der Variablen den Vertrauenswert der ethischen Kontrolleinheit, dass das Ziel ein Feind ist. Ein anderer, boolescher Wert, bedeutet, ob die Tötungskraft von Waffen erlaubt oder verboten ist. Am Ende kam Arkin zu einer Reihe von Algorithmen, und mithilfe von Computersimulationen und vereinfachten Kampfszenarien - zum Beispiel eines UAV, das eine Gruppe von Menschen auf freiem Feld angreift - konnte er seine Technik testen.Arkin gibt zu, dass das von den US-Streitkräften gesponserte Projekt noch nicht das Stadium des fertigen Systems erreicht hat und nur zum Nachweis seiner Funktionsfähigkeit erstellt wurde. Aber seiner Meinung nach zeigen die Ergebnisse der Arbeit, dass Roboter noch besser sind, als Menschen den Regeln des Krieges folgen können. Zum Beispiel können Roboter lebensbedrohliche Aktionen mit mehr Zurückhaltung als Menschen ausführen und nur als Reaktion darauf schießen. Oder wenn sich Zivilisten nähern, können sie im Allgemeinen das Feuer einstellen, selbst wenn sie selbst zerstört werden. Roboter leiden nicht unter Stress, Unzufriedenheit, Wut, Angst - und all dies kann die Annahme der richtigen Entscheidungen bei Menschen beeinträchtigen. Theoretisch können Roboter daher menschliche Soldaten übertreffen , die in der Hitze des Kampfes oft und manchmal unvermeidlich Fehler machen."Infolgedessen können wir Leben retten, insbesondere das Leben unschuldiger Menschen, die in einer Schlacht gefangen sind", sagt Arkin. "Und wenn Roboter dies können, deutet die Moral auf die Notwendigkeit hin, sie einzusetzen."Natürlich wird diese Ansicht nicht allgemein akzeptiert. Kritiker Autonome Waffen bestehen darauf, dass nur ein präventives Verbot Sinn macht, weil solche Waffen hinter den Kulissen erscheinen. "Es gibt kein solches Feuersystem, auf das wir hinweisen und sagen könnten: Ja, hier ist er ein Killerroboter", sagt Mary Wareham. Lobby Manager und Coor von Human Rights Watch ordinator Kampagne zum Verbot Killerroboter ( Kampagne Stop Killer - Roboter) - Koalitionen verschiedener humanitärer Gemeinschaften. - Wir sprechen über viele verschiedene Waffensysteme, die auf unterschiedliche Weise funktionieren. Wir sind jedoch besorgt über eines ihrer gemeinsamen Merkmale - die mangelnde menschliche Kontrolle über die Funktion der Zielauswahl und des Angriffs. "Bei den Vereinten Nationen gibt es seit fünf Jahren Diskussionen über autonome Roboter , die töten können, aber die Länder haben keine Einigung erzielt. 2013 schrieb Christof Heyns, UN-Sonderberichterstatter für Menschenrechte, einen einflussreichen Bericht, in dem er feststellte, dass Länder eine seltene Gelegenheit haben, die Risiken autonomer Waffen zu diskutieren, noch bevor sie entwickelt werden. Nachdem Hines an mehreren UN-Treffen teilgenommen hat, sagt er: "Wenn Sie zurückblicken, bin ich etwas ermutigt, aber wenn Sie nach vorne schauen, scheinen wir Probleme zu haben, wenn wir nicht schneller vorankommen."Im Dezember dieses Jahres wird auf der UN-Konvention über klassische Waffen eine Konferenz über fünfjährige Arbeit stattfinden, und das Thema autonome Roboter steht auf der Tagesordnung. Es ist jedoch unwahrscheinlich, dass ihr Verbot akzeptiert wird. Eine solche Entscheidung erfordert eine einstimmige Entscheidung aller Länder, und es gibt grundsätzliche Meinungsverschiedenheiten zwischen ihnen darüber, was mit dem breiten Spektrum autonomer Waffen geschehen soll, die in Zukunft erscheinen werden.Streitigkeiten über Killerroboter führen daher zu einer Diskussion über Menschen. Zumindest anfangs werden autonome Waffen jeder Technologie ähnlich sein: Sie können genau und umsichtig oder chaotisch und katastrophal eingeführt werden. Und die Leute müssen die Anschuldigungen akzeptieren. Daher die Frage „Sind autonome Kampfroboter eine gute Idee?“ nicht der richtige. Es ist besser, die Frage zu stellen: "Vertrauen wir uns genug, um Robotern für unser Leben zu vertrauen?"

Transformers (2007) Probleme . Eine Bande außerirdischer Roboter, angeführt von Megatron, versucht, alle Menschen zu vernichten.„Wenn Menschen von autonomen Waffen hören, repräsentieren sie oft den Terminator und sagen:„ Was haben wir getan? “, Sagt Paul Scharre, Programmmanager für zukünftige militärische Angelegenheiten in Das Zentrum der neuen amerikanischen Sicherheitsforschungsgruppe in Washington. "Aber es ist unwahrscheinlich, dass das Militär diese Art von autonomer Waffe einsetzen will." Ihm zufolge werden autonome Systeme höchstwahrscheinlich militärische Einrichtungen wie Radar, Panzer, Schiffe, U-Boote und Flugzeuge angreifen.Die Aufgabe, das Ziel zu identifizieren - festzustellen, ob ein Objekt dem Feind gehört - ist eine der kritischsten Aufgaben für die KI. Sich bewegende Ziele, Flugzeuge und Raketen haben eine Flugbahn, die verfolgt werden kann und auf deren Grundlage die Entscheidung getroffen wird, ein Objekt zum Absturz zu bringen. So funktioniert die Phalanx-Kanone auf US-Kriegsschiffen, ebenso wie das israelische Raketenabfangsystem Iron Dome. Wenn jedoch Menschen als Ziel ausgewählt werden, ist diese Identifizierung kompliziert. Selbst unter idealen Bedingungen kann die Erkennung von Objekten und Umgebungen, mit denen Menschen ständig fertig werden, für Roboter zu komplex sein.Ein Computer kann die Figur einer Person unterscheiden, selbst wenn sie sich heimlich bewegt. Für den Algorithmus ist es jedoch schwierig zu verstehen, womit Menschen beschäftigt sind und welche Absichten ihre Körpersprache und ihr Gesichtsausdruck vermitteln. Hebt ein Mann eine Waffe oder einen Rechen? Hält er eine Bombe oder ein Baby?Scarre behauptet, dass Roboterwaffen, die versuchen, ein Ziel selbst zu wählen, angesichts von Schwierigkeiten sparen. Seiner Meinung nach bleibt der beste Ansatz unter dem Gesichtspunkt der Sicherheit, Legalität und Ethik die Entwicklung solcher Taktiken und Technologien, bei denen Menschen mit Robotern zusammenarbeiten . "Das Militär kann in fortschrittliche Robotik und Automatisierung investieren, aber gleichzeitig die Person in der Kontrollkette verlassen, um Entscheidungen über Ziele zu treffen, um sicher zu sein", sagt er. „Schließlich sind die Menschen flexibler und passen sich besser an neue Situationen an, die wir möglicherweise nicht programmieren. Dies ist besonders wichtig in einem Krieg, in dem ein Gegner versucht, Ihre Systeme zu besiegen, sie auszutricksen und zu hacken. “Es überrascht nicht, dass Südkoreaner von DoDAAM ihre Uhrenroboter mit strengen Autonomieeinschränkungen herstellen. Jetzt schießen ihre Roboter erst, wenn eine Person das Ziel bestätigt und "Feuer" befiehlt. "Die ursprüngliche Version war ein automatisches Feuersystem" , sagte ein Ingenieur des Unternehmens gegenüber BBC im vergangenen Jahr . "Aber alle Kunden baten darum, Sicherheitsmaßnahmen einzubeziehen ... Sie befürchteten, dass die Waffe falsch sein könnte."Andere Experten glauben, dass der einzige Weg, um die fatalen Fehler einer autonomen Waffe, insbesondere unter Beteiligung von Zivilisten, zu vermeiden, darin besteht, geeignete Programme zu erstellen. "Wenn wir so dumm sind, dass wir uns auf dem Schlachtfeld weiterhin gegenseitig töten und wenn immer mehr Kräfte auf die Maschinen übertragen werden, können wir zumindest sicherstellen, dass sie ihre Arbeit auf ethische Weise erledigen", sagt Ronald Arkin, IT Spezialist vom Institute of Technology in Georgia.Arkin ist zuversichtlich, dass autonome Waffen wie Soldaten den Regeln der Kriegsführung und den Kriegsgesetzen, einschließlich der humanitären Völkergesetze , folgen müssenSchutz der Zivilbevölkerung und Begrenzung der Macht und der Arten zulässiger Waffen. Dies bedeutet, dass wir bestimmte moralische Eigenschaften in ihre Programme einbringen müssen, damit sie unterschiedliche Situationen verstehen und zwischen Gut und Böse unterscheiden können. Ihre Software muss einen ethischen Kompass haben.In den letzten zehn Jahren hat Arkin an einem solchen Kompass gearbeitet. Mit mathematischen und logischen Werkzeugen aus dem Bereich der Maschinenethik übersetzt er die Kriegsgesetze und die Regeln der Kriegsführung in Variablen und Operationen, die für einen Computer verständlich sind. Beispielsweise enthält eine der Variablen den Vertrauenswert der ethischen Kontrolleinheit, dass das Ziel ein Feind ist. Ein anderer, boolescher Wert, bedeutet, ob die Tötungskraft von Waffen erlaubt oder verboten ist. Am Ende kam Arkin zu einer Reihe von Algorithmen, und mithilfe von Computersimulationen und vereinfachten Kampfszenarien - zum Beispiel eines UAV, das eine Gruppe von Menschen auf freiem Feld angreift - konnte er seine Technik testen.Arkin gibt zu, dass das von den US-Streitkräften gesponserte Projekt noch nicht das Stadium des fertigen Systems erreicht hat und nur zum Nachweis seiner Funktionsfähigkeit erstellt wurde. Aber seiner Meinung nach zeigen die Ergebnisse der Arbeit, dass Roboter noch besser sind, als Menschen den Regeln des Krieges folgen können. Zum Beispiel können Roboter lebensbedrohliche Aktionen mit mehr Zurückhaltung als Menschen ausführen und nur als Reaktion darauf schießen. Oder wenn sich Zivilisten nähern, können sie im Allgemeinen das Feuer einstellen, selbst wenn sie selbst zerstört werden. Roboter leiden nicht unter Stress, Unzufriedenheit, Wut, Angst - und all dies kann die Annahme der richtigen Entscheidungen bei Menschen beeinträchtigen. Theoretisch können Roboter daher menschliche Soldaten übertreffen , die in der Hitze des Kampfes oft und manchmal unvermeidlich Fehler machen."Infolgedessen können wir Leben retten, insbesondere das Leben unschuldiger Menschen, die in einer Schlacht gefangen sind", sagt Arkin. "Und wenn Roboter dies können, deutet die Moral auf die Notwendigkeit hin, sie einzusetzen."Natürlich wird diese Ansicht nicht allgemein akzeptiert. Kritiker Autonome Waffen bestehen darauf, dass nur ein präventives Verbot Sinn macht, weil solche Waffen hinter den Kulissen erscheinen. "Es gibt kein solches Feuersystem, auf das wir hinweisen und sagen könnten: Ja, hier ist er ein Killerroboter", sagt Mary Wareham. Lobby Manager und Coor von Human Rights Watch ordinator Kampagne zum Verbot Killerroboter ( Kampagne Stop Killer - Roboter) - Koalitionen verschiedener humanitärer Gemeinschaften. - Wir sprechen über viele verschiedene Waffensysteme, die auf unterschiedliche Weise funktionieren. Wir sind jedoch besorgt über eines ihrer gemeinsamen Merkmale - die mangelnde menschliche Kontrolle über die Funktion der Zielauswahl und des Angriffs. "Bei den Vereinten Nationen gibt es seit fünf Jahren Diskussionen über autonome Roboter , die töten können, aber die Länder haben keine Einigung erzielt. 2013 schrieb Christof Heyns, UN-Sonderberichterstatter für Menschenrechte, einen einflussreichen Bericht, in dem er feststellte, dass Länder eine seltene Gelegenheit haben, die Risiken autonomer Waffen zu diskutieren, noch bevor sie entwickelt werden. Nachdem Hines an mehreren UN-Treffen teilgenommen hat, sagt er: "Wenn Sie zurückblicken, bin ich etwas ermutigt, aber wenn Sie nach vorne schauen, scheinen wir Probleme zu haben, wenn wir nicht schneller vorankommen."Im Dezember dieses Jahres wird auf der UN-Konvention über klassische Waffen eine Konferenz über fünfjährige Arbeit stattfinden, und das Thema autonome Roboter steht auf der Tagesordnung. Es ist jedoch unwahrscheinlich, dass ihr Verbot akzeptiert wird. Eine solche Entscheidung erfordert eine einstimmige Entscheidung aller Länder, und es gibt grundsätzliche Meinungsverschiedenheiten zwischen ihnen darüber, was mit dem breiten Spektrum autonomer Waffen geschehen soll, die in Zukunft erscheinen werden.Streitigkeiten über Killerroboter führen daher zu einer Diskussion über Menschen. Zumindest anfangs werden autonome Waffen jeder Technologie ähnlich sein: Sie können genau und umsichtig oder chaotisch und katastrophal eingeführt werden. Und die Leute müssen die Anschuldigungen akzeptieren. Daher die Frage „Sind autonome Kampfroboter eine gute Idee?“ nicht der richtige. Es ist besser, die Frage zu stellen: "Vertrauen wir uns genug, um Robotern für unser Leben zu vertrauen?"Source: https://habr.com/ru/post/de395139/

All Articles