KI erzeugt realistische Geräusche im Filmmaterial

Mitarbeiter des Massachusetts Institute of Computer Science und des Labors für künstliche Intelligenz (CSAIL) und von Google Research haben ein neuronales Netzwerk entwickelt, das gelernt hat, beliebige Videosequenzen abzuspielen , realistische Geräusche zu erzeugen und die Eigenschaften von Objekten vorherzusagen. Das Programm analysiert das Video, erkennt Objekte, ihre Bewegung und Art des Kontakts - Schock, Gleiten, Reibung und so weiter. Basierend auf diesen Informationen wird ein Ton erzeugt, den eine Person in 40% der Fälle für realistischer hält als die reale.Wissenschaftler schlagen vor, dass diese Entwicklung im Kino und im Fernsehen weit verbreitet sein wird, um Soundeffekte aus einer Videosequenz ohne Ton zu erzeugen. Darüber hinaus kann es für das Training von Robotern nützlich sein, die Eigenschaften der Welt besser zu verstehen.Umgebungsgeräusche sagen viel über die Eigenschaften der umgebenden Objekte aus. Während des Selbstlernens können sich zukünftige Roboter wie Kinder verhalten - Objekte berühren, durch Berühren ausprobieren, einen Stock hineinstecken, versuchen, sich zu bewegen, zu heben. In diesem Fall erhält der Roboter eine Rückmeldung, in der er die Eigenschaften des Objekts erkennt - sein Gewicht, seine Elastizität usw.Der Ton eines Kontaktobjekts enthält auch wichtige Informationen zu den Eigenschaften des Objekts. „Wenn Sie mit dem Finger über ein Glas Wein fahren, entspricht das Geräusch, das Sie machen, der Menge an Flüssigkeit, die in das Glas gegossen wird“, erklärt der Doktorand Andrew Owens , Hauptautor einer veröffentlichten wissenschaftlichen Arbeit, die noch nicht für eine wissenschaftliche Zeitschrift bereit ist, sondern nur veröffentlicht wirdöffentlich verfügbar auf arXiv.org. Die Präsentation der wissenschaftlichen Arbeit findet diesen Monat auf der jährlichen Konferenz über Bildverarbeitung und Mustererkennung (CVPR) in Las Vegas statt.Wissenschaftler haben 977 Videos ausgewählt, in denen Menschen Aktionen mit umgebenden Objekten ausführen, die aus verschiedenen Materialien bestehen: kratzen, mit einem Stock schlagen usw. Insgesamt enthielten die Videos 46.577 Aktionen. CSAIL-Schüler haben alle Aktionen manuell markiert und dabei die Art des Materials, den Kontaktort, die Art der Aktion (Schock / Kratzen / Sonstiges) und die Art der Reaktion des Materials oder Objekts (Verformung, statische Form, harte Bewegung usw.) angegeben. Videos mit Ton wurden verwendet, um das neuronale Netzwerk zu trainieren, und manuell platzierte Tags wurden nur verwendet, um das Ergebnis des Trainings des neuronalen Netzwerks zu analysieren , nicht aber , um es zu trainieren.

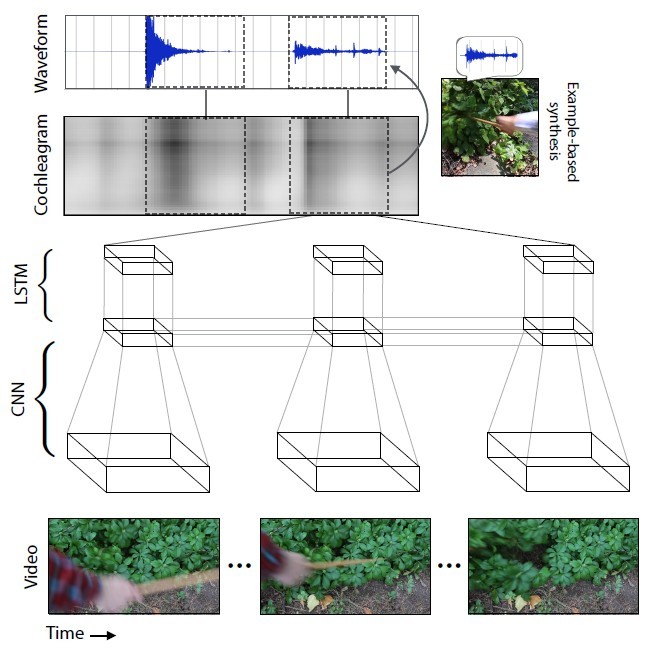

Mitarbeiter des Massachusetts Institute of Computer Science und des Labors für künstliche Intelligenz (CSAIL) und von Google Research haben ein neuronales Netzwerk entwickelt, das gelernt hat, beliebige Videosequenzen abzuspielen , realistische Geräusche zu erzeugen und die Eigenschaften von Objekten vorherzusagen. Das Programm analysiert das Video, erkennt Objekte, ihre Bewegung und Art des Kontakts - Schock, Gleiten, Reibung und so weiter. Basierend auf diesen Informationen wird ein Ton erzeugt, den eine Person in 40% der Fälle für realistischer hält als die reale.Wissenschaftler schlagen vor, dass diese Entwicklung im Kino und im Fernsehen weit verbreitet sein wird, um Soundeffekte aus einer Videosequenz ohne Ton zu erzeugen. Darüber hinaus kann es für das Training von Robotern nützlich sein, die Eigenschaften der Welt besser zu verstehen.Umgebungsgeräusche sagen viel über die Eigenschaften der umgebenden Objekte aus. Während des Selbstlernens können sich zukünftige Roboter wie Kinder verhalten - Objekte berühren, durch Berühren ausprobieren, einen Stock hineinstecken, versuchen, sich zu bewegen, zu heben. In diesem Fall erhält der Roboter eine Rückmeldung, in der er die Eigenschaften des Objekts erkennt - sein Gewicht, seine Elastizität usw.Der Ton eines Kontaktobjekts enthält auch wichtige Informationen zu den Eigenschaften des Objekts. „Wenn Sie mit dem Finger über ein Glas Wein fahren, entspricht das Geräusch, das Sie machen, der Menge an Flüssigkeit, die in das Glas gegossen wird“, erklärt der Doktorand Andrew Owens , Hauptautor einer veröffentlichten wissenschaftlichen Arbeit, die noch nicht für eine wissenschaftliche Zeitschrift bereit ist, sondern nur veröffentlicht wirdöffentlich verfügbar auf arXiv.org. Die Präsentation der wissenschaftlichen Arbeit findet diesen Monat auf der jährlichen Konferenz über Bildverarbeitung und Mustererkennung (CVPR) in Las Vegas statt.Wissenschaftler haben 977 Videos ausgewählt, in denen Menschen Aktionen mit umgebenden Objekten ausführen, die aus verschiedenen Materialien bestehen: kratzen, mit einem Stock schlagen usw. Insgesamt enthielten die Videos 46.577 Aktionen. CSAIL-Schüler haben alle Aktionen manuell markiert und dabei die Art des Materials, den Kontaktort, die Art der Aktion (Schock / Kratzen / Sonstiges) und die Art der Reaktion des Materials oder Objekts (Verformung, statische Form, harte Bewegung usw.) angegeben. Videos mit Ton wurden verwendet, um das neuronale Netzwerk zu trainieren, und manuell platzierte Tags wurden nur verwendet, um das Ergebnis des Trainings des neuronalen Netzwerks zu analysieren , nicht aber , um es zu trainieren. Das neuronale Netzwerk analysierte die Eigenschaften des Klangs, die jeder Art der Interaktion mit Objekten entsprechen - Lautstärke, Tonhöhe und andere Eigenschaften. Während des Trainings untersuchte das System das Video Bild für Bild, analysierte den Ton in diesem Bild und fand eine Übereinstimmung mit dem ähnlichsten Ton in der bereits akkumulierten Datenbank. Das Wichtigste war, dem neuronalen Netzwerk beizubringen, den Klang in Frames zu dehnen.

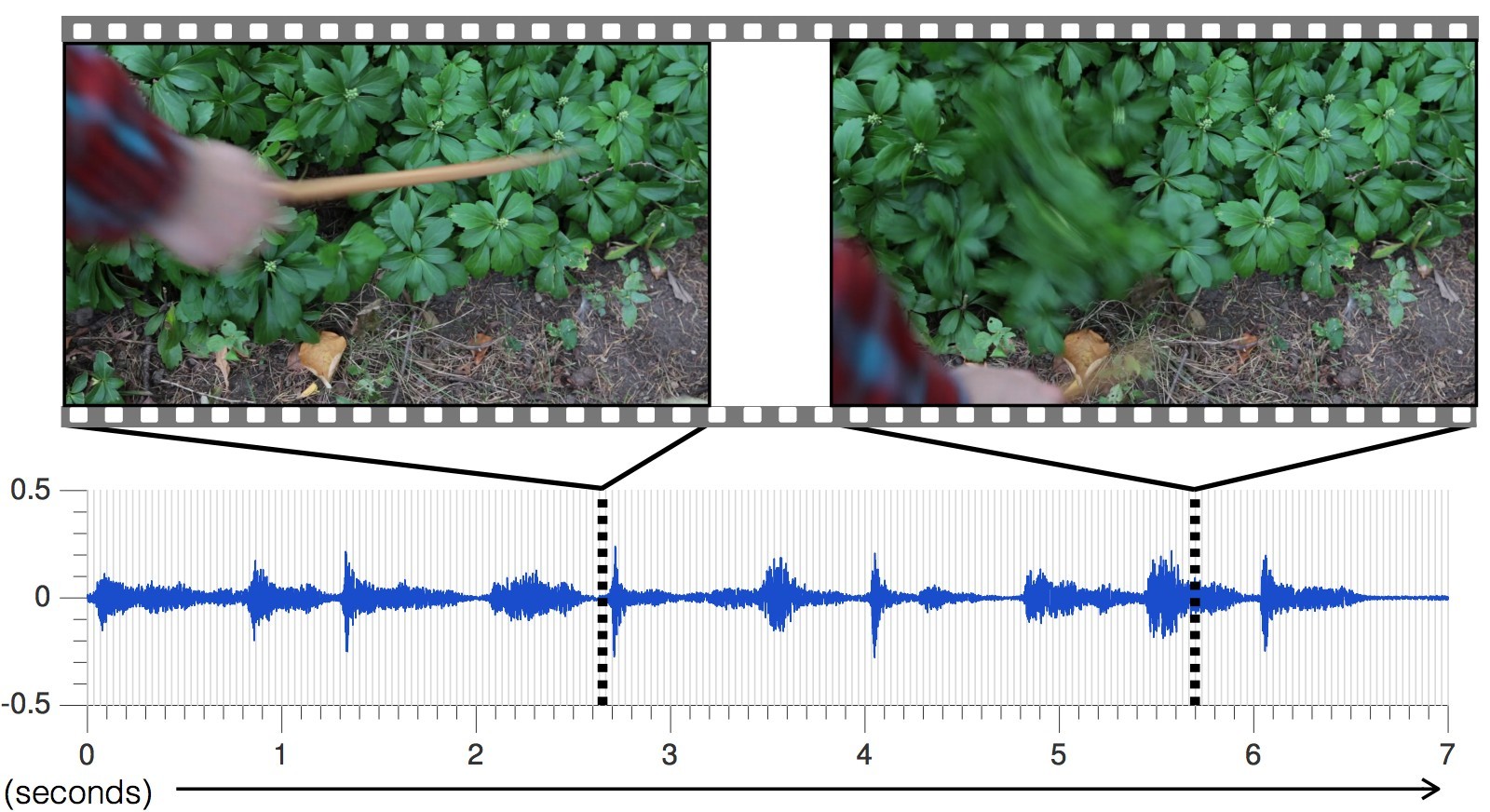

Das neuronale Netzwerk analysierte die Eigenschaften des Klangs, die jeder Art der Interaktion mit Objekten entsprechen - Lautstärke, Tonhöhe und andere Eigenschaften. Während des Trainings untersuchte das System das Video Bild für Bild, analysierte den Ton in diesem Bild und fand eine Übereinstimmung mit dem ähnlichsten Ton in der bereits akkumulierten Datenbank. Das Wichtigste war, dem neuronalen Netzwerk beizubringen, den Klang in Frames zu dehnen. Mit jedem neuen Video wurde die Genauigkeit der Tonvorhersage erhöht.Der vom neuronalen Netzwerk für verschiedene Szenen erzeugte Ton im Vergleich zum realen.

Mit jedem neuen Video wurde die Genauigkeit der Tonvorhersage erhöht.Der vom neuronalen Netzwerk für verschiedene Szenen erzeugte Ton im Vergleich zum realen. Infolgedessen lernte das neuronale Netzwerk, die unterschiedlichsten Geräusche mit allen Nuancen genau vorherzusagen: vom Klopfen von Steinen bis zum Rascheln von Efeu.„Die aktuellen Ansätze von Forschern auf dem Gebiet der künstlichen Intelligenz konzentrieren sich nur auf einen der fünf Sinne: Bildverarbeitungsspezialisten untersuchen visuelle Bilder, Spracherkennungsspezialisten Ton usw.“, sagt Abhinav Gupta, Assistenzprofessor für Robotik an der Carnegie University. Mellon. "Diese Studie ist ein Schritt in die richtige Richtung, der den Lernprozess auf die gleiche Weise nachahmt wie die Menschen, dh die Integration von Ton und Bild."Um die Wirksamkeit der KI zu testen, führten Wissenschaftler eine Online-Studie zu Amazon Mechanical Turk durch, deren Teilnehmer gebeten wurden, zwei Optionen für den Ton eines bestimmten Videos zu vergleichen und festzustellen, welcher Ton real ist und welcher nicht.Als Ergebnis des Experiments gelang es der KI in 40% der Fälle, Menschen zu täuschen . Laut einigen Kommentatoren in den Foren ist es jedoch nicht so schwierig, eine Person zu täuschen, da ein erheblicher Teil des Wissens über das Klangbild der Welt von modernen Menschen aus Spielfilmen und Computerspielen gewonnen wird. Das Klangspektrum für Filme und Spiele besteht aus Spezialisten, die Sammlungen von Standardbeispielen verwenden. Das heißt, wir hören ständig über das Gleiche.In einem Online-Experiment hielten die Leute in zwei von fünf Fällen den vom Programm erzeugten Ton für realistischer als den tatsächlichen Ton des Videos. Dies ist ein besseres Ergebnis als andere Methoden zur Synthese realistischer Klänge.

Infolgedessen lernte das neuronale Netzwerk, die unterschiedlichsten Geräusche mit allen Nuancen genau vorherzusagen: vom Klopfen von Steinen bis zum Rascheln von Efeu.„Die aktuellen Ansätze von Forschern auf dem Gebiet der künstlichen Intelligenz konzentrieren sich nur auf einen der fünf Sinne: Bildverarbeitungsspezialisten untersuchen visuelle Bilder, Spracherkennungsspezialisten Ton usw.“, sagt Abhinav Gupta, Assistenzprofessor für Robotik an der Carnegie University. Mellon. "Diese Studie ist ein Schritt in die richtige Richtung, der den Lernprozess auf die gleiche Weise nachahmt wie die Menschen, dh die Integration von Ton und Bild."Um die Wirksamkeit der KI zu testen, führten Wissenschaftler eine Online-Studie zu Amazon Mechanical Turk durch, deren Teilnehmer gebeten wurden, zwei Optionen für den Ton eines bestimmten Videos zu vergleichen und festzustellen, welcher Ton real ist und welcher nicht.Als Ergebnis des Experiments gelang es der KI in 40% der Fälle, Menschen zu täuschen . Laut einigen Kommentatoren in den Foren ist es jedoch nicht so schwierig, eine Person zu täuschen, da ein erheblicher Teil des Wissens über das Klangbild der Welt von modernen Menschen aus Spielfilmen und Computerspielen gewonnen wird. Das Klangspektrum für Filme und Spiele besteht aus Spezialisten, die Sammlungen von Standardbeispielen verwenden. Das heißt, wir hören ständig über das Gleiche.In einem Online-Experiment hielten die Leute in zwei von fünf Fällen den vom Programm erzeugten Ton für realistischer als den tatsächlichen Ton des Videos. Dies ist ein besseres Ergebnis als andere Methoden zur Synthese realistischer Klänge. Am häufigsten täuschte AI die Teilnehmer des Experiments mit den Geräuschen von Materialien wie Blättern und Schmutz, weil diese Geräusche komplexer und nicht so „sauber“ sind wie diejenigen, die beispielsweise aus Holz oder Metall bestehen.Zurück zum Training des neuronalen Netzwerks als Nebenprodukt der Studie wurde festgestellt, dass der Algorithmus mit einer Genauigkeit von 67% zwischen weichen und harten Materialien unterscheiden kann, indem er einfach ihren Klang vorhersagt. Mit anderen Worten, der Roboter kann auf den Asphaltweg und das Gras davor schauen - und daraus schließen, dass der Asphalt hart und das Gras weich ist. Der Roboter erkennt dies an dem vorhergesagten Geräusch, ohne auf Asphalt und Gras zu treten. Dann kann er gehen, wo er will - und seine Gefühle testen, indem er in der Datenbank nachschaut und gegebenenfalls Korrekturen in der Bibliothek der Klangbeispiele vornimmt. Auf diese Weise werden Roboter in Zukunft die Welt um sie herum studieren und beherrschen.Die Forscher haben jedoch noch viel zu tun, um die Technologie zu verbessern. Das neuronale Netzwerk wird heute oft mit der schnellen Bewegung von Objekten verwechselt, ohne in den genauen Moment des Kontakts zu fallen. Darüber hinaus kann KI nur Ton erzeugen, der auf direktem Kontakt basiert, der auf Video aufgezeichnet wird, und es gibt so viele Geräusche um uns herum, die nicht auf visuellem Kontakt beruhen: das Geräusch von Bäumen, das Summen eines Lüfters in einem Computer. „Was wirklich cool wäre, wäre, irgendwie einen Sound zu simulieren, der nicht so eng mit dem Filmmaterial zusammenhängt“, sagt Andrew Owens.

Am häufigsten täuschte AI die Teilnehmer des Experiments mit den Geräuschen von Materialien wie Blättern und Schmutz, weil diese Geräusche komplexer und nicht so „sauber“ sind wie diejenigen, die beispielsweise aus Holz oder Metall bestehen.Zurück zum Training des neuronalen Netzwerks als Nebenprodukt der Studie wurde festgestellt, dass der Algorithmus mit einer Genauigkeit von 67% zwischen weichen und harten Materialien unterscheiden kann, indem er einfach ihren Klang vorhersagt. Mit anderen Worten, der Roboter kann auf den Asphaltweg und das Gras davor schauen - und daraus schließen, dass der Asphalt hart und das Gras weich ist. Der Roboter erkennt dies an dem vorhergesagten Geräusch, ohne auf Asphalt und Gras zu treten. Dann kann er gehen, wo er will - und seine Gefühle testen, indem er in der Datenbank nachschaut und gegebenenfalls Korrekturen in der Bibliothek der Klangbeispiele vornimmt. Auf diese Weise werden Roboter in Zukunft die Welt um sie herum studieren und beherrschen.Die Forscher haben jedoch noch viel zu tun, um die Technologie zu verbessern. Das neuronale Netzwerk wird heute oft mit der schnellen Bewegung von Objekten verwechselt, ohne in den genauen Moment des Kontakts zu fallen. Darüber hinaus kann KI nur Ton erzeugen, der auf direktem Kontakt basiert, der auf Video aufgezeichnet wird, und es gibt so viele Geräusche um uns herum, die nicht auf visuellem Kontakt beruhen: das Geräusch von Bäumen, das Summen eines Lüfters in einem Computer. „Was wirklich cool wäre, wäre, irgendwie einen Sound zu simulieren, der nicht so eng mit dem Filmmaterial zusammenhängt“, sagt Andrew Owens.Source: https://habr.com/ru/post/de395243/

All Articles