NVIDIA sucht nach Möglichkeiten zur Optimierung von BP-Bildern

Das Unternehmen plant, den Komfort von BP zu erhöhen und die Rechenleistung durch Simulation der peripheren Sicht zu verringern

Das menschliche Auge ist komplex. Wir als Allesfresser haben einen ziemlich weiten Betrachtungswinkel, sehen aber immer noch deutlich nur, worauf unsere Augen gerichtet sind. Der Rest des Bereichs ermöglicht es uns, zwischen Objekten zu unterscheiden, aber wir sehen sie verschwommen, verschwommen. Dies nennen wir periphere Sicht.Anfänglich verfolgten Hersteller von VR-Helmen die Klarheit des Bildes auf den Bildschirmen, die Bildwiederholfrequenz des Rahmens und die Gesamtbildqualität. Jetzt, da HTC-, Oculus- und Sony-Produkte in einen breiten Markt eintreten, ist es an der Zeit, über Optimierungen nachzudenken, da sich nicht jeder einen Desktop-PC im Wert von 1.500 bis 2.500 US-Dollar leisten kann, um ein neues Produkt auszuprobieren. Und das ohne die Kosten für das Headset.Die finanzielle Hauptlast bilden Grafikkarten, die Bilder in zwei Streams auf den Bildschirmen von VR-Helmen rendern. Und NVidia als Hauptakteur auf dem Markt und als Zulieferer dachte darüber nach, den Komfort des Eintauchens in die VR-Welt zu optimieren und zu verbessern.Jetzt wird das gesamte Bild in VR-Headsets mit der gleichen Qualität gezeichnet. Wenn der Benutzer einen beliebigen Teil des Bildschirms betrachtet, wird das Bild in derselben Qualität angezeigt. In Wirklichkeit sieht das menschliche Auge jedoch nur in einem engen Fokusbereich klar und alles andere fällt auf das periphere Sehen, das Bild, von dem aus unser Gehirn verarbeitet und erweicht.NVidia kam zu dem Schluss, dass die Simulation des Verhaltens des realen Auges beim Rendern von Bildern auf den Bildschirmen von BP-Headsets eine gute Lösung wäre, da dies zum einen die Rechenleistung des PCs, an den der Helm angeschlossen ist, verringert und zum anderen den Realismus erhöht Bildverhalten und erhöhen dementsprechend den Komfort des Gameplays.Da unsere Augen jedoch mobil sind, ist es unmöglich, in der Mitte des Bildschirms eine klare „Unschärfe“ des Fokus zu erzielen. Um das Verhalten des realen Sehens zu simulieren, griffen die NVIDIA-Ingenieure auf ein Eye-Tracking-System zurück, um klar zu bestimmen, wohin der Benutzer schaut. Infolgedessen gelang es ihnen, ein System zu entwickeln, das das Verhalten des menschlichen Sehens ganz realistisch simuliert und gleichzeitig die Rechenressourcen des Systems spart:

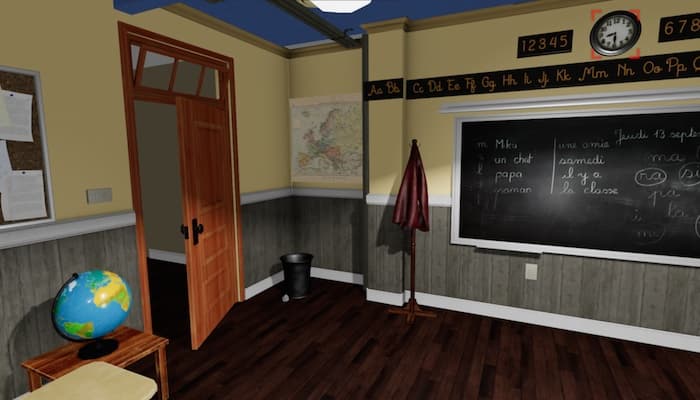

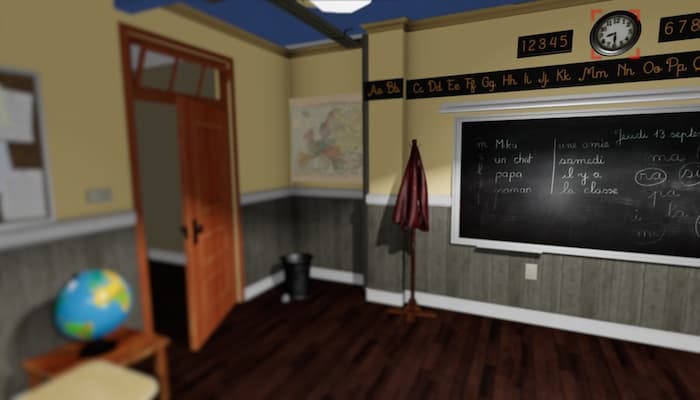

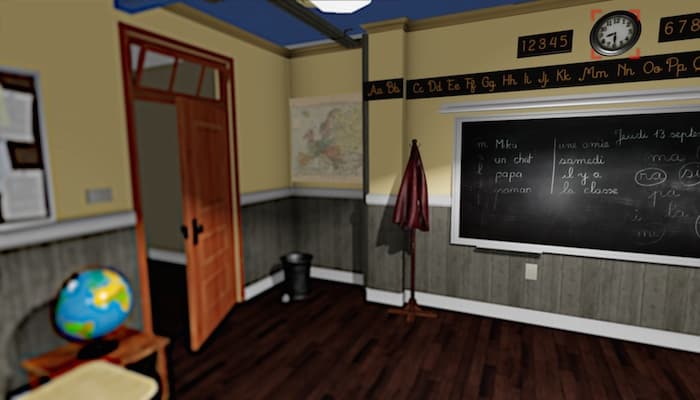

Das menschliche Auge ist komplex. Wir als Allesfresser haben einen ziemlich weiten Betrachtungswinkel, sehen aber immer noch deutlich nur, worauf unsere Augen gerichtet sind. Der Rest des Bereichs ermöglicht es uns, zwischen Objekten zu unterscheiden, aber wir sehen sie verschwommen, verschwommen. Dies nennen wir periphere Sicht.Anfänglich verfolgten Hersteller von VR-Helmen die Klarheit des Bildes auf den Bildschirmen, die Bildwiederholfrequenz des Rahmens und die Gesamtbildqualität. Jetzt, da HTC-, Oculus- und Sony-Produkte in einen breiten Markt eintreten, ist es an der Zeit, über Optimierungen nachzudenken, da sich nicht jeder einen Desktop-PC im Wert von 1.500 bis 2.500 US-Dollar leisten kann, um ein neues Produkt auszuprobieren. Und das ohne die Kosten für das Headset.Die finanzielle Hauptlast bilden Grafikkarten, die Bilder in zwei Streams auf den Bildschirmen von VR-Helmen rendern. Und NVidia als Hauptakteur auf dem Markt und als Zulieferer dachte darüber nach, den Komfort des Eintauchens in die VR-Welt zu optimieren und zu verbessern.Jetzt wird das gesamte Bild in VR-Headsets mit der gleichen Qualität gezeichnet. Wenn der Benutzer einen beliebigen Teil des Bildschirms betrachtet, wird das Bild in derselben Qualität angezeigt. In Wirklichkeit sieht das menschliche Auge jedoch nur in einem engen Fokusbereich klar und alles andere fällt auf das periphere Sehen, das Bild, von dem aus unser Gehirn verarbeitet und erweicht.NVidia kam zu dem Schluss, dass die Simulation des Verhaltens des realen Auges beim Rendern von Bildern auf den Bildschirmen von BP-Headsets eine gute Lösung wäre, da dies zum einen die Rechenleistung des PCs, an den der Helm angeschlossen ist, verringert und zum anderen den Realismus erhöht Bildverhalten und erhöhen dementsprechend den Komfort des Gameplays.Da unsere Augen jedoch mobil sind, ist es unmöglich, in der Mitte des Bildschirms eine klare „Unschärfe“ des Fokus zu erzielen. Um das Verhalten des realen Sehens zu simulieren, griffen die NVIDIA-Ingenieure auf ein Eye-Tracking-System zurück, um klar zu bestimmen, wohin der Benutzer schaut. Infolgedessen gelang es ihnen, ein System zu entwickeln, das das Verhalten des menschlichen Sehens ganz realistisch simuliert und gleichzeitig die Rechenressourcen des Systems spart: Vollständig gerendertes Bild für BP, Fokus auf die Uhr

Vollständig gerendertes Bild für BP, Fokus auf die Uhr Nur die „unscharfe“ Peripherie des Bildes für BP, Fokus auf die Uhr

Nur die „unscharfe“ Peripherie des Bildes für BP, Fokus auf die Uhr „Die unscharfe“ Peripherie des Bildes für BP mit der Aufrechterhaltung des notwendigen Kontrastniveaus, Nachahmung des realen Sehens, Fokus auf die UhrSchon jetzt können Sie anhand des Bildes erkennen, dass die NVIDIA-Ingenieure auf dem richtigen Weg sind. Wenn man sich selbst auf dem Bildschirm auf die Uhr konzentriert, fehlt auf den ersten Blick praktisch der Unterschied zwischen dem ersten und dem dritten Bild. Die Entwicklung basiert auf der bestehenden SMI-Technologie (SensoMotoric Instruments), die im November 2014 für Oculus Rift DK2 eingeführt wurde.Wenn Sie der Meinung sind, dass NVIDIA-Ingenieure einfach alles „einschäumen“, was unscharf ist, irren Sie sich. Im Verlauf der Arbeit wurde festgestellt, dass beim traditionellen Rendern des Bildes im Bereich des peripheren Sehens Dips und Flimmern entstehen, die ein Gefühl von Unbehagen verursachen. Nur die "Unschärfe" des Bildes verringert den Kontrast, was ein Gefühl des "Tunnelns" des Sehens hervorruft.Aus diesem Grund haben die Ingenieure einen vollständigen Algorithmus erstellt, der Form, Farbe und Kontrast sowie die Bewegung des Objekts bewertet. Dank dessen geht das „Blau“ für den Benutzer bequem und fast unmerklich ohne Nebenwirkungen vorbei.Videodemonstration der Phasen von "Unschärfe" -Bildern für BP von NVIDIA

„Die unscharfe“ Peripherie des Bildes für BP mit der Aufrechterhaltung des notwendigen Kontrastniveaus, Nachahmung des realen Sehens, Fokus auf die UhrSchon jetzt können Sie anhand des Bildes erkennen, dass die NVIDIA-Ingenieure auf dem richtigen Weg sind. Wenn man sich selbst auf dem Bildschirm auf die Uhr konzentriert, fehlt auf den ersten Blick praktisch der Unterschied zwischen dem ersten und dem dritten Bild. Die Entwicklung basiert auf der bestehenden SMI-Technologie (SensoMotoric Instruments), die im November 2014 für Oculus Rift DK2 eingeführt wurde.Wenn Sie der Meinung sind, dass NVIDIA-Ingenieure einfach alles „einschäumen“, was unscharf ist, irren Sie sich. Im Verlauf der Arbeit wurde festgestellt, dass beim traditionellen Rendern des Bildes im Bereich des peripheren Sehens Dips und Flimmern entstehen, die ein Gefühl von Unbehagen verursachen. Nur die "Unschärfe" des Bildes verringert den Kontrast, was ein Gefühl des "Tunnelns" des Sehens hervorruft.Aus diesem Grund haben die Ingenieure einen vollständigen Algorithmus erstellt, der Form, Farbe und Kontrast sowie die Bewegung des Objekts bewertet. Dank dessen geht das „Blau“ für den Benutzer bequem und fast unmerklich ohne Nebenwirkungen vorbei.Videodemonstration der Phasen von "Unschärfe" -Bildern für BP von NVIDIASource: https://habr.com/ru/post/de396385/

All Articles