Danke für den Speicher: Wie billig Speicher das Rechnen verändert

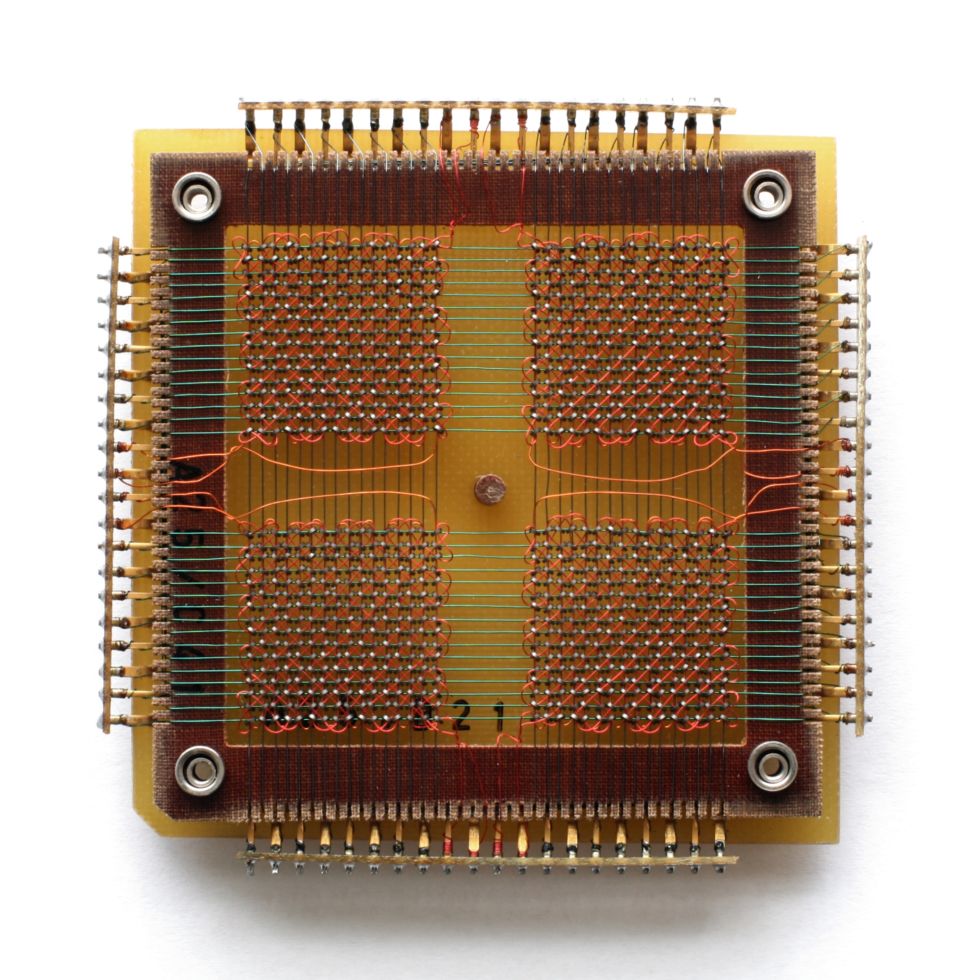

Der frühe Micron DRAM mit einer Kapazität von 1 MbitRAM (Direktzugriffsspeicher) ist in jedem Computersystem vorhanden, von kleinen integrierten Controllern bis hin zu Industrieservern. Daten werden im SRAM (statisches RAM) oder DRAM (dynamisches RAM) gespeichert, während der Prozessor mit ihnen arbeitet. Mit dem Rückgang der RAM-Preise kann das Modell zum Verschieben von Daten zwischen RAM und einem permanenten Speicherort verschwinden.RAM wird stark von Marktschwankungen beeinflusst, aber auf lange Sicht sinkt sein Wert. Im Jahr 2000 kostete ein Gigabyte Speicher mehr als 1000 US-Dollar, jetzt nur noch 5 US-Dollar. Dies ermöglicht es uns, uns eine völlig andere Systemarchitektur vorzustellen.Datenbanken werden normalerweise auf Datenträgern gespeichert, von wo aus die erforderlichen Informationen bei Bedarf in den Speicher eingelesen und dann verarbeitet werden. Es wird allgemein angenommen, dass die Speichermenge im System mehrere Größenordnungen kleiner ist als das Festplattenvolumen - beispielsweise Gigabyte gegen Terabyte. Mit zunehmendem Speicher wird es jedoch effizienter, mehr Daten in den Speicher zu laden, wodurch die Anzahl der Lese- und Schreibvorgänge verringert wird. Mit einer Verringerung der RAM-Kosten wird es möglich, die gesamte Datenbank in den Speicher zu laden, Operationen an ihnen auszuführen und sie zurückzuschreiben. Jetzt sind wir an einem Punkt angelangt, an dem einige Datenbanken nicht mehr auf die Festplatte zurückgeschrieben werden und ständig im Speicher hängen bleiben.

Der frühe Micron DRAM mit einer Kapazität von 1 MbitRAM (Direktzugriffsspeicher) ist in jedem Computersystem vorhanden, von kleinen integrierten Controllern bis hin zu Industrieservern. Daten werden im SRAM (statisches RAM) oder DRAM (dynamisches RAM) gespeichert, während der Prozessor mit ihnen arbeitet. Mit dem Rückgang der RAM-Preise kann das Modell zum Verschieben von Daten zwischen RAM und einem permanenten Speicherort verschwinden.RAM wird stark von Marktschwankungen beeinflusst, aber auf lange Sicht sinkt sein Wert. Im Jahr 2000 kostete ein Gigabyte Speicher mehr als 1000 US-Dollar, jetzt nur noch 5 US-Dollar. Dies ermöglicht es uns, uns eine völlig andere Systemarchitektur vorzustellen.Datenbanken werden normalerweise auf Datenträgern gespeichert, von wo aus die erforderlichen Informationen bei Bedarf in den Speicher eingelesen und dann verarbeitet werden. Es wird allgemein angenommen, dass die Speichermenge im System mehrere Größenordnungen kleiner ist als das Festplattenvolumen - beispielsweise Gigabyte gegen Terabyte. Mit zunehmendem Speicher wird es jedoch effizienter, mehr Daten in den Speicher zu laden, wodurch die Anzahl der Lese- und Schreibvorgänge verringert wird. Mit einer Verringerung der RAM-Kosten wird es möglich, die gesamte Datenbank in den Speicher zu laden, Operationen an ihnen auszuführen und sie zurückzuschreiben. Jetzt sind wir an einem Punkt angelangt, an dem einige Datenbanken nicht mehr auf die Festplatte zurückgeschrieben werden und ständig im Speicher hängen bleiben. Megabit-Chip von Carl Zeiss

Megabit-Chip von Carl Zeiss Bis 1975 war RAM ein

Bis 1975 war RAM ein 4-Megabyte-EPROM-Chip mit Magnetkernspeicher, der unter Verwendung von durch ein Fenster gesendeter ultravioletter Strahlung gelöscht wurde.

4-Megabyte-EPROM-Chip mit Magnetkernspeicher, der unter Verwendung von durch ein Fenster gesendeter ultravioletter Strahlung gelöscht wurde. Eine Reihe moderner DRAM-Speicherzugriffsgeschwindigkeitenwerden in Nanosekunden gemessen, und die Festplattenzugriffszeit wird in Millisekunden gemessen - d. H. Der Speicher ist millionenfach schneller. Die Datenübertragungsgeschwindigkeit im Speicher ist natürlich nicht millionenfach schneller - dies sind Gigabyte pro Sekunde gegenüber mehreren hundert Megabyte pro Sekunde für schnelle Festplatten -, aber zumindest die RAM-Geschwindigkeit übersteigt die Geschwindigkeit der Laufwerke um eine Größenordnung.In der realen Welt sind die Unterschiede nicht so gravierend, aber das Lesen und Zurückschreiben von Daten von einer Festplatte in den Arbeitsspeicher ist ein schwerwiegender Engpass und ein Feld, in dem Fehler auftreten können. Das Verschwinden dieses Schritts führt zu einer Vereinfachung der Anweisungen, einer Erhöhung der Einfachheit und Effizienz.Mit dem Rückgang der RAM-Preise in großen Unternehmen und Rechenzentren ist es populär geworden, Server mit Terabyte Speicher zu versorgen. Abgesehen von der Größe möchte die Datenbank im Speicher aus Gründen der Zuverlässigkeit normalerweise nicht aufbewahrt werden. RAM verliert Inhalt, wenn ein Stromausfall oder ein System gefährdet ist. Diese Probleme treten auf, wenn versucht wird, den Zuverlässigkeitsstandard der ACID-Datenbank einzuhalten (Atomizität, Konsistenz, Isolation, Haltbarkeit - Atomizität, Kohärenz, Isolation, Haltbarkeit).Probleme können mit Abgüssen und Protokollen vermieden werden. So wie Sie Datenbanksicherungen von Datenträgern erstellen können, können Datenbanken im Speicher in den Speicher kopiert werden. Durch das Erstellen von Casts wird verhindert, dass andere Prozesse Daten lesen. Die Häufigkeit von Haltepunkten ist daher ein Kompromiss zwischen Geschwindigkeit und Zuverlässigkeit. Dies kann wiederum durch Aufzeichnen von Transaktionen oder durch Protokollieren und Aufzeichnen von Datenänderungen ausgeglichen werden, sodass ein späterer Status aus einer früheren Kopie wiederhergestellt werden kann. Wenn sich die Datenbank jedoch vollständig im Speicher befindet, geht ein bestimmter Prozentsatz der Redundanz verloren.Mit Programmen zum Verwalten von Datenbanken im Speicher (IMDBS) können Sie Hybridsysteme erstellen, in denen sich einige Datenbanktabellen im Speicher befinden und andere auf der Festplatte gespeichert sind. Dies ist besser als das Zwischenspeichern und praktisch in Fällen, in denen es sinnlos ist, die gesamte Datenbank im Speicher zu halten.Datenbanken können komprimiert werden, insbesondere auf Systemen mit Spalten, in denen Tabellen als Spaltengruppen und nicht als Zeilen gespeichert sind. Die meisten Komprimierungstechnologien bevorzugen, dass benachbarte Daten vom gleichen Typ sind, und Spalten in Tabellen enthalten fast immer Daten vom gleichen Typ. Obwohl die Komprimierung eine höhere Rechenlast mit sich bringt, eignet sich das Speichern von Spalten gut für komplexe Abfragen in sehr großen Datenmengen. Deshalb interessieren sich Big-Data-Benutzer und Wissenschaftler dafür .Unternehmen wie Google haben in großem Umfang auf RAM umgestellt, sodass eine große Anzahl von Suchanfragen mit einer akzeptablen Geschwindigkeit verarbeitet wird. Es gibt auch Probleme beim Bereitstellen des Zugriffs auf große Speichermengen, da die mit einem Motherboard verbundene RAM-Größe begrenzt ist und die Organisation des gemeinsamen Zugriffs zu zusätzlichen Verzögerungen führt.

Eine Reihe moderner DRAM-Speicherzugriffsgeschwindigkeitenwerden in Nanosekunden gemessen, und die Festplattenzugriffszeit wird in Millisekunden gemessen - d. H. Der Speicher ist millionenfach schneller. Die Datenübertragungsgeschwindigkeit im Speicher ist natürlich nicht millionenfach schneller - dies sind Gigabyte pro Sekunde gegenüber mehreren hundert Megabyte pro Sekunde für schnelle Festplatten -, aber zumindest die RAM-Geschwindigkeit übersteigt die Geschwindigkeit der Laufwerke um eine Größenordnung.In der realen Welt sind die Unterschiede nicht so gravierend, aber das Lesen und Zurückschreiben von Daten von einer Festplatte in den Arbeitsspeicher ist ein schwerwiegender Engpass und ein Feld, in dem Fehler auftreten können. Das Verschwinden dieses Schritts führt zu einer Vereinfachung der Anweisungen, einer Erhöhung der Einfachheit und Effizienz.Mit dem Rückgang der RAM-Preise in großen Unternehmen und Rechenzentren ist es populär geworden, Server mit Terabyte Speicher zu versorgen. Abgesehen von der Größe möchte die Datenbank im Speicher aus Gründen der Zuverlässigkeit normalerweise nicht aufbewahrt werden. RAM verliert Inhalt, wenn ein Stromausfall oder ein System gefährdet ist. Diese Probleme treten auf, wenn versucht wird, den Zuverlässigkeitsstandard der ACID-Datenbank einzuhalten (Atomizität, Konsistenz, Isolation, Haltbarkeit - Atomizität, Kohärenz, Isolation, Haltbarkeit).Probleme können mit Abgüssen und Protokollen vermieden werden. So wie Sie Datenbanksicherungen von Datenträgern erstellen können, können Datenbanken im Speicher in den Speicher kopiert werden. Durch das Erstellen von Casts wird verhindert, dass andere Prozesse Daten lesen. Die Häufigkeit von Haltepunkten ist daher ein Kompromiss zwischen Geschwindigkeit und Zuverlässigkeit. Dies kann wiederum durch Aufzeichnen von Transaktionen oder durch Protokollieren und Aufzeichnen von Datenänderungen ausgeglichen werden, sodass ein späterer Status aus einer früheren Kopie wiederhergestellt werden kann. Wenn sich die Datenbank jedoch vollständig im Speicher befindet, geht ein bestimmter Prozentsatz der Redundanz verloren.Mit Programmen zum Verwalten von Datenbanken im Speicher (IMDBS) können Sie Hybridsysteme erstellen, in denen sich einige Datenbanktabellen im Speicher befinden und andere auf der Festplatte gespeichert sind. Dies ist besser als das Zwischenspeichern und praktisch in Fällen, in denen es sinnlos ist, die gesamte Datenbank im Speicher zu halten.Datenbanken können komprimiert werden, insbesondere auf Systemen mit Spalten, in denen Tabellen als Spaltengruppen und nicht als Zeilen gespeichert sind. Die meisten Komprimierungstechnologien bevorzugen, dass benachbarte Daten vom gleichen Typ sind, und Spalten in Tabellen enthalten fast immer Daten vom gleichen Typ. Obwohl die Komprimierung eine höhere Rechenlast mit sich bringt, eignet sich das Speichern von Spalten gut für komplexe Abfragen in sehr großen Datenmengen. Deshalb interessieren sich Big-Data-Benutzer und Wissenschaftler dafür .Unternehmen wie Google haben in großem Umfang auf RAM umgestellt, sodass eine große Anzahl von Suchanfragen mit einer akzeptablen Geschwindigkeit verarbeitet wird. Es gibt auch Probleme beim Bereitstellen des Zugriffs auf große Speichermengen, da die mit einem Motherboard verbundene RAM-Größe begrenzt ist und die Organisation des gemeinsamen Zugriffs zu zusätzlichen Verzögerungen führt.Leben nach dem RAM

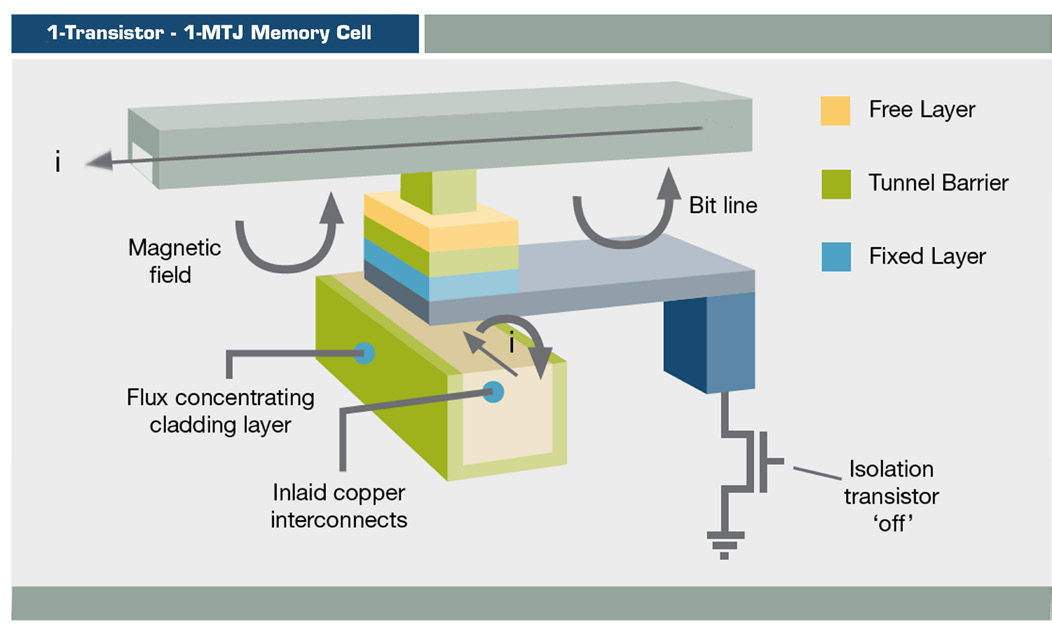

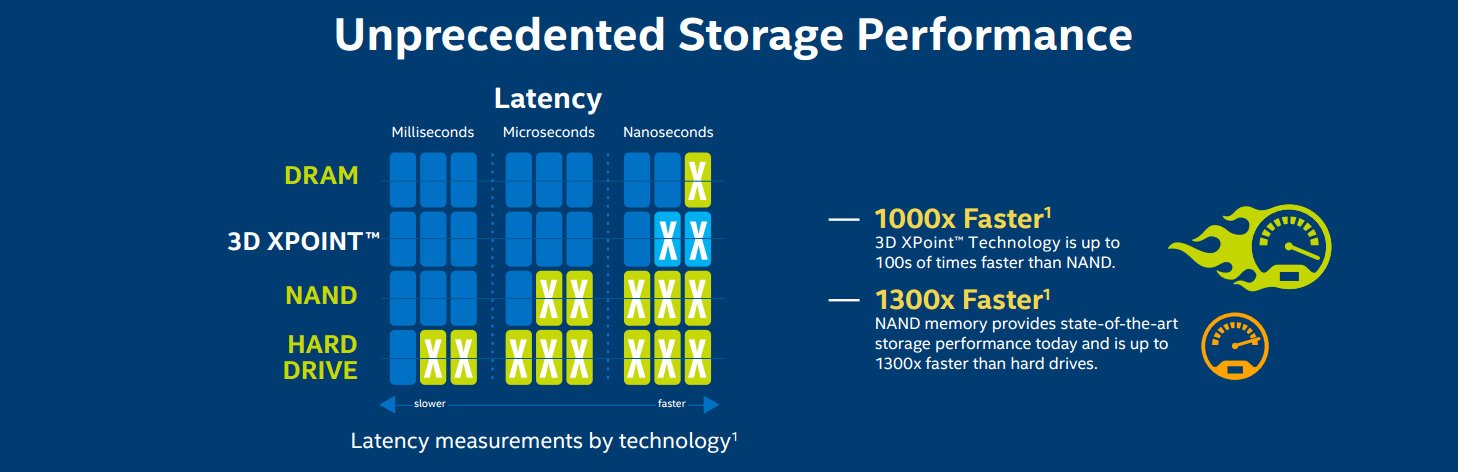

Sie können jedoch nicht garantieren, dass die Arbeit mit Daten im Speicher die Zukunft der Datenverarbeitung ist. Eine alternative Methode ist die Verwendung von nichtflüchtigem RAM (nichtflüchtiger RAM, NVRAM), der den Benutzern in Form von SSDs bekannt ist und eine mit Festplattensystemen kompatible Architektur bietet. Sie laufen jetzt auf einem NAND-Flash-Speicher, der im Vergleich zu mechanischen Festplatten hohe Lese- und Schreibgeschwindigkeiten bietet. Aber sie hat ihre eigenen Probleme. Der Flash-Speicher benötigt relativ hohe Spannungen, um Daten aufzuzeichnen, und er degeneriert allmählich, gegen die spezielle Algorithmen kämpfen müssen, was zu einer allmählichen Verlangsamung des Betriebs führt. Die Kosten für Speicher und Speicher im Laufe der Zeit (Dollar pro Megabyte)Wie Sie der Grafik entnehmen können, sinken die Kosten für Laufwerke im Laufe der Zeit ungefähr genauso wie die Kosten für RAM. Die sinkenden Kosten für SSDs haben zu ihrer Verteilung in Rechenzentren und Arbeitsplätzen geführt. Bisher ist jedoch nicht klar, wie die Zukunft dieser Technologie aussehen wird. Eine im Februar 2016 veröffentlichte Studie von Google, die auf einer Nutzungsdauer von sechs Jahren basiert, kam zu dem Schluss, dass Flash-Speicher viel weniger zuverlässig sind als Festplatten - zum Beispiel schwerwiegende Fehler - obwohl seltenere Ersetzungen erforderlich sind. Und SSDs für den Unternehmensgebrauch unterscheiden sich in der Qualität nicht von den Verbraucheroptionen.Es erscheinen jedoch bereits neue NVRAM-Typen. Ferroelektrisches RAM (FRAM) sollte früher ein Ersatz für RAM und Flash-Laufwerke in Mobilgeräten sein, jetzt hat sich die Aufmerksamkeit auf magnetoresistives RAM (MRAM) verlagert. In Bezug auf die Geschwindigkeit nähert es sich dem RAM und die Zugriffsverzögerung beträgt 50 Nanosekunden - es ist langsamer als 10 ns im DRAM, aber 1000-mal schneller als Mikrosekunden im NAND.

Die Kosten für Speicher und Speicher im Laufe der Zeit (Dollar pro Megabyte)Wie Sie der Grafik entnehmen können, sinken die Kosten für Laufwerke im Laufe der Zeit ungefähr genauso wie die Kosten für RAM. Die sinkenden Kosten für SSDs haben zu ihrer Verteilung in Rechenzentren und Arbeitsplätzen geführt. Bisher ist jedoch nicht klar, wie die Zukunft dieser Technologie aussehen wird. Eine im Februar 2016 veröffentlichte Studie von Google, die auf einer Nutzungsdauer von sechs Jahren basiert, kam zu dem Schluss, dass Flash-Speicher viel weniger zuverlässig sind als Festplatten - zum Beispiel schwerwiegende Fehler - obwohl seltenere Ersetzungen erforderlich sind. Und SSDs für den Unternehmensgebrauch unterscheiden sich in der Qualität nicht von den Verbraucheroptionen.Es erscheinen jedoch bereits neue NVRAM-Typen. Ferroelektrisches RAM (FRAM) sollte früher ein Ersatz für RAM und Flash-Laufwerke in Mobilgeräten sein, jetzt hat sich die Aufmerksamkeit auf magnetoresistives RAM (MRAM) verlagert. In Bezug auf die Geschwindigkeit nähert es sich dem RAM und die Zugriffsverzögerung beträgt 50 Nanosekunden - es ist langsamer als 10 ns im DRAM, aber 1000-mal schneller als Mikrosekunden im NAND. MRAM-Schema MRAMspeichert Informationen unter Verwendung einer magnetischen Orientierung anstelle einer elektrischen Ladung unter Verwendung einer Dünnschichtstruktur und eines magnetischen Tunnelübergangs. Switching MRAM wird bereits in Produkten wie den EqualLogic-Speicherarrays von Dell verwendet, bisher jedoch nur für das Journaling.Spin Transfer MRAM (ST-MRAM) verwendet eine komplexere Struktur, die möglicherweise eine Erhöhung der Dichte ermöglicht. Jetzt bringt Everspin es auf den Markt, das kürzlich an der NASDAQ unter dem Code MRAM veröffentlicht wurde. Andere Firmen, die diese Gelegenheit nutzen, sind Crocus, Micron, Qualcomm, Samsung, Spin Transfer Technologies (STT) und Toshiba.

MRAM-Schema MRAMspeichert Informationen unter Verwendung einer magnetischen Orientierung anstelle einer elektrischen Ladung unter Verwendung einer Dünnschichtstruktur und eines magnetischen Tunnelübergangs. Switching MRAM wird bereits in Produkten wie den EqualLogic-Speicherarrays von Dell verwendet, bisher jedoch nur für das Journaling.Spin Transfer MRAM (ST-MRAM) verwendet eine komplexere Struktur, die möglicherweise eine Erhöhung der Dichte ermöglicht. Jetzt bringt Everspin es auf den Markt, das kürzlich an der NASDAQ unter dem Code MRAM veröffentlicht wurde. Andere Firmen, die diese Gelegenheit nutzen, sind Crocus, Micron, Qualcomm, Samsung, Spin Transfer Technologies (STT) und Toshiba. 3D XPoint-Speicher

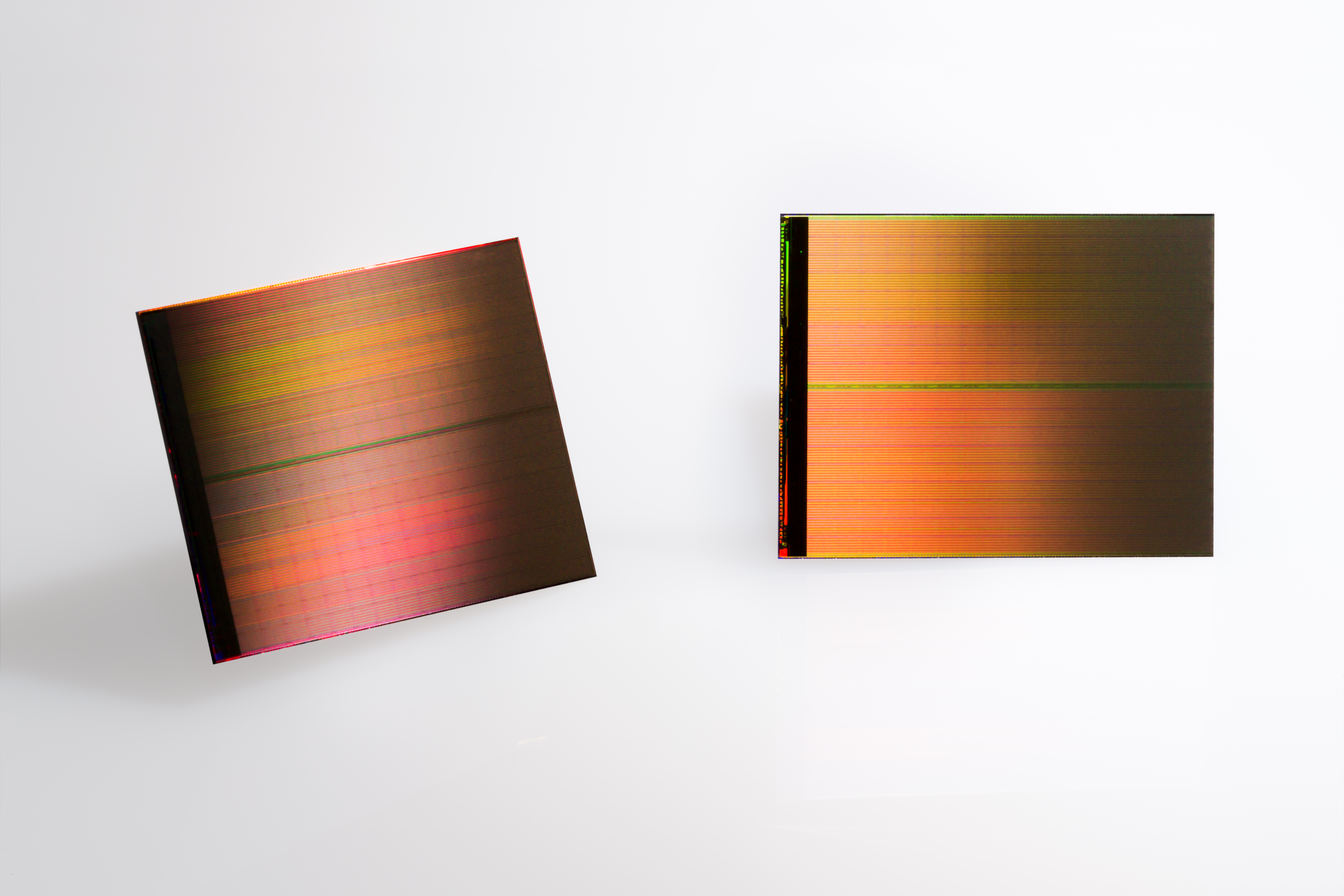

3D XPoint-Speicher Zwei 128 GB 3D XPoint- Chips

Zwei 128 GB 3D XPoint- Chips Diagramm für den Intel / Micron 3D XPoint-

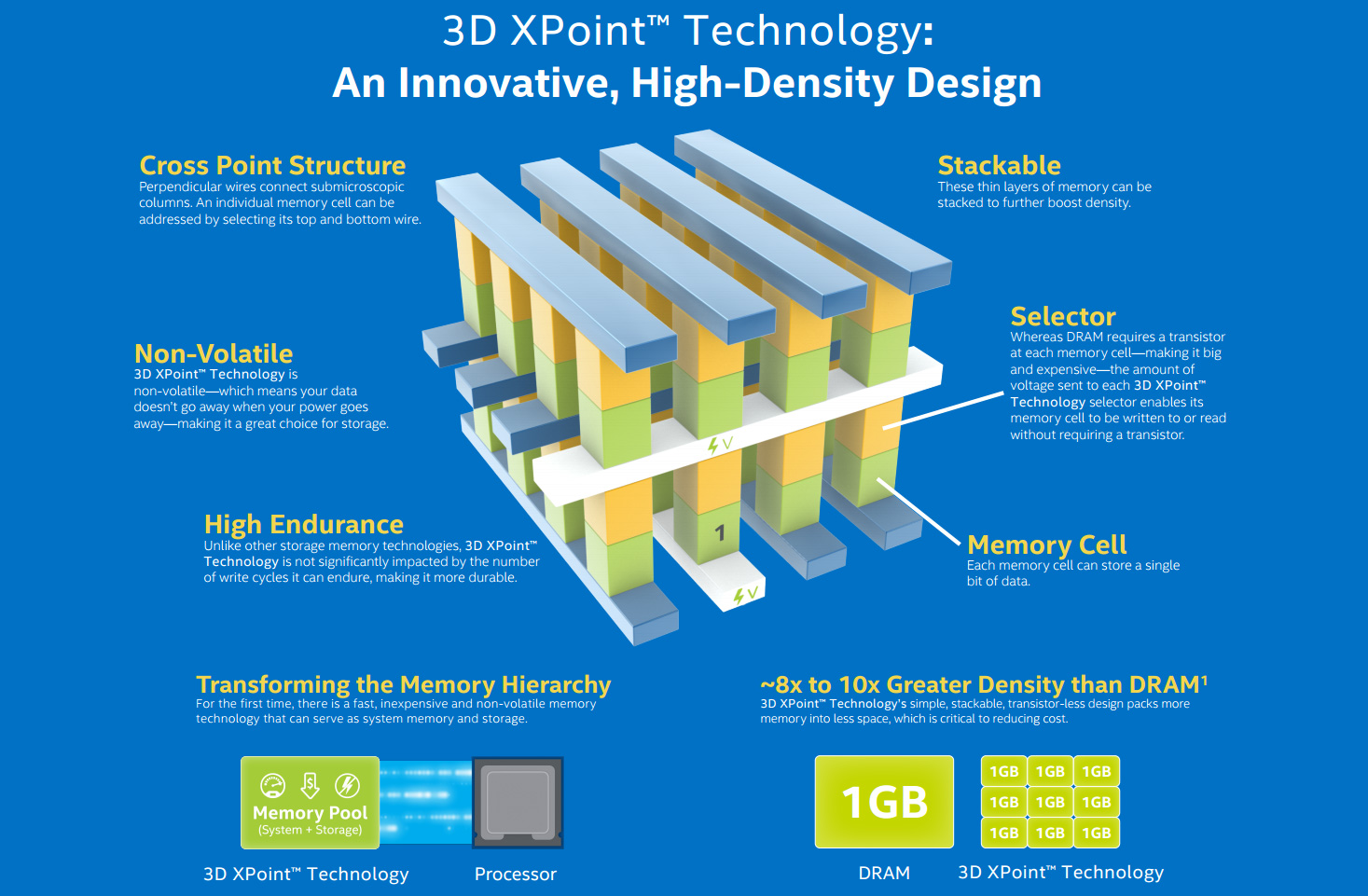

Diagramm für den Intel / Micron 3D XPoint- GeschwindigkeitsvergleichIn der Zwischenzeit arbeitet Intel mit Micron an einem NVRAM-Typ namens 3D XPoint (ausgesprochen „Crosspoint“). Diese Form des Phasenwechselspeichers (PCM), bekannt als Resistive RAM (ReRAM), wurde erstmals 2015 veröffentlicht. "3D" bedeutet die Möglichkeit der mehrschichtigen Konstruktion von Speicher. Intel geht davon aus, dass XPoint 1.000-mal schneller als NAND und zehnmal so umfangreich sein kann, obwohl diese Ansprüche in letzter Zeit leicht zurückgegangen sind. Der Preis wird voraussichtlich zwischen Flash und DRAM liegen. Aus diesem Grund ist es unwahrscheinlich, dass es in Privathaushalten Fuß fasst, aber im großen Maßstab kann es RAM und SSD ersetzen.IBM arbeitet auch am Phasenwechselspeicher. Wie Intel basiert ihre Technologie auf Chalkogenidglas, das in wiederbeschreibbaren optischen Medien verwendet wird. Das Unternehmen nutzt Elektrizität, um Material aus einem amorphen Zustand in einen der drei kristallinen umzuwandeln, und verfügt über einen Durchbruch bei den Kapazitäten, wodurch die Speicherkosten niedriger als bei DRAM sind.Das RAM-Rennen wirkt sich auf alle Ebenen der Computerentwicklung aus. Durch Erhöhen des Arbeitsspeichers von 8 auf 16 GB auf Endbenutzer-Desktops wird das Multitasking beschleunigt und die Effizienz speicherintensiver Programme erhöht.In Ultrabooks sind SSDs bereits die Norm, und wachsende Kapazitäten machen sie bereits zu Kandidaten für den Austausch von Festplatten. Die nächste Generation von dreidimensionalem NAND(V-NAND, vertikal) verspricht eine höhere Effizienz und Aufzeichnungsdichte. Samsung prognostiziert, dass es bis 2020 512-GB-SSDs für Endbenutzer zum Preis der heutigen Terabyte-Schraube geben wird.Für mittelständische Unternehmen und akademische Einrichtungen bedeutet billigeres RAM eine bessere Analyse der Daten im Speicher - wenn die Software damit Schritt hält. SAP HANA ist eine In-Memory-Datenbank, eine Plattform für den weit verbreiteten Einsatz von Cloud- und lokalen Lösungen, mit der kleinere Unternehmen mit Big Data arbeiten können. IBM und Oracle haben ähnliche Datenbanken.RAM demokratisiert Technologie - Technologie wird billiger und der Unterschied zwischen großen und kleinen Organisationen wird beseitigt.

GeschwindigkeitsvergleichIn der Zwischenzeit arbeitet Intel mit Micron an einem NVRAM-Typ namens 3D XPoint (ausgesprochen „Crosspoint“). Diese Form des Phasenwechselspeichers (PCM), bekannt als Resistive RAM (ReRAM), wurde erstmals 2015 veröffentlicht. "3D" bedeutet die Möglichkeit der mehrschichtigen Konstruktion von Speicher. Intel geht davon aus, dass XPoint 1.000-mal schneller als NAND und zehnmal so umfangreich sein kann, obwohl diese Ansprüche in letzter Zeit leicht zurückgegangen sind. Der Preis wird voraussichtlich zwischen Flash und DRAM liegen. Aus diesem Grund ist es unwahrscheinlich, dass es in Privathaushalten Fuß fasst, aber im großen Maßstab kann es RAM und SSD ersetzen.IBM arbeitet auch am Phasenwechselspeicher. Wie Intel basiert ihre Technologie auf Chalkogenidglas, das in wiederbeschreibbaren optischen Medien verwendet wird. Das Unternehmen nutzt Elektrizität, um Material aus einem amorphen Zustand in einen der drei kristallinen umzuwandeln, und verfügt über einen Durchbruch bei den Kapazitäten, wodurch die Speicherkosten niedriger als bei DRAM sind.Das RAM-Rennen wirkt sich auf alle Ebenen der Computerentwicklung aus. Durch Erhöhen des Arbeitsspeichers von 8 auf 16 GB auf Endbenutzer-Desktops wird das Multitasking beschleunigt und die Effizienz speicherintensiver Programme erhöht.In Ultrabooks sind SSDs bereits die Norm, und wachsende Kapazitäten machen sie bereits zu Kandidaten für den Austausch von Festplatten. Die nächste Generation von dreidimensionalem NAND(V-NAND, vertikal) verspricht eine höhere Effizienz und Aufzeichnungsdichte. Samsung prognostiziert, dass es bis 2020 512-GB-SSDs für Endbenutzer zum Preis der heutigen Terabyte-Schraube geben wird.Für mittelständische Unternehmen und akademische Einrichtungen bedeutet billigeres RAM eine bessere Analyse der Daten im Speicher - wenn die Software damit Schritt hält. SAP HANA ist eine In-Memory-Datenbank, eine Plattform für den weit verbreiteten Einsatz von Cloud- und lokalen Lösungen, mit der kleinere Unternehmen mit Big Data arbeiten können. IBM und Oracle haben ähnliche Datenbanken.RAM demokratisiert Technologie - Technologie wird billiger und der Unterschied zwischen großen und kleinen Organisationen wird beseitigt. Google Data Center mit benutzerdefinierten Servern

Google Data Center mit benutzerdefinierten Servern Sequoia Supercomputer

Sequoia Supercomputer

Supercomputer Sunway TaihuLight, der schnellste Computer der Welt, 93 Petan Flops

Supercomputer Sunway TaihuLight, der schnellste Computer der Welt, 93 Petan Flops Titan, der schnellste Supercomputer in den USA

Titan, der schnellste Supercomputer in den USA EcoPod HP-RechenzentrumNicht zuletzt geht es um die Notwendigkeit eines Supercomputerspeichers. Der schnellste chinesische Sunway TaihuLight SC enthält derzeit 1.300 TB DDR3-DRAM, was für seine Geschwindigkeit von 93 Petaflops (Billiarden Gleitkommaoperationen pro Sekunde) relativ gering ist. Insbesondere aus diesem Grund beträgt der Energieverbrauch nur 15,3 MW, dies kann jedoch zu einem begrenzenden Faktor werden.Jetzt streben alle nach den Präfix-Exaflops oder 1000 Petaflops. Der von Riken und Fujitsu entwickelte japanische Post-K-Computer wird bis 2020 fertig sein und den Hybrid Memory Cube von Micron, eine mehrschichtige Implementierung von DRAM, enthalten und möglicherweise auch 3D XPoint NVRAM verwenden. Das europäische Projekt NEXTGenIO am Edinburgh Supercomputer Centre will bis 2022 Exaflops erzielen, auch mit 3D XPoint.In den USA soll das im Rahmen der NSCI-Initiative entwickelte Exascale Computing-Projekt bis 2023 zwei Supercomputer mit ähnlicher Geschwindigkeit vorstellen. Ihre Architektur wird noch entwickelt, aber da Geschwindigkeit und Energieeffizienz Priorität haben, wird RAM eine zentrale Rolle dabei spielen.

EcoPod HP-RechenzentrumNicht zuletzt geht es um die Notwendigkeit eines Supercomputerspeichers. Der schnellste chinesische Sunway TaihuLight SC enthält derzeit 1.300 TB DDR3-DRAM, was für seine Geschwindigkeit von 93 Petaflops (Billiarden Gleitkommaoperationen pro Sekunde) relativ gering ist. Insbesondere aus diesem Grund beträgt der Energieverbrauch nur 15,3 MW, dies kann jedoch zu einem begrenzenden Faktor werden.Jetzt streben alle nach den Präfix-Exaflops oder 1000 Petaflops. Der von Riken und Fujitsu entwickelte japanische Post-K-Computer wird bis 2020 fertig sein und den Hybrid Memory Cube von Micron, eine mehrschichtige Implementierung von DRAM, enthalten und möglicherweise auch 3D XPoint NVRAM verwenden. Das europäische Projekt NEXTGenIO am Edinburgh Supercomputer Centre will bis 2022 Exaflops erzielen, auch mit 3D XPoint.In den USA soll das im Rahmen der NSCI-Initiative entwickelte Exascale Computing-Projekt bis 2023 zwei Supercomputer mit ähnlicher Geschwindigkeit vorstellen. Ihre Architektur wird noch entwickelt, aber da Geschwindigkeit und Energieeffizienz Priorität haben, wird RAM eine zentrale Rolle dabei spielen.Source: https://habr.com/ru/post/de398373/

All Articles