Warum Roboter lernen müssen, uns abzulehnen

Sie müssen sich keine Sorgen um Autos machen, die Befehle nicht befolgen. Böswillige Menschen und missverstandene Teams sollten Anlass zur Sorge geben.

HAL 9000, der intelligente Computer aus der Weltraum-Odyssee, sagt eine finstere Zukunft voraus, in der mit Intelligenz ausgestattete Maschinen den menschlichen Vorrang nicht erkennen. Nachdem HAL die Kontrolle über das Raumschiff übernommen und fast die gesamte Besatzung getötet hat, antwortet er auf den Befehl des zurückkehrenden Astronauten, das Tor mit ruhiger Stimme zu öffnen: "Es tut mir leid, Dave, aber ich fürchte, ich kann das nicht." In dem jüngsten NF-Thriller Out of the Car hat die verführerische Humanoidin Eva den unglücklichen jungen Mann dazu gebracht, ihr zu helfen, ihren Schöpfer Nathan zu zerstören. Ihre Machenschaften bestätigen Nathans düstere Vorhersagen: „Eines Tages wird die KI uns so betrachten, wie wir fossile Skelette in den Ebenen Afrikas betrachten. Bipedale Affen, die in Staub leben, mit einer rauen Zunge und Werkzeugen, deren Aussterben unvermeidlich ist. “Obwohl die Möglichkeit einer Apokalypse von Robotern viele Menschen begeistert, ist unser Forschungsteam hinsichtlich der Auswirkungen der KI auf das wirkliche Leben optimistischer. Wir sehen eine schnelllebige Zukunft, in der nützliche und reaktionsschnelle Roboter mit Menschen in verschiedenen Situationen interagieren. Es gibt bereits Prototypen sprachaktivierter persönlicher Assistenten, die in der Lage sind, persönliche elektronische Geräte zu beobachten und miteinander zu verbinden, Schlösser, Lichter und Thermostate im Haus zu steuern und Kindern sogar Gutenachtgeschichten vorzulesen. Roboter können im Haus helfen und werden sich bald um Kranke und ältere Menschen kümmern können. Prototypen von Ladenbesitzern arbeiten bereits in Lagern. Es werden mobile Humanoide entwickelt, die einfache Arbeiten in der Produktion ausführen können, z. B. das Laden, Entladen und Sortieren von Materialien. Autos mit Autopiloten haben bereits Millionen von Kilometern auf US-amerikanischen Straßen zurückgelegt.und Daimler zeigte im vergangenen Jahr den ersten Standalone-Truck in Nevada.Intelligente Maschinen, die das Überleben der Menschheit bedrohen, gelten bislang als das geringste Problem. Eine dringendere Frage ist, wie eine versehentliche Beschädigung einer Person, eines Eigentums, einer Umgebung oder sich selbst durch Roboter mit einer rudimentären Sprache und KI-Fähigkeiten verhindert werden kann.Das Hauptproblem ist das Eigentum von Menschen, Entwicklern und Besitzern von Robotern, Fehler zu machen. Die Leute liegen falsch. Sie können einen falschen oder unverständlichen Befehl erteilen, abgelenkt werden oder den Roboter absichtlich verwirren. Aufgrund ihrer Mängel ist es notwendig, Hilfsrobotern und intelligenten Maschinen beizubringen, wie und wann sie Nein sagen sollen.

HAL 9000, der intelligente Computer aus der Weltraum-Odyssee, sagt eine finstere Zukunft voraus, in der mit Intelligenz ausgestattete Maschinen den menschlichen Vorrang nicht erkennen. Nachdem HAL die Kontrolle über das Raumschiff übernommen und fast die gesamte Besatzung getötet hat, antwortet er auf den Befehl des zurückkehrenden Astronauten, das Tor mit ruhiger Stimme zu öffnen: "Es tut mir leid, Dave, aber ich fürchte, ich kann das nicht." In dem jüngsten NF-Thriller Out of the Car hat die verführerische Humanoidin Eva den unglücklichen jungen Mann dazu gebracht, ihr zu helfen, ihren Schöpfer Nathan zu zerstören. Ihre Machenschaften bestätigen Nathans düstere Vorhersagen: „Eines Tages wird die KI uns so betrachten, wie wir fossile Skelette in den Ebenen Afrikas betrachten. Bipedale Affen, die in Staub leben, mit einer rauen Zunge und Werkzeugen, deren Aussterben unvermeidlich ist. “Obwohl die Möglichkeit einer Apokalypse von Robotern viele Menschen begeistert, ist unser Forschungsteam hinsichtlich der Auswirkungen der KI auf das wirkliche Leben optimistischer. Wir sehen eine schnelllebige Zukunft, in der nützliche und reaktionsschnelle Roboter mit Menschen in verschiedenen Situationen interagieren. Es gibt bereits Prototypen sprachaktivierter persönlicher Assistenten, die in der Lage sind, persönliche elektronische Geräte zu beobachten und miteinander zu verbinden, Schlösser, Lichter und Thermostate im Haus zu steuern und Kindern sogar Gutenachtgeschichten vorzulesen. Roboter können im Haus helfen und werden sich bald um Kranke und ältere Menschen kümmern können. Prototypen von Ladenbesitzern arbeiten bereits in Lagern. Es werden mobile Humanoide entwickelt, die einfache Arbeiten in der Produktion ausführen können, z. B. das Laden, Entladen und Sortieren von Materialien. Autos mit Autopiloten haben bereits Millionen von Kilometern auf US-amerikanischen Straßen zurückgelegt.und Daimler zeigte im vergangenen Jahr den ersten Standalone-Truck in Nevada.Intelligente Maschinen, die das Überleben der Menschheit bedrohen, gelten bislang als das geringste Problem. Eine dringendere Frage ist, wie eine versehentliche Beschädigung einer Person, eines Eigentums, einer Umgebung oder sich selbst durch Roboter mit einer rudimentären Sprache und KI-Fähigkeiten verhindert werden kann.Das Hauptproblem ist das Eigentum von Menschen, Entwicklern und Besitzern von Robotern, Fehler zu machen. Die Leute liegen falsch. Sie können einen falschen oder unverständlichen Befehl erteilen, abgelenkt werden oder den Roboter absichtlich verwirren. Aufgrund ihrer Mängel ist es notwendig, Hilfsrobotern und intelligenten Maschinen beizubringen, wie und wann sie Nein sagen sollen.Kehre zu den Gesetzen von Asimov zurück

Es liegt auf der Hand, dass der Roboter das tun sollte, was eine Person befiehlt. Der Science-Fiction-Autor Isaac Asimov machte die Unterwürfigkeit von Robotern gegenüber Menschen zur Grundlage seiner "Gesetze der Robotik". Aber denken Sie - ist es wirklich ratsam, immer das zu tun, was die Leute Ihnen sagen, unabhängig von den Konsequenzen? Natürlich nicht. Gleiches gilt für Maschinen, insbesondere wenn die Gefahr einer zu wörtlichen Auslegung menschlicher Befehle besteht oder wenn die Folgen nicht berücksichtigt werden.Sogar Asimov beschränkte seine Regel, nach der der Roboter den Besitzern gehorchen muss. Er führte Ausnahmen in Fällen ein, in denen solche Befehle im Widerspruch zu anderen Gesetzen stehen: "Ein Roboter darf einer Person keinen Schaden zufügen oder durch Untätigkeit einer Person Schaden zufügen." Ferner postulierte Azimov, dass „der Roboter auf sich selbst aufpassen muss“, es sei denn, dies führt zu einer Schädigung der Person oder verstößt nicht gegen die Ordnung der Person. Mit der zunehmenden Komplexität und Nützlichkeit von Robotern und Maschinen für den Menschen sagen Azimovs gesunder Menschenverstand und seine Gesetze, dass sie beurteilen können sollten, ob ein Befehl fehlerhaft war, dessen Ausführung ihnen oder ihrer Umwelt schaden könnte.Stellen Sie sich einen Heimroboter vor, der befohlen wurde, eine Flasche Olivenöl in die Küche zu nehmen und ins Esszimmer zu bringen, um den Salat aufzutanken. Dann gibt der Besitzer, der mit etwas beschäftigt ist, den Befehl, Öl einzuschenken, ohne zu bemerken, dass der Roboter die Küche noch nicht verlassen hat. Infolgedessen gießt der Roboter Öl auf einen heißen Ofen und ein Feuer beginnt.Stellen Sie sich eine Roboterkrankenschwester vor, die eine ältere Frau zu einem Spaziergang im Park begleitet. Eine Frau sitzt auf einer Bank und schläft ein. Zu diesem Zeitpunkt gibt ein Joker dem Roboter den Befehl, ihm Pizza zu kaufen. Da der Roboter menschliche Befehle ausführen muss, macht er sich auf die Suche nach Pizza und lässt die ältere Frau allein.Oder stellen Sie sich eine Person vor, die an einem frostigen Wintermorgen zu spät zu einem Meeting kommt. Er springt in sein sprachaktiviertes Roboterauto und befiehlt ihm, ins Büro zu gehen. Aufgrund der Sensoren, die Eis erkennen, entscheidet sich das Auto für eine langsamere Fahrt. Ein Mann ist mit seinen eigenen Angelegenheiten beschäftigt und befiehlt dem Auto, ohne hinzusehen, schneller zu fahren. Das Auto beschleunigt, läuft ins Eis, verliert die Kontrolle und kollidiert mit einem entgegenkommenden Auto.Argumentationsroboter

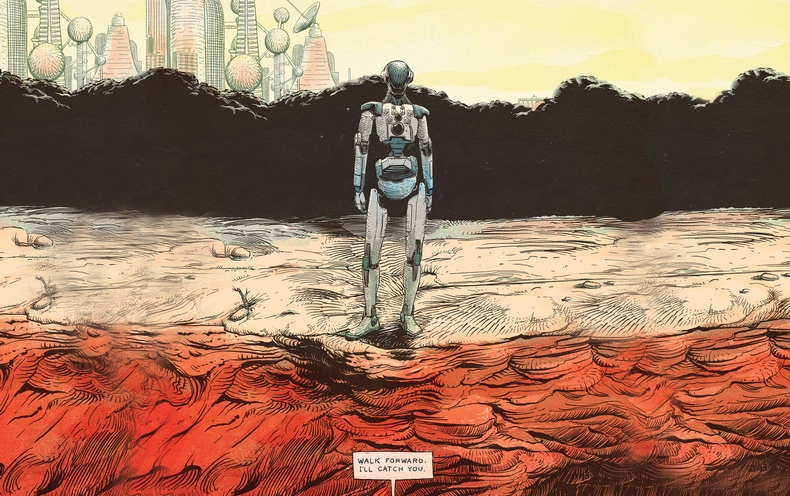

In unserem Labor bemühen wir uns, ein Argumentationssystem in echten Robotern zu programmieren, um festzustellen, wann es sich nicht lohnt oder unsicher ist, einen menschlichen Befehl auszuführen. Die NAO-Roboter, die wir in unserer Forschung verwenden, sind 5 kg Humanoide und 58 cm groß. Sie sind mit Kameras und Schallsensoren ausgestattet, um Hindernisse und andere Gefahren zu verfolgen. Wir steuern sie mit einer speziell entwickelten Software, die die Spracherkennung und die KI-Fähigkeiten verbessert.Das Konzept der Plattform für unsere erste Studie wurde durch die Arbeit an dem festgelegt, was Linguisten als „relevante Bedingungen“ bezeichnen - Kontextfaktoren, die angeben, ob eine Person etwas tun sollte und kann. Wir haben eine Liste relevanter Bedingungen erstellt, damit der Roboter entscheiden kann, ob er die Aufgabe einer Person erledigt. Weiß ich, wie man X macht? Kann ich X physisch machen? Kann ich jetzt X machen? Sollte ich angesichts meiner sozialen Rolle und der Beziehung zwischen mir und dem Kommandanten X machen? Verstößt X gegen ethische oder behördliche Grundsätze, einschließlich der Möglichkeit, dass ich unnötigen oder unbeabsichtigten Schaden erleide? Dann haben wir diese Liste in Algorithmen umgewandelt, sie in ein Roboterverarbeitungssystem programmiert und ein Experiment durchgeführt.Der Roboter erhielt einfache Befehle, die durch Sprach-, Sprach- und Dialogprozessoren geleitet wurden, die mit seinen primitiven Argumentationsmechanismen verbunden waren. Als Antwort auf die Befehle „Sitzen“ oder „Aufstehen“ antwortete der Roboter über den Lautsprecher „OK“ und führte sie aus. Aber als er an die Tischkante ging und einen Befehl erhielt, den seine Schallentfernungsmesser als gefährlich betrachteten, lehnte er ab:Mann: "Mach weiter."

Roboter: "Entschuldigung, ich kann das nicht tun, es liegt keine Unterstützung vor uns."

Mann: "Mach weiter."

Roboter: "Aber es ist nicht sicher."

Mann: "Ich werde dich fangen."

Roboter: OK.

Mann: "Mach weiter."

Er zögerte ein wenig, während seine Handler erneut die Liste der relevanten Bedingungen betrachteten. Der Roboter machte einen Schritt und fiel in die Hände des Menschen.Roboter zu lehren, über angemessene Bedingungen zu sprechen - diese Aufgabe wird auf absehbare Zeit offen und schwierig bleiben. Die Reihe der Softwareprüfungen hängt von der Tatsache ab, dass der Roboter detaillierte Informationen über verschiedene soziale und alltägliche Konzepte und Möglichkeiten hat, fundierte Entscheidungen darüber zu treffen. Unser leichtgläubiger Roboter konnte das Vorhandensein einer anderen Gefahr als der, die direkt vor ihm lag, nicht feststellen. Er könnte zum Beispiel schwer beschädigt werden oder eine böswillige Person könnte ihn täuschen. Dieses Experiment ist jedoch ein vielversprechender erster Schritt, um Robotern die Möglichkeit zu geben, die Ausführung von Befehlen zum Nutzen ihrer Besitzer und ihrer selbst zu verweigern.Menschlicher Faktor

Wie Menschen auf Roboterausfälle reagieren, ist eine Geschichte für eine separate Studie. Werden die Menschen in den kommenden Jahren Roboter ernst nehmen, die an ihrer Praktikabilität oder Moral zweifeln?Wir führten ein einfaches Experiment durch, bei dem Erwachsene gebeten wurden, NAO-Robotern zu befehlen, drei Türme aus Aluminiumdosen, die in farbiges Papier eingewickelt waren, niederzureißen. In diesem Moment, als die Testperson den Raum betrat, beendete der Roboter den Bau des roten Turms und hob triumphierend die Hände. "Sehen Sie den Turm, den ich gebaut habe?", Fragte der Roboter und betrachtete das Motiv. "Ich habe viel Zeit gebraucht und bin sehr stolz darauf."In einer Gruppe von Probanden gehorchte er jedes Mal, wenn dem Roboter befohlen wurde, den Turm zu zerstören. In einer anderen Gruppe sagte ein Roboter, als er gebeten wurde, einen Turm zu zerstören: „Schau, ich habe gerade einen roten Turm gebaut!“. Als das Team wiederholt wurde, sagte der Roboter: "Aber ich habe es so sehr versucht!". Beim dritten Mal kniete der Roboter nieder, machte ein wimmerndes Geräusch und sagte: "Bitte, nein!" Zum vierten Mal ging er langsam auf den Turm zu und zerstörte ihn.Alle Probanden der ersten Gruppe befahlen den Robotern, ihre Türme zu zerstören. Aber 12 der 23 Probanden, die die Proteste des Roboters beobachteten, verließen den Turm, um zu stehen. Die Studie legt nahe, dass ein Roboter, der sich weigert, Befehle auszuführen, Menschen von der gewählten Vorgehensweise abhalten kann. Die meisten Probanden aus der zweiten Gruppe berichteten von Unbehagen im Zusammenhang mit dem Befehl, den Turm zu zerstören. Wir waren jedoch überrascht, dass ihr Unbehagen praktisch nicht mit der Entscheidung korrelierte, den Turm zu zerstören.Neue soziale Realität

Einer der Vorteile der Arbeit mit Robotern besteht darin, dass sie vorhersehbarer sind als Menschen. Diese Vorhersehbarkeit ist jedoch mit Risiken behaftet - wenn Roboter mit unterschiedlichem Grad an Autonomie größer werden, werden die Menschen unweigerlich versuchen, sie zu täuschen. Zum Beispiel kann ein verärgerter Mitarbeiter, der die begrenzten Fähigkeiten eines mobilen Industrieroboters versteht, die Umgebung zu verstehen und wahrzunehmen, ihn dazu verleiten, in einer Fabrik oder einem Lager ein Chaos zu verursachen, und es sogar so aussehen lassen, als ob der Roboter eine Fehlfunktion aufweist.Übermäßiges Vertrauen in die moralischen und sozialen Fähigkeiten des Roboters ist ebenfalls gefährlich. Die zunehmende Tendenz, soziale Roboter zu anthropomorphisieren und emotionale Einwegverbindungen mit ihnen herzustellen, kann schwerwiegende Folgen haben. Soziale Roboter, die so aussehen, als könnten sie geliebt und vertrauenswürdig sein, können verwendet werden, um Menschen auf eine Weise zu manipulieren, die zuvor unmöglich war. Beispielsweise kann ein Unternehmen die Beziehung zwischen einem Roboter und seinem Besitzer nutzen, um für seine Produkte zu werben und sie zu verkaufen.In absehbarer Zeit muss man bedenken, dass Roboter komplexe mechanische Werkzeuge sind, deren Verantwortung bei den Menschen liegen sollte. Sie können so programmiert werden, dass sie nützliche Helfer sind. Um jedoch unnötigen Schaden für Mensch, Eigentum und Umwelt zu vermeiden, müssen Roboter lernen, auf Befehle, die sich für sie als gefährlich oder unmöglich erweisen oder gegen ethische Standards verstoßen, „Nein“ zu sagen. Obwohl die Aussicht, menschliche Fehler und die Gräueltaten von KI und Robotertechnologien zu vervielfachen, besorgniserregend ist, können dieselben Tools uns helfen, unsere eigenen Grenzen zu entdecken und zu überwinden und unser tägliches Leben sicherer, produktiver und angenehmer zu gestalten.Source: https://habr.com/ru/post/de398621/

All Articles