Google Neural Network formatiert Echtzeitbilder nach dem Zufallsprinzip

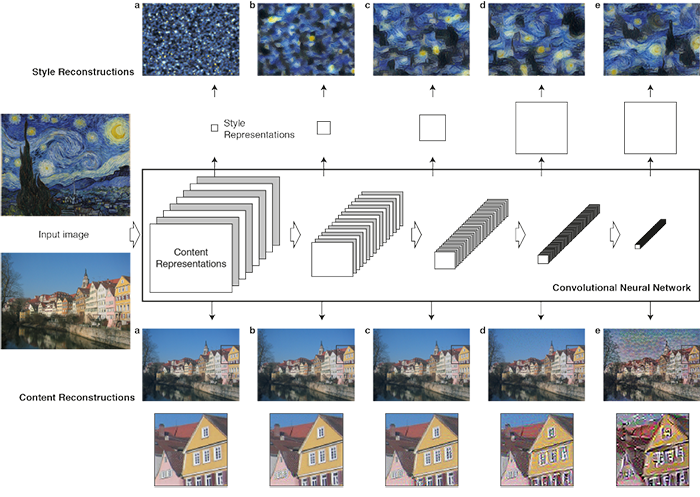

Das neuronale Netzwerk von Google überlagert einen der 32 trainierten Stile auf dem Foto (fünf werden hier angezeigt). Das Programm ist anspruchslos in Bezug auf Hardware und Speicher. Der Code wird in Kürze veröffentlicht.Synthese von Texturen mit Übertragung des Stils von einem Bild auf ein anderes - eine bekannte Technik, die 15 Jahre alt ist. Es wurde erstmals im Artikel „ Analogies in Image “ einer Gruppe von Forschern von Microsoft Research für die SIGGRAPH 2001-Konferenz sowie im Artikel „ Image Padding for Texture Synthesis and Transfer “ von Mitsubishi Electric Research und der University of California in Berkeley im selben Jahr 2001 beschrieben. Jetzt ist es schwer zu sagen, welches früher aufgetaucht ist.Im Jahr 2015 erhielt die Technik ein zweites Leben, als neuronale Netze mit der Synthese von Bildern mit Stilübertragung verbunden wurden. Es geschah nach der wissenschaftliche Arbeit „ neuroalgorithms künstlerischer Stil “ Getisa, Ecker und Bethge von der Universität Eberhard-Karls Tübingen, Deutschland ( Artikel auf Geektimes ). Die Arbeit ist so beeindruckend, dass der beschriebene Algorithmus bald in mehreren Computerprogrammen für den Verbrauchermarkt implementiert wurde, einschließlich mobiler Anwendungen wie dem russischen Prisma (Juni 2016).Die Arbeit von Gatis, Ecker und Betge ist gut, weil die Autoren das neuronale Netzwerk auf die vorhandenen Werke berühmter Künstler trainiert haben: Vincent Van Gogh, Pablo Picasso, Edward Munch und andere. Gleichzeitig kann das neuronale Netzwerk weiterhin an anderen Datensätzen trainiert werden, sodass dies ein universelles Werkzeug ist. Es ist ein solches neuronales Netzwerk, das auf dem Server von Prisma und anderen Unternehmen ausgeführt wird, die mobile Anwendungen verteilen, um Benutzerfotos zu stilisieren.Das Faltungs-Neuronale Netz von Getis, Ecker und Betge wurde auf der Grundlage des 19-lagigen VGG-Neuronalen Netzes von Simonyan und Zisserman erstelltund die Verarbeitung des Originalbildes erfolgt in mehreren Stufen. In jeder Phase der Hierarchie erhöht sich die Anzahl der Filter. Das Styling für einen bestimmten Stil erfolgt in den ersten Phasen des „Downsamplings“ (breite Striche, kubistische Muster usw.), und die letzten Schichten des neuronalen Netzwerks verarbeiten das Originalbild so, dass Objekte erkennbar bleiben ( d und e im Diagramm). Das neuronale Netzwerk beginnt an einer zufälligen Position (oder vom Originalbild) zu arbeiten, bis das Ergebnis die angegebenen Anforderungen erfüllt.

Das neuronale Netzwerk von Google überlagert einen der 32 trainierten Stile auf dem Foto (fünf werden hier angezeigt). Das Programm ist anspruchslos in Bezug auf Hardware und Speicher. Der Code wird in Kürze veröffentlicht.Synthese von Texturen mit Übertragung des Stils von einem Bild auf ein anderes - eine bekannte Technik, die 15 Jahre alt ist. Es wurde erstmals im Artikel „ Analogies in Image “ einer Gruppe von Forschern von Microsoft Research für die SIGGRAPH 2001-Konferenz sowie im Artikel „ Image Padding for Texture Synthesis and Transfer “ von Mitsubishi Electric Research und der University of California in Berkeley im selben Jahr 2001 beschrieben. Jetzt ist es schwer zu sagen, welches früher aufgetaucht ist.Im Jahr 2015 erhielt die Technik ein zweites Leben, als neuronale Netze mit der Synthese von Bildern mit Stilübertragung verbunden wurden. Es geschah nach der wissenschaftliche Arbeit „ neuroalgorithms künstlerischer Stil “ Getisa, Ecker und Bethge von der Universität Eberhard-Karls Tübingen, Deutschland ( Artikel auf Geektimes ). Die Arbeit ist so beeindruckend, dass der beschriebene Algorithmus bald in mehreren Computerprogrammen für den Verbrauchermarkt implementiert wurde, einschließlich mobiler Anwendungen wie dem russischen Prisma (Juni 2016).Die Arbeit von Gatis, Ecker und Betge ist gut, weil die Autoren das neuronale Netzwerk auf die vorhandenen Werke berühmter Künstler trainiert haben: Vincent Van Gogh, Pablo Picasso, Edward Munch und andere. Gleichzeitig kann das neuronale Netzwerk weiterhin an anderen Datensätzen trainiert werden, sodass dies ein universelles Werkzeug ist. Es ist ein solches neuronales Netzwerk, das auf dem Server von Prisma und anderen Unternehmen ausgeführt wird, die mobile Anwendungen verteilen, um Benutzerfotos zu stilisieren.Das Faltungs-Neuronale Netz von Getis, Ecker und Betge wurde auf der Grundlage des 19-lagigen VGG-Neuronalen Netzes von Simonyan und Zisserman erstelltund die Verarbeitung des Originalbildes erfolgt in mehreren Stufen. In jeder Phase der Hierarchie erhöht sich die Anzahl der Filter. Das Styling für einen bestimmten Stil erfolgt in den ersten Phasen des „Downsamplings“ (breite Striche, kubistische Muster usw.), und die letzten Schichten des neuronalen Netzwerks verarbeiten das Originalbild so, dass Objekte erkennbar bleiben ( d und e im Diagramm). Das neuronale Netzwerk beginnt an einer zufälligen Position (oder vom Originalbild) zu arbeiten, bis das Ergebnis die angegebenen Anforderungen erfüllt. Darstellungen von Inhalt und Stil sind im neuronalen Netzwerk voneinander getrennt. Somit können sie unabhängig voneinander gesteuert werden. Nehmen Sie beispielsweise Inhalte von einem Bild und Stile von einem anderen.

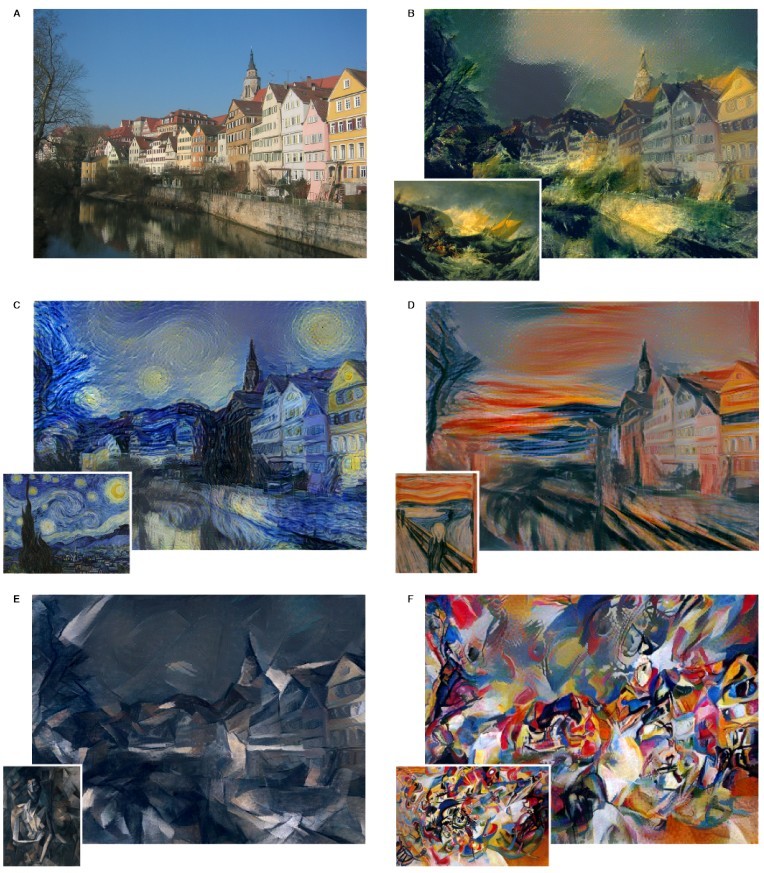

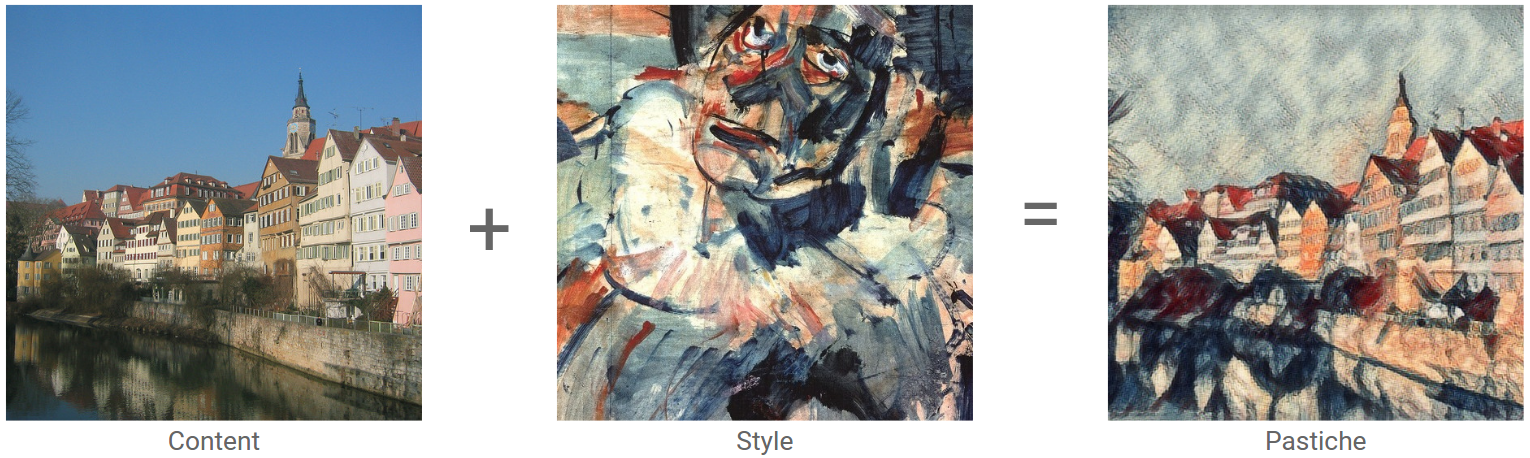

Darstellungen von Inhalt und Stil sind im neuronalen Netzwerk voneinander getrennt. Somit können sie unabhängig voneinander gesteuert werden. Nehmen Sie beispielsweise Inhalte von einem Bild und Stile von einem anderen. Beispiele für das Stylen von Bildern in den neuronalen Netzen von Gatis, Ecker und BetgeOriginalbild: Altstadt in Tübingen Stilbeispiel

Beispiele für das Stylen von Bildern in den neuronalen Netzen von Gatis, Ecker und BetgeOriginalbild: Altstadt in Tübingen Stilbeispiel : Gemälde „ Clownskopf “ (1907-1908), Georges Rouault, Stil: Expressionismus

: Gemälde „ Clownskopf “ (1907-1908), Georges Rouault, Stil: Expressionismus Das Ergebnis der Arbeit des neuronalen Netzes

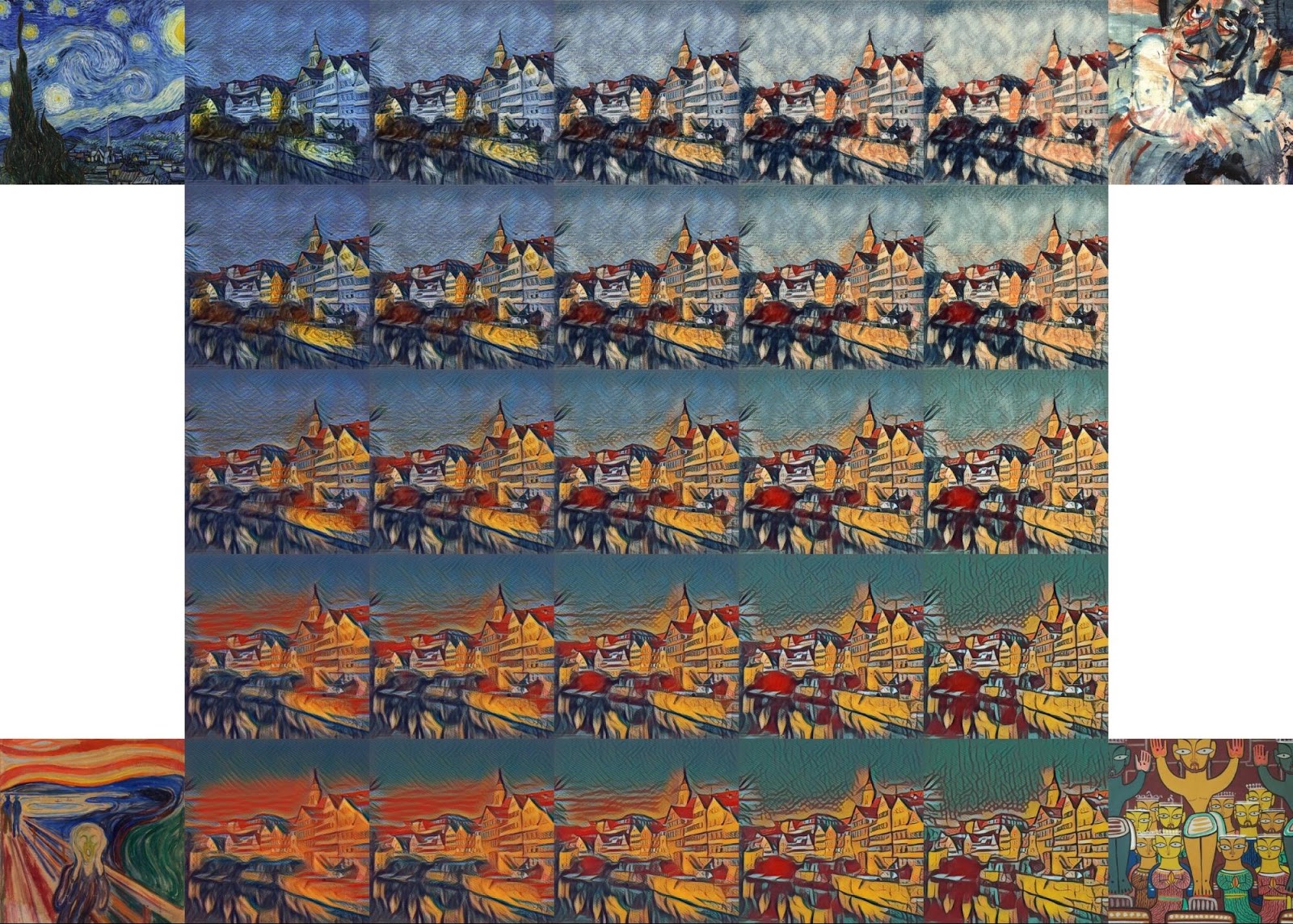

Das Ergebnis der Arbeit des neuronalen Netzes Diese Arbeit gilt als grundlegender Durchbruch in Deep-Learning-Technologien. denn dies ist der erste konzeptionelle Beweis für die Übertragung des künstlerischen Stils durch ein neuronales Netzwerk. Was als künstlerische Vision, als Stil und Genre des Autors angesehen wurde, wird erfolgreich formalisiert und von einem neuronalen Netzwerk aufgenommen. Künstliche Intelligenz beherrschte zunächst echte Kreativität.Die Idee, Stil und Inhalt des Bildes zu trennen, schuf eine Vielzahl neuronaler Netze, unter anderem zur Erzeugung erschreckender Bilderund zum Generieren von Porno-Bildern .Leider haben die neuronalen Netze Gatis, Ecker und Betge einen Nachteil: Ein solches neuronales Netz stellt zu hohe Anforderungen an die Rechenressourcen. Dies wurde nach der Veröffentlichung der ersten Demo-Anwendungen deutlich, die einige Minuten auf dem Server verarbeitet wurden.In späteren Arbeiten, auch von russischen Spezialisten , wurde das neuronale Netz aufgrund der eingeschränkten Funktionalität erheblich optimiert. Infolgedessen erreichte die Optimierung ein derartiges Ausmaß, dass anstelle einiger Minuten die Stilisierung des Fotos fast augenblicklich erfolgte. Es gab also die Möglichkeit, sogar Echtzeitvideos zu stilisieren !Aber eine solche Stilisierung hat eine Kehrseite der Medaille. Ultraschnelles Styling ist nur möglich, wenn ein Bild für das Sample aufgenommen wurde . Dies ist eine Einschränkung des ursprünglichen Algorithmus, da er nicht an einen Stil gebunden ist. Mit anderen Worten, wenn Sie ein System erstellen möchten, das 100 verschiedene Stile übertragen kann, müssen Sie 100 verschiedene neuronale Netze vorab trainieren.Jetzt hat Google zu dieser Forschung beigetragen. Am 24. Oktober 2016 veröffentlichten Mitarbeiter des Google Brain Team einen Artikel, in dem ein Algorithmus beschrieben wird, der genauso schnell wie die vorherigen arbeitet, jedoch gleichzeitig in einem einzigen universellen neuronalen Netzwerk, das alle erworbenen Stile auferlegen kann.nach den WortenEntwickler, ihr Algorithmus ist einfach zu implementieren und stellt keine hohen Anforderungen an den Arbeitsspeicher. Darüber hinaus kann er nach dem Training mehrerer Stile mehrere Stile gleichzeitig kombinieren und arbeitet in Echtzeit. Hier ist zum Beispiel ein Foto derselben Altstadt in Tübingen, auf dem vier Stile gleichzeitig überlagert sind .

Diese Arbeit gilt als grundlegender Durchbruch in Deep-Learning-Technologien. denn dies ist der erste konzeptionelle Beweis für die Übertragung des künstlerischen Stils durch ein neuronales Netzwerk. Was als künstlerische Vision, als Stil und Genre des Autors angesehen wurde, wird erfolgreich formalisiert und von einem neuronalen Netzwerk aufgenommen. Künstliche Intelligenz beherrschte zunächst echte Kreativität.Die Idee, Stil und Inhalt des Bildes zu trennen, schuf eine Vielzahl neuronaler Netze, unter anderem zur Erzeugung erschreckender Bilderund zum Generieren von Porno-Bildern .Leider haben die neuronalen Netze Gatis, Ecker und Betge einen Nachteil: Ein solches neuronales Netz stellt zu hohe Anforderungen an die Rechenressourcen. Dies wurde nach der Veröffentlichung der ersten Demo-Anwendungen deutlich, die einige Minuten auf dem Server verarbeitet wurden.In späteren Arbeiten, auch von russischen Spezialisten , wurde das neuronale Netz aufgrund der eingeschränkten Funktionalität erheblich optimiert. Infolgedessen erreichte die Optimierung ein derartiges Ausmaß, dass anstelle einiger Minuten die Stilisierung des Fotos fast augenblicklich erfolgte. Es gab also die Möglichkeit, sogar Echtzeitvideos zu stilisieren !Aber eine solche Stilisierung hat eine Kehrseite der Medaille. Ultraschnelles Styling ist nur möglich, wenn ein Bild für das Sample aufgenommen wurde . Dies ist eine Einschränkung des ursprünglichen Algorithmus, da er nicht an einen Stil gebunden ist. Mit anderen Worten, wenn Sie ein System erstellen möchten, das 100 verschiedene Stile übertragen kann, müssen Sie 100 verschiedene neuronale Netze vorab trainieren.Jetzt hat Google zu dieser Forschung beigetragen. Am 24. Oktober 2016 veröffentlichten Mitarbeiter des Google Brain Team einen Artikel, in dem ein Algorithmus beschrieben wird, der genauso schnell wie die vorherigen arbeitet, jedoch gleichzeitig in einem einzigen universellen neuronalen Netzwerk, das alle erworbenen Stile auferlegen kann.nach den WortenEntwickler, ihr Algorithmus ist einfach zu implementieren und stellt keine hohen Anforderungen an den Arbeitsspeicher. Darüber hinaus kann er nach dem Training mehrerer Stile mehrere Stile gleichzeitig kombinieren und arbeitet in Echtzeit. Hier ist zum Beispiel ein Foto derselben Altstadt in Tübingen, auf dem vier Stile gleichzeitig überlagert sind . Die Forscher glauben, dass ihre Arbeit neue Möglichkeiten für den kreativen Einsatz von Stilisierungs-Neuronalen Netzen eröffnet. In naher Zukunft versprechen sie, den Quellcode des Programms für TensorFlow auf dem Magenta-Blog zu veröffentlichen , damit jeder die Demo auf seinem Computer ausführen kann.Weitere Details zum Stylen von Bildern im neuronalen Netzwerk werden im populärwissenschaftlichen Video beschrieben.. Es wurde von zwei Mitarbeitern Nat und Lo in 20% ihrer Arbeitszeit aufgezeichnet, die Google für Projekte ihrer Wahl bereitstellt.

Die Forscher glauben, dass ihre Arbeit neue Möglichkeiten für den kreativen Einsatz von Stilisierungs-Neuronalen Netzen eröffnet. In naher Zukunft versprechen sie, den Quellcode des Programms für TensorFlow auf dem Magenta-Blog zu veröffentlichen , damit jeder die Demo auf seinem Computer ausführen kann.Weitere Details zum Stylen von Bildern im neuronalen Netzwerk werden im populärwissenschaftlichen Video beschrieben.. Es wurde von zwei Mitarbeitern Nat und Lo in 20% ihrer Arbeitszeit aufgezeichnet, die Google für Projekte ihrer Wahl bereitstellt.Source: https://habr.com/ru/post/de398703/

All Articles