Das neuronale Netzwerk liest 46,8% der Wörter auf den Lippen im Fernsehen, während nur 12,4%

Die Rahmen der vier Programme, in denen das Programm untersucht wurde, sowie das Wort "Nachmittag", das von zwei verschiedenen Sprechern ausgesprochen wurde.Vor zwei Wochen sprachen sie über das neuronale LipNet-Netzwerk , das eine Rekordqualität von 93,4% der menschlichen Spracherkennung auf den Lippen aufwies. Schon damals waren viele Anwendungen für solche Computersysteme vorgesehen: eine neue Generation medizinischer Hörgeräte mit Spracherkennung, Systeme für stille Vorträge an öffentlichen Orten, biometrische Identifizierung, Systeme zur geheimen Übertragung von Informationen für Spionage, Spracherkennung per Video von Überwachungskameras usw. Und jetzt berichteten Experten der Universität Oxford zusammen mit einem Google DeepMind-Mitarbeiter über ihre eigenen Entwicklungen in diesem Bereich.Das neue neuronale Netz wurde auf willkürlichen Texten von Personen trainiert, die auf dem BBC-Fernsehkanal agieren. Interessanterweise wurde das Training automatisch durchgeführt, ohne die Rede zuvor manuell zu kommentieren. Das System selbst erkannte Sprache, kommentierte das Video, fand Gesichter im Rahmen und lernte dann, die Beziehung zwischen Wörtern (Geräuschen) und Lippenbewegungen zu bestimmen.Infolgedessen erkennt dieses System effektiv beliebige Texte und nicht wie LipNet Instanzen aus dem speziellen Korpus von GRID-Sätzen. Der GRID-Fall hat eine streng begrenzte Struktur und ein streng begrenztes Vokabular, daher sind nur 33.000 Sätze möglich. Dadurch wird die Anzahl der Optionen um Größenordnungen reduziert und die Erkennung vereinfacht.Der spezielle GRID-Fall setzt sich wie folgt zusammen:Befehl (4) + Farbe (4) + Präposition (4) + Buchstabe (25) + Ziffer (10) + Adverb (4),wobei die Zahl der Anzahl der Wortvarianten für jede der sechs verbalen Kategorien entspricht.Im Gegensatz zu LipNet arbeitet die Entwicklung von DeepMind und Spezialisten der Universität Oxford an beliebigen Sprachströmen für die Fernsehbildqualität. Es ist viel mehr wie ein echtes System, das für den praktischen Gebrauch bereit ist.AI trainierte 5.000 Stunden Video, das von Januar 2010 bis Dezember 2015 von sechs Fernsehshows des britischen BBC-Fernsehsenders aufgezeichnet wurde: Dies sind regelmäßige Pressemitteilungen (1584 Stunden), Morgennachrichten (1997 Stunden), Newsnight-Shows (590 Stunden) und World News (194) Stunden), Fragestunde (323 Stunden) und World Today (272 Stunden). Insgesamt enthalten die Videos 118.116 Sätze kontinuierlicher menschlicher Sprache.Danach wurde das Programm in Sendungen überprüft, die zwischen März und September 2016 ausgestrahlt wurden.

Die Rahmen der vier Programme, in denen das Programm untersucht wurde, sowie das Wort "Nachmittag", das von zwei verschiedenen Sprechern ausgesprochen wurde.Vor zwei Wochen sprachen sie über das neuronale LipNet-Netzwerk , das eine Rekordqualität von 93,4% der menschlichen Spracherkennung auf den Lippen aufwies. Schon damals waren viele Anwendungen für solche Computersysteme vorgesehen: eine neue Generation medizinischer Hörgeräte mit Spracherkennung, Systeme für stille Vorträge an öffentlichen Orten, biometrische Identifizierung, Systeme zur geheimen Übertragung von Informationen für Spionage, Spracherkennung per Video von Überwachungskameras usw. Und jetzt berichteten Experten der Universität Oxford zusammen mit einem Google DeepMind-Mitarbeiter über ihre eigenen Entwicklungen in diesem Bereich.Das neue neuronale Netz wurde auf willkürlichen Texten von Personen trainiert, die auf dem BBC-Fernsehkanal agieren. Interessanterweise wurde das Training automatisch durchgeführt, ohne die Rede zuvor manuell zu kommentieren. Das System selbst erkannte Sprache, kommentierte das Video, fand Gesichter im Rahmen und lernte dann, die Beziehung zwischen Wörtern (Geräuschen) und Lippenbewegungen zu bestimmen.Infolgedessen erkennt dieses System effektiv beliebige Texte und nicht wie LipNet Instanzen aus dem speziellen Korpus von GRID-Sätzen. Der GRID-Fall hat eine streng begrenzte Struktur und ein streng begrenztes Vokabular, daher sind nur 33.000 Sätze möglich. Dadurch wird die Anzahl der Optionen um Größenordnungen reduziert und die Erkennung vereinfacht.Der spezielle GRID-Fall setzt sich wie folgt zusammen:Befehl (4) + Farbe (4) + Präposition (4) + Buchstabe (25) + Ziffer (10) + Adverb (4),wobei die Zahl der Anzahl der Wortvarianten für jede der sechs verbalen Kategorien entspricht.Im Gegensatz zu LipNet arbeitet die Entwicklung von DeepMind und Spezialisten der Universität Oxford an beliebigen Sprachströmen für die Fernsehbildqualität. Es ist viel mehr wie ein echtes System, das für den praktischen Gebrauch bereit ist.AI trainierte 5.000 Stunden Video, das von Januar 2010 bis Dezember 2015 von sechs Fernsehshows des britischen BBC-Fernsehsenders aufgezeichnet wurde: Dies sind regelmäßige Pressemitteilungen (1584 Stunden), Morgennachrichten (1997 Stunden), Newsnight-Shows (590 Stunden) und World News (194) Stunden), Fragestunde (323 Stunden) und World Today (272 Stunden). Insgesamt enthalten die Videos 118.116 Sätze kontinuierlicher menschlicher Sprache.Danach wurde das Programm in Sendungen überprüft, die zwischen März und September 2016 ausgestrahlt wurden.Ein Beispiel für das Lippenlesen von einem Fernsehbildschirm Das Programm zeigte eine ziemlich hohe Lesequalität. Sie erkannte auch sehr komplexe Sätze mit ungewöhnlichen grammatikalischen Konstruktionen und der Verwendung von Eigennamen korrekt. Beispiele für perfekt erkannte Sätze:- VIELE MEHR MENSCHEN, DIE AN DEN ANGRIFFEN BETEILIGT SIND

- CLOSE TO THE EUROPEAN COMMISSION’S MAIN BUILDING

- WEST WALES AND THE SOUTH WEST AS WELL AS WESTERN SCOTLAND

- WE KNOW THERE WILL BE HUNDREDS OF JOURNALISTS HERE AS WELL

- ACCORDING TO PROVISIONAL FIGURES FROM THE ELECTORAL COMMISSION

- THAT’S THE LOWEST FIGURE FOR EIGHT YEARS

- MANCHESTER FOOTBALL CORRESPONDENT FOR THE DAILY MIRROR

- LAYING THE GROUNDS FOR A POSSIBLE SECOND REFERENDUM

- ACCORDING TO THE LATEST FIGURES FROM THE OFFICE FOR NATIONAL STATISTICS

- IT COMES AFTER A DAMNING REPORT BY THE HEALTH WATCHDOG

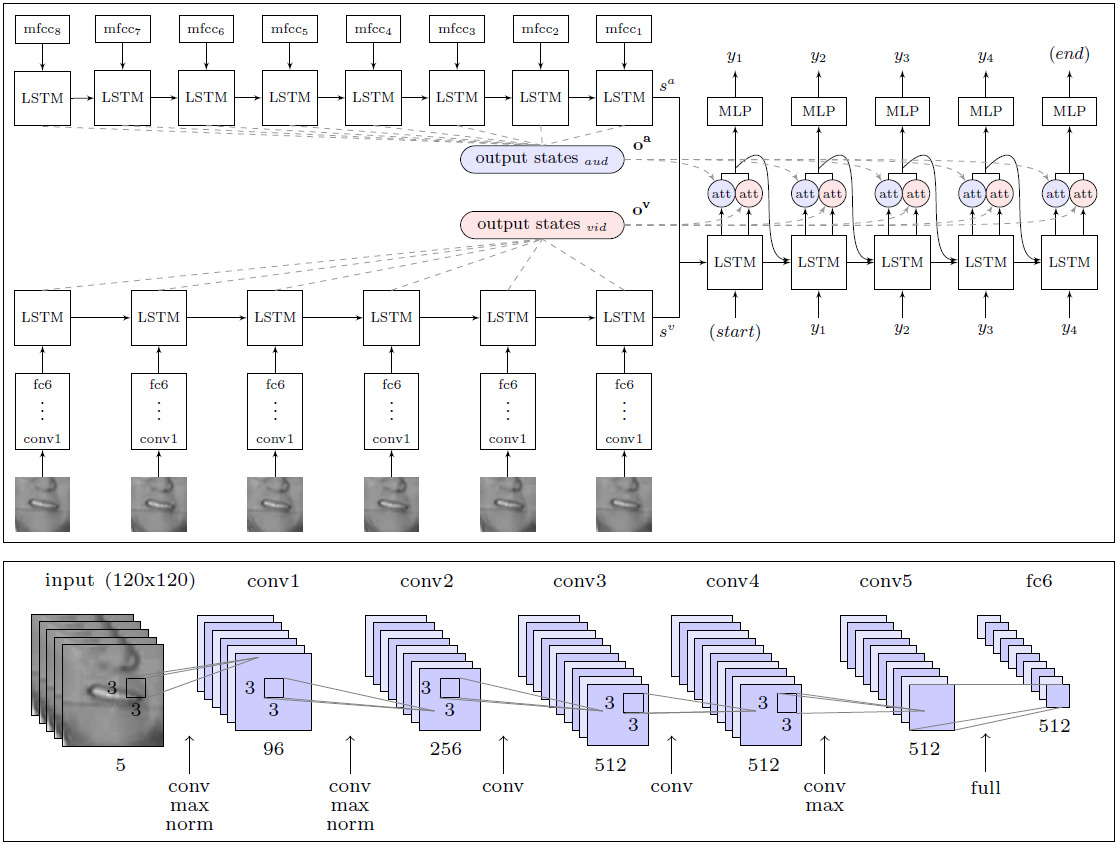

AI übertraf die Effektivität der Arbeit einer Person, eines Experten für Lippenlesen, die versuchte, 200 zufällige Videoclips aus einem aufgezeichneten Verifizierungsvideoarchiv zu erkennen, erheblich.Der Fachmann konnte ohne einen einzigen Fehler nur 12,4% der Wörter kommentieren, während die KI 46,8% korrekt aufzeichnete. Forscher stellen fest, dass viele Fehler als geringfügig bezeichnet werden können. Zum Beispiel das fehlende "s" am Ende von Wörtern. Wenn wir uns der Analyse der Ergebnisse weniger streng nähern, hat das System in Wirklichkeit viel mehr als die Hälfte der Wörter in der Luft erkannt.Mit diesem Ergebnis ist DeepMind allen anderen Lippenlesern deutlich überlegen, einschließlich des oben genannten LipNet, das ebenfalls an der Universität Oxford entwickelt wurde. Es ist jedoch zu früh, um über die ultimative Überlegenheit zu sprechen, da LipNet nicht auf einen so großen Datensatz trainiert wurde.Laut Experten ist DeepMind ein großer Schritt zur Entwicklung eines vollautomatischen Lippenlesesystems. Die Architektur des WLAS-Moduls (Watch, Listen, Attend and Spell) und ein Faltungsnetzwerk zum Lesen von LippenDas große Verdienst der Forscher liegt in der Tatsache, dass sie einen riesigen Datensatz für das Training und Testen des Systems mit 17.500 eindeutigen Wörtern zusammengestellt haben. Schließlich sind es nicht nur fünf Jahre kontinuierliche Aufzeichnung von Fernsehprogrammen in gutem Englisch, sondern auch eine klare Synchronisation von Video und Ton (im Fernsehen gibt es oft eine Synchronisation von bis zu 1 Sekunde, selbst im professionellen englischen Fernsehen) sowie die Entwicklung eines Moduls für die Spracherkennung, das überlagert ist auf Video und wird zum Unterrichten des Lippenlesesystems verwendet (WLAS-Modul, siehe Abbildung oben).Bei der geringsten Rassynchronisation wird das Training des Systems praktisch unbrauchbar, da das Programm die korrekte Entsprechung von Geräuschen und Lippenbewegungen nicht bestimmen kann. Nach einer gründlichen Vorarbeit erfolgte die Schulung des Programms vollautomatisch - es wurden alle 5000 Videos unabhängig verarbeitet.Bisher gab es einen solchen Satz einfach nicht, daher waren dieselben LipNet-Autoren gezwungen, sich auf die GRID-Basis zu beschränken. Zu Ehren der DeepMind-Entwickler versprachen sie, einen öffentlich zugänglichen Datensatz für die Schulung anderer AIs zu veröffentlichen. Kollegen vom LipNet-Entwicklungsteam haben bereits gesagt, dass sie sich darauf freuen.Die wissenschaftliche Arbeit veröffentlicht in der Public Domain auf der Website arXiv (: 1611.05358v1 arXiv).Wenn kommerzielle Lippenlesesysteme auf dem Markt erscheinen, wird das Leben gewöhnlicher Menschen viel einfacher. Es ist davon auszugehen, dass solche Systeme sofort in Fernseher und andere Haushaltsgeräte eingebaut werden, um die Sprachsteuerung und die nahezu fehlerfreie Spracherkennung zu verbessern.

Die Architektur des WLAS-Moduls (Watch, Listen, Attend and Spell) und ein Faltungsnetzwerk zum Lesen von LippenDas große Verdienst der Forscher liegt in der Tatsache, dass sie einen riesigen Datensatz für das Training und Testen des Systems mit 17.500 eindeutigen Wörtern zusammengestellt haben. Schließlich sind es nicht nur fünf Jahre kontinuierliche Aufzeichnung von Fernsehprogrammen in gutem Englisch, sondern auch eine klare Synchronisation von Video und Ton (im Fernsehen gibt es oft eine Synchronisation von bis zu 1 Sekunde, selbst im professionellen englischen Fernsehen) sowie die Entwicklung eines Moduls für die Spracherkennung, das überlagert ist auf Video und wird zum Unterrichten des Lippenlesesystems verwendet (WLAS-Modul, siehe Abbildung oben).Bei der geringsten Rassynchronisation wird das Training des Systems praktisch unbrauchbar, da das Programm die korrekte Entsprechung von Geräuschen und Lippenbewegungen nicht bestimmen kann. Nach einer gründlichen Vorarbeit erfolgte die Schulung des Programms vollautomatisch - es wurden alle 5000 Videos unabhängig verarbeitet.Bisher gab es einen solchen Satz einfach nicht, daher waren dieselben LipNet-Autoren gezwungen, sich auf die GRID-Basis zu beschränken. Zu Ehren der DeepMind-Entwickler versprachen sie, einen öffentlich zugänglichen Datensatz für die Schulung anderer AIs zu veröffentlichen. Kollegen vom LipNet-Entwicklungsteam haben bereits gesagt, dass sie sich darauf freuen.Die wissenschaftliche Arbeit veröffentlicht in der Public Domain auf der Website arXiv (: 1611.05358v1 arXiv).Wenn kommerzielle Lippenlesesysteme auf dem Markt erscheinen, wird das Leben gewöhnlicher Menschen viel einfacher. Es ist davon auszugehen, dass solche Systeme sofort in Fernseher und andere Haushaltsgeräte eingebaut werden, um die Sprachsteuerung und die nahezu fehlerfreie Spracherkennung zu verbessern.Source: https://habr.com/ru/post/de399429/

All Articles