Das taiwanesische Unternehmen 42Ark und der in den USA ansässige Hersteller von „intelligenten“ CatFi-Box-Feedern verwenden CCTV-Kameras, um Katzengesichter zu erkennen

Das taiwanesische Unternehmen 42Ark und der in den USA ansässige Hersteller von „intelligenten“ CatFi-Box-Feedern verwenden CCTV-Kameras, um Katzengesichter zu erkennen1941 installierte der deutsche Elektrotechniker Walter Bruch an der Teststelle, an der die V-2-Raketen getestet wurden, ein CCTV-System (Closed Circuit Television). Dies ist der erste Fall in der Geschichte, in dem Videoüberwachung in der Praxis eingesetzt wird. Der Bediener musste die ganze Zeit vor dem Monitor sitzen. Dies dauerte bis 1951, bis die ersten VTR-Geräte (VideoTape Recorder) erschienen, die Bilder auf Magnetband aufzeichneten.

Die Aufzeichnung auf dem Medium hat den Bediener nicht vor der Notwendigkeit bewahrt, an dem Prozess teilzunehmen. Gesichtserkennung, Position von Objekten, sogar Bewegungserkennung - all diese Funktionen wurden von einer Person ausgeführt, die in Echtzeit vor dem Monitor saß oder das Videoarchiv nachträglich studierte.

Das Rad des Fortschritts rollt weiter. Die Videoüberwachung erhielt eine Videoanalyse, die den Prozess der Arbeit mit dem System grundlegend veränderte. Erinnern Sie sich an die

Geschichte über die Katze und das tief lernende neuronale Netzwerk? Ja, dies ist auch Teil der Videoanalyse, aber winzig. Heute werden wir über Technologien sprechen, die die Welt der CCTV-Systeme grundlegend verändern.

Warteschlangenerkennung und Betatest Die weltweit erste IP-Kamera Neteye 200, die 1996 von Axis entwickelt wurde

Die weltweit erste IP-Kamera Neteye 200, die 1996 von Axis entwickelt wurdeDie Videoüberwachung wurde als geschlossenes Sicherheitssystem entwickelt, das nur zur Behebung von Sicherheitsproblemen entwickelt wurde. Die Einschränkungen der analogen Videoüberwachung erlaubten keine andere Verwendung von Geräten. Die Integration der Videoüberwachung in digitale Systeme hat die Möglichkeit eröffnet, durch Analyse der Bildsequenz automatisch verschiedene Daten zu empfangen.

Die Wichtigkeit ist schwer zu überschätzen: Im Normalfall beginnt der Bediener nach 12 Minuten kontinuierlicher Beobachtung, bis zu 45% der Ereignisse zu verpassen. Und bis zu 95% der potenziell störenden Ereignisse werden nach 22 Minuten kontinuierlicher Überwachung übersehen (gemäß IMS Research, 2002).

Es sind komplexe Videoanalysealgorithmen erschienen: Besucher zählen, Conversions zählen, Statistiken über Bargeldtransaktionen und vieles mehr. Der Beobachtungsoperator verschwindet in diesem System - wir überlassen dem Computer die Möglichkeit, zu „beobachten“ und Schlussfolgerungen zu ziehen.

Das einfachste Beispiel für intelligente Videoüberwachung ist die Bewegungserkennung. Es ist nicht so wichtig, ob in der Kamera selbst ein eingebauter Detektor vorhanden ist. Wenn Sie beispielsweise die

Ivideon Server- Software auf einem Computer installieren, wird der Bewegungsmelder als Software verwendet. Ein Detektor kann mehrere Videoüberwachungsbetreiber gleichzeitig ersetzen. Und bereits in den 2000er Jahren tauchten die ersten Videoanalysesysteme auf, die Objekte und Ereignisse im Rahmen erkennen können.

Ivideon entwickelt derzeit mehrere Videoanalysemodule. Seit der

Veröffentlichung von OpenAPI sind die Dinge durch die Integration mit Partnern schneller geworden. Einige der Projekte befinden sich noch in geschlossenen Tests, aber etwas ist bereits fertig. Dies ist zum einen die

Integration in Registrierkassen zur Kontrolle von Bargeldtransaktionen (bisher basierend auf iiko und Shtrikh-M). Zweitens wurde ein Warteschlangendetektor entwickelt.

Wir hatten einen

Ivideon-Schalter , der die Anzahl der Kunden im Raum bestimmte. Mit Analytics konnten wir uns von speziellen Geräten zum Cloud Computing abwenden. Jetzt brauchen wir keine spezielle Kamera - jede Überwachungskamera mit einer Auflösung von 1080p + ist geeignet. Jetzt wollen wir nicht nur Leute zählen, sondern auch die Warteschlangen bestimmen. Daher sind sie für jedes Geschäft, Einkaufszentrum oder Büro bereit, in dem Menschen stehen und Warteschlangen bilden, um eine kostenlose Kamera für den Warteschlangenerkennungstest bereitzustellen.

Mailen Sie uns , um am Projekt teilzunehmen.

Darüber hinaus arbeitet Ivideon mit Gesichtserkennungstechnologie.

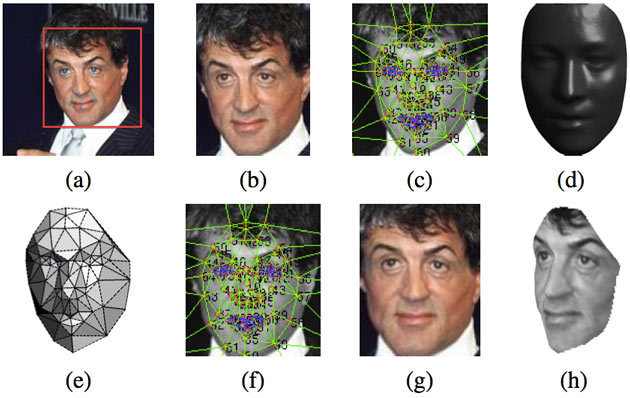

Wer erkennt wie Die DeepFace-Technologie wird von Facebook am Beispiel der Erkennung des emotionalen Gesichts von Sylvester Stallone getestet

Die DeepFace-Technologie wird von Facebook am Beispiel der Erkennung des emotionalen Gesichts von Sylvester Stallone getestetApple, Facebook, Google, Intel, Microsoft und andere Technologie-Giganten arbeiten an Lösungen in diesem Bereich. An 22 US-Flughäfen sind Videoüberwachungssysteme mit automatischer Gesichtserkennung von Passagieren installiert. In Australien entwickeln sie ein biometrisches System zur Erkennung von Gesichtern und Fingerabdrücken als Teil eines Programms zur Automatisierung der Pass- und Zollkontrolle.

Das größte chinesische Internetunternehmen, Baidu, führte ein erfolgreiches Experiment zum Stornieren von Tickets mithilfe der Gesichtserkennungstechnologie mit einer Genauigkeit von 99,77% und einer Aufnahme- und Erkennungszeit von 0,6 Sekunden durch. An den Eingängen zum Park sind Stände mit Tablets und speziellen Rahmen angebracht, die das Schießen durchführen. Wenn ein Tourist zum ersten Mal in den Park kommt, macht das System ein Bild von ihm, um in Zukunft die Gesichtserkennungsfunktion auf dem Foto zu verwenden. Neue Fotos werden mit Fotos aus der Datenbank verglichen. Auf diese Weise bestimmt das System, ob eine Person das Recht hat, sie zu besuchen.

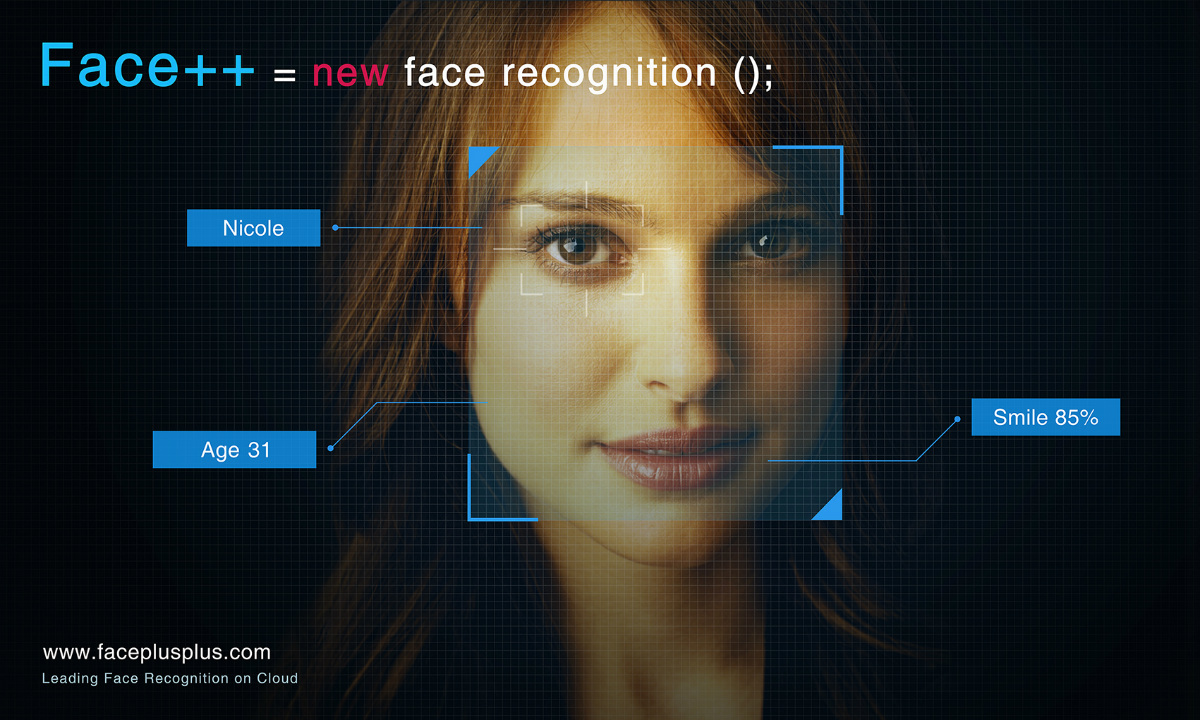

In China ist die Technologie im Allgemeinen sehr gut. Im Jahr 2015 startete Alipay, ein Betreiber der Online-Zahlungsplattform, der Teil der Alibaba Holding ist, ein Zahlungsverifizierungssystem auf der Basis von Face ++, einer Cloud-Gesichtserkennungsplattform, die vom chinesischen Startup Megvii entwickelt wurde. Das System heißt Smile to Pay - es ermöglicht Alipay-Benutzern, Online-Einkäufe mit einem Selfie zu bezahlen (Alipay ermittelt den Eigentümer anhand eines Lächelns). UBER in China hat begonnen, ein auf Face ++ basierendes Fahrererkennungssystem zu

verwenden , um Betrug und Identitätsdiebstahl entgegenzuwirken und zusätzliche Sicherheit für die Fahrgäste zu gewährleisten.

Interessanter ist es jedoch, sich nicht mit ausländischen Lösungen zu befassen, sondern mit in Russland erstellten Dienstleistungen. Diese Technologien sind dem Endbenutzer viel näher (wenn er aus unserem Land stammt), Sie können sie kennenlernen und sich in Zukunft zur Verwendung in Ihrem eigenen Produkt zusammenschließen. Es gibt viele Gesichtserkennungsunternehmen. Erinnern wir uns an einige, die nach Gehör bleiben.

Das 1999 gegründete Unternehmen Vokord verwendet FaceControl 3D, um mit synchronen Bildern von Stereokameras zu arbeiten, erstellt ein 3D-Modell des Gesichts im Rahmen und sucht automatisch nach dem Modell, das mit den Modellen in der vorhandenen Datenbank erhalten wurde. Im Jahr 2016 begann Vokord

, einen eigenen mathematischen Gesichtserkennungsalgorithmus zu verwenden, der auf Faltungs-Neuronalen Netzen basiert. Daher funktionieren ihre Algorithmen jetzt mit jeder Videoüberwachungskamera. Das Unternehmen behauptet, dass sie die Gesichter (in der Größe von 128 x 128 Pixel) von Personen erkennen können, die dem Stream folgen. Ende 2016 zeigte der Vocord DeepVo1-Algorithmus die besten Ergebnisse bei den globalen Identifikationstests und

erkannte 75,127% der Personen korrekt.

VisionLabs wurde 2012 gegründet und gewann den größten

Wettbewerb für Technologieunternehmen

GoTech in Russland und Osteuropa. Es wurde in die Liste der Finalisten des europäischen Programms „

Challenge UP! “, Entwickelt, um die Markteinführung von Lösungen und Dienstleistungen auf der Grundlage des Konzepts des Internet der Dinge zu beschleunigen, hat mehrere Millionen Investitionen angezogen und führt seine Produkte bereits im kommerziellen Sektor ein. Vor kurzem hat die Otkritie Bank das Gesichtserkennungssystem VisionLabs eingeführt, um den Kundenservice und die Wartezeiten in der Schlange zu optimieren. Es lohnt sich, eine wunderbare Geschichte zu lesen, wie CROC-Spezialisten

eine Katze mit VisionLabs

gefangen haben.

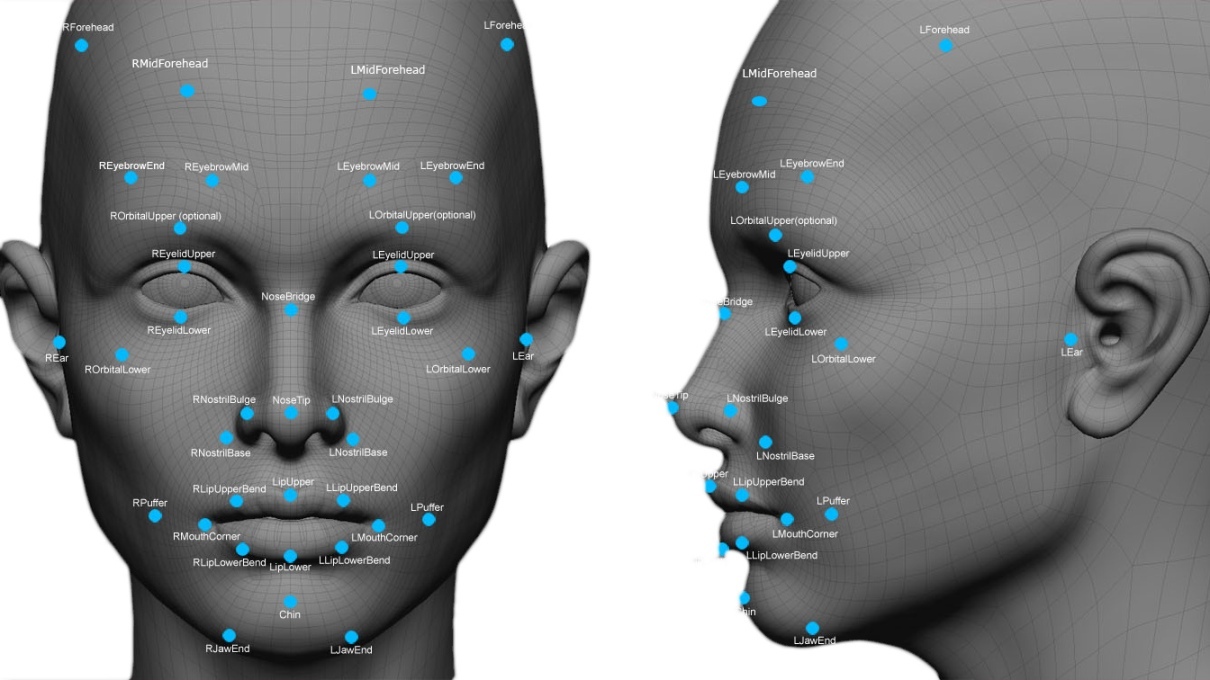

VisionLabs, das eines der besten Ergebnisse bei Erkennungs- und Fehlerraten erzielt hat, funktioniert auch mit neuronalen Netzen, die bestimmte Merkmale jedes Gesichts wie Augenform, Nasenform, Ohrmuschelrelief usw. offenbaren. Mit ihrem Luna-System können Sie all diese Merkmale des Gesichts auf dem Foto in den Archiven finden. Eine weitere Entscheidung des Unternehmens, Face Is, erkennt das Gesicht des Kunden im Geschäft, findet sein Profil im CRM-System, erfährt daraus die Kaufhistorie und die Interessen des Käufers und sendet eine Benachrichtigung mit einem persönlichen Angebot über den Rabatt auf seine bevorzugte Warengruppe an das Telefon.

Die Automatisierung des Einstellungsprozesses für das Skillaz-Startup und VisionLabs plant, Ende 2017 ein Computererkennungssystem einzuführen, mit dem das Verhalten von Arbeitssuchenden bewertet wird. Nach der Analyse der Daten zieht das System Rückschlüsse auf die beruflichen Qualitäten einer Person und die Eignung für die Stelle. Die vollständigen Merkmale des „Mietwagen“ -Systems werden vom Unternehmen nicht bekannt gegeben. Es ist nur bekannt, dass die Geselligkeit des Kandidaten anhand seiner Antworten auf bestimmte Fragen bewertet wird, die vom Online-Interview-System gestellt werden. Das neuronale Netzwerk sucht nach der Beziehung zwischen dem Verhalten des Kandidaten im Bild von der Überwachungskamera und dem Schweregrad der einen oder anderen Kompetenz.

Das Raster, das aus Dr. Lightman und Sherlock Holmes in einer Person besteht, berücksichtigt den Gesichtsausdruck des Kandidaten, seine Gesten sowie die Physiognomie. Es ist erwähnenswert, dass die Methode zur Bestimmung des Persönlichkeitstyps eines Menschen, seiner spirituellen Qualitäten, basierend auf der Analyse äußerer Merkmale und seines Ausdrucks, als modernes Beispiel für Pseudowissenschaften in der modernen psychologischen Wissenschaft angesehen wird. Wie mit diesem Widerspruch im neuen Produkt umzugehen ist, ist noch unklar.

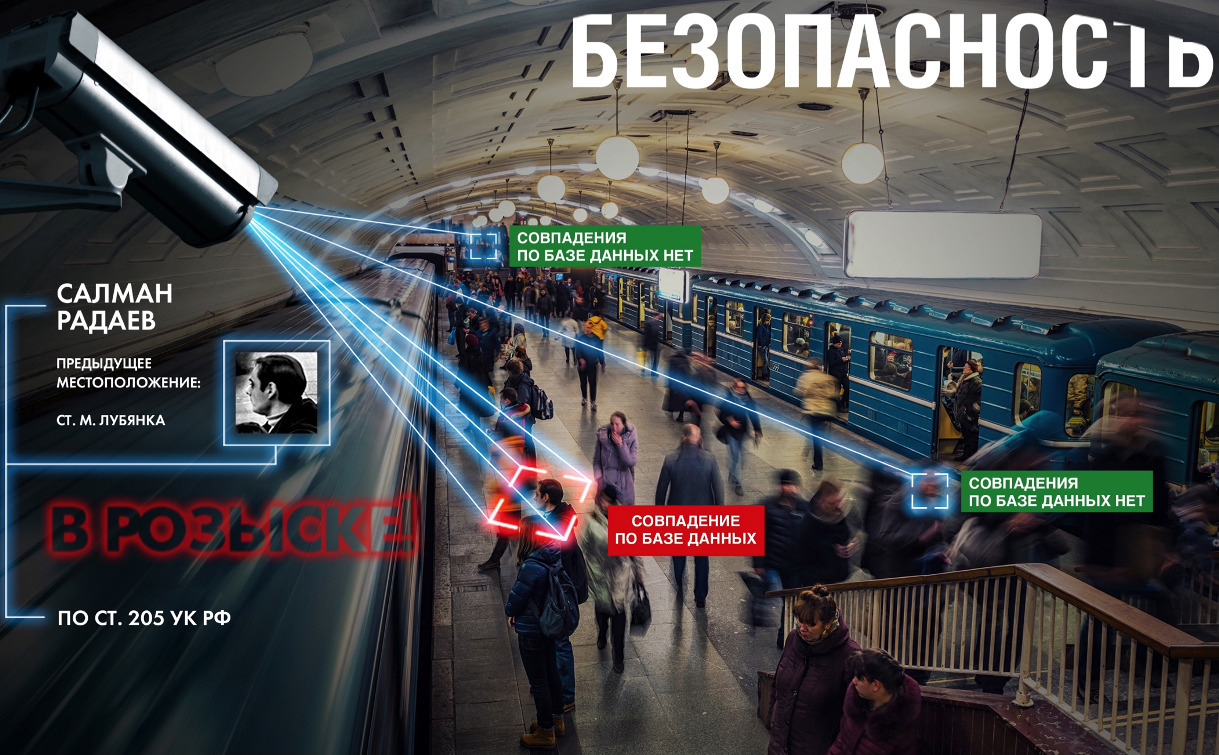

NTechLab-Präsentationsfolie, die Salman Radaev niederdrückt

NTechLab-Präsentationsfolie, die Salman Radaev niederdrücktNTechLab begann mit einer Anwendung, die die Hunderasse anhand eines Fotos bestimmte. Später schrieben sie den FaceN-Algorithmus, mit dem sie im Herbst 2015 am internationalen Wettbewerb

The MegaFace Benchmark teilnahmen . NTechLab gewann zwei von vier Nominierungen und schlug das Google-Team (in einem Jahr wird Vokord im selben Wettbewerb gewinnen und NTechLab wird auf den 4. Platz vorrücken). Der Erfolg ermöglichte es ihnen, den

FindFace- Dienst schnell zu implementieren und nach Personen aus Fotos auf VKontakte zu suchen. Dies ist jedoch nicht die einzige Möglichkeit, die Technologie anzuwenden. Beim Alfa Future People Festival, das von der Alfa Bank mit FindFace organisiert wurde, konnten Besucher ihre Fotos unter Hunderten von anderen finden, indem sie ein Selfie an einen Chatbot schickten.

Darüber hinaus

zeigte NTechLab

ein System , mit dem Geschlecht, Alter und Emotionen mithilfe eines Bildes von einer Videokamera in Echtzeit erkannt werden können. Das System kann die Reaktion des Publikums in Echtzeit auswerten, sodass Sie die Emotionen bestimmen können, die Besucher bei Präsentationen oder Sendungen von Werbebotschaften erleben. Alle NTechLab-Projekte basieren auf selbstlernenden neuronalen Netzen.

Ivideons Weg zur Videoanalyse

Die Gesichtserkennung ist eine der schwierigsten Aufgaben im Bereich der Videoanalyse. Einerseits scheint alles klar zu sein und wurde schon lange benutzt. Andererseits sind Identifikationslösungen in einer Menschenmenge immer noch sehr teuer und bieten keine absolute Genauigkeit.

Seit 2012 arbeitet Ivideon mit Videoanalysealgorithmen. In diesem Jahr haben wir Anwendungen für iOS und Android veröffentlicht, sind in ausländische Märkte eingetreten, haben dezentrale CDN-Netzwerke mit Servern in den USA, den Niederlanden, Deutschland, Korea, Russland, der Ukraine und Kasachstan gestartet und sind der einzige internationale Videoüberwachungsdienst, der weltweit gleich gut funktioniert. Im Allgemeinen schien es einfach und schnell zu sein, Ihre Analysen mit Blackjack und Erkennung durchzuführen ... wir waren jung, das Gras schien grüner und die Luft süß und träge.

[

Zu dieser Zeit haben wir klassische Algorithmen in Betracht gezogen. Zuerst müssen Sie die Gesichter im Bild erkennen und lokalisieren: Verwenden Sie Haar-Kaskaden , suchen Sie nach Regionen mit einer hautähnlichen Textur usw. Angenommen, wir müssen die erste Person finden, die auf sie stößt, und sie nur im Videostream begleiten. Hier können Sie den Lucas-Canada-Algorithmus verwenden . Wir finden das Gesicht durch den Algorithmus und bestimmen dann die charakteristischen Punkte darin. Wir begleiten die Punkte mit dem Lucas-Canada-Algorithmus. Nach ihrem Verschwinden glauben wir, dass das Gesicht aus dem Blickfeld verschwunden ist. Nachdem wir die charakteristischen Merkmale des Gesichts erhalten haben, können wir es mit den in die Datenbank eingebetteten Merkmalen vergleichen.

Um die Flugbahn des Objekts (Gesicht) zu glätten und seine Position im nächsten Frame vorherzusagen, verwenden wir den Kalman-Filter . Hierbei ist zu beachten, dass der Kalman-Filter für lineare Bewegungsmodelle ausgelegt ist. Für nichtlineare wird der Partikelfilter- Algorithmus verwendet (als Variante des Partikelfilter + Mean Shift- Algorithmus).

Sie können auch Hintergrundsubtraktionsalgorithmen verwenden: eine Bibliothek mit Beispielen für die Implementierung von Algorithmen zum Subtrahieren des Hintergrunds + Artikel zur Implementierung des Lightweight-Algorithmus zum Subtrahieren des Hintergrunds von ViBe. Vergessen Sie außerdem nicht eine der häufigsten Viola-Jones- Methoden, die in der OpenCV-Computer-Vision-Bibliothek implementiert sind. ]]

Einfache Gesichtserkennung ist gut, aber nicht genug. Es ist auch notwendig, eine stabile Verfolgung mehrerer Objekte im Rahmen sicherzustellen, selbst wenn sie sich gemeinsam schneiden oder ein Hindernis vorübergehend „verschwinden“. Zählen Sie eine beliebige Anzahl von Objekten, die eine bestimmte Zone überqueren, und berücksichtigen Sie die Schnittrichtungen. Um zu wissen, wann ein Objekt / Objekt im Rahmen erscheint und verschwindet, bewegen Sie die Maus über die schmutzige Tasse auf dem Tisch und finden Sie im Videoarchiv den Moment, in dem es dort erschien und wer es verlassen hat. Während der Verfolgung kann sich ein Objekt sehr stark ändern (in Bezug auf Transformationen). Diese Änderungen sind jedoch von Bild zu Bild so, dass das Objekt identifiziert werden kann.

Darüber hinaus wollten wir eine universelle Cloud-Lösung für alle verfügbar machen - von den anspruchsvollsten Benutzern. Die Lösung musste flexibel und skalierbar sein, da wir selbst nicht wissen konnten, was der Benutzer überwachen und was der Benutzer berücksichtigen wollte. Es ist durchaus möglich, dass jemand vorgeschlagen hätte, eine auf Ivideon basierende Kakerlakensendung mit automatischer Ermittlung des Gewinners zu machen.

Nur fünf Jahre später haben wir begonnen, einzelne Komponenten der Videoanalyse zu testen. In neuen Artikeln werden wir mehr über diese Projekte sprechen.

PS Wir suchen also Freiwillige für Warteschlangendetektortests. Sowie Benutzer des SHTRIH-M-Systems zum Testen eines neuen Cash-Management-Systems. Schreiben Sie in der

Mail oder in den Kommentaren.