Studien zeigen, dass Computermodelle, die als neuronale Netze bekannt sind und in immer mehr Anwendungen verwendet werden, lernen können, Sequenzen in Daten mit denselben Algorithmen wie das menschliche Gehirn zu erkennen.

Das Gehirn löst sein kanonisches Problem - das Training -, indem es viele seiner Verbindungen nach einem unbekannten Regelwerk anpasst. Um diese Regeln aufzudecken, begannen Wissenschaftler vor 30 Jahren mit der Entwicklung von Computermodellen, um den Lernprozess zu reproduzieren. In einer wachsenden Anzahl von Experimenten wird heute deutlich, dass sich diese Modelle bei bestimmten Aufgaben sehr ähnlich wie das reale Gehirn verhalten. Forscher sagen, dass diese Ähnlichkeit eine grundlegende Übereinstimmung zwischen Gehirn- und Computer-Lernalgorithmen nahe legt.

Der vom Computermodell verwendete Algorithmus wird als

Boltzmann-Maschine bezeichnet . Es wurde 1983

von Jeffrey Hinton und Terry Seinowski

erfunden [tatsächlich

1985 - ca. übersetzt.]. Es sieht sehr vielversprechend aus als einfache theoretische Erklärung mehrerer Prozesse im Gehirn - Entwicklung, Gedächtnisbildung, Erkennung von Objekten und Geräuschen, Schlaf- und Wachzyklen.

"Dies ist die beste Gelegenheit, das Gehirn heute zu verstehen", sagt Sue Becker, Professorin für Psychologie, Neurobiologie und Verhalten an der Universität. McMaster in Hamilton, Ontario. "Ich kenne kein Modell, das ein breiteres Spektrum von Phänomenen beschreibt, die mit Lernen und Gehirnstruktur zusammenhängen."

Hinton, ein Pionier auf dem Gebiet der KI, wollte immer die Regeln verstehen, nach denen das Gehirn die Kommunikation verbessert oder schwächt - das heißt, den Lernalgorithmus. „Ich habe beschlossen, dass etwas gebaut werden muss, um es zu verstehen“, sagt er. Nach dem reduktionistischen Ansatz der Physiker plant er, einfache Computermodelle des Gehirns unter Verwendung verschiedener Lernalgorithmen zu erstellen und zu sehen, „welche funktionieren werden“, sagt Hinton, teils Professor für Informatik an der Universität Toronto, teils bei Google.

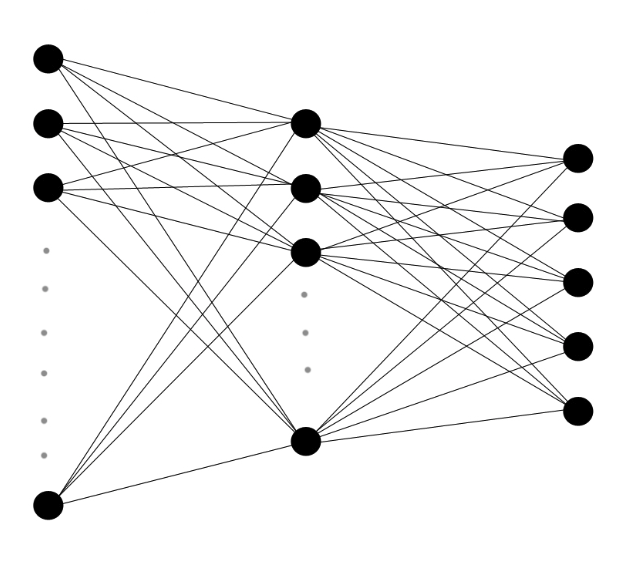

Mehrschichtige neuronale Netze bestehen aus Schichten künstlicher Neuronen mit gewichteten Verbindungen zwischen ihnen. Ich sende den eingehenden Daten eine Kaskade von Signalen in Schichten, und der Algorithmus bestimmt die Änderung der Gewichte jeder Verbindung.

Mehrschichtige neuronale Netze bestehen aus Schichten künstlicher Neuronen mit gewichteten Verbindungen zwischen ihnen. Ich sende den eingehenden Daten eine Kaskade von Signalen in Schichten, und der Algorithmus bestimmt die Änderung der Gewichte jeder Verbindung.In den 1980er und 1990er Jahren erfand Hinton, der Ururenkel der Logik des 19. Jahrhunderts, George Boole, dessen Arbeit die Grundlage der modernen Informatik bildete, mehrere Algorithmen für maschinelles Lernen. Algorithmen, die steuern, wie ein Computer aus Daten lernt, werden in Computermodellen verwendet, die als "künstliche neuronale Netze" bezeichnet werden - Netze miteinander verbundener virtueller Neuronen, die Signale an ihre Nachbarn senden, ein- oder ausschalten oder "auslösen". Wenn Daten in das Netzwerk eingespeist werden, führt dies zu einer Kaskade von Antworten, und der Algorithmus wählt basierend auf dem Bild dieser Antworten aus, die Gewichte der Verbindungen oder Synapsen zwischen jedem Neuronenpaar zu erhöhen oder zu verringern.

Seit Jahrzehnten vegetieren viele Hinton-Computermodelle. Dank der Fortschritte bei der Prozessorleistung, des Fortschritts beim Verständnis des Gehirns und der Algorithmen spielen neuronale Netze in der Neurobiologie eine immer größere Rolle. Sejnowski [Sejnowski], Leiter des Computerlabors für Neurobiologie am Institut für biologische Forschung. Salka in La Jolla, Kalifornien, sagt: „Vor dreißig Jahren hatten wir sehr grobe Ideen. Jetzt fangen wir an, einige davon zu testen. “

Gehirnmaschinen

Hintons frühe Versuche, das Gehirn zu reproduzieren, waren begrenzt. Computer könnten ihre Lernalgorithmen in kleinen neuronalen Netzen ausführen, aber Skalierungsmodelle überlasteten die Prozessoren sehr schnell. Im Jahr 2005 entdeckte Hinton, dass der Prozess effizienter wird, wenn Sie die neuronalen Netze in Schichten unterteilen und die Algorithmen auf jeder Schicht separat ausführen und dabei die Struktur und Entwicklung des Gehirns ungefähr wiederholen.

Obwohl Hinton seine Entdeckung in

zwei bekannten Magazinen veröffentlichte , waren neuronale Netze bis dahin aus der Mode gekommen, und er "kämpfte darum, die Leute zu interessieren", sagte Lee Deng, leitender Forscher bei Microsoft Research. Deng kannte Hinton jedoch und beschloss 2009, seine „Deep Learning“ -Methode zu testen, um sein Potenzial schnell zu erkennen. In den folgenden Jahren werden Lernalgorithmen in der Praxis in einer wachsenden Anzahl von Anwendungen verwendet, z. B. im persönlichen Assistenten von Google Now oder in der Sprachsuchfunktion von Microsoft Windows-Telefonen.

Einer der vielversprechendsten Algorithmen, die Boltzmann-Maschine, ist nach dem österreichischen Physiker Ludwig Boltzmann aus dem 19. Jahrhundert benannt, der einen Zweig der Physik entwickelte, der sich mit einer großen Anzahl von Teilchen befasst, der so genannten statistischen Mechanik. Boltzmann entdeckte eine Gleichung, die die Wahrscheinlichkeit angibt, dass ein molekulares Gas eine bestimmte Energie hat, wenn es das Gleichgewicht erreicht. Wenn Sie die Moleküle durch Neuronen ersetzen, tendiert das Ergebnis zur gleichen Gleichung.

Die Netzwerksynapsen beginnen mit einer zufälligen Verteilung von Gewichten, und die Gewichte werden nach einem relativ einfachen Verfahren schrittweise angepasst: Die erzeugte Antwortschaltung beim Empfangen von Daten (wie Bildern oder Tönen) durch die Maschine wird mit der zufälligen Antwortschaltung der Maschine verglichen, die auftritt, wenn keine Daten eingegeben werden.

Joffrey Hinton glaubt, dass der beste Ansatz zum Verständnis der Lernprozesse im Gehirn darin besteht, Computer zu bauen, die auf die gleiche Weise lernen.

Joffrey Hinton glaubt, dass der beste Ansatz zum Verständnis der Lernprozesse im Gehirn darin besteht, Computer zu bauen, die auf die gleiche Weise lernen.Jede virtuelle Synapse verfolgt beide statistischen Sätze. Wenn die damit verbundenen Neuronen beim Empfang von Daten häufiger in enger Reihenfolge ausgelöst werden als während des Zufallsbetriebs, erhöht sich das Gewicht der Synapse um einen Wert, der proportional zur Differenz ist. Wenn jedoch zwei Neuronen während einer zufälligen Operation häufiger zusammen ausgelöst werden, wird die sie verbindende Synapse als zu stark und geschwächt angesehen.

Die am häufigsten verwendete Version der Boltzmann-Maschine funktioniert nach dem „Training“ besser, da Tausende von Probendaten nacheinander auf jeder Schicht verarbeitet wurden. Erstens empfängt die untere Schicht des Netzwerks Rohdaten in Form von Bildern oder Tönen, und in der Art von Netzhautzellen werden Neuronen ausgelöst, wenn sie Kontraste in ihrem Datenbereich erkennen, beispielsweise das Umschalten von hell auf dunkel. Ihre Auslösung kann die Auslösung der mit ihnen verbundenen Neuronen auslösen, abhängig vom Gewicht der Synapse, die sie verbindet. Da die Auslösung von Paaren virtueller Neuronen ständig mit Hintergrundstatistiken verglichen wird, treten nach und nach sinnvolle Verbindungen zwischen Neuronen auf und verstärken sich. Die Gewichte der Synapsen werden angegeben, und Kategorien von Tönen und Bildern werden in die Verbindungen eingebaut. Jede nachfolgende Ebene wird auf ähnliche Weise trainiert, wobei Daten aus der darunter liegenden Ebene verwendet werden.

Wenn Sie ein Bild eines Autos einem neuronalen Netzwerk zuführen, das darauf trainiert ist, bestimmte Objekte in Bildern zu erkennen, funktioniert die untere Ebene, wenn ein Kontrast erkannt wird, der ein Gesicht oder einen Endpunkt anzeigt. Diese Signale werden an Neuronen höherer Ebene gesendet, die Winkel, Teile der Räder usw. bestimmen. In der oberen Ebene werden Neuronen nur als Reaktion auf das Bild des Autos ausgelöst.

"Die Magie des Geschehens im Web besteht darin, dass es zusammengefasst werden kann", sagt Yann LeCun, Direktor des Data Science Center an der New York University. "Wenn Sie ihr ein Auto zeigen, das sie zuvor noch nicht gesehen hat, und wenn das Auto einige Formen und Merkmale aufweist, die mit den ihr während des Trainings gezeigten Maschinen gemeinsam sind, kann sie feststellen, dass es sich um ein Auto handelt."

Neuronale Netze haben kürzlich ihre Entwicklung dank des Hinton-Mehrschichtmodus, der Verwendung von Hochgeschwindigkeits-Computerchips zur Verarbeitung von Grafiken und des explosionsartigen Anstiegs der Anzahl der für das Training verfügbaren Bilder und Sprachaufzeichnungen beschleunigt. Netzwerke können 88% der Wörter in englischer Sprache korrekt erkennen, während die durchschnittliche Person 96% erkennt. Sie können Autos und Tausende anderer Objekte in Bildern mit ähnlicher Genauigkeit erkennen und haben in den letzten Jahren eine dominierende Position bei Wettbewerben für maschinelles Lernen eingenommen.

Ein Gehirn aufbauen

Niemand weiß, wie man die Regeln, nach denen das Gehirn trainiert wird, direkt herausfindet, aber es gibt viele indirekte Übereinstimmungen zwischen dem Verhalten des Gehirns und der Boltzmann-Maschine.

Beide werden ohne Aufsicht trainiert, wobei nur vorhandene Muster in den Daten verwendet werden. "Ihre Mutter erzählt Ihnen nicht millionenfach, was auf dem Bild gezeigt wird", sagt Hinton. - Man muss lernen, Dinge ohne den Rat anderer zu erkennen. Nachdem Sie die Kategorien studiert haben, werden Ihnen die Namen dieser Kategorien mitgeteilt. So lernen die Kinder etwas über Hunde und Katzen, und dann lernen sie, dass Hunde "Hunde" und Katzen "Katzen" genannt werden.

Das Gehirn eines Erwachsenen ist nicht so flexibel wie das junge, genau wie die Boltzmann-Maschine, die für 100.000 Bilder von Autos trainiert hat. Es wird sich nicht viel ändern, nachdem sie ein anderes gesehen hat. Ihre Synapsen haben bereits die richtigen Gewichte für die Kategorisierung von Autos. Aber das Training endet nicht. Neue Informationen können in die Struktur der Gehirn- und Boltzmann-Maschinen integriert werden.

In den letzten zwei Jahrzehnten hat eine Untersuchung der Gehirnaktivität in einem Traum den ersten Beweis erbracht, dass das Gehirn einen dem Boltzmann-Algorithmus ähnlichen Algorithmus verwendet, um neue Informationen und Erinnerungen in seine Struktur aufzunehmen. Neurowissenschaftler wissen seit langem, dass der Schlaf eine wichtige Rolle bei der Gedächtniskonsolidierung spielt und zur Integration neuer Informationen beiträgt. 1995

schlugen Hinton und Kollegen

vor, dass der Schlaf die Rolle einer Grundebene im Algorithmus spielt und die Aktivität von Neuronen ohne Eingabedaten bezeichnet.

"Während des Schlafes müssen Sie nur die Grundfrequenz der Neuronen herausfinden", sagt Hinton. - Sie finden die Korrelation ihrer Arbeit für den Fall heraus, dass das System alleine arbeitet. Und wenn die Neuronen mehr korrelieren, erhöhen Sie einfach die Gewichte zwischen ihnen. Und wenn weniger, reduzieren Sie das Gewicht. "

Auf Synapsenebene kann „dieser Algorithmus auf verschiedene Arten bereitgestellt werden“, sagt Sezhnowski, Berater der Präsidialverwaltung im Rahmen

der BRAIN-Initiative , einer Studie mit einem Zuschuss von 100 Millionen US-Dollar zur Entwicklung neuer Gehirnforschungstechniken.

Er sagt, dass es für das Gehirn am einfachsten ist, mit dem Boltzmann-Algorithmus zu arbeiten, indem es tagsüber Synapsen baut und nachts verringert.

Giulio Tononi , Leiter des Zentrums für Schlaf- und Bewusstseinsstudien an der Universität von Wisconsin-Madison, fand heraus, dass die Genexpression in Synapsen sie gemäß dieser Hypothese verändert: Gene, die am Synapsenwachstum beteiligt sind, sind tagsüber aktiver und Gene, die an der Kontraktion beteiligt sind Synapsen - nachts.

Bei einer anderen Option kann „die Basislinie in einem Traum berechnet und dann tagsüber relativ dazu geändert werden“, sagt Sezhnowski. In seinem Labor werden detaillierte Computermodelle von Synapsen und die von ihnen unterstützten Netzwerke erstellt, um zu bestimmen, wie sie Statistiken über Wachheit und Schlafmuster sammeln und wann sich die Stärke von Synapsen ändert, um diesen Unterschied anzuzeigen.

Schwierigkeiten mit dem Gehirn

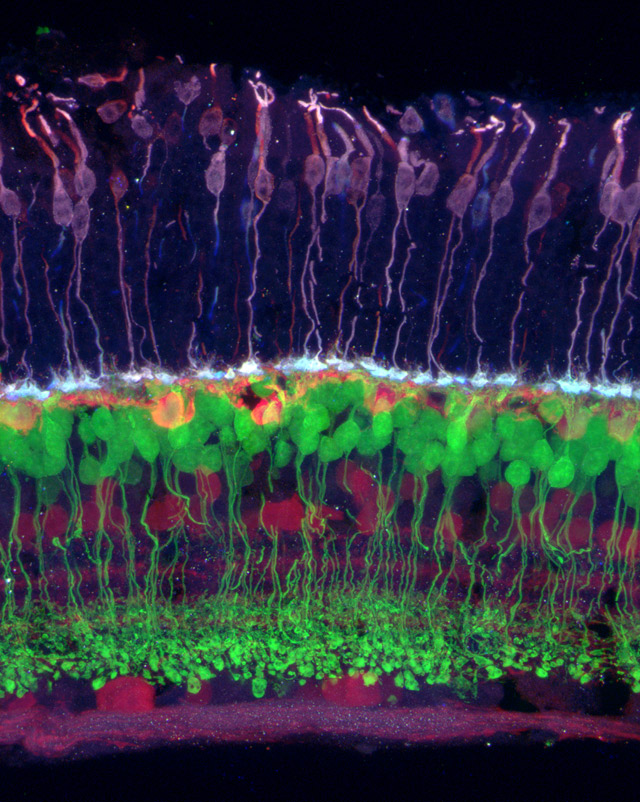

Bild der Netzhaut, in der verschiedene Zelltypen durch unterschiedliche Farben gekennzeichnet sind. Farbempfindlich (violett) verbindet sich mit horizontal (orange), das mit bipolar (grün) verbunden ist, und mit den Zellen der Netzhaut und des Ganglions (lila).

Bild der Netzhaut, in der verschiedene Zelltypen durch unterschiedliche Farben gekennzeichnet sind. Farbempfindlich (violett) verbindet sich mit horizontal (orange), das mit bipolar (grün) verbunden ist, und mit den Zellen der Netzhaut und des Ganglions (lila).Der Boltzmann-Algorithmus kann einer von vielen sein, die vom Gehirn zur Feinabstimmung von Synapsen verwendet werden. In den 1990er Jahren entwickelten mehrere unabhängige Gruppen ein theoretisches Modell dafür, wie das visuelle System den Informationsfluss zur Netzhaut effizient codiert. Die Theorie postulierte, dass es in den unteren Schichten des visuellen Kortex einen Prozess der „Streukodierung“ gibt, ähnlich der Bildkomprimierung, wodurch die späten Stadien des visuellen Systems effizienter arbeiten.

Vorhersagen des Modells bestehen nach und nach immer strengere Tests. In einem in PLOS Computational Biology veröffentlichten Artikel stellten Computational Neuroscientists aus Großbritannien und Australien fest, dass neuronale Netze, die den von Hinton 2002 erfundenen Streupodierungsalgorithmus Products of Experts verwenden, dieselben ungewöhnlichen visuellen Daten verarbeiten, die lebende Katzen erhalten (Zum Beispiel untersuchen Katzen und neuronale Netze gestreifte Bilder), ihre Neuronen produzieren fast identische ungewöhnliche Verbindungen.

"Wenn die Informationen den visuellen Kortex erreichen, präsentiert das Gehirn sie unserer Meinung nach als verstreuten Code", sagte Bruno Olshausen, Computational Neuroscientist und Direktor des Redwood Center for Theoretical Neurobiology an der University of California-Berkeley, der an der Entwicklung mitwirkte Streukodierungstheorie. "Als ob eine Boltzmann-Maschine in Ihrem Kopf sitzt und versucht, die Verbindungen zu verstehen, die zwischen den Elementen des verstreuten Codes bestehen."

Olshausen und das Team verwendeten neuronale Netzwerkmodelle der höheren Schichten des visuellen Kortex, um zu zeigen, wie das Gehirn trotz der Bewegung von Bildern

eine stabile Wahrnehmung visueller Eingaben aufrechterhalten kann. In einer anderen

Studie fanden sie heraus, dass die Aktivität von Neuronen im visuellen Kortex von Katzen, die einen Schwarzweißfilm betrachten, von der Boltzmann-Maschine sehr gut beschrieben wird.

Eine der möglichen Anwendungen dieser Arbeit ist die Herstellung von Neuroprothesen, beispielsweise einer künstlichen Netzhaut. Wenn Sie sich ansehen, wie „Informationen im Gehirn formatiert werden, können Sie verstehen, wie Sie das Gehirn dazu anregen können, zu glauben, dass es ein Bild sieht“, sagt Olshausen.

Laut Sezhnowski können Forscher durch das Verständnis der Wachstums- und Reduktionsalgorithmen von Synapsen diese ändern und lernen, wie die Funktionsweise des neuronalen Netzwerks gestört wird. "Dann können sie mit den bekannten Problemen der Menschen verglichen werden", sagt er. - Fast alle psychischen Störungen können durch Probleme mit Synapsen erklärt werden. Wenn wir Synapsen besser verstehen können, können wir verstehen, wie das Gehirn normal funktioniert, wie es Informationen verarbeitet, wie es lernt und was schief geht, wenn Sie beispielsweise Schizophrenie entwickeln. “

Der Ansatz zur Untersuchung des Gehirns mithilfe neuronaler Netze steht in starkem Kontrast zum Ansatz des

Human Brain Project . Dies ist der veröffentlichte Plan des Schweizer Neurowissenschaftlers Henry Marcram, mit einem Supercomputer eine genaue Simulation des menschlichen Gehirns zu erstellen. Im Gegensatz zu Hintons Ansatz, der mit einem stark vereinfachten Modell beginnt und dem Weg der allmählichen Komplikation folgt, möchte Markram sofort die größtmögliche Datenmenge bis hin zu einzelnen Molekülen einbeziehen und hofft, dass er dadurch die volle Funktionalität und das volle Bewusstsein hat.

Das Projekt wurde von der Europäischen Kommission mit 1,3 Milliarden US-Dollar finanziert, aber Hinton glaubt, dass diese Megasimulation fehlschlagen wird und in zu vielen beweglichen Teilen stecken bleibt, die noch niemand versteht.

Darüber hinaus glaubt Hinton nicht, dass das Gehirn nur durch seine Bilder verstanden werden kann. Solche Daten sollten verwendet werden, um Algorithmen zu erstellen und zu verfeinern. "Theoretisches Denken und die Erforschung des Raums der Lernalgorithmen sind erforderlich, um eine Theorie wie diese zu erstellen", sagt Boltzmanns Maschine. Der nächste Schritt für Hinton ist die Entwicklung von Algorithmen zum Trainieren noch hirnähnlicherer neuronaler Netze, bei denen Synapsen Neuronen innerhalb einer Schicht und nicht nur zwischen verschiedenen Schichten verbinden. „Das Hauptziel ist es, die Vorteile zu verstehen, die durch die Komplikation der Berechnungen in jeder Phase erzielt werden können“, sagt er.

Die Hypothese ist, dass mehr Verbindungen zu stärkeren Rückschleifen führen, die laut Olshausen höchstwahrscheinlich dazu beitragen, dass das Gehirn "die fehlenden Details ausfüllt". Die oberen Schichten stören die Arbeit von Neuronen aus den unteren Schichten, die sich mit Teilinformationen befassen. "All dies hängt eng mit dem Bewusstsein zusammen", sagt er.

Das menschliche Gehirn ist immer noch viel komplexer als jedes Modell. Es ist größer, dichter, effizienter, hat mehr Verbindungen und komplexe Neuronen - und arbeitet gleichzeitig mit mehreren Algorithmen. Olshausen schlägt vor, dass wir ungefähr 15% der Aktivität des visuellen Kortex verstehen. Obwohl die Modelle voranschreiten, sind die Neurowissenschaften immer noch "der Physik vor Newton ähnlich", sagt er. Dennoch ist er zuversichtlich, dass der Prozess der Arbeit auf der Grundlage dieser Algorithmen eines Tages das Haupträtsel des Gehirns erklären kann - wie Daten aus den Sinnesorganen in einen subjektiven Realitätssinn umgewandelt werden. Bewusstsein, sagt Olshausen, "ist etwas, das aus der Realität hervorgeht, eine sehr komplexe Boltzmann-Maschine."