Was als KI bezeichnet werden kann und was nicht - in gewissem Sinne hängt von der Definition ab. Es ist nicht zu leugnen, dass AlphaGo - eine KI, die vom Google DeepMind-Team entwickelt und den Weltmeister besiegt wurde - sowie ähnliche Systeme, die in den letzten Jahren eingehend trainiert wurden, in der Lage waren, recht komplexe Rechenprobleme zu lösen. Aber werden sie uns zu einer echten, vollständigen KI führen, zu verallgemeinerter Intelligenz oder OI? Kaum - und hier ist warum.

Eines der Hauptmerkmale des OI, mit dem Sie sich beim Erstellen befassen müssen, ist, dass es in der Lage sein muss, unabhängig mit der Außenwelt umzugehen und ein eigenes internes Verständnis für alles zu entwickeln, was es trifft, hört, sagt oder tut. Andernfalls befinden Sie sich in den Händen moderner KI-Programme, deren Bedeutung vom Anwendungsentwickler festgelegt wurde. Die KI versteht in der Tat nicht, was passiert, und ihr Spezialisierungsbereich ist sehr eng.

Das Problem der Bedeutung ist vielleicht die grundlegendste Aufgabe der KI und wurde noch nicht gelöst. Einer der ersten, der dies ausdrückte, war der Kognitionswissenschaftler Stevan Harnad, der 1990 die Arbeit „Das Problem der Symbolübereinstimmung“ schrieb. Auch wenn Sie nicht glauben, dass wir Symbole manipulieren, bleibt die Aufgabe bestehen: die im System vorhandene Repräsentation mit der realen Welt zu vergleichen.

Im Einzelnen stellen wir fest, dass die Aufgabe des Verstehens uns zu vier Unteraufgaben führt:

1. Wie strukturiere ich die Informationen, die eine Person (Person oder KI) von der Außenwelt erhält?

2. Wie kann man diese strukturierten Informationen mit der Welt verbinden, dh wie kann man ein Verständnis der Welt für eine Person aufbauen?

3. Wie kann man dieses Verständnis mit anderen Persönlichkeiten synchronisieren? (Andernfalls wird die Kommunikation unmöglich und der Intellekt wird sich als unerklärlich und isoliert herausstellen.)

4. Warum macht eine Person etwas? Wie starte ich diese ganze Bewegung?

Das erste Problem, die Strukturierung, wird durch tiefes Lernen und ähnliche Trainingsalgorithmen, die keine Überwachung erfordern, gut gelöst - es wird beispielsweise in AlphaGo verwendet. In diesem Bereich haben wir insbesondere dank der jüngsten Zunahme der Rechenleistung und des Einsatzes von GPUs, die die Informationsverarbeitung besonders gut parallelisieren, erhebliche Erfolge erzielt. Diese Systeme arbeiten, indem sie ein übermäßig redundantes Signal, das im mehrdimensionalen Raum ausgedrückt wird, auf Signale kleinerer Dimensionen reduzieren und gleichzeitig den Informationsverlust minimieren. Mit anderen Worten, sie erfassen einen wichtigen Teil des Signals aus Sicht der Informationsverarbeitung.

Das zweite Problem, das Problem der Verbindung von Informationen mit der realen Welt, dh die Schaffung von "Verständnis", steht in direktem Zusammenhang mit der Robotisierung. Um mit der Welt zu interagieren, braucht man einen Körper, und um diese Verbindung aufzubauen, muss man mit der Welt interagieren. Daher argumentiere ich oft, dass es ohne Robotisierung keine KI gibt (obwohl es ausgezeichnete Roboter ohne KI gibt, aber das ist eine andere Geschichte). Dies wird oft als "Problem der Verkörperung" bezeichnet, und die meisten KI-Forscher sind sich einig, dass Intelligenz und Verkörperung eng miteinander verbunden sind. In verschiedenen Körpern gibt es verschiedene Formen der Intelligenz, die von Tieren leicht gesehen werden können.

Alles beginnt mit so einfachen Dingen wie der Suche nach Bedeutung in Ihren eigenen Körperteilen und wie man sie kontrolliert, um den gewünschten Effekt in der sichtbaren Welt zu erzielen, wie das Gefühl von Raum, Distanz, Farbe usw. aufgebaut wird. In diesem Bereich wurden detaillierte Untersuchungen von einem Wissenschaftler wie J. Kevin O'Regan durchgeführt, der für seine "sensomotorische Bewusstseins-Theorie" bekannt ist. Dies ist jedoch nur der erste Schritt, da dann immer abstraktere Konzepte auf Basis dieser weltlichen sensomotorischen Strukturen aufgebaut werden müssen. Wir haben diesen Punkt noch nicht erreicht, aber die Forschung zu diesem Thema ist bereits im Gange.

Das dritte Problem ist die Frage nach dem Ursprung der Kultur. Bei einigen Tieren können die einfachsten Formen der Kultur verfolgt und sogar Fähigkeiten über Generationen hinweg übertragen werden, jedoch in einem sehr begrenzten Volumen, und nur Menschen haben die Schwelle des exponentiellen Wachstums des erworbenen Wissens erreicht, das wir Kultur nennen. Kultur ist ein Katalysator für Intelligenz, und KI, die nicht in der Lage ist, kulturell zu interagieren, ist nur von akademischem Interesse.

Kultur kann jedoch nicht manuell als Code in die Maschine eingegeben werden. Es sollte das Ergebnis eines Lernprozesses sein. Der beste Weg, um diesen Prozess zu verstehen, ist die

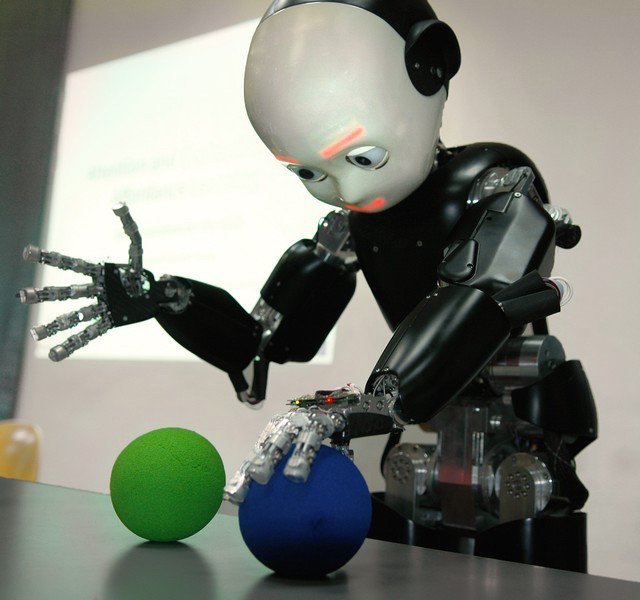

Entwicklungspsychologie . Die Arbeit zu diesem Thema wurde von Jean Piaget und Michael Tomasello durchgeführt, die den Prozess des Erwerbs von kulturellem Wissen durch Kinder untersuchten. Dieser Ansatz brachte eine neue Disziplin der Robotik hervor, die „Roboterentwicklung“, bei der ein Kind als Modell herangezogen wurde (wie dies beim iCub-Roboter in der Abbildung der Fall ist).

Diese Frage hängt auch eng mit dem Studium des Sprachlernprozesses zusammen, und dies ist eines der Themen, die ich selbst studiere. Die Arbeit von Menschen wie Luc Steels und anderen hat gezeigt, dass der Prozess des Erwerbs einer Sprache mit der Evolution verglichen werden kann: Eine Person schafft neue Konzepte, indem sie mit der Welt interagiert, sie zur Kommunikation mit anderen Persönlichkeiten verwendet und Strukturen auswählt, die dazu beitragen, erfolgreicher als andere zu kommunizieren (hauptsächlich um gemeinsame Ziele zu erreichen). Nach Hunderten von Versuchen und Irrtümern, wie im Fall der biologischen Evolution, generiert das System das beste Konzept und seine syntaktische / grammatikalische Übersetzung.

Dieser Prozess wurde experimentell getestet und ist überraschend ähnlich wie sich natürliche Sprachen entwickeln und wachsen. Er ist auch für das sofortige Lernen verantwortlich, wenn eine Person das Konzept sofort wahrnimmt - solche Dinge können solche statistikbasierten Modelle wie Deep Learning nicht erklären. Mehrere Forschungslabors, die diesen Ansatz verwenden, versuchen nun, den Weg der Wahrnehmung von Grammatik, Gesten und komplexeren kulturellen Phänomenen weiter zu beschreiten. Dies ist insbesondere das AI Lab, das von mir in der französischen Firma Aldebaran für Robotik gegründet wurde. Jetzt ist es Teil der SoftBank-Gruppe geworden - sie haben die Roboter

Nao ,

Romeo und

Pepper (unten) entwickelt.

Und schließlich ist das vierte Problem mit „intrinsischer Motivation“ konfrontiert. Warum tut eine Person überhaupt etwas und ist nicht nur in Ruhe? Überlebensanforderungen reichen nicht aus, um menschliches Verhalten zu erklären. Selbst wenn Sie eine Person füttern und für die Sicherheit sorgen, wartet sie nicht auf die Rückkehr des Hungers. Die Menschen studieren die Umwelt, versuchen etwas zu tun und werden von irgendeiner Form von Neugier getrieben. Der Forscher Pierre-Yves Oudeyer hat gezeigt, dass der einfachste mathematische Ausdruck von Neugier in Form des Wunsches einer Person, die Lerngeschwindigkeit zu maximieren, ausreicht, um überraschend komplexes und unerwartetes Verhalten zu erzeugen (siehe zum Beispiel ein Experiment mit einem „Spielplatz“, das in durchgeführt wurde Sony CSL).

Anscheinend ist für das System etwas Ähnliches erforderlich, um den Wunsch zu wecken, die drei vorherigen Schritte zu durchlaufen: Strukturieren Sie die Informationen über die Welt, kombinieren Sie sie mit Ihrem Körper und erstellen Sie aussagekräftige Konzepte. Wählen Sie dann aus Sicht der Kommunikation die effektivste aus, um eine Verbindung herzustellen eine Kultur, in der Zusammenarbeit möglich ist. Aus meiner Sicht ist dies genau das, was das OI-Programm ist.

Ich wiederhole, dass die rasche Entwicklung des Deep Learning und der jüngste Erfolg einer solchen KI in Spielen wie go eine sehr gute Nachricht sind, da diese KI viele Anwendungspunkte in der medizinischen Forschung, in der Industrie, im Umweltschutz und in anderen Bereichen finden wird. Dies ist jedoch nur ein Teil des Problems, das ich hier zu erklären versuchte. Ich glaube nicht, dass tiefes Lernen ein Allheilmittel ist, das uns zu einer echten KI im Sinne einer Maschine führt, die lernen kann, in Frieden zu leben, auf natürliche Weise mit uns zu interagieren, die Komplexität unserer Emotionen und kulturellen Verzerrungen zu verstehen und uns letztendlich dabei zu helfen, die Welt zu einem besseren Ort zu machen.