HDD oder einfach eine Festplatte eroberte vom Moment ihres Auftretens an schnell den Markt für Speichergeräte und Datenverarbeitung. Jetzt werden sie schrittweise durch SSDs ersetzt, deren Modellpalette eine Vielzahl von Merkmalen wie Lese- / Schreibgeschwindigkeit, physische Größe, Volumen usw. aufweist. Aber am Anfang, in jenen Tagen, als sogar die Festplatte als Neuheit angesehen wurde, gab es einige sehr seltsame, aber überraschende Modelle, von denen ich Ihnen heute erzählen möchte.

Microsolutions RucksackWas ist der häufigste Port, den selbst ein Anfänger in der Welt der Computer kennt? Natürlich USB. Damit verbinden wir externe Speichermedien mit unseren PCs, oder? Und das war nicht immer so. In den frühen 90er Jahren, als USB nicht in Frage kam, wurde die Backpack-Festplatte von Microsolutions veröffentlicht. Seine Funktion war die Art der Verbindung - über den Anschluss für den Drucker. Das erste Modell war bis zu 80 MV.

Der Treiber dieses Geräts musste CONFIG.SYS nur eine Zeile hinzufügen, und er verbrauchte weniger als 5 KB Speicher. Der Rucksack lief zum Zeitpunkt der Veröffentlichung so schnell wie interne IDE-Laufwerke mit 80 oder 512 MV. Die Übertragungsrate betrug etwa 1 MB pro Sekunde. Im Gegensatz zu Zip-Laufwerken waren Rucksäcke echte Festplatten mit einer typischen Leistungsmetrik - einer Suchzeit von 12 ms. Es war sogar möglich, eine Kette solcher Festplatten zu erstellen, indem man sie miteinander verband.

Quanten-BigfootBigfoot-Festplattenhersteller haben es sich zur Aufgabe gemacht, ein zuverlässiges und schnelles Datenspeichergerät zu den niedrigsten Kosten pro Megabyte zu entwickeln. Und sie näherten sich diesem Problem sehr ungewöhnlich mit dem 5,25-Zoll-Formfaktor (der Größe einer CD-ROM oder einer alten Diskette). Was ist der Punkt? Mit 5,25-Zoll-Platten konnten mehr Daten gespeichert werden als auf Standard-3,5-Zoll-CDs. Die Drehzahl war nicht die größte - nur 3600 U / min, aber aufgrund des vergrößerten Umfangs war sie höher als die der gleichen CDs. Ganz zu schweigen von der Tatsache, dass die Kosten für Quantum Bigfoot deutlich niedriger waren.

Bei der Arbeit mit einem großen Formfaktor gab es jedoch erhebliche Mängel. Die durchschnittliche Suchzeit für Bigfoot betrug nicht mehr als 12-14 Millisekunden. Obwohl dies eine großartige Leistung für eine so große Festplatte ist. Ein noch wichtigeres Problem war die Latenz (Verzögerung). Um dieses Problem besser zu verstehen, sind nachfolgend die Vergleichsindikatoren für Bigfoot und HDD anderer Hersteller aufgeführt:

Wenn wir uns die Spalte ganz rechts ansehen, sehen wir, dass zwei SCSI-Laufwerke (nämlich WD und Cheetah) die Leistung verdoppelten, aber ihre Kosten waren 1000 USD höher als die von IDE-Laufwerken. Der 3,5-Zoll-Medaillengewinner war jedoch nur 30 US-Dollar teurer als Bigfoot und deutlich schneller. Und wenn Sie die Kosten für Bigfoot um 60 Evergreens erhöhen, erhalten Sie Deskstar 4 mit 5400 U / min.

Bigfoot-Antriebe sind sicherlich interessant, aber Quantum konzentrierte sich immer noch nicht auf Geschwindigkeit und Leistung, sondern auf Kosten.

Iomega Zip DriveFestplatten mit Wechseldatenträgern waren noch nie so beliebt, mit Ausnahme des Zip-Laufwerks von Iomega, das sich auf dem Höhepunkt mehrerer Jahre befand. Für ein paar hundert Dollar könnten Sie ein externes Parallelport-Gerät mit 100-MB-Kassetten erhalten, ähnlich wie bei überwachsenen Disketten. Sie können beliebig oft in das Gerät eingesetzt werden. Die Leistung war sehr akzeptabel, obwohl die Kosten für ein Megabyte extrem hoch waren. Datenübertragungsrate - 1 MB pro Sekunde. Nicht schlecht. Aber die Suchzeit war nicht so fröhlich - bis zu 29 ms.

Insgesamt war Zip Drive zu klein, zu langsam und zu teuer, um ein Massenprodukt zu werden. Zu einer Zeit waren sie jedoch sehr beliebt, weil sie etwas Ungewöhnliches und Neues auf dem Markt waren.

SDX-LaufwerkeSDX bedeutete eine schnellere Datenspeicherung. Es war keine richtige Festplatte. Es war vielmehr eine neue Methode zum Implementieren der Verbindung eines CD-ROM-Laufwerks. Zunächst ein kleiner Hintergrund.

Die Standardmethode zum Anschließen des Laufwerks an einen PC verfügt über einen dedizierten Bus: Frühere Modelle (meistens mit einfacher und doppelter Geschwindigkeit) verwendeten eine von drei Verbindungen: Panasonic, Mitsumi oder Sony. SCSI war und ist eine weitere effektive, wenn auch recht teure Option. Fast alle moderneren CD-ROM-Laufwerke verwendeten den ATA-Bus, besser bekannt als IDE. IDE-CDs waren schnell, kostengünstig und einfach einzurichten. Lange Zeit verfügten alle PCs über zwei IDE-Controller, von denen jeder zwei IDE-Geräte unterstützen konnte: normalerweise Festplatten und CD-ROMs, obwohl auch Bandlaufwerke und CD-ROMs in der IDE verfügbar waren. (DVD-Laufwerke kamen später, aber es funktionierte nach den gleichen Prinzipien.)

In der Regel wurde ein CD-Laufwerk als eigenständiges Gerät auf einem zweiten IDE-Controller oder als Kopie einer Festplatte auf einem primären IDE-Controller konfiguriert. Die Leistung war gut: Die maximale IDE-Datenrate für den ATA-33 erreichte 33 Mbit / s.

Der SDX-Betrieb von Western Digital war völlig anders: Die SDX-CD wurde für die Verbindung mit einer SDX-Festplatte entwickelt, die wiederum mit einem Standard-IDE-Controller verbunden ist. Dies ist kein IDE-Slave, SDX verwendet im Allgemeinen eine andere Verbindung. Mit einem 10-poligen Kabel anstelle eines 40-poligen IDE-Kabels.

Eine SDX-Festplatte wurde installiert, um das relativ langsame CD-ROM-Laufwerk automatisch zwischenzuspeichern, was die Suchzeit auf der Festplatte erheblich beschleunigte und eine etwas höhere Datenübertragungsgeschwindigkeit ergab, was die Leistung der CD-ROM erhöhte. Dies war die Hauptaufgabe des SDX-Cache für Festplatten.

Der Cache kann die CD-Leistung erheblich beeinträchtigen. CD-ROM-Caching-RAM existiert seit Beginn der Zwei-Geschwindigkeits-Laufwerke und ist ein Standardbestandteil aller wichtigen Betriebssysteme. Beispielsweise verwendete das alte DOS Smart Drive automatisch eine kleine Menge RAM, um ein CD-Laufwerk sowie eine Festplatte zwischenzuspeichern. (Vorausgesetzt, Sie haben SMARTDRV nach MSCDEX heruntergeladen.) Obwohl der Arbeitsspeicher sehr schnell war - etwa 2.000-mal schneller als das CD-ROM-Laufwerk -, betrug die maximal vernünftige Cache-Größe basierend auf dem Arbeitsspeicher in jenen Tagen nur wenige MB. und für CDs - ca. 650 MB.

Eine praktischere Idee war die Verwendung einer Festplatte zum Zwischenspeichern eines CD-Laufwerks. In den neunziger Jahren war die Festplatte viel langsamer als der Arbeitsspeicher, aber immer noch etwa zehnmal schneller als eine CD-ROM. Selbst dann waren die meisten Festplatten so groß, dass das Einrichten von etwa einem Gigabyte für den CD-Cache normalerweise praktisch war. Darüber sprach SDX. Die SDX-Festplatte wurde zum Zwischenspeichern der daran angeschlossenen SDX-CD-ROM-Laufwerke entwickelt. Grob gesagt kann SDX die Leistung eines CD-Laufwerks verdoppeln, ohne zusätzliche CPU- oder PCI-Ressourcen zu verwenden und ohne Dateisysteme eine weitere Schicht hinzuzufügen.

Andererseits war es nicht erforderlich, ein neues und nicht standardmäßiges CD-ROM-Laufwerk zu verwenden, um die Vorteile einer CD-Cache-Festplatte zu nutzen. Dies kann problemlos in Software mit Leistungssteigerungen von mindestens SDX durchgeführt werden. Es gab mehrere Software-CDs, die mit jeder Art von CD funktionierten: alt oder neu, IDE oder SCSI. (Auch die alten Zwei-Gang-Laufwerke Panasonic, Mitsumi und Sony).

Vorteile von SDX- CD-Laufwerk-Caching ohne zusätzliche CPU- oder PCI-Bus-Ressourcen.

- Der Cache auf Firmware-Ebene erforderte keine Betriebssystemunterstützung, daher funktionierte SDX automatisch mit Unix, OS / 2, Linux und MacOS und nicht nur mit DOS und Windows.

- Zukünftige Aktualisierungen der Festplatte können dazu führen, dass das CD-ROM-Laufwerk auch effektive Leistungsverbesserungen bietet.

- Die Produktion von SDX-CDs war etwas günstiger.

SDX Nachteile- Aktualisieren von SDX-CD-ROMs ausschließlich auf andere Modelle derselben Marke.

- Sehr begrenzte Unterstützung.

- Die Kosten für die Festplatte sind leicht erhöht.

- Die Unfähigkeit, in Laptops zu verwenden.

Vorteile, die SDX und Software gemeinsam haben- Eine signifikante Steigerung der CD-Leistung ist eine minimale Steigerung für große Dateien, eine größere Steigerung der Leistung für kleine Dateien.

- Längere Lebensdauer von CD-ROM-Laufwerken.

Software-Vorteile- Es gibt viele weitere Optionen für das intelligente Caching, einschließlich des Vorabrufs bestimmter Dateien aus gängigen Programmnamen.

- Zulässige dynamische Anpassung der gesamten Cache-Größe ohne erneute Partitionierung der Festplatte.

- Arbeitete mit jeder Art von Festplatte oder CD-ROM-Laufwerk, neu oder vorhanden.

- Erlaubte freie Wahl der Festplattenmarke und der Cache-Software.

- Viel einfacher zu aktualisieren.

Softwarefehler- Eine leicht erhöhte Prozessorlast - um 3-4%.

- Dem Windows-Dateisystem wurde eine weitere komplexe Ebene hinzugefügt.

- Eingeschränkte Unterstützung für das Betriebssystem.

Um den vollen Erfolg zu erzielen, musste SDX mit anderen Festplattenherstellern zusammenarbeiten, nicht nur mit Western Digital. WD sagte, dass sie beabsichtigten, die SDX-Schnittstelle zu einem offenen Standard wie einer IDE oder SCSI zu machen, aber sie taten dies nicht rechtzeitig. Andere Hersteller von Festplatten, insbesondere Maxtor, wollten SDX verwenden, aber WD forderte Lizenzgebühren an, was andere Hersteller, die dies als generell im Widerspruch zu den Open-Access-Prinzipien betrachteten, sehr abstieß. Zum Beispiel war die Ultra ATA-Technologie von Quantum völlig kostenlos.

Es konnte der Schluss gezogen werden, dass WD nur mehr Geld mit Lizenzgebühren verdienen wollte, bevor seine Technologie öffentlich verbreitet und als einheitlicher Standard eingeführt wurde. Ende 1997 führte dies zu ernsthaften Meinungsverschiedenheiten zwischen den Festplattenherstellern, und WD musste seine napoleonischen Pläne aufgeben.

Western Digital PortfolioMitte der 90er Jahre erhielt Western Digital eine Ohrfeige aus der Welt der Computertechnologie für seine seltsamen Ideen (siehe Absatz oben). Aber sie beschlossen, nicht aufzugeben und hörten hier nicht auf. Ein neuer Portfolio-Festplattentyp mit einem nicht standardmäßigen Formfaktor für Laptops wurde eingeführt - 3 Zoll, nicht Standard 2,5. Zuerst schien es, dass dies eine andere verrückte Idee war. Wenn das Prinzip eines Laptops kleiner und einfacher ist, warum dann größer machen? WD sagte jedoch, sie hätten einen Weg gefunden, mit einer etwas größeren Festplatte mehr Speicher auf weniger Platz zu bekommen.

Zu dieser Zeit zielte die Entwicklung von Laptops auf größere, aber gleichzeitig flachere Modelle ab. All dies war auf die Zunahme der Bildschirme zurückzuführen. Portfolio hielt mit diesen Trends Schritt. Eine Vergrößerung von einem halben Zoll ermöglichte eine Erhöhung der Speicherkapazität auf einem einzelnen Laufwerk um bis zu 70%. Mit einer etwas größeren Platte konnten WDs doppelt so viele Informationen pro Kubikzoll auf der Festplatte speichern. Außerdem drehte sich eine solche Scheibe schneller und einfacher.

WD wiederum hatte einen sehr großen Konkurrenten mit seiner Vision, wie sich Festplatten entwickeln sollten. Dies ist IBM. Sie erhöhten die Produktivität aufgrund solcher Methoden und Technologien: Erstens eine signifikante Erhöhung der Datendichte, MRX- und GMR-Leseköpfe, Glasplatten, fortschrittliche PRML, erhöhte Rotationsgeschwindigkeit und intelligente Formatierung. Mit einem Anteil von 40% am Weltmarkt könnte es sich IBM natürlich leisten, auf dem Gebiet der Festplatten zu forschen.

Im Gegensatz dazu gab es ein innovatives 3-Zoll-Laufwerk von WD, das viel Geld sparte und keine hohe Datendichte erforderte, mit der der Hersteller immer Probleme hatte. So konnte sich WD in den Markt drängen und einen Teil davon erobern.

Der herausragendste Vertreter der Portfolio-Linie hatte eine sehr beeindruckende Spezifikation:

- 2 Platten 2,1 GB;

- MR- und PRML-Köpfe;

- Stoßfestigkeit 300/100 g;

- Suchzeit 14 ms;

- Drehzahl 4000 U / min;

- Datenübertragungsrate von 83 Mbit / s.

Solche Indikatoren waren nach den Flaggschiffen der IBM Laptop-Linie an zweiter Stelle.

Alles wäre in Ordnung, aber die finanziellen Probleme von WD führten dazu, dass die Portfolio-Linie im Januar 1998 auslief. Das gleiche wurde von einem anderen Hersteller von 3-Zoll-Rädern gemacht - JTS. In jenen Tagen litten viele Unternehmen genau unter einem Mangel an Finanzmitteln als unter einem Mangel an Ideen, und WD ist ein gutes Beispiel.

Seagate Barracuda 2 PSLeider werden diese Scheiben speziell für Seagate nicht mehr hergestellt. Zu dieser Zeit waren sie jedoch sehr beliebt, da sie sich von den anderen dadurch unterschieden, dass sie zwei Leseköpfe verwendeten, die letztendlich die doppelte Datenübertragungsgeschwindigkeit lieferten.

Eine große Anzahl von Lese- / Schreibköpfen ist nichts Einzigartiges, aber sie werden alle einzeln verwendet, und die maximale Datenübertragungsgeschwindigkeit hängt davon ab, wie viele Daten unter dem Kopf übertragen werden. Im Gegensatz dazu hat Barracuda 2HP den Datenstrom in zwei Hälften aufgeteilt, wobei jeweils eine Hälfte der beiden Köpfe gesendet und die Daten beim Lesen neu kompiliert wurden. In jenen Tagen gaben die besten Platten mit einer Rotationsgeschwindigkeit von 7200 U / min eine Übertragungsgeschwindigkeit von 50 - 60 Mbit / s, und Barracuda gab bis zu 113 Mbit / s aus, was diese Platte zu der schnellsten auf dem Planeten zu dieser Zeit machte.

Diese Idee war nicht neu, aber die erste, die weltweit umgesetzt wurde. Warum ist 2HP gerade jetzt verschwunden?

Dies liegt vor allem daran, dass Sie mit einem RAID-Array (das mehrere Festplatten in einer Struktur kombiniert) ähnliche Ergebnisse für die Datenübertragungsgeschwindigkeit erzielen können. In dieser Ausführungsform wird die komplexe Aufgabe des Trennens und Rekombinierens von Daten von dem RAID-Controller oder dem Software-Controller ausgeführt. Darüber hinaus ist RAID in den letzten Jahren zu einer günstigeren Option geworden, um die Festplattenleistung zu steigern.

Der zweite Grund für das Verschwinden der 2HP-Technologie war die Markteinführungszeit. 2HP-Entwickler haben viel Zeit damit verbracht, neue Modelle zu implementieren, die dieser Technologie entsprechen. Während andere Hersteller keine Zeit umsonst verschwendeten.

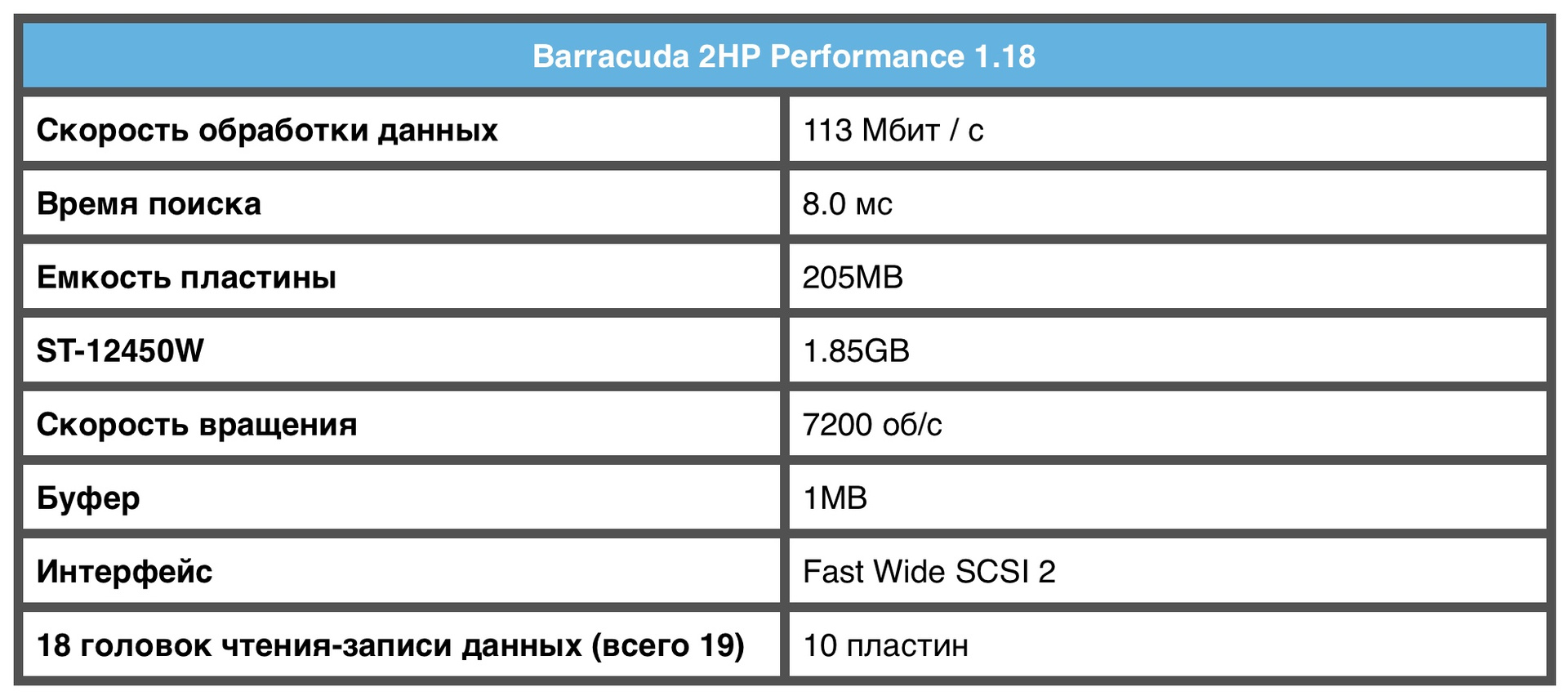

Barracuda 2HP Spezifikation Ibm Microdrive

Ibm MicrodriveIBM Microdrive mit einem Durchmesser von 1 Zoll ist viel leichter als PCMCIA, aber es ist immer noch eine echte Festplatte mit beweglichen Lese- / Schreibköpfen und einem winzigen 1-Zoll-Laufwerk, das sich mit einer unglaublichen Geschwindigkeit von 4500 U / min dreht.

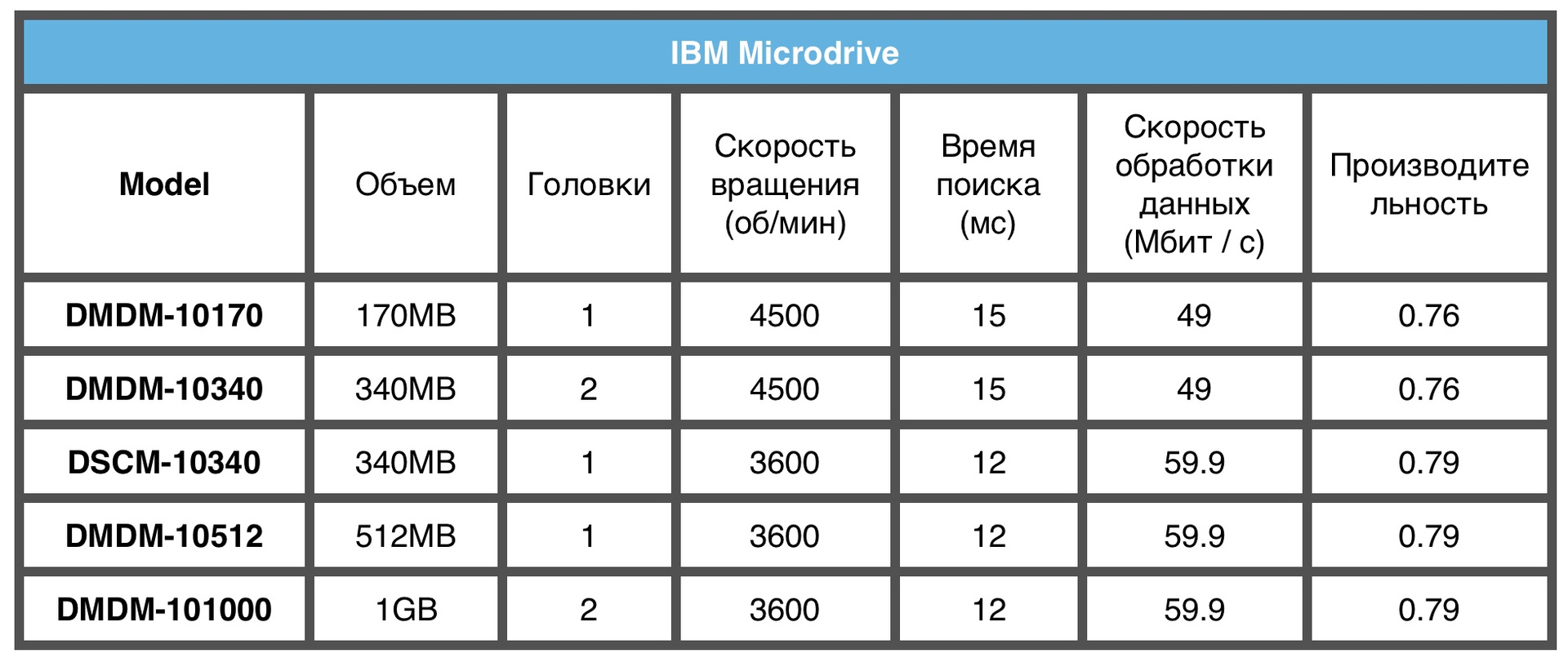

Die beiden veröffentlichten Modelle speicherten 170 und 360 MB Daten und ihre Leistung war vergleichbar mit der eines 20-Megabyte-Desktop-Laufwerks.

Die 170-MB-Version war einzigartig, da sie nur einen Lese- / Schreibkopf hat.

Bis Anfang der 2000er Jahre hatte keine einzige Festplatte nur einen Kopf.

IBM Microdrive-Modellspezifikationen

Natürlich gibt es mittlerweile viele moderne Laufwerke mit einer Leistung, die viel höher ist als die der Vertreter auf unserer Liste, aber sie bleiben aufgrund ihrer damals einzigartigen Technologie ein wesentlicher Bestandteil der Geschichte der Festplatten und verdienen daher Aufmerksamkeit. Sie dienten als Anstoß für die Entwicklung und Forschung von HDD und später von SSD.

Als Werbung. Förderung! Erst jetzt können Sie

VPS (KVM) mit dedizierten Laufwerken in den Niederlanden und den USA bis zu 4 Monate kostenlos nutzen (Konfigurationen von VPS (KVM) - E5-2650v4 (6 Kerne) / 10 GB DDR4 / 240 GB SSD oder 4 TB HDD / 1 Gbit / s 10 TB - 29 USD / Monat und höher, Optionen mit RAID1 und RAID10 sind verfügbar) , ein vollwertiges Analogon dedizierter Server. Wenn Sie für einen Zeitraum von 1-12 Monaten bestellen, sind die

Bedingungen der Aktion hier, bestehende Abonnenten können 2 Monate als Bonus erhalten!

Wie man die Infrastruktur des Gebäudes baut. Klasse mit Dell R730xd E5-2650 v4 Servern für 9.000 Euro für einen Cent?