Anscheinend ist die Ära des GPU-Computing gekommen! Intel geht es schlecht. Wenn Sie meinen Blog in den letzten Jahren nicht regelmäßig gelesen haben, erkläre ich, dass ich [

Alex St. John ] 1994

an den Ursprüngen des ursprünglichen DirectX-Teams bei Microsoft stand und die Direct3D-API zusammen mit anderen ersten directX-Entwicklern (Craig Eisler und Eric Engstrom) und trug zu seinem Vertrieb in der Videospielbranche und unter Grafikchipherstellern bei. Zu diesem Thema in

meinem Blog finden Sie viele Geschichten, aber die, die in direktem Zusammenhang mit diesem Beitrag steht, habe ich 2013 geschrieben.

Nvidia Geschichte

Ich denke, dass die Version der zukünftigen Spiele von Nvidia korrekt ist, und ich genieße es wirklich, in einer Zeit zu leben, in der ich mit solch erstaunlichen Computerfähigkeiten arbeiten kann. Es scheint mir, dass ich eine Ära erlebt habe, in der ich die Enterprise- Brücke entlang gehen und mit dem Warp-Antrieb spielen kann. Und im wahrsten Sinne des Wortes - Nvidia nennt den Warp die minimale Einheit paralleler Prozesse, die auf der GPU ausgeführt werden können.

Diejenigen, die Aktienkursen folgen, haben möglicherweise bemerkt, dass die Aktien von Nvidia nach vielen Jahren langsamen Anstiegs in letzter Zeit stark gestiegen sind. Es scheint mir, dass dieser plötzliche Durchbruch eine revolutionäre Veränderung im Computer-Computing ankündigt, die den Höhepunkt langjähriger Fortschritte in der

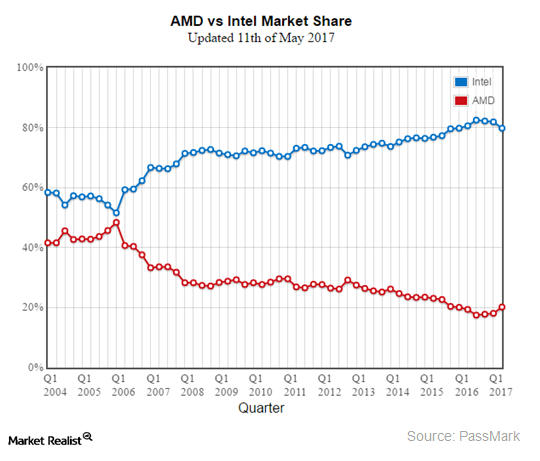

GPGPU- Entwicklung darstellt. Bis heute hat Intel das Monopol über das Computing auf dem Industriemarkt aufrechterhalten und die Angriffe der Wettbewerber auf ihre Überlegenheit im Industrial Computing erfolgreich abgewehrt. Diese Dominanz ist in diesem Jahr zu Ende gegangen, und der Markt sieht, dass sie sich nähert. Um zu verstehen, was passiert und warum dies passiert, werde ich auf meine frühen Jahre bei Microsoft zurückkommen.

In den 90er Jahren prägte Bill Gates den Begriff „Kooperation“ (Kooperation = Wettbewerb + Kooperation), um gefolterte Wettbewerbspartnerschaften mit anderen Technologieführern der damaligen Zeit zu beschreiben. Wenn es um Intel geht, tauchte der Begriff besonders oft auf. Und während das Schicksal und der Erfolg von Microsoft und Intel immer enger miteinander verflochten waren, kämpften die beiden Unternehmen ständig um die Vorherrschaft. Beide Unternehmen hatten Teams von Leuten, die sich darauf spezialisiert hatten, einen Vorteil gegenüber ihren Konkurrenten zu erlangen. Paul Maritz, der damalige Geschäftsführer von Microsoft, war sehr besorgt, dass Intel versuchen könnte, Windows zu virtualisieren, sodass viele andere konkurrierende Betriebssysteme auf den Markt kommen und parallel zu Windows auf einem Desktop-PC existieren könnten. Interessanterweise wurde Paul Maritz später CEO von VMWARE. In der Tat hat Intel aktiv in solche Versuche investiert. Eine ihrer Strategien war der Versuch, auf Software-Ebene alle allgemein akzeptierten Eisenfunktionen zu emulieren, mit denen OEMs normalerweise PCs lieferten - Grafikkarten, Modems, Soundkarten, Netzwerkgeräte usw. Durch die Übertragung sämtlicher externer Computer auf den Intel-Prozessor könnte das Unternehmen den Umsatz und das Wachstum aller möglichen alternativen Computerplattformen zerstören, die andernfalls wachsen und die CPU von Intel gefährden könnten. Insbesondere die Ankündigung der 3DR-Technologie durch Intel im Jahr 1994 veranlasste Microsoft, DirectX zu erstellen.

Ich arbeitete für das Team von Microsoft, das für die strategische Positionierung des Unternehmens im Lichte der Wettbewerbsbedrohungen auf dem Markt verantwortlich war, der „Developer Relations Group“ (DRG). Intel forderte Microsoft auf, einen Vertreter zu entsenden, um bei der 3DR-Präsentation zu sprechen. Als Experte für Grafik und 3D bei Microsoft wurde ich mit einer besonderen Mission beauftragt, die Bedrohung durch die neue Initiative von Intel zu bewerten und eine wirksame Strategie zu formulieren, um damit umzugehen. Ich entschied, dass Intel wirklich versuchte, Windows zu virtualisieren und auf Softwareebene alle möglichen Datenverarbeitungsgeräte zu emulieren. Ich schrieb einen Vorschlag mit dem Titel "Unterhaltung ernst nehmen", in dem ich vorschlug, die Versuche von Intel zu blockieren, Windows klein zu machen, um einen wettbewerbsfähigen Verbrauchermarkt für neue Hardwarefunktionen zu schaffen. Ich wollte einen neuen Satz von Windows-Treibern erstellen, die einen massiven Wettbewerb auf dem Hardwaremarkt ermöglichten, damit neue Medien wie Audio, Dateneingabe, Video, Netzwerktechnologien usw. arbeiten können. Auf dem PC-Spielemarkt, den wir entwickeln, hängen wir von unseren eigenen Windows-Treibern ab. Intel konnte die Konkurrenz auf dem freien Markt, die wir für Unternehmen geschaffen haben, die Eisen herstellen, nicht bewältigen und konnte daher keine CPU schaffen, die alle Funktionen, die Benutzer benötigen könnten, effektiv virtualisieren kann. Und so wurde DirectX geboren.

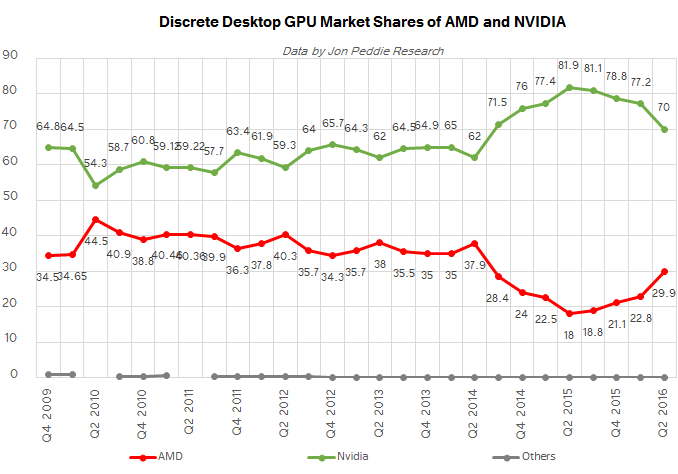

Auf diesem Blog finden Sie viele Geschichten über die Ereignisse rund um die Erstellung von DirectX, aber kurz gesagt, unsere „böse Strategie“ war ein Erfolg. Microsoft erkannte, dass es notwendig war, sich auf Videospiele zu konzentrieren, um den Verbrauchermarkt zu dominieren und Intel einzudämmen. Danach erschienen Dutzende Hersteller von 3D-Chips. Etwa 20 Jahre später dominierte Nvidia zusammen mit ATI, das seitdem von AMD übernommen wurde, unter den wenigen Überlebenden den Markt für Consumer-Grafiken und in jüngerer Zeit den Markt für industrielle Computer.

Dies bringt uns zurück in das laufende Jahr 2017, in dem die GPU endlich beginnt, x86-Prozessoren vollständig zu ersetzen, die alle mit Ehrfurcht behandelt haben. Warum jetzt und warum die GPU? Das Geheimnis der x86-Hegemonie war der Erfolg von Windows und die Abwärtskompatibilität mit x86-Anweisungen bis in die 1970er Jahre. Intel konnte sein Monopol auf dem Industriemarkt aufrechterhalten und erhöhen, da die Kosten für die Portierung von Anwendungen auf eine CPU mit einem anderen Befehlssatz, der keine Marktnische besetzt, zu hoch waren. Die phänomenalen Funktionen des Windows-Betriebssystems, die an die x86-Plattform gebunden sind, haben die Marktposition von Intel gestärkt. Der Anfang vom Ende kam, als Microsoft und Intel gemeinsam den Sprung zur Dominanz im aufstrebenden Markt für mobile Computer nicht schaffen konnten. Zum ersten Mal seit mehreren Jahrzehnten trat auf dem x86-CPU-Markt ein Riss auf, der von ARM-Prozessoren gefüllt wurde. Danach konnten neue alternative Windows-Betriebssysteme von Apple und Google einen neuen Markt erobern. Warum haben Microsoft und Intel diesen Sprung nicht geschafft? Sie können ein Auto aus interessanten Gründen finden, aber im Rahmen dieses Artikels möchte ich eines hervorheben - x86-Abwärtskompatibilitätsgepäck. Zum ersten Mal ist Energieeffizienz für den CPU-Erfolg wichtiger als Geschwindigkeit. Alle Transistoren und Millionen von Codezeilen für x86, die von Intel und Microsoft in PCs eingebettet wurden, sind zu Hindernissen für die Energieeffizienz geworden. Der wichtigste Aspekt der Markthegemonie von Intel und Microsoft wurde zu einem Zeitpunkt zu einem Hindernis.

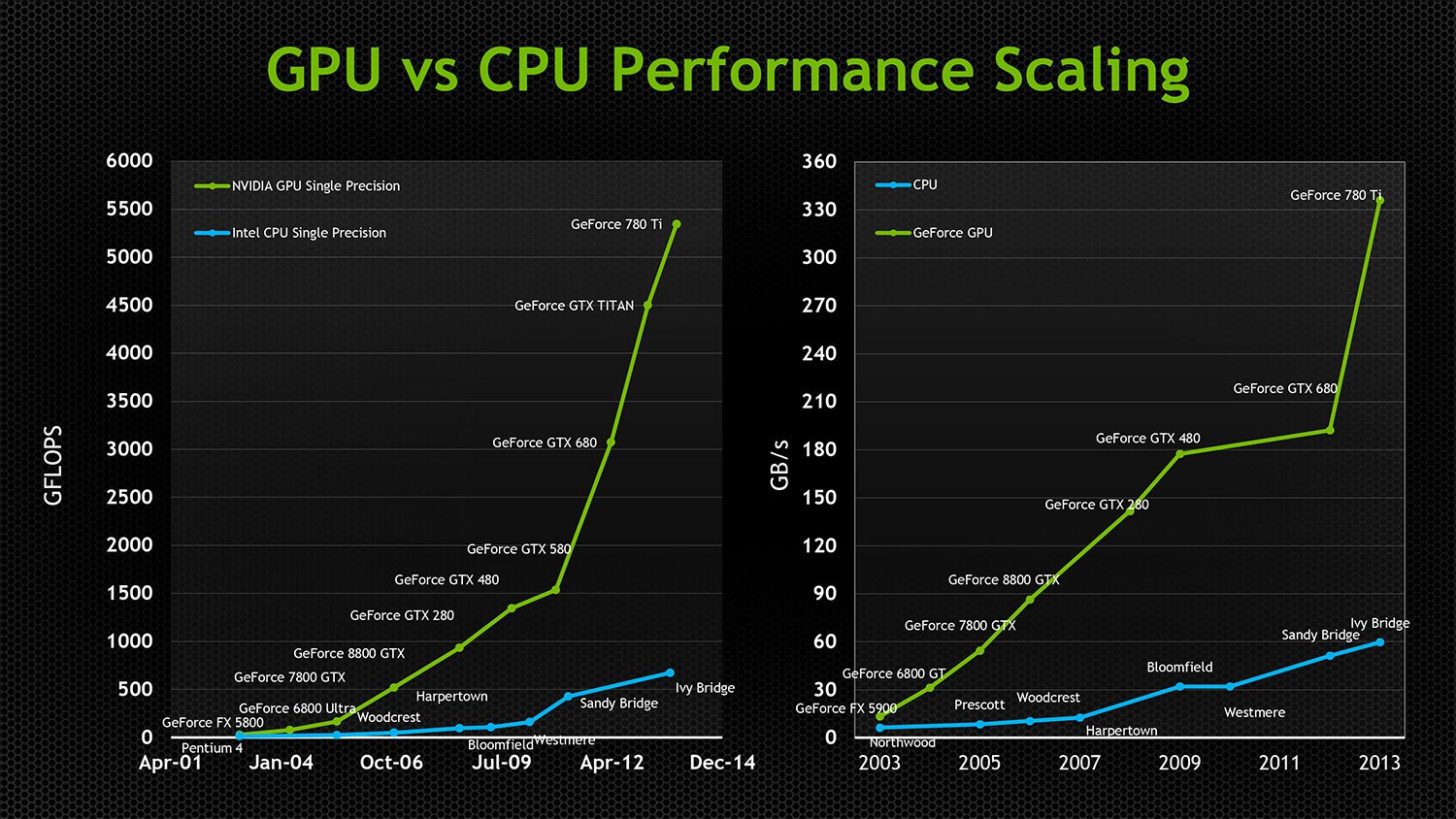

Das Bedürfnis von Intel nach einer konstanten Geschwindigkeitssteigerung und Unterstützung für Abwärtskompatibilität zwang das Unternehmen dazu, immer mehr energiehungrige Transistoren auszugeben, um bei jeder neuen Generation von x86-Prozessoren immer geringere Geschwindigkeitsgewinne zu erzielen. Die Abwärtskompatibilität hat auch die Fähigkeit von Intel, seine Chips zu parallelisieren, ernsthaft beeinträchtigt. Die erste parallele GPU erschien in den 90er Jahren, und die ersten Intel Dual-Core-CPUs wurden erst 2005 veröffentlicht. Bis heute kann die leistungsstärkste CPU von Intel nur 24 Kerne verarbeiten, obwohl die meisten modernen Grafikkarten über Prozessoren mit Tausenden von Kernen verfügen. Ursprünglich parallele GPUs hatten kein Gepäck mit Abwärtskompatibilität, und dank architekturunabhängiger Technologien konnten APIs wie Direct3D und OpenGL Innovationen entwickeln und die Parallelität erhöhen, ohne Kompromisse bei der Kompatibilität oder der Transistoreffizienz eingehen zu müssen. Bis 2005 waren GPUs sogar zu Allzweck-Computerplattformen geworden, die heterogenes Allzweck-Parallel-Computing unterstützen. Mit Heterogenität meine ich, dass die Chips von AMD und NVIDIA trotz der völlig unterschiedlichen Low-Level-Architektur und -Anweisungen dieselben kompilierten Programme ausführen können. Und zu einer Zeit, als Chips von Intel sinkende Leistungsspitzen erzielten, verdoppelte die GPU ihre Geschwindigkeit alle 12 Monate und reduzierte gleichzeitig den Stromverbrauch um die Hälfte! Durch die extreme Parallelisierung konnten Transistoren sehr effizient eingesetzt werden, sodass jeder der GPU hinzugefügte Transistor die Betriebsgeschwindigkeit effektiv beeinflussen konnte, während eine zunehmende Anzahl von x86-Transistoren, deren Anzahl zunahm, nicht ausgelastet war.

Obwohl GPUs zunehmend in industrielle Supercomputer, Medien und VDIs eindrangen, kam die Hauptwende auf dem Markt, als Google begann, GPUs effektiv einzusetzen, um neuronale Netze zu trainieren, die zu sehr nützlichen Dingen fähig sind. Der Markt erkannte, dass KI die Zukunft der Big-Data-Verarbeitung sein und riesige neue Automatisierungsmärkte eröffnen würde. GPUs waren ideal für den Betrieb neuronaler Netze geeignet. Bis zu diesem Zeitpunkt hat sich Intel erfolgreich auf zwei Ansätze verlassen, die den wachsenden Einfluss der GPU auf das Industrial Computing unterdrückt haben.

1. Intel hielt die PCI-Busgeschwindigkeit niedrig und begrenzte die Anzahl der von ihrem Prozessor unterstützten E / A-Pfade, wodurch sichergestellt wurde, dass GPUs immer von Intel-Prozessoren abhängen, um ihre Last zu verarbeiten, und von verschiedenen wertvollen Echtzeit-Hochgeschwindigkeits-Computeranwendungen getrennt bleiben Aufgrund von Verzögerungen und Einschränkungen der PCI-Bandbreite. Während ihre CPU den Anwendungszugriff auf die GPU-Geschwindigkeit beschränken konnte, blieb Nvidia an diesem Ende des PCI-Busses ohne Zugriff auf viele praktisch nützliche Industrielasten hängen.

2. Bereitstellung einer billigen GPU mit minimaler Funktionalität auf dem Consumer-Prozessor, um Nvidia und AMD vom Premium-Gaming-Markt und von der allgemeinen Akzeptanz durch den Markt zu isolieren.

Die wachsende Bedrohung durch die fehlgeschlagenen Versuche von Nvidia und Intel, x86-kompatible Supercomputer-Beschleuniger zu entwickeln, zwang Intel, eine andere Taktik zu wählen. Sie haben Altera erworben und möchten programmierbare FPGAs in die nächste Prozessorgeneration von Intel aufnehmen. Dies ist eine schwierige Methode, um sicherzustellen, dass der Intel-Prozessor im Vergleich zur eingeschränkten PCI-Bus-Hardware der Konkurrenz größere E / A-Funktionen unterstützt und die GPU keine Vorteile bietet. Durch die Unterstützung von FPGAs konnte Intel paralleles Computing auf seinen Chips unterstützen, ohne in die Tore des wachsenden Marktes für Anwendungen mit GPUs zu geraten. Außerdem konnten Hersteller von Industriecomputern hochspezialisierte Hardware erstellen, die immer noch von x86 abhängig ist. Dies war ein brillanter Schritt von Intel, da die Möglichkeit ausgeschlossen wurde, dass die GPU gleichzeitig in mehrere Richtungen in den Industriemarkt eintritt. Genial, aber höchstwahrscheinlich zum Scheitern verurteilt.

Fünf aufeinanderfolgende Nachrichten erklären den Grund, warum ich sicher bin, dass die x86-Party 2017 enden wird.

1.

Der VisionFund-Fonds von SoftBank erhält Investitionen in Höhe von 93 Milliarden US-Dollar von Unternehmen, die Intel ersetzen möchten2.

SoftBank kaufte ARM Holdings für 32 Milliarden US-Dollar3.

SoftBank kaufte Aktien von Nvidia für 4 Milliarden US-Dollar4. Nvidia startet

Project Denver [Codename für die Nvidia-Mikroarchitektur, die den 64/32-Bit-Befehlssatz ARMv8-A implementiert, wobei eine Kombination aus einem einfachen Hardware-Decoder und einem Software-Binärübersetzer mit dynamischer Neukompilierung verwendet wird. perev.]

5.

NVIDIA kündigte den Xavier

Tegra SOC mit einer Volta-GPU mit 7 Milliarden Transistoren, 512 CUDA-Kernen und 8 benutzerdefinierten ARM64-Kernen an - einem mobilen ARM / Hybrid-Chip mit GPU-beschleunigten ARM-Kernen.

Warum ist diese Abfolge von Ereignissen wichtig? In diesem Jahr kam die erste Generation unabhängiger GPUs mit breitem Zugang auf den Markt und kann ohne Hindernisse ein eigenes Betriebssystem in Form von PCI auf den Markt bringen. Nvidia benötigt keinen x86-Prozessor mehr. ARM verfügt über eine beeindruckende Anzahl von Betriebssystemen und Anwendungen für Verbraucher und Industrie, die auf diese portiert sind. Alle Industrie- und Cloud-Märkte wechseln für eine breite Palette ihrer Marktlösungen zu Chips von ARM als Controller. FPGAs sind bereits in ARM-Chips integriert. ARM-Chips verbrauchen wenig Strom, sind leistungsschwächer, aber GPUs sind extrem schnell und effizient, sodass GPUs Prozessorleistung bereitstellen können und ARM-Kerne mühsame E / A- und UI-Vorgänge ausführen können, für die keine Verarbeitungsleistung erforderlich ist. Immer mehr Anwendungen, die mit Big Data, Hochleistungsrechnern und maschinellem Lernen arbeiten, benötigen kein Windows mehr und funktionieren nicht unter x86. 2017 ist das Jahr, in dem Nvidia die Leine bricht und in wertvollen neuen Märkten, die nicht für x86-basierte Lösungen geeignet sind, zu einer wirklich wettbewerbsfähigen Alternative zum x86-basierten Industrial Computing wird.

Wenn der ARM-Prozessor nicht leistungsfähig genug für Ihre Anforderungen ist, wird

IBM in Zusammenarbeit mit Nvidia eine neue Generation von Power9-CPUs für die Verarbeitung großer Datenmengen mit 160 PCIe-Lanes herstellen.

AMD bringt auch eine neue Ryzen-CPU auf den Markt. Im

AMD bringt auch eine neue Ryzen-CPU auf den Markt. Im Gegensatz zu Intel hat AMD kein strategisches Interesse daran, die PCI-Leistung zu beeinträchtigen. Ihre Consumer-Chips unterstützen 64 PCIe 3.0-Lanes und die professionellen 128. AMD bringt außerdem einen neuen HIP-Cross-Compiler auf den Markt, der CUDA-Anwendungen mit AMD-GPUs kompatibel macht. Trotz der Tatsache, dass diese beiden Unternehmen miteinander konkurrieren, werden beide von der Verdrängung von Intel auf dem Industriemarkt durch alternative Ansätze für GPU-Computing profitieren.

All dies bedeutet, dass GPU-basierte Lösungen in den kommenden Jahren Industrial Computing mit zunehmender Geschwindigkeit erfassen werden und die Welt der Desktop-Schnittstellen zunehmend auf Cloud-Visualisierung oder Arbeiten an mobilen ARM-Prozessoren angewiesen sein wird, da sogar

Microsoft die Unterstützung von ARM angekündigt hat .

Alles in allem gehe ich davon aus, dass wir in einigen Jahren nur noch vom Kampf zwischen GPU und FPGA um den Vorteil im Industrial Computing hören werden, während die Ära der CPU allmählich endet.