Es lohnt sich wahrscheinlich nicht, ausführlich über das sogenannte

Mooresche Gesetz bei Geektimes zu sprechen - wir alle wissen es zumindest ungefähr. Kurz gesagt, dieses Gesetz ist eine empirische Beobachtung von Gordon Moore. Es gab mehrere Formulierungen des Gesetzes selbst, aber die moderne besagt, dass sich die Anzahl der auf einem Chip für integrierte Schaltkreise platzierten Transistoren alle 24 Monate verdoppelt. Wenig später erschien eine Art Gesetz, wo es nicht zwei Jahre, sondern 18 Monate erscheint. Dies liegt nicht an Moore, sondern an David House von Intel. Seiner Meinung nach sollte sich die Leistung von Prozessoren alle 18 Monate verdoppeln, da sowohl die Anzahl der Transistoren als auch die Geschwindigkeit jedes einzelnen von ihnen gleichzeitig zunehmen.

Seit dem Wortlaut des Gesetzes versuchen Entwickler elektronischer Elemente, mit den festgelegten Zeitrahmen Schritt zu halten. Im Allgemeinen war das Gesetz für 1965 etwas Ungewöhnliches, es kann sogar als radikal bezeichnet werden. Damals waren die „Mini-Computer“ noch nicht sehr klein und nahmen die Lautstärke eines normalen Desktops im Raum ein oder sogar noch mehr. Zu dieser Zeit war es schwer vorstellbar, dass Computer im Laufe der Zeit sogar Teil eines Kühlschranks, einer Waschmaschine oder anderer Haushaltsgeräte werden könnten. Die meisten Menschen haben nie einen Computer gesehen, und diejenigen, die ihn gesehen haben, haben fast nie mit ihnen gearbeitet. Nun, diejenigen, die arbeiteten, verwendeten Lochkarten und andere nicht sehr bequeme Werkzeuge für die Interaktion mit Computern, die wiederum dazu dienten, einen ziemlich engen Bereich von Aufgaben zu lösen.

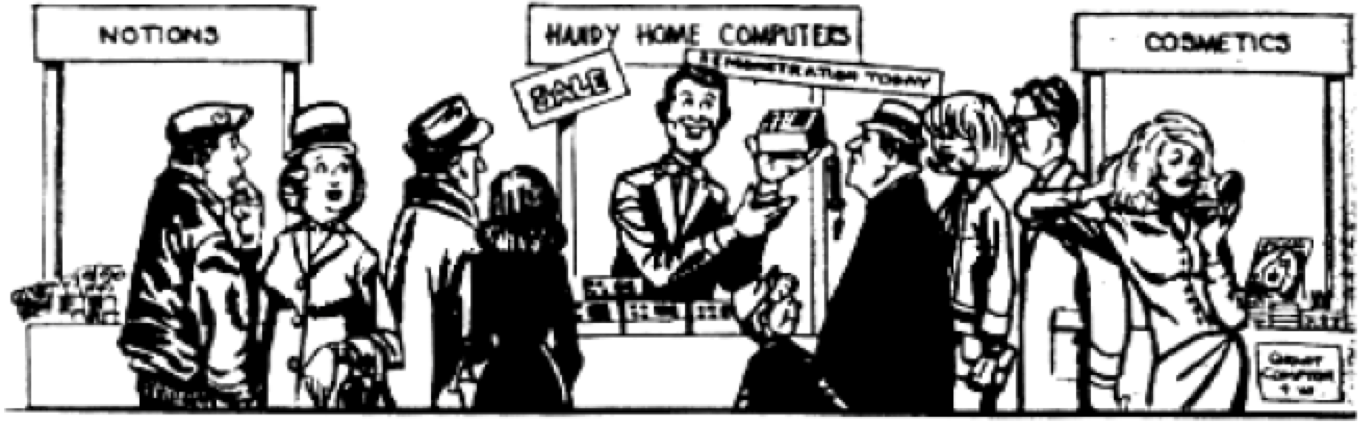

Nachdem die Idee von Moore bekannt wurde, fingen sie sogar an, in Zeitschriften zu scherzen. Zum Beispiel haben sie in einer von ihnen hier eine solche Karikatur gepostet:

Dann war es schwer vorstellbar, dass selbst solche Computer bald überhaupt nicht mehr als klein gelten würden. Moore sah die Illustration übrigens, und sie war sehr überrascht von ihrer Originalität. Soweit man das beurteilen kann, versuchte der Künstler eine etwas skeptische Haltung gegenüber der Idee zu vermitteln, die PC-Größe ständig zu reduzieren. Aber nach 25 Jahren wurde diese Illustration zur alltäglichen Realität.

Moores Gesetzeseinfluss

Wie oben erwähnt, gibt es verschiedene Variationen des Moore'schen Gesetzes. Wir sprechen nicht nur von einer konstanten Erhöhung der Anzahl der Transistoren im Chip. Eine der Konsequenzen von Moores Idee ist der Versuch herauszufinden, wie schnell alle schrumpfenden Transistoren arbeiten werden. Außerdem haben Wissenschaftler und Spezialisten für Informationstechnologie unter Verwendung der Idee von Moore versucht, vorherzusagen, wie schnell die RAM-Größe, der Hauptspeicher, die Produktivität der Chips usw. zunehmen werden.

Die Hauptsache ist jedoch nicht, welche Version von Moores Gesetz neugieriger / nützlicher ist, sondern welche Auswirkungen die Hauptidee auf unsere Welt hatte. Hier lassen sich drei Haupteinflussformen unterscheiden. Dies ist eine Rivalität von Entwicklern, die die Architektur von Computersystemen prognostizieren und ändern.

RivalitätDas Mooresche Gesetz kann verwendet werden, um herauszufinden, wie viele Informationen auf dem Volumen eines Chips gespeichert werden können. Dieses Gesetz kann übrigens dem RAM im Feld zugeschrieben werden. Zu Beginn der Computertechnologie oder besser gesagt des PCs könnte ein Computerchip gespeichert werden

. Die Chips selbst wurden als RAM (Random Access Memory) bezeichnet. Chips mit 16K begannen viele zu produzieren. Dann erschienen in voller Übereinstimmung mit Moores Gesetz oder noch schneller Chips mit 64 K. Die Ingenieure, die diese Chips entwickelten, kannten das Gesetz und versuchten, es einzuhalten. So wurde von Anfang an ein spezieller Produktionszyklus ohne Unterbrechung eingerichtet, als die Ingenieure, die einen Chip freigaben, bereits die Arbeiten an der nächsten Generation beendeten. Diese Situation wird jetzt beobachtet. Jeder kennt die Regeln und das Spiel und jeder nimmt daran teil.

PrognoseDa die Ingenieure eines der Unternehmen, die elektronische Komponenten herstellen, die Tendenz zu einer Erhöhung der Anzahl der Transistoren im Chipvolumen kannten (und die Formel zunächst klar genug war), konnten sie sich ungefähr vorstellen, wann welche Generation von Chips freigegeben werden würde. Und es war eine ziemlich genaue Vorhersage. Man könnte sich auch vorstellen, in welchem Jahr und mit welcher Leistung der Prozessor arbeiten wird.

Ingenieure in Unternehmen begannen mit der Erstellung von Produktionsplänen, die sich hauptsächlich auf das Mooresche Gesetz konzentrierten. Computerhersteller hatten eine gute Vorstellung davon, wann welche Maschinengeneration den Markt verlassen sollte und wann welche erscheinen sollte.

Man kann sagen, dass das Mooresche Gesetz den Produktionsprozess für die Herstellung elektronischer Komponenten und Systeme festgelegt hat. In dieser Hinsicht gab es keine Überraschungen, und es konnte auch keine geben, da alle mit ungefähr der gleichen Geschwindigkeit arbeiteten und nicht versuchten, den von Moore festgelegten Zeitrahmen zu überholen oder hinter ihm zurückzubleiben. Alles war perfekt vorhersehbar.

PC-Architektur und Elemente

PC-Architektur und ElementeTrotzdem erlaubte das Moore'sche Gesetz den Ingenieuren, ein Chipdesign zu entwickeln, das seit langem zum Maßstab geworden ist. Dies ist ein Intel 4004 und seine nachfolgenden Inkarnationen. Es wurde eine spezialisierte Architektur entwickelt, die

von Neumann-Architektur genannt wurde .

Im März 1945 wurden die Prinzipien der logischen Architektur in einem Dokument namens "Der erste Entwurf des EDVAC-Berichts" formalisiert - einem Bericht für das US Army Ballistic Laboratory, auf dessen Grundlage ENIAC aufgebaut und EDVAC entwickelt wurde. Da es sich nur um einen Entwurf handelte, war der Bericht nicht zur Veröffentlichung, sondern nur zur Verbreitung innerhalb der Gruppe bestimmt. German Goldstein, der Kurator des Projekts der US-Armee, vervielfachte diese wissenschaftliche Arbeit und sandte sie zur Überprüfung an einen breiten Kreis von Wissenschaftlern. Da auf der ersten Seite des Dokuments nur der Name von Neumann [1] stand, hatten die Leser des Dokuments den falschen Eindruck, er sei der Autor aller in der Arbeit vorgestellten Ideen. Das Dokument lieferte genügend Informationen, damit diejenigen, die es lesen, ihre Computer, ähnlich wie EDVAC, nach denselben Prinzipien und mit derselben Architektur bauen konnten, was infolgedessen als "von Neumann-Architektur" bekannt wurde.

Nach dem Ende des Zweiten Weltkriegs und dem Ende der Arbeiten an ENIAK im Februar 1946 löste sich das Team von Ingenieuren und Wissenschaftlern, John Mokley, John Eckert, auf, sich dem Geschäft zuzuwenden und Computer auf kommerzieller Basis zu entwickeln. Von Neumann, Goldstein und Burks zogen an das Institute for Advanced Research, wo sie beschlossen, eine eigene IAS-Maschine ähnlich wie EDVAC zu entwickeln und für Forschungsarbeiten zu verwenden. Im Juni 1946 [2] [3] legten sie ihre Prinzipien für den Aufbau von Computern im klassischen Artikel „Eine vorläufige Betrachtung des logischen Entwurfs eines elektronischen Computergeräts“ dar. Seitdem ist mehr als ein halbes Jahrhundert vergangen, aber die darin enthaltenen Bestimmungen sind bis heute relevant. Der Artikel begründet überzeugend die Verwendung eines Binärsystems zur Darstellung von Zahlen, da zuvor alle Rechenmaschinen verarbeitete Zahlen in Dezimalform gespeichert haben. Die Autoren demonstrierten die Vorteile des Binärsystems für die technische Implementierung, die Bequemlichkeit und Einfachheit der Ausführung von arithmetischen und logischen Operationen darin. In der Zukunft begannen Computer, nicht numerische Arten von Informationen zu verarbeiten - Text, Grafik, Ton und andere, aber die Codierung von Binärdaten bildet immer noch die Informationsbasis jedes modernen Computers.

Alle Fundamente, die vor einigen Jahrzehnten gelegt wurden und das Fundament wurden. In Zukunft blieb fast alles unverändert, die Entwickler versuchten nur, Computer immer produktiver zu machen.

Es sei daran erinnert, dass Moores Gesetz die Grundlage für alles ist. Alle seine Inkarnationen dienten als Unterstützung für das Grundmodell der Entwicklung der Computertechnologie, und schon wenig konnte zu einer Unterbrechung dieses Zyklus führen. Und je aktiver die Entwicklung der Computertechnologie vorangetrieben wurde, desto tiefer konnten die Entwickler dieser Systeme im Gesetz festsitzen. In der Tat dauert die Schaffung einer anderen Computerarchitektur Jahre, und nur wenige Unternehmen konnten sich diesen Luxus leisten - die Suche nach alternativen Wegen zur Entwicklung der Computertechnologie. Forschungsorganisationen wie das MIT haben mutige Experimente wie die Lisp-Maschine und die Verbindungsmaschine durchgeführt. Hier können Sie eines der japanischen Projekte erwähnen. Aber das alles endete mit nichts, die Architektur von Neumann blieb in Gebrauch.

Die Arbeit von Ingenieuren und Programmierern bestand nun darin, die Arbeit ihrer Programme und Hardware so zu optimieren, dass jeder Quadratmillimeter Chips immer effizienter arbeitete. Entwickler konkurrierten um das Zwischenspeichern immer größerer Datenmengen. Außerdem haben verschiedene Hersteller elektronischer Komponenten versucht (und versuchen es immer noch), so viele Kerne wie möglich in einem Prozessor zu platzieren. Wie dem auch sei, alle Arbeiten haben sich auf eine begrenzte Anzahl von Prozessorarchitekturen konzentriert. Dies sind X86, ARM und PowerPC. Vor dreißig Jahren gab es noch viele mehr.

X86 wird hauptsächlich auf Desktops, Laptops und Cloud-Servern verwendet. ARM-Prozessoren laufen auf Telefonen und Tablets. Nun, PowerPC wird in den meisten Fällen in der Automobilindustrie eingesetzt.

Eine interessante Ausnahme zu den strengen Spielregeln, die durch Moores Gesetz festgelegt wurden, ist die GPU. Sie wurden entwickelt, um grafische Informationen mit einem hohen Maß an Effizienz zu verarbeiten, sodass sich ihre Architektur (noch) vom Prozessor unterscheidet. Um dieser Aufgabe gerecht zu werden, musste die GPU jedoch unabhängig von der Entwicklung der Prozessoren entwickelt werden. Die Architektur der Grafikkarten wurde optimiert, um die große Datenmenge zu verarbeiten, die zum Rendern des Bildes auf dem Bildschirm erforderlich ist. Daher entwickelten die Ingenieure hier einen anderen Chip-Typ, der die vorhandenen Prozessoren nicht ersetzte, sondern ihre Fähigkeiten ergänzte.

Wann wird Moores Gesetz aufhören zu wirken?

Im üblichen Sinne hat es bereits aufgehört zu arbeiten, in diesem klassischen Verständnis, das oben diskutiert wurde. Dies wird durch verschiedene Quellen belegt, darunter zum Beispiel

diese . Jetzt läuft das Rennen noch. Zum Beispiel gab es in demselben ersten kommerziellen 5-Bit-Intel 4004-Prozessor, der 1971 veröffentlicht wurde, 2.300 Transistoren. Nach 45 Jahren stellte Intel 2016 den 24-Kern-Xeon Broadwell-WS-Prozessor mit 5,7 Milliarden Transistoren vor. Dieser Prozessor ist in 14-nm-Technologie erhältlich. IBM hat kürzlich einen 7-nm-Prozessor mit 20 Milliarden Transistoren und einen 5-nm-Prozessor mit 30 Milliarden Transistoren angekündigt.

5 nm ist jedoch eine Schicht mit einer Dicke von nur 20 Atomen. Hier nähert sich das Engineering bereits der technischen Grenze einer weiteren Verbesserung des Prozesses. Darüber hinaus ist die Dichte von Transistoren in modernen Prozessoren sehr hoch. 5 oder sogar 10 Milliarden Transistoren pro Quadratmillimeter. Die Signalübertragungsgeschwindigkeit im Transistor ist sehr hoch und von großer Bedeutung. Die Kernfrequenz moderner schnellster Prozessoren beträgt 8,76 GHz. Eine weitere Beschleunigung ist zwar möglich, aber auch ein technisches Problem und sehr, sehr groß. Aus diesem Grund haben sich Ingenieure dafür entschieden, Mehrkernprozessoren zu erstellen, anstatt die Frequenz eines einzelnen Kerns weiter zu erhöhen.

Dies ermöglichte es, das Tempo der Zunahme der Anzahl von Operationen pro Sekunde aufrechtzuerhalten, das durch Moores Gesetz vorgesehen ist. Dennoch ist der Multinuklearismus selbst eine gewisse Abweichung vom Gesetz. Eine Reihe von Experten ist jedoch der Ansicht, dass es keine Rolle spielt, wie wir versuchen, „aufzuholen“. Hauptsache, das Tempo der technologischen Entwicklung, insbesondere der Computertechnologie, entspricht mehr oder weniger dem Gesetz von Moore.

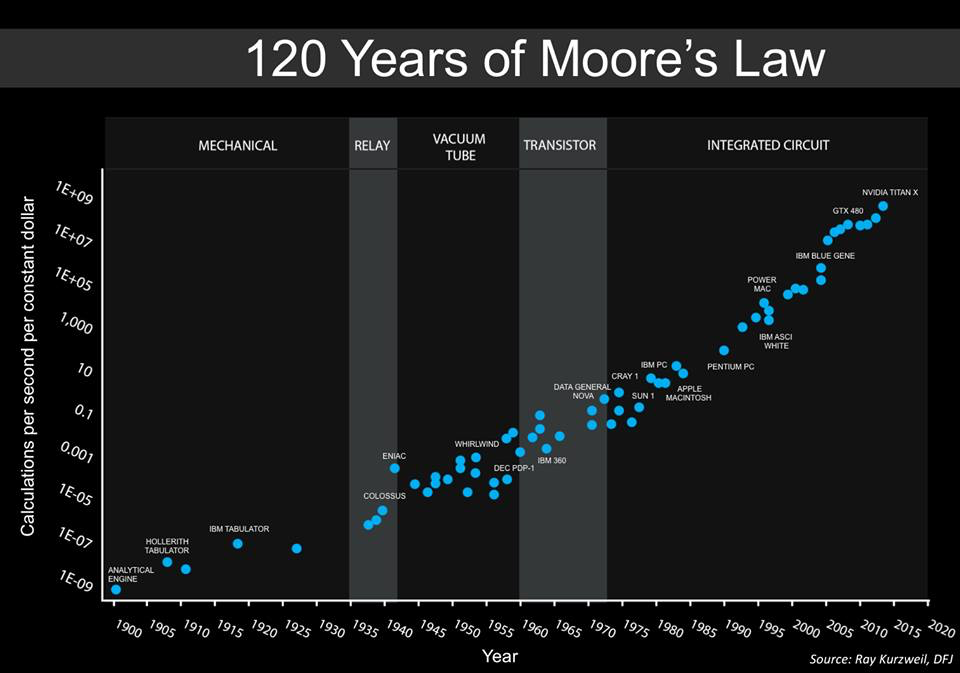

Unten sehen Sie eine Grafik von Steve Jurvetson, Mitbegründer von Draper Fisher Jurvetson. Er behauptet, dies sei ein erweiterter Zeitplan, der zuvor von

Ray Kurzweil vorgelegt worden sei.

Diese Grafik zeigt die relativen Kosten der Anzahl der Vorgänge pro Zeiteinheit (1 Sekunde). Das heißt, wir können deutlich sehen, wie viel billiger Computercomputer im Laufe der Zeit sind. Darüber hinaus wurden die Berechnungen sozusagen immer universeller. In den 40er Jahren gab es spezielle Maschinen, mit denen militärische Codes geknackt werden konnten. In den 1950er Jahren wurden Computer verwendet, um mit allgemeinen Aufgaben zu arbeiten, und dieser Trend hält bis heute an.

Interessanterweise sind die letzten beiden Positionen in der Tabelle die GPU, GTX 450 und NVIDIA Titan X. Interessanterweise gab es 2010 keine GPUs in der Tabelle, sondern nur Multi-Core-Prozessoren.

Im Allgemeinen ist die GPU bereits hier und viele sind damit zufrieden. Darüber hinaus wird eine Richtung wie Deep Learning, eine der Manifestationen neuronaler Netze, immer beliebter. Viele große und kleine Unternehmen sind an ihrer Entwicklung beteiligt. Und GPUs sind ideal für neuronale Netze.

Warum das alles? Tatsache ist, dass die allgemeine Zunahme der Anzahl der Berechnungen zwar immer noch erhalten bleibt, aber die Methoden und Geräte ändern sich.

Was bedeutet das alles?

Jetzt ändert sich die Form des Computercomputers. Architekten müssen bald nicht mehr darüber nachdenken, was sie sonst noch tun müssen, um mit Moores Gesetz Schritt zu halten. Jetzt werden nach und nach neue Ideen eingeführt, die Höhen erreichen, die für herkömmliche Computersysteme mit traditioneller Architektur nicht zugänglich sind. Vielleicht wird in naher Zukunft die Rechengeschwindigkeit nicht so wichtig sein, sondern es wird möglich sein, die Systemleistung anders zu verbessern.

Selbstlernende Systeme

Selbstlernende SystemeJetzt sind viele neuronale Netze GPU-abhängig. Für sie werden Systeme mit spezialisierter Architektur erstellt. Zum Beispiel hat Google eigene Chips entwickelt, die als TensorFlow Units (orTPUs) bezeichnet werden. Mit ihnen können Sie aufgrund der Effizienz der Berechnungen Rechenleistung sparen. Google verwendet diese Chips in seinen Rechenzentren, und viele der Cloud-Dienste des Unternehmens arbeiten auf ihrer Basis. Infolgedessen ist die Systemleistung höher und der Energieverbrauch niedriger.

Spezialisierte ChipsIn herkömmlichen Mobilgeräten arbeiten jetzt ARM-Prozessoren, die spezialisiert sind. Diese Prozessoren verarbeiten Informationen von Kameras, optimieren die Sprachverarbeitung und arbeiten in Echtzeit mit der Gesichtserkennung. Spezialisierung auf alles ist das, was die Elektronik erwartet.

Spezialisierte ArchitekturJa, der Keil konvergierte nicht mit der von Neumann-Architektur, jetzt werden Systeme mit unterschiedlichen Architekturen entwickelt, die für unterschiedliche Aufgaben ausgelegt sind. Dieser Trend wird nicht nur beibehalten, sondern sogar beschleunigt.

ComputersicherheitCyberkriminelle werden immer geschickter. Wenn Sie einige Systeme hacken, können Sie Millionen, Dutzende Millionen Dollar verdienen. In den meisten Fällen ist das Hacken des Systems jedoch aufgrund von Software- oder Hardwarefehlern möglich. Die überwiegende Mehrheit der von Crackern verwendeten Tricks funktioniert auf Systemen mit von Neumann-Architektur, aber nicht mit anderen Systemen.

QuantensystemeDie sogenannten Quantencomputer sind experimentelle Technologien, die unter anderem auch sehr teuer sind. Hier werden kryogene Elemente sowie viele andere Dinge verwendet, die in herkömmlichen Systemen nicht zu finden sind. Quantencomputer unterscheiden sich grundlegend von den üblichen Computern, und das Gesetz von Moore gilt nicht für sie. Mit ihrer Hilfe ist es Experten zufolge jedoch möglich, die Leistung einiger Arten von Berechnungen radikal zu steigern. Vielleicht war es Moores Gesetz, das Wissenschaftler und Ingenieure dazu veranlasste, nach neuen Wegen zu suchen, um die Effizienz des Rechnens zu steigern und sie zu finden.

Als Nachwort

Höchstwahrscheinlich werden wir in 5-10 Jahren völlig neue Computersysteme sehen, wir sprechen jetzt über Halbleitertechnologie. Diese Systeme werden unseren wildesten Plänen voraus sein und sich sehr schnell entwickeln. Höchstwahrscheinlich werden Spezialisten, die versuchen, Moores Gesetz zu umgehen, neue Chip-Entwicklungstechnologien entwickeln, die uns, wenn sie uns jetzt davon erzählt hätten, magisch erschienen wären. Was würden Menschen, die vor 50 Jahren lebten, sagen, wenn sie ein modernes Smartphone bekämen? Nur wenige würden verstehen, wie alles funktioniert. So ist es in unserem Fall.