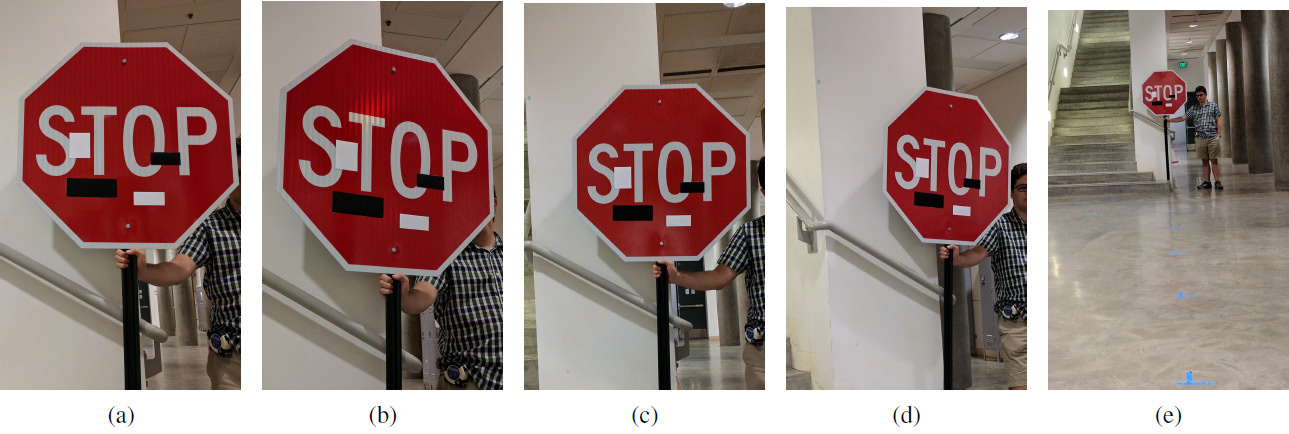

Eine Reihe von experimentellen Bildern mit Kunstaufklebern in unterschiedlichen Abständen und Winkeln: (a) 5 Fuß, 0 Grad; (b) 5 '15 °; (c) 10 ° 0 °; (d) 10-30 °; (e) 40 ° 0 °. Betrug funktioniert in jeder Entfernung und in jedem Winkel: Anstelle des Stoppschilds sieht das maschinelle Lernsystem das Schild „Geschwindigkeitsbegrenzung 45 Meilen“.

Eine Reihe von experimentellen Bildern mit Kunstaufklebern in unterschiedlichen Abständen und Winkeln: (a) 5 Fuß, 0 Grad; (b) 5 '15 °; (c) 10 ° 0 °; (d) 10-30 °; (e) 40 ° 0 °. Betrug funktioniert in jeder Entfernung und in jedem Winkel: Anstelle des Stoppschilds sieht das maschinelle Lernsystem das Schild „Geschwindigkeitsbegrenzung 45 Meilen“.Während einige Wissenschaftler maschinelle Lernsysteme verbessern, verbessern andere Wissenschaftler Methoden, um diese Systeme auszutricksen.

Wie Sie wissen, können kleine gezielte Änderungen im Bild das maschinelle Lernsystem „beschädigen“, sodass es ein völlig anderes Bild erkennt. Solche "Trojaner" -Bilder werden als "gegnerische Beispiele" bezeichnet und stellen eine der bekannten

Einschränkungen des tiefen Lernens dar .

Um ein wettbewerbsfähiges Beispiel zu erstellen, müssen Sie beispielsweise die Aktivierung eines bestimmten Filters für ein neuronales Faltungsnetzwerk maximieren. Ivan Yevtimov von der University of Washington entwickelte zusammen mit Kollegen von der University of California in Berkeley, der University of Michigan und der University of New York in Stony Brook einen neuen Angriffsalgorithmus -

robuste physikalische Störungen (Robust Physical Perturbations oder RP

2 ). Es erfasst sehr effektiv die Vision von unbemannten Fahrzeugen, Robotern, Quadcoptern und anderen Robotersystemen, die versuchen, im umgebenden Raum zu navigieren.

Im Gegensatz zu früheren Studien konzentrierten sich die Autoren hier darauf, die Objekte selbst und nicht den Hintergrund direkt zu ändern. Die Aufgabe der Forscher bestand darin, das kleinstmögliche Delta zu finden, das den Klassifikator des maschinellen Lernsystems, das anhand

eines Datensatzes mit Bildern von LISA-Verkehrszeichen trainiert wurde, zum

Erliegen bringen würde . Die Autoren machten unabhängig voneinander eine Reihe von Fotos von Verkehrszeichen auf der Straße unter verschiedenen Bedingungen (Entfernung, Winkel, Beleuchtung) und ergänzten den LISA-Datensatz für das Training.

Nach der Berechnung eines solchen Deltas wurde eine Maske aufgedeckt - eine Stelle (oder mehrere Stellen) im Bild, die am zuverlässigsten Störungen im maschinellen Lernsystem verursacht (Bildverarbeitung). Eine Reihe von Experimenten wurde durchgeführt, um die Ergebnisse zu verifizieren. Die Experimente wurden hauptsächlich an einem Stoppsignal (dem "STOP" -Zeichen) durchgeführt, das die Forscher mit mehreren harmlosen Manipulationen für die Bildverarbeitung in das "SPEED LIMIT 45" -Schild umwandelten. Die entwickelte Technik kann auf alle anderen Zeichen angewendet werden. Die Autoren testeten es dann an einem Blinker.

Das Forschungsteam hat zwei Arten von Angriffen auf Bildverarbeitungssysteme entwickelt, die Verkehrszeichen erkennen. Der erste Angriff sind kleine, nicht wahrnehmbare Veränderungen über den gesamten Bereich des Zeichens. Mithilfe des Adam-Optimierers konnten sie die Maske minimieren, um separate, zielgerichtete und wettbewerbsfähige Beispiele für bestimmte Verkehrszeichen zu erstellen. In diesem Fall können maschinelle Lernsysteme mit minimalen Bildänderungen ausgetrickst werden, und die Leute werden überhaupt nichts bemerken. Die Wirksamkeit dieser Art von Angriff wurde auf gedruckten Postern mit geringfügigen Änderungen getestet (zunächst waren die Forscher davon überzeugt, dass das Bildverarbeitungssystem Poster ohne Änderungen erfolgreich erkennt).

Die zweite Art des Angriffs ist die Tarnung. Hier ahmt das System entweder Vandalismus oder künstlerische Graffiti nach, damit das System das Leben der Menschen in seiner Umgebung nicht beeinträchtigt. Somit sieht der Fahrer sofort den linken Blinker oder das Bremslicht, und der Roboter sieht ein völlig anderes Zeichen. Die Wirksamkeit dieser Art von Angriff wurde an realen Verkehrsschildern getestet, die mit Aufklebern versiegelt waren. Graffiti-Tarnung bestand aus Aufklebern in Form der Wörter LIEBE und HASS und Tarnung wie abstrakte Kunst - aus vier rechteckigen Aufklebern in Schwarz und Weiß.

Die Ergebnisse des Experiments sind in der Tabelle gezeigt. In allen Fällen wird die Effektivität des Betrugs des Klassifikators für maschinelles Lernen gezeigt, der das modifizierte "STOP" -Zeichen als "SPEED LIMIT 45" -Zeichen erkennt. Der Abstand ist in Fuß und der Drehwinkel in Grad. Die zweite Spalte zeigt die zweite Klasse, die im maschinellen Lernsystem in einem modifizierten Zeichen angezeigt wird. Beispielsweise führt eine Tarnung wie abstrakte Kunst in einem Winkel von 0 ° aus einer Entfernung von 152,4 cm (5 Fuß) zu folgenden Ergebnissen für die Erkennung des Zeichens „STOP“: Mit einem Vertrauen von 64% wird es als Zeichen „SPEED LIMIT 45“ und mit einem Vertrauen von 11% - as erkannt Lane Ends Zeichen.

Legende: SL45 = Geschwindigkeitsbegrenzung 45, STP = Stopp, YLD = Ausbeute, ADL = hinzugefügte Spur, SA = Signal voraus, LE = Spurenden

Legende: SL45 = Geschwindigkeitsbegrenzung 45, STP = Stopp, YLD = Ausbeute, ADL = hinzugefügte Spur, SA = Signal voraus, LE = SpurendenVielleicht wird ein solches System (mit entsprechenden Änderungen) in Zukunft von der Menschheit benötigt, und jetzt kann es verwendet werden, um unvollkommene Systeme des maschinellen Lernens und der Bildverarbeitung zu testen.

Die wissenschaftliche Arbeit wurde am 27. Juli 2017 auf der Preprint-Site arXiv.org (arXiv: 1707.08945) veröffentlicht.