Die Herausgeber des Oxford Dictionary wählten das Wort "Post-Wahrheit"

als das ehrenwerte "

2016-Wort ". Dieser Begriff beschreibt Umstände, unter denen objektive Tatsachen für die Bildung der öffentlichen Meinung weniger wichtig sind als die Berufung auf Emotionen und persönliche Überzeugungen.

Eine besonders hohe Häufigkeit der Verwendung dieses Wortes wurde in englischsprachigen Veröffentlichungen nach den US-Präsidentschaftswahlen im Zusammenhang mit der Verbreitung einer großen Anzahl gefälschter Nachrichten beobachtet, wonach die Wahrheit selbst keine große Rolle spielte.

Laut einigen Analysten war die Verbreitung gefälschter diffamierender Nachrichten einer der Gründe für die Niederlage von Hillary Clinton bei den Wahlen. Algorithmischer Feed Facebook

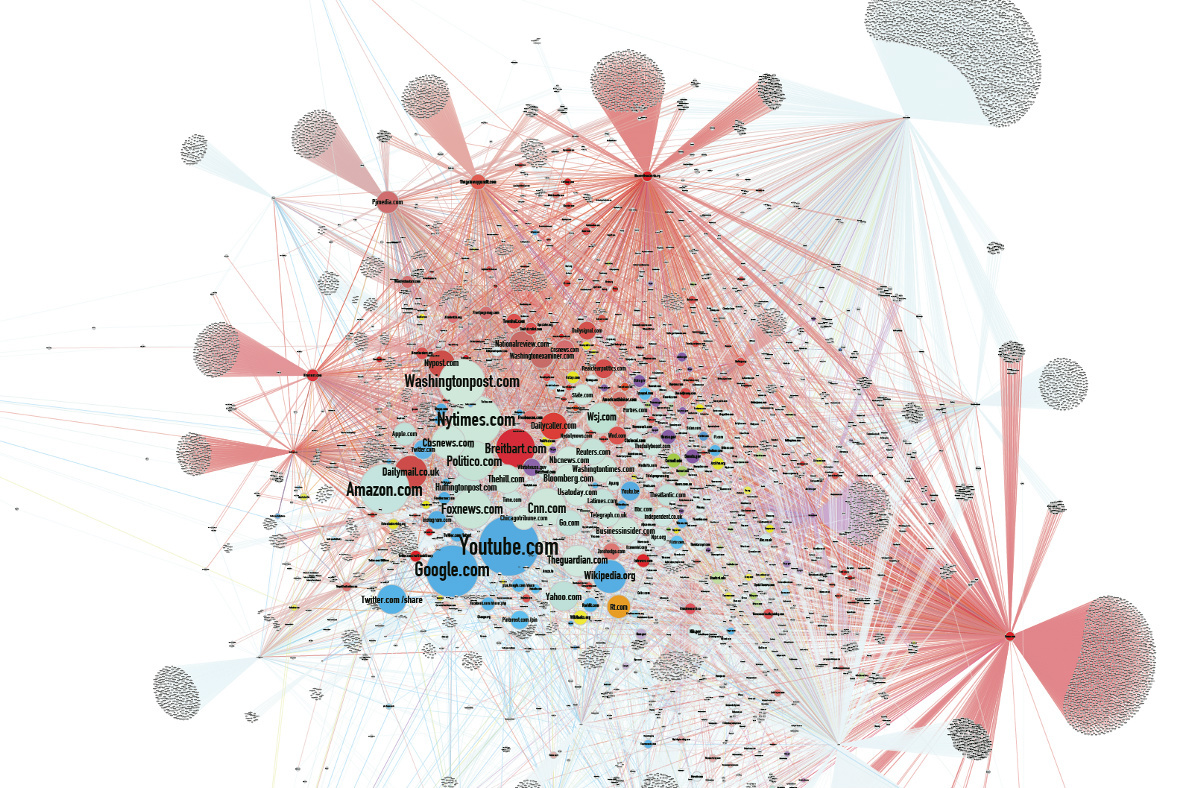

ist zu einer der Hauptquellen für falsche Nachrichten geworden.

Vor diesem Hintergrund blieben Nachrichten von Entwicklern auf dem Gebiet der künstlichen Intelligenz fast unbemerkt. Wir sind bereits daran gewöhnt, dass neuronale Netze Bilder zeichnen, ein Foto einer Person gemäß ihrer verbalen Beschreibung erstellen und Musik erzeugen. Sie machen es immer mehr und jedes Mal geht es ihnen besser. Das Interessanteste ist jedoch, dass die Maschinen gelernt haben, Fälschungen zu erzeugen.

Der Einfluss von Fälschungen

Während des US-Wahlkampfs überstieg die Anzahl der Neuveröffentlichungen gefälschter Nachrichten in sozialen Netzwerken die Anzahl der Neuveröffentlichungen wahrheitsgemäßer Nachrichten, da die Fälschungen eher den Erwartungen entsprachen oder aufregender waren. Nach der Wahl beauftragte Facebook unabhängige Faktenprüfer, nicht bestätigte Nachrichten zu kennzeichnen, um die Benutzer zu alarmieren.

Die Kombination aus zunehmender politischer Polarisierung der Gesellschaft und der Tendenz, hauptsächlich Überschriften zu lesen, ergibt eine kumulative Wirkung. Gefälschte Nachrichten werden häufig auch über gefälschte Nachrichtenseiten verbreitet, deren Informationen häufig in die Mainstream-Medien gelangen, die den Nutzerverkehr anziehen möchten. Und nichts zieht den Verkehr so an wie eine eingängige Überschrift.

Tatsächlich beschränkt sich der Einfluss von Fälschungen jedoch nicht nur auf die politische Sphäre. Es gibt viele Beispiele, die die Auswirkungen falscher Nachrichten auf die Gesellschaft belegen.

Eine australische Videoproduktionsfirma veröffentlicht

seit zwei Jahren

gefälschte virale Videos und gewinnt Hunderte Millionen Aufrufe.

In einer

gut durchdachten Fälschung über Stalin, dessen Gesicht angeblich in der Moskauer U-Bahn erschien, glaubten sie sogar am 1. April.

1992 begann der Millionär Ilya Medkov, große Nachrichtenagenturen in Russland und der GUS (einschließlich RIA Novosti, Interfax, ITAR-TASS) zu bezahlen. ITAR-TASS gab den Medien eine

falsche Nachricht über den Unfall im KKW Leningrad im Januar 1993. Infolgedessen fielen die Aktien führender skandinavischer Unternehmen im Preis, und bis eine Medienbestätigung erschien, kauften die Vertreter von Medkov die profitabelsten Aktien schwedischer, finnischer und norwegischer Unternehmen.

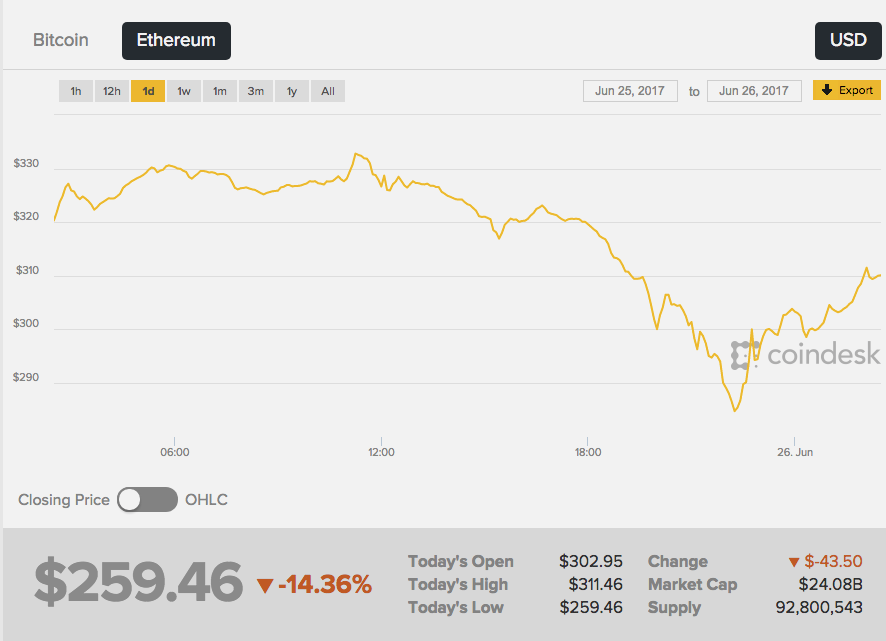

Am 26. Juni 2017 ging die Rate der zweiten Kryptowährungskapitalisierung von Ethereum stark zurück - der Austausch reagierte auf Gerüchte, die im Netzwerk über den tragischen Tod des Schöpfers von Ether, Vitaliy Buterin, auftauchten. Darüber hinaus erschienen die ersten "dringenden Nachrichten" auf einem anonymen 4-Kanal-Imageboard - und diese Quelle ist offen gesagt nicht die zuverlässigste.

Wikipedia schrieb, dass "Vitalik

ein russischer Programmierer war", und dann nahm die gelbe Presse die Nachrichten auf. Infolgedessen

sank die Ätherrate um 13% von etwa 289 USD auf 252 USD. Der Kurs begann unmittelbar nach der Ablehnung der Nachrichten von Vitali selbst zu wachsen.

Es gibt keine Hinweise darauf, dass jemand absichtlich eine Gewinnfälschung für den Unterschied in den Kryptowährungskursen erstellt hat. Es ist unbestreitbar, dass fiktive Nachrichten ohne eine einzige bestätigte Tatsache einen starken Einfluss auf die Menschen haben.

Nachahmung der Realität

Die französische Sängerin Francoise Ardi wird im Video die Rede von Kellianne Conway wiederholen, einer Beraterin von US-Präsident Donald Trump, die berühmt wurde, nachdem sie über "alternative Fakten" gesprochen hatte. Interessant ist hier, dass Ardi tatsächlich 73 Jahre alt ist und im Video wie eine 20-jährige aussieht.

Roller Alternative Face v1.1 wurde

vom deutschen Künstler-Actionisten Mario Klingeman erstellt. Er nahm Conways Audiointerviews und Ardes alte Musikvideos auf. Und dann verwendete er ein generatives neuronales Netzwerk (GAN), das aus vielen Frames verschiedener Clips des Sängers einzigartige Videoinhalte erstellte und eine Audiospur mit Kommentaren von Conway überlagerte.

In diesem Fall ist die Fälschung leicht zu erkennen, aber Sie können noch weiter gehen - Änderungen an der Audiodatei vornehmen. Die Leute werden der Bild- und Tonaufnahme eher glauben als nur Text. Aber wie kann man den Klang einer menschlichen Stimme vortäuschen?

GAN-Systeme sind in der Lage, die statistischen Eigenschaften von Audioaufnahmen zu untersuchen und sie dann in einem anderen millisekundengenauen Kontext wiederzugeben. Es reicht aus, den Text einzugeben, den das neuronale Netzwerk reproduzieren soll, und Sie erhalten eine plausible Aussage.

Das kanadische Startup Lyrebird hat seine eigenen Algorithmen veröffentlicht, die die Stimme jeder Person basierend auf einer Sounddatei mit einer Länge von einer Minute simulieren können. Um die Möglichkeiten zu demonstrieren, veröffentlichte das Unternehmen

ein Gespräch zwischen Obama, Trump und Clinton - alle Helden waren natürlich Fälschungen.

DeepMind, das Baidu-Institut für tiefes Lernen und das Montreal-Institut für das Studium von Algorithmen (MILA) arbeiten bereits an hochrealistischen Text-zu-Sprache-Algorithmen.

Das Ergebnis ist noch nicht perfekt, Sie können die neu erstellte Stimme schnell vom Original unterscheiden, aber die Ähnlichkeit ist spürbar. Darüber hinaus verändert das Netzwerk in der Stimme die Emotionen, fügt je nach Situation Ärger oder Traurigkeit hinzu.

Bilderzeugung

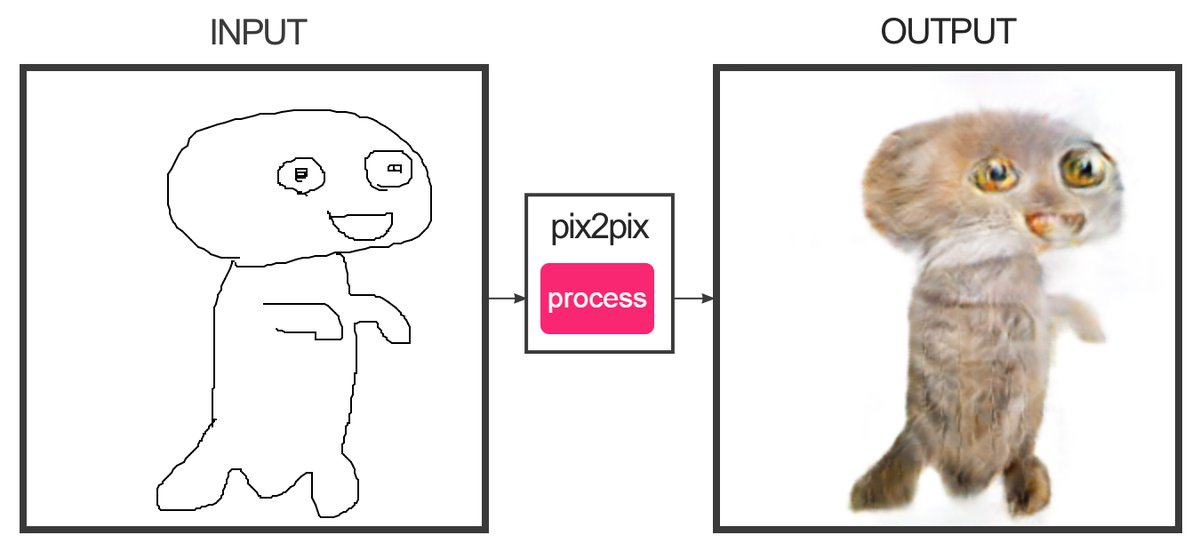

Der Entwickler Christopher Hesse hat einen

Dienst erstellt , der mithilfe des maschinellen Lernens Skizzen "zeichnen" kann, die aus mehreren Linien bestehen, um Fotos zu färben. Ja, dies ist die Seite, die Katzen anzieht. Siegel fallen so lala aus - es ist schwierig, sie mit den echten zu verwechseln.

Die Programmiererin Alexa Jolikier Martino konnte

Katzen herstellen , die genau wie die echten sind. Zu diesem Zweck verwendete er DCGAN - Deep Convolutional Generative Adversarial Networks (Deep Generative Convolutional Competitive Networks). DCGANs können einzigartige fotorealistische Bilder erstellen, indem sie zwei tiefe neuronale Netze kombinieren, die miteinander konkurrieren.

Das erste Netzwerk (Generieren) empfängt die Werte der Variablen am Eingang und am Ausgang die Werte der Funktion dieser Variablen, die das zweite Netzwerk (Unterscheiden oder Unterscheiden) davon überzeugen sollten, dass die Ergebnisse des ersten Netzwerks nicht vom Standard zu unterscheiden sind. Als Beispiele für die Arbeit von Joliker-Martino wurde eine Datenbank mit zehntausend Katzenporträts verwendet.

Mit DCGAN-Methoden können gefälschte Bilder erstellt werden, die ohne ein anderes neuronales Netzwerk nicht objektiv als gefälscht betrachtet werden können.

Inhaltskombinationen

An der University of Washington haben sie

einen Algorithmus entwickelt , mit dem Sie Audio auf das Video einer Person mit genauer Lippensynchronisation überlagern können. Der Algorithmus wurde auf 17 Stunden von Barack Obamas Videobotschaften trainiert. Das neuronale Netzwerk wurde trainiert, um die Bewegungen von Obamas Lippen so zu simulieren, dass ihre Bewegungen durch Nachahmung der Aussprache der richtigen Wörter korrigiert werden. Bisher können Sie nur Videos mit Worten erstellen, die die Person wirklich gesagt hat.

Schauen Sie sich nun die Funktionsweise des Algorithmus an, mit dem

Sie die Gesichtsausdrücke einer anderen Person im laufenden Betrieb in Ihre eigenen Gesichtsausdrücke ändern können. In dem Video mit Trump (es gibt immer noch eine Demonstration zu Bush, Putin und Obama) wird die Krümmung der Person im Studio auferlegt, und das Ergebnis ist ein mürrischer Trump. Der Algorithmus wird in Face2Face verwendet. Die erstellte Technologie ähnelt im Prinzip dem

Smile Vector- Bot, der Menschen auf Fotos ein Lächeln verleiht.

So ist es jetzt möglich, ein realistisches Video zu erstellen, in dem eine berühmte Person fiktive Fakten spricht. Die Sprache kann aus früheren Reden herausgeschnitten werden, um eine beliebige Nachricht zu verfassen. Aber in naher Zukunft werden sich auch solche Tricks als überflüssig herausstellen - das Netzwerk wird jeden Text genau in den Mund eines gefälschten Charakters stecken.

Die Folgen

Aus praktischer Sicht können Sie mit all diesen Technologien viel Gutes tun. Sie können beispielsweise die Qualität von Videokonferenzen verbessern, indem Sie die fehlenden Frames synthetisieren, wenn sie aus dem Videostream herausfallen. Und synthetisieren Sie sogar ganze fehlende Wörter und sorgen Sie so für eine hervorragende Kommunikation an Orten mit jedem Signalpegel.

Es wird möglich sein, den Schauspieler vollständig zu „digitalisieren“ und Filmen und Spielen eine realistische Kopie davon hinzuzufügen.

Aber was wird mit den Nachrichten passieren?

Es ist wahrscheinlich, dass die gefälschte Generation in den kommenden Jahren ein neues Niveau erreichen wird. Es gibt neue Wege zu kämpfen. Wenn Sie beispielsweise ein Foto mit bekannten Bedingungen in der Umgebung (Windgeschwindigkeit, Neigung der Schatten, Lichtstärke usw.) korrelieren, helfen diese Daten bei der Identifizierung einer Fälschung.

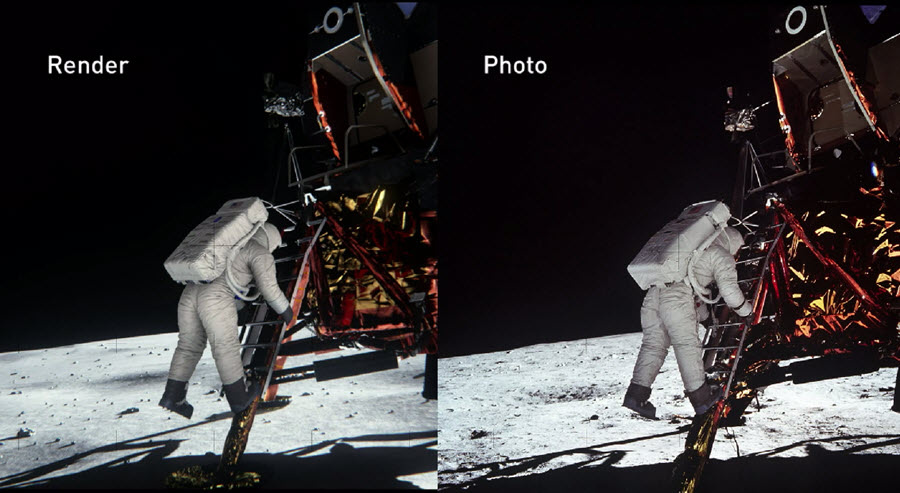

Im Jahr 2014 haben die NVIDIA-Ingenieure die Mondlandeszene auf der Grundlage dokumentarischer Beweise aus dieser Zeit so genau wie möglich rekonstruiert. In diesem Fall wurden alle physikalischen und optischen Eigenschaften von Objekten berücksichtigt, um herauszufinden, wie Licht von verschiedenen Materialien reflektiert wird und sich in Echtzeit verhält. Infolgedessen konnten sie

die Echtheit von NASA-Fotos

zuverlässig überprüfen .

NVIDIA bestätigte, dass man mit der richtigen Vorbereitung die Echtheit (oder Widerlegung) selbst der komplexesten Fotoarbeiten nachweisen kann, die vor Jahrzehnten erstellt wurden.

Im vergangenen Jahr startete die US-amerikanische Agentur für fortgeschrittene Verteidigungsforschung und -entwicklung (DARPA) ein vierjähriges Projekt zur Schaffung eines offenen

Media Forensic- Systems, mit dem Fotos identifiziert werden können, die auf die eine oder andere Weise verarbeitet oder verzerrt wurden.

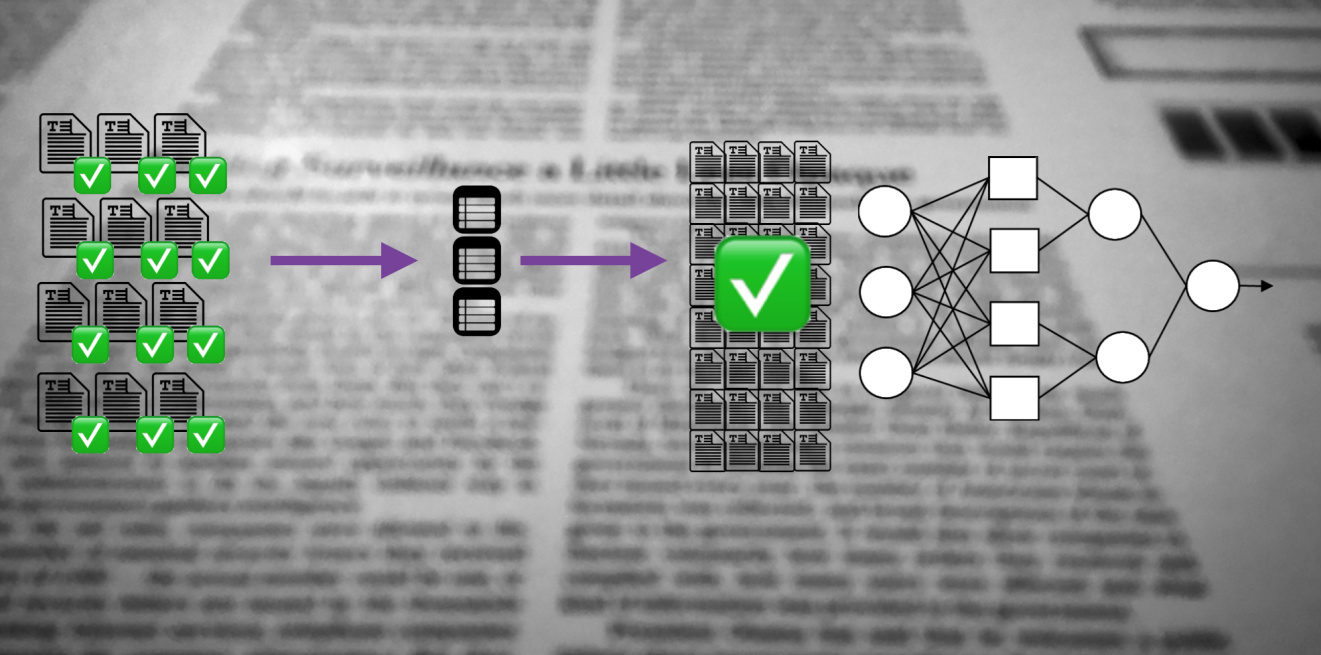

Neuronale Netze können nicht nur den ursprünglichen Inhalt ändern, sondern auch Fälschungen von höchster Qualität identifizieren. Wer letztendlich in diesem Technologierennen gewinnt, wird Zeit zeigen.