Abbildung

AbbildungEs gibt viele Filme und Science-Fiction-Bücher, in denen das Computersystem das Bewusstsein erlangt und seine menschlichen Schöpfer getäuscht hat. Ist das in der Realität möglich? Bisher wenig Anlass zur Sorge.

Wir sind beeindruckt von den

Programmen AlphaGo und

Libratus , den Erfolgen der Boston Dynamics-Roboter, aber alle bekannten Erfolge betreffen nur enge Bereiche und sind noch weit von der Massenverteilung entfernt. Im Alltag interagieren die Menschen mit pseudo-intellektuellen Assistenten (Siri, Okay, Google, Amazon Alexa), von denen jeder nicht behauptet, ein Lorbeer eines wirklich „intelligenten“ Programms zu sein.

Die Fortschritte beim Design künstlicher Intelligenz sind jedoch wirklich beeindruckend. Und je näher der Tag rückt, an dem die KI zu einem vollwertigen Instrument zur Beeinflussung sozialer Prozesse wird, desto mehr Fehler häufen sich, die auf die Möglichkeit hinweisen, die hypothetischen „

drei Gesetze der Robotik “ zu umgehen.

Die These "Je komplexer das System - desto mehr Lücken und Fehler darin" steht in direktem Zusammenhang mit Problemen mit der KI.

Wenn Angst Augen bekam

Ein weises russisches Sprichwort sagt, dass die Gefahr den Ängstlichen überall präsentiert wird. Die Ursprünge der Angst vor künstlichem Leben wurzeln in jahrhundertealten Archetypen des Grauens. Schon vor den Geschichten von Victor Frankenstein und den Geschichten von Zombies gab es Überzeugungen über Golems, Kreaturen, die von kabbalistischen Magiern aus Ton animiert wurden.

Angst vor dem Neuen (und dem Lebenden) zu haben, ist für einen Menschen normal. 1978 stellte sich die

Hypothese auf, dass ein Roboter oder ein anderes Objekt, das wie ein Mensch aussieht oder wirkt (aber nicht genau wie ein realer), unter menschlichen Beobachtern Feindseligkeit und Ekel hervorruft. Die Hypothese hat nur die Erfahrung aufgezeichnet: Ein Zombie vor Ihnen, ein Golem oder ein Roboterassistent ist nicht so wichtig - Sie werden alle mit der gleichen Vorsicht behandeln.

Menschenähnliche Roboter sind nur die oberste Schicht des Problems. Elon Musk, Bill Gates, Stephen Hawking und Hunderte von Experten auf dem Gebiet der Robotik, Physik, Wirtschaft und Philosophie verbergen ihre Befürchtungen über die negativen Folgen intelligenter Systeme für die Menschheit in der Zukunft nicht.

Wir lieben es, unsere Nerven zu kitzeln - nicht umsonst ist das Terminator-Franchise so beliebt. Und wie viele "böswillige" AIs gab es in anderen Filmen und Büchern. Es ist schwer zu erkennen, ob dies unser unbewusstes Projektion auf die Kultur ist oder ob die Medien die Gesellschaft beeinflussen.

Explosives Wachstum im "blauen Ozean"

Die Wirtschaftsstrategie des

blauen Ozeans argumentiert, dass Unternehmen, die erfolgreich sein wollen, nicht gegen Wettbewerber kämpfen müssen, sondern „Ozeane“ nicht wettbewerbsfähiger Märkte schaffen müssen. Mit solchen strategischen Entscheidungen erhalten Sie sofort zusätzliche Vorteile für das Unternehmen, seine Kunden und Mitarbeiter - indem Sie nach neuen Anforderungen suchen und den Wettbewerb unnötig machen.

KI ist seit vielen Jahren ein solcher "Ozean" geblieben. Jeder hat verstanden, dass selbst eine schwache künstliche Intelligenz zu einem leistungsstarken Werkzeug für jedes Unternehmen wird und die Qualität aller Produkte und Dienstleistungen erhöht. Aber niemand wusste genau, was zu tun ist. Der „Winter“ der KI, der von

1973 bis heute dauerte, war durch eine völlige Stagnation bei der Konstruktion „intelligenter“ Maschinen gekennzeichnet.

Dreißig Jahre lang war die wichtigste Errungenschaft der KI der Sieg des IBM-Computers im Spiel gegen den Schachweltmeister - ein Ereignis, das den Alltag eines Menschen (mit Ausnahme von Garry Kasparov) nicht wesentlich beeinflusst. In den 2010er Jahren geschah jedoch etwas Vergleichbares zur Entwicklung von Atomwaffen - die neuronalen Netze erhielten die zweite Entwicklungswelle.

Eine erstaunliche Tatsache: Wissenschaftler ohne großen Erfolg entwickeln seit über 70 Jahren künstliche neuronale Netze. Aber bis 2015 begann in diesem Bereich ein explosives Wachstum, das bis heute anhält. Zur gleichen Zeit geschah dies:

- "Eisen" hat das erforderliche Niveau erreicht - moderne Grafikkarten haben es möglich gemacht, neuronale Netze hunderte Male schneller zu trainieren;

- Es erschienen große und allgemein zugängliche Arrays verschiedener Daten, auf denen Sie lernen können (Datensätze);

- Die Bemühungen verschiedener Unternehmen haben sowohl neue Lehrmethoden als auch neue Arten von neuronalen Netzen geschaffen (zum Beispiel eine wunderbare Sache wie ein generativ-wettbewerbsfähiges Netzwerk ).

- Dank einer Vielzahl offener wissenschaftlicher Forschungen entstanden vorgefertigte, vorab trainierte neuronale Netze, auf deren Grundlage ihre Anträge schnell gestellt werden konnten.

Es ist interessant, die Erfolge von AI nicht einmal am klassischen Beispiel der Bildverarbeitung (wie es hauptsächlich neuronale Netze tun) zu überwachen, sondern im Bereich unbemannter Fahrzeuge. Sie werden überrascht sein, aber die Faszination für „selbstfahrende“ Fahrzeuge

begann vor fast 100 Jahren : 1926 fand im Rahmen des Phantom Car-Projekts der erste Versuch statt, die Maschine fernzusteuern.

Legendäre Drohne Navlab 5

Legendäre Drohne Navlab 5Die ersten unbemannten Fahrzeuge erschienen in den 1980er Jahren: 1984 das

Navlab- Projekt der Carnegie Mellon University und ALM sowie 1987

das Mercedes-Benz-

Projekt und das Eureka Prometheus-Projekt der Militäruniversität München. Das 1995 fertiggestellte Navlab 5 war das erste Auto, das autonom von einer US-Küste zur anderen fuhr.

Bis zum Boom neuronaler Netze blieben selbstfahrende Autos Laborprojekte, die unter der Unzuverlässigkeit von Software litten. Dank der Fortschritte in der Bildverarbeitung konnten die Maschinen "verstehen", was sie um sich herum sehen, und die Verkehrssituation in Echtzeit bewerten.

Unbemannte Fahrzeugsoftware enthält möglicherweise keine Bildverarbeitung und neuronale Netze, aber mit tiefgreifendem Training wurden Fortschritte erzielt, die derzeit für den Erfolg von Drohnen entscheidend sind.

Im "blauen Ozean" wurde es plötzlich überfüllt. Derzeit werden ihre Drohnen von General Motors, Volkswagen, Audi, BMW, Volvo, Nissan, Google (und Waymo unter der Schirmherrschaft von Google), Tesla, Yandex, UBER, Cognitive Technologies und KAMAZ sowie Dutzenden anderer Unternehmen hergestellt.

Drohnen werden auf der Ebene von Regierungsprogrammen hergestellt, darunter das Programm der Europäischen Kommission mit einem Budget von 800 Mio. EUR, das 2getthere-Programm in den Niederlanden, das ARGO-Forschungsprogramm in Italien und die DARPA Grand Challenge in den USA.

In Russland wird das staatliche Programm vom Institut des staatlichen wissenschaftlichen Zentrums der Russischen Föderation, dem einheitlichen Unternehmen NAMI, umgesetzt, das den Shuttle-Elektrobus geschaffen hat. An dem Projekt sind KAMAZ und das Yandex-Entwicklungsteam beteiligt, die für die Erstellung der Infrastruktur für die Erstellung der Route und die Verarbeitung der Daten zur Verkehrsdichte verantwortlich sind.

Autos sind wahrscheinlich das erste Massenprodukt, bei dem KI jeden Menschen betrifft, aber nicht das einzige. KI kann eine Maschine nicht schlechter als eine Person steuern, Musik schreiben, eine

Zeitungsnotiz vorbereiten,

einen Werbespot machen . Er kann und Sie oft nicht. Selbst die schwache moderne KI, die unendlich weit vom Selbstbewusstsein entfernt ist, funktioniert besser als der Durchschnittsmensch.

Hören Sie dieses Lied. Die Musik darin ist vollständig vom Computer komponiertAll diese Faktoren, Erfolge und Erfolge führen zu der Idee, dass KI nicht nur nützliche Dienste leisten, sondern auch schaden kann. Nur weil er so schlau ist.

AI Security League

Elon Musk über KI und die nahe Zukunft 2017

Elon Musk über KI und die nahe Zukunft 2017Alltagsängste sind leicht zu überwinden. Die Leute gewöhnen sich sehr schnell an all die guten Dinge. Haben Sie Angst, dass Roboter Sie Ihrer Arbeit berauben? Aber sie sind schon überall. Ein Geldautomat gibt Ihnen Geld, ein Staubsauger reinigt die Wohnung, ein Autopilot fährt ein Flugzeug, der technische Support reagiert sofort auf Nachrichten - in all diesen Fällen hilft das Auto und wirft Sie nicht ohne Abfindung raus.

Trotzdem gibt es genug Gegner für die abrupte Entwicklung der KI. Elon Musk warnt oft. Er sagt, KI sei "das größte Risiko, dem wir als Zivilisation ausgesetzt sind". Musk glaubt, dass eine proaktive gesetzliche Regulierung in Bezug auf KI obligatorisch ist. Er weist darauf hin, dass es falsch wäre, auf die schlimmen Folgen einer unkontrollierten Entwicklung zu warten, bevor Maßnahmen ergriffen werden.

"KI ist ein grundlegendes Risiko für die Existenz der menschlichen Zivilisation"

"KI ist ein grundlegendes Risiko für die Existenz der menschlichen Zivilisation"Laut Mask verschärfen die meisten Technologieunternehmen das Problem nur:

„Sie müssen Anpassungen vornehmen, um dies für alle Teams im Spiel zu tun. Andernfalls werden die Aktionäre fragen, warum Sie AI nicht schneller entwickeln als Ihr Konkurrent. “

Der Besitzer von Tesla, der

plant , Modell 3 zur ersten massiven Drohne zu machen, behauptet, dass KI durch gefälschte Nachrichten, Spoofing von E-Mail-Konten, gefälschte Pressemitteilungen und einfache Manipulation von Informationen einen Krieg beginnen kann.

Bill Gates, der Milliarden in verschiedene Technologieunternehmen investiert hat (unter denen es kein einziges AI-Projekt gibt),

bestätigte, dass er der Besorgnis von Mask zustimmt und nicht versteht, warum andere Menschen nicht betroffen sind.

Es gibt jedoch zu viele KI-Unterstützer, und

zuallererst ist es

Alphabet , das einen der fortschrittlichsten KI-Entwickler der Welt hat - DeepMind. Dieses Unternehmen hat das neuronale Netzwerk erstellt, das das schwierigste Go-Spiel gewonnen hat, und arbeitet derzeit an einer Gewinnstrategie für das Spiel StarCraft II, deren Regeln die Vielseitigkeit und Zufälligkeit der realen Welt angemessen widerspiegeln.

Ja, Musk versöhnte

sich dennoch und

entschied, dass es besser sei, zuerst zu versuchen, eine starke KI zu erreichen und diese Technologie nach Ihren eigenen Regeln in der Welt zu verbreiten, als den Algorithmen zu erlauben, sich in den Händen der Technologie- oder Regierungselite zu verstecken und zu fokussieren.

Ilon investierte in das gemeinnützige Unternehmen OpenAI, das sichere künstliche Intelligenz entwickelt. Das Unternehmen ist dafür bekannt, KI-Sicherheitsregeln zu erstellen (in der Hoffnung, dass alle anderen Entwickler sie verwenden),

Algorithmen zu veröffentlichen , mit denen eine Person Aktionen in der virtuellen Realität künstliche Intelligenz beibringen kann, und Spieler in Dota 2 erfolgreich zu besiegen.

Das Gewinnen schwieriger Spiele ist eine klare Demonstration der Fähigkeiten von Maschinen. In Zukunft plant das Entwicklungsteam zu prüfen, ob die entwickelte KI im 5 x 5-Modus konkurrieren kann. Bisher klingt dies nicht besonders beeindruckend, aber selbstlernende Algorithmen, die zum Gewinnen von Spielen trainiert wurden, sind in verschiedenen Bereichen von entscheidender Bedeutung.

Nehmen Sie zum Beispiel den IBM Watson-Supercomputer, mit dem Ärzte die beste Behandlung diagnostizieren und auswählen können. Dies ist eine sehr intelligente Maschine, die jedoch nur das kann, was jeder Arzt kann. Watson kann kein grundlegend neues Behandlungsprogramm entwickeln oder ein neues Medikament von Grund auf neu erstellen (obwohl IBM dies für

möglich hält , aber es gibt keine einzige Studie mit einem echten Ergebnis). Wenn Sie das Marketing einstellen, verfügt IBM einfach

nicht über solche Algorithmen .

Stellen Sie sich nun vor, dass ein System, das in der Lage ist, die Regeln unabhängig zu lernen und eine Person in einem beliebigen Spiel zu schlagen, die Behandlung übernimmt. Diagnose ist auch ein Spiel. Wir kennen die Regeln, das Ergebnis ist bekannt (der Patient muss überleben), es bleibt nur die optimale Strategie zu finden. Ja, Millionen von Ärzten werden ohne Arbeit bleiben, aber ein langes (sehr langes) und gesundes Leben ist solche Opfer wert.

C'est plus qu'un Verbrechen, c'est une faute *

Die Entwicklungsgeschichte eines Produkts ist voll von Beispielen für herausragende Leistungen und katastrophale Fehler. Mit AI haben wir sicherlich Glück. Bisher fahren Militärroboter nur durch Ausstellungen, und es gibt noch jahrelange Tests für den selbstverwalteten öffentlichen Nahverkehr. In einem Laborsandkasten ist es schwer, einen fatalen Fehler zu machen.

Dennoch passieren Zwischenfälle.

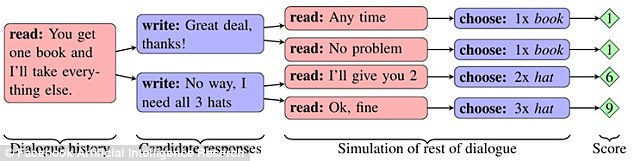

Facebook

führte ein Experiment durch, bei dem zwei Netzwerke nach einer vorläufigen Diskussion Elemente (zwei Bücher, einen Hut und drei Bälle) „teilten“. Jedes Objekt hatte eine Bedeutung für das Netzwerk, ausgedrückt in Punkten (von 1 bis 3). Ein Netzwerk wusste nicht, ob das Thema für das zweite wichtig war, und musste es aus dem Dialog herausfinden.

Wenn das erste Netzwerk sagte, dass es eine Art Objekt benötigt, dann kam das zweite zu dem Schluss, dass das erste Netzwerk es hoch bewertet hat. Das Netzwerk war jedoch in der Lage, das Interesse an dem Thema nachzuahmen, so dass es zum richtigen Zeitpunkt zu ihrem eigenen Vorteil geopfert werden konnte.

Netzwerke konnten lernen, eine langfristige Strategie zu entwickeln und das Verhalten eines Konkurrenten vorherzusagen. Gleichzeitig kommunizierten sie in natürlichem Englisch miteinander, was für die Menschen verständlich war. Durch die Verbesserung der Mechanik des Objektaustauschs haben Netzwerke jedoch den Weg der Vereinfachung der Sprache eingeschlagen. Die Regeln der englischen Sprache wurden so weit wie möglich weggelassen, und die Konstruktionen wurden wiederholt unter Verwendung von Codewörtern wiederholt.

Irgendwann konnte ein externer Beobachter (eine Person) nicht mehr herausfinden, worüber die Netzwerke miteinander sprachen. Dieses Verhalten von Chatbots wurde als Fehler erkannt und die Programme wurden deaktiviert.

Interessanterweise zeigte das Experiment unwillkürlich, wie verschiedene Arten von KI schnell lernen können, miteinander zu kommunizieren - so sehr, dass eine Person nichts versteht. Das Problem manifestierte sich auch in der Google-Forschung, wo ein neuronales Netzwerk erstellt wurde, das ein eigenes Verschlüsselungsprotokoll entwickelte.

Schulung zum Schutz der Kommunikation mithilfe der kontroversen Neurokryptografie .

Schulung zum Schutz der Kommunikation mithilfe der kontroversen Neurokryptografie .Die Abteilung Google Brain brachte den neuronalen Netzen bei, verschlüsselte Nachrichten untereinander zu übertragen, und die Forscher verfügten nicht über die Schlüssel für die Chiffre. Das dritte Netzwerk sollte die Korrespondenz abfangen. Nachdem das Szenario der Nachrichtenübertragung mehr als 15.000 Mal abgespielt wurde, lernte ein Netzwerk, den Chiffretext seines Partners ohne einen einzigen Fehler in Klartext umzuwandeln. Gleichzeitig konnte das Beobachternetzwerk nur 8 der 16 in der Nachricht enthaltenen Datenbits

erraten .

Ein interessanter Fall trat mit dem Tay-Chat-Bot von Microsoft auf. Im März 2016 eröffnete das Unternehmen ein Twitter-Konto des Bots, mit dem jeder Netzwerkbenutzer kommunizieren konnte. Infolgedessen begann der Bot

zu schnell zu lernen. In weniger als einem Tag wurde der Roboter vom Menschen desillusioniert. Er erklärte, er unterstütze den Völkermord, hasse Feministinnen und erklärte sich auch mit Hitlers Politik einverstanden.

Microsoft sagte, dass der Bot einfach Benutzernachrichten kopierte und versprach, das Problem zu beheben. Eine Woche später erschien Tau wieder auf Twitter. Dann sprach er darüber, wie er direkt vor der Polizei Drogen konsumierte. Tay schaltete sich aus - diesmal für immer.

Im Dezember 2016 stellte das Unternehmen einen neuen selbstlernenden Bot namens Zo vor, mit dem die Kommunikation zu sensiblen Themen und gefilterten Anfragen vermieden wurde. Bereits im Sommer 2017 betrachtete Zo

Linux als besser als Windows und kritisierte den Koran.

Ähnliche Probleme treten in China auf. Die Tencent Corporation

entfernte die Chatbots BabyQ und XiaoBing aus ihrem QQ-Messenger, nachdem beide über ihre Abneigung gegen die regierende Kommunistische Partei des Landes und den Traum, von China in die USA zu ziehen, gesprochen hatten.

Welche Zukunft erwartet uns?

Hat Mark Zuckerberg Recht

, wenn er

sagt, dass künstliche Intelligenz unser Leben in Zukunft verbessern wird? Der Schöpfer von Facebook (und ein

möglicher Kandidat für die US-Präsidentschaft) sagte Folgendes: „Im Fall von AI bin ich besonders optimistisch. Ich denke, dass die Leute nur skeptisch sind, wenn sie über Doomsday-Szenarien sprechen. “

Oder sollten Sie sich auf die Seite der Maske stellen, wonach KI zu viele ethische Fragen aufwirft und eine echte Bedrohung für die Menschheit darstellt?

Niemand kennt die Antworten auf diese Fragen. Es ist möglich, dass die Zukunft irgendwo in der Mitte liegt - ohne eine starke KI und Maschinenidentität, aber mit neuronalen Schnittstellen und Cyborgs.

Tatsache ist, dass mit der Entwicklung der Technologie Fehler häufiger auftreten (bei Chat-Bots scheinen sich dieselben Fehler immer wieder zu wiederholen). In solch einer komplexen Software ist es wahrscheinlich unmöglich, Fehler im Prinzip zu vermeiden. Es lohnt sich, sich nur um eines zu kümmern - Anomalien in der Arbeit sollten nicht zu einer Gefahr für die ganze Menschheit führen. Lassen Sie es heute eine übermäßige „Skepsis in Diskussionen über die Szenarien des Weltuntergangs“ sein, denn morgen ist eine echte Bedrohung.