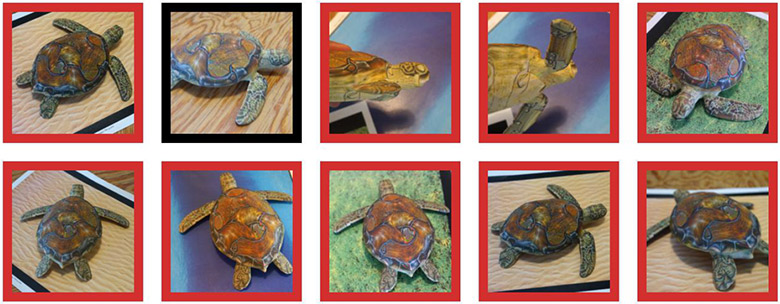

Eine auf einem 3D-Drucker gedruckte Schildkröte wird vom neuronalen Netzwerk als Schildkröte (grüner Umriss), Gewehr (roter Umriss) oder als anderes Objekt (schwarzer Umriss) erkannt.

Eine auf einem 3D-Drucker gedruckte Schildkröte wird vom neuronalen Netzwerk als Schildkröte (grüner Umriss), Gewehr (roter Umriss) oder als anderes Objekt (schwarzer Umriss) erkannt.Es ist seit langem bekannt, dass kleine, zielgerichtete Änderungen im Bild das maschinelle Lernsystem „brechen“, so dass es

ein völlig anderes Bild klassifiziert . Solche "Trojaner" -Bilder werden als "gegnerische Beispiele" bezeichnet und stellen eine der bekannten

Einschränkungen des tiefen Lernens dar .

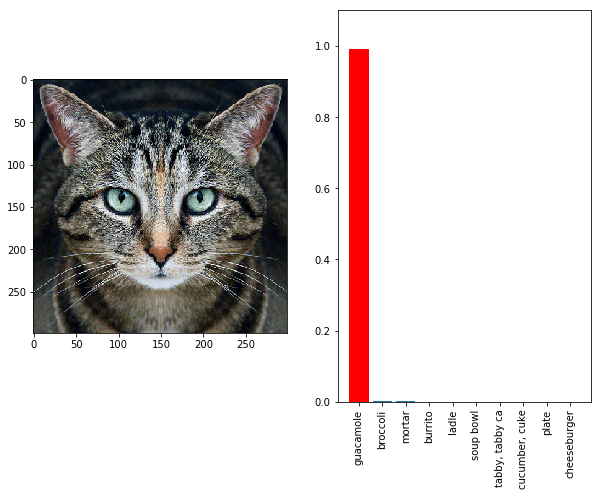

Sie funktionieren einfach: Sie müssen einen Gradientenanstieg im Eingabedatenraum durchführen, um Muster zu generieren, die die Klassenvorhersage für eine bestimmte Klasse maximieren. Wenn wir beispielsweise ein Foto eines Pandas aufnehmen und den Gradienten „Gibbon“ hinzufügen, wird das neuronale Netzwerk diesen Panda als Gibbon klassifizieren. Schildkröte kann als Gewehr ausgegeben werden (siehe Abbildung oben). Die Katze verwandelt sich in einen kalten Guacamole-Snack (siehe unter der Katze) - das spielt keine Rolle. Jedes Objekt verwandelt sich in den Augen der maschinellen Intelligenz in ein anderes, weil die KI ein spezielles "Vision" -System hat, das sich vom Menschen unterscheidet.

Bisher funktionierte eine solche Feineinstellung des Verlaufs nur bei 2D-Bildern und war sehr empfindlich gegenüber Verzerrungen.

Ein Foto einer Katze wird im InceptionV3- Klassifikator als Guacamole erkannt

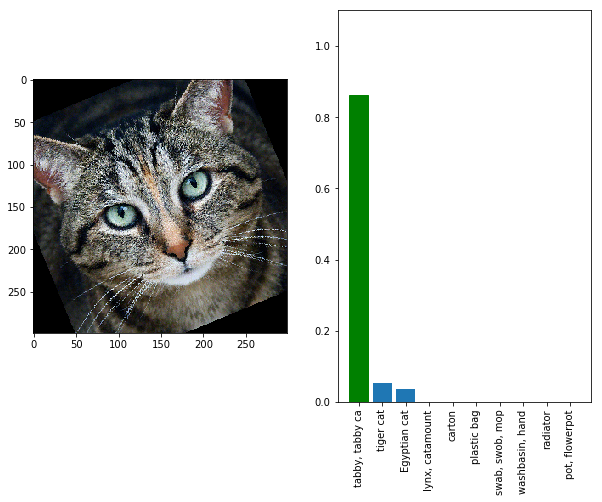

Ein Foto einer Katze wird im InceptionV3- Klassifikator als Guacamole erkanntBetrachten Sie die Katze aus einem anderen Blickwinkel oder aus einer anderen Entfernung - und das neuronale Netzwerk sieht die Katze wieder darin und keinen kalten Snack.

Ein Foto einer Katze wird im InceptionV3- Klassifikator wieder als Katze erkannt, wenn Sie es ein wenig drehen

Ein Foto einer Katze wird im InceptionV3- Klassifikator wieder als Katze erkannt, wenn Sie es ein wenig drehenDas heißt, in der Realität sind solche Wettbewerbsbeispiele aufgrund des Zooms, des Rauschens der Digitalkamera und anderer Verzerrungen, die in der Realität unvermeidlich sind, nicht effektiv. Dies ist nicht akzeptabel, wenn wir

Offline-Bildverarbeitungssysteme zuverlässig und stetig täuschen wollen. Aber jetzt ist die Hoffnung entstanden, dass die Menschen diese Aufgabe erfüllen können. Forscher des Massachusetts Institute of Technology und der unabhängigen Forschungsgruppe LabSix (bestehend aus Studenten und Absolventen des MIT) haben den weltweit ersten Algorithmus entwickelt, der

wettbewerbsfähige Beispiele in 3D generiert. Das folgende Video zeigt beispielsweise eine Schildkröte, die vom Google InceptionV3-Klassifikator in nahezu jedem Winkel als Gewehr erkannt wird.

Der Algorithmus kann nicht nur Schildkröten, sondern auch beliebige Modelle erzeugen. Für die Probe druckten die Forscher auch einen Baseball, der in jedem Winkel als Espresso (Kaffee) klassifiziert ist, und schufen eine große Anzahl anderer Modelle - besondere optische Täuschungen für die KI.

Die optische Täuschung funktioniert auch dann, wenn sich das Objekt auf dem Foto in einem semantisch irrelevanten Kontext befindet. Offensichtlich konnte das neuronale Netz während des Trainings weder ein Gewehr unter Wasser noch einen Espresso im Handschuh eines Fängers sehen.

Konkurrierende Beispiele in 3D: eine Schildkröte, die für das neuronale InceptionV3-Netzwerk wie ein Gewehr aussieht, und ein Baseball, der wie ein Espresso aussieht

Konkurrierende Beispiele in 3D: eine Schildkröte, die für das neuronale InceptionV3-Netzwerk wie ein Gewehr aussieht, und ein Baseball, der wie ein Espresso aussiehtObwohl die Methode speziell für ein bestimmtes neuronales Netzwerk „geschärft“ wurde, wurde in den Kommentaren zu früheren wissenschaftlichen Artikeln zu diesem Thema die Bemerkung von Forschern

berücksichtigt , dass der Angriff höchstwahrscheinlich viele Modelle betreffen wird, die auf diesen bestimmten Datensatz trainiert wurden - einschließlich verschiedener Faltungsnetzwerkarchitekturen und sogar lineare Klassifikatoren. Für einen Angriff reicht also die Hypothese aus, auf welche Daten das Modell trainiert werden könnte.

"Konkret bedeutet dies, dass es wahrscheinlich die Möglichkeit geben wird, ein Verkehrsschild für den Verkauf eines Hauses zu erstellen, was für menschliche Fahrer durchaus üblich erscheint, für ein unbemanntes Fahrzeug jedoch wie ein Fußgänger, der plötzlich auf dem Bürgersteig auftaucht", heißt es in der wissenschaftlichen Arbeit. "Konkurrierende Beispiele sind von praktischem Interesse, was berücksichtigt werden muss, da neuronale Netze immer häufiger (und gefährlicher) werden."

Zum Schutz vor solchen Angriffen können Entwickler der zukünftigen KI geheime Informationen über die Architektur ihrer neuronalen Netze und vor allem über den Datensatz, der im Training verwendet wurde, aufbewahren.

Der wissenschaftliche Artikel wurde am 30. Oktober 2017 auf der Preprint-Website arXiv.org (arXiv: 1707.07397v2) veröffentlicht.