Systeme der künstlichen Intelligenz (KI) gewinnen an Boden. In diesem Zusammenhang diskutieren Anwälte und Gesetzgeber das Problem, wie solche Systeme reguliert werden sollten, die für ihre Handlungen verantwortlich sind. Dieses Problem erfordert eine sorgfältige Untersuchung und einen ausgewogenen Ansatz, da KI-Systeme große Datenmengen generieren können und in Anwendungen mit unterschiedlichen Funktionen verwendet werden - von medizinischen Systemen und Autopiloten in Autos bis hin zur Vorhersage von Verbrechen und zur Berechnung potenzieller Krimineller. Gleichzeitig bemühen sich Wissenschaftler, eine „starke KI“ zu schaffen, die zum Denken fähig ist, und es stellt sich die Frage, wie das Vorhandensein von Absichten in seinen Handlungen festgestellt werden kann - oder ob Handlungen als unbeabsichtigt erkannt werden.

Es gibt viele Möglichkeiten, das KI-System zur Rechenschaft zu ziehen und Verantwortung zu übernehmen. Zu diesem Thema wurden mehrere Studien veröffentlicht. In einem neuen

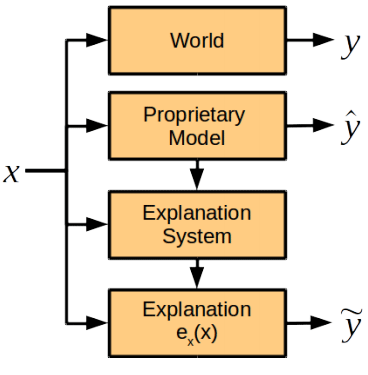

Forschungsbericht diskutieren Informatiker, Kognitionswissenschaftler und Anwälte der Universitäten Harvard und Cambridge (USA) eine Komponente des zukünftigen KI-Verantwortlichkeitssystems, nämlich die Rolle einer Erläuterung der KI, dh eine Bewertung, wie das System der künstlichen Intelligenz seine Handlungen erklärt . Wissenschaftler kamen zu dem Schluss, dass das Modul zur Erklärung von Aktionen vom allgemeinen KI-System getrennt werden sollte.

Die Autoren der wissenschaftlichen Arbeit beschreiben alle Probleme, die auftreten, wenn versucht wird, das KI-System um eine Erklärung seiner Handlungen zu bitten.

Erstens sollte eine solche Gelegenheit in der Phase der Systementwicklung geboten werden, da die KI sonst möglicherweise ihre Handlungen ablehnt oder nicht erklären kann.

Zweitens verarbeitet das KI-System eine große Anzahl von Daten unter Verwendung komplexer proprietärer Algorithmen oder Methoden, die es selbst im Lernprozess entwickelt hat. Wenn sie versucht, ihre Handlungen so vollständig wie möglich zu erklären, kann sie zu viele Daten generieren, die für eine Person unverständlich sind. Oder - wie das andere Extrem - ein zu vereinfachtes Modell liefern, das nicht die wirklichen Absichten der KI und die Motive der Handlungen widerspiegelt. Darüber hinaus können die Betriebsalgorithmen des KI-Systems geistiges Eigentum des sich entwickelnden Unternehmens sein. Daher ist es erforderlich, eine solche Methode zur Erstellung einer Erläuterung bereitzustellen, um die Ursachen des Systems zu ermitteln, die zugrunde liegenden Algorithmen jedoch nicht herauszugeben.

Forscher glauben, dass eine Erklärung möglich ist, ohne die Algorithmen und Regeln aufzudecken, die der Funktionsweise des KI-Systems zugrunde liegen. Im Falle eines Vorfalls sollte das System Antworten auf die folgenden Fragen geben:

- Was sind die Hauptfaktoren, die die Entscheidung beeinflussen?

- Würde eine Änderung eines bestimmten Faktors zu einer Änderung der Entscheidung führen?

- Warum führten zwei ähnliche Fälle zu unterschiedlichen Lösungen?

Antworten auf solche Fragen erfordern nicht unbedingt die Offenlegung von proprietären Geheimnissen und internen Systemalgorithmen, sondern vermitteln gleichzeitig ein klares Verständnis der Motive.

Wissenschaftler argumentieren, in welchen Fällen es angebracht ist, von der KI eine Erklärung ihrer Handlungen zu verlangen. Dies ist in der Tat erforderlich, wenn der Nutzen der Erklärung den Preis ihrer Quittung überwiegt: „Wir glauben, dass es drei Bedingungen für Situationen gibt, in denen das Unternehmen es für erforderlich hält, eine Erklärung vom Entscheidungsträger einzuholen. Dies sind moralische, soziale oder rechtliche Gründe “, erklärt Finale Doshi-Velez, Hauptautor des Papiers.

Gleichzeitig sollte man nicht in jeder Situation buchstäblich Erklärungen von der KI verlangen. Wie oben erwähnt, erhöht dies das Risiko der Herausgabe von Geschäftsgeheimnissen und belastet die Entwickler von KI-Systemen zusätzlich. Mit anderen Worten, die ständige Rechenschaftspflicht der KI gegenüber dem Menschen wird die Entwicklung dieser Systeme behindern, auch in Bereichen, die für den Menschen wichtig sind.

Im Gegensatz zu der weit verbreiteten Annahme, dass das KI-System eine Black Box ist, deren Ursachen für den Menschen unverständlich sind, sind sich die Autoren der wissenschaftlichen Arbeit sicher, dass ein normal funktionierendes Modul zur Erklärung der Aktionen der KI entwickelt werden kann. Dieses Modul wird in das System integriert, arbeitet jedoch unabhängig von den Entscheidungsalgorithmen und befolgt diese nicht.

Wissenschaftler glauben, dass es einige Punkte in der Erklärung von Handlungen gibt, die für Menschen leicht darzulegen sind und für Maschinen schwierig sind und umgekehrt.

Vergleich der menschlichen Fähigkeiten und KI zu erklären | Mann | AI |

|---|

| Die Vorteile | Kann den hinteren Akt erklären | Reproduzierbarkeit, mangelnder sozialer Druck |

| Nachteile | Kann ungenau und unzuverlässig sein, fühlt sozialen Druck | Erfordert eine vorläufige Programmierung des Erklärungsmoduls, zusätzliche Taxonomien und die Erweiterung des Speichersystems |

Die Expertengruppe empfiehlt jedoch, dass das erste Mal, das für KI-Systeme festgelegt wird, derselbe Standard für die Erklärung ihrer Handlungen ist, der heute für Menschen festgelegt ist (dieser Standard ist im US-Recht festgelegt: Insbesondere bei strikter Haftung, Scheidung und Diskriminierung ist eine Erklärung erforderlich.) für Verwaltungsentscheidungen und von Richtern und Jurys, um ihre Entscheidungen zu erläutern - obwohl der Detaillierungsgrad der Erläuterung in jedem Fall sehr unterschiedlich ist).

Wenn die Gründe für die Handlungen der KI über das Verständnis des Menschen hinausgehen, kann, um die KI in Zukunft zu berücksichtigen, ein anderer Standard für ihre Erläuterungen entwickelt werden, sagen Wissenschaftler.

Der wissenschaftliche Artikel wurde am 3. November 2017 auf der Preprint-Website arXiv.org (arXiv: 1711.01134v1) veröffentlicht.