Im Mai 2017 stellten Google Brain-Forscher das

AutoML- Projekt vor, das den Entwurf von Modellen für maschinelles Lernen automatisiert. AutoML-Experimente haben gezeigt, dass dieses System kleine neuronale Netze mit sehr guter Leistung erzeugen kann - vergleichbar mit den neuronalen Netzen, die von menschlichen Experten entworfen und trainiert werden. Zunächst beschränkte sich AutoML jedoch auf kleine wissenschaftliche Datensätze wie CIFAR-10 und Penn Treebank.

Die Google-Ingenieure fragten sich: Was wäre, wenn wir dem KI-Generator ernstere Aufgaben stellen würden? Ist dieses KI-System in der Lage, eine andere KI zu generieren, die bei wichtigen Aufgaben wie der Klassifizierung von Objekten aus der

ImageNet- Datenbank - dem bekanntesten großen Datensatz in der

Bildverarbeitung - besser ist als von Menschen erstellte KI? Es gab also ein neuronales

NASNet- Netzwerk, das fast ohne menschliches Eingreifen erstellt wurde.

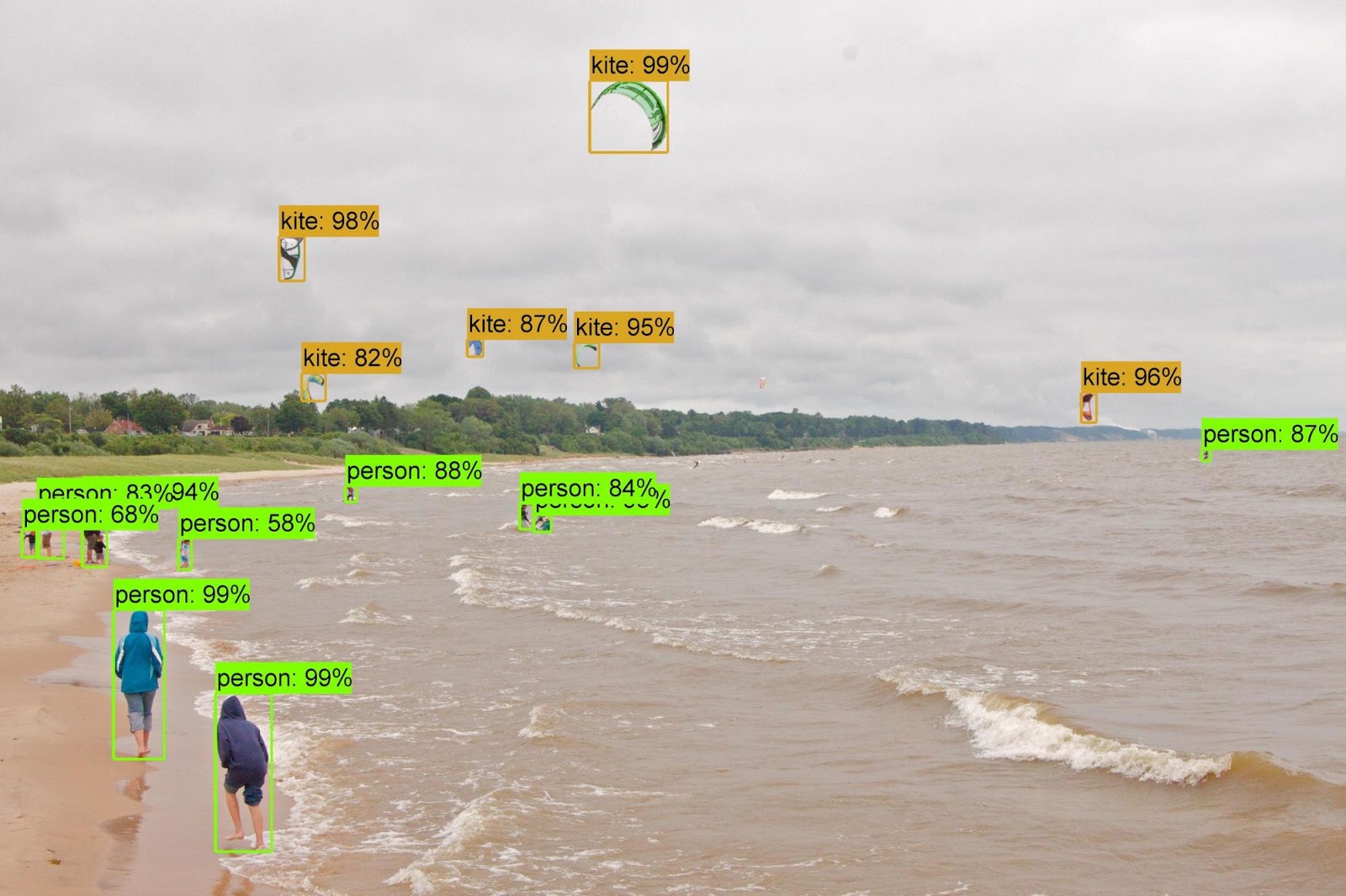

Wie sich herausstellte, kommt die KI mit dem Design und Training neuronaler Netze nicht schlechter zurecht als der Mensch. Die Aufgabe, Objekte aus dem ImageNet-Dataset zu klassifizieren und Objekte aus dem

COCO- Dataset zu definieren, war Teil des Projekts

Learning Transferable Architectures for Scalable Image Recognition .

Die Entwickler des AutoML-Projekts

geben an, dass sich die Aufgabe als nicht trivial herausgestellt hat, da die neuen Datensätze mehrere Größenordnungen größer sind als die vorherigen, mit denen das System arbeitet. Ich musste einige der Algorithmen von AutoML ändern, einschließlich der Neugestaltung des Suchraums, damit AutoML die beste Ebene finden und viele Male duplizieren konnte, bevor ich die endgültige Version des neuronalen Netzwerks erstellte. Darüber hinaus untersuchten die Entwickler Optionen für die Architektur neuronaler Netze für CIFAR-10 - und übertrugen die erfolgreichste Architektur manuell auf ImageNet- und COCO-Aufgaben.

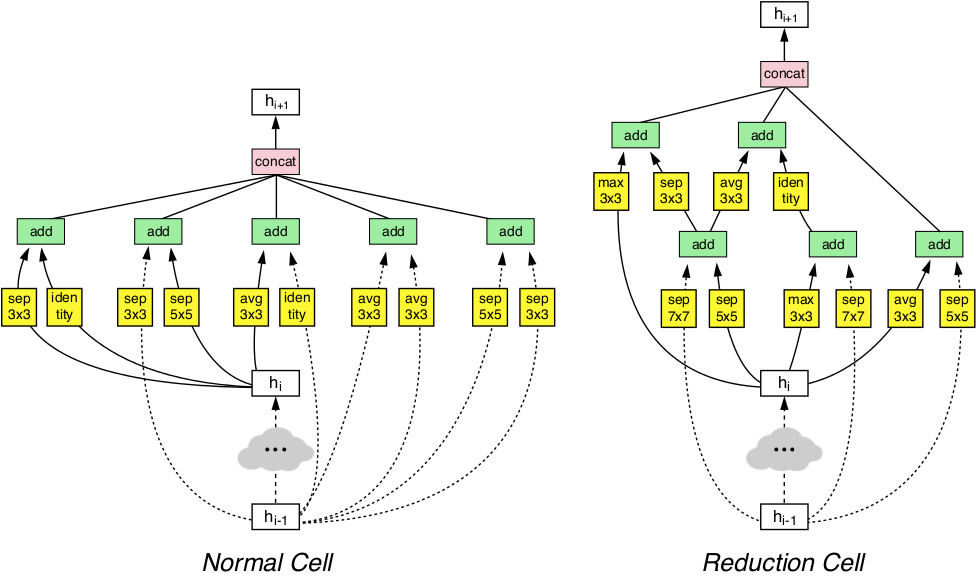

Dank dieser Manipulationen konnte das AutoML-System die effizientesten Schichten des neuronalen Netzwerks erkennen, die für CIFAR-10 gut funktionierten und gleichzeitig bei ImageNet- und COCO-Aufgaben eine gute Leistung erbrachten. Diese beiden entdeckten Schichten wurden kombiniert, um eine innovative Architektur namens NASNet zu bilden.

Die NASNet-Architektur besteht aus zwei Arten von Schichten: einer normalen Schicht (links) und einer Reduktionsschicht (rechts). Diese beiden Ebenen werden von einem AutoML-Generator entworfen.

Die NASNet-Architektur besteht aus zwei Arten von Schichten: einer normalen Schicht (links) und einer Reduktionsschicht (rechts). Diese beiden Ebenen werden von einem AutoML-Generator entworfen.Benchmarks haben gezeigt, dass die automatisch generierte KI alle anderen Bildverarbeitungssysteme übertrifft, die von menschlichen Experten für die Klassifizierung und Definition von Objekten erstellt und geschult wurden.

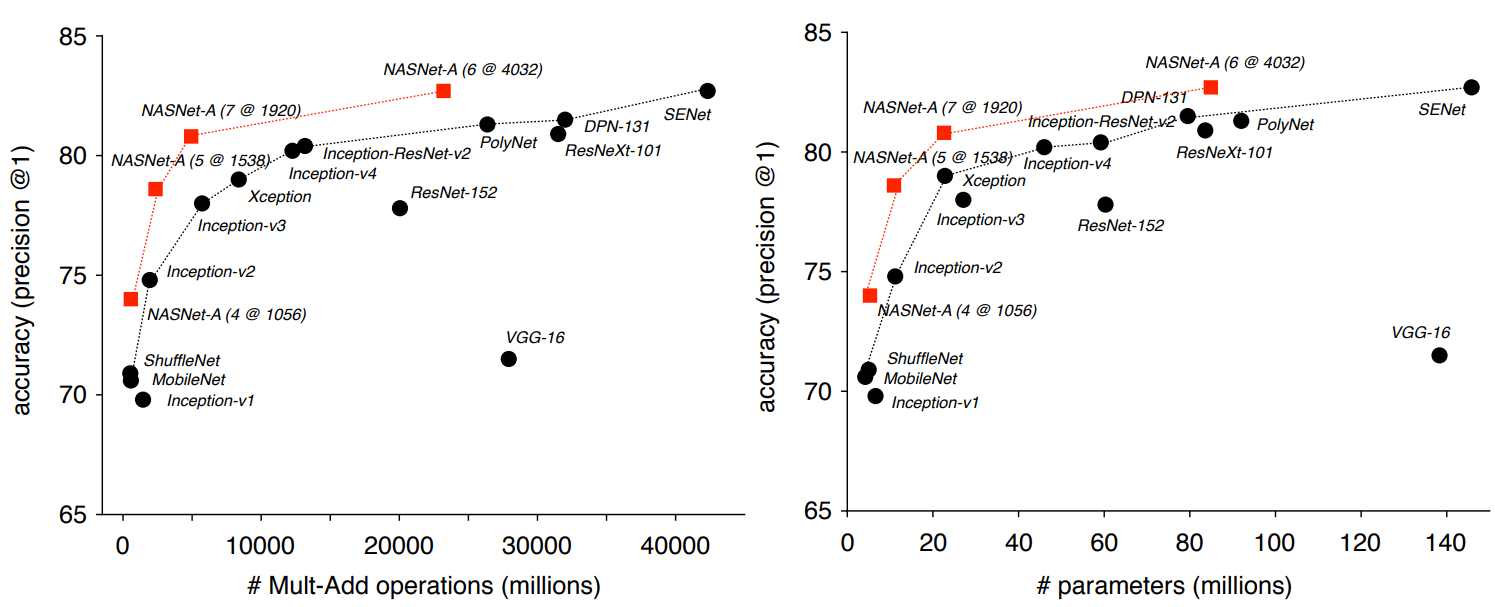

In der auf ImageNet basierenden Klassifizierungsaufgabe zeigte das neuronale NASNet-Netzwerk eine Vorhersagegenauigkeit von 82,7% für den Testsatz. Dieses Ergebnis ist höher als bei allen zuvor entwickelten Bildverarbeitungsmodellen der Inception-Familie. Das NASNet-System zeigte ein um mindestens 1,2 Prozentpunkte höheres Ergebnis als alle bekannten neuronalen Bildverarbeitungsnetze, einschließlich der neuesten Ergebnisse von Arbeiten, die noch nicht in der wissenschaftlichen Presse veröffentlicht, aber bereits auf der Preprint-Website von arXiv.org veröffentlicht wurden.

Die Forscher betonen, dass NASNet skaliert und daher angepasst werden kann, um auf Systemen mit schwachen Computerressourcen ohne großen Genauigkeitsverlust zu arbeiten. Das neuronale Netzwerk kann sogar auf einem Mobiltelefon mit einer schwachen CPU mit einer begrenzten Speicherressource arbeiten. Die Autoren sagen, dass die Miniaturversion von NASNet eine Genauigkeit von 74% aufweist, was 3,1 Prozentpunkte besser ist als die bekannten neuronalen Netze mit der höchsten Qualität für mobile Plattformen.

Als die vom ImageNet-Klassifikator erfassten Attribute in die Objekterkennung übertragen und mit dem

Faster-RCNN-Framework kombiniert wurden, zeigte das System die besten Ergebnisse beim COCO-Objekterkennungsproblem sowohl im großen Modell als auch in der reduzierten Version für mobile Plattformen. Das große Modell zeigte ein Ergebnis von 43,1% mAP, was 4 Prozentpunkte besser ist als der des nächsten Konkurrenten.

Die Autoren haben den Quellcode für NASNet in den Repositorys

Slim and

Object Detection für TensorFlow geöffnet, damit jeder in seiner eigenen Arbeit ein neues neuronales Netzwerk erleben kann.

Der wissenschaftliche Artikel wurde am 1. Dezember 2017 auf der Preprint-Website arXiv.org veröffentlicht (arXiv: 1707.07012v3, dritte Version).