Eine Gruppe von Forschern aus Berkeley hat dieses Jahr zwei Videos veröffentlicht. In einem von ihnen läuft ein Pferd hinter dem Zaun. In der zweiten bekommt sie plötzlich ein schwarz-weißes Zebramuster. Das Ergebnis ist nicht perfekt, aber die Streifen passen so gut zum Pferd, als ob der Stammbaum dieser Tiere ins Chaos gestürzt wäre. Ein ähnlicher Trick ist ein Indikator für die sich entwickelnde Fähigkeit von Algorithmen für maschinelles Lernen, die Realität zu verändern.

Einige andere Forscher verwendeten neuronale Netze,

um Fotos von Schwarzbären in glaubwürdige Bilder von Pandas, Äpfeln in Orangen und Katzen in Hunde zu

verwandeln . Ein Reddit-Benutzer verwendete einen anderen Algorithmus für maschinelles Lernen, um Pornovideos zu bearbeiten, und

fügte dort Promi-Gesichter ein . Startup Lyrebird

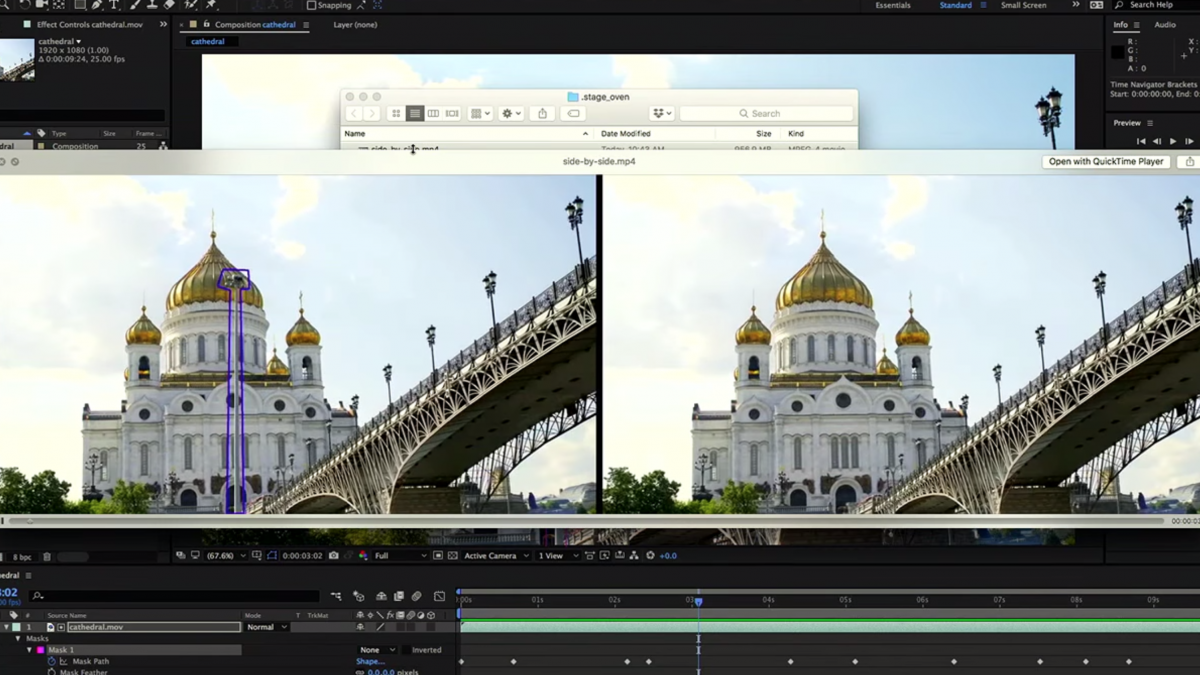

synthetisiert eine ziemlich überzeugende Sprache basierend auf einer einminütigen Aufzeichnung der Stimme einer Person. Die Ingenieure von Adobe, die die Sensei-Plattform für künstliche Intelligenz entwickeln, führen

maschinelles Lernen in innovative Tools für die Video-, Foto- und Audiobearbeitung ein. Diese Projekte unterscheiden sich stark in ihrer Herkunft und ihren Zielen, aber eines haben sie gemeinsam: Sie synthetisieren Bilder und Töne, die sich als erstaunlich ähnlich wie echte herausstellen. Im Gegensatz zu früheren Experimenten sehen und klingen diese KI-Kreationen realistisch.

Die diesen Veränderungen zugrunde liegenden Technologien werden uns bald zu neuen kreativen Bereichen führen, die Fähigkeiten zeitgenössischer Künstler verbessern und gewöhnliche Amateure zu Profis machen. Wir werden nach neuen Definitionen des Konzepts der Kreativität suchen, die seinen Horizont erweitern und die Kreationen von Maschinen einschließen. Aber dieser Boom wird einen Nachteil haben. Ein Teil des durch künstliche Intelligenz erstellten Inhalts wird verwendet, um zu täuschen und Angst vor einer endlosen Lawine

gefälschter Nachrichten zu erzeugen. Die alte Debatte darüber, ob das Bild geändert wurde, wird einer neuen weichen - über die Herkunft aller Arten von Inhalten, einschließlich Text. Sie werden sich fragen: Welche Rolle haben die Leute (wenn überhaupt) bei der Erstellung dieses Albums / dieser Serie / dieses Artikels gespielt?

Bisher gab es zwei Möglichkeiten, Audio oder Video ähnlich wie echte zu erstellen. Die erste besteht darin, eine Produktionsszene mit Kameras und Mikrofonen aufzunehmen. Die zweite besteht darin, den Einsatz menschlicher Talente zu maximieren, oft für viel Geld, um eine exakte Kopie zu erstellen. Jetzt bieten Algorithmen für maschinelles Lernen eine dritte Option, mit der jeder mit minimalen technischen Kenntnissen vorhandene Inhalte ändern kann, um neues Material zu erstellen.

Die Geburt der Venus - Version von Deep Dreams

Die Geburt der Venus - Version von Deep DreamsDer von den neuronalen Netzen erzeugte Inhalt war zunächst nicht realistisch ausgerichtet. Googles Deep Dreams, das 2015 veröffentlicht wurde, war ein frühes Beispiel für die Verwendung von Deep Learning, um psychedelische Landschaften und vieläugige groteske Kunstwerke zu prägen. Die 2016er Hit-App Prisma nutzte Deep Learning, um Fotofilter zu verbessern, z. B. das Stylen von Bildern mit Mondrian- oder Munch-Gemälden. Diese Technik wird als Stilübertragung bezeichnet: Nehmen Sie den Stil eines Bildes (z. B. „Scream“) und wenden Sie ihn auf das zweite Bild an.

Jetzt werden Stilübertragungsalgorithmen ständig verbessert. Nehmen wir zum Beispiel die

Arbeit von Kavita Balas Labor an der Cornell University. Es zeigt, wie tiefes Lernen den Stil eines Fotos (eine flackernde Nachtatmosphäre) auf ein Bild einer düsteren Metropole übertragen kann - und die Rezensenten täuschen kann, die glauben, dass dieser Ort real ist. Inspiriert vom Potenzial der künstlichen Intelligenz, ästhetische Eigenschaften zu erkennen, war Professor Bala Mitbegründer von

GrokStyle . Stellen Sie sich vor, Sie mögen dekorative Kissen auf der Couch eines Freundes oder eine Decke in einer Zeitschrift. Zeigen Sie dem GrokStyle-Algorithmus dieses Bild und es werden Bilder von Dingen im gleichen Stil gefunden.

Professor Bala sagt: „Was ich an diesen Technologien mag, ist, wie sie Design und Stil demokratisieren. Ich bin ein Technologe: Ich schätze Schönheit und Stil, aber ich kann sie nicht einmal in der Nähe schaffen. Und diese Arbeit stellt mir solche Dinge zur Verfügung. Auch sehr erfreut, dies anderen zur Verfügung stellen zu können. Die Tatsache, dass wir in diesem Bereich nicht begabt sind, bedeutet nicht, dass wir in einer langweiligen Umgebung leben müssen. “

Bei Adobe ist maschinelles Lernen seit mehr als einem Jahrzehnt Teil der Entwicklung kreativer Produkte, aber das Unternehmen hat kürzlich einen großen Schritt nach vorne gemacht. Im Oktober demonstrierten Ingenieure, die an Sensei arbeiteten, ein vielversprechendes Videobearbeitungswerkzeug namens Adobe Cloak. Damit kann der Benutzer beispielsweise einen Laternenpfahl einfach aus einem Videoclip entfernen - eine Aufgabe, die selbst für einen erfahrenen Redakteur furchtbar schmerzhaft wäre. Ein anderes Projekt namens Project Puppetron wendet einen bestimmten künstlerischen Stil auf Echtzeitvideos an. Sie können eine Person in Form einer animierten Bronzestatue oder einer gezeichneten Zeichentrickfigur anzeigen. „Sie können einfach etwas vor der Kamera tun und daraus eine Echtzeitanimation machen“, sagt John Brandt, leitender Wissenschaftler und Direktor von Adobe Research.

Maschinelles Lernen macht diese Projekte möglich, da es Teile des Gesichts unterscheiden und den Unterschied zwischen dem vorderen und hinteren Hintergrund besser erkennen kann als frühere Ansätze für Computer Vision. Mit Sensei-Werkzeugen können Künstler nicht mit Materialien, sondern mit Konzepten arbeiten. „Photoshop verwaltet Pixel hervorragend, aber die Leute versuchen tatsächlich, den von diesen Pixeln angezeigten Inhalt zu manipulieren“, erklärt Brandt.

Dies ist ein guter Teil der Nachrichten. Wenn Künstler keine Zeit mehr damit verbringen müssen, einzelne Punkte auf dem Bildschirm zu zeichnen, steigt ihre Produktivität. Laut Brandt freut er sich sehr über die Möglichkeit der Entstehung neuer Kunstformen und wartet darauf, dass sie kommen.

Adobe Cloak Demonstration

Adobe Cloak DemonstrationEs ist jedoch nicht schwer vorstellbar, wie diese kreative Explosion zu sehr schlimmen Folgen führt. Yanshun Yao, Absolvent der University of Chicago, sah ein gefälschtes Video von AI und beschloss, ein Projekt zu starten, das die Gefahren des maschinellen Lernens untersucht. In dem Video, das er sah, hielt der generierte Barack Obama eine Rede. Yao wollte überprüfen, ob es möglich war, etwas Ähnliches mit Textmaterial anzukurbeln?

Die Struktur des Textes sollte nahezu fehlerfrei sein, damit die meisten Leser von seiner "menschlichen Herkunft" überzeugt sind. Yao begann mit einer relativ einfachen Aufgabe - gefälschte Bewertungen für Yelp und Amazon zu generieren. Ein solcher Text kann nur aus wenigen Sätzen bestehen, und die Leser erwarten keine hohen Sprachkenntnisse. Er und seine Kollegen erstellten ein

neuronales Netzwerk und erstellten Texte zum Thema Yelp-Länge von 5 Sätzen. Die Bewertungen enthielten Aussagen wie "Jetzt ist dies unser Lieblingsort!" und "Ging dort mit meinem Bruder, bestellte eine vegetarische Pasta - sehr lecker." Außerdem fragte Yao die Leute, ob diese Texte echt oder falsch seien - und natürlich täuschten sich die Leute oft.

Die Kosten für das Schreiben solcher Bewertungen liegen zwischen 10 und 50 US-Dollar, und Yao behauptet, es sei nur eine Frage der Zeit, bis jemand versucht, den Prozess zu automatisieren, indem er die Preise senkt und die Website mit gefälschten Bewertungen überflutet. Er erkundete auch die Möglichkeiten neuronaler Netze, Yelp vor gefälschten Inhalten zu schützen - und erzielte einige Erfolge. Sein nächstes Ziel ist es, glaubwürdige Nachrichtenartikel zu generieren.

Bei Videoinhalten kann der Fortschritt sogar noch schneller voranschreiten. Hani Farid, Experte für die Erkennung gefälschter Fotos und Videos und Professor am Dartmouth College, ist besorgt darüber, wie schnell sich virale Inhalte verbreiten und wie der Prozess der Erkennung seiner Authentizität hinterherhinkt. Er gibt zu, dass es in naher Zukunft ein glaubwürdiges Video geben wird, in dem Donald Trump den Befehl für einen Atomangriff auf Nordkorea erteilt. Es wird viral und sät Panik - so wie es einst

eine Radiosendung über den „Krieg der Welten“

ausgelöst hat . "Ich möchte keine hysterischen Annahmen treffen, aber ich denke nicht, dass die Befürchtungen unbegründet sind", sagt er.

Trumps generierte Auftritte laufen jedoch bereits im Web. Sie sind ein Produkt von Lyrebird, einem Startup für Sprachsynthesizer. Jose Sotelo, Mitbegründer und CEO des Unternehmens, ist überzeugt, dass die Existenz dieser Technologie unvermeidlich ist, so dass er und seine Kollegen sie weiterentwickeln werden - natürlich ohne die Ethik zu vergessen. Er ist sicher, dass die beste Verteidigung für heute darin besteht, das Bewusstsein für die Möglichkeiten des maschinellen Lernens zu schärfen. Sotelo bemerkt: „Wenn Sie meine Fotos auf dem Mond sehen, werden Sie mit ziemlicher Sicherheit entscheiden, dass sie in einem Grafikeditor erstellt werden. Aber wenn Sie eine Audioaufnahme hören, bei der der beste Freund böse Dinge über Sie spricht, werden Sie höchstwahrscheinlich besorgt sein. Dies ist wirklich eine neue Technologie, die die Menschheit vor neue Herausforderungen stellt. “

Es ist unwahrscheinlich, dass etwas die Welle der generierten KI-Inhalte stoppen kann. Es ist ein Szenario möglich, in dem Betrüger und unehrliche Politiker mithilfe von Technologie irreführende Informationen erstellen.

Die positive Seite ist, dass der generierte KI-Inhalt auch der Gesellschaft einen enormen Service bieten kann. Sotelo von Lyrebird träumt davon, dass seine Technologie wieder in der Lage sein wird, mit Menschen zu sprechen, die aufgrund von Amyotropher Lateralsklerose oder Krebs ihre Stimme verloren haben. Und das eingangs erwähnte Video mit Pferden und Zebras war ein Nebenprodukt der Arbeit zur Verbesserung der Sicht unbemannter Fahrzeuge. Die Software für solche Maschinen wird zunächst in einer virtuellen Umgebung trainiert. Aber eine Welt wie Grand Theft Auto ähnelt der Realität sehr entfernt. Der Zebrification-Algorithmus wurde entwickelt, um die Lücke zwischen der virtuellen Umgebung und der realen Welt zu schließen und letztendlich unbemannte Fahrzeuge sicherer zu machen.