Neue Bildgebungssysteme, Mikroskope und Videomatrizen erzeugen digitale Bilder, die auf Computerberechnungen und nicht auf herkömmlichen Objektiven basieren.

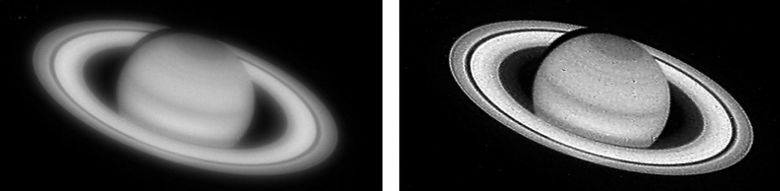

Sogar mittelalterliche Handwerker konnten Glaslinsen und gebogene Spiegel für die Projektion von Bildern herstellen. Solche Konstruktionen wurden verwendet, um Mikroskope, Lochkameras, Teleskope und andere Instrumente herzustellen, mit denen wir sehr kleine und große Objekte weit und nahe, auf der Erde und am Himmel besser sehen können. Die nächste Revolution in der Bilderzeugung fand um die Mitte des 19. Jahrhunderts statt: Die Fotografie wurde erfunden. Jetzt können Sie „angehaltene Momente“ erfassen, abspielen und replizieren. Heute steht die Ära der chemischen Fotografie kurz vor dem Abschluss, eine neue Ära blüht - die digitale Bildgebung. Seine Wurzeln liegen in der Fernsehtechnologie, aber wir werden den Beginn der Ära 1975 betrachten, als die erste Digitalkamera erschien. Heutzutage erfassen Milliarden von Webcams und Kameras in Mobiltelefonen weltweit mehr als eine Billion Bilder pro Jahr, und viele von ihnen werden sofort ins Internet hochgeladen. Trotz der explosionsartigen Zunahme von Anzahl, Vielfalt und Verwendungsmöglichkeiten von Bildgebungssystemen bleiben die Aufgaben der Optiker weitgehend unverändert: ein qualitativ hochwertiges optisches Bild zu erstellen, das die Szene genau wiedergibt, damit sie „gut aussieht“.

In den letzten 10 bis 20 Jahren hat sich jedoch ein neues Paradigma herausgebildet: die rechnergestützte Bildgebung. Dieses Paradigma ersetzt möglicherweise traditionelle Ansätze nicht vollständig, wird jedoch jahrhundertealte Ideen in Frage stellen und dazu beitragen, alternative Methoden für den Entwurf von Bildgebungssystemen zu entwickeln. Beispielsweise stehen uns bereits neue Funktionen und Formen von Bildgebungssystemen zur Verfügung, darunter Super-Miniaturgeräte zum Aufnehmen von makroskopischen Objekten und Mikroskopen ohne Linsen.

Wie der Name schon sagt, spielt das Rechnen eine Schlüsselrolle bei der Bildung des endgültigen digitalen Bildes. Lange Zeit haben sie sich mit Hilfe der digitalen Bildverarbeitung verbessert: Sie haben den Rote-Augen-Effekt beim Aufnehmen mit dem Blitz entfernt, die Farben angepasst usw., aber die optischen Schaltkreise der Objektive wurden nie unter Berücksichtigung dieser Anforderungen entworfen. Die digitale Signalverarbeitung ermöglicht es jedoch beispielsweise, optische Verzerrungen wie "Kissen" oder Weitwinkelverzerrungen an den Bildrändern zu korrigieren. Als das Hubble-Orbital-Teleskop Ende der 1980er Jahre die ersten Bilder zur Erde schickte, waren sie viel „seifiger“ als erwartet. Es wurde schnell klar, dass es einige Probleme mit der Optik gab. Die Wissenschaftler der NASA stellten fest, was los war, und bis zur Reparatur des Teleskops korrigierten sie viele Jahre lang viele Fehler mithilfe ausgefeilter digitaler Verarbeitungsalgorithmen.

Mitte der neunziger Jahre kamen Wade Thomas Cathey und Edward Dowski Jr. auf die Idee, Linsen zu entwerfen, um verschwommene, „verschlechterte“ Bilder zu erzeugen, die jedoch so verschlechtert sind, dass Digitale Verarbeitungsalgorithmen ermöglichten es, Bilder mit herkömmlichen Objektiven nicht schlechter oder sogar besser aufzunehmen. Insbesondere Katie und Dowsky wandten sich dem charakteristischen Merkmal aller herkömmlichen Kameras zu: der begrenzten Schärfentiefe. Wenn Sie sich auf ein Objekt in durchschnittlicher Entfernung von Ihnen konzentrieren, sieht es scharf aus, aber Objekte, die näher und weiter entfernt sind, verschwimmen. Die Schärfentiefe bezieht sich auf den Bereich, in dem alle Objekte einigermaßen scharf aussehen. So entwickelten zwei Wissenschaftler eine neue Linse, die die optischen Bilder von Objekten in allen Entfernungen fast genauso stark verwischte. Und dann schärfte ein spezieller Algorithmus das gesamte Bild und erzielte eine Schärfentiefe, die für gewöhnliche Objektive nicht erreichbar ist. Obwohl viele Wissenschaftler die beschriebene Technik weiter verbessert haben, hat die Idee von Katie und Dowsky die Disziplin der rechnergestützten Erfassung und Bilderzeugung weit vorangetrieben.

Eine weitere Konsequenz dieser wissenschaftlichen Arbeit war, dass jetzt optische Schaltungen für Linsen entwickelt werden, die auf der Erstellung von Bildern für Computer und nicht für Menschen basieren. Es ist paradox, dass in unserer Ära des Total Shooting nur sehr wenige Menschen echte optische Bilder sahen, die von Kameras erzeugt wurden. Die Zeiten sind lange vorbei, in denen der Fotograf, der sich zur Kamera beugte und sich mit einem dicken Umhang bedeckte, den Verschluss herauszog und vor dem Einlegen der Kassette mit dem Film auf dem Milchglas ein „Live“ -Bild sah, das direkt vom Objektiv erzeugt wurde. Heute sehen wir auf den Bildschirmen das Ergebnis der digitalen Verarbeitung von optischen Bildern, die auf Siliziummatrizen gefallen sind.

Der nächste Anwendungsbereich für die Kombination von Optik und digitaler Verarbeitung war die Vereinfachung des Linsendesigns. In Ihrem Smartphone kann ein Kameraobjektiv aus 7-8 optischen Elementen bestehen, und professionelle Kameraobjektive bestehen manchmal aus mehr als 15 optischen Elementen. Eine große Anzahl von Linsen ist erforderlich, um Bildfehler zu korrigieren - Aberrationen, die jedem optischen System eigen sind: chromatisch (Farbgeister um Objekte) und optisch (Verzerrung der Form und Proportionen von Objekten). Das heißt, komplexe Objektivdesigns sind erforderlich, um „gut aussehende“ Bilder zu erzeugen. Die Kombination aus Optik und digitaler Verarbeitung hilft dabei, einen Teil der Arbeit zur Korrektur von Aberrationen auf eine digitale Komponente zu verlagern, sodass Sie auf einige optische Elemente verzichten können, ohne die Qualität des endgültigen digitalen Bilds zu beeinträchtigen. Das heißt, Verarbeitungsalgorithmen spielen die Rolle virtueller optischer Elemente. Dieser Ansatz ermöglichte es, kompaktere und billigere optische Systeme ohne Qualitätsverlust zu schaffen.

Inwieweit werden diese Ideen entwickelt? Welcher Anteil der Bildgebungsaufgabe kann von der Optik auf eine digitale Komponente übertragen werden? Wie einfach kann eine optische Schaltung sein, um ein anständiges Bild zu erhalten? Ist es realistisch, Linsen und Spiegel loszuwerden? Dies wurde in den letzten Jahren auf drei Arten erreicht: Die Linsen und die optischen Bilder, die sie erzeugen, sind vollständig ausgeschlossen. Die Methoden basieren auf Beugung, optischer Phasenrekonstruktion und der Drucksensortechnik. Und um das endgültige Bild zu erhalten, das für Menschen geeignet ist, werden Computerberechnungen aktiv verwendet.

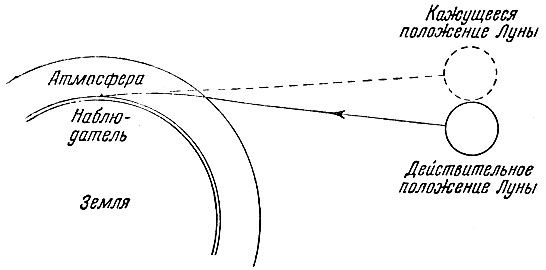

Herkömmliche Linsen fokussieren einen Lichtstrahl mithilfe der Brechung : Licht wird beim Durchgang durch eine Mediengrenze (Luftglas) mit unterschiedlichen Lichtgeschwindigkeiten gebrochen. Dank des Brechungseffekts scheint ein Bleistift, der mit Wasser in ein Glas getaucht ist, gekrümmt zu sein: Das vom Bleistift reflektierte Licht wird gebrochen, wenn es auf dem Weg zu Ihren Augen in die Luft gelangt. Daher ist der Unterwasserteil des Bleistifts, den wir sehen, nicht dort, wo er tatsächlich ist.

Übrigens scheinen dank der Brechung (Brechung) an der Grenze zwischen Weltraum und Erdatmosphäre alle Himmelsobjekte etwas höher zu liegen als ihr tatsächlicher Standort:

Gekrümmte Spiegel, wie sie in großen Teleskopen verwendet werden, erzeugen ein Bild anders: durch Reflexion . Um den Unterschied zwischen Brechung und Reflexion zu verstehen, stellen Sie sich Licht in Form von Strahlen (Linien) vor.

Zwei weitere physikalische Phänomene helfen dabei, die Ausbreitungsrichtung des Lichts zu ändern und seine Wellennatur zu nutzen (denken Sie an die Welle-Teilchen-Dualität ): Beugung und Interferenz . Wenn sich zwei kohärente Lichtwellen treffen, überlappen sie sich, die resultierende Wellenamplitude erscheint. Wenn das Maximum einer Welle immer mit dem Maximum der anderen übereinstimmt, verstärken sich die Wellen gegenseitig, was als konstruktive Interferenz bezeichnet wird . Wenn das Maximum einer Welle immer mit dem Minimum der anderen übereinstimmt, heben sich die Wellen gegenseitig auf - dies ist eine destruktive Interferenz , wodurch das Licht vollständig verschwinden kann.

Sie können das Licht durch Beugung steuern, indem Sie es auf einer glatten Oberfläche auf das Beugungsgitter richten - eine Reihe feinster Striche (Raster). Da Wellen unterschiedlicher Länge in unterschiedliche Richtungen reflektiert werden, tritt eine Farbfärbung auf. Wenn beispielsweise weißes Licht von winzigen Rillen auf der Oberfläche einer CD oder DVD reflektiert wird, sehen wir Regenbogenstreifen. Aufgrund der Abhängigkeit der Wellenlängen vom Raster ist es unmöglich, ein Beugungsgitter zu erzeugen, das die Linsen einfach ersetzt. Ein optisches Bild, das von einem Gitter erzeugt wird, sieht niemals so gut aus wie ein Bild von einer gut gestalteten Linse. Trotzdem ist es durchaus möglich, akzeptable digitale Bilder mit einer Kombination aus Beugungsoptik (unter Verwendung von Beugung) und angepasster Signalverarbeitung (unter Berücksichtigung der Optik) zu erstellen.

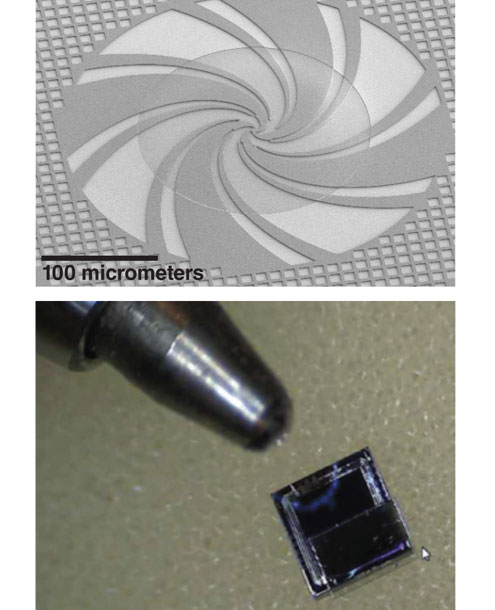

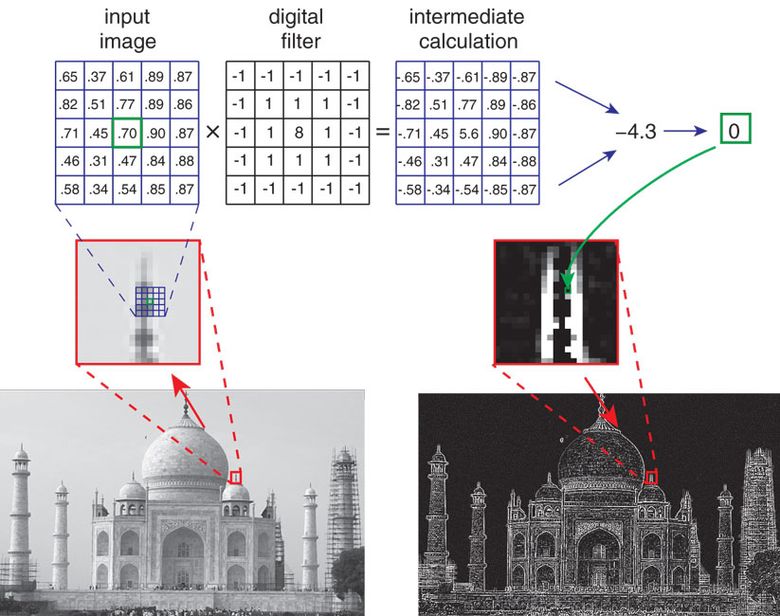

In einer der Klassen von nicht objektiven Vorrichtungen für makroskopische Aufnahmen werden Miniaturbeugungsgitter verwendet, die sich schrittweise in der Dicke eines transparenten Materials (Glas oder Silikat) befinden und einen Teil des einfallenden Lichts relativ zum anderen Teil verzögern. Die mathematischen Eigenschaften des Stufenschemas sind derart, dass die Lichtverteilung im Material schwach von der Wellenlänge und daher von einer geringfügigen Variation der Dicke des Glases selbst abhängt, die unvermeidlich während der Herstellung auftritt. Gitter sind an einem lichtempfindlichen Sensor angebracht - wie die Matrix bei herkömmlichen Digitalkameras. Das einfallende Licht passiert die Gitter und erreicht das Array, das bereits speziell in „Komponenten“ zerlegt wurde. Es sieht überhaupt nicht wie ein gewöhnliches Bild aus: eine Art verschwommene Wolke, die für das menschliche Auge unverständlich ist. Diese Wolke enthält jedoch genügend visuelle Informationen (wenn auch ungewöhnlich verteilt), um das gewünschte Bild mithilfe eines als Bildfaltung bezeichneten Rechenprozesses daraus wiederherzustellen.

Der Bildrekonstruktionsalgorithmus ist leicht empfindlich gegenüber visuellem Rauschen, beispielsweise zufälligen Schwankungen der Anzahl der Photonen oder elektrischem Rauschen während der Umwandlung des Signals vom Sensor in eine numerische Darstellung (der sogenannte Quantisierungsfehler). Daher kann das Bild visuell verrauscht sein. Obwohl diese Qualität für eine Reihe einfacher Aufgaben ausreicht (z. B. um die Anzahl der Personen in einem Frame zu zählen), müssen Sie für ein anständigeres Bild mehr Informationen über die aufgenommene Szene erfassen. Die Lösung "in der Stirn" besteht darin, mehrere Miniatur-Phasengitter zu verwenden, um verschiedene Informationen über die Szene zu erfassen. Das heißt, jedes Gitter bildet ein digitales Komponentenbild, diese Komponenten können dann verarbeitet werden und ein besseres Bild kann erhalten werden.

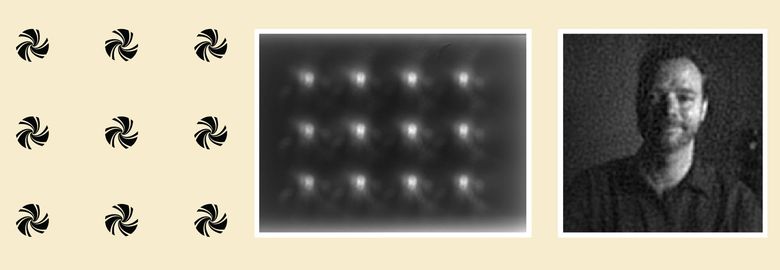

Eine Art von linsenlosem Bildgebungssystem verwendet Arrays, die Licht streuen, anstatt es wie Linsen zu fokussieren. Im obigen Beispiel ist ein Array von 12 Binärphasen-Mikronetzen (links) entworfen, um so viele visuelle Informationen wie möglich über die Szene zu erfassen. Nachdem das Licht durch das Array gelangt ist, werden 12 verschwommene Punkte erhalten, von denen keiner eine Person verstehen lässt, was hier (in der Mitte) gefilmt wird. Dieses optische Bild enthält jedoch genügend Informationen, um mithilfe der digitalen Verarbeitung, die als „Bildfaltung“ bezeichnet wird, ein vollständig lesbares Porträt (rechts) zu erhalten.

Dieser Ansatz hilft nicht nur, ein Bild der Szene zu erstellen, sondern es auch zu analysieren: um die visuellen Eigenschaften (z. B. ob das Foto ein menschliches Gesicht enthält), die Richtung und Geschwindigkeit der Gesamtbewegung der Szene ( visueller Fluss , visueller Fluss) zu bestimmen und die Anzahl der Personen zu berechnen drinnen. In solchen Situationen werden Beugungsgitter entworfen, um die erforderlichen Informationen zu extrahieren, und der Verarbeitungsalgorithmus wird an eine bestimmte Aufgabe angepasst. Wenn wir beispielsweise einen vertikalen Barcode lesen müssen, verwenden wir ein vertikales Beugungsgitter und einen Algorithmus, der jedes Pixel eines digitalen Bildes auf einen Schwellenwert bringt: Licht wird in dunkel, dunkel in schwarz umgewandelt. Das Ergebnis ist ein digitales Schwarzweißbild, das bereits vom Barcode-Lesealgorithmus erkannt werden kann.

Phasenrekonstruktionsmikroskopie

Der Ansatz zur Erzeugung vorgespannter Mikroskope unterscheidet sich von den Methoden zur Erzeugung von Computerkameras für Makroobjekte, obwohl das Beugungsphänomen auch hier verwendet wird. Im Gegensatz zu einem Gerät, das eine Szene bei normaler Beleuchtung durch Sonne oder Lampen aufnimmt, kann jedoch nur kohärente Laserstrahlung oder monochromatisches Licht von einer oder mehreren Quellen für die Beleuchtung in der Mikroskopie ausgewählt werden. Auf diese Weise können Sie die Beugung und Interferenz von Licht steuern. Darüber hinaus sind die für uns interessanten Objekte so klein, dass eine Beugung auftritt, wenn Licht durch die Objekte selbst und nicht durch ein künstliches Beugungsgitter fällt.

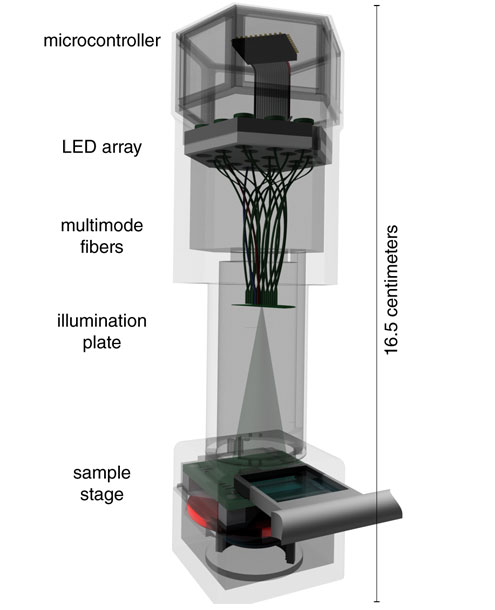

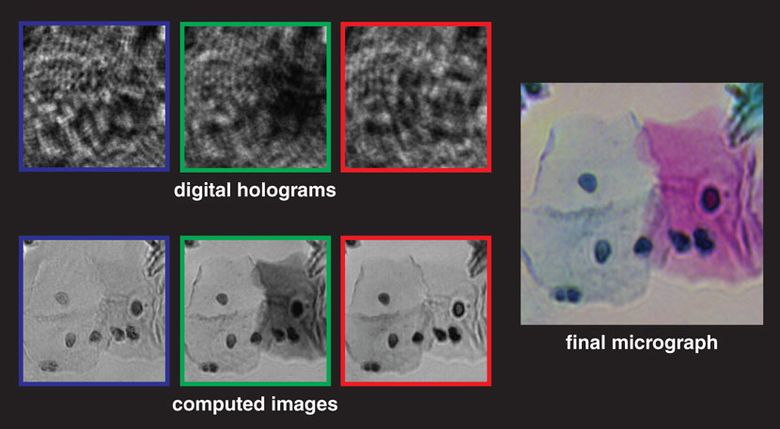

Das Schema eines solchen Mikroskops impliziert, dass die Probe auf einer lichtempfindlichen Matrix mit einer großen Anzahl kleiner Pixel platziert wird: beispielsweise einer 10-Megapixel-Matrix, die häufig in Digitalkameras zu finden ist. Dieses Schema wird auch als "On-Chip-Mikroskop" bezeichnet, da die Probe direkt auf der Bilderzeugungsmatrix platziert wird. Licht von einem Laser oder einer spektral reinen Farb-LED fällt auf die Probe und wird auf die aufgenommenen Objekte gestreut. Die resultierenden Beugungswellen - die den Objektstrahl (Objektstrahl) bilden - werden der Beleuchtung überlagert, die ohne Verzerrung durch die Probe geht - dem Referenzstrahl (Referenzstrahl). Das Ergebnis ist ein komplexes Interferenzmuster, das von einer lichtempfindlichen Matrix aufgezeichnet und in der digitalen Inline-Holographie verwendet wird. Das Rohbild ähnelt vage den mikroskopischen Schatten der Probe, und in einigen Fällen reicht es aus, die Anzahl und Position von Objekten grob zu berechnen. Das rohe holographische Bild ist jedoch zu schlammig, verrauscht, enthält "Ringartefakte" und erlaubt keine Bestimmung der Morphologie von Objekten. Das Bild ist schlecht.

Das Interferenzmuster durchläuft mehrere Stufen der digitalen Verarbeitung, die Hauptstufe ist der Phasenrekonstruktionsalgorithmus. Darin werden unter Verwendung der Physik der optischen Interferenz Schlussfolgerungen über die Struktur und Position von Objekten in der Probe gezogen. Kurz gesagt: Der Algorithmus sucht nach optischen Informationen über die im Hologramm verlorene Phase in der Matrix (die nur das Interferenzmuster und nicht die Phasen einzelner Lichtstrahlen selbst registriert). Der Algorithmus berechnet iterativ Phaseninformationen im Objektstrahl, was höchstwahrscheinlich zum Auftreten eines solchen optischen Interferenzmusters führte. Wenn Informationen über die Phase im Objektstrahl bestimmt werden, berechnet der Algorithmus seine zeitliche Änderung, um ein Bild der Objekte zu erstellen und das endgültige digitale Bild zu erzeugen.

Wie bei Makrogeräten wird die Auflösung durch die Aufnahme mehrerer optischer Bilder erhöht, von denen jedes leicht unterschiedliche Informationen enthält. Vor dem Registrieren jedes Frames können Sie beispielsweise die Lichtquelle, die Probe selbst oder die Matrix leicht verschieben. Dann werden die Rahmen verarbeitet und kombiniert, um ein Interferenzbild mit erhöhter Auflösung zu erhalten (das für den Menschen immer noch unverständlich ist), und dann werden die Phasen der Phasenwiederherstellung und der vorübergehenden Wiederherstellung durchgeführt.

Objektive Mikroskope auf einem Chip haben mehrere Vorteile.

Erstens kann der Aufnahmebereich der Probe (d. H. Das Sichtfeld) extrem groß sein, er ist nur durch die Größe der lichtempfindlichen Matrix begrenzt, auf der die Probe platziert ist. Mit modernen Matrizen können Sie ein Sichtfeld von 20 bis 20 Quadratzentimetern bereitstellen.

Zweitens können sogar transparente Objekte (zum Beispiel die meisten Bakterien in einer Wasserschicht) mit Objektivmikroskopen untersucht werden, wenn sie die Phase des durch sie hindurchtretenden Lichts ändern. Spezielle optische Objektivmikroskope ermöglichen auch die Untersuchung solcher "Phasenobjekte", wenn auch mit einem viel kleineren Sichtfeld und der Gesamtgröße der Probe.

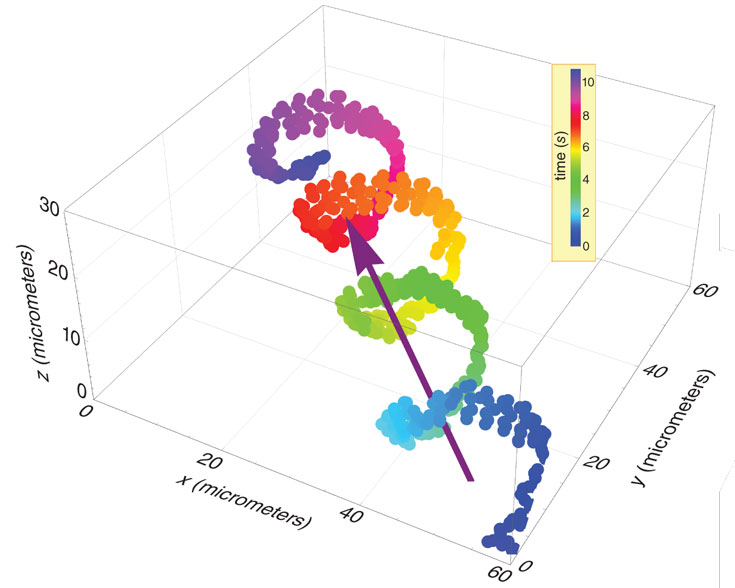

Drittens ermöglicht die digitale Verarbeitung des optischen Bildes, verschiedene Zelltypen (z. B. Spermien oder Blutzellen in den Kapillaren) zu isolieren und ihre Bewegungen zu verfolgen. Dank dessen können Ärzte und Biologen wichtige Daten erhalten.

Viertens sind solche Mikroskope viel billiger und kompakter als herkömmliche. Objektive Mikroskope können an ein Mobiltelefon angeschlossen werden, das in ländlichen Gebieten verwendet wird, und digitale Daten können zur weiteren gründlichen Analyse überall übertragen werden.

Drucksensortechnik

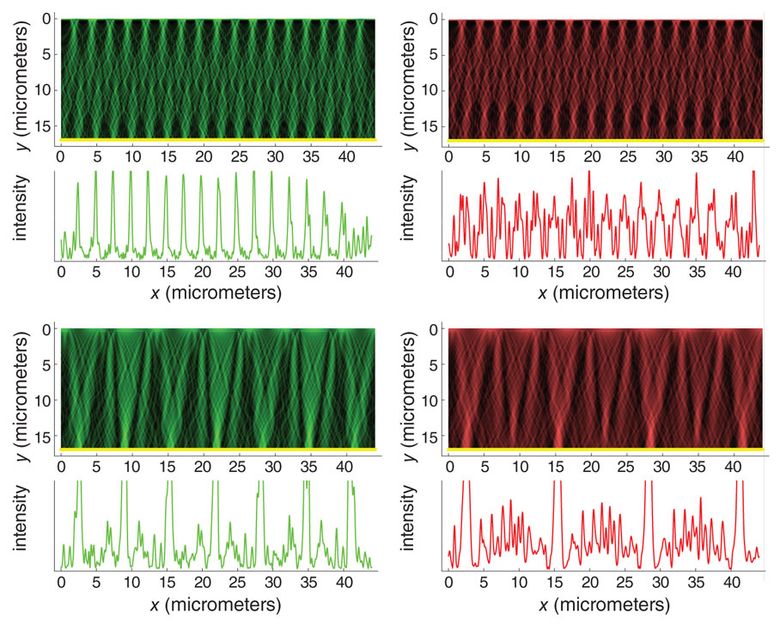

Der dritte Ansatz zur voreingenommenen Bilderzeugung basiert auf den neuesten Fortschritten in der Mathematik und Signalstatistik - der Kompressionserfassungstechnik . Ein optisches Bild auf einer Matrix ist ein komplexes Signal, das in Form einer Zahlenliste dargestellt und von verschiedenen Algorithmen verarbeitet wird. Da ein komplexes Tonsignal aus vielen einfacheren Tönen besteht, von denen jeder im richtigen Verhältnis hinzugefügt wird, wird das Bild aus einer großen Anzahl einfacherer Bilder gebildet. Eine Reihe einfacher Bilder oder Signale wird als Basis bezeichnet . Im Bereich des Klangs ist die häufigste Basis eine Reihe von reinen Cosinustönen. Es spielt keine Rolle, wie kompliziert der Sound ist. Von einer Autohupe bis zu einer Beethoven-Symphonie kann alles durch Hinzufügen einer großen Anzahl von Kosinus-Grundwellen erzeugt werden, für die jeweils die erforderliche Intensität und Zeitverschiebung ausgewählt werden.

Was könnte eine ähnliche Grundlage im Bereich der Bilder sein? Die zwei beliebtesten und nützlichsten visuellen Grundlagen sind Sätze zweidimensionaler Kosinuswellen und Wavelet-Muster mit mehreren Auflösungen. Diese Grundelemente sind mathematisch elegant und bilden die Grundlage für moderne JPEG- und JPEG 2000-Bildkomprimierungsschemata. Anstatt die Werte jedes Pixels in einem digitalen Bild zu speichern und zu übertragen, bearbeiten Sie eine Datei, die die Amplituden verschiedener Komponentenbasissignale beschreibt. Infolgedessen ist die "komprimierte" Datei viel kleiner als das Bild selbst. Diese Basen dienten jahrzehntelang treu als Werkzeug für die Verarbeitung digitaler Bilder, führten jedoch nicht zur Schaffung neuer Methoden für die Entwicklung optischer Schaltungen. Daher macht es kein optisches Element einfach, Basen einzuführen.

Fahren wir mit der Druckmessung fort. Theoretisch zeigen die Statistiken, dass, während die Informationen über die Szene redundant sind (d. H. Das Bild komprimiert werden kann), es nicht erforderlich ist, die Basen zu messen, Messungen einer Zufallsstichprobe ausreichend sind. « », , ( ), compressive sensing. , , .

, (), . . «» , , (). , .

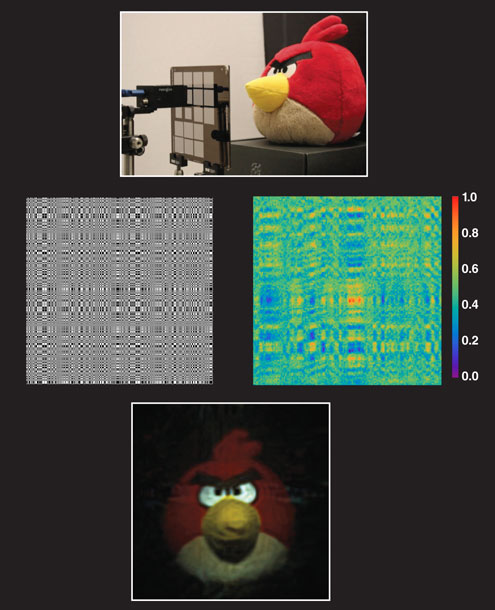

, -. (coded apertures) ( - ) . FlatCam (Ashok Veeraraghavan) . , (. ). — Angry Birds — ( ) . , , , . , . , . compressive sensing «» , .

.

, . , , , . 0,5 0,2 — , . FlatCam , , .

, , , , . , - , . , , .

. , , , , , , . , , , . , , , .

, . , - .