Sundar Pichai kam gestern um 20 Uhr Moskauer Zeit zum Shoreline Amphitheatre in Mountain View und eröffnete Google I / O 2018. Die Konferenz wird drei Tage vom 8. bis 10. Mai dauern, aber die Hauptsache wurde während einer traditionellen Grundsatzrede von der Bühne angekündigt. Android P lernte Gesten wie in iOS 11 auf dem iPhone X, Google Assistant spricht jetzt mit sechs verschiedenen Stimmen und besteht fast den Turing-Test. Entwickler erhalten das ML-Kit, um maschinelles Lernen in ihren Anwendungen zu implementieren.

Google-Assistent

Assistent ist das Highlight des Programms. In den zwei Jahren seit der Ankündigung entschied er sich für 500 Millionen verschiedene Geräte. Dies sind neben Smartphones auch intelligente Lautsprecher, Kopfhörer, Fernseher und Uhren. Es ist in Autos von 40 verschiedenen Herstellern integriert und unterstützt die Arbeit mit über 5000 Haushaltsgeräten wie Geschirrspülern und Anrufen.

Jetzt wurde ihm beigebracht, mit sechs verschiedenen Stimmen zu sprechen und mehrere Befehle in einer Phrase gleichzeitig zu verstehen. Bis Ende des Jahres wird Google Assistant in 80 Ländern arbeiten und 30 Sprachen unterstützen, darunter Russisch. Und ja, Sie müssen nicht mehr ständig "OK Google" sagen. Das heißt, Sie können sagen: "Ok, Google, stellen Sie um 7 Uhr morgens einen Alarm ein und erinnern Sie mich daran, Joghurt zu kaufen, wenn ich in der Nähe des Supermarkts bin."

Zuvor erwarteten wir vom Assistenten hauptsächlich eine verbale Antwort, beispielsweise von einem intelligenten Sprecher. Bei dieser E / A zeigte Google jedoch mehrere Geräte aus der Kategorie der intelligenten Displays an - dies ist im Wesentlichen eine intelligente Spalte, nur mit einem Touchscreen. Eine solche Spalte mit einem Bildschirm kann "OK Google, schalte Jimmy Kimmel ein" sagen, und sie wird seine Show auf YouTube finden und sie starten. Laut Google ist es auf demselben Gerät bequem, nach Rezepten zu suchen. Wie sich die sogenannten "Smart Displays" grundlegend von herkömmlichen Tablets unterscheiden, ist noch nicht ganz klar.

In den USA wurde Google Assistant auch das Arbeiten im Rahmen des Abhol- und Zustellungsschemas beigebracht und an beliebte Netzwerke gebunden: Starbucks, 7-Eleven, Dunkin 'Donuts und andere. In den USA können Sie jetzt mit dem Assistenten sprechen und einen Latte mit Karamell bestellen, um ihn in einem praktischen Café abzuholen.

Alles, was Sie dem Assistenten sagen, wird er sich merken und nach und nach Tipps geben und ein Bild des kommenden Tages erstellen, wie es Google Now getan hat, nur genauer. Alle diese Chips werden im Sommer 2018 in der neuen Version von Android erscheinen.

Google Duplex

Auf Google I / O enthüllte Sundar, wie das Unternehmen Google Duplex nennt. Alle Erfolge der letzten Jahre wurden kombiniert, und dies hat es dem Assistenten ermöglicht, erfolgreich ein Telefongespräch mit einer ahnungslosen Person zu führen. Zumindest sagten sie das von der Bühne. Wenn all diese "äh ...", "hmm" und andere rein menschliche Sprachnuancen das neuronale Netzwerk wirklich auslösten, dann sind wir kurz davor, dass der Computer den Turing-Test besteht. Überzeugen Sie sich selbst:

Sie bitten den Assistenten, einen Tisch für Sie im Restaurant zu reservieren, und er ruft dort im Hintergrund an und stimmt in allem überein. Stimme Es bleibt zu warten, bis auch ein virtueller Assistent am anderen Ende des Kabels gepflanzt ist.

Einige Wochen später plant Google ein vollwertiges Experiment mit kleinen Unternehmen. Assistenten planen, "anzurufen", damit er Kundenanrufe beantwortet.

Android P.

Die Beta-Version von Android P erscheint am 8. Mai und ist auf 11 Smartphones verfügbar:

- Sony Xperia XZ2

- Xiaomi Mi Mix 2S

- Nokia 7 Plus

- Oppo r15 pro

- Vivo x21

- OnePlus 6

- Essentielles PH-1

- Google Pixel / XL

- Google Pixel 2/2 XL

Die neue Version des Betriebssystems hat den Ansatz für Navigation und Gesten überarbeitet. Insbesondere haben sie auf die gleiche Weise wie beim iPhone X einen Aufruf der Liste der offenen Anwendungen implementiert - mit einem Wisch von unten nach oben. Die Schaltfläche zum Aufrufen von Anwendungen aus dem Hintergrund wurde vollständig verlassen, und die Schaltfläche Zurück wird nur angezeigt, wenn eine Anwendung geöffnet ist. Darüber hinaus wird das Design einiger Schnittstellenelemente gemäß Material Design 2 aktualisiert.

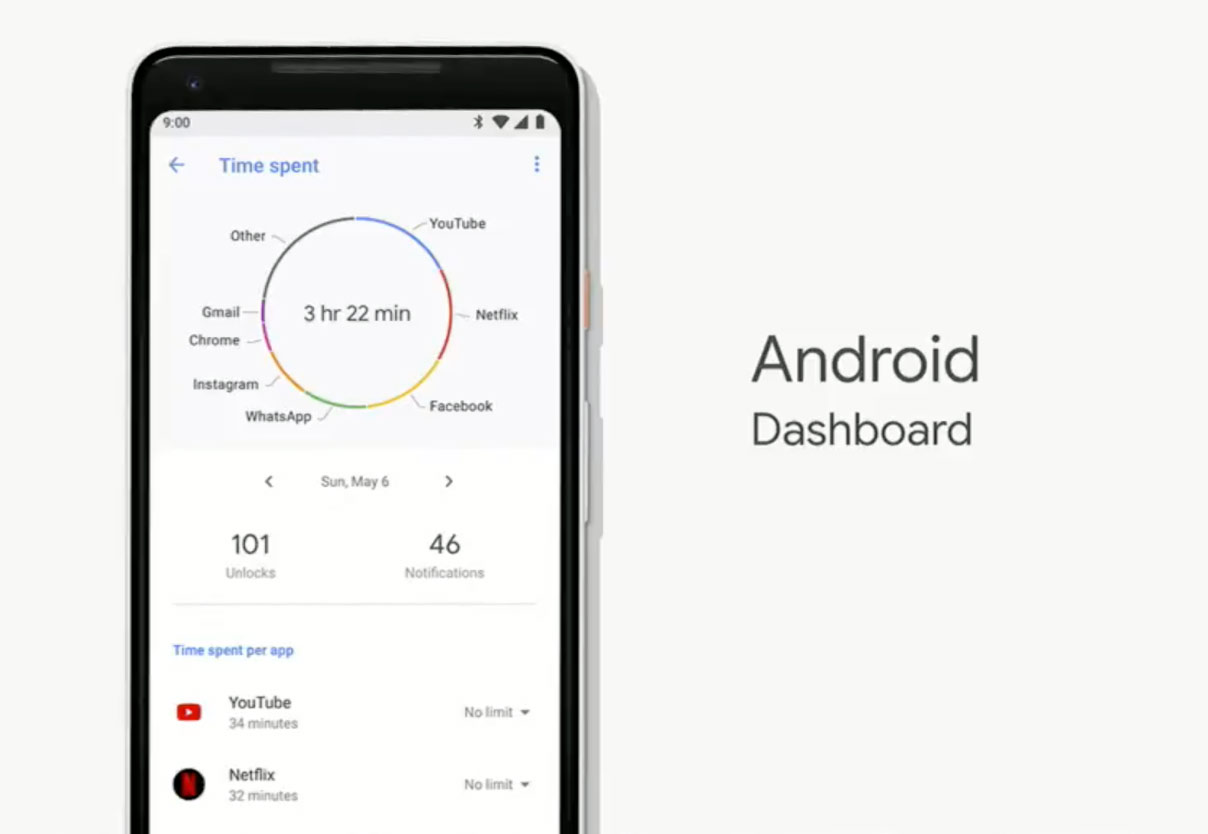

Pichai sprach separat über mehrere neue Funktionen. In Android P wurde beispielsweise "Dashboard" angezeigt, in dem Statistiken zur Smartphone-Nutzung angezeigt werden: Wie oft Sie es an einem Tag entsperrt haben, wie viele Benachrichtigungen Sie gelesen haben.

In den Einstellungen der YouTube-Anwendung für Android kannst du einen Modus auswählen, in dem von Zeit zu Zeit eine Erinnerung angezeigt wird, dass es Zeit ist, eine Pause einzulegen, wenn du ein Video längere Zeit ununterbrochen angesehen hast. Außerdem können Benachrichtigungen über neue Videos von den Kanälen, die Sie abonniert haben, jetzt als tägliche Zusammenfassung und nicht einzeln empfangen werden.

Family Link - ein Bedienfeld für die Geräte Ihrer Kinder, mit dem Sie die Zeit vor dem Bildschirm begrenzen können.

Google News

In Google I / O sprach Sundar Pichai über die Wiedergeburt von Google News. Jetzt ähnelt "News" Yandex.Zen - es ist ein intelligenter Nachrichtenaggregator, der weiß, was Sie normalerweise lesen und welchen Ressourcen Sie vertrauen. Es filtert das Unnötige heraus und zeigt fünf wichtige Geschichten in den letzten Stunden auf der Registerkarte „Für Sie“ an.

Maschinelles Lernen

Durch maschinelles Lernen können neue Android-Geräte erheblich Batteriestrom sparen, indem sie vorhersagen, welche Anwendung Sie als Nächstes mit einer Wahrscheinlichkeit von etwa 60% starten werden.

Aber die Hauptsache - jetzt steht allen Entwicklern dank des Machine Learning Kit die API für den Zugriff auf Smartphone-Funktionen wie die Erkennung von Text und Gesichtern in Fotos oder beispielsweise das Scannen von Barcodes zur Verfügung. Darüber hinaus sagten sie von Anfang an, dass Entwickler Zugriff auf die neuronalen Cloud-Netzwerke von Google haben werden, gaben jedoch keine Details an.