Die Hysterie um die Zukunft der künstlichen Intelligenz (KI) hat die Welt erobert. Es gibt keinen Mangel an sensationellen Nachrichten darüber, wie KI

Krankheiten heilen ,

Innovationen beschleunigen und

die Kreativität einer Person

verbessern kann . Wenn Sie die Schlagzeilen der Medien lesen, können Sie entscheiden, dass Sie bereits in einer Zukunft leben, in der die KI alle Aspekte der Gesellschaft durchdrungen hat.

Obwohl nicht zu leugnen ist, dass die KI

uns eine

Reihe vielversprechender Möglichkeiten eröffnet hat , hat dies auch zur Entstehung des Denkens geführt, das als Glaube an die Allmacht der KI bezeichnet werden kann. Nach dieser Philosophie können Algorithmen

für maschinelles Lernen

alle Probleme der Menschheit lösen , wenn genügend Daten vorhanden sind.

Aber diese Idee hat ein großes Problem. Es unterstützt nicht den Fortschritt der KI, sondern gefährdet den Wert der Maschinenintelligenz, vernachlässigt wichtige Sicherheitsprinzipien und bereitet die Menschen auf unrealistische Erwartungen an die KI-Fähigkeiten vor.

Der Glaube an die Allmacht der KI

In nur wenigen Jahren gelangte der Glaube an die Allmacht der KI von den Gesprächen der Technologie-Evangelisten des Silicon Valley in die Köpfe von Regierungsvertretern und Gesetzgebern auf der ganzen Welt. Das Pendel schwang vom anti-utopischen Konzept der

KI, die die Menschheit zerstört , zum utopischen Glauben an das

Kommen unseres algorithmischen Retters .

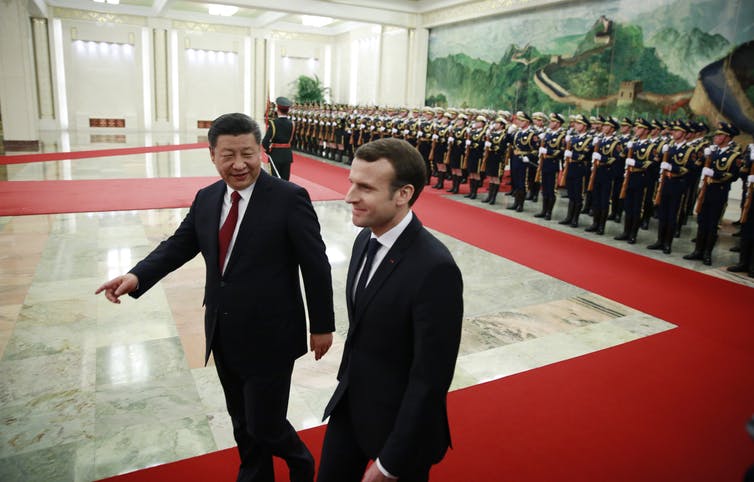

Wir sehen bereits, wie Regierungen nationale KI-Entwicklungsprogramme unterstützen und im technologischen und rhetorischen

Wettrüsten konkurrieren, um einen Vorsprung im boomenden Sektor des maschinellen Lernens (MO) zu erlangen. Zum Beispiel hat die britische Regierung

versprochen, 300 Millionen Pfund in KI-Forschung zu

investieren , um auf diesem Gebiet führend zu werden. Der französische Präsident

Emmanuel Macron war fasziniert vom transformativen Potenzial der KI und beschloss,

Frankreich zu einem internationalen KI-Zentrum zu machen . Die chinesische Regierung erweitert ihre KI-Fähigkeiten mit einem

Regierungsplan zur Schaffung einer chinesischen KI-Industrie im Wert von 150 Milliarden US-Dollar bis 2030. Der Glaube an die Allmacht der KI gewinnt an Dynamik und wird nicht aufgeben.

Neuronale Netze - leichter gesagt als getan

Während viele politische Aussagen die transformativen Auswirkungen der bevorstehenden „

KI-Revolution “

anpreisen, unterschätzen sie normalerweise die Komplexität der Einführung fortschrittlicher MO-Systeme in der realen Welt.

Eine der vielversprechendsten Varianten der KI-Technologie sind

neuronale Netze . Diese Form des maschinellen Lernens basiert auf einer beispielhaften Nachahmung der neuronalen Struktur des menschlichen Gehirns, jedoch in viel kleinerem Maßstab. Viele AI-basierte Produkte verwenden neuronale Netze, um Muster und Regeln aus großen Datenmengen zu extrahieren. Viele Politiker verstehen jedoch nicht, dass wir durch einfaches Hinzufügen eines neuronalen Netzwerks zum Problem nicht unbedingt sofort eine Lösung finden. Wenn wir der Demokratie ein neuronales Netzwerk hinzufügen, werden wir sie nicht sofort weniger diskriminiert, ehrlicher oder persönlicher machen.

Herausfordernde Datenbürokratie

KI-Systeme erfordern eine große Datenmenge, aber im öffentlichen Sektor gibt es normalerweise keine

geeignete Dateninfrastruktur zur Unterstützung fortschrittlicher MO-Systeme. Die meisten Daten werden in Offline-Archiven gespeichert. Eine kleine Anzahl vorhandener digitalisierter Datenquellen ertrinkt in der Bürokratie. Die Daten werden meistens auf verschiedene Regierungsabteilungen verteilt, für die jeweils eine spezielle Zugriffsberechtigung erforderlich ist. Unter anderem verfügt der öffentliche Sektor normalerweise nicht über genügend Talente, die über die erforderlichen technischen Fähigkeiten verfügen, um die

Vorteile der KI voll auszuschöpfen.

Aus diesen Gründen wird der AI-bezogene

Sensationalismus vielfach kritisiert. Stuart Russell, Professor für Informatik in Berkeley, befürwortet seit langem einen realistischeren Ansatz, der sich auf die

einfachsten, alltäglichen Anwendungen der KI konzentriert, anstatt auf die hypothetische Übernahme der Welt durch superintelligente Roboter. In ähnlicher Weise

schreibt Rodney Brooks , Professor für Robotik am MIT, dass "fast alle Innovationen in Robotik und KI viel, viel mehr Zeit für eine echte Implementierung benötigen, als dies sowohl von Fachleuten auf diesem Gebiet als auch von allen anderen angenommen wird."

Eine der vielen Herausforderungen bei der Bereitstellung von MO-Systemen besteht darin, dass KI extrem

anfällig für Angriffe ist . Dies bedeutet, dass eine böswillige KI eine andere KI angreifen kann, um sie zu zwingen, falsche Vorhersagen zu treffen oder auf eine bestimmte Weise zu handeln. Viele

Forscher haben gewarnt, dass es unmöglich ist, KI sofort einzuführen, ohne geeignete

Sicherheitsstandards und Schutzmechanismen vorzubereiten. Bisher wurde das Thema KI-Sicherheit jedoch nicht gebührend berücksichtigt.

Maschinelles Lernen ist keine Magie

Wenn wir die Vorteile der KI nutzen und potenzielle Risiken minimieren möchten, müssen wir darüber nachdenken, wie wir IOs in bestimmten Bereichen von Regierung, Wirtschaft und Gesellschaft sinnvoll anwenden können. Und das bedeutet, dass wir anfangen müssen, die

Ethik der KI und das

Misstrauen vieler Menschen in MO zu diskutieren.

Vor allem müssen wir die Grenzen der KI und die Punkte verstehen, an denen die Menschen noch die Kontrolle übernehmen müssen. Anstatt ein unrealistisches Bild der KI-Fähigkeiten zu zeichnen, müssen Sie einen Schritt zurücktreten und

die realen technologischen Fähigkeiten der KI von der Magie

trennen .

Facebook war lange Zeit der

Ansicht, dass Probleme wie die Verbreitung von Desinformation und die Anstiftung zum Hass algorithmisch erkannt und gestoppt werden könnten. Unter dem Druck des Gesetzgebers versprach das Unternehmen jedoch schnell, seine Algorithmen durch eine

Armee von 10.000 menschlichen Gutachtern zu ersetzen.

In der Medizin erkennen sie auch, dass KI nicht als Lösung für alle Probleme angesehen werden kann. Das

IBM Watson for Oncology- Programm war eine KI, die Ärzten bei der Krebsbekämpfung helfen sollte. Und obwohl es so konzipiert wurde, dass es die besten Empfehlungen gibt, fällt es Experten

schwer, der Maschine zu vertrauen . Infolgedessen wurde das Programm in den meisten Krankenhäusern

geschlossen, in denen die Probeläufe stattfanden.

Ähnliche Probleme treten im Bereich der Gesetzgebung auf, wenn

Algorithmen in US-Gerichten verwendet wurden , um Sätze auszusprechen. Algorithmen berechneten Risikowerte und gaben den Richtern

Empfehlungen zu Sätzen. Es stellte sich jedoch heraus, dass das System die strukturelle Rassendiskriminierung verstärkt und danach aufgegeben wurde.

Diese Beispiele zeigen, dass es für alles keine AI-basierten Lösungen gibt. Die Verwendung von KI für die KI selbst ist nicht immer produktiv oder nützlich. Nicht jedes Problem lässt sich am besten mit Machine Intelligence lösen. Dies ist die wichtigste Lektion für alle, die ihre Investitionen in staatliche KI-Entwicklungsprogramme erhöhen möchten: Alle Entscheidungen haben einen Preis, und nicht alles, was automatisiert werden kann, muss automatisiert werden.