Ende Juli veranstaltete Google in seinem Moskauer Büro (gegenüber dem Kreml) einen geschlossenen Hackathon. Das Thema war die Entwicklung von

Aktionen für einen Sprachassistenten . Wir (

Just AI ) und ein Dutzend weitere Teams nahmen an dieser Veranstaltung teil und nahmen nicht nur rote Rucksäcke mit Google Nishtyaks heraus, sondern auch viele nützliche Kenntnisse zum Erstellen hochwertiger Sprachschnittstellen.

Während einiger Hackathon-Tage versuchten alle, eine Sprachanwendung für einen Assistenten zu entwickeln, und jemand veröffentlichte sogar seine Werke im Google Actions-Verzeichnis. Am Beispiel

unserer Anwendung werden wir darüber sprechen, wie Sie die perfekte Aktion und die einfache Google-Moderation erstellen.

Was sind Aktionen bei Google?

Google Assistant kann nicht nur Standard-Sprachbefehle ausführen. Sie können für ihn eigene Add-Ons erstellen, die dem Assistenten Funktionen hinzufügen. Google nennt diese Add-Ons Aktionen. Und auf Russisch bedeutet dies eine „Anwendung“. Weitere Informationen zu Aktionen bei Google finden Sie

hier .

Warum erstellen Sie Ihre eigene Aktion?

Wenn Sie eine Art mobile Anwendung erstellen oder eine Website haben, die Ihren Kunden einige nützliche Dienste bietet, ist Google Assistant ein weiterer cooler Kanal für die Interaktion mit Ihrem Kunden. Immerhin ist der Sprachassistent auf mehr als 500 Millionen Geräten installiert! Und das sind nicht nur Smartphones, sondern auch intelligente Lautsprecher, Autos, Uhren, Fernseher. Wenn Sie Ihre Website oder Anwendung mit einem Sprachassistenten ergänzen, werden Sie höchstwahrscheinlich neue Kunden und Benutzer finden, da diese auf allen diesen Geräten bereits mit dem Assistenten sprechen. Und sie erzählen Ihren Freunden und Bekannten eher von Ihrem Service.

Wie man Action richtig macht

Denken Sie jedoch nicht, dass die Anwendung für den Sprachassistenten mit der Site identisch ist. Dies ist eine grundlegend andere Benutzererfahrung (UX), für die bereits eigene

Richtlinien gelten . Der Benutzer spricht mit dem Assistenten, daher muss Ihre Assistentenanwendung den Benutzer in einer natürlichen Sprache sprechen.

Beim Hackathon haben wir unseren eigenen

Aimylogic Conversational Interface Designer verwendet , auf dem wir

unsere erste Anwendung für Google Assistant implementiert haben. Und an seinem Beispiel werden wir jetzt über die wertvollsten Lektionen sprechen, die wir in dieser Zeit gelernt haben.

So sieht unsere fertige Aktion im Aimylogic-Konstruktor aus.

So sieht unsere fertige Aktion im Aimylogic-Konstruktor aus.Lektion Nummer 1. Aktion ist Stimme

Der Assistent ist eine Sprachschnittstelle. Benutzer sprechen mit einem Assistenten, wenn es bequemer ist, dies zu sagen, als eine Anwendung oder Site zu öffnen.

Es ist unbedingt erforderlich, klar zu verstehen, warum diese oder jene Funktion Ihres Dienstes für den Benutzer über die Sprachschnittstelle nützlich sein kann.

Stimme ist, wenn Sie schnell und manchmal ohne auf den Bildschirm schauen müssen. Die Stimme ist, wenn sowohl die Frage als auch die Antwort beim ersten Mal kurz und klar sind. Und wenn der Benutzer dafür nicht fünf Klicks machen muss, wird er diese Gelegenheit sicherlich nutzen.

In unserer Anwendung „Yoga für die Augen“ gibt es eine solche Funktion. Dies sind eigentlich Übungen zum Sehen. Der Benutzer sollte während des Unterrichts nicht vom Bildschirm abgelenkt werden. Deshalb verwenden wir die Sprachschnittstelle.Lektion Nummer 2. Aktion sollte wirklich nützlich sein

Der Assistent löst die Aufgaben des Benutzers und öffnet nicht nur den Browser

Erstellen Sie keine Assistentenanwendung, die dem Benutzer nichts nützt. Die Aktion kann sehr einfach sein und nur eine Funktion Ihres Dienstes ausführen, sollte jedoch vollständig nützlich sein. Ansonsten macht es keinen Sinn.

"Yoga für die Augen" ist nützlich, da der Benutzer die Übungen und ihre Reihenfolge nicht in verschiedenen Komplexen auswendig lernen muss. Es wird einfach eine Aktion aufgerufen, die die Übung einzeln liest und vom Benutzer ausgeführt wird.Zu diesem Zweck haben wir verschiedene Komplexe ausgewählt und die Übungen in einer regulären Google-Tabelle auf verschiedenen Blättern platziert. Unsere Anwendung

verwendet diese Tabelle als Datenbank , wählt mithilfe einer

HTTP-Anforderung eine Liste von Übungen aus dem gewünschten Blatt aus und liest sie dem Benutzer in einem Zyklus vor. Sobald der Benutzer die nächste Übung beendet hat, sagt er „Komm schon“ und Action liest Folgendes.

Lektion Nummer 3. Die Maßnahmen sollten klar und vorhersehbar sein.

Der Assistent erklärt immer, was er vom Benutzer erwartet. Und der Benutzer weiß immer, was der Assistent jetzt tun wird.

Aktion ist ein Dialog zwischen einem Assistenten und einem Benutzer. Wenn Action auf das nächste Replikat wartet, muss der Benutzer verstehen, was er jetzt sagen kann und wie der Assistent reagiert. Andernfalls erscheint der Assistent dem Benutzer unangemessen und unverständlich. Und du willst es nicht benutzen.

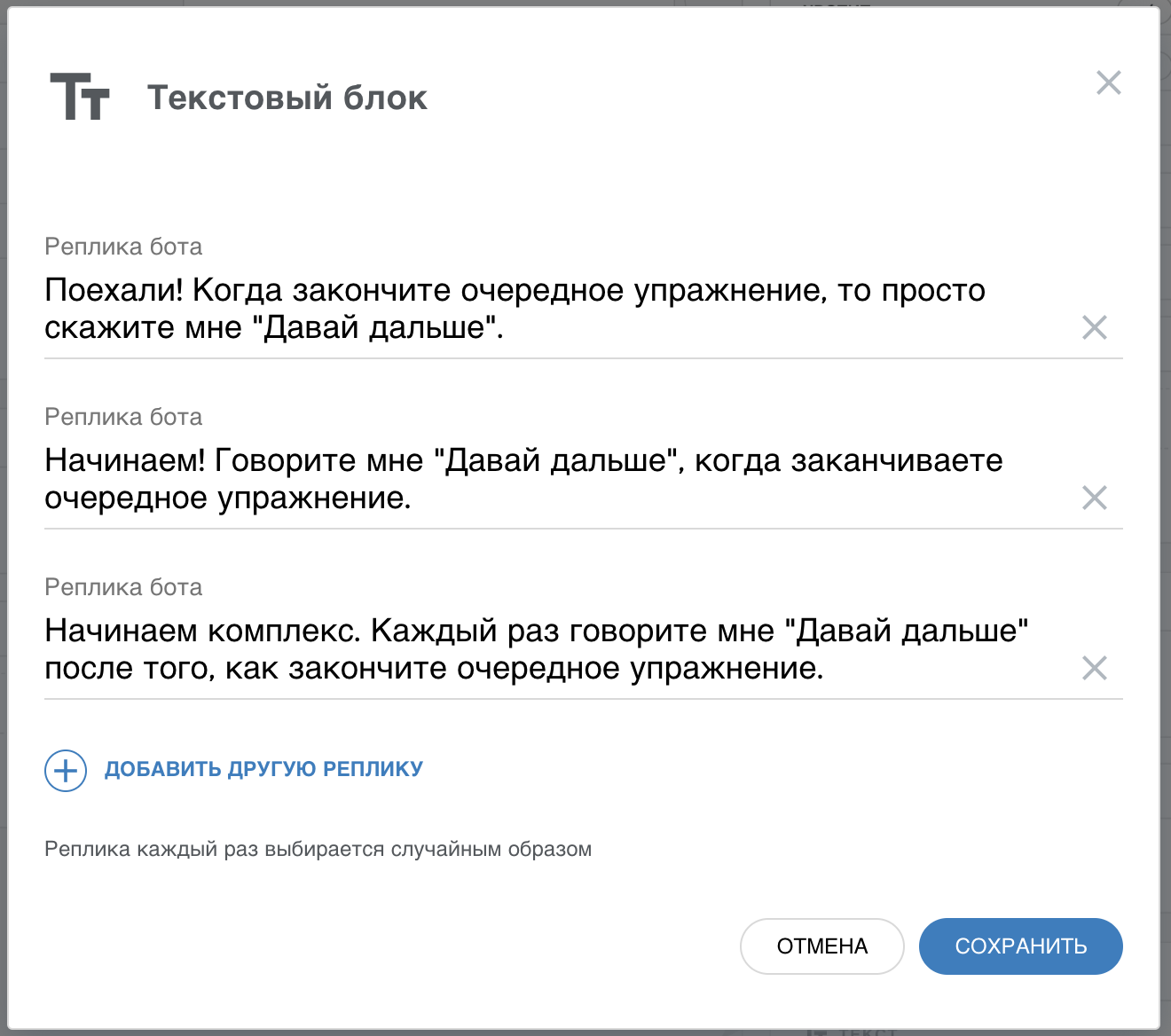

Die Anwendung „Yoga für die Augen“ erklärt dem Benutzer kurz, aber klar, dass er bei jedem Abschluss der nächsten Übung „Komm schon“ sagen sollte. Danach liest der Assistent die nächste Übung und wartet erneut. Der Benutzer versteht also, was er tun soll und was der Assistent von ihm erwartet. Der Dialog ist einfach, aber überraschend effektiv.Im

Abschnitt "Phrasen" haben wir Synonyme für die Phrase

"Komm schon" hinzugefügt

, damit der Assistent angemessen auf andere Formulierungen reagiert. Außerdem haben wir Schaltflächen mit Tipps hinzugefügt, damit der Benutzer beim ersten Mal versteht, wie unsere Anwendung funktioniert. Wir haben auch die Variabilität der Antworten verwendet, um nicht jedes Mal, wenn der Benutzer die Lektion beginnt, denselben Satz zu wiederholen.

Lektion Nummer 4. Aktion sollte kurz sprechen, aber natürlich

Es ist schwierig, langen Text von einem Roboter zu hören. Und wenn der Text unnatürlich klingt, wird es noch schlimmer.

Ein Assistent ist ein Roboter, der wie ein Mensch sein möchte. In der Praxis bedeutet dies, dass alle Repliken des Assistenten verständlich sein sollten, aber nicht zu roboterhaft.

Sprachsynthese ist eine komplizierte Sache. Der Text ist etwas länger - und der Benutzer hört ihn nicht bis zum Ende an. Und wenn der Assistent so ist, als würde ein Roboter die Nachricht auf den Punkt bringen, wird der Benutzer sie überhaupt nicht verstehen. Nun, oder er wird mehr Mühe brauchen, um zu verstehen, was von ihm verlangt wird.

Arbeiten Sie also an Ihren Antworten . Machen Sie sie einerseits kurz und fügen Sie ihnen andererseits eine Konversationssprache hinzu.

Bei der Auswahl von Übungen für das Sehen aus dem Internet haben wir festgestellt, dass sie für die Site und nicht für die interaktive Oberfläche gut geeignet sind. Aus diesem Grund haben wir jede Übung überarbeitet, um sie gleichzeitig kürzer und verständlicher zu machen. Zum Beispiel gab es auf einer Site mit Übungen einen solchen Text„Schließ deine Augen. Dann reibe deine Handflächen und befestige sie an deinen Augen. Bleiben Sie in dieser Position, bis Ihre Hände Wärme abgeben. Dann, ohne die Augen zu öffnen, reiben Sie Ihre Handflächen zurück und setzen Sie sie wieder in Ihre Augen. Führen Sie die Übung dreimal durch. “

Wir haben es so geändert„Schließ deine Augen. Reibe deine Handflächen fest, bringe sie zu deinen Augen und sitze eine Minute lang so. “

Und brach in zwei Zeilen. Wenn der Benutzer

"Weiter" sagt

, antwortet

der Assistent:

"Wiederholen Sie dies jetzt noch zweimal .

"Sie können nicht einfach Text von der Website kopieren und als Sprachassistent verwenden . Wir müssen an den Texten arbeiten, damit sie für das Ohr verständlich sind.

Lektion Nummer 5. Die Aktion muss mit dem Benutzer interagieren

Assistent ist ein persönlicher Assistent. Es sollte dem Benutzer helfen, das Ergebnis zu erhalten, und nicht nur auf Aktionen von ihm warten.

Auf der Website oder in der mobilen Anwendung erstellen wir eine Oberfläche mit Schaltflächen, Listen, Bildern usw. Der Sprachassistent kann dies auch tun, aber der Hauptunterschied besteht darin, dass er spricht und dem Benutzer erlaubt, eine beliebige Phrase auszusprechen. Und dies ändert die Herangehensweise an die Benutzeroberfläche.

Der Benutzer hört möglicherweise nicht, was der Assistent ihm gesagt hat. Oder verstehe das erste Mal nicht. Der Assistent sollte immer bereit sein, auf Anfrage zu wiederholen. Oder formulieren Sie Ihre Antwort neu, wenn der Benutzer sie nicht versteht. Versetzen Sie sich in die Lage eines Assistenten. Sie sprechen mit einer anderen Person, und es ist wichtig, dass Sie Sie verstehen, und nicht unbedingt beim ersten Mal. Sie zeigen dem Gesprächspartner nicht nur ein Blatt Papier mit Menüelementen, sondern helfen auch bei der Auswahl.

In „Yoga für die Augen“ haben wir es so gemacht, dass der Assistent die Übung immer wiederholen kann, wenn der Benutzer dies wünscht. Zeigen Sie außerdem nicht nur den Text der Übung erneut an, sondern bieten Sie umgangssprachlich an, die Übung noch einmal durchzuführen. Zu diesem Zweck haben wir verschiedene Variationen der Phrase „Wiederholen“ im Phrasenblock verwendet und eine weitere Blase mit dem Text gesetzt, bevor wir den Text der Übung wiederholt haben.

Lektion Nummer 6. Aktion hat kein Recht zu brechen

Der Assistent muss auch auf unverständliche Benutzerphrasen angemessen reagieren

Der Assistent verfügt weder über einen blauen Bildschirm noch über ein Fehlerfenster und eine Schaltfläche OK. Und der Benutzer kann wiederum alles sagen und überhaupt nicht, was Ihre Aktion trainiert. In diesem Fall sollte die Anwendung den Benutzer nicht dafür „beschuldigen“, dies nicht zu sagen. Es ist notwendig, irgendwie auf einen unverständlichen Befehl zu reagieren und dem Benutzer noch einmal zu erklären, was von ihm erwartet wird.

Nur zu sagen:

"Oh, ich verstehe dich nicht" ist nicht genug. Dies entspricht der Anzeige

des Lieblingsfensters aller Benutzer mit einem Fehler. "Und was soll ich als nächstes tun?" - Der Benutzer wird fragen.

„Yoga für die Augen“ reagiert sehr einfach auf unverständliche Sätze - es klärt mit dem Benutzer, ob er die aktuelle Übung abgeschlossen hat. Und wenn er in diesem Fall etwas Unverständliches beantwortet, wird er fragen, ob er sein Studium überhaupt beenden möchte. Zu diesem Zweck haben wir den Zweig "Beliebige andere Phrasen" im Phrasenblock verwendet , um auf unverständliche Befehle zu reagieren. Es kam vor, dass der Assistent ihn entspannt zum Beenden einlädt, wenn der Benutzer nicht für die Fortsetzung des Unterrichts konfiguriert ist. Geben Sie unverständlichen Sätzen mehr Aufmerksamkeit

Geben Sie unverständlichen Sätzen mehr Aufmerksamkeit . Immerhin ist dies die „am häufigsten verwendete Funktion“ Ihrer Aktion.

Lektion Nummer 7. Aktion sollte den Benutzer erkennen

Ein Assistent ist ein Assistent, der seinen Benutzer kennt und sein Verhalten im Laufe der Zeit ändert.

Wenn der Benutzer Ihre Aktion zum ersten Mal gestartet hat, sollte die Anwendung darüber sprechen, wofür sie gedacht ist und wie sie verwendet wird. Wenn der Benutzer die Anwendung jedoch jeden Tag aufruft, ist es nicht sinnvoll, sie jedes Mal mit derselben Hilfe zu laden. Sie müssen das Verhalten der Anwendung wie der Assistent ändern, wodurch der Benutzer jeden Tag besser kennengelernt wird.

Aimylogic enthält Informationen darüber, wie lange es her ist, dass ein Benutzer das letzte Mal auf die Anwendung zugegriffen hat. Yoga für die Augen verwendet dies, um den Benutzer beim Start anders zu begrüßen. Und da das Aufladen jeden Tag erfolgen muss, erinnert Sie unsere Anwendung daran, wenn der Benutzer die Anwendung längere Zeit nicht gestartet hat. Dazu verwenden wir den Block Bedingungen, in dem wir überprüfen, vor wie langer Zeit wir die vorherige Anfrage erhalten haben. Abhängig davon durchläuft Action verschiedene Zweige des Dialogfelds.

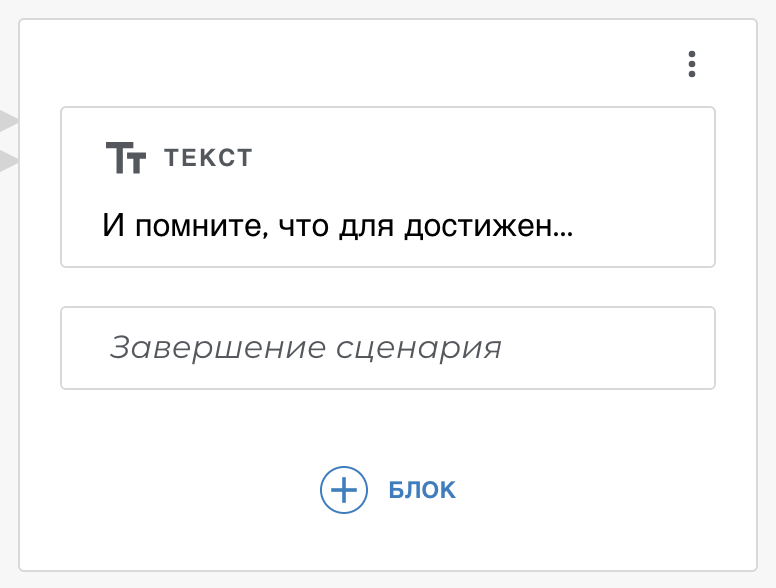

Lektion Nummer 8. Die Aktion muss enden

Sie müssen die Verbindung zum Mikrofon trennen, wenn die Anwendung ihre Arbeit beendet hat.

Ist dies nicht der Fall,

lehnt Google Ihre Bewerbung bei der Veröffentlichung im Verzeichnis ab. Daher muss Ihre Anwendung mindestens einen Zweig des Dialogs haben, der zum Verlassen der Anwendung führt. In diesem Fall müssen Sie das Mikrofon „schließen“.

In „Yoga für die Augen“ kann der Benutzer immer „Genug“ oder „Ich bin müde“ sagen, um den Unterricht abzuschließen. Aimylogic hat einen Skript-Vervollständigungsblock - wir haben ihn in unserem Dialog verwendet, um uns vom Benutzer zu verabschieden und unsere Aktion abzuschließen.

Und noch ein paar Tipps von uns

Versuchen Sie nicht, alle Funktionen Ihres Dienstes in die Sprachanwendung für den Assistenten zu übertragen. Im Dialog geht es um Einfachheit, nicht um Multifunktionalität. Ihre Aktion kann nur eine Funktion ausführen, dies ist jedoch so bequem, dass der Benutzer genau jeden Tag auf Ihre Anwendung zugreift.

Führen Sie keine weitere IVR von einem Assistenten durch . Der Assistent sollte keine möglichen Antworten auflisten - dies ist unnatürlich. Wenn Sie zum Sprachmenü kommen, ist es Elend. Sie müssen nicht dasselbe von einem Assistenten tun. Er kann Sprache erkennen, also arbeiten Sie an Ihrem Skript, damit es natürlich ist. In derselben Aimylogic gibt es alle Tools dafür, und gleichzeitig müssen Sie überhaupt keinen Code schreiben.

Schaltflächen sind Hinweise, nicht das Hauptelement der Sprachbenutzeroberfläche . Der Assistent ist keine Tastenschnittstelle, sondern eine Sprachschnittstelle. Daher sollten die Schaltflächen nur als Hinweise verwendet werden. Ihr Dialog sollte so sein, dass der Benutzer ohne Schaltflächen zurechtkommt.

Schreiben Sie eine kurze Datenschutzrichtlinie und geben Sie den Namen Ihrer Anwendung an. Ohne dies wird Ihre Bewerbung nicht von Google moderiert. Schauen Sie sich

unsere endgültige Version an , um nicht die gleichen Fehler zu machen wie wir :)

Abschließend

Google Assistant hat vor kurzem begonnen, Russisch zu verstehen. Und es gibt immer noch nicht viel von dem, was im Westen ist (coole Stimme, intelligenter Lautsprecher usw.). Aber das alles ist eine Frage der Zeit. Jetzt können Sie versuchen, diesen neuen Kanal für Ihre Dienste zu entwickeln, indem Sie die vorhandenen Erfahrungen von Google und anderen Entwicklern nutzen.

PS . Wenig später werden wir in unseren Tutorials schrittweise Anleitungen veröffentlichen, wie man Yoga für die Augen auf Aimylogic macht. Besuchen Sie unseren Telegramm-Chat, damit Entwickler die Veröffentlichung nicht verpassen.

PS . Wenig später werden wir in unseren Tutorials schrittweise Anleitungen veröffentlichen, wie man Yoga für die Augen auf Aimylogic macht. Besuchen Sie unseren Telegramm-Chat, damit Entwickler die Veröffentlichung nicht verpassen.