Vor einigen Monaten haben die Mitarbeiter unseres Forschungslabors bei der Arbeit am nächsten Projekt NVMe-Festplatten und Softwarelösungen untersucht, um die beste Option für die Zusammenstellung eines Software-Arrays zu finden.

Die Testergebnisse waren dann überraschend entmutigend - das enorme Geschwindigkeitspotential von NVMe-Festplatten korrelierte überhaupt nicht mit der nachgewiesenen Leistung bestehender Softwareprodukte.

Unseren Entwicklern hat es nicht gefallen. Und sie beschlossen, ihr Produkt zu schreiben ... Ein Produkt, das die Vermarkter später freudig mit dem Namen RAIDIX ERA erfanden.

Heute stellen mehr als ein Dutzend Unternehmen Server her, die für die Verwendung von NVMe-Laufwerken geeignet sind. Der Markt für Produkte, die diese Technologie unterstützen und entwickeln, hat ein enormes Potenzial. Im G2M-Analysebericht werden überzeugende Zahlen präsentiert, die davon überzeugen, dass dieses Datenübertragungsprotokoll in naher Zukunft dominieren wird.

Diagramm aus dem G2M-Bericht

Diagramm aus dem G2M-BerichtDerzeit ist Intel einer der führenden Hersteller von NVMe-Komponenten. An ihren Geräten haben wir Tests durchgeführt, um die Fähigkeiten bestehender Softwareprodukte zur Verwaltung einer solchen „innovativen“ Hardware zu bewerten.

Zusammen mit unserem Partner Promobit (einem Hersteller von Servern und Datenspeichersystemen unter der Marke BITBLAZE) organisierten wir Tests der Intel NVMe-Laufwerke und der gängigen Software zur Verwaltung solcher Geräte. Die Tests wurden nach der SNIA-Methode durchgeführt.

In diesem Artikel werden wir die Zahlen teilen, die beim Testen des Intel NVMe-Hardwaresystems, der Software-Arrays von MDRAID, Zvol über ZFS RAIDZ2 und in der Tat unserer neuen Entwicklung erhalten wurden.

Hardwarekonfiguration

Als Basis für die Testplattform haben wir das Serversystem Intel Server System R2224WFTZS verwendet. Es verfügt über 2 Sockel für die Installation von skalierbaren Intel Xeon-Prozessoren und 12 Speicherkanäle (insgesamt 24 DIMMs) DDR 4 mit einer Frequenz von bis zu 2666 MHz.

Weitere Informationen zur Serverplattform finden Sie

auf der Website des Herstellers .

Alle NVMe-Laufwerke sind über 3 Backplanes

F2U8X25S3PHS verbunden .

Insgesamt haben wir 12 NVMe-Laufwerke INTEL SSDPD2MD800G4 mit der Firmware CVEK6256004E1P0BGN im System.

Die Serverplattform war mit zwei Intel® Xeon® Gold 6130-CPU-Prozessoren mit 2,10 GHz und aktiviertem Hyper-Threading ausgestattet, sodass zwei Threads von jedem Kern aus gestartet werden konnten. Somit haben wir am Ausgang 64 Computer-Threads erhalten.

Testvorbereitung

Alle Tests in diesem Artikel wurden gemäß der Spezifikation der SNIA SSS PTSe v 1.1-Methodik durchgeführt. Einschließlich der vorläufigen Vorbereitung der Lagerung wurde durchgeführt, um ein stabiles und ehrliches Ergebnis zu erzielen.

Mit SNIA kann der Benutzer die Parameter für die Anzahl der Threads und die Warteschlangentiefe festlegen. Daher setzen wir 64/32 mit 64 Computer-Threads auf 32 Kernen.

Jeder Test wurde in 16 Runden durchgeführt, um das System auf ein stabiles Indikatorniveau zu bringen und zufällige Werte auszuschließen.

Vor Beginn der Tests haben wir eine vorläufige Vorbereitung des Systems vorgenommen:

- Installieren der Kernel-Version 4.11 unter CentOS 7.4.

- Schalten Sie C-STATES und P-STATES aus.

- Führen Sie das Dienstprogramm optimiert-adm aus und legen Sie das Latenzleistungsprofil fest.

Die Prüfung jedes Produkts und Gegenstands wurde in den folgenden Schritten durchgeführt:

Vorbereitung der Geräte gemäß der SNIA-Spezifikation (abhängig und unabhängig von der Art der Last).

- IOps-Test in Blöcken von 4k, 8k, 16k, 32k, 64k, 128k, 1m mit Variationen der Lese- / Schreibkombinationen 0/100, 5/95, 35/65, 50/50, 65/35, 95/5, 100/0 .

- Latenztests mit 4k-, 8k-, 16k-Blöcken mit Variationen der Lese- / Schreibkombinationen 0/100, 65/35 und 100/0. Die Anzahl der Threads und die Warteschlangentiefe beträgt 1-1. Die Ergebnisse werden als durchschnittliche und maximale Verzögerung aufgezeichnet.

- Throughtput-Test mit 128k- und 1M-Blöcken in 64 Zeilen von 8 Teams.

Wir haben zunächst die Leistung, Latenz und den Durchsatz der Hardwareplattform getestet. Dies ermöglichte es uns, das Potenzial der vorgeschlagenen Ausrüstung zu bewerten und mit den Fähigkeiten der angewandten Softwarelösungen zu vergleichen.

Test 1. Hardwaretests

Zunächst haben wir uns entschlossen zu prüfen, wozu ein Intel DCM D3700 NVMe-Laufwerk in der Lage ist.

In der Spezifikation gibt der Hersteller die folgenden Leistungsparameter an:

Random Read (100% Span) 450.000 IOPS

Random Write (100% Span) 88000 IOPS

Test 1.1 Ein NVMe-Laufwerk. IOPS-Test

Leistungsergebnis (IOps) in tabellarischer Form. Lese- / Schreibmischung%.

| Blockgröße | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 84017.8 | 91393.8 | 117271.6 | 133059.4 | 175086.8 | 281131.2 | 390969.2 |

| 8k | 42602.6 | 45735,8 | 58980.2 | 67321.4 | 101357.2 | 171316.8 | 216551.4 |

| 16k | 21618.8 | 22834.8 | 29703.6 | 33821.2 | 52552.6 | 89731.2 | 108347 |

| 32k | 10929.4 | 11322 | 14787 | 16811 | 26577.6 | 47185.2 | 50670.8 |

| 64k | 5494.4 | 5671.6 | 7342.6 | 8285.8 | 13130.2 | 23884 | 27249.2 |

| 128k | 2748.4 | 2805.2 | 3617.8 | 4295.2 | 6506.6 | 11997.6 | 13631 |

| 1m | 351.6 | 354.8 | 451.2 | 684.8 | 830.2 | 1574.4 | 1702.8 |

Leistungsergebnis (IOps) in grafischer Form. Lese- / Schreibmischung%.

Zu diesem Zeitpunkt haben wir Ergebnisse erzielt, die die Werksergebnisse nicht ganz erreichen. Höchstwahrscheinlich spielte NUMA (das in Multiprozessorsystemen verwendete Implementierungsschema für den Computerspeicher, wenn die Zugriffszeit auf den Speicher durch seinen Standort relativ zum Prozessor bestimmt wird) seine Rolle, aber wir werden es vorerst nicht beachten.

Test 1.2 Ein NVMe-Laufwerk. Verzögerungstests

Durchschnittliche Antwortzeit (ms) in Tabellenform. Lese- / Schreibmischung%.

| Blockgröße | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,02719 | 0,072134 | 0,099402 |

| 8k | 0,029864 | 0,093092 | 0,121582 |

| 16k | 0,046726 | 0,137016 | 0,16405 |

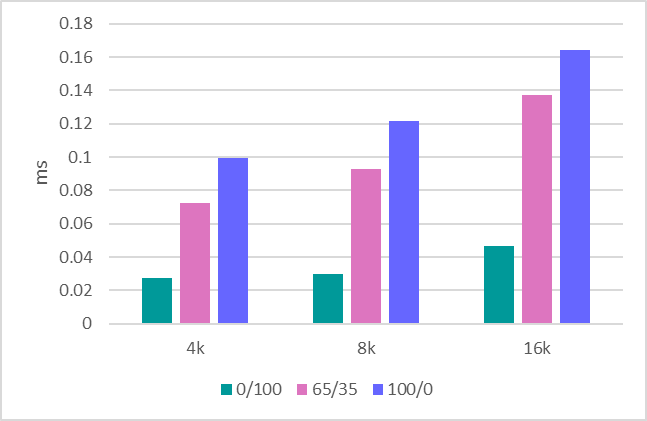

Durchschnittliche Antwortzeit (ms) in grafischer Form. Lese- / Schreibmischung%.

Maximale Antwortzeit

Maximale Antwortzeit (ms) in Tabellenform. Lese- / Schreibmischung%.

| Blockgröße | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 6.9856 | 4.7147 | 1,5098 |

| 8k | 7.0004 | 4.3118 | 1,4086 |

| 16k | 7.0068 | 4.6445 | 1.1064 |

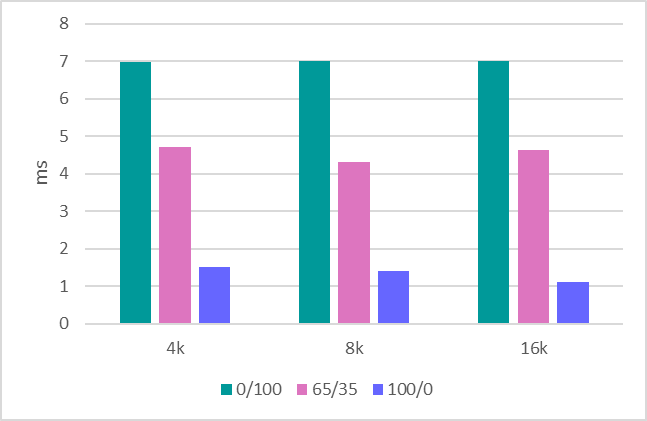

Maximale Antwortzeit (ms) in grafischer Form. Lese- / Schreibmischung%.

Test 1.3 Durchsatz

Der letzte Schritt ist die Bewertung des Durchsatzes. Hier sind die folgenden Indikatoren:

1 MB sequentielle Aufzeichnung - 634 MBit / s.

1 MB sequentielles Lesen - 1707 MBit / s.

Sequentielle 128-KB-Aufnahme - 620 MBit / s.

Sequentielles Lesen mit 128 KB - 1704 MBit / s.

Nachdem wir uns mit einem Laufwerk befasst haben, bewerten wir die gesamte Plattform, die aus 12 Laufwerken besteht.

Test 1.4 System in 12 Laufwerken. IOPS-Test

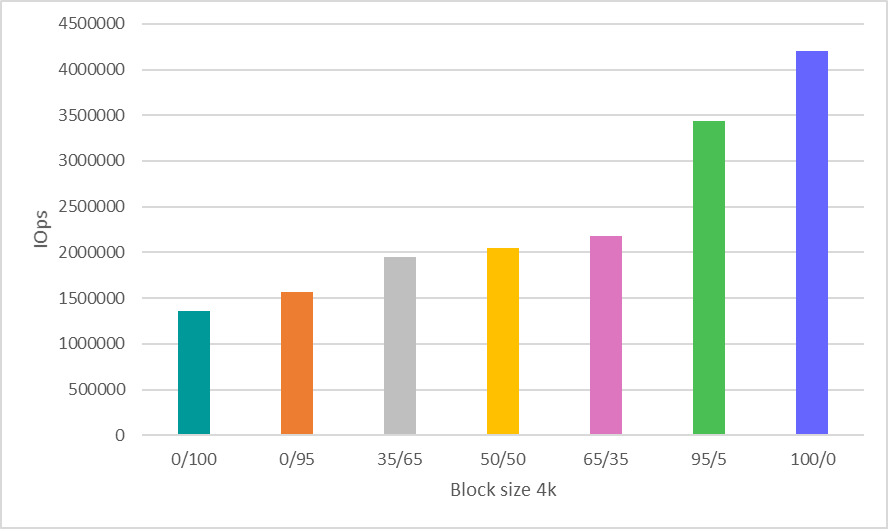

Hier wurde eine willensstarke Entscheidung getroffen, Zeit zu sparen und Ergebnisse nur für die Arbeit mit dem 4k-Block anzuzeigen, der bei weitem das häufigste und indikativste Szenario für die Bewertung der Leistung ist.

Leistungsergebnis (IOps) in tabellarischer Form. Lese- / Schreibmischung%.

| Blockgröße | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 1363078.6 | 1562345 | 1944105 | 2047612 | 2176476 | 3441311 | 4202364 |

Leistungsergebnis (IOps) in grafischer Form. Lese- / Schreibmischung%.

Testen Sie das 1.5-System in 12 Laufwerken. Bandbreitentests

1 MB sequentielle Aufzeichnung - 8612 MBit / s.

1 MB sequentielles Lesen - 20481 MBit / s.

Sequentielle 128-KB-Aufzeichnung - 7500 MBit / s.

Sequentielles Lesen mit 128 KB - 20400 MBit / s.

Wir werden uns die erhaltenen Hardware-Leistungsindikatoren am Ende des Artikels noch einmal ansehen und sie mit den Nummern der darauf getesteten Software vergleichen.

Test 2: MDRAID testen

Wenn wir über ein Software-Array sprechen, fällt uns zuerst MDRAID ein. Denken Sie daran, dass dies die Basissoftware RAID für Linux ist, die kostenlos verteilt wird.

Lassen Sie uns sehen, wie MDRAID mit dem vorgeschlagenen 12-Festplatten-System mit einer RAID 0-Array-Ebene umgeht. Wir alle wissen, dass das Erstellen von RAID 0 auf 12 Laufwerken besonderen Mut erfordert, aber jetzt benötigen wir diese Array-Ebene, um die maximalen Funktionen dieser Lösung zu demonstrieren.

Test 2.1 MDRAID. RAID 0. IOPS-Test

Leistungsergebnis (IOps) in tabellarischer Form. Lese- / Schreibmischung%.

| Blockgröße | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 1010396 | 1049306.6 | 1312401.4 | 1459698.6 | 1932776.8 | 2692752.8 | 2963943.6 |

| 8k | 513627.8 | 527230.4 | 678140 | 771887.8 | 1146340.6 | 1894547.8 | 2526853.2 |

| 16k | 261087.4 | 263638.8 | 343679.2 | 392655.2 | 613912.8 | 1034843.2 | 1288299.6 |

| 32k | 131198.6 | 130947.4 | 170846.6 | 216039.4 | 309028.2 | 527920.6 | 644774.6 |

| 64k | 65083.4 | 65099.2 | 85257.2 | 131005.6 | 154839.8 | 268425 | 322739 |

| 128k | 32550.2 | 32718.2 | 43378.6 | 66999.8 | 78935.8 | 136869.8 | 161015.4 |

| 1m | 3802 | 3718.4 | 3233.4 | 3467.2 | 3546 | 6150.8 | 8193.2 |

Leistungsergebnis (IOps) in grafischer Form. Lese- / Schreibmischung%.

Test 2.2 MDRAID. RAID 0. Verzögerungstests

Durchschnittliche Antwortzeit (ms) in Tabellenform. Lese- / Schreibmischung%.

| Blockgröße | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,03015 | 0,067541 | 0,102942 |

| 8k | 0,03281 | 0,082132 | 0,126008 |

| 16k | 0,050058 | 0,114278 | 0,170798 |

Durchschnittliche Antwortzeit (ms) in grafischer Form. Lese- / Schreibmischung%.

Maximale Antwortzeit

Maximale Antwortzeit (ms) in Tabellenform. Lese- / Schreibmischung%.

| Blockgröße | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 6.7042 | 3,7257 | 0,8568 |

| 8k | 6.5918 | 2.2601 | 0,9004 |

| 16k | 6.3466 | 2,7741 | 2,5678 |

Maximale Antwortzeit (ms) in grafischer Form. Lese- / Schreibmischung%.

Test 2.3 MDRAID. RAID 0. Bandbreitentests

1 MB sequentielles Schreiben - 7820 MBPS.

1 MB sequentielles Lesen - 20418 MBPS.

Sequentielles Schreiben mit 128 KB - 7622 MBPS.

Sequentielles Lesen mit 128 KB - 20.380 MBPS.

Test 2.4 MDRAID. RAID 6. IOPS-Test

Lassen Sie uns nun sehen, was dieses System auf RAID-Ebene 6 hat.

Optionen zur Array-Erstellung

mdadm --create --verbose --chunk 16K / dev / md0 --level = 6 --raid-device = 12 / dev / nvme0n1 / dev / nvme1n1 / dev / nvme2n1 / dev / nvme3n1 / dev / nvme4n1 / dev / nvme5n1 / dev / nvme8n1 / dev / nvme9n1 / dev / nvme10n1 / dev / nvme11n1 / dev / nvme6n1 / dev / nvme7n1

Das Gesamtvolumen des Arrays betrug

7450,87 GiB.

Wir starten den Test nach der vorläufigen Initialisierung des RAID-Arrays.

Leistungsergebnis (IOps) in tabellarischer Form. Lese- / Schreibmischung%.

| Blockgröße | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 39907.6 | 42849 | 61609.8 | 78167.6 | 108594.6 | 641950.4 | 1902561.6 |

| 8k | 19474.4 | 20701.6 | 30316.4 | 39737,8 | 57051.6 | 394072.2 | 1875791.4 |

| 16k | 10371.4 | 10979.2 | 16022 | 20992.8 | 29955.6 | 225157.4 | 1267495.6 |

| 32k | 8505.6 | 8824.8 | 12896 | 16657.8 | 23823 | 173261.8 | 596857.8 |

| 64k | 5679.4 | 5931 | 8576.2 | 11137.2 | 15906.4 | 109469.6 | 320874.6 |

| 128k | 3976.8 | 4170.2 | 5974.2 | 7716.6 | 10996 | 68124.4 | 160453.2 |

| 1m | 768,8 | 811.2 | 1177.8 | 1515 | 2149.6 | 4880.4 | 5499 |

Leistungsergebnis (IOps) in grafischer Form. Lese- / Schreibmischung%.

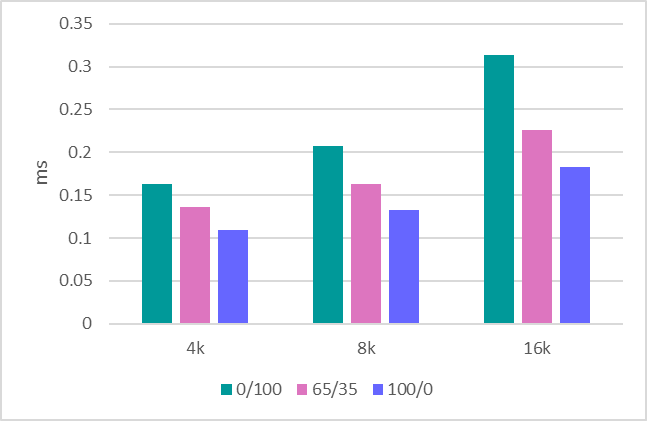

Test 2.5 MDRAID. RAID 6. Verzögerungstests

Durchschnittliche Antwortzeit (ms) in Tabellenform. Lese- / Schreibmischung%.

| Blockgröße | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,193702 | 0,145565 | 0,10558 |

| 8k | 0,266582 | 0,186618 | 0,127142 |

| 16k | 0,426294 | 0,281667 | 0,169504 |

Durchschnittliche Antwortzeit (ms) in grafischer Form. Lese- / Schreibmischung%.

Maximale Antwortzeit

Maximale Antwortzeit (ms) in Tabellenform. Lese- / Schreibmischung%.

| Blockgröße | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 6.1306 | 4,5416 | 4.2322 |

| 8k | 6.2474 | 4,5197 | 3,5898 |

| 16k | 5.4074 | 5.5861 | 4.1404 |

Maximale Antwortzeit (ms) in grafischer Form. Lese- / Schreibmischung%.

Es ist erwähnenswert, dass MDRAID hier sehr gute Verzögerungen aufwies.

Test 2.6 MDRAID. RAID 6. Bandbreitentests

1 MB sequentielles Schreiben - 890 MBPS.

1 MB sequentielles Lesen - 18800 MBPS.

Sequentielles Schreiben mit 128 KB - 870 MBPS.

Sequentielles Lesen mit 128 KB - 10400 MBPS.

Test 3. Zvol über ZFS RAIDZ2

ZFS verfügt über eine integrierte RAID-Erstellungsfunktion und einen integrierten Volume-Manager, der virtuelle Blockgeräte erstellt, die von vielen Speicherherstellern verwendet werden. Wir werden diese Funktionen auch nutzen, indem wir einen Pool mit RAIDZ2-Schutz (analog zu RAID 6) und einem virtuellen Block-Volume darüber erstellen.

Version 0.79 (ZFS) wurde kompiliert. Optionen zur Array- und Volume-Erstellung:

ashift = 12 / komprimierung - aus / dedup - aus / aufzeichnungsgröße = 1M / atime = aus / cachefile = keine / Typ RAID = RAIDZ2

ZFS zeigt mit dem neu erstellten Pool sehr gute Ergebnisse. Bei wiederholtem Überspielen wird die Leistung jedoch erheblich verringert.

Der SNIA-Ansatz ist gut, da Sie nach wiederholten Überschreibungen echte Ergebnisse beim Testen ähnlicher Dateisysteme (das auf ZFS basierende) sehen können.

Test 3.1 ZVOL (ZFS). RAIDZ2. IOps-Test

Leistungsergebnis (IOps) in tabellarischer Form. Lese- / Schreibmischung%.

| Blockgröße | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 15719.6 | 15147.2 | 14190.2 | 15592.4 | 17965.6 | 44832.2 | 76314.8 |

| 8k | 15536.2 | 14929.4 | 15140.8 | 16551 | 17898.8 | 44553.4 | 76187.4 |

| 16k | 16696.6 | 15937.2 | 15982.6 | 17350 | 18546.2 | 44895,4 | 75549.4 |

| 32k | 11859.6 | 10915 | 9698.2 | 10235.4 | 11265 | 26741.8 | 38167.2 |

| 64k | 7444 | 6440.2 | 6313.2 | 6578.2 | 7465.6 | 14145.8 | 19099 |

| 128k | 4425.4 | 3785.6 | 4059.8 | 3859.4 | 4246.4 | 7143.4 | 10052.6 |

| 1m | 772 | 730.2 | 779,6 | 784 | 824.4 | 995.8 | 1514.2 |

Leistungsergebnis (IOps) in grafischer Form. Lese- / Schreibmischung%.

Leistungsdaten sind völlig unscheinbar. Gleichzeitig liefert reines zvol (vor dem Umschreiben) signifikant bessere Ergebnisse (5-6 mal höher). Hier zeigte der Test, dass nach dem ersten Überspielen die Leistung abnimmt.

Test 3.2 ZVOL (ZFS). RAIDZ2. Verzögerungstests

Durchschnittliche Antwortzeit (ms) in Tabellenform. Lese- / Schreibmischung%.

| Blockgröße | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,332824 | 0,255225 | 0,218354 |

| 8k | 0,3299 | 0,259013 | 0,225514 |

| 16k | 0,139738 | 0,180467 | 0,233332 |

Durchschnittliche Antwortzeit (ms) in grafischer Form. Lese- / Schreibmischung%.

Maximale Antwortzeit

Maximale Antwortzeit (ms) in Tabellenform. Lese- / Schreibmischung%.

| Blockgröße | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 90,55 | 69,9718 | 84.4018 |

| 8k | 91,6214 | 86.6109 | 104.7368 |

| 16k | 108,2192 | 86,2194 | 105,658 |

Maximale Antwortzeit (ms) in grafischer Form. Lese- / Schreibmischung%.

Test 3.3 ZVOL (ZFS). RAIDZ2. Bandbreitentests

1 MB sequentielles Schreiben - 1150 MBPS.

1 MB sequentielles Lesen - 5500 MBPS.

Sequentielles Schreiben mit 128 KB - 1100 MBPS.

Sequentielles Lesen mit 128 KB - 5300 MBPS.

Test 4: RAIDIX ERA

Schauen wir uns nun die Tests unseres neuen Produkts - RAIDIX ERA - an.

Wir haben RAID6 erstellt. Streifengröße: 16kb. Führen Sie den Test nach Abschluss der Initialisierung aus.

Leistungsergebnis (IOps) in tabellarischer Form. Lese- / Schreibmischung%.

| Blockgröße | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 354887 | 363830 | 486865.6 | 619349.4 | 921403.6 | 2202384.8 | 4073187.8 |

| 8k | 180914.8 | 185371 | 249927.2 | 320438.8 | 520188.4 | 1413096.4 | 2510729 |

| 16k | 92115.8 | 96327.2 | 130661.2 | 169247.4 | 275446.6 | 763307.4 | 1278465 |

| 32k | 59994.2 | 61765.2 | 83512.8 | 116562.2 | 167028.8 | 420216.4 | 640418.8 |

| 64k | 27660.4 | 28229.8 | 38687.6 | 56603.8 | 76976 | 214958.8 | 299137.8 |

| 128k | 14475.8 | 14730 | 20674.2 | 30358.8 | 40259 | 109258.2 | 160141.8 |

| 1m | 2892.8 | 3031.8 | 4032.8 | 6331.6 | 7514.8 | 15871 | 19078 |

Leistungsergebnis (IOps) in grafischer Form. Lese- / Schreibmischung%.

Test 4.2 RAIDIX ERA. RAID 6. Verzögerungstests

Durchschnittliche Antwortzeit (ms) in Tabellenform. Lese- / Schreibmischung%.

| Blockgröße | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,16334 | 0,136397 | 0,10958 |

| 8k | 0,207056 | 0,163325 | 0,132586 |

| 16k | 0,313774 | 0,225767 | 0,182928 |

Durchschnittliche Antwortzeit (ms) in grafischer Form. Lese- / Schreibmischung%.

Maximale Antwortzeit

Maximale Antwortzeit (ms) in Tabellenform. Lese- / Schreibmischung%.

| Blockgröße | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 5.371 | 3.4244 | 3,5438 |

| 8k | 5.243 | 3,7415 | 3,5414 |

| 16k | 7.628 | 4.2891 | 4.0562 |

Maximale Antwortzeit (ms) in grafischer Form. Lese- / Schreibmischung%.

Verzögerungen ähneln denen von MDRAID. Für genauere Schlussfolgerungen sollte jedoch eine Schätzung der Verzögerungen unter einer schwerwiegenderen Belastung durchgeführt werden.

Test 4.3 RAIDIX ERA. RAID 6. Bandbreitentests

1 MB sequentielles Schreiben - 8160 MBPS.

1 MB sequentielles Lesen - 19700 MBPS.

Sequentielles Schreiben mit 128 KB - 6200 MBPS.

Sequentielles Lesen mit 128 KB - 19700 MBPS.

Fazit

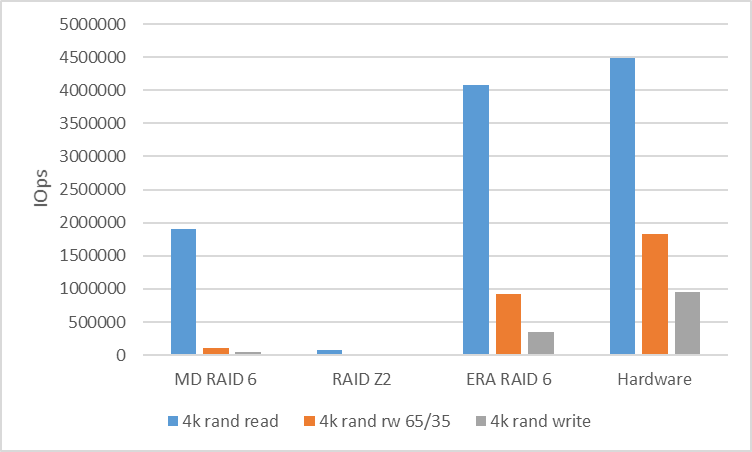

Als Ergebnis der Tests lohnt es sich, die aus Softwarelösungen erhaltenen Zahlen mit denen der Hardwareplattform zu vergleichen.

Um die Leistung des zufälligen Ladens zu analysieren, vergleichen wir die Geschwindigkeit von RAID 6 (RAIDZ2), wenn mit einem Block in 4k gearbeitet wird.

| MD RAID 6 | RAIDZ2 | RAIDIX ERA RAID 6 | Hardware |

|---|

| 4k R100% / W0% | 1902561 | 76314 | 4073187 | 4,494,142 |

| 4k R65% / W35% | 108594 | 17965 | 921403 | 1823432 |

| 4k R0% / W100% | 39907 | 15719 | 354887 | 958054 |

Um die Leistung der seriellen Last zu analysieren, betrachten wir RAID 6 (RAIDZ2) mit einem 128k-Block. Zwischen den Threads haben wir eine 10-GB-Verschiebung verwendet, um Cache-Treffer zu vermeiden und echte Leistung zu zeigen.

| MD RAID 6 | RAIDZ2 | RAIDIX ERA RAID 6 | Hardware |

|---|

| 128k seq gelesen | 10400 | 5300 | 19700 | 20.400 |

| 128k seq schreiben | 870 | 1100 | 6200 | 7500 |

Was ist das Ergebnis?

Beliebte und kostengünstige Software-RAID-Arrays für die Arbeit mit NVMe-Geräten können nicht die Leistung anzeigen, die dem Hardwarepotenzial innewohnt.

Hier besteht ein sehr offensichtlicher Bedarf an einer Steuerungssoftware, die die Situation verschärfen und zeigen kann, dass die Programmsteuerungssymbiose mit NVMe-Laufwerken sehr produktiv und flexibel sein kann.

Um diese Anforderung zu verstehen, hat unser Unternehmen ein RAIDIX ERA-Produkt entwickelt, dessen Entwicklung sich auf die Lösung der folgenden Probleme konzentrierte:

- Hohe Lese- und Schreibleistung (mehrere Millionen IOps) auf Arrays mit Parität im Mischmodus.

- Streaming-Leistung von 30 GBit / s, auch während des Failovers und der Wiederherstellung.

- Unterstützung für RAID-Level 5, 6, 7.3.

- Hintergrundinitialisierung und Rekonstruktion.

- Flexible Einstellungen für verschiedene Lasttypen (Benutzerseite).

Heute können wir sagen, dass diese Aufgaben abgeschlossen wurden und das Produkt einsatzbereit ist.

Gleichzeitig haben wir, da wir das Interesse vieler Interessenten an solchen Technologien verstanden haben, für die Veröffentlichung nicht nur eine kostenpflichtige, sondern auch eine

kostenlose Lizenz vorbereitet, mit der Probleme sowohl auf NVMe- als auch auf SSD-Laufwerken vollständig gelöst werden können.

Weitere Informationen zu RAIDIX ERA finden Sie

auf unserer Website .

UPD Reduzierte ZFS-Tests mit 8k für Recordsize und Volblocksize

ZFS-Optionstabelle

| NAME | EIGENTUM | WERT | QUELLE |

|---|

| Tank | Aufzeichnungsgröße | 8K | lokal |

| Tank | Komprimierung | aus | Standard |

| Tank | dedup | aus | Standard |

| Tank | Prüfsumme | aus | lokal |

| Tank | volblocksize | - - | - - |

| Panzer / Schlachtzug | Aufzeichnungsgröße | - - | - - |

| Panzer / Schlachtzug | Komprimierung | aus | lokal |

| Panzer / Schlachtzug | dedup | aus | Standard |

| Panzer / Schlachtzug | Prüfsumme | aus | lokal |

| Panzer / Schlachtzug | volblocksize | 8k | Standard |

Die Aufnahme ist schlechter geworden, das Lesen ist besser.

Trotzdem sind alle Ergebnisse deutlich schlechter als bei anderen Lösungen

| Blockgröße | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 13703.8 | 14399.8 | 20903.8 | 25669 | 31610 | 66955.2 | 140849.8 |

| 8k | 15126 | 16227.2 | 22393.6 | 27720.2 | 34274.8 | 67008 | 139480.8 |

| 16k | 11111.2 | 11412.4 | 16980.8 | 20812.8 | 24680.2 | 48803.6 | 83710.4 |