Im Juni veröffentlichte ein Team von Wissenschaftlern der University of California in San Francisco

eine Studie , die Aufschluss darüber gibt, wie Menschen ihre Tonhöhe in ihrer Rede ändern.

Die Ergebnisse dieser Studie können nützlich sein, um Synthesizer für natürlich klingende Sprache zu entwickeln - mit Emotionen und verschiedenen Intonationen.

Über die Studie - in unserem Artikel heute.

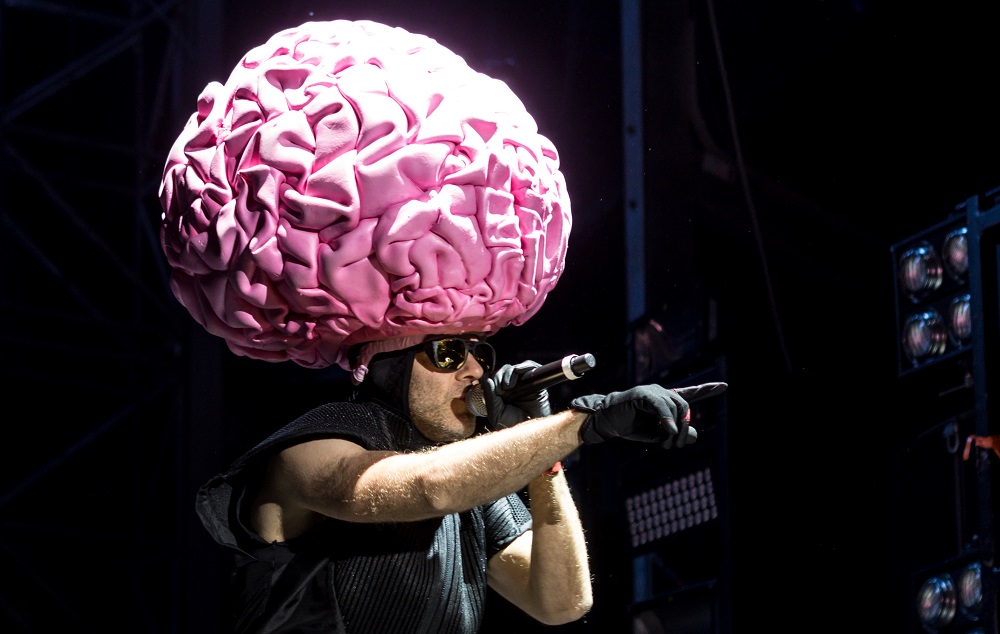

Foto Florian Koppe / CC

Foto Florian Koppe / CCWie war die Studie?

Ein Team von Wissenschaftlern an der University of California hat kürzlich eine Reihe von Experimenten durchgeführt. Sie untersucht die Beziehung zwischen verschiedenen Teilen des Gehirns und den Sprachorganen. Forscher versuchen herauszufinden, was während eines Gesprächs im Gehirn passiert.

Die fragliche Arbeit in dem Artikel konzentriert sich auf den Bereich, der den Kehlkopf kontrolliert, auch zum Zeitpunkt der Änderung der Tonhöhe.

Der führende Spezialist in der Studie war der Neurochirurg Edward Chang (Edward Chang). Er arbeitet mit Patienten mit Epilepsie - er führt Operationen durch, die Krämpfe verhindern. Chang überwacht die Gehirnaktivität einiger seiner Patienten mit Hilfe spezieller Geräte.

Das Team rekrutierte Freiwillige für ihre Forschung aus dieser speziellen Patientengruppe. Mit angeschlossenen Sensoren können Sie ihre neuronale Aktivität während der Experimente überwachen. Diese als

Elektrokortikographie bekannte Methode half Wissenschaftlern, den Bereich des Gehirns zu finden, der für Tonhöhenänderungen verantwortlich ist.

Die Studienteilnehmer wurden gebeten, den gleichen Satz laut zu wiederholen, aber jedes Mal unterschiedliche Wörter hervorzuheben. Daraus änderte sich die Bedeutung des Ausdrucks. Gleichzeitig änderte sich auch die Frequenz des Grundtons - die Frequenz der Stimmbänder.

Das Team stellte fest, dass Neuronen in einem Bereich des Gehirns aktiviert wurden, als der Patient den Ton erhöhte. Dieser Bereich in der motorischen Zone der Kortikalis ist für die Muskeln des Kehlkopfes verantwortlich. Die Forscher stimulierten die Elektrizität der Neuronen in diesem Bereich, auf die die Muskeln des Kehlkopfes mit Spannung reagierten, und einige Patienten machten unwillkürlich Geräusche.

Die Teilnehmer der Studie enthielten auch eine Aufzeichnung ihrer eigenen Stimmen. Dies verursachte eine Reaktion von Neuronen. Daraus folgerten die Teammitglieder, dass dieser Bereich des Gehirns nicht nur an der Veränderung der Frequenz des Grundtons beteiligt ist, sondern auch an der Wahrnehmung von Sprache. Dies kann eine Vorstellung davon geben, wie das Gehirn an der Nachahmung der Sprache eines anderen beteiligt ist. Sie können die Tonhöhe und andere Merkmale ändern, um den Gesprächspartner zu parodieren.

Nützlich bei der Entwicklung von Sprachsynthesizern

Der Journalist Robbie Gonzalez von Wired

glaubt, dass die Ergebnisse der Studie für die Prothetik des Kehlkopfes nützlich sein könnten und es Patienten ohne Stimme ermöglichen könnten, realistischer zu "sprechen". Dies wird von den Wissenschaftlern selbst bestätigt.

Synthesizer menschlicher Sprache - zum Beispiel die

von Stephen Hawking - können immer noch Wörter reproduzieren und neuronale Aktivitäten interpretieren. Sie können jedoch nicht betonen, wie es eine Person mit einem gesunden Sprachapparat tun würde. Aus diesem Grund klingt die Rede unnatürlich und es ist nicht immer klar, ob der Gesprächspartner eine Frage stellt oder eine Erklärung abgibt.

Wissenschaftler erforschen weiterhin den Bereich des Gehirns, der für die Änderung der Frequenz des Grundtons verantwortlich ist. Es wird davon ausgegangen, dass Sprachsynthesizer in Zukunft in der Lage sein werden, die neuronale Aktivität in diesem Bereich zu analysieren und auf der Grundlage der erhaltenen Daten Sätze auf natürliche Weise zu bilden - betonen Sie die richtigen Wörter mit der Tonhöhe, bilden Sie Fragen und Aussagen auf intonationaler Ebene, je nachdem, was die Person sagen möchte.

Andere Sprachmodellstudien

Vor nicht allzu langer Zeit

wurde im Labor von Edward Chang eine weitere

Studie durchgeführt, die bei der Entwicklung von Sprachformungsgeräten helfen kann. Die Teilnehmer lasen Hunderte von Sätzen vor, in deren Klang fast alle möglichen phonetischen Konstruktionen des amerikanischen Englisch verwendet wurden. Und Wissenschaftler verfolgten die neuronale Aktivität der Probanden.

Foto PxHere / PD

Foto PxHere / PDDiesmal wurde die Koartikulation zu einem interessanten Objekt - wie die Organe des Stimmapparates (z. B. Lippen und Zunge) funktionieren, wenn verschiedene Töne ausgesprochen werden. Es wurde auf Wörter geachtet, in denen verschiedene Vokale demselben festen Konsonanten folgen. Wenn wir solche Wörter aussprechen, funktionieren Lippen und Zunge oft unterschiedlich - daher ist auch unsere Wahrnehmung der entsprechenden Geräusche unterschiedlich.

Die Wissenschaftler bestimmten nicht nur die Gruppen von Neuronen, die für bestimmte Bewegungen der Organe des Vokaltrakts verantwortlich sind, sondern fanden auch heraus, dass die Sprachzentren des Gehirns die Bewegungen der Muskeln der Zunge, des Kehlkopfs und anderer Organe des Vokaltrakts koordinieren, wobei sie sich auf den Kontext der Sprache stützen - in welcher Reihenfolge die Töne erzeugt werden. Wir wissen, dass die Sprache je nach dem nächsten Ton im Wort unterschiedliche Positionen einnimmt, und es gibt eine große Anzahl solcher Klangkombinationen - dies ist ein weiterer Faktor, der den Klang der menschlichen Sprache natürlich macht.

Die Untersuchung aller Koartikulationsoptionen, die durch neuronale Aktivität gesteuert werden, wird auch eine Rolle bei der Entwicklung von Sprachsynthesetechnologien für Menschen spielen, die die Sprechfähigkeit verloren haben, deren neuronale Funktionen jedoch erhalten geblieben sind.

Um Menschen mit Behinderungen zu helfen

, werden auch Systeme verwendet, die nach dem entgegengesetzten Prinzip arbeiten - AI-basierte Tools, mit denen Sprache in Text umgewandelt werden kann. Das Vorhandensein von Intonationen und Akzenten in der Sprache ist auch eine Schwierigkeit für diese Technologie. Ihre Anwesenheit verhindert, dass Algorithmen für künstliche Intelligenz einzelne Wörter erkennen.

Mitarbeiter von Cisco, dem Moskauer Institut für Physik und Technologie und der Higher School of Economics haben kürzlich

eine mögliche Lösung für das Problem der Umwandlung von amerikanischem Englisch in Text vorgestellt. Ihr System verwendet die

CMUdict- Aussprachebasis und wiederkehrende neuronale Netzwerkfunktionen. Ihre Methode besteht in der automatischen vorläufigen „Reinigung“ der Sprache von „zusätzlichen“ Geräuschen. In Bezug auf den Klang kommt die Sprache dem gesprochenen amerikanischen Englisch nahe, ohne dass regionale oder ethnische „Spuren“ klar zum Ausdruck gebracht werden.

Die Zukunft der Sprachforschung

In Zukunft

möchte Professor Chang auch untersuchen

, wie das Gehirn von Menschen, die Chinesisch sprechen, funktioniert. In ihnen können Variationen in der Frequenz des Grundtons die Bedeutung des Wortes erheblich verändern. Wissenschaftler interessieren sich dafür, wie Menschen in diesem Fall unterschiedliche phonetische Konstruktionen wahrnehmen.

Benjamin Dichter, einer von Changs Kollegen,

glaubt ,

dass der nächste Schritt darin besteht, die Beziehung zwischen Gehirn und Kehlkopf weiter zu verstehen. Das Team muss nun lernen, wie es erraten kann, welche Tonfrequenz der Sprecher wählen wird, indem er seine neuronale Aktivität analysiert. Dies ist der Schlüssel zur Schaffung eines Synthesizers für natürlich klingende Sprache.

Wissenschaftler

glauben, dass es in naher Zukunft nicht möglich sein wird, ein solches Gerät herauszubringen, aber das Studium von Dichter und dem Team wird die Wissenschaft näher an den Moment bringen, in dem der künstliche Sprachapparat lernt, nicht nur einzelne Wörter, sondern auch Intonationen zu interpretieren, was bedeutet, der Sprache Emotionen hinzuzufügen.

Interessanter über den Sound - in unserem Telegrammkanal :

Wie klang Star Wars?

Wie klang Star Wars?

Ausgefallene Audio-Gadgets

Ausgefallene Audio-Gadgets

Klänge aus der Welt der Albträume

Klänge aus der Welt der Albträume

Kino auf den Tellern

Kino auf den Tellern

Musik bei der Arbeit

Musik bei der Arbeit