In diesem Artikel werden die Ergebnisse von Messungen der Zugriffsgeschwindigkeit auf das Dateisystem im Hypervisor in verschiedenen ZFS-Installationsoptionen veröffentlicht. Allen Interessierten bitte ich um einen Schnitt, ich warne vor dem Vorhandensein einer großen Anzahl von Bildern unter Spoilern (optimiert).

Hallo allerseits! Es gibt viele Materialien im Netzwerk, die sich mit dem ZFS-Dateisystem (im Folgenden als FS bezeichnet), seiner Entwicklung unter Linux und seiner praktischen Anwendung befassen. Ich war sehr an diesem FS im Zusammenhang mit der Verbesserung meines

Heimvirtualisierungsservers interessiert (sowie dank des

kvaps- Benutzerbeitrags), konnte aber im Internet keine vergleichenden Leistungstests für virtualisierte Maschinen finden (vielleicht habe ich schlecht gesucht). Aus diesem Grund habe ich beschlossen, eine Testplattform für meine Vergleichsstudie zusammenzustellen.

Mein Artikel gibt nicht vor, eine wissenschaftliche Entdeckung zu sein. Es ist unwahrscheinlich, dass er Fachleuten hilft, die schon lange mit ZFS arbeiten und alle seine Funktionen kennen. Er hilft Anfängern jedoch dabei, den „Preis“ jedes Gigabytes geteilt durch die Leistung ungefähr zu schätzen.

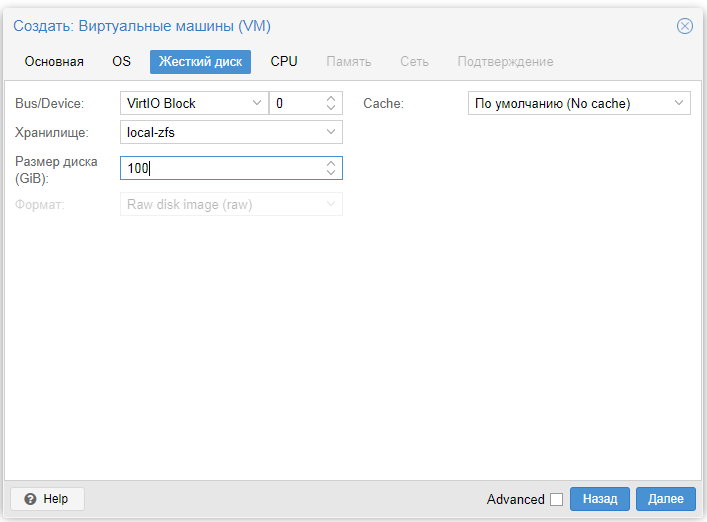

Die Essenz des Experiments war wie folgt: Proxmox VE 5.2 wurde auf dem Computer installiert (jedes Mal von einer Bootdiskette). Während der Installation wurde eine der XFS / ZFS-Optionen ausgewählt. Danach wurde eine virtuelle Maschine erstellt, auf der Windows Server 2008 R2 installiert wurde. Anschließend wurde das beliebte Dienstprogramm CrystalDiskMark 5.2.2 gestartet und Tests wurden auf Volumes von 1, 4,

32 GiB ausgeführt (aufgrund des Verlusts von Bildern mit den Ergebnissen von 32 GiB-Tests können Sie es bei der Auswahl nicht verwenden Lösungen, verfügbare Daten werden für Extras bereitgestellt).

Der XFS FS-Test wurde verwendet, um die Referenzgeschwindigkeit einer Festplatte zu messen (möglicherweise ist dies falsch, aber ich habe nicht an andere Optionen gedacht, um sie zu bewerten).

Tests ZFS RAID 0, RAID 1 wurden auf zwei zufällig ausgewählten Festplatten durchgeführt, ZFS RaidZ1 auf 3 Festplatten, ZFS RAID 10, RaidZ2 auf 4 Festplatten. Tests mit ZFS RaidZ3 wurden nicht durchgeführt, da nicht der Wunsch bestand, eine weitere äußerst kostengünstige 500-GB-Festplatte zu kaufen.

Unter dem Spoiler werde ich kurz jeden der ZFS-RAID-Typen anhand meines Beispiels für das empfangene Volumen von "kommerziellen" Gigabyte beschreiben:

ZFS-RAID2 Scheiben:

- ZFS RAID 0 - Striped, 2 * DiskSize = 1000 GB.

- ZFS RAID 1 - Spiegelung (Spiegelung), Volume 1 * DiskSize = 500 GB.

3 Scheiben:

- ZFS RaidZ1 - auch bekannt als ZFS RaidZ, ein Analogon zu RAID5, Volume (N - 1) * DiskSize = 1000 GB.

4 Scheiben:

- ZFS RAID 10 - Striped Mirrored, 2 * DiskSize = 1000 GB.

- ZFS RaidZ2 - ein Analogon von RAID6, die Menge von (N - 2) * DiskSize = 1000GB.

- Gleichzeitig habe ich keinen solchen Test durchgeführt, sondern ZFS RaidZ1 mit 4 Festplatten = 1500 GB.

Das Wesentliche

ist hier sehr klar. Und auch, wie viele Festplatten verloren gehen dürfen, um die Informationen zu speichern.

Ich möchte darauf hinweisen, dass zusätzlich zu den unterschiedlichen Zugriffsgeschwindigkeiten des Dateisystems noch das Gesamtvolumen des resultierenden Arrays und die Zuverlässigkeit der Datensicherheit bei Ausfall von Festplatten berücksichtigt werden müssen.

Technische Eigenschaften der Plattform, die (möglicherweise) die Testergebnisse beeinflussen:

- Hauptplatine: Intel Desktop Board DS67SQ-B3;

- Prozessor: Intel Pentium G630 2,7 GHz;

- RAM: 2 x 4096 MB Hynix PC3-10700;

- Festplatten: 3 x WD 5000AZRX 500 GB SATA 64 MB Cache, 1 x WD 5000AZRZ 500 GB SATA 64 MB Cache, SSD SATA Goldenfir T650-8 GB;

- Stromversorgung: DeepCool DA500N 500W.

Der virtuellen Maschine (KVM) für Tests wurden 4 GB RAM, 1 Prozessorkern und eine VirtIO Block 100 GB-Festplatte zugewiesen.

Für auf ZFS installierte Systeme wurden 2 Tests durchgeführt, bei der zweiten wurde die SSD als Cache-Laufwerk angeschlossen.

Alle Ergebnisse sind unten als Screenshots dargestellt. Wenn jemand diese Ergebnisse digitalisieren möchte, bin ich dankbar und nehme die Ergebnisse der Arbeit in den Artikel auf.

Vielen Dank an alle, die aufgepasst haben, ich hoffe, dass dieses Beispiel für jemanden wie für mich nützlich sein wird.

PS Aus irgendeinem Grund verstehe ich nicht, einige der Bilder sind irgendwo verschwunden, Messungen wurden Ende des Frühlings durchgeführt, die Testplattform konnte nicht in dieser Form zusammengebaut werden, glücklicherweise fielen alle auf Tests mit 32 GiB.

PPS Ich habe nicht versucht, für Organisationen und / oder Softwareprodukte zu werben. Ich wollte keine Lizenzvereinbarungen verletzen. Wenn ich mich irgendwo geirrt habe, schreibe bitte in private Nachrichten.

PPPS Das ZFS-Logo ist eine Reproduktion.