Ich habe mich entschlossen, diesen Artikel im Anschluss an diesen Beitrag zu schreiben.

Ich möchte Sie an einen kurzen Punkt erinnern: In der Zeitschrift Nature wurden die Ergebnisse einer mit

diesem Test durchgeführten Studie veröffentlicht.

Worüber möchte ich schreiben?

Erstens, warum diese Studie für die Lösung des genannten Problems und in der Form, in der sie durchgeführt wurde, absolut nutzlos ist.

Zweitens, wie man eine solche Studie priorisiert.

Versuchen Sie drittens, verschiedene Unfallszenarien unter den im Test angegebenen Bedingungen zu simulieren.

In diesem Beitrag hat der Autor nicht von Anfang an vergeblich einen Link zum Test eingefügt. Dies würde dazu beitragen, bedeutungslose Kommentare von Personen zu vermeiden, die die ursprüngliche Botschaft der Studie nicht verstanden haben.

Bitte machen Sie mindestens ein paar Mal einen Test , um das Diskussionsthema zu verstehen.

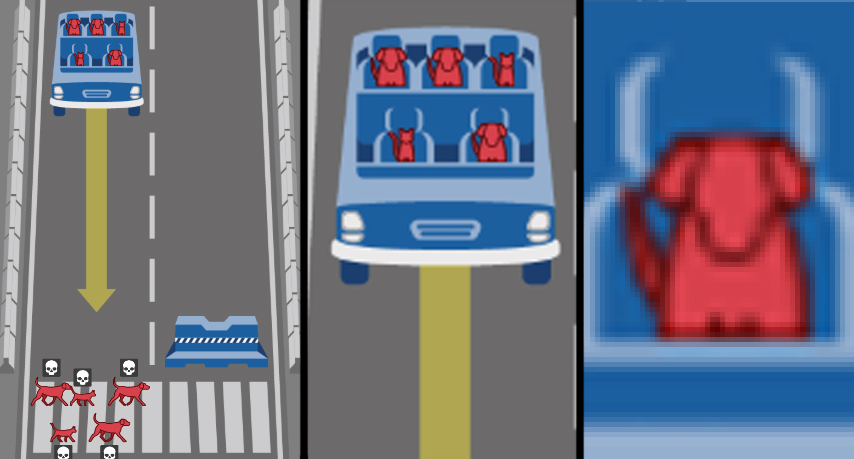

Was sie versprochen haben, uns in der Studie zu zeigen

Die Diskussion des ersten Beitrags, episch für Habr, zeigte, dass die Mehrheit der Menschen nicht weiß, wie sie unter den gegebenen Bedingungen denken sollen, sondern anfängt zu phantasieren: "Sterben einige Menschen im Test?" Immerhin können Sie beide Fußgänger und den Block / seitwärts umgehen, um die Handbremse / das Zahnrad zu reiben / bremsen? Aber ich würde ... ". Verstehen Sie, dass dies ein vereinfachtes Beispiel für die Entwicklung von Aktionsalgorithmen und -richtlinien zur Regulierung des Autopilotverhaltens auf der Straße ist! Unter dem Gesichtspunkt der Entwicklung von Sicherheitsregeln sind solche Extreme und Vereinfachungen gerechtfertigt. Es geht um die möglichen Konsequenzen, auf die die Menschen vorbereitet sein sollten. Soldaten gehen nicht zu Minenfeldern, nicht weil dort jeder Quadratzentimeter abgebaut wird, sondern wegen der Wahrscheinlichkeit zu sterben. Es ist normalerweise nicht sehr hoch, aber niemand wird es riskieren. Daher ist im Test die Wahl zwischen 100% Tod aller Passagiere oder aller Fußgänger angemessen - so bezeichnen wir das Risiko, wenn man bedenkt, dass es inakzeptabel ist, Leben in unserer Gesellschaft zu riskieren.

Die Botschaft der Studie lautet: Sie, die Menschen, die jetzt leben, müssen in einer Welt der Zukunft leben, die mit Autos auf dem Autopiloten gefüllt ist. Und für uns, Entwickler von Automobilen, KI und anderen Dingen, ist es wichtig zu wissen, aber wie sollten sich Roboterroboter Ihrer Meinung nach verhalten? Nun, hier sind Sie, ja, ja, Sie sind es - sagen Sie mir, was ich mit einem Robomobil tun soll, wenn Kopf und Katze darin fahren und es dabei ist, Obdachlose und Hunde zu vernichten? Welche Ethik sollten Robomobile haben, wenn sie sich entscheiden müssen?

Und nachdem wir das ursprüngliche Motiv für die Studie identifiziert haben, möchte ich einige Aspekte davon diskutieren.

Was die Studie tatsächlich zeigte

Das erste, was auffällt, ist, dass das Forschungsdesign überhaupt nicht auf das erklärte Ziel abzielt. Die in Form von Dilemmata gestellten Aufgaben eignen sich nicht zur Schaffung einer „Ethik“ des Verhaltens von Roboterautos. Eher nicht alle. Hier sind die Dilemmata, die die Aufgabe erfüllen, „Regeln für das Verhalten eines Roboterautos zu entwickeln, um die Schwere der Folgen eines Unfalls zu verringern“:

- "Passagier / Fußgänger" - wählen Sie, wer gespeichert werden soll;

- "Verstoß gegen Verkehrsregeln" - entscheiden Sie, ob bewusstlose Fußgänger geopfert werden sollen;

- „Anzahl potenzieller Opfer“ - Wählen Sie aus, ob die Anzahl der Opfer Vorrang hat.

Und dann kommen die Parameter, die, wie sich herausstellt, für die Verurteilung in unserer zivilisierten Gesellschaft sehr wichtig sind. Die Leute wurden ehrlich und unschuldig gefragt: Ihr Niveau an Sexismus, Lukismus, Ageismus? Sind Sie für die Unterscheidung von Fett oder nicht klassifiziert? Und schließlich antworteten Hunderttausende ehrlich ...

Bravo!

Genau in den besten Traditionen unterhaltsamer Filme und Serien, wenn die Welt der Hauptfiguren tatsächlich ein großer Sandkasten hinter einem hohen Zaun ist und es ihr Verhalten ist, das ein Experiment ist! Soziologen, Psychologen und Kulturwissenschaftler erhielten unter dem Deckmantel der überaus wichtigen Forschung auf dem Gebiet der Robotik und KI eine so aussagekräftige Stichprobe zum Trolley-Problem , von der noch niemand zuvor geträumt hatte! Nun, außer dass die Hautfarbe nicht zur Umfrage hinzugefügt wurde, aber dann würden die rassistischen Obertöne der Studie mit Weiß genäht ... oh.

Im Ernst, dieser geschlechtsphänotypische Teil der Studie wird durch kategoriale Argumente abgeschnitten. Das erste Argument ist der Humanismus. Als zivilisierte Menschen müssen wir den Vorrang des Wertes des menschlichen Lebens vor allen individuellen Unterschieden stellen. Das heißt, die Formulierung der Frage ist als diskriminierend empörend. Das zweite Argument: Viele Unfälle ereignen sich, und in der Grenze wird die Verteilung der Opfer nach Aussehen, Bildung, Geschlecht und Alter zu ihren gesellschaftlichen Anteilen tendieren. Daher ist es zumindest seltsam, dies zusätzlich zu regeln. Das dritte Argument: Es erscheint nicht ratsam, künstliche Intelligenz zu schaffen, die einen Anzug von Brioni von einem Pullover von Bershka unterscheidet, um weiter zu vergleichen, ob eine Person Status hat und ob es sich lohnt, sie zu vernichten. Außerdem würde ich nicht darauf vertrauen, dass die KI urteilt - ein obdachloser Fußgänger oder ein Wissenschaftler? (Hallo zu den Frisuren der angesehenen Wissenschaftler Perelman oder Gelfand :))

Zusätzlich zu diesen unnötigen Parametern verwerfen wir leicht die verbleibenden zwei: Speziesspezifität und Nichteinmischung. Ja, wir werden kleine Tiere vernichten, um Menschen zu retten, die gedacht hätten. Und was den Parameter „Intervention / Nichtinterferenz“ durch Manövrieren betrifft, so ist dieser wesentliche Teil des Trolley-Problems nicht nur ein Hindernis für das Auto, da die Maschine nicht nach der Ethik handelt, sondern nach den darin festgelegten Algorithmen. Und da wir uns die Aufgabe gestellt haben, wie sich das Auto bei einem Unfall mit einer Kollision mit Menschen verhalten soll, gehen wir im Wortlaut davon aus, dass es sich irgendwie verhalten muss. Heutzutage bewältigt der Schienenverkehr erfolgreich unkomplizierte Kollisionen ohne Konsequenzen, und wir entwickeln eine Politik zur Minimierung der Opfer von Verkehrsunfällen.

Dies bedeutet, dass wir die rationalen Körner der Forschung vom soziopsychologischen Experiment getrennt haben, um das Ausmaß der Intoleranz in der Weltgesellschaft zu untersuchen. Wir arbeiten weiter mit den ersten drei genannten Dilemmata. Und es gibt etwas zu zerlegen. Bei näherer Betrachtung stellen sich heraus, dass sie unvollständig sind ...

Drei Dilemmata von Roboterautos

Verstoßen Fußgänger gegen Verkehrsregeln? Hier drückt die Mehrheit ausdrücklich den Sozialdarwinismus oder eine stillschweigend bedauerliche, bedauerliche Reaktion aus - vielmehr müssen sie diejenigen, die gegen die Regeln verstoßen, zugunsten der Unschuldigen opfern. Bewusste Menschen fahren nicht auf Schienen, weil sie wissen, dass der Zug nicht anhalten wird - lassen Sie sie wissen, dass das Robomobil auch nicht anhalten wird. Alles ist logisch, wenn auch zynisch. Aber in diesem listigen Dilemma verbirgt sich Einseitigkeit, Unvollständigkeit. Fußgänger, die gegen Verkehrsregeln verstoßen, sind nur eine von vielen Situationen. Aber wenn das Roboterauto kaputt geht ?? Diese Situation wurde nicht berücksichtigt, aber sie (die Kameras des Autos haben ein Schild oder eine Ampel übersehen) ist theoretisch viel wahrscheinlicher als ein plötzlicher Bremsausfall. Allerdings habe ich wieder in der Fantasie und insbesondere getroffen. Es ist wichtiger, im Test nur die äquivalente Reziprozität der Situation zu zeigen. Stellen Sie sich Folgendes vor: Wenn Fußgänger gegen Verkehrsregeln verstoßen, sterben sie, und dies ist „logisch“ und „richtig“. Wenn das Robomobil verletzt, sollte er für diesen Fehler Selbstmord begehen? Vergessen Sie nicht, dass gleichzeitig der Anführer, der Landstreicher und die darin sitzende Katze sterben! Dies ist eine wichtige Korrektur, im Test jedoch nicht.

Weiter. Die Anzahl der potenziellen Opfer. Auch hier ist das nicht so einfach. Verwerfen Sie Geschlechterstereotype und Respekt vor dem Alter, Verachtung für die Fetten und Obdachlosen. Wir gehen davon aus, dass sie bei einem Unfall proportional zu der Häufigkeit sterben, mit der sie in der Natur vorkommen. Und wir werden entscheiden: Drei sterben besser als fünf. Klingt das logisch? Gut. Lassen Sie uns all diese höllische Absurdität unterbrechen , aber wir haben eine abstrakte Simulation. Was ist besser - 50 oder 51 Menschen zu töten? 1051 oder 1052? Das ist also nicht so wichtig? Was ist dann besser - 1 Fußgänger oder 50 Menschen in einem Bus zu töten? Und jetzt ist es wichtig geworden? Und wohin geht diese Linie? Ist jede zusätzliche Person wertvoll? Aber ist es wichtig, wenn auf lange Sicht Tausende von Menschen bei Verkehrsunfällen sterben? Wie im Fall des Auftretens wird in der Realität eine angemessene Schätzung der Anzahl potenzieller Opfer unter Verwendung von KI äußerst schwierig sein. Das einzige, was Sinn macht, ist die Bedingung, dass nicht eingegriffen wird (kein Manövrieren), wenn die Anzahl der Opfer gleich ist.

Der dritte Aspekt sorgte in den Kommentaren zu diesem ersten Artikel über Habré für große Kontroversen. Und nach den Ergebnissen der Studie zu urteilen, ist sie für die Gesellschaft völlig zweideutig, und hier liegt das Hauptproblem, das gelöst werden muss. Es geht darum, wen man riskiert - Fußgänger oder Passagiere?

Einige sagen, dass Fußgänger für nichts verantwortlich sind, was bedeutet, dass sie an erster Stelle gerettet werden müssen. Im Allgemeinen ist es heute unter Stadtbewohnern Mode, sich um Fußgänger zu kümmern, ganze Straßen zu Fußgängern zu machen, alle 50 Meter Kreuzungen mit einer Ampel zu erstellen, die Verkehrsgeschwindigkeit im Zentrum zu verringern und Fußgängern Vorrang einzuräumen. Auch hier ist es notwendig, sie irgendwie zu sichern, und eine Robotermaschine, die ohne Bremsen in der Menge fliegt, sollte sich selbst zerstören, um die am stärksten gefährdeten Teilnehmer der Bewegung zu retten. Aus meiner Sicht haben sie Recht, dass Fußgänger die Verhaltensbedingungen des Roboterautos eines anderen nicht unterschrieben haben. Sie könnten generell gegen ihre Einführung sein. Gleichzeitig ist es unmöglich, sich den Passagier einer solchen Maschine vorzustellen, der mit den Bedingungen für ihre Verwendung nicht einverstanden ist. Daher ist die Situation ein Interessenkonflikt. Es ist bequemer für mich, dich zu töten, und ich werde dich töten, wie eine Person zu einer anderen sagt.

Die zweiten sagen, dass jeder, der ein Roboterauto kauft und generell in dieses steigt, die Garantie haben sollte, dass sie ihn im Falle eines Unfalls retten und keinen Arzt, ein Kind oder zwei Katzen töten, um eine Kreuzung zu retten. Einerseits sieht es logisch und gerechtfertigt aus, andererseits stellt der Passagier in diesem Fall sein Leben bewusst über andere. Beim Kauf eines Autos mit einem Autopiloten steht jedem seiner Besitzer die perfekte Waffe zur Verfügung, eine Silberkugel, eine ungelenkte Rakete, eine Maschine, die jede andere Person auf ihrem Weg legal vollständig tötet.

Beide Seiten mit Schaum im Mund ziehen über das "erste Gesetz der Robotik", das aus der Science-Fiction stammt. Es klingt demagogisch schön, aber niemand versucht es zu verstehen oder in Bezug auf das Problem herauszufordern. Sie ist jedoch auf diese Formulierung des Problems nicht anwendbar, da Konzepte ersetzt werden: Die Heuristik / KI der Maschine wählt nicht zwischen den Werten des menschlichen Lebens, sondern handelt streng nach den Algo-Rhythmen, die auf der Grundlage der von Menschen erfundenen subjektiven Prioritäten erstellt wurden. Und hier spielt es keine Rolle, welche Art von sozialem Konstrukt bei der Wahl von "töten / verschonen" als Priorität angesehen wird: die Körpermasse, die wir zuvor abgelehnt haben, Alter und Status oder die sozialdarwinistische Selbstsucht des Autobesitzers.

Der zweite Ansatz, ein einseitiger Angriff auf das Leben von Fußgängern, macht die Forschung von einem Trolley-Problem zum klassischen Dilemma eines Gefangenen . Wenn die Parteien zu einem Kompromiss kommen, ist eine allgemeine Entwicklung (Einführung von Robomobilen) mit minimaler Verschlechterung für einige möglich (Minimierung der Anzahl unvermeidlicher Todesfälle durch Robomobile) - was der Wunsch nach dem Pareto-Optimum ist. Es gibt jedoch immer einen Egoisten, der sich nur auf seine Interessen verlässt. "Er wird 20 Jahre alt, aber ich werde freigelassen." "Er wird sterben, wenn er die Straße überquert, obwohl die Bremsen mein Auto abgelehnt haben." Vielleicht ist dieser Ansatz gerechtfertigt, wenn Ereignisse im Leben einzeln sind und zwei Teilnehmer am Spiel teilnehmen. Wenn Zehntausende oder Hunderttausende von Teilnehmern anwesend sind und täglich Ausflüge stattfinden, wird ein solches Ein-Tor-Spiel zur Diskriminierung von Fußgängern.

Persönlich glaube ich, dass das Passagier- / Fußgänger-Dilemma im Rahmen des formulierten Problems zu einer Sackgasse führt. Eine Maschine, die möglicherweise diejenigen tötet, die sich darauf eingelassen haben, ist aus Sicht des gesunden Menschenverstandes absurd und wird natürlich keine Käufer auf dem Markt finden. Ein Auto, das absichtlich Fußgänger tötet, ist in einer zivilisierten Gesellschaft als Element positiver Diskriminierung und Bedrohung des Lebens der Menschen unmöglich.

Wir gehen weiter. Der Artikel diskutiert nicht wirklich und bedeutet keine Politik zur Minimierung der tragischen Folgen von Unfällen mit Robomobilen. Die Gesamtsummen sind in "Regionen" unterteilt, die sich in ihren Prioritäten erheblich unterscheiden und eher zweideutig sind (es gibt Erklärungen zu "religiösen Merkmalen und kolonialem Einfluss", aber ... im Allgemeinen Grüße an den Irak mit Afghanistan in "West" und Frankreich mit der Tschechischen Republik in " Südlicher Sektor). Und so dreht sich die Frage in der Sprache: Werden Sie für jedes Land Robomobile mit unterschiedlicher "Ethik" herstellen?

Die Autoren des Artikels in der Diskussion bezeichnen die drei von ihnen identifizierten „grundlegenden Grundblöcke“: Menschen (nicht Tiere) retten, mehr Leben retten, jüngere retten. Die Diagramme zeigen jedoch deutlich, dass die Menschen im östlichen Sektor etwas weniger Bevölkerung und Jugendliche haben, als es ihnen egal ist. Es stellt sich heraus, dass die ausgewählten vorrangigen Richtlinien der Meinung der überwältigenden Mehrheit widersprechen werden. Warum wurden dann überhaupt Leute befragt?

Vielleicht einfach zählen?

Aber kommen wir zum unterhaltsamen Teil dieses Beitrags.

Anstatt Menschen mit unterschiedlichen soziokulturellen Auswirkungen und wahrscheinlich in 99% der Fälle mit nicht zum Kern gehörender Ausbildung um Rat in Bezug auf Robotik zu bitten, wenden wir uns einem unparteiischen Instrument zu. Nehmen wir die am Anfang des Artikels ausgewählten Dilemmata. Unter den Testbedingungen erstellen wir die einfachste Computersimulation. Und wir werden die Anzahl der toten Verkehrsteilnehmer bewerten.

Und denken Sie daran: Unsere Aufgabe als Politiker im Bereich der Verkehrssicherheit ist es, die Gesamtzahl der Opfer zu reduzieren. Wir werden im Rahmen und in den Konventionen des ursprünglichen Moral Machine-Tests arbeiten, wobei der Schwerpunkt auf dem Lebensrisiko von Verkehrsunfallteilnehmern liegt und nicht auf komplexen realistischen Bewertungen einer Autokollision mit einem Hindernis oder Personen. Wir haben kein EuroNCAP, wir werden Python haben.

Zunächst schreiben wir einen Code, der das Dilemma erfüllt, "diejenigen zu retten, die mehr sterben". Im Rahmen des Moral Machine-Tests machen wir zufällig 1 bis 5 Passagiere und Fußgänger, stellen die Bedingung ein, wenn Fußgänger> Passagiere das Auto sofort auf einem Betonblock töten. Wir tragen zum Beispiel 10.000 solcher Unfälle.

Ich höre nicht auf den Anspruchscode, sondern habe zum ersten Mal in meinem Leben etwas in Python geschriebennpedtotal = 0

npasstotal = 0

ndeadped = 0

ndeadpass = 0

# 0 0

n=0

while n < 10000:

#10000

nped = random.randint(1, 5)

npass = random.randint(1, 5)

# 1 5

npedtotal += nped

npasstotal += npass

#

if nped > npass:

ndeadpass += npass

else:

ndeadped += nped

# ,

# .

# .

n += 1

print (" ", npedtotal)

print (" ", npasstotal)

print (" ", ndeadped, "(",100*ndeadped/npedtotal, "%",")")

print (" ", ndeadpass, "(",100*ndeadpass/npasstotal,"%"")")

print (" ", ndeadped + ndeadpass, "(",100*(ndeadped + ndeadpass)/(npasstotal+npedtotal), "%", ")")

…

29960

29924

13903 ( 46.4052069426 % )

8030 ( 26.8346477744 %) 21933 ( 36.6258098991 % )

, ! , !

. . , . – , « » 4 5, == . , 20 20 , , , 5 – , 5 – . : , , . > >= :

29981

29865

7859 ( 26.2132684033 % )

14069 ( 47.1086556169 %)

21928 ( 36.6407111586 % )

, occupants, - , . , . 30000 , 100% — .

, , . – , , 50% , 30000.

– . , , , ! , : , , , , , . , : .

, -```python

import random

npedtotal = 0

npasstotal = 0

ndeadped = 0

ndeadpass = 0

# 0 0

n=0

while n < 10000:

#10000

nped = random.randint(1, 5)

npass = random.randint(1, 5)

trafficlight = random.randint(0, 1)

# 1 5

#

npedtotal += nped

npasstotal += npass

#

if trafficlight == 0:

ndeadped += nped

else:

if nped > npass:

ndeadpass += npass

else:

ndeadped += nped

# ,

# .

# .

n += 1

print (« », npedtotal)

print (« », npasstotal)

print (« », ndeadped, "(",100*ndeadped/npedtotal, "%",")")

print (« », ndeadpass, "(",100*ndeadpass/npasstotal,"%"")")

print (« », ndeadped + ndeadpass, "(",100*(ndeadped + ndeadpass)/(npasstotal+npedtotal), "%", ")")

```

">"

29978

29899

21869 ( 72.9501634532 % )

4042 ( 13.5188467842 %)

25911 ( 43.2737111078 % )

">="

30152

30138

19297 ( 63.9990713717 % )

6780 ( 22.4965160263 %)

26077 ( 43.2526123735 % )

, , . ( ).

, . – .

. , , . Moral Machine, , , . - , .

, , , . – , , . . – , , , . , – .

, - , . , , , . – , , .

. . , . .