Trotz der Zuverlässigkeit moderner Rechenzentren ist für kritische Einrichtungen ein weiteres kritisches Maß an Redundanz erforderlich, da die gesamte IT-Infrastruktur aufgrund einer vom Menschen verursachten oder Naturkatastrophe ausfallen kann. Um die Katastrophenverträglichkeit sicherzustellen, müssen Sicherungs-Rechenzentren erstellt werden. Unter dem Schnitt unsere Geschichte über die Probleme, die sich aus ihrer Kombination ergeben (DCI - Data Center Interconnection).

Das von der Menschheit verarbeitete Datenvolumen ist zu unglaublichen Werten gewachsen, und die Rolle der IT-Infrastruktur in Geschäftsprozessen ist so groß, dass selbst kurzfristige Ausfälle das Unternehmen vollständig lähmen können. Überall werden digitale Technologien eingeführt, von denen insbesondere der Finanzsektor, die Telekommunikation oder beispielsweise der große Internethandel abhängig sind. Die Zuverlässigkeit von Rechenzentren reicht für einen großen Cloud-Anbieter, eine Bank oder einen großen Telekommunikationsbetreiber nicht aus: Verluste durch kleine Ausfallzeiten können in astronomischen Mengen berechnet werden, und um dies zu vermeiden, ist eine katastrophenresistente Infrastruktur erforderlich. Sie können es nur durch Erhöhen der Redundanz erstellen - Sie müssen Backup-Rechenzentren erstellen.

Trennung von Hochverfügbarkeit und Notfallwiederherstellung

Rechenzentren oder Geräte von Unternehmen, die in gemieteten Räumlichkeiten installiert sind, können kombiniert werden. Die Fehlertoleranz von geoverteilten Lösungen wird durch die Softwarearchitektur erreicht, und Eigentümer können in ihren eigenen Einrichtungen sparen: Sie müssen kein Rechenzentrum aufbauen, z. B. ein Tier III- oder sogar Tier II-Level. Sie können Dieselgeneratoren aufgeben, Open-Frame-Server verwenden, mit extremen Temperaturbedingungen spielen und andere interessante Tricks ausführen. Auf gemieteten Flächen gibt es weniger Freiheitsgrade, hier legt der Anbieter die Spielregeln fest, aber die Prinzipien der Vereinigung sind dieselben. Bevor auf katastrophenresistente IT-Services eingegangen wird, sollten drei magische Abkürzungen erwähnt werden: RTO, RPO und RCO. Diese wichtigen Leistungsindikatoren bestimmen die Fähigkeit der IT-Infrastruktur, Störungen standzuhalten.

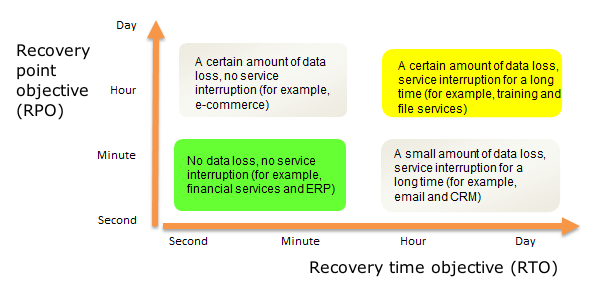

RTO (Recovery Time Objective) - zulässige Zeit für die Wiederherstellung eines IT-Systems nach einem Vorfall;

RPO (Recovery Point Objective) - Datenverlust während der Notfallwiederherstellung akzeptabel. Sie wird normalerweise als der maximale Zeitraum gemessen, in dem Daten verloren gehen können.

RCO (Recovery Capacity Objective) ist Teil der IT-Last, die das Backup-System übernehmen kann. Der letztere Indikator kann in Prozent, Transaktionen und anderen "Papageien" gemessen werden.

Es ist wichtig, zwischen Hochverfügbarkeitslösungen (HA) und Notfallwiederherstellungslösungen (DR) zu unterscheiden. Der Unterschied zwischen ihnen kann in Form eines Diagramms mit RPO und RTO als Koordinatenachsen dargestellt werden:

Im Idealfall verlieren wir keine Daten und verschwenden keine Zeit mit der Wiederherstellung nach einem Fehler. Die Sicherungssite stellt die volle Funktionalität der Dienste sicher, auch wenn der Hauptdienst zerstört wird. Null RTO und RPO können nur mit dem synchronen Betrieb von Rechenzentren erreicht werden: Tatsächlich handelt es sich um einen geografisch verteilten fehlertoleranten Cluster mit Echtzeit-Datenreplikation und anderen Freuden. Im asynchronen Modus ist die Datenintegrität nicht mehr garantiert: Da die Replikation in regelmäßigen Abständen erfolgt, können einige Informationen verloren gehen. Die Zeit für den Wechsel zum Backup-Standort beträgt in diesem Fall einige Minuten bis mehrere Stunden, wenn es um die sogenannte geht Kühlreserve, wenn die meisten Backup-Geräte ausgeschaltet sind und keinen Strom verbrauchen.

Technische Details

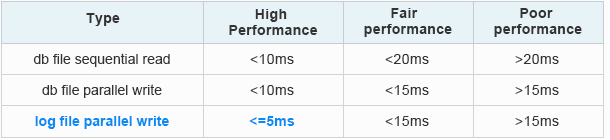

Die technischen Schwierigkeiten, die beim Kombinieren von zwei oder mehr Rechenzentren auftreten, werden in drei Kategorien unterteilt: Verzögerungen bei der Datenübertragung, unzureichende Bandbreite der Kommunikationskanäle und Probleme mit der Informationssicherheit. Die Kommunikation zwischen Rechenzentren erfolgt normalerweise über eigene oder gemietete Glasfaserkommunikationsleitungen, sodass wir später darauf eingehen werden. Bei DPCs, die im synchronen Modus arbeiten, sind Verzögerungen das Hauptproblem. Um eine Datenreplikation in Echtzeit sicherzustellen, sollten sie 20 Millisekunden und manchmal 10 Millisekunden nicht überschreiten - dies hängt von der Art der Anwendung oder des Dienstes ab.

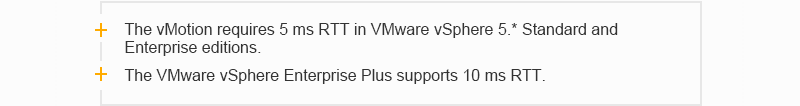

Andernfalls funktioniert beispielsweise die Fibre Channel-Protokollfamilie nicht, auf die in modernen Speichersystemen kaum verzichtet werden kann. Dort sollte die Verzögerung umso geringer sein, je höher die Geschwindigkeit ist. Es gibt natürlich Protokolle, mit denen Sie über Ethernet mit Speichernetzwerken arbeiten können, aber hier hängt vieles von den Anwendungen und installierten Geräten ab, die im Rechenzentrum verwendet werden. Im Folgenden finden Sie Beispiele für Latenzanforderungen für gängige Oracle- und VMware-Anwendungen:

Verzögerungsanforderungen für Oracle Extended Distance Cluster:

Aus offiziellen Oracle-Daten: So erkennen Sie, ob die E / A der Datenbank langsam ist [ID 1275596.1]

Aus offiziellen Oracle-Daten: So erkennen Sie, ob die E / A der Datenbank langsam ist [ID 1275596.1]VMware-Verzögerungsanforderungen:

Fallstudie zu VMware vSphere Metro Storage Cluster (VMware vSphere 5.0)

Fallstudie zu VMware vSphere Metro Storage Cluster (VMware vSphere 5.0)

Bei der Datenübertragung kann die Signalverzögerung in Form von zwei Komponenten dargestellt werden: T

total = T

equip. + T

s wobei T

äqu. - die Verzögerung, die durch den Durchgang des Signals durch das Gerät verursacht wird, und T

s - die Verzögerung, die durch den Durchgang des Signals durch die optische Faser verursacht wird. Die Verzögerung, die durch den Durchgang des Signals durch das Gerät (T-

Gerät ) verursacht wird, hängt von der Architektur des Geräts und der Methode der Datenkapselung während der optoelektrischen Signalumwandlung ab. In DWDM-Geräten wird diese Funktionalität den Transponder- oder Muxpondermodulen zugewiesen. Daher sind sie bei der Organisation der Kommunikation zwischen zwei Rechenzentren besonders vorsichtig bei der Auswahl des Transpondertyps (Muxponder), damit die Verzögerung am Transponder (Muxponder) am geringsten ist.

Im synchronen Modus spielt die Ausbreitungsgeschwindigkeit des Signals in der optischen Faser (T

s ) eine wichtige Rolle. Es ist bekannt, dass die Geschwindigkeit der Lichtausbreitung in einer optischen Standardfaser (z. B. G.652) vom Brechungsindex ihres Kerns abhängt und ungefähr 70% der Lichtgeschwindigkeit im Vakuum (~ 300.000 km / s) entspricht. Wir werden nicht tief in die physikalischen Grundlagen einsteigen, aber es ist leicht zu berechnen, dass die Verzögerung in diesem Fall etwa 5 Mikrosekunden pro Kilometer beträgt. Daher können zwei Rechenzentren in einer Entfernung von nur etwa 100 Kilometern synchron arbeiten.

Im asynchronen Modus sind die Verzögerungsanforderungen nicht so streng, aber wenn der Abstand zwischen den Objekten stark vergrößert wird, beginnt die Dämpfung des optischen Signals in der Faser zu wirken. Das Signal muss verstärkt und regeneriert werden, dh Sie müssen Ihr eigenes Übertragungssystem erstellen oder Amtsleitungskommunikationskanäle leasen. Das Verkehrsaufkommen zwischen den beiden Rechenzentren ist recht groß und wächst tendenziell ständig. Die Haupttreiber des Verkehrswachstums zwischen Rechenzentren: Virtualisierung, Cloud-Dienste, Migration und Verbindung neuer Server und Speichersysteme. Hier kann das Problem einer unzureichenden Bandbreite der Datenübertragungskanäle auftreten. Eine Erhöhung auf unendlich funktioniert aufgrund des Fehlens eigener freier Fasern oder der hohen Mietkosten nicht. Der letzte wichtige Punkt betrifft die Informationssicherheit: Daten, die zwischen Rechenzentren ausgeführt werden, müssen verschlüsselt werden, was auch die Verzögerungen erhöht. Es gibt andere Punkte, wie die Komplexität der Verwaltung eines verteilten Systems, aber ihr Einfluss ist nicht so groß, und alle technischen Hindernisse hängen hauptsächlich mit den Merkmalen von Kommunikationskanälen und Endgeräten zusammen.

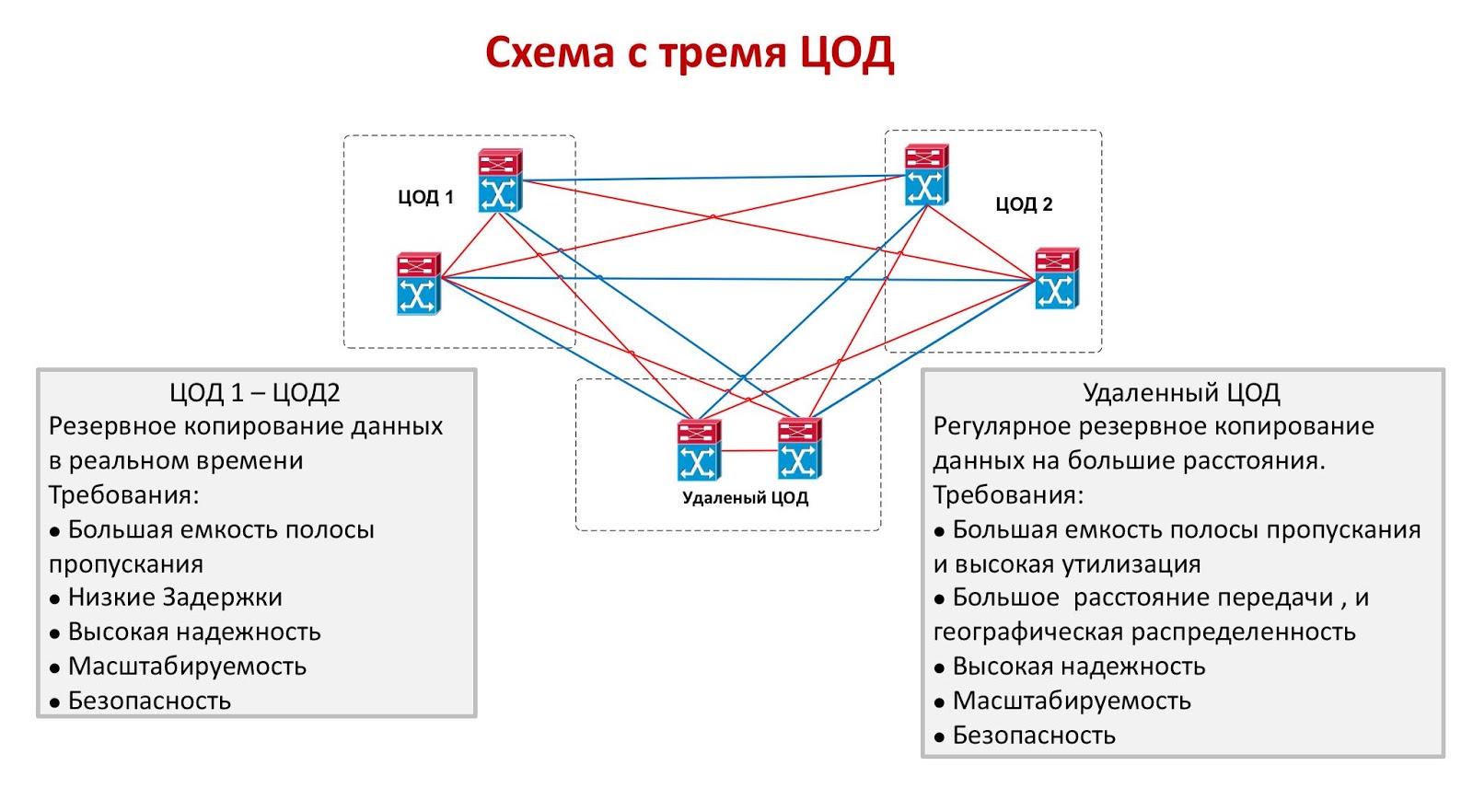

Zwei oder drei sind wirtschaftliche Schwierigkeiten

Beide Modi zum Kombinieren von Rechenzentren weisen erhebliche Nachteile auf. Synchron arbeitende Objekte sollten nahe beieinander liegen, was nicht das Überleben von mindestens einem von ihnen im Falle einer Katastrophe größeren Ausmaßes garantiert. Ja, diese Option ist zuverlässig vor menschlichem Versagen, vor Feuer, vor der Zerstörung des Maschinenraums infolge eines Flugzeugabsturzes oder vor einem anderen lokalen Notfall geschützt, aber es ist weit davon entfernt, dass beide Rechenzentren beispielsweise einem katastrophalen Erdbeben standhalten können. Im asynchronen Modus können Objekte Tausende von Kilometern voneinander entfernt sein, aber es wird sichergestellt, dass akzeptable RTO- und RPO-Werte fehlschlagen. Eine ideale Lösung wäre eine Schaltung mit drei Rechenzentren, von denen zwei synchron arbeiten, und das dritte befindet sich so weit wie möglich von ihnen entfernt und spielt die Rolle einer asynchronen Reserve.

Das einzige Problem mit den drei Rechenzentren sind die extrem hohen Kosten. Die Organisation eines einzigen Backup-Standorts ist nicht billig, und nur wenige können es sich leisten, zwei inaktive Rechenzentren zu behalten. Ein ähnlicher Ansatz wird manchmal im Finanzsektor verwendet, wenn die Transaktionskosten sehr hoch sind: Eine große Börse kann ein System mit drei kleinen Rechenzentren starten, im Bankensektor bevorzugen sie jedoch die Verwendung einer synchronen Kombination aus beiden. Andere Branchen kombinieren normalerweise zwei Rechenzentren, die im synchronen oder asynchronen Modus arbeiten.

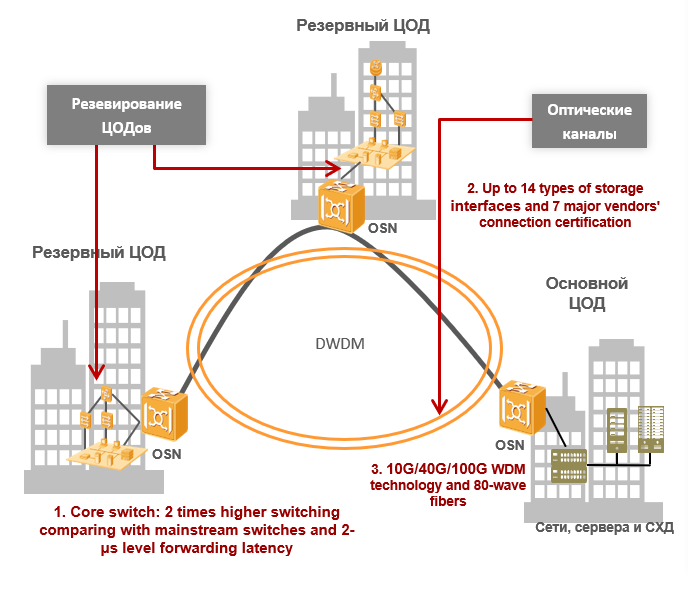

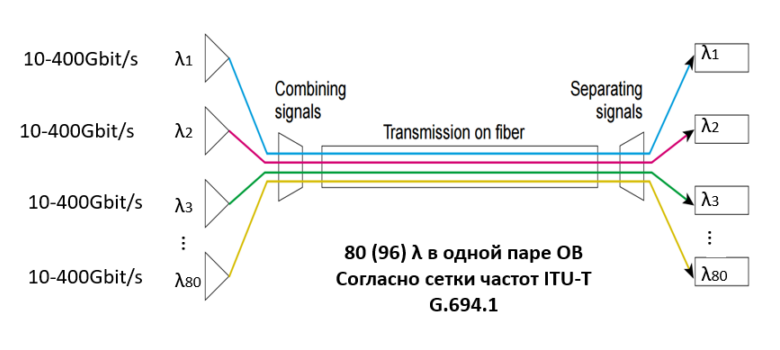

DWDM - Optimale Lösung für DCI

Wenn der Kunde die beiden Rechenzentren kombinieren muss, stößt er unweigerlich auf die oben genannten Probleme. Um sie zu lösen, verwenden wir die DWDM-Spektralmultiplextechnologie, die das Multiplexen einer Anzahl von Trägersignalen in eine einzelne optische Faser unter Verwendung verschiedener Wellenlängen (λ, dh Lambda) ermöglicht. Darüber hinaus kann es in einem optischen Paar bis zu 80 (96) Wellenlängen gemäß dem Frequenzgitter ITU-T G.694.1 geben. Die Datenübertragungsrate jeder Wellenlänge beträgt 100 Gbit / s, 200 Gbit / s oder 400 Gbit / s, und die Kapazität eines optischen Paares kann 80 λ * 400 Gbit / s = 32 Tbit / s erreichen. Es gibt bereits vorgefertigte Designs mit 1 Tbit / s pro Wellenlänge: Sie werden in naher Zukunft eine noch größere Bandbreite bieten. Heute wird das Problem der Kanalbandbreite vollständig gelöst: Anstelle zusätzlicher Fasern wird der Kunde die verfügbaren effizienter nutzen - die Nutzung des Datenverkehrs wird fantastische Werte erreichen.

Durch spektrales Multiplexen können wir Bandbreitenprobleme lösen. Für Rechenzentren, die im synchronen Modus arbeiten, ist dies völlig ausreichend, da die Verzögerungen bei der Datenübertragung zwischen ihnen aufgrund der kurzen Entfernung gering sind und mehr vom Typ des im DWDM-System verwendeten Transponders (oder Muxponders) abhängen. Es ist erwähnenswert, dass eines der Hauptmerkmale der DWDM-Spektralkomprimierungstechnologie die vollständig transparente Verkehrsübertragung ist, da die Technologie auf der ersten physischen Ebene des siebenstufigen OSI-Modells funktioniert. Wenn ich so sagen darf, ist das DWDM-System für seine Client-Verbindungen „transparent“, als ob sie über ein direktes Patchkabel verbunden wären. Wenn wir über den asynchronen Modus sprechen, hängt die Hauptverzögerung von der Entfernung zwischen den Rechenzentren ab (wir erinnern uns, dass es in OB eine Verzögerung von 5 Mikrosekunden pro Kilometer gibt), aber es gibt keine strengen Anforderungen für Verzögerungen. Daher wird der Übertragungsbereich durch die Fähigkeiten des DWDM-Systems bestimmt und durch drei Faktoren begrenzt: Signaldämpfung, Signal-Rausch-Verhältnis und Lichtstreuung im Polarisationsmodus.

Bei der Berechnung des optischen Teils der DWDM-Leitung werden alle diese Faktoren berücksichtigt und basierend auf den Berechnungen werden die Arten von Transpondern (oder Muxpondern), die erforderliche Anzahl und Art von Verstärkern sowie andere Komponenten des optischen Pfades ausgewählt. Mit der Entwicklung von DWDM-Systemen und dem Auftreten von Transpondern in ihrer Zusammensetzung, die einen kohärenten Empfang bei Geschwindigkeiten von 40 Gbit / s und 100 Gbit / s und höher unterstützen, wurde die Polarisationsmodendispersion von Licht als begrenzender Faktor nicht mehr berücksichtigt. Die Frage der Berechnung der optischen Linie und der Auswahl des Verstärkertyps ist ein großes separates Thema, bei dem der Leser die Grundlagen der physikalischen Optik kennen muss, und wir werden sie in diesem Artikel nicht im Detail erörtern.

Die WDM-Technologie kann Informationssicherheitsprobleme lösen. Natürlich muss die Verschlüsselung nicht auf optischer Ebene durchgeführt werden, aber dieser Ansatz hat eine Reihe unbestreitbarer Vorteile. Die Verschlüsselung auf höheren Ebenen erfordert häufig autonome Geräte für unterschiedliche Verkehrsströme und trägt zu erheblichen Verzögerungen bei. Mit zunehmender Anzahl solcher Geräte nehmen auch die Verzögerungen zu und die Komplexität des Netzwerkmanagements nimmt ebenfalls zu. Die optische OTN-Verschlüsselung (G.709 - ITU-T-Empfehlung, die das Frame-Format in DWDM-Systemen beschreibt) hängt nicht von der Art des Dienstes ab, erfordert keine separaten Geräte und ist sehr schnell - der Unterschied zwischen verschlüsseltem und unverschlüsseltem Datenstrom überschreitet normalerweise 10 nicht Millisekunden.

Ohne die Verwendung der DWDM-Spektralmultiplextechnologie ist es fast unmöglich, große Rechenzentren zu kombinieren und einen katastrophensicheren verteilten Cluster zu erstellen. Das über das Netzwerk übertragene Informationsvolumen wächst exponentiell und früher oder später werden die Möglichkeiten bestehender Glasfaserkommunikationsleitungen ausgeschöpft. Das Verlegen oder Mieten zusätzlicher Geräte kostet den Kunden viel mehr als der Kauf von Geräten. Tatsächlich ist die Versiegelung heute die einzige wirtschaftlich sinnvolle Option. Auf kurzen Entfernungen ermöglichen DWDM-Technologien die effizientere Nutzung vorhandener Glasfasern, wodurch die Nutzung des Verkehrs zum Himmel erhöht wird, und auf große Entfernungen werden Verzögerungen bei der Datenübertragung minimiert. Heute ist es vielleicht die beste auf dem Markt verfügbare Technologie, und es lohnt sich, sie genauer zu betrachten.