Heute werde ich über die hyperkonvergente SharxBase-Plattform sprechen. Es gab keine Überprüfung dieses Komplexes auf Habré, und es wurde beschlossen, dieser Ungerechtigkeit ein Ende zu setzen. Unser Team hat es geschafft, die Lösung "im Kampf" zu testen. Die Ergebnisse sind unten aufgeführt.

PS Es gibt viele Tische, reelle Zahlen und anderes „Fleisch“ unter dem Schnitt. Für diejenigen, die in die Essenz eingetaucht sind - willkommen!

Über das Produkt

Die SharxBase-Plattform basiert auf von Intel hergestellten Servern und OpenNebula- und StorPool-Open-Source-Software. Es handelt sich um eine Box-Lösung, die Serverhardware mit vorinstallierter Virtualisierung und verteilter Speichersoftware enthält.

Eine von vier grundlegenden Standardkonfigurationen - Klein, Mittel, Groß, Speicher - kann bestellt werden, die sich in der Menge der verfügbaren Computerressourcen (Prozessoren, RAM) und dem Speicherplatz unterscheiden. Die Server sind als Module konzipiert: Ein typisches 2-HE-Gehäuse, das bis zu vier Server aufnehmen kann, für die Installation in einem Standard-19-Zoll-Server-Rack. Die Plattform unterstützt sowohl die horizontale Skalierung durch Erhöhen der Anzahl der Knoten als auch die vertikale Skalierung durch Erhöhen der RAM-Größe in den Knoten Wir unterstützen derzeit die Installation von Netzwerkadaptern, Boot-Steuerungsmodulen und NVMe-Laufwerken.

Speicherarchitektur

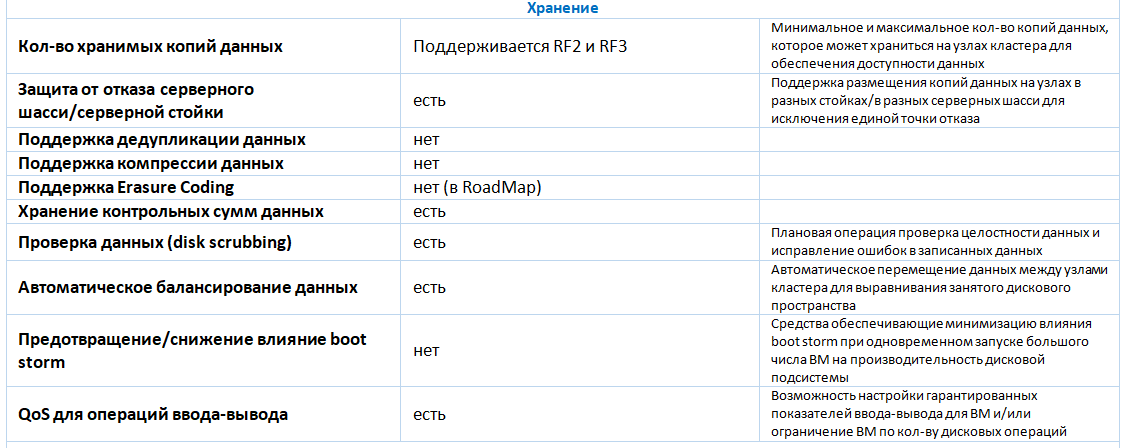

Für die Organisation verteilter fehlertoleranter Speicher werden Flash-Laufwerke (SSD und / oder NVMe) verwendet. Das verwendete Medium ist Ethernet. Um Speicherplatz zu übertragen, müssen dedizierte Netzwerkschnittstellen verwendet werden - mindestens zwei 25-GbE-Schnittstellen. Dienste, die verteilten Speicher bereitstellen, arbeiten auf jedem Server im Cluster und verwenden einen Teil seiner Computerressourcen. Die Menge der Ressourcen hängt von der Anzahl und dem Volumen der installierten Laufwerke ab. Der Overhead beträgt durchschnittlich 34 GB RAM pro Host. Die Verbindung zum verteilten Speicher erfolgt über das iSCSI-Blockzugriffsprotokoll. Um die Fehlertoleranz sicherzustellen, wird die zwei- oder dreimalige Datensicherung unterstützt. Für produktive Installationen empfiehlt der Hersteller die Verwendung von dreifacher Redundanz. Derzeit wird von Speicheroptimierungstechnologien nur Thin Provisioning unterstützt. Deduplizierung und Datenkomprimierung mithilfe von verteiltem Speicher werden nicht unterstützt. Zukünftige Versionen unterstützen die Löschcodierung.

Virtualisierung

Zum Starten einer virtuellen Maschine (VM) wird der KVM-Hypervisor verwendet. Alle grundlegenden Funktionen für ihre Erstellung und Verwaltung werden unterstützt:

- Erstellung einer VM von Grund auf unter Angabe der erforderlichen Hardwarekonfiguration (Prozessorkerne, RAM-Größe, Anzahl und Größe der virtuellen Festplatten, Anzahl der Netzwerkadapter usw.);

- VM-Klonen von einer vorhandenen oder Vorlage;

- Erstellen eines sofortigen Snapshots (Snapshot), Löschen eines Snapshots, Zurücksetzen von Änderungen, die an der VM ab dem Zeitpunkt der Momentaufnahme des Snapshots vorgenommen wurden;

- Ändern der Hardwarekonfiguration einer zuvor erstellten VM, einschließlich des Verbindens oder Trennens einer virtuellen Festplatte oder eines Netzwerkadapters für eine enthaltene VM (Hotplug / Hot Unplug);

- VM-Migration zwischen Virtualisierungsservern

- Überwachen des Status der VM, einschließlich Überwachen der Auslastung von Computerressourcen und virtuellen Festplatten (aktuelle Größe, E / A-Volumen in MB / s oder in IOPS);

- Planen von Vorgängen mit VMs nach einem Zeitplan (Einschalten, Ausschalten, Erstellen eines Snapshots usw.);

- Verbinden und Verwalten von VMs über VNC- oder SPICE-Protokolle von einer Webkonsole aus.

Typisches Blockdiagramm (4 Knoten)

Typisches Blockdiagramm (4 Knoten)Die Plattformverwaltung erfolgt über die grafische Oberfläche oder die Befehlszeile (lokal oder remote, wenn eine Verbindung über SSH hergestellt wird) sowie über die öffentliche API.

Unter den Einschränkungen der Virtualisierungsplattform kann das Fehlen von Mechanismen zum automatischen Ausgleichen von VMs zwischen Cluster-Hosts festgestellt werden.

SharxBase unterstützt nicht nur die Servervirtualisierung, sondern kann auch softwarekonfigurierte Rechenzentren und private Cloud-Infrastrukturen erstellen. Als Beispiel für solche Funktionen kann man Folgendes feststellen:

- Verwaltung von Zugriffsrechten basierend auf der Benutzermitgliedschaft in Gruppen und Zugriffssteuerungslisten (ACLs): Rechte können verschiedenen Benutzergruppen zugewiesen werden, die den Zugriff auf virtuelle Infrastrukturkomponenten einschränken.

- Abrechnung des Ressourcenverbrauchs (Abrechnung): Prozessoren, RAM, Festplattenressourcen;

- Schätzung der Kosten des Verbrauchs von Rechenressourcen (Showback) in willkürlichen Einheiten basierend auf den verbrauchten Ressourcen und ihren Preisen;

- Grundfunktionen von IPAM (IP Address Management): automatische Zuweisung von IP-Adressen für VM-Netzwerkschnittstellen aus einem vorgegebenen Bereich;

- Grundfunktionen von SDN: Erstellen eines virtuellen Routers zum Übertragen von Datenverkehr zwischen virtuellen Netzwerken.

Mit dem entwickelten Informationssicherheitsmodul implementiert SharxBase zusätzliche Maßnahmen zur Gewährleistung der Informationssicherheit des Plattformverwaltungssystems: anpassbare Anforderungen an Benutzerkontokennwörter (Komplexität, Länge, Nutzungsdauer, Wiederholbarkeit usw.), Blockieren von Benutzern, Verwaltung aktueller Zugriffssitzungen auf die Verwaltungskonsole, Registrierung Ereignisse und andere. Die Software wird in das Register der russischen Software (Nummer 4445) eingetragen. Das Prüflabor erhielt eine positive Schlussfolgerung zu erfolgreich abgeschlossenen Zertifizierungstests der SharxBase-Software im FSTEC-RF-Zertifizierungssystem für Stufe 4 zur Überwachung des Fehlens von NDV sowie zur Einhaltung von Spezifikationen (Erfüllung der Anforderungen zum Schutz von Virtualisierungsumgebungen) bis einschließlich GIS-Klasse 1 / ISPD-Sicherheitsstufe. Die Erlangung einer Bescheinigung über die Übereinstimmung mit den Anforderungen des Zertifizierungssystems für Informationssicherheit bedeutet, dass im Dezember 2018 die Nr. ROSS RU.0001.01BI00 (FSTEC der Russischen Föderation) erwartet wird.

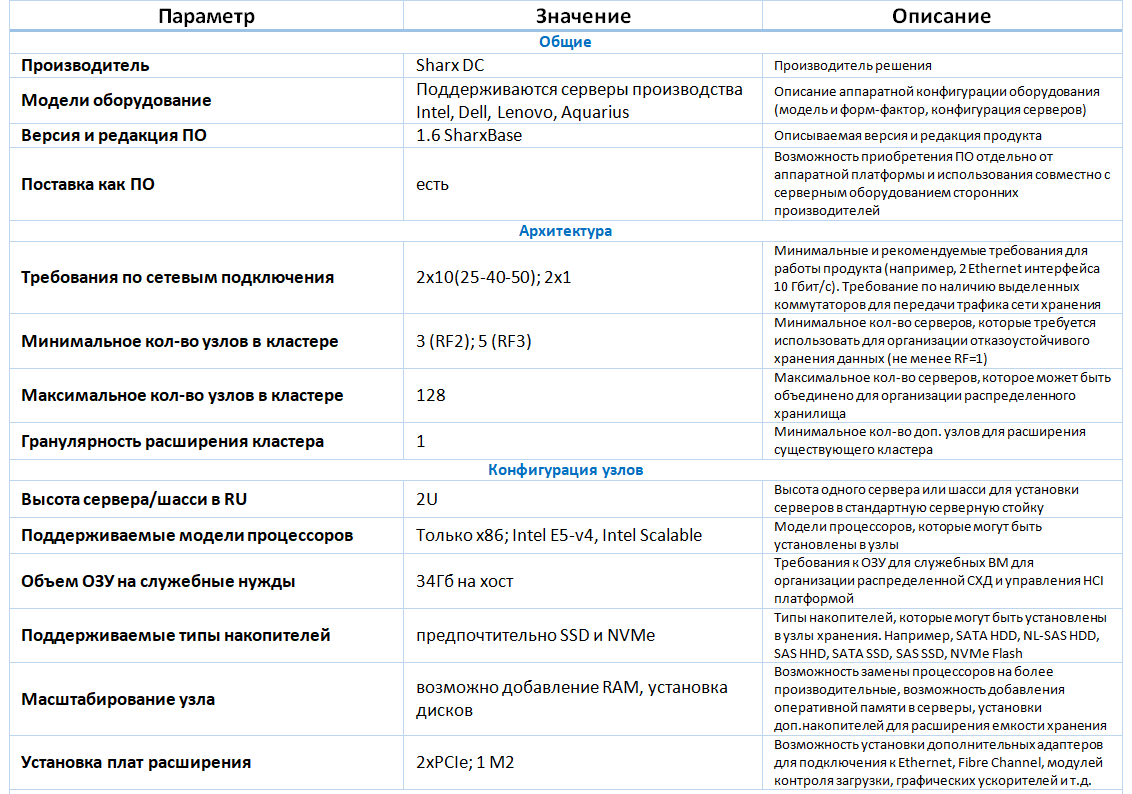

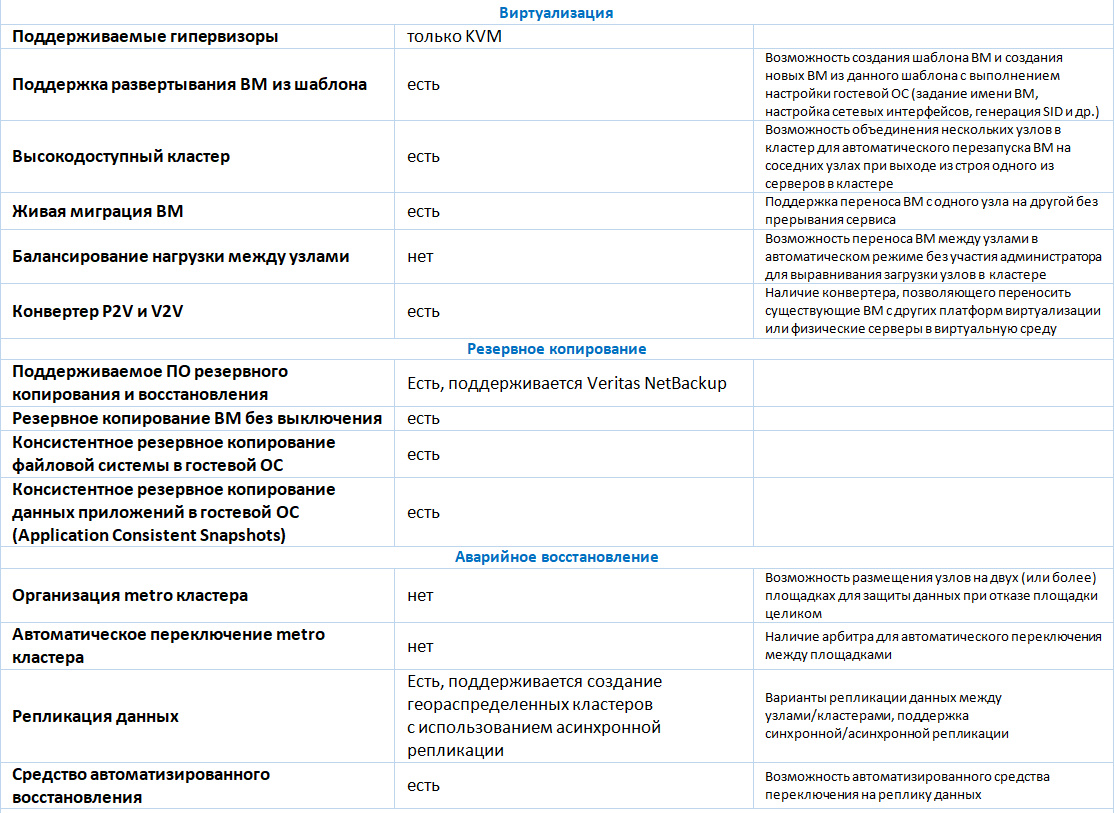

Eine detaillierte Beschreibung der Funktionalität finden Sie in der folgenden Tabelle.

Überwachung

SharxBase Monitoring bietet Zugriff auf erweiterte Plattformstatusinformationen, Warnungseinstellungen und Plattformstatusanalysen.

Das Überwachungssubsystem ist ein verteiltes System, das auf jedem der Clusterknoten installiert ist und dem Virtualisierungsverwaltungssystem Daten zum Status der Plattform bereitstellt.

Das Echtzeitüberwachungs-Subsystem sammelt Informationen über Plattformressourcen, wie z.

| Serverknoten | Netzteile | Schalter | Virtuelle Maschinen | Verteiltes Data Warehouse |

|---|

- Seriennummer des Geräts

- Seriennummer des Knotens und des Motherboards

- Einheit und Einheitentemperatur

- CPU-Modell und Last

- Steckplatznummern, Häufigkeit, Größe und Verfügbarkeit des Arbeitsspeichers

- Knoten und Speicheradresse

- Die Drehzahl der Lüfter

- Netzwerkadapterstatus

- Seriennummer des Netzwerkadapters

- Der Status der Festplatte und ihre Systeminformationen

| - Seriennummer der Stromversorgung

- Der Zustand des Netzteils und seiner Last

| - Modell wechseln

- Status des Switches und seiner Ports

- Die Drehzahl der Lüfter

- Status der Lüfter

- VLAN-Liste anzeigen

| - CPU-Auslastung

- RAM laden

- Netzwerklast

- Status der virtuellen Maschine

- Schreib- / Lesegeschwindigkeit der Festplatte

- Eingehende / ausgehende Verbindungsgeschwindigkeit

| - Anzeige des freien / belegten Platzes

- Festplattenstatus

- Verwendeter Speicherplatz

- Laufwerksfehler

|

Zwischensummen

Die Vorteile der Lösung umfassen:

- die Möglichkeit der Lieferung an Organisationen auf Sanktionslisten;

- Die Lösung basiert auf dem OpenNebula-Projekt, das sich seit langer Zeit aktiv entwickelt.

- Unterstützung aller erforderlichen Funktionen zur Servervirtualisierung, ausreichend für kleine und mittlere Installationen (bis zu 128 Hosts);

- das Vorhandensein eines Informationssicherheitsmoduls, das die Umsetzung gesetzlicher Anforderungen im Bereich der Informationssicherheit gewährleistet.

Die Nachteile der Lösung umfassen:

- geringere Funktionalität im Vergleich zu anderen HCI-Lösungen auf dem Markt (z. B. Dell VxRail, Nutanix);

- eingeschränkte Unterstützung durch Backup-Systeme (derzeit wurde die Unterstützung von Veritas NetBackup angekündigt);

- Einige der Verwaltungsaufgaben werden über die Konsole ausgeführt und sind nicht über das Internet zugänglich.

Funktionalität

Bei der Erweiterung des Portfolios hyperkonvergenter Lösungen haben wir gemeinsam mit dem Anbieter Tests zu Leistung und Fehlertoleranz durchgeführt.

Leistungstests

Der Prüfstand war ein 4-Knoten-Cluster von Intel HNS2600TP-Servern. Die Konfiguration aller Server war identisch. Die Server hatten die folgenden Hardwareeigenschaften:

- Servermodell - Intel HNS2600TP;

- zwei Intel Xeon E5-2650 v4-Prozessoren (12 Kerne mit einer Taktfrequenz von 2,2 GHz und Unterstützung für Hyper-Threading);

- 256 GB RAM (224 GB Arbeitsspeicher stehen zum Ausführen der VM zur Verfügung);

- Netzwerkadapter mit 2 QSFP + -Ports mit einer Datenübertragungsrate von 40 Gbit / s;

- ein RAID-Controller LSI SAS3008;

- 6 SATA-SSD-Laufwerke Intel DC S3700 mit einer Kapazität von jeweils 800 GB;

- zwei Netzteile mit einer Nennleistung von jeweils 1600 W.

- Auf den Servern ist die Virtualisierungssoftware SharxBase v1.5 installiert.

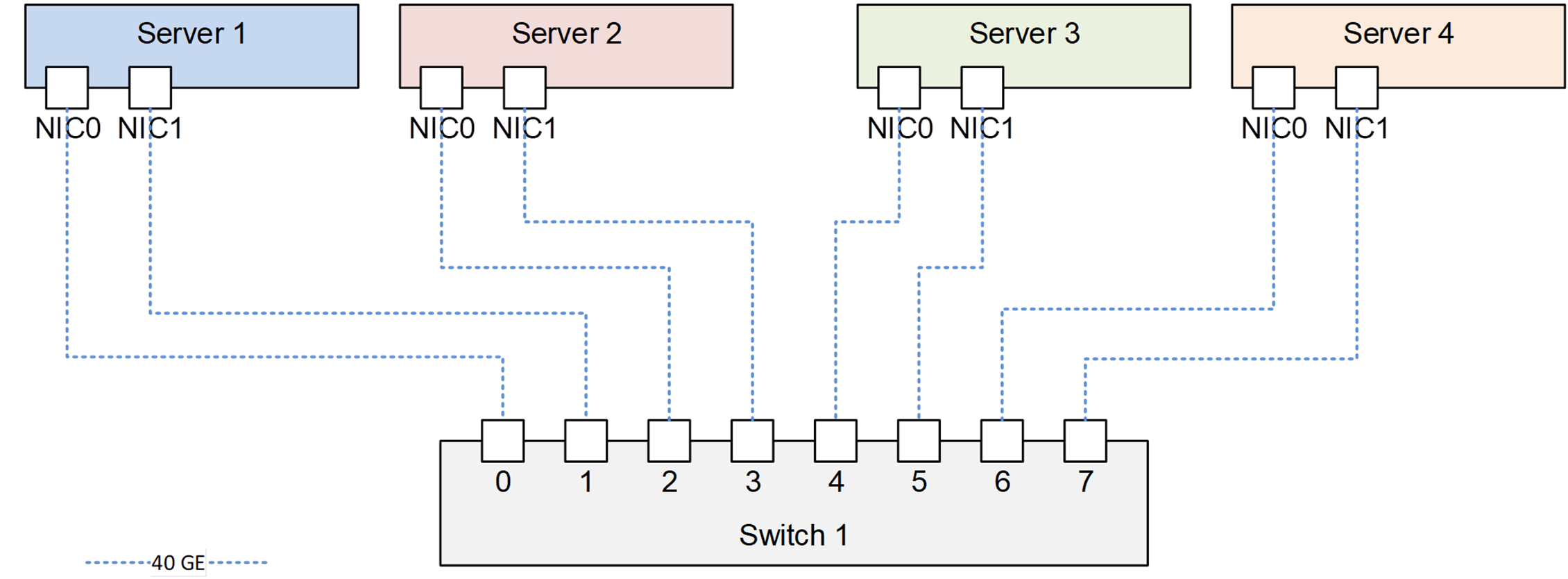

Alle Server, die mit dem Mellanox-Netzwerk-Switch verbunden sind. Das Anschlussdiagramm ist in der Abbildung dargestellt.

Verbindungsdiagramm von Servern auf einem Prüfstand

Verbindungsdiagramm von Servern auf einem PrüfstandAlle zuvor beschriebenen Funktionalitäten wurden als Ergebnis der Funktionstests bestätigt.

Das Testen des Festplattensubsystems wurde mit der Vdbench-Softwareversion 5.04.06 durchgeführt. Auf jedem physischen Server wurde eine VM unter Linux mit 8 vCPU und 16 GB RAM erstellt. Zum Testen auf jeder VM wurden 8 virtuelle Festplatten mit jeweils 100 GB erstellt.

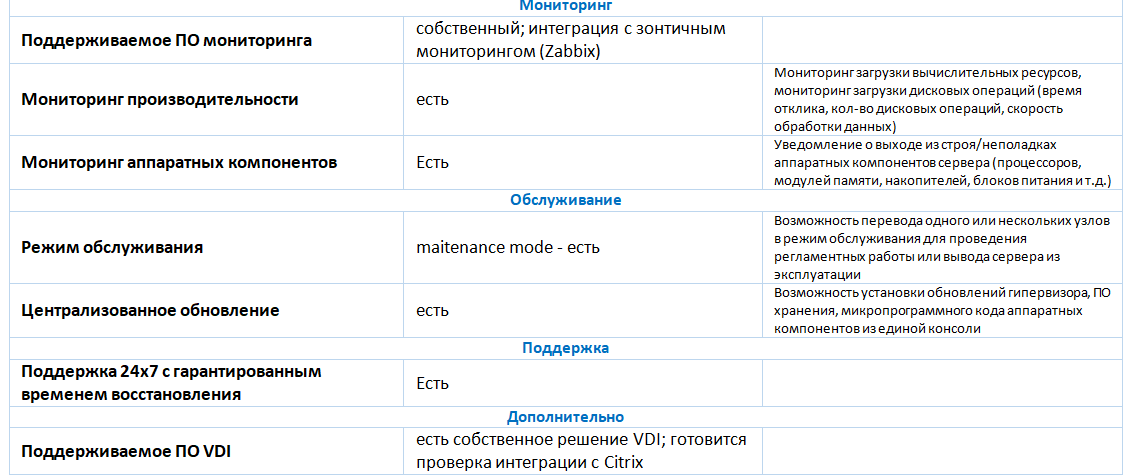

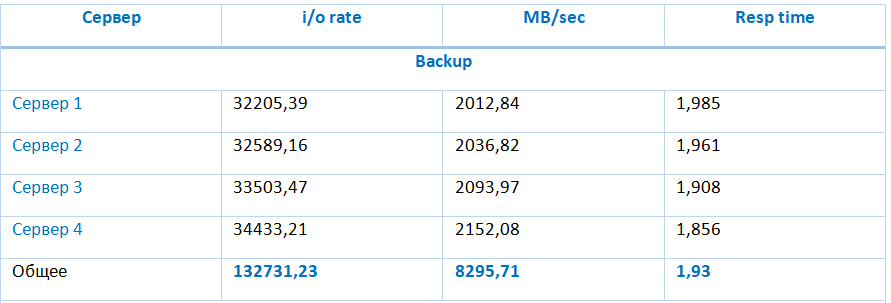

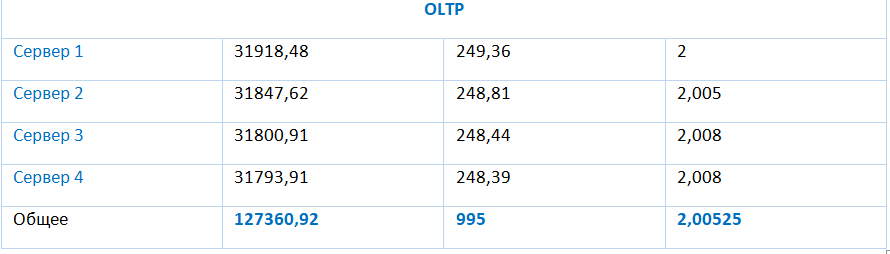

Während der Tests wurden die folgenden Arten von Lasten überprüft:

- (Backup) 0% zufällig, 100% gelesen, 64 KB Blockgröße, 1 ausstehende E / A;

- (Wiederherstellen) 0% zufällig, 100% schreiben, 64 KB Blockgröße, 1 ausstehende E / A;

- (Typisch) 100% zufällig, 70% gelesen, 4 KB Blockgröße, 4 herausragende E / A;

- (VDI) 100% zufällig, 20% gelesen, 4 KB Blockgröße, 8 ausstehende E / A;

- (OLTP) 100% zufällig, 70% gelesen, 8 KB Blockgröße, 4 herausragende E / A.

Die Testergebnisse dieser Typen sind in der Tabelle dargestellt:

Der Speicher bietet besonders leistungsstarke Indikatoren für sequentielle Lese- und Schreibvorgänge von 8295,71 MB bzw. 2966,16 MB. Die Speicherleistung bei einer typischen Last (zufällige E / A mit 4-KB-Blöcken mit 70% Lesezugriff) erreicht 133977,94 E / A mit einer durchschnittlichen E / A-Verzögerung von 1,91 ms und nimmt mit zunehmendem Verhältnis von Schreibvorgängen zu Lesevorgängen ab.

Fehlertoleranzprüfung

Mit diesen Tests konnte überprüft werden, ob ein Ausfall einer der Systemkomponenten nicht zum Herunterfahren des gesamten Systems führt.

| Test | Testdetails | Kommentare |

|---|

| Festplattenfehler im Speicherpool | 14:00 - das System funktioniert normal;

14:11 - Deaktivieren der ersten SSD in Server 1;

14:12 - Ein SSD-Fehler wird in der Plattformverwaltungskonsole angezeigt.

14:21 - Deaktivieren Sie die erste SSD in Server 2.

14:35 - Der Ausfall von zwei SSDs wird in der Plattformverwaltungskonsole angezeigt.

14:38 - Laufwerke an Server 1 und 2 zurückgeben. LED-Anzeigen auf der SSD werden nicht angezeigt.

14:40 - Der Ingenieur hat über die CLI das Hinzufügen von SSD zum Repository durchgeführt.

14:50 - in der Plattformverwaltungskonsole werden als funktionierend angezeigt;

15:00 - Die Synchronisierung der VM-Komponenten ist abgeschlossen.

| Das System funktionierte normal. Die Fehlertoleranzanzeige ist wie angegeben. |

| Netzwerkfehler | 15:02 - das System funktioniert normal;

15:17 - Deaktivieren Sie einen der beiden Server 1-Ports.

15:17 - Verlust einer Echoanforderung an die IP-Adresse der Webkonsole (der isolierte Server diente als Leiter). Auf die auf dem Server ausgeführte VM kann über das Netzwerk zugegriffen werden.

15:18 - Das Deaktivieren des zweiten Ports auf Server 1, der VM und der Serververwaltungskonsole war nicht mehr verfügbar.

15:20 - Die VM wurde auf dem Server 3-Knoten neu gestartet.

15:26 - Server 1-Netzwerkschnittstellen sind verbunden, der Server wird an den Cluster zurückgegeben.

15:35 - Die Synchronisation der Komponenten der VM-Festplatten ist abgeschlossen.

| Das System funktionierte normal. |

| Ausfall eines physischen Servers | 15:35 - das System funktioniert normal;

15:36 - Herunterfahren von Server 3 über den Ausschaltbefehl in der IPMI-Schnittstelle;

15:38 - Die Test-VM wurde auf Server 1 neu gestartet.

15:40 - Aufnahme von Server 3;

15:43 - Serverbetrieb wiederhergestellt;

15:47 - Die Synchronisation ist abgeschlossen.

| Das System funktionierte normal. |

Testergebnisse

Die SharxBase-Plattform bietet ein hohes Maß an Verfügbarkeit und Fehlertoleranz bei Ausfall einer der wichtigsten Hardwarekomponenten. Aufgrund der dreifachen Redundanz für das Festplattensubsystem garantiert die Plattform die Verfügbarkeit und Sicherheit von Daten im Falle eines doppelten Ausfalls.

Zu den Nachteilen der Plattform zählen hohe Anforderungen an den Speicherplatz, die durch das Speichern und Synchronisieren von drei vollständigen Kopien von Daten sowie das Fehlen von Mechanismen für eine effizientere Nutzung des Speicherplatzes wie Deduplizierung, Komprimierung oder Löschcodierung verursacht werden.

Basierend auf den Ergebnissen aller durchgeführten Tests können wir den Schluss ziehen, dass die hyperkonvergente SharxBase-Plattform ein hohes Maß an Verfügbarkeit und Leistung für verschiedene Arten von Lasten bieten kann, einschließlich OLTP-Systemen, VDI und Infrastrukturdiensten.

Ilya Kuykin,

Führender Konstrukteur von Computersystemen,

Jet Infosystems