Wieder Wolken, Wolken und Wolken. Der Wechsel zu den Clouds, sei es Ihre private Cloud in Ihrem Rechenzentrum, eine private Cloud mit einem Anbieter oder mit öffentlichen Anbietern wie Amazon AWS, Microsoft Azure, IBM Cloud oder Google Cloud, ist unerbittlich. Das ist mir besonders aufgefallen, als ich in die USA gezogen bin. Hier reden alle über sie und immer - die Luft ist buchstäblich gesättigt mit diesem Thema. Hersteller von Software und Hardware haben dies perfekt verstanden und möchten dieses Zeitfenster in dieser sich verändernden Welt nicht verpassen.

Kuberneties Service

Kuberneties Servicewird zu einem wichtigen und leistungsstarken Werkzeug sowohl für die Erstellung und Verwaltung von Data Fabric (das später erläutert wird) als auch für den Wettbewerb auf dem Gebiet der HCI-Systeme. Zuvor war NetApp HCI eine ziemlich einfache Lösung, die nur mit VMware funktionierte, da Nutanix tatsächlich gestartet wurde. Nach der Einführung von NKS wird NetApp HCI für Nutanix in Bezug auf containergestützte DataCenter- und Next-Generation-Anwendungen der nächsten Generation wesentlich schwieriger sein, gleichzeitig aber die Nische verlassen, in der der Nutanix-Hypervisor theoretisch auf NetApp HCI ausgeführt werden kann.

NetApp Kubernetes Service Demo .

HCIEiner der ersten und wohlverdienten HCIs, mit denen viele vertraut sind, ist Nutanix. Trotz der Tatsache, dass Nutanix ein sehr interessantes Produkt ist, ist es nicht ohne Nachteile. Das Interessanteste an Nutanix ist meiner Meinung nach das interne Ökosystem, nicht die Speicherarchitektur. Wenn wir über die Mängel sprechen, ist es erwähnenswert, dass das Marketing einige Ingenieure verdecken könnte, indem es die falsche Nachricht übermittelt, dass alle Daten immer lokal sind und dies gut ist. Während Konkurrenten, die auf NetApp HCI hinweisen, auf die Daten über das Netzwerk zugreifen müssen, das „lang“ und im Allgemeinen „kein echter HCI“ ist, ohne eine Definition dessen zu geben, was ein echter HCI ist, obwohl dies nicht möglich ist im Prinzip, wie zum Beispiel in „Cloud“, zu dessen Definition sich auch niemand verpflichtet. Weil es von Menschen für Marketingzwecke erfunden wurde, so dass es in Zukunft möglich sein würde, den Inhalt dieses Konzepts zu ergänzen und zu ändern, und nicht für rein technische Zwecke, bei denen ein Objekt zunächst immer eine unveränderte Definition hat.

Anfänglich war es einfacher, genau mit der für die Massen zugänglichen Architektur in den HCI-Markt einzusteigen, was einfacher zu konsumieren ist, nämlich nur die Komodie des Servers mit vollen Festplatten zu verwenden.

Dies bedeutet jedoch nicht, dass dies die bestimmenden Eigenschaften von HCI und die beste HCI-Option sind. Die Erklärung des Problems hat tatsächlich ein Problem oder, wie gesagt, eine Nuance verursacht: Wenn Sie Speicher in einer Share-Nothing-Architektur verwenden, die Nutanix HCI auf der Basis von Komoditätsgeräten enthält, müssen Sie die Zugänglichkeit und den Datenschutz sicherstellen. Dazu müssen Sie mindestens alle Datensätze kopieren von einem Server zum anderen. Und wenn die virtuelle Maschine einen neuen Datensatz auf der lokalen Festplatte generiert, ist alles in Ordnung, wenn dieser Datensatz nicht synchron dupliziert und auf einen anderen Server übertragen werden muss,

um auf die Antwort zu warten, dass er sicher und zuverlässig ist. Mit anderen Worten, in Nutanix und in der Tat in jeder Share-Nothing-Architektur entspricht die Geschwindigkeit von Datensätzen plus oder minus bestenfalls der Tatsache, dass diese Datensätze sofort über das Netzwerk in den gemeinsam genutzten Speicher übertragen würden.

Die wichtigsten Slogans für das grundlegende Design von HCI waren immer die Einfachheit der Erstinstallation und -konfiguration, die Möglichkeit, von einer minimalen, einfachen und kostengünstigen Konfiguration aus zu beginnen und auf die gewünschte Größe zu erweitern, die einfache Erweiterung / Komprimierung, die einfache Verwaltung von einer einzigen Konsole aus, die Automatisierung - all dies hängt irgendwie damit zusammen Einfachheit, Cloud-ähnliche Erfahrung, Flexibilität und Granularität des Ressourcenverbrauchs. Ob das Speichersystem in der HCI-Architektur eine separate Box oder ein Teil des Servers ist, spielt jedoch keine große Rolle, um diese Einfachheit zu erreichen.

Zusammenfassend lässt sich sagen, dass das Marketing viele Ingenieure überraschend in die Irre geführt hat, dass lokale Laufwerke immer besser sind, was nicht der Fall ist, da es aus technischer Sicht im Gegensatz zum Marketing nicht so einfach ist. Nachdem wir die falsche Schlussfolgerung gezogen haben, dass es HCI-Architekturen gibt, die nur lokale Festplatten verwenden, können wir die folgende falsche Schlussfolgerung ziehen, dass über das Netzwerk verbundene Speichersysteme immer langsamer arbeiten. Die Prinzipien des Informationsschutzes, der Logik und der Physik in dieser Welt sind jedoch so konzipiert, dass dies unmöglich zu erreichen ist, und es gibt keine Möglichkeit, sich der Kommunikation über das Netzwerk zwischen Festplattensubsystemen in der HCI-Infrastruktur zu entziehen. Es besteht ein grundlegender Unterschied darin, ob sich die Festplatten lokal zusammen mit den Computerknoten befinden oder in einem separaten Speicherknoten, der dort über das Netzwerk verbunden ist. Im Gegensatz dazu können Sie mit dedizierten Speicherknoten weniger Abhängigkeiten von HCI-Komponenten voneinander erzielen. Wenn Sie beispielsweise die Anzahl der Knoten in einem HCI-Cluster basierend auf demselben Nutanix oder vSAN reduzieren, reduzieren Sie automatisch den Speicherplatz im Cluster. Und umgekehrt: Wenn Sie Rechenknoten hinzufügen, müssen Sie diesem Server Festplatten hinzufügen. In der NetApp HCI-Architektur sind diese Komponenten nicht miteinander verbunden. Die Gebühr für eine solche Infrastruktur hängt überhaupt nicht von der Geschwindigkeit des Festplattensubsystems ab, aber zum Starten müssen mindestens 2 Speicherknoten und mindestens 2 Rechenknoten für insgesamt 4 Knoten vorhanden sein. 4 NetApp HCI-Knoten können mit Half Blades in 2U gepackt werden.

NetApp HCI

NetApp HCIMit dem Kauf von SolidFire erschien die HCI in der NetApp-Produktlinie (dieses Produkt hat keinen eigenen Namen, deshalb wird es einfach als HCI bezeichnet). Der Hauptunterschied zu den „klassischen“ HCI-Systemen besteht in separaten Speicherknoten, die über das Netzwerk verbunden sind. Das SolidFire-System selbst, das für HCI die „hundertprozentige“ Schicht darstellt, unterscheidet sich grundlegend von den All-Flash-AFF-Systemen, die aus der FAS-Linie entwickelt wurden, die wiederum seit etwa 26 Jahren auf dem Markt ist.

Wenn Sie ihn besser kennenlernen (

was Sie auch tun können ), wird klar, dass dies ein Produkt einer völlig anderen Ideologie ist, die sich an ein anderes Verbrauchersegment (Cloud-Anbieter) richtet und idealerweise genau zu ihren Aufgaben passt, sowohl in Bezug auf Leistung, Fehlertoleranz als auch Sicht der Integration in ein einziges Abrechnungs-Ökosystem.

Glühen für alle 200 NetApp SolidFire-Tests Arthur Alikulov, Evgeny Elizarov. NetApp Richtungen 2018 .

NetApp bewegt sich in die Wolkenund ist seit langem kein Hersteller von Speichersystemen mehr. Jetzt ist es eher ein trübes Date-Management-Unternehmen, zumindest bewegen sie sich hartnäckig in diese Richtung. Eine Vielzahl verschiedener Implementierungen von NetApp-Produkten spricht dafür - SaaS-Backup für O365, SaaS-Backup für Salesforce (und Pläne für Google Apps, Slack & ServiceNow). ONTAP Select ist zu einer sehr wichtigen Entscheidung geworden, unabhängig und nicht wie zuvor eine kleine Lotion für die Replikation auf ein „vollwertiges“ FAS. NDAS integriert sich immer tiefer in die bisher scheinbar nicht integrierbaren Speichersysteme und die Cloud und bietet Backup, eine Google-ähnliche Suche im Dateiverzeichnis und eine grafische Verwaltungsoberfläche als Service. FabricPool ging noch tiefer und kombinierte die SSD und die Cloud, was vorher unwahrscheinlich oder sogar verrückt schien.

Die Tatsache, dass NetApp in relativ kurzer Zeit bei vier der weltweit größten Cloud-Anbieter gelandet ist, zeigt die Ernsthaftigkeit ihrer Absichten. Darüber hinaus basiert der NFS-Dienst in Azure ausschließlich auf NetApp AFF-Systemen.

Azure NetApp Files-Demo .

NetApp AFF-Speichersysteme sind in Azure, AWS und Google als Service verfügbar, NetApp ist für deren Support, Aktualisierung und Wartung zuständig, und Cloud-Benutzer können AFF-Systemspeicher und -Funktionalität für Snapshoting, Klonen und QoS als Service nutzen.

NetApp Cloud Volumes Service für AWS Demo .

Die IBM Cloud verwendet ONTAP Select, das genau die gleiche Funktionalität wie das AFF-System hat, jedoch als Software verwendet wird, die auf dem Server des Servers installiert werden kann. Active IQ ist ein Webportal, das Informationen zu NetApp-Software und -Ausrüstungen anzeigt und Empfehlungen zur Antizipation von Problemen und zur Aktualisierung von AI-Algorithmen enthält, die auf zusammengesetzter Telemetrie von NetApp-Geräten und -Diensten ausgeführt werden.

NetApp Active IQ-Demo .

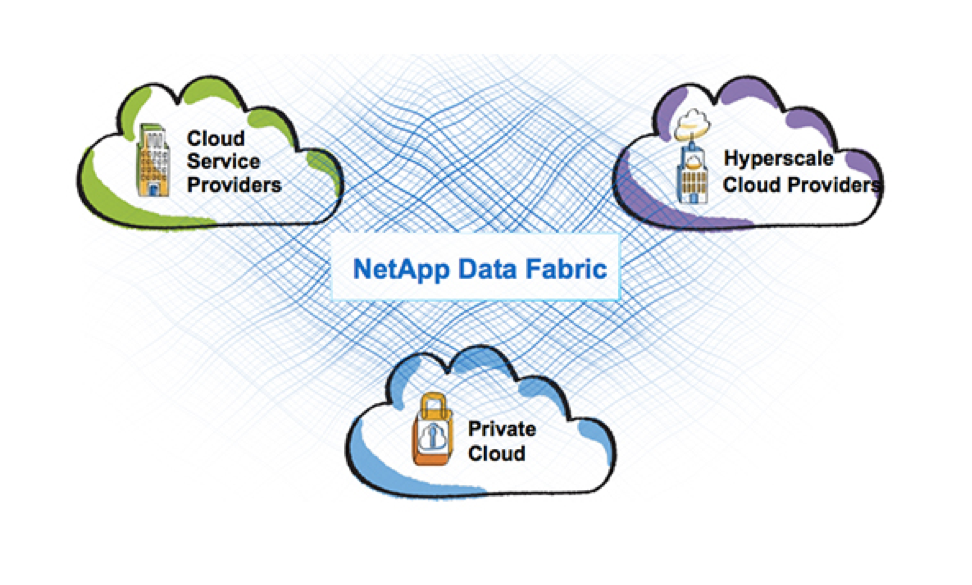

DatenstrukturIm Allgemeinen ist die Data Fabric-Strategie, die NetApp derzeit verfolgt, darauf ausgelegt, diese völlig unterschiedlichen Umgebungen zu kombinieren: öffentliche und private Clouds sowie alle NetApp-Produkte. Schließlich reicht es nicht aus, nur ein Produkt in der Cloud zu starten, sondern es muss logisch und harmonisch in die Dienste von Cloud-Anbietern passen. Und heute ist NetApp mehr als erfolgreich. Data Fabric aus der Marketingidee erhält reibungslos konkrete Funktionen in Form einzelner Technologien und Produkte: FabricPool-Tiering zwischen SSD und S3, SnapMirror zwischen ONTAP und SolidFier / HCI, SnapCenter für ONTAP und SolidFier (das noch nicht implementiert wurde), NDAS-Datensicherungsdienst Ihre Speicherung in der Cloud, MAX Data-Software für softwaredefinierten Speicher. Dies sind alles NetApp-Produkte oder -Funktionen, die diese Vision von Data Fabric verkörpern. ONTAP Select kann jetzt unter Nutanix ausgeführt werden und bietet dem Ökosystem umfangreiche Dateifunktionen.

Data Fabric ist teilweise eine Vision des Prozesses des Zusammenführens oder Integrierens aller NetApp-Produkte und sogar der Clouds, und ich sehe sogar nicht nur Marketing, sondern sogar das physische Zusammenführen einzelner Produkte.

Nicht nur das, ich möchte eine Vorhersage machen. Seit einigen Jahren spiele ich dieses Spiel auf Kosten von Vorhersagen mit einigen meiner Kollegen, und bis jetzt war ich immer sehr nah dran oder habe den Gedankengang in dieser Firma erraten. Mal sehen, wie viel Glück ich diesmal habe. Ich möchte betonen, dass dies meine persönliche Meinung ist, basierend auf Informationen, die ich über alle 7 Jahre meiner Erfahrung mit NetApp und Intuition erhalten habe. Keiner von NetApp hat mir dies gesagt, daher kann dies nur eine Erfindung meiner Vorstellungskraft sein:

- AFF wird Teil von HCI

- Es ist möglich, LUN online zwischen AFF / HCI zu migrieren

NetApp ist letztendlich ein SpeicheranbieterVielleicht ist dies ein zu lauter Titelname, aber NetApp geht in die Phase, in der das Unternehmen zu einem Datenverwaltungs-, softwaredefinierten, Cloud-nativen Betreiber wird und wie üblich weiterhin Speicher produziert. Der Speicher ist nicht verschwunden und der Rand ist nicht sichtbar für die Tatsache, dass dies in naher Zukunft geschehen kann, aber der Schwerpunkt verlagert sich auf die Wolkendecke und auf die Daten selbst.

Dieser Text wurde in enger Zusammenarbeit mit Dmitry

bbk verfasst , wenn Sie mehr über NetApp-Technologien erfahren möchten - seien Sie nicht zu faul, um ihn + zu setzen, und neue Artikel lassen Sie nicht warten.

Wenn Sie an Nachrichten aus der NetApp-Welt interessiert sind, begrüßen Sie den

StorageTalks- Telegrammkanal. Wenn Sie jedoch nach einer aktiven russischsprachigen Speichergemeinschaft suchen,

besuchen Sie den

StorageDiscussions- Telegramm-Chat.