Der Informatikspezialist Siwei Lyu sah sich mehrere Wochen lang die von seinem Team erstellten Deepfake-Videos mit quälender Besorgnis an. Diese gefälschten Filme, die mit dem Algorithmus für maschinelles Lernen erstellt wurden, zeigten Prominente, die Dinge taten, die sie nicht tun würden. Sie schienen ihm seltsam erschreckend, und nicht nur, weil er wusste, dass sie falsch waren. "Sie sehen falsch aus", erinnert er sich, "aber es ist sehr schwierig, genau zu bestimmen, was diesen Eindruck macht."

Aber einmal in seinem Gehirn kam eine Kindheitserinnerung. Wie viele andere Kinder spielte er mit Kindern "Peeper". "Ich habe solche Wettbewerbe immer verloren", sagt er, "denn als ich ihre blinzelfreien Gesichter betrachtete, fühlte ich mich sehr unwohl."

Er erkannte, dass diese gefälschten Filme ihm ein ähnliches Unbehagen bereiteten: Er spielte diesen Filmstars die Peeper vor, weil sie ihre Augen nicht so oft öffneten und schlossen wie echte Menschen.

Um herauszufinden, warum, untersuchten Luy, Professor an der Albany University, und sein Team jeden Schritt der

DeepFake- Software, mit der diese Videos erstellt wurden.

Deepfake-Programme nehmen viele Bilder einer bestimmten Person am Eingang auf - Sie, Ihre Ex-Freundin, Kim Jong-un -, so dass sie aus verschiedenen Blickwinkeln mit unterschiedlichen Gesichtsausdrücken gesehen werden können, die unterschiedliche Wörter sagen. Algorithmen lernen, wie dieser Charakter aussieht, und synthetisieren dann das erworbene Wissen in einem Video, das zeigt, wie diese Person das tut, was sie nie getan hat.

Pornografie Stephen Colbert spricht die Worte von John Oliver. Präsident

warnt vor den Gefahren gefälschter Videos.

Diese Videos sehen auf dem Telefonbildschirm einige Sekunden lang überzeugend aus, sind aber (noch) nicht perfekt. Sie können Zeichen von Fälschungen gesehen werden, zum Beispiel auf seltsame Weise, ständig offene Augen, die sich aus den Mängeln des Schöpfungsprozesses ergeben. Als Lu die Eingeweide von DeepFake betrachtete, stellte er fest, dass es unter den Bildern, die das Programm untersuchte, nicht so viele Fotos mit geschlossenen Augen gab (weil Sie kein Selfie behalten, auf dem Sie blinken?). "Es wird eine Verzerrung", sagt er. Das neuronale Netz versteht das Blinken nicht. Programme können auch andere „physiologische Signale, die Menschen innewohnen“, übersehen, sagte Luya, der dieses Phänomen beschreibt - Atmung mit normaler Geschwindigkeit oder Vorhandensein eines Pulses. Obwohl sich diese Studie auf Werbespots konzentrierte, die mit einer bestimmten Software erstellt wurden, ist allgemein anerkannt, dass selbst eine große Anzahl von Fotos die physische Wahrnehmung einer Person möglicherweise nicht angemessen beschreiben kann, sodass jede auf diesen Bildern geschulte Software nicht perfekt ist.

Die Enthüllung über das Blinken enthüllte viele gefälschte Videos. Einige Wochen nachdem Lu und das Team einen Entwurf der Arbeit online gestellt hatten, erhielten sie einen anonymen Brief mit Links zu den nächsten gefälschten Videos auf YouTube, in denen die Stars ihre Augen in einem normaleren Modus öffneten und schlossen. Gefälschte Schöpfer haben sich weiterentwickelt.

Und das ist natürlich. Wie Lu in

einem Interview mit The Conversation feststellte, kann „Deepfake-Videos durch Blinken von Bildern mit geschlossenen Augen in die Datenbank oder durch Trainieren von Videos ein Blinken hinzugefügt werden.“ Wenn Sie wissen, was das Zeichen einer Fälschung ist, können Sie es vermeiden - dies ist „nur“ ein technisches Problem. Dies bedeutet, dass gefälschte Videos in ein Wettrüsten zwischen Entwicklern und Erkennern verwickelt werden. Forschungen wie Luys Arbeit können das Leben gefälschter Hersteller nur erschweren. "Wir versuchen, die Messlatte höher zu legen", sagt er. "Wir möchten diesen Prozess komplizieren, um ihn zeitaufwändiger zu gestalten."

Denn jetzt ist es sehr einfach. Laden Sie das Programm herunter, googeln Sie Promi-Fotos und geben Sie sie an den Programmeingang weiter. Sie verdaut sie, lernt von ihnen. Und obwohl sie noch nicht völlig unabhängig ist, trägt sie mit ein wenig Hilfe etwas Neues und sieht ziemlich real aus.

"Sie ist sehr verschwommen", sagt Lu. Und er meint nicht Bilder. "Diese Linie ist zwischen Wahrheit und Fälschung", sagte er.

Dies ärgert und überrascht gleichzeitig niemanden, der in letzter Zeit am Leben war und im Internet gesurft hat. Dies ist jedoch besonders besorgniserregend für die Militär- und Geheimdienstabteilungen. Insbesondere deshalb werden die Studien von Lu wie einige andere Werke von einem

DARPA-Programm namens MediFor - Media Forensics (Medienforensik) finanziert.

Das MediFor-Projekt wurde 2016 gestartet, als die Agentur eine Zunahme der Aktivitäten gefälschter Hersteller feststellte. Das Projekt versucht, ein automatisiertes System zu schaffen, das drei Ebenen von Anzeichen von Fälschungen untersucht und eine „Bewertung der Realität“ eines Bildes oder Videos erstellt. Auf der ersten Ebene werden schmutzige digitale Spuren durchsucht - Rauschen von einer Kamera eines bestimmten Modells oder Komprimierungsartefakte. Die zweite Ebene ist physisch: Die Beleuchtung befindet sich nicht im Gesicht, die Reflexion sieht bei dieser Anordnung der Lampe nicht so aus, wie sie aussehen sollte. Letzteres ist semantisch: Vergleich von Daten mit bestätigten realen Informationen. Wenn zum Beispiel behauptet wird, dass das Video, das das Fußballspiel aufgenommen hat, am Dienstag, dem 9. Oktober 2018, um 14 Uhr im Central Park gedreht wurde, stimmt der Himmelszustand mit dem Wetterarchiv überein? Sammeln Sie alle Ebenen und erhalten Sie eine Einschätzung der Realität der Daten. DARPA hofft, dass es bis zum Ende von MediFor Prototypen von Systemen geben wird, mit denen es möglich sein wird, umfangreiche Überprüfungen durchzuführen.

Die Uhr tickt jedoch (oder handelt es sich nur um einen sich wiederholenden Ton, der von einer KI erzeugt wird, die auf Daten zur Zeiterfassung trainiert ist?) „In einigen Jahren werden Sie in der Lage sein, auf die Herstellung von Ereignissen zu stoßen“, sagt DARPA-Programmmanager Matt Turek. "Nicht nur ein einzelnes Bild oder ein bearbeitetes Video, sondern mehrere Bilder oder Clips, die versuchen, eine überzeugende Botschaft zu vermitteln."

Der Informatiker Juston Moore hat ein klareres Bild von der möglichen Zukunft im Los Alamos National Laboratory. Nehmen wir an: Wir informieren den Algorithmus, dass wir ein Video benötigen, in dem Moore eine Apotheke ausraubt. Wir führen es in die Videoaufnahmen des Sicherheitssystems dieser Institution ein. schicke ihn ins Gefängnis. Mit anderen Worten, er befürchtet, dass es leicht sein wird, Menschen zu ersetzen, wenn sich die Standards für die Überprüfung von Beweisen nicht parallel zur Herstellung von Fälschungen entwickeln (oder nicht entwickeln können). Und wenn sich die Gerichte nicht auf visuelle Daten verlassen können, kann sich herausstellen, dass echte Beweise ignoriert werden.

Wir kommen zu dem logischen Schluss, dass einmaliges Sehen nicht besser ist als hundertmaliges Hören. "Es kann vorkommen, dass wir keinen fotografischen Beweisen vertrauen", sagt er, "aber ich möchte nicht in einer solchen Welt leben."

Eine solche Welt ist nicht so unglaublich. Und das Problem geht laut Moore weit über das Ersetzen von Individuen hinaus. „Algorithmen können Bilder von Menschen

erstellen , die nicht zu echten Menschen gehören. Sie können Bilder seltsamerweise verändern und ein

Pferd in ein Zebra verwandeln“, sagt Moore. Sie können Teile von Bildern

entfernen und Vordergrundobjekte

aus dem Video entfernen .

Vielleicht können wir Fälschungen nicht schneller verarbeiten, als sie gemacht werden. Aber vielleicht klappt es - und diese Gelegenheit motiviert das Moore-Team, digitale Methoden zur Untersuchung von Beweisen zu studieren. Das Los Alamos-Programm, das Kenntnisse über Cybersysteme, Informationssysteme, theoretische Biologie und Biophysik kombiniert, ist etwa ein Jahr jünger als die DARPA-Agentur. Ein Ansatz konzentriert sich auf die „Komprimierbarkeit“ in Fällen, in denen das Bild nicht so viele Informationen enthält, wie es scheint. „Grundsätzlich bauen wir auf der Idee auf, dass alle KI-Bildgeneratoren nur eine begrenzte Anzahl von Dingen haben, die sie erstellen können“, sagt Moore. "Selbst wenn mir oder Ihnen das Bild ziemlich kompliziert erscheint, finden Sie darin eine sich wiederholende Struktur." Beim Recycling von Pixeln bleibt nicht viel übrig.

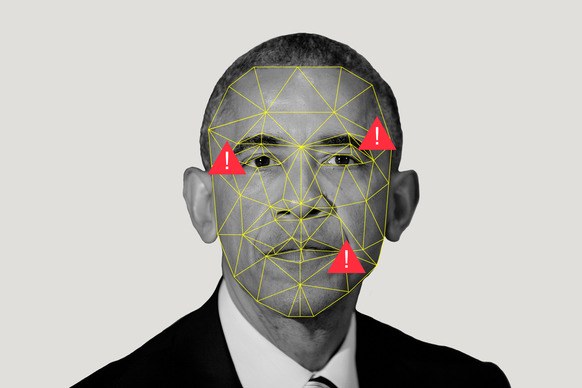

Sie verwenden auch spärliche Codierungsalgorithmen, um das Spiel mit Übereinstimmungen zu spielen. Nehmen wir an, wir haben zwei Sammlungen: eine Reihe realer Bilder und eine Reihe künstlich erstellter KI-Bilder. Der Algorithmus untersucht sie und erstellt das, was Moore als „Wörterbuch der visuellen Elemente“ bezeichnet. Dabei stellt er fest, dass künstliche Bilder etwas gemeinsam haben und dass reale Bilder etwas gemeinsam haben. Wenn Moores Freund Obamas Bild retweetet und Moore der Ansicht ist, dass das Bild mit KI erstellt wurde, kann er es durch das Programm laufen lassen und herausfinden, welchem der Wörterbücher es näher kommt.

Los Alamos, wo sich einer der leistungsstärksten Supercomputer der Welt befindet, lädt Ressourcen in dieses Programm hoch, nicht nur, weil jemand Moore durch einen gefälschten Raub ersetzen kann. Die Mission des Labors ist es, "die Probleme der nationalen Sicherheit mit Hilfe wissenschaftlicher Exzellenz zu lösen". Ihre Hauptaufgabe ist die nukleare Sicherheit, die garantiert, dass Bomben nicht explodieren, wenn sie nicht explodieren sollten, und explodieren, wenn sie sollten (bitte nicht), sowie Unterstützung bei der Nichtverbreitung. All dies erfordert ein allgemeines Wissen über maschinelles Lernen, da es, wie Moore sagt, hilft, "große Schlussfolgerungen aus kleinen Datensätzen zu ziehen".

Abgesehen davon sollten Unternehmen wie Los Alamos in der Lage sein, ihren Augen zu trauen - oder zu wissen, wann ihnen nicht vertraut werden muss. Was ist, wenn Sie Satellitenbilder sehen, wie ein Land Atomwaffen mobilisiert oder testet? Was ist, wenn jemand Sensorwerte vortäuscht?

Dies ist eine beängstigende Zukunft, in der die Arbeit von Moore und Lu idealerweise vermieden werden sollte. Aber in einer Welt, in der alles verloren ist, bedeutet Sehen nicht glauben, aber scheinbar absolute Messungen können falsch sein. Alles Digitale ist zweifelhaft.

Aber vielleicht ist „Zweifel“ das falsche Wort. Viele Leute werden Fälschungen zum Nennwert nehmen (erinnern Sie sich an das

Foto eines Hais in Houston?), Besonders wenn der Inhalt ihren Überzeugungen entspricht. "Die Menschen werden an das glauben, was sie glauben", sagt Moore.

Die Wahrscheinlichkeit dafür ist für die breite Öffentlichkeit, die die Nachrichten sieht, höher als im Bereich der nationalen Sicherheit. Und um die Verbreitung von Fehlinformationen unter uns Simpletons zu verhindern, bietet DARPA die Zusammenarbeit in sozialen Medien an, um den Benutzern dabei zu helfen, festzustellen, dass die Glaubwürdigkeit des Videos, in dem Kim Jong-un Makronen tanzt, eher gering ist. Turek weist darauf hin, dass soziale Netzwerke die Geschichte verbreiten können, indem sie das Video so schnell widerlegen wie das Video selbst.

Aber werden sie es tun? Die Exposition ist ein

mühsamer Prozess (obwohl nicht so

ineffizient wie das Gerücht). Und die Leute müssen wirklich die Fakten zeigen, bevor sie ihre Meinung über Fiktion ändern können.

Aber selbst wenn niemand die Meinung der Massen über die Richtigkeit des Videos ändern kann, ist es wichtig, dass Menschen, die politische und rechtliche Entscheidungen treffen - darüber, wer Raketen transportiert oder Menschen tötet - versuchen, Maschinen zu verwenden, um die scheinbare Realität vom KI-Schlaf zu trennen.