Es ist kein Geist im Auto

In den letzten Jahren wurden die Medien mit übertriebenen Beschreibungen von Technologien für künstliche Intelligenz (KI) und maschinelles Lernen (MO) überflutet. Es scheint, dass es auf dem Gebiet der Informatik noch nie so etwas gegeben hat, dass so viele Menschen mit so einer kleinen Vorstellung davon, was passiert, so viele lächerliche Aussagen gemacht haben. Für jeden, der in den 1980er Jahren aktiv an fortschrittlichen Computergeräten beteiligt war, scheint das seltsam.

In der diesmonatigen Ausgabe von The Atlantic, einem hochfliegenden intellektuellen und meistverkauften Autor,

Sapiens. Eine kurze Geschichte der Menschheit und

Homo Deus: Eine kurze Geschichte von morgen beschreibt Yuval Noah Harari die Auswirkungen der KI auf die Demokratie. Der interessanteste Aspekt des Artikels ist Hararis übermäßiges Vertrauen in die Fähigkeiten moderner KI-Technologien. Er beschreibt einen Google-Freund,

DeepMinds Schachprogramm, als "kreativ", "einfallsreich" und "brillant".

In

der Dokumentation der Luftwaffe

, The Joy of AI, beschreiben Professor Jim Al-Khalili und der Gründer von DeepMind, Demis Hassabis, wie das KI-System „eine echte Entdeckung gemacht“ hat, „wirklich eine neue Idee generieren kann“ und „Strategien entwickelt, die unabhängig erfunden wurden“.

Und wenn ein ähnlicher Strom von Übertreibungen und Anthropomorphismen verwendet wird, um dumme und mechanistische Systeme zu beschreiben, dann ist es Zeit, die Realität mit einer Rückkehr zu den Grundlagen zu testen.

Die Diskussion über Computertechnologie erfolgt häufig durch Mythen, Metaphern und menschliche Interpretationen dessen, was auf dem Bildschirm erscheint. Metaphern wie "Intuition", "Kreativität" und neuere "Strategien" sind Teil der aufkommenden Mythologie. KI-Experten finden Muster im KI-Spiel und nennen sie „Strategien“, aber das neuronale Netzwerk hat keine Ahnung, was eine Strategie ist. Wenn es irgendeine Art von Kreativität gibt, dann gehört sie Forschern von DeepMind, die die Prozesse von Trainingssystemen entwickeln und verwalten.

Die heutigen KI-Systeme basieren auf einer Vielzahl automatisierter Versuche und Irrtümer. In jeder Phase wird die

Back-Propagation- Technik verwendet, um Informationen über Fehler zu übertragen und das System zu optimieren, um die Anzahl der Fehler in Zukunft zu verringern. Dies verbessert schrittweise die Effektivität der KI bei der Ausführung einer bestimmten Aufgabe, beispielsweise beim Schachspielen.

Der Anstieg der Wirksamkeit von KI, MO und so weiter. „Deep Learning“ (GO) basiert größtenteils auf der Anwendung dieser Backpropagation-Technik. Es wurde erstmals in den 1960er Jahren erfunden und in den 1980er Jahren von Joffrey Hinton auf neuronale Netze angewendet. Mit anderen Worten, seit über 30 Jahren gibt es in der KI keine signifikanten konzeptionellen Fortschritte. Die meisten Ergebnisse von KI-Forschungen und Medienartikeln zeigen, was passiert, wenn Berge teurer Computergeräte und eine geniale Werbekampagne in die Umsetzung einer alten Idee gesteckt werden.

Und es kann nicht gesagt werden, dass DeepMind keine wertvolle Arbeit leistet. Die Hilfsarbeit von Maschinen bei der Entwicklung neuer Strategien und Ideen ist interessant, insbesondere wenn die Bedienung dieser Maschine aufgrund ihrer Komplexität schwer zu verstehen ist. In unserer säkularen Kultur zieht die Magie und das Geheimnis der Technologie Menschen an, und es ist nur von Vorteil, einem meist trockenen und rationalen Ingenieurgebiet ein mysteriöses Bild zu geben. In einem Google-Freund ist jedoch kein Geist.

Eisen gegen Software, Analog gegen Digital, Thompson gegen Hassabis

Der ganze Hype um DeepMind-Maschinen erinnert mich an die Aufregung, die vor ein paar Jahrzehnten nach einem völlig anderen und möglicherweise tieferen „maschinellen Lernsystem“ entstanden ist.

Im November 1997 erschien die

Arbeit von Adrian Thompson, einem Forscher am Zentrum für Computational Neurobiology and Robotics der University of Sussex, zusammen mit dem

Artikel „Kreationen aus prähistorischem Silizium - wir veröffentlichen den Darwinismus im Elektroniklabor und sehen, was er schafft“ auf dem Cover des New Scientist-Magazins. Ein hartes Auto, das niemand versteht. “

Thompsons Arbeit sorgte für eine leichte Sensation, als er den Zoll ablehnte und die Entwicklung des MO-Systems für elektronische Geräte einleitete, anstatt wie alle anderen einen programmatischen Ansatz zu verwenden. Er entschied sich dafür, weil er erkannte, dass digitale Software durch die binäre Ein / Aus-Natur der Schalter, aus denen das Signalverarbeitungsgehirn eines digitalen Computers besteht, eingeschränkt war.

Im Gegensatz dazu haben sich die Neuronen des menschlichen Gehirns entwickelt, um an verschiedenen subtilen, manchmal unverständlich komplexen physikalischen und biochemischen

Prozessen teilzunehmen. Thompson schlug vor, dass die Entwicklung von Computergeräten unter Verwendung eines automatischen Prozesses der natürlichen Selektion alle analogen (unendlich unterschiedlichen) physikalischen Eigenschaften der realen Welt nutzen kann, die Silizium innewohnt und die einfachsten digitalen Computerschalter bilden - was zu etwas ähnlich Effektivem führen kann analoge Arbeit der Komponenten des menschlichen Gehirns. Und er hatte recht.

In seinem Labor leitete Thompson die Entwicklung der FPGA-Konfiguration (eine Art digitaler Siliziumchip, bei dem die Verbindungen zwischen seinen digitalen Schaltern ständig neu konfiguriert werden können), um ihm beizubringen, wie zwei verschiedene Audiosignale getrennt werden. Nachdem er einen Blick in den Chip geworfen hatte, um zu sehen, wie der Evolutionsprozess die Verbindungen zwischen den Schaltern optimierte, stellte er ein beeindruckend effektives Arbeitsschema fest - es wurden nur 37 Komponenten verwendet.

Darüber hinaus wird das resultierende Evolutionsschema von Digitalingenieuren nicht mehr verstanden. Einige der 37 Komponenten waren nicht mit anderen verbunden, aber als sie aus dem Stromkreis entfernt wurden, funktionierte das gesamte System nicht mehr. Die einzig vernünftige Erklärung für diese seltsame Situation war, dass das System mysteriöse elektromagnetische Verbindungen zwischen ähnlichen digitalen Komponenten verwendete. Mit anderen Worten, der Evolutionsprozess übernahm die analogen Eigenschaften der Komponenten und Materialien des Systems aus der realen Welt, um seine „Berechnungen“ durchzuführen.

Es war eine Gehirnexplosion. Ich war in den 1990er Jahren ein junger Forscher, hatte Erfahrung in der Forschung zu

elektronischen Geräten und KI, und die Arbeit von Thompson hat mich erstaunt. Der Computer war nicht nur in der Lage, eine völlig neue Art elektronischer Schaltkreise zu erfinden und die Fähigkeiten von Elektronikingenieuren zu übertreffen, sondern vor allem den Weg zur Entwicklung unendlich leistungsfähigerer Computersysteme und KI aufzuzeigen.

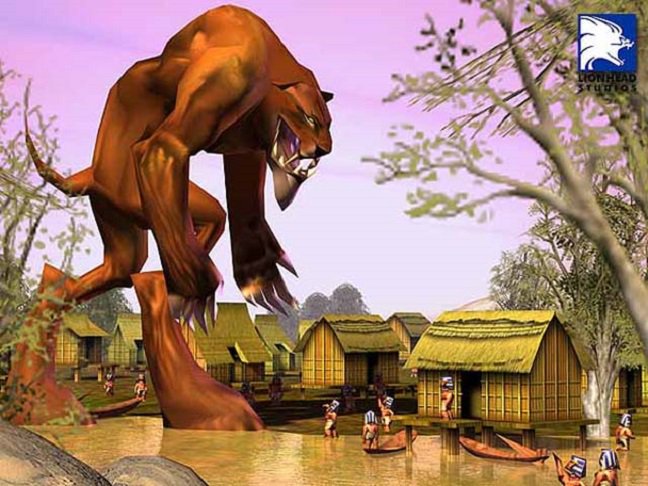

Hassabis begann als führender KI-Programmierer in dem inzwischen vergessenen Spiel von Lionhead Studio, Black & White.

Hassabis begann als führender KI-Programmierer in dem inzwischen vergessenen Spiel von Lionhead Studio, Black & White.Also, was ist passiert? Warum ist Thompson fast vergessen und Googles Muttergesellschaft Alphabet wirft Hassabis mit Geld, und Dokumentarfilme der Luftwaffe singen ihm Panegyrik vor? Zum größten Teil geht es um eine gute Zeit. In den 1990er Jahren war AI so trendy wie Omas Schlüpfer. Heute muss die KI uns zur "vierten industriellen Revolution" führen. Das Kapital verfolgt das "nächste große Projekt". Obwohl die digitalen KI-Systeme von DeepMind nicht sehr gut zur Modellierung komplexer realer analoger Systeme wie des Wetters oder des menschlichen Gehirns geeignet sind, eignen sie sich auf jeden Fall gut zum Mahlen digitaler Daten aus der einfachsten digitalen Online-Welt in Form von Links, Klicks, Likes, Wiedergabelisten und Pixeln .

DeepMind profitierte auch von seiner Fähigkeit, das Produktgesicht zu zeigen. DeepMind bewarb seine Technologie und Führung und kultivierte das technologische Rätsel, aber die gesamte Demonstration seiner Arbeit lief auf Spielzeug mit den einfachsten berechenbaren Regeln hinaus. Der Vorteil von Spielen ist ihre Verständlichkeit und visuelle Attraktivität für die Medien und die Öffentlichkeit. Tatsächlich werden die meisten kommerziellen Anwendungen dieser Technologie mit

alltäglichen Hintergrundgeschäftsanwendungen verbunden sein , beispielsweise zur

Optimierung der Energieeffizienz von Rechenzentren, in denen Google seine Computer speichert.

Ceci n'est pas une paddle *

* "Dies ist kein Ruder" - ein Hinweis auf das Gemälde " Verrat der Bilder "Thompson und Hassabis - abgesehen davon, dass sie Briten waren, verfügten sie definitiv über die Erfahrung und die Fähigkeiten, die für das effektive Training und die Weiterentwicklung ihrer Systeme erforderlich sind, aber eine solche Abhängigkeit von den Fähigkeiten und der Kreativität der Menschen ist offensichtlich eine Schwäche eines KI- oder MO-Systems. Auch ihre Technologie war sehr zerbrechlich. Beispielsweise haben Thompson-Systeme häufig aufgehört, bei Temperaturen zu arbeiten, die sich von denen unterscheiden, bei denen sie sich entwickelt haben. In DeepMind wurde die Effektivität der KI durch einfaches

Ändern der Paddelgröße in einem der Videospiele des Unternehmens vollständig zunichte gemacht. Diese Zerbrechlichkeit ist darauf zurückzuführen, dass AI von DeepMind nicht versteht, was ein Paddel ist - und sogar das Videospiel selbst; Die Schalter funktionieren nur mit Binärzahlen.

In letzter Zeit haben die MO-Systeme wirklich große Erfolge erzielt, aber dieser Fortschritt wurde größtenteils durch die Verwendung einer großen Menge von Standard-Computergeräten zur Lösung von Problemen und nicht durch radikale Innovationen erzielt. Irgendwann in nicht allzu ferner Zukunft wird es nicht mehr möglich sein, mehr winzige Siliziumschalter auf einen Siliziumchip zu stopfen. Die Effizienz der Schaltung (mehr Berechnungen mit weniger Geräten) wird kommerziell wichtig, und an diesem Punkt können sich entwickelnde Geräte endlich in Mode kommen.

Es können auch Hybridsysteme auftreten, die die Ansätze von Thompson und Hassabis kombinieren. Aber egal was passiert, Harrari muss warten, bis er ein „kreatives“ KI-System erwerben kann, um sein nächstes Bestseller-Buch zu schreiben.