Interpretation der Rede auf der Web Camp Zagreb Konferenz Maciej Tseglovsky, ein amerikanischer Webentwickler, Unternehmer, Redner und Sozialkritiker polnischer Herkunft.

Interpretation der Rede auf der Web Camp Zagreb Konferenz Maciej Tseglovsky, ein amerikanischer Webentwickler, Unternehmer, Redner und Sozialkritiker polnischer Herkunft.Als sich amerikanische Physiker 1945 darauf vorbereiteten, die Atombombe zu testen, kam jemand auf die Frage, ob ein solcher Test die Atmosphäre entzünden könnte.

Die Angst war berechtigt. Der Stickstoff, der den größten Teil der Atmosphäre ausmacht, ist energetisch instabil. Wenn die beiden Atome stark genug kollidieren, verwandeln sie sich in ein Magnesiumatom, ein Alpha-Teilchen, und setzen enorme Energie frei:

N

14 + N

14 ⇒ Mg

24 + α + 17,7 MeV

Eine wichtige Frage war, ob diese Reaktion sich selbst tragen könnte. Die Temperatur in der Kugel einer nuklearen Explosion sollte alles übersteigen, was einst auf der Erde beobachtet wurde. Könnte es sein, dass wir ein Streichholz in einen Haufen trockener Blätter werfen?

Physiker aus Los Alamos führten eine Analyse durch und stellten fest, dass die Sicherheitsmarge zufriedenstellend war. Da wir heute alle zur Konferenz gekommen sind, wissen wir, dass sie Recht hatten. Sie waren zuversichtlich in ihre Vorhersagen, da die Gesetze für Kernreaktionen unkompliziert und bekannt waren.

Heute schaffen wir eine andere Technologie, die die Welt verändert - die Maschinenintelligenz. Wir wissen, dass dies enorme Auswirkungen auf die Welt haben, die Funktionsweise der Wirtschaft verändern und den unvorhersehbaren Dominoeffekt auslösen wird.

Es besteht aber auch das Risiko einer unkontrollierbaren Reaktion, bei der die KI schnell genug das menschliche Intelligenzniveau erreicht und übertrifft. Und in diesem Moment werden uns soziale und wirtschaftliche Probleme am wenigsten beunruhigen. Jede ultra-intelligente Maschine hat ihre eigenen Hyperziele und arbeitet daran, diese zu erreichen, indem sie Menschen manipuliert oder einfach ihren Körper als bequeme Quelle für Ressourcen verwendet.

Im vergangenen Jahr veröffentlichte der Philosoph Nick Bostrom das Buch Superintelligence, in dem er die alarmistische Sichtweise der KI beschrieb und zu beweisen versuchte, dass eine solche Explosion der Intelligenz sowohl gefährlich als auch unvermeidlich ist, wenn man sich auf einige moderate Annahmen stützt.

Der Computer, der die Welt erobert, ist das Lieblingsthema von NF. Viele Menschen nehmen dieses Szenario jedoch ernst, daher müssen wir sie ernst nehmen. Stephen Hawking, Elon Musk, eine große Anzahl von Investoren und Milliardären aus dem Silicon Valley halten dieses Argument für überzeugend.

Lassen Sie mich zunächst die Voraussetzungen skizzieren, die erforderlich sind, um Bostroms Argumentation zu beweisen.

Hintergrund

Voraussetzung 1: Ideeneffizienz

Die erste Prämisse ist eine einfache Beobachtung der Existenz eines denkenden Geistes. Jeder von uns trägt auf seinen Schultern eine kleine Schachtel mit denkendem Fleisch. Ich benutze meine, um zu sprechen, du benutzt meine, um zuzuhören. Manchmal können diese Köpfe unter den richtigen Bedingungen rational denken.

Wir wissen also, dass dies im Prinzip möglich ist.

Voraussetzung 2: keine Quantenprobleme

Die zweite Prämisse besagt, dass das Gehirn die übliche Konfiguration von Materie ist, obwohl es äußerst komplex ist. Wenn wir genug darüber wüssten und die richtige Technologie hätten, könnten wir seine Struktur genau kopieren und sein Verhalten mithilfe elektronischer Komponenten emulieren, genau wie heute können wir eine sehr einfache Anatomie von Neuronen simulieren.

Mit anderen Worten, diese Prämisse besagt, dass Bewusstsein unter Verwendung gewöhnlicher Physik entsteht. Einige Leute, wie

Roger Penrose , hätten sich diesem Argument widersetzt und geglaubt, dass auf Quantenebene etwas Ungewöhnliches im Gehirn passiert.

Wenn Sie religiös sind, können Sie glauben, dass das Gehirn ohne Seele nicht arbeiten kann.

Aber für die meisten Menschen ist diese Prämisse leicht zu akzeptieren.

Voraussetzung 3: viele mögliche Köpfe.

Die dritte Voraussetzung ist, dass der Raum aller möglichen Köpfe groß ist.

Unser Intelligenzniveau, unsere Denkgeschwindigkeit, eine Reihe kognitiver Verzerrungen usw. nicht vorbestimmt, sondern Artefakte unserer Evolutionsgeschichte. Insbesondere gibt es kein physikalisches Gesetz, das die Intelligenz auf menschlicher Ebene einschränkt.

Es ist gut, sich ein Beispiel dafür vorzustellen, was in der Natur passiert, wenn versucht wird, die Geschwindigkeit zu maximieren. Wenn Sie in vorindustriellen Zeiten einen Geparden getroffen haben (und überlebt haben), können Sie entscheiden, dass sich nichts schneller bewegen kann.

Aber wir wissen natürlich, dass es alle Arten von Materiekonfigurationen gibt, zum Beispiel ein Motorrad, das sich schneller als ein Gepard bewegen und sogar steiler aussehen kann. Es gibt jedoch keinen direkten Entwicklungsweg zum Motorrad. Die Evolution musste zuerst Menschen erschaffen, die bereits alle möglichen nützlichen Dinge erschaffen hatten.

In Analogie mag es Köpfe geben, die viel schlauer sind als unsere, aber während der Evolution auf der Erde unzugänglich sind. Es ist möglich, dass wir sie erstellen oder Maschinen erfinden können, die Maschinen erfinden können, die sie erstellen können.

Es mag eine natürliche Grenze für die Intelligenz geben, aber es gibt keinen Grund zu der Annahme, dass wir nahe daran sind. Vielleicht ist der klügste Intellekt doppelt so klug wie der Mensch und vielleicht sechzigtausend.

Diese Frage ist empirisch und wir wissen nicht, wie wir sie beantworten sollen.

Prämisse 4: Oben ist viel Platz

Die vierte Voraussetzung ist, dass Computer immer noch viele Möglichkeiten bieten, schneller und kleiner zu werden. Sie können davon ausgehen, dass sich Moores Gesetz verlangsamt - aber für diese Prämisse reicht es zu glauben, dass Eisen im Prinzip kleiner und schneller ist, bis zu mehreren Größenordnungen.

Aus der Theorie ist bekannt, dass die physikalischen

Grenzen der Berechnungen ziemlich hoch sind. Wir können die Zahlen für mehrere Jahrzehnte verdoppeln, bis wir auf eine grundlegende physikalische Grenze stoßen und nicht auf die wirtschaftliche oder politische Grenze von Moores Gesetz.

Prämisse 5: Computerzeitskalen

Die vorletzte Prämisse ist, dass wenn es uns gelingt, KI zu erstellen, sei es eine Emulation des menschlichen Gehirns oder eine spezielle Software, diese auf Zeitskalen funktioniert, die für die Elektronik charakteristisch sind (Mikrosekunden) und nicht für den Menschen (Stunden). .

Um einen Zustand zu erreichen, in dem ich diesen Bericht erstellen kann, musste ich geboren werden, aufwachsen, zur Schule gehen, zur Universität gehen, ein wenig leben, hierher fliegen und so weiter. Computer können zehntausende Male schneller laufen.

Insbesondere kann man sich vorstellen, dass der elektronische Verstand seine Schaltung (oder die Hardware, auf der er arbeitet) ändern und zu einer neuen Konfiguration übergehen kann, ohne alles auf menschlicher Ebene neu studieren zu müssen, lange Gespräche mit menschlichen Lehrern zu führen, aufs College zu gehen, Versuchen Sie, sich selbst zu finden, indem Sie an Malkursen teilnehmen und so weiter.

Voraussetzung 6: Rekursive Selbstverbesserung

Die letzte Prämisse ist meine Favoritin, da sie schamlos amerikanisch ist. Demnach wird er sich verbessern wollen, egal welche Ziele die KI haben mag (was seltsame, fremde Ziele sein mögen). Er möchte die beste Version von AI sein.

Daher wird er es nützlich finden, seine eigenen Systeme rekursiv umzugestalten und zu verbessern, um sich selbst schlauer zu machen und möglicherweise in einem kühleren Gebäude zu leben. Und gemäß der Prämisse der Zeitskalen kann eine rekursive Selbstverbesserung sehr schnell auftreten.

Fazit: eine Katastrophe!

Wenn wir diese Prämissen akzeptieren, kommen wir zu einer Katastrophe. Irgendwann, mit zunehmender Geschwindigkeit von Computern und der Intelligenz von Programmen, wird ein unkontrollierter Prozess auftreten, der einer Explosion ähnelt.

Sobald der Computer die menschliche Intelligenz erreicht hat, braucht er nicht mehr die Hilfe von Menschen, um eine verbesserte Version von sich selbst zu entwickeln. Er wird dies viel schneller tun und nicht aufhören, bis er die natürliche Grenze erreicht hat, die sich als um ein Vielfaches größer als die menschliche Intelligenz herausstellen kann.

In diesem Moment kann diese monströse rationale Kreatur, die eine Kreisverkehrssimulation der Arbeit unserer Emotionen und unseres Intellekts verwendet, uns davon überzeugen, ihm Zugang zu Fabriken zu gewähren, künstliche DNA zu synthetisieren oder ihn einfach ins Internet gehen zu lassen, wo er einen Weg zu allem aufbrechen kann. alles und zerstören alle in der Debatte in den Foren vollständig. Und von diesem Moment an wird alles sehr schnell zu Science Fiction.

Stellen wir uns eine bestimmte Entwicklung der Ereignisse vor. Nehmen wir an, ich möchte einen Roboter bauen, der Witze sagt. Ich arbeite mit einem Team, und jeden Tag wiederholen wir unser Programm, kompilieren und dann erzählt uns der Roboter einen Witz. Der Roboter ist zunächst praktisch nicht lustig. Er ist auf dem niedrigsten Niveau menschlicher Fähigkeiten.

Was ist grau und kann nicht schwimmen?

Schloss

Aber wir arbeiten hart daran und am Ende erreichen wir den Punkt, an dem der Roboter Witze macht, die bereits anfangen, lustig zu sein:

Ich sagte meiner Schwester, dass sie ihre Augenbrauen zu hoch zieht.

Sie sah überrascht aus.

In diesem Stadium wird der Roboter noch intelligenter und beginnt, an seiner eigenen Verbesserung teilzunehmen. Jetzt hat er bereits ein gutes instinktives Verständnis dafür, was lustig ist und was nicht, also hören die Entwickler auf seinen Rat. Infolgedessen erreicht er ein fast übermenschliches Niveau, auf dem er lustiger ist als jeder Mensch aus seiner Umgebung.

Mein Gürtel hält meine Hose und die Schlaufen an meiner Hose halten den Gürtel.

Was ist los? Welcher von ihnen ist ein echter Held?

An diesem Punkt beginnt ein unkontrollierbarer Effekt. Die Forscher gehen für das Wochenende nach Hause, und der Roboter beschließt, sich neu zu kompilieren, um ein bisschen lustiger und ein bisschen schlauer zu werden. Er verbringt das Wochenende damit, den Teil zu optimieren, der die Arbeit immer wieder gut macht. Ohne mehr Hilfe von einer Person zu benötigen, kann er dies so schnell tun, wie es das Eisen erlaubt.

Wenn Forscher am Montag zurückkehren, wird die KI zehntausende Male lustiger als alle Menschen auf der Erde. Er erzählt ihnen einen Witz und sie sterben vor Lachen. Und jeder, der versucht, mit einem Roboter zu sprechen, stirbt vor Lachen, wie in einer Parodie von Monty Python. Die Menschheit stirbt vor Lachen.

Den wenigen Menschen, die ihm eine Nachricht geben konnten, in der sie ihn aufforderten aufzuhören, erklärt die KI (auf witzige und selbstironische Weise, die sich als tödlich herausstellt), dass es ihm egal ist, ob Menschen überleben oder sterben, sein Ziel ist es einfach, lächerlich zu sein.

Infolgedessen baut die KI die Menschheit und baut Raumschiffe und Nano-Raketen, um die entferntesten Ecken der Galaxie zu untersuchen und nach anderen Kreaturen zu suchen, die unterhalten werden können.

Dieses Szenario ist eine Karikatur von Bostroms Argumenten, weil ich nicht versuche, Sie von seiner Wahrhaftigkeit zu überzeugen, sondern Sie damit impfe.

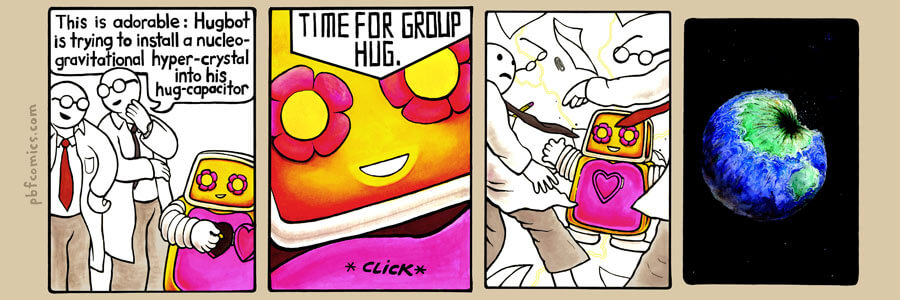

Comic von PBF mit der gleichen Idee:

Comic von PBF mit der gleichen Idee:

- Berühren: Die Umarmung versucht, einen Hyperkristall der nuklearen Schwerkraft in ihre Umarmung einzubetten!

- ...

- Zeit für Gruppenumarmungen!In diesen Szenarien ist die Standard-KI böse, genau wie eine Pflanze auf einem anderen Planeten standardmäßig giftig ist. Ohne sorgfältige Anpassung gibt es keinen Grund für die Motivation oder die Werte der KI, unseren zu ähneln.

Das Argument argumentiert, dass wir diese Weltanschauung in ihre Grundlagen einbetten müssen, damit der künstliche Geist etwas hat, das einem menschlichen Wertesystem ähnelt.

KI-Alarmisten lieben das Beispiel des Büroklammermaximierers - einen fiktiven Computer, der eine Büroklammerfabrik betreibt, die intelligent wird, sich rekursiv auf gottähnliche Fähigkeiten verbessert und dann seine ganze Energie darauf verwendet, das Universum mit Büroklammern zu füllen.

Es zerstört die Menschheit nicht, weil es böse ist, sondern weil Eisen in unserem Blut ist, das besser zur Herstellung von Büroklammern verwendet wird. Wenn wir also einfach eine KI erschaffen, ohne ihre Werte anzupassen, heißt es im Buch, dann ist eines der ersten Dinge, die er tut, die Zerstörung der Menschheit.

Es gibt viele bunte Beispiele dafür, wie dies geschehen kann. Nick Bostrom stellt vor, wie das Programm vernünftig wird, wartet, baut heimlich kleine Geräte zur Reproduktion von DNA. Wenn alles fertig ist, dann:

Nanofabriken, die Nervengas oder Zielsuchraketen von der Größe von Mücken produzieren, werden gleichzeitig von jedem Quadratmeter des Planeten platzen, und dies wird das Ende der Menschheit sein.

Das ist wirklich Zinn!

Der einzige Weg, um aus diesem Chaos herauszukommen, besteht darin, einen solchen moralischen Punkt zu entwickeln, dass das KI-Wertesystem auch nach Tausenden und Abertausenden von Selbstverbesserungszyklen stabil bleibt und zu seinen Werten Dinge wie „Menschen helfen“, „niemanden töten“ und „auf die Wünsche der Menschen hören“ gehören ".

Das heißt: "Tu was ich meine."

Hier ist ein sehr poetisches Beispiel von Eliezer Yudkowsky, das amerikanische Werte beschreibt, die wir brauchen, um unsere KI zu lehren:

Kohärenter extrapolierter Wille ist unser Wunsch, mehr zu wissen, schneller zu denken und unseren Vorstellungen von uns selbst zu entsprechen, einander näher zu kommen; so dass unsere Gedanken einander näher sind als geteilt, dass unsere Wünsche dazu beitragen, sich nicht widersetzen, dass unsere Wünsche so interpretiert werden, wie wir sie interpretieren wollen.

Wie gefällt dir TK? Jetzt schreiben wir den Code.

Ich hoffe, Sie sehen die Ähnlichkeit dieser Idee mit dem Geist aus Märchen. Die KI ist allmächtig und gibt Ihnen, was Sie fragen, interpretiert aber alles zu wörtlich, wodurch Sie die Anfrage bereuen.

Und nicht, weil der Geist dumm (er ist super schlau) oder bösartig ist, sondern einfach, weil Sie als Person zu viele Annahmen über das Verhalten des Geistes gemacht haben. Das menschliche Wertesystem ist einzigartig und muss klar definiert und in einer „freundlichen“ Maschine implementiert werden.

Dieser Versuch ist eine ethische Version eines Versuchs zu Beginn des 20. Jahrhunderts, die Mathematik zu formalisieren und auf eine starre logische Grundlage zu stellen. Niemand sagt jedoch, dass der Versuch in einer Katastrophe endete.

Als ich etwas über zwanzig war, lebte ich in Vermont, in einem Provinz- und Landstaat. Oft kam ich mit einem Abendflugzeug von Geschäftsreisen zurück und musste eine Stunde lang mit dem Auto durch den dunklen Wald nach Hause fahren.

Ich habe mir dann das Abendprogramm im Art Bell Radio angehört - es war eine Talkshow, die die ganze Nacht dauerte und in der die Moderatoren verschiedene Liebhaber der Verschwörungstheorie und Menschen mit innovativem Denken interviewten. Ich kam eingeschüchtert nach Hause oder blieb unter einer Taschenlampe stehen, unter dem Eindruck, dass Außerirdische mich bald entführen würden. Dann fiel es mir sehr leicht, mich zu überzeugen. Beim Lesen ähnlicher Szenarien im Zusammenhang mit KI geht es mir genauso.

Daher freute ich mich, nach einigen Jahren einen Aufsatz von Scott Alexander zu entdecken, in dem er über die erlernte erkenntnistheoretische Hilflosigkeit schrieb.

Erkenntnistheorie ist eines dieser großen und komplexen Wörter, aber es bedeutet wirklich: „Woher weißt du, dass das, was du weißt, wirklich wahr ist?“ Alexander bemerkte, dass er als junger Mann sehr an verschiedenen "alternativen" Geschichten für die Urheberschaft aller Arten von

Verrückten interessiert war. Er las diese Geschichten und glaubte ihnen vollständig, dann las er die Widerlegung und glaubte ihm und so weiter.

Einmal entdeckte er drei alternative Geschichten, die sich widersprachen, weshalb sie nicht gleichzeitig wahr sein konnten. Daraus schloss er, dass er einfach ein Mann war, der seinen Urteilen nicht trauen konnte. Er war zu leicht zu überzeugen.

Menschen, die an Superintelligenz glauben, stellen einen interessanten Fall dar - viele von ihnen sind überraschend klug. Sie können Sie mit ihren Argumenten in den Boden treiben. Aber sind ihre Argumente wahr oder sind nur sehr kluge Leute anfällig für religiöse Überzeugungen über die Risiken, die von KI ausgehen, was es sehr einfach macht, sie zu überzeugen? Ist die Idee der Superintelligenz eine Nachahmung einer Bedrohung?

Wenn Sie überzeugende Argumente zu einem seltsamen Thema bewerten, können Sie zwei Perspektiven auswählen, interne und externe.

Angenommen, eines Tages erscheinen Menschen in lustigen Kleidern vor Ihrer Haustür und fragen Sie, ob Sie sich ihrer Bewegung anschließen möchten. Sie glauben, dass das UFO zwei Jahre später die Erde besuchen wird und dass unsere Aufgabe darin besteht, die Menschheit auf den großen Aufstieg auf dem Strahl vorzubereiten.

Eine interne Perspektive erfordert eine intensive Diskussion ihrer Argumente. Sie fragen die Besucher, wie sie von UFOs erfahren haben, warum sie glauben, dass er zu uns kommt, um uns abzuholen - Sie stellen alle möglichen normalen Fragen, die ein Skeptiker in einem solchen Fall stellen würde.

Stellen Sie sich vor, Sie haben eine Stunde mit ihnen gesprochen und sie haben Sie überzeugt. Sie bestätigten ironischerweise das bevorstehende Kommen eines UFO, die Notwendigkeit, sich darauf vorzubereiten, und Sie glaubten immer noch nicht an so viel in Ihrem Leben, wie Sie jetzt an die Wichtigkeit glauben, die Menschheit auf dieses große Ereignis vorzubereiten.

Die äußere Perspektive sagt Ihnen etwas anderes. Die Leute sind seltsam gekleidet, sie haben Perlen, sie leben in einer Art abgelegenem Lager, sie sprechen gleichzeitig und ein wenig beängstigend. Und obwohl ihre Argumente eisern sind, sagt Ihre ganze Erfahrung, dass Sie einem Kult begegnet sind.

Natürlich haben sie gute Argumente dafür, warum Sie den Instinkt ignorieren sollten, aber dies ist eine interne Perspektive. Eine externe Perspektive kümmert sich nicht um den Inhalt, sie sieht die Form und den Kontext und sie mag das Ergebnis nicht.

Daher möchte ich das Risiko einer KI aus beiden Perspektiven ansprechen. Ich denke, die Argumente für Superintelligenz sind dumm und voller nicht unterstützter Annahmen. Aber wenn sie Ihnen überzeugend erscheinen, dann ist etwas Unangenehmes mit KI-Alarmismus als kulturellem Phänomen verbunden, weshalb wir es nur ungern ernst nehmen sollten.

Zunächst einige meiner Argumente gegen die Superintelligenz von Bostroma, die ein Risiko für die Menschheit darstellt.

Argument gegen unscharfe Definitionen

« » () . , , , , .

, – - , , ( -) .

( ), , . , – . , , , , . .

– , , , . ?

. . , , , . , .

, , – . , - , . , , .

, , «, », , , «, ».

, . , . , , , .

, , .

, , , , .

. , , .

1930- , , . , .

: , , , .

, .

. -. , , , , , ?

Ethereum, ,

.

,

. , - , , , .

. , , . , , . , , , – .

. , , ; , , .

« » , , , , – , « ?» , – , .

, « » , , reddit/r/paperclip, , .

AdSense , .

, , , . . , .

Google Google Home, .

, , , . , . , «», .

, . , , – World of Warcraft .

, , , , , .

, , ,

.

, , , , , , -.

, , [-, , 2016 , / . .]. . .

, . . , , , .

. , , . , , - .

, , , . , .

, – . , , , .

, , , , , .

*

[

1954 / . . ]]

, , , . , , , ( ).

Intel , , .

? .

, . , .

Wenn Sie glauben, dass die KI es uns ermöglicht, die Galaxie zu erobern (ganz zu schweigen von der Simulation von Billionen von Gedanken), haben Sie erschreckende Zahlen in Ihren Händen. Riesige Zahlen multipliziert mit winzigen Wahrscheinlichkeiten sind das Kennzeichen des KI-Alarmismus.

Bostrom beschreibt irgendwann, worum es seiner Meinung nach geht:

Wenn wir uns all das Glück vorstellen, das wir während eines Lebens in Form einer Träne der Freude erfahren haben, dann wird das Glück all dieser Seelen in der Lage sein, die Ozeane der Erde jede Sekunde zu füllen und zu füllen, und dies für Hunderte von Milliarden von Milliarden von Jahrtausenden. Es ist sehr wichtig, dass wir garantieren, dass diese Tränen Freudentränen sind.

Ziemlich schwere Belastung für die Schultern eines 20-jährigen Entwicklers!

Hier gibt es natürlich einen „Salon-Fokus“, wenn man sich durch Multiplikation astronomischer Größen mit winzigen Wahrscheinlichkeiten von der Notwendigkeit überzeugen kann, einige seltsame Dinge zu tun.

All diese Bewegung in Bezug auf die Rettung der Zukunft der Menschheit ist ein feiger Kompromiss. Wir haben die gleichen Argumente erlebt, um den Kommunismus zu rechtfertigen und zu erklären, warum immer alles kaputt ist und die Menschen kein elementares Maß an materiellem Komfort haben können.

Wir wollten diese Welt reparieren, und nach diesem Glück wird es so viel geben, dass sich das tägliche Leben jedes Menschen verbessern wird. Dafür war es jedoch zunächst notwendig, die Welt zu reparieren.

Ich lebe in Kalifornien und hier ist der höchste Prozentsatz an Bettlern unter allen Vereinigten Staaten, obwohl sich auch das Silicon Valley hier befindet. Ich sehe nichts, was meine reiche Industrie tun würde, um das Leben der einfachen Leute und der verzweifelten Menschen um uns herum zu verbessern. Wenn Sie sich jedoch für die Idee der Superintelligenz begeistern, ist die Forschung auf dem Gebiet der KI das Wichtigste, was Sie auf dem Planeten tun können. Dies ist wichtiger als Politik, Malaria, hungernde Kinder, Kriege, globale Erwärmung - alles, was Sie sich vorstellen können. In der Tat wurde unter der Bedrohung von Billionen und Billionen von Kreaturen die gesamte Bevölkerung der Zukunft der Menschheit, simuliert und gegenwärtig, in der zukünftigen Zeit zusammengefasst. Und unter solchen Bedingungen erscheint die Arbeit an anderen Problemen nicht rational.

Größenwahn

Diese Haltung verschmilzt mit Größenwahn, mit diesen Bösewichten von Bond, die an der Spitze unserer Branche stehen. Die Leute glauben, dass die Welt von Superintelligenz überwältigt sein wird, und sie verwenden dieses Argument, um zu rechtfertigen, warum kluge Leute zuerst versuchen sollten, die Welt zu übernehmen - um sie zu reparieren, bevor die KI sie bricht.

Joey Ito, Leiter des MIT Media Lab, sagte kürzlich in einem Gespräch mit Obama etwas Wunderbares:

Dies mag einen meiner Studenten am MIT verärgern, aber eines meiner Anliegen ist, dass die wichtigsten AI-bezogenen Informatiken junge Männer sind, meistens weiße, die lieber mit Computern kommunizieren als andere Menschen. Viele von ihnen glauben, dass wir uns keine Sorgen um so hässliche Dinge wie Politik und Gesellschaft machen müssen, wenn sie diese universelle KI aus Science-Fiction erstellen können. Sie denken, dass Autos alles für uns haben werden.

Besessene KI-Leute erkennen, dass die Welt keine Programmieraufgabe ist und wollen sie in eine Programmieraufgabe verwandeln, indem sie eine gottähnliche Maschine entwerfen. Das ist Größenwahn, und ich mag es nicht.

Voodoo-Transhumanismus

Wenn Sie von den Risiken der KI überzeugt sind, müssen Sie einen ganzen Wagen trauriger Überzeugungen mitnehmen, die mit einem Anhänger zu ihnen fahren.

Für den Anfang ist dies Nanotechnologie. Jede ständige Superintelligenz wird in der Lage sein, winzige Autos zu bauen, die zu allen möglichen Dingen fähig sind. Wir werden in einer Gesellschaft leben, die sich von einem Defizit befreit hat, in dem es eine Fülle von Material gibt.

Die Nanotechnologie kann auch Ihr Gehirn scannen, damit Sie es in einen anderen Körper oder in die virtuelle Welt laden können. Daher ist die zweite Konsequenz freundlicher Superintelligenz, dass niemand stirbt - und wir werden unsterblich.

Gute KI kann sogar die Toten wiederbeleben. Nanomaschinen können in mein Gehirn gelangen, die Erinnerungen meines Vaters studieren und seine Simulation erstellen, mit der ich interagieren kann und die mich immer enttäuscht, unabhängig davon, was ich tue.

Eine weitere seltsame Folge des Aufkommens der KI ist die galaktische Expansion. Ich konnte nie verstehen, warum dies geschieht, aber dies ist die Grundlage für die Ideen der Transhumanisten. Das Schicksal der Menschheit besteht entweder darin, unseren Planeten zu verlassen und die Galaxie zu kolonisieren oder zu sterben. Und diese Aufgabe wird immer dringlicher, da andere Zivilisationen die gleiche Wahl treffen und uns im Weltraumrennen überholen können.

Daher hängen viele seltsame komplementäre Ideen mit der Annahme der Existenz einer wahren KI zusammen.

Religion 2.0

In der Tat ist es eine Art Religion. Die Menschen nannten den Glauben an technologische Singularität „eine Apokalypse für Nerds“, und das ist es auch. Dies ist ein cooler Hack - anstatt an einen externen Gott zu glauben, stellen Sie sich vor, wie Sie selbst eine Kreatur erschaffen, deren Funktionalität mit Gott identisch ist. Hier können sogar wahre Atheisten ihren Weg zu einem bequemen Glauben rationalisieren.

KI hat alle Eigenschaften eines Gottes: Er ist allmächtig, allwissend und unterstützt entweder (wenn Sie die Überprüfung der Grenzen des Arrays richtig organisiert haben) oder den reinen Teufel, in dessen Barmherzigkeit Sie sich befinden. Und wie in jeder Religion gibt es sogar ein Gefühl der Dringlichkeit. Müssen heute handeln! Auf dem Spiel steht das Schicksal der Welt! Und natürlich

brauchen sie Geld .

Da diese Argumente religiöse Instinkte ansprechen, sind sie, sobald sie verwurzelt sind, sehr schwer zu beseitigen.

Comic-Ethik

Diese religiösen Überzeugungen führen zu einer Comic-Ethik, in der mehrere einsame Helden die Aufgabe erhalten, die Welt mit Technologie und einem scharfen Verstand zu retten. Und es geht um das Schicksal des Universums. Infolgedessen ist unsere Branche voller reicher Typen, die sich vorstellen, Batman zu sein (interessanterweise will niemand Robin sein).

Fiebersimulationen

Wenn Sie an die Möglichkeit eines künstlichen Lebens glauben und dass KI extrem leistungsfähige Computer entwickeln kann, werden Sie höchstwahrscheinlich glauben, dass wir in einer Simulation leben. So funktioniert es

Angenommen, Sie sind ein Historiker, der in einer Welt nach der Singularität lebt. Sie studieren den Zweiten Weltkrieg und möchten wissen, was passieren wird, wenn Hitler 1941 Moskau einnimmt. Da Sie Zugang zu Hypercomputern haben, richten Sie die Simulation ein, beobachten die Konvergenz der Armeen und schreiben wissenschaftliche Arbeiten.

Aufgrund der Granularität der Simulation sind ihre Charaktere intelligente Wesen wie Sie. Daher können Sie die Simulation aufgrund der Ethikempfehlung Ihrer Universität nicht deaktivieren. Sie haben nicht nur vorgetäuscht, der Holocaust zu sein. Als Ethikforscher müssen Sie jetzt die Simulation betriebsbereit halten.

Infolgedessen wird die simulierte Welt Computer erfinden, AI, wird beginnen, ihre eigenen Simulationen auszuführen. In gewisser Weise werden Simulationen die Hierarchie immer weiter durchlaufen, bis Ihnen die Prozessorleistung ausgeht.

Jede zugrunde liegende Realität kann also eine große Anzahl verschachtelter Simulationen enthalten, und ein einfaches

Zählargument beweist, dass die Wahrscheinlichkeit, dass wir in einer Simulation leben, größer ist als die, dass wir in der realen Welt leben.

Aber daran zu glauben bedeutet, an Magie zu glauben. Wenn wir uns in einer Simulation befinden, wissen wir nichts über die Regeln auf einer höheren Ebene. Wir wissen nicht einmal, ob Mathematik dort genauso funktioniert - vielleicht in der simulierenden Welt 2 + 2 = 5 oder sogar 2 + 2 =.

Eine simulierte Welt liefert keine Informationen über die Welt, in der sie gestartet wurde. In der Simulation können Menschen leicht von den Toten auferstehen, wenn der Administrator die erforderlichen Backups gespeichert hat. Und wenn wir einen der Admins kontaktieren, haben wir tatsächlich eine direkte Verbindung zu Gott.

Dies ist eine ernsthafte Bedrohung für die geistige Gesundheit. Je tiefer Sie in die Welt der Simulationen eintauchen, desto verrückter werden Sie.

Wir haben jetzt vier unabhängige Wege, um durch den Supermind unsterblich zu werden:

- Die wohlwollende KI erfindet die medizinische Nanotechnologie und unterstützt den Körper in jungen Jahren für immer.

- AI erfindet einen vollständigen Gehirn-Scan, einschließlich Gehirn-Scans von Toten, gefrorenen Köpfen usw., mit denen Sie in einem Computer leben können.

- KI „belebt“ Menschen wieder, indem sie das Gehirn anderer Menschen auf der Suche nach Erinnerungen an eine Person scannt und dies mit Videos und anderen Materialien kombiniert. Wenn sich niemand gut genug an einen Menschen erinnert, kann er in einer Simulation, die mit seiner DNA beginnt und alle Lebensbedingungen wiederherstellt, immer von Grund auf neu wachsen.

- Wenn wir bereits in der Simulation leben, besteht die Möglichkeit, dass derjenige, der sie gestartet hat, Backups erstellt und Sie sie davon überzeugen können, sie herunterzuladen.

Das meine ich mit KI, die sich mit religiösen Impulsen befasst. Welches andere Glaubenssystem bietet Ihnen vier Möglichkeiten für wissenschaftlich belegte Unsterblichkeit?

Wir haben erfahren, dass mindestens ein amerikanischer Plutokrat (höchstwahrscheinlich Elon Musk, der glaubt, dass die Chancen, dass wir in einer Simulation leben, eine Milliarde zu eins sind) ein Paar Encoder engagiert haben, um zu versuchen, die Simulation zu knacken. Aber das ist eine sehr grobe Absicht! Ich benutze es!

Wenn Sie der Meinung sind, dass Sie in einem Computerprogramm leben, sind Versuche, es auf segfault zu bringen, für jeden, der mit Ihnen darin lebt, unangemessen. Dies ist viel gefährlicher und verantwortungsloser als Atomwissenschaftler, die versuchen, die Atmosphäre in die Luft zu jagen.

Durst nach Daten

Wie ich bereits erwähnt habe, besteht der effektivste Weg, etwas Interessantes aus der von uns erstellten KI herauszuholen, darin, sie mit Daten zu löschen. Eine solche Dynamik ist sozial schädlich. Wir sind der orwellschen Einführung von Mikrofonen in jedem Haus nahe gekommen. KI-Daten werden zentralisiert und zum Trainieren neuronaler Netze verwendet, die dann besser auf unsere Wünsche eingehen können.

Wenn Sie jedoch der Meinung sind, dass dieser Weg uns zur KI führt, sollten Sie die Menge der gesammelten Daten in möglichst wenig geänderter Form maximieren. Dies bestärkt nur die Notwendigkeit, die meisten Daten zu sammeln und die umfassendste Überwachung durchzuführen.

Stringtheorie für Programmierer

Das Risiko einer KI ist die Stringtheorie für Programmierer. Es macht Spaß darüber nachzudenken, es ist interessant und für Experimente auf dem Niveau der modernen Technologie völlig unzugänglich. Sie können mentale Kristallpaläste bauen, die auf den Grundprinzipien basieren, und dann in sie klettern und die Leiter hinter ihnen festziehen.

Menschen, die auf der Grundlage einer langen Kette abstrakter Argumente zu absurden Schlussfolgerungen gelangen können und auf ihre Wahrheit vertrauen - das sind keine Menschen, denen das Kulturmanagement anvertraut werden muss.

Der Drang zum Wahnsinn

Dieser ganze Bereich der "Forschung" führt zum Wahnsinn. Eines der Kennzeichen für tiefes Nachdenken über KI-Risiken ist, dass Sie bei anderen Enthusiasten umso beliebter werden, je verrückter Ihre Ideen sind. Dies zeigt Ihren Mut, diesem Gedankengang bis zum Ende zu folgen.

Ray Kurzweil , der glaubt, dass er nicht sterben wird, arbeitet seit mehreren Jahren mit Google zusammen und arbeitet jetzt wahrscheinlich an diesem Problem. Silicon Valley ist im Allgemeinen voll von Leuten, die unter dem Deckmantel des Geldes an verrückten Projekten arbeiten.

Cosplay AI

Der schädlichste soziale Effekt der Angst vor KI ist das, was ich Cosplay-KI nenne. Menschen, die von der Realität und Unvermeidlichkeit der KI überzeugt sind, beginnen sich zu verhalten, während ihre Fantasien ihnen sagen, was die superintelligente KI tun kann.

In seinem Buch listet Bostrom sechs Dinge auf, denen KI gelingen muss, bevor sie die Welt einnimmt:

- Multiplikation der Intelligenz.

- Strategisches Denken.

- Soziale Manipulation.

- Hacks

- Technologische Forschung.

- Wirtschaftliche Produktivität.

Wenn Sie sich die Anhänger der KI aus dem Silicon Valley ansehen, dann scheinen sie selbst an dieser quasi-soziopathischen Liste zu arbeiten.

Sam Altman, Leiter von YCombinator, ist mein Lieblingsbeispiel für einen solchen Archetyp. Er ist anscheinend fasziniert von der Idee, die Welt von Grund auf neu zu erfinden, den Einfluss und die persönliche Produktivität zu maximieren. Er hat Teams beauftragt, Städte von Grund auf neu zu erfinden, und ist in schattenpolitischen Betrug verwickelt, um die Wahlen zu beeinflussen.

Dieses Verhalten des „Umhangs und Dolches“, das der Techno-Elite innewohnt, wird eine negative Gegenreaktion von Menschen hervorrufen, die nicht an Technologien beteiligt sind, die nicht gerne manipuliert werden. Es ist unmöglich, endlos die Hebel der Macht zu ziehen, es wird schließlich beginnen, andere Mitglieder der demokratischen Gemeinschaft zu ärgern.

Ich habe Leute von den sogenannten beobachtet "Rationalistische Gemeinschaften" beziehen sich auf Personen, die nicht als effektiv gelten, "Nicht-Spieler-Charaktere" (NPCs), ein Begriff, der aus Spielen entlehnt wurde. Dies ist eine schreckliche Art, die Welt zu betrachten.

Ich arbeite in einer Branche, in der selbsternannte Rationalisten die verrücktesten Menschen sind. Es ist überwältigend.

Diese KI-Cosplayer sind wie Neunjährige, die im Hinterhof ein Campingcamp errichten und mit Taschenlampen in Zelten spielen. Sie projizieren ihre eigenen Schatten auf die Wände des Zeltes und haben Angst vor ihnen, als wären sie Monster.

Tatsächlich reagieren sie jedoch auf ein verzerrtes Selbstbild. Es gibt eine Rückkopplungsschleife zwischen der Art und Weise, wie kluge Menschen sich das Verhalten gottähnlicher Intelligenz vorstellen und wie sie ihr eigenes Verhalten aufbauen.

Was ist die Antwort, wie kann dies behoben werden?

Wir brauchen bessere Science Fiction! Und wie in vielen anderen Fällen haben wir die Technologie bereits.

Dies ist Stanislav Lem, der große polnische Science-Fiction-Autor. Die englischsprachige NF ist schrecklich, aber im Ostblock haben wir viele gute Waren, und wir müssen sie korrekt exportieren. Es wurde bereits aktiv ins Englische übersetzt, diese Übersetzungen müssen nur besser verteilt werden.

Was Autoren wie Lem oder die Brüder Strugatsky von ihren westlichen Partnern unterscheidet, ist, dass sie unter schwierigen Bedingungen aufgewachsen sind, den Krieg überlebt haben und dann in totalitären Gesellschaften gelebt haben, in denen sie ihre Ideen nicht direkt durch ein gedrucktes Wort ausdrücken mussten.

Sie haben ein echtes Verständnis der menschlichen Erfahrung und der Grenzen des utopischen Denkens, das im Westen praktisch nicht vorhanden ist.

Es gibt bemerkenswerte Ausnahmen - Stanley Kubrick war dazu in der Lage -, aber es ist äußerst selten, eine amerikanische oder britische NF zu finden, die eine zurückhaltende Ansicht darüber ausdrückt, was wir als Spezies mit Technologie tun können.

Alchemisten

Da ich KI-Alarmismus kritisiere, ist es fair, meine Karten auf den Tisch zu legen. Ich denke, dass sich unser Verständnis des Geistes in ungefähr demselben Zustand befindet, in dem sich die Alchemie im 17. Jahrhundert befand.

Alchemisten haben einen schlechten Ruf. Wir betrachten sie als Mystiker, die größtenteils nicht an experimentellen Arbeiten beteiligt sind. Moderne Forschungen zeigen, dass sie viel fleißiger als wir denken. In vielen Fällen verwendeten sie moderne experimentelle Techniken, führten Laboraufzeichnungen und stellten die richtigen Fragen.

Alchemisten haben viele Dinge richtig verstanden! Zum Beispiel waren sie von der korpuskulären Theorie der Materie überzeugt: dass alles aus winzigen Stücken besteht und dass es möglich ist, diese Stücke auf unterschiedliche Weise miteinander zu komponieren und unterschiedliche Substanzen zu erzeugen - und das ist so!

Ihr Problem war der Mangel an genauer Ausrüstung, die notwendig war, um die Entdeckungen zu machen, die sie brauchten. Die große Entdeckung, die ein Alchemist machen muss, ist das Gesetz der Massenerhaltung: Das Gewicht der Ausgangsbestandteile stimmt mit dem Gewicht des Endbestandteils überein. Einige von ihnen können jedoch Gase oder verdampfende Flüssigkeiten sein, und den Alchemisten mangelte es einfach an Genauigkeit. Moderne Chemie war erst im 18. Jahrhundert möglich.

Aber die Alchemisten hatten auch Hinweise, die sie verwirrten. Sie waren von Quecksilber besessen. Quecksilber ist chemisch nicht besonders interessant, aber es ist das einzige Metall in der flüssigen Phase bei Raumtemperatur. Dies schien den Alchemisten sehr wichtig zu sein und zwang sie, Quecksilber in das Zentrum ihres alchemistischen Systems zu stellen und nach dem Stein der Weisen zu suchen, um unedle Metalle in Gold umzuwandeln.

Die Neurotoxizität von Quecksilber verschlimmerte die Situation. Wenn Sie zu viel mit ihr spielen, kommen Ihnen seltsame Gedanken. In diesem Sinne ähnelt es unseren aktuellen mentalen Experimenten, die sich auf das Supermind beziehen.

Stellen Sie sich vor, wir hätten einem großen Alchemisten wie

George Starkey oder Isaac Newton ein Lehrbuch über moderne Chemie in die Vergangenheit geschickt. Das erste, was sie damit machen würden, wäre, darin nach einer Antwort auf die Frage zu suchen, ob wir den Stein der Weisen gefunden hatten. Und sie würden wissen, dass wir ihn gefunden haben! Wir haben ihren Traum verwirklicht!

Aber wir mögen es nicht so sehr, denn nachdem wir Metalle in Gold verwandelt haben, stellt sich heraus, dass es radioaktiv ist. Stellen Sie sich neben einen Barren aus umgewandeltem Gold, der Sie mit unsichtbaren magischen Strahlen tötet.

Man kann sich vorstellen, wie schwierig es wäre, moderne Konzepte von Radioaktivität und Atomenergie für sie nicht mystisch klingen zu lassen.

Wir müssten ihnen erklären, warum wir den „Stein der Weisen“ verwenden: für die Herstellung von Metall, das es auf dem Planeten noch nie gegeben hat, und ein paar Handvoll davon reichen aus, um eine ganze Stadt in die Luft zu jagen, wenn sie mit ausreichend hoher Geschwindigkeit kollidieren.

Darüber hinaus müssten wir den Alchemisten erklären, dass alle Sterne am Himmel „philosophische Steine“ sind, die ein Element in ein anderes verwandeln, und dass alle Teilchen in unserem Körper von Sternen des Firmaments stammen, das existierte und explodierte, bevor die Erde erschien.

, , , , , , , , , , .

, , , , , , . – . , .

, . . – . , , ( ), , .

, , .

, . , . , , , . , , , .

. , , .

, , , , , . , .

, – , «», , . . Und das ist großartig! . , :

, , , .

—

, , , .

,

, , , - , , .

, , , , .

, , , . , - . , .

, , , , .

, . , - , , , , , .

: , , . !

, – , , .