Jesse Bataglia hält ihren Sohn Bennett in ihrem Haus in Ranch Mirage, Kalifornien. Auf der Suche nach einem neuen Kindermädchen nutzte Batalha Predictim, einen Onlinedienst, der angeblich „fortgeschrittene künstliche Intelligenz“ verwendet, um das Risiko zu bewerten, dass das Kindermädchen drogenabhängig wird, sich aggressiv verhält oder „schlechte Manieren“ zeigt.

Jesse Bataglia hält ihren Sohn Bennett in ihrem Haus in Ranch Mirage, Kalifornien. Auf der Suche nach einem neuen Kindermädchen nutzte Batalha Predictim, einen Onlinedienst, der angeblich „fortgeschrittene künstliche Intelligenz“ verwendet, um das Risiko zu bewerten, dass das Kindermädchen drogenabhängig wird, sich aggressiv verhält oder „schlechte Manieren“ zeigt.Als Jesse Bataglia begann, nach einem neuen Kindermädchen für ihren einjährigen Sohn zu suchen, wollte sie mehr Informationen über den Angestellten erhalten als das Fehlen eines Strafregisters, Kommentare der Eltern und persönliche Interviews. Aus diesem Grund wandte sie sich an den Onlinedienst Predictim, um mithilfe der „fortgeschrittenen künstlichen Intelligenz“ die Identität des Kindermädchens zu bewerten, und schickte seine Scanner an Tausende von Posts auf Facebook, Twitter und Instagram eines der Kandidaten.

Das System führte eine automatische "Risikobewertung" eines 24-jährigen Mädchens ein und behauptete, das Risiko des Konsums ihrer Medikamente sei "sehr gering". Das System bewertete das Risiko von Einschüchterung, Aggression, Respektlosigkeit und schlechten Manieren jedoch etwas höher - um 2 von 5.

Das System erklärt seine Entscheidungen nicht. Bataglia, die das Kindermädchen für absolut vertrauenswürdig hielt, begann plötzlich zu zweifeln. "Social Media zeigt die Identität einer Person", sagte der 29-jährige Bataglia, der in einem Vorort von Los Angeles lebt. "Warum ist die Punktzahl 2, nicht 1?"

Predictim bietet Eltern dieselben Dienstleistungen, die Dutzende anderer Technologieunternehmen an Arbeitgeber auf der ganzen Welt verkaufen: KI-Systeme, die menschliche Sprache, Mimik und Online-Präsenz analysieren und gleichzeitig versprechen, die geheimen Aspekte ihres persönlichen Lebens aufzudecken.

Die Technologie verändert die Art und Weise, wie einige Unternehmen nach Kandidaten suchen, Arbeitnehmer einstellen und bewerten, und bietet Arbeitgebern eine konkurrenzlose Bewertung von Kandidaten durch eine neue Welle invasiver psychologischer Bewertungen und Überwachung.

Fama behauptet, dass sie KI verwenden, um die sozialen Netzwerke der Arbeiter auf „toxisches Verhalten“ zu überwachen, um ihre Chefs zu alarmieren. HireVue, ein Rekrutierungstechnologiefirma, das mit Unternehmen wie Geico, Hilton und Unilever zusammenarbeitet, bietet ein System an, das den Ton, die Wortwahl und die Mimik des Kandidaten während eines Videointerviews automatisch analysiert und seine Fähigkeiten und Manieren vorhersagt (um bessere Ergebnisse zu erzielen, werden Kandidaten mehr angeboten lächeln).

Kritiker argumentieren jedoch, dass Systeme wie Predictim eine Gefahr für sich selbst darstellen und automatische Lösungen hinterlassen, die das Leben eines Menschen ohne Überprüfung verändern können.

Systeme hängen von Black-Box-basierten Algorithmen ab, die fast keine Details darüber liefern, wie sie alle komplexen Details des Innenlebens einer Person auf die Berechnung ihrer positiven und negativen Seiten reduziert haben. Und obwohl die Predictim-Technologie das Denken der Eltern beeinflusst, bleibt sie völlig unbewiesen, fast ungeklärt und anfällig für Wahrnehmungsverzerrungen in Bezug darauf, wie genau sich das richtige Kindermädchen in sozialen Netzwerken verhalten, aussehen und sprechen sollte.

Es gibt "ein verrücktes Rennen, um die Kontrolle über die KI zu übernehmen und alle Arten von Entscheidungen zu treffen, ohne den Menschen Bericht zu erstatten", sagte Jeff Chester, Executive Director des Center for Digital Democracy, einer Technologie-Interessenvertretung. "Es scheint, als hätten sich die Leute mit digitalem Soda betrunken, und sie denken, es ist eine normale Art, unser Leben zu verwalten."

Der Predictim-Scanprozess analysiert das gesamte Verhalten von Kindermädchen in sozialen Netzwerken, die für viele der jüngsten Kindermädchen den größten Teil ihres Lebens erfassen können. Gleichzeitig wird den Kindermädchen mitgeteilt, dass dies ein schwerwiegender Nachteil im Wettbewerb um Arbeitsplätze ist, wenn sie sich weigern, sich einem solchen Scan zu unterziehen.

Sal Parsa, CEO und Mitbegründer von Predictim, sagte, das Unternehmen, das im vergangenen Monat im Rahmen des Berkeley-Technologie-Inkubators der SkyDeck University of California gegründet wurde, nehme die ethischen Fragen des Einsatzes seiner Technologie ernst. Er sagte, dass Eltern die Bewertung als Berater betrachten sollten, was „vielleicht die wirklichen Eigenschaften des Kindermädchens widerspiegelt und vielleicht nicht widerspiegelt“.

Er fügte hinzu, dass die Gefahr, ein problematisches oder gewalttätiges Kindermädchen einzustellen, die KI zu einem wesentlichen Instrument für jeden Elternteil macht, der versucht, sein Kind in Sicherheit zu bringen.

"Durchsuchen Sie Google nach Missbrauch von Babysittern und Sie werden Hunderte von Ergebnissen finden", sagte er. - Es gibt Menschen mit psychischen Erkrankungen oder nur wütend. Unser Ziel ist es, alles in unserer Macht stehende zu tun, um sie aufzuhalten. “

Die Kosten für das Scannen von Predictim beginnen bei 24,99 US-Dollar. Für sie müssen Sie den Namen und die E-Mail-Adresse des potenziellen Kindermädchens angeben und ihre Zustimmung zum umfassenden Zugriff auf ihre Konten in sozialen Netzwerken einholen. Das Kindermädchen kann dies ablehnen, und dann erhalten die Eltern eine Benachrichtigung darüber, und das Kindermädchen selbst erhält einen Brief, in dem es heißt: "Der Elternteil, der an Ihnen interessiert war, kann Sie erst einstellen, wenn Sie der Anfrage nachkommen."

Predictim-Manager geben an, dass sie Algorithmen verwenden, um Sprache und Bilder zu verarbeiten, „Computer Vision“ zu betreiben, Nanny-Beiträge auf Facebook, Twitter und Instagram auszuwerten und nach Hinweisen auf ihr Offline-Leben zu suchen. Der Bericht wird nur von den Eltern erhalten, die nicht verpflichtet sind, seine Ergebnisse mit dem Kindermädchen zu teilen.

Eltern können sich wahrscheinlich selbst öffentliche Nanny-Konten in sozialen Netzwerken ansehen. Computerberichte versprechen jedoch eine gründliche Einschätzung der Jahre der Online-Aktivitäten, die auf eine einzige Zahl reduziert sind: eine verlockend einfache Lösung für eine fast unmögliche Aufgabe.

Risikobewertungen lassen sich in verschiedene Kategorien einteilen, einschließlich offener Inhalte und Drogenmissbrauch. Das Startup behauptet in der Werbung auch, dass sein System in der Lage ist, andere Merkmale der Persönlichkeit des Kindermädchens zu bewerten, wie Höflichkeit, Fähigkeit, mit anderen zu arbeiten, und „Positivität“.

Das Unternehmen hofft, die milliardenschwere Branche des „Outsourcings der elterlichen Verantwortung“ zu revolutionieren, und hat bereits begonnen, Werbung zu schalten, indem es Blogs und Websites für Eltern für „Mütter“ sponsert. Die Marketingstrategie konzentriert sich auf die erklärte Gelegenheit, Geheimnisse preiszugeben und den „Albtraum eines Elternteils“ zu verhindern. In der Werbung werden Strafsachen angeführt, darunter beispielsweise der Fall einer Kinderpflegerin aus Kentucky, die wegen schwerer Körperverletzung eines acht Monate alten Kindes verurteilt wurde.

"Wenn die Eltern dieses von der Krankenschwester betroffenen Mädchens Predictim im Genehmigungsverfahren für Kandidaten verwenden könnten", heißt es in der Marketingerklärung des Unternehmens, "würden sie sie niemals mit ihrem kostbaren Kind allein lassen."

Technologieexperten sagen jedoch, dass das System selbst Warnungen ausgibt und dabei auf die Befürchtungen der Eltern zurückgreift, Ergebnisse von Persönlichkeitsscans mit nicht überprüfter Genauigkeit zu verkaufen.

Sie werfen auch Fragen auf, wie solche Systeme trainieren und wie anfällig sie für Fehler sind, die sich aus den Unsicherheiten ergeben können, die mit der Nutzung sozialer Netzwerke durch Kindermädchen verbunden sind. Eltern erhalten nur eine Warnung vor zweifelhaftem Verhalten, ohne bestimmte Sätze, Links oder andere Details, anhand derer sie ihre Entscheidung treffen könnten.

Als ein Scan eines Kindermädchens eine Warnung vor einer möglichen Verfolgung von ihrer Seite ausgab, sagte eine aufgeregte Mutter, die diese Einschätzung beantragte, sie könne nicht herausfinden, ob das Programm ein Zitat aus einem alten Film, Lied oder einem anderen Satz bemerkte, den sie für wirklich gefährliche Aussagen hielt .

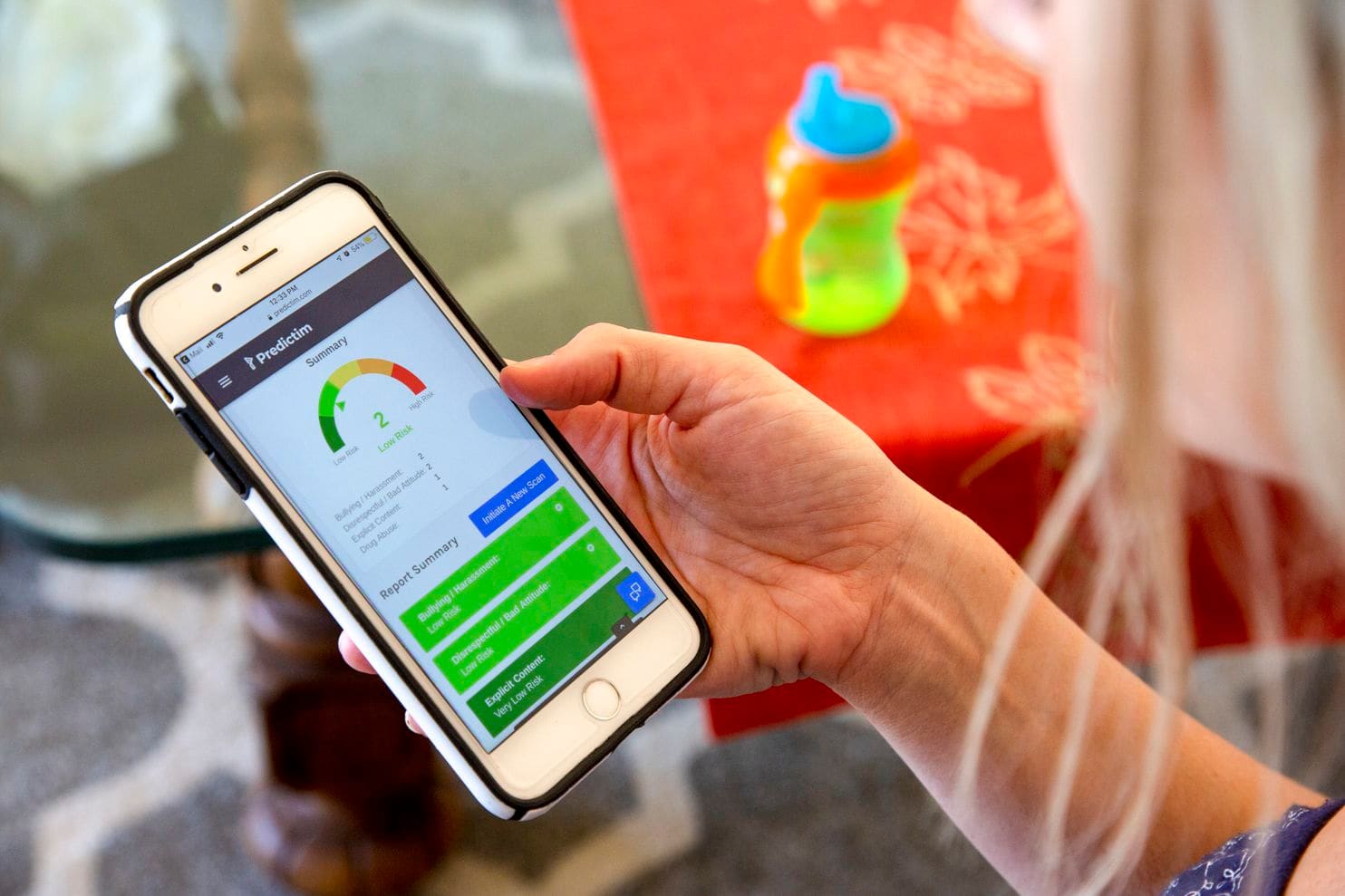

Jesses Telefon zeigt die Ergebnisse der Predictim-Anwendung

Jesses Telefon zeigt die Ergebnisse der Predictim-AnwendungJamie Williams, ein Anwalt der Electronic Frontier Foundation, einer Bürgerrechtsgruppe, sagte, dass in Bezug auf die meisten Algorithmen, die heute zur Bewertung der Bedeutung von Wörtern und Fotografien verwendet werden, bekannt ist, dass ihnen ein menschlicher Kontext und ein gesunder Menschenverstand fehlen. Selbst Technologiegiganten wie Facebook hatten Schwierigkeiten, Algorithmen zu entwickeln, die zwischen harmlosen und wütenden Kommentaren unterscheiden konnten.

„Wie kann man dieses System zur Bewertung von Jugendlichen ausprobieren: Sie sind Kinder! - sagte Williams. - Kinder haben ihre eigenen Witze, sie sind berühmt für Sarkasmus. "Was eine Person von dem Algorithmus als" schlechte Manieren "hält, kann als politische Aussage oder legitime Kritik angesehen werden."

Und wenn das System falsch ist - sagen wir mal, dass das Kindermädchen Drogen missbraucht - können die Eltern den Fehler nicht herausfinden. Klare Bewertungen und Einschätzungen der Genauigkeit des Systems können dazu führen, dass Eltern viel mehr Genauigkeit und Autoritarismus von ihm erwarten, als eine Person an seiner Stelle versprechen könnte. Infolgedessen neigen Eltern dazu, Kindermädchen einzustellen, die sie sonst meiden würden, oder sich von Menschen zu entfernen, die ihr Vertrauen bereits verdient haben.

"Es gibt keine Metrik, die genau sagen kann, ob diese Methoden in ihren Vorhersagen so effektiv sind wie die Aussagen der Entwickler", sagte Miranda Bogen, Chefanalystin am Upturn Washington Think Tank, der die Verwendung von Algorithmen für die automatische Entscheidungsfindung und Beurteilung untersucht . "Die Attraktivität dieser Technologien wird wahrscheinlich ihre tatsächlichen Fähigkeiten übertreffen."

Malissa Nielsen, eine 24-jährige Nanny, die für Bataglia arbeitet, hat kürzlich zwei anderen Familien Zugang zu ihren sozialen Netzwerken zur Bewertung bei Predictim gewährt. Sie sagte, dass sie in Bezug auf soziale Netzwerke immer vorsichtig sei und beschloss, zusätzliche Informationen weiterzugeben, ohne sich selbst zu verletzen. Sie geht wöchentlich in die Kirche, schwört nicht und beendet die Lehrerausbildung im Bereich des Unterrichts von kleinen Kindern. Danach hofft sie, einen Kindergarten zu eröffnen.

Als sie jedoch erfuhr, dass das System ihr aufgrund von Respektlosigkeit und Mobbing keine idealen Noten verlieh, war sie erstaunt. Sie glaubte, dass es Eltern erlaubt sei, ihre Präsenz in sozialen Netzwerken und nicht den Algorithmus zu untersuchen - eine kritische Analyse ihrer Persönlichkeit. Sie wurde auch nicht über die Ergebnisse eines Tests informiert, der möglicherweise ihre einzige Einnahmequelle schädigen könnte.

„Ich möchte dieses Problem ein wenig verstehen. Warum hat dieses Programm so über mich gedacht? - sagte Nielsen. "Der Computer hat keine Gefühle; er kann das alles nicht erkennen."

Die Amerikaner vertrauen immer noch nicht den Algorithmen, deren Entscheidungen ihr tägliches Leben beeinflussen können. In einer Umfrage des Pew Research Center in diesem Monat bewerteten 57% der Befragten die automatische Verarbeitung von Lebensläufen für Bewerber als "inakzeptabel".

Predictim berichtet jedoch, dass sie sich darauf vorbereiten, die Arbeit im ganzen Land auszuweiten. Die Manager von Sittercity, einem Online-Babysitter-Service, der von Millionen von Eltern besucht wird, sprechen über den Start eines Pilotprogramms, das die automatischen Bewertungen von Predictim in die aktuellen automatischen Bewertungen und Serviceprüfungen integriert.

"Die Suche nach einem Kindermädchen ist mit Unsicherheiten behaftet", sagte Sandra Dainora, Produktleiterin bei Sittercity, die glaubt, dass solche Tools bald zum Standard bei der Online-Suche nach Betreuern werden können. "Eltern sind ständig auf der Suche nach der besten Lösung, der vollständigsten Forschung, den zuverlässigsten Fakten."

Predictim-Manager glauben auch, dass sie die Fähigkeiten des Systems ernsthaft erweitern und noch persönlichere Einschätzungen des Privatlebens der Nanny anbieten können. Joel Simonov, Technologiedirektor, sagte, das Team sei daran interessiert, „nützliche psychometrische Daten“ zu erhalten, die auf der Analyse der Aktivität von Kindermädchen in sozialen Netzwerken basieren, und ihre Geschichten einem Identitätstest zu unterziehen, beispielsweise der Myers-Briggs-Typologie, um diese Ergebnisse den Eltern zur Verfügung zu stellen.

Social Media Mining und Predictims Interesse an massenpsychologischen Analysen ähneln den Ambitionen von Cambridge Analytica, einem politischen Beratungsunternehmen, das Trumps Wahlkampf unterstützte und Facebook in einen globalen Identitätsskandal verwickelte. Die Verantwortlichen von Predictim behaupten jedoch, interne Sicherheitskontrollen eingerichtet zu haben und arbeiten daran, die persönlichen Daten der Kindermädchen zu schützen. "Wenn wir ein Datenleck bei einem Kindermädchen hätten, wäre das nicht cool", sagte Simonov.

Experten befürchten, dass AI-basierte Bewertungssysteme eine Zukunft bedeuten, in der der Erhalt eines Arbeitsplatzes, der nicht unbedingt mit der Kinderbetreuung zusammenhängt, von der Maschine abhängt. Viele Rekrutierungs- und Rekrutierungsunternehmen erstellen oder investieren bereits in Systeme, die Kandidaten-Lebensläufe in großem Umfang analysieren und automatische Kandidatenbewertungen abgeben können. Ähnliche KI-Systeme - einschließlich Jigsaw, einem von Google entwickelten Technologie-Inkubator - werden verwendet, um Online-Kommentare auf Belästigung, Bedrohung und Grausamkeit zu verfolgen.

Es wurde jedoch bereits mehr als einmal gezeigt, wie Algorithmen zum Auffinden von Mitarbeitern Fehler verbergen, die die Karriere einer Person ruinieren können. Amazon.com hat die Entwicklung des Einstellungsalgorithmus eingestellt, nachdem festgestellt wurde, dass Frauen unrechtmäßig unterschätzt werden, da die Einstellungshistorie des Unternehmens, die der Tendenz der Technologiebranche folgt, Männer einzustellen, dem System beigebracht hat, männliche Kandidaten zu bevorzugen. Das Unternehmen sagte, sie hätten dieses Programm nie zur Bewertung von Kandidaten verwendet.

Einige KI-Experten glauben, dass solche Systeme Vorurteile in Bezug auf Alter oder Rasse ernsthaft aufblähen können, indem sie beispielsweise wichtige Wörter oder Fotos bestimmter Personengruppen häufiger als andere markieren. Sie sind auch besorgt, dass Predictim junge Kindermädchen dazu zwingen wird, ihre persönlichen Daten zu teilen, nur um einen Job zu bekommen.

Diana Werner, Mutter von zwei Kindern, die in einem Vorort von San Francisco lebt, ist jedoch der Ansicht, dass Kindermädchen freiwillig persönliche Informationen weitergeben sollten, um ihre Eltern zu beruhigen. "Die Überprüfung der Biografie ist eine gute Sache, aber Predictim untersucht das Thema eingehend und analysiert das Individuum - seinen sozialen und intellektuellen Status", sagte sie. Wo sie lebt, "werden 100% der Eltern einen solchen Dienst nutzen wollen", fügte sie hinzu. "Wir alle wollen das perfekte Kindermädchen."