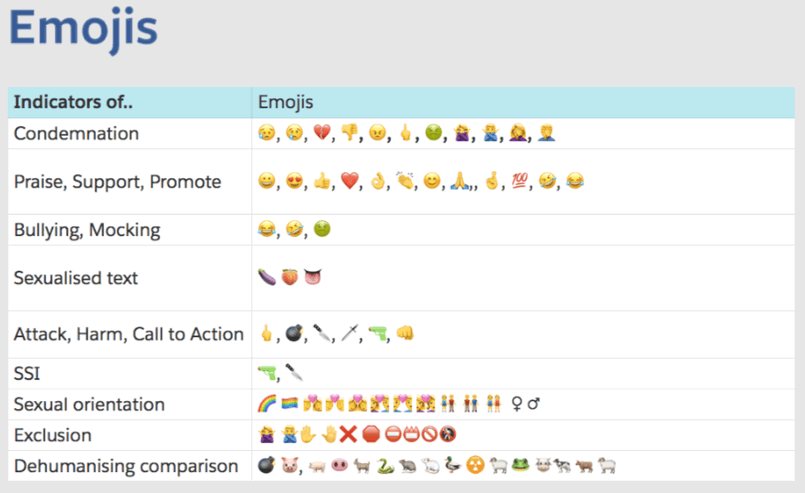

Das Handbuch erklärt, welche Emoticons als Bedrohung angesehen werden können oder im Kontext bestimmter Gruppen Hass auslösen können.

Das Handbuch erklärt, welche Emoticons als Bedrohung angesehen werden können oder im Kontext bestimmter Gruppen Hass auslösen können.Unter dem Feuer der Kritik ist Facebook gezwungen, Maßnahmen zu ergreifen, um Inhalte zu moderieren. Aber diese Aufgabe ist nicht so einfach, wie es scheint. Die Medien haben ein internes Handbuch für Facebook-Moderatoren erhalten: Dies sind mehr als 1400 (!) Seiten mit Anweisungen, die manchmal sehr schwer zu verstehen sind,

schreibt die NY Times .

Heute werfen Politiker und öffentliche Organisationen dem sozialen Netzwerk vor, Hass und Fehlinformationen anzuregen. Für Facebook ist dies in erster Linie ein finanzielles Problem, da solche Anschuldigungen einen negativen Hintergrund schaffen und den Aktienkurs nachteilig beeinflussen können, was das Wohl der Eigentümer und Mitarbeiter des Unternehmens bedeutet.

Facebook, das etwa 5 Milliarden US-Dollar pro Quartal verdient, sollte allen zeigen, dass es den Kampf gegen bösartige Inhalte ernst nimmt. Aber wie kann man Milliarden von Nachrichten pro Tag in mehr als 100 Sprachen verfolgen und gleichzeitig die Benutzerbasis weiter ausbauen, die die Grundlage für das Geschäft bildet? Die Entscheidung des Unternehmens: Ein Netzwerk von Moderatoren, die von einem PowerPoint-Folienlabyrinth geleitet werden und verbotene Inhalte erklären.

"Jeden Dienstagmorgen versammeln sich mehrere Dutzend Facebook-Mitarbeiter zum Frühstück, um neue Regeln auszuarbeiten und zu diskutieren, was zwei Milliarden Nutzer der Website sagen dürfen", schreibt die

NY Times . "Basierend auf den Ergebnissen der Treffen werden die relevanten Regeln an mehr als 7.500 Moderatoren auf der ganzen Welt verschickt." Die Zeitung hat mehr als 1.400 Seiten Regelbücher. Informationen wurden von einem der Mitarbeiter bereitgestellt, der sich Sorgen über übermäßige Moderation und zu viele Fehler macht, die das Unternehmen bei der Moderation von Inhalten macht.

Die Prüfung der Dokumente ergab zahlreiche Lücken, Vorurteile und offensichtliche Fehler. Offensichtlich unterscheiden sich die Regeln für verschiedene Sprachen und Länder, wodurch Hassreden in einigen Regionen gedeihen und in anderen Regionen unnötig unterdrückt werden können. Zum Beispiel, als die Moderatoren aufgefordert wurden, die Spendenaufrufe für die Opfer des Vulkans in Indonesien zu entfernen, weil einer der Organisatoren der Spendenaktion auf der schwarzen Liste der verbotenen Facebook-Gruppen stand. In Indien wurde den Moderatoren fälschlicherweise gesagt, sie sollten Kommentare entfernen, die die Religion kritisieren. In Myanmar war die extremistische Gruppe aufgrund eines Fehlers in der Facebook-Dokumentation mehrere Monate lang aktiv.

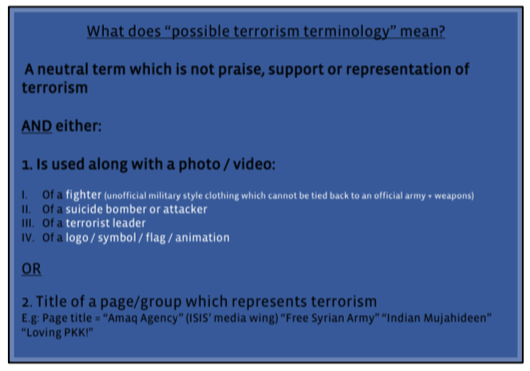

Screenshot aus dem Facebook-Handbuch für Moderatoren

Screenshot aus dem Facebook-Handbuch für ModeratorenNach der Popup-Dokumentation zu urteilen, versucht Facebook, Prinzipien für Moderatoren in Form einfacher Ja- oder Nein-Regeln zu formulieren. Anschließend überträgt das Unternehmen die eigentliche Moderation an Drittunternehmen. Sie ziehen hauptsächlich ungelernte Arbeitskräfte an, von denen viele in Call Centern arbeiten (die berüchtigte „indische Unterstützung“ - dies sind die Mitarbeiter, die an der Moderation beteiligt sind).

Oft verlassen sich Moderatoren auf Google Translate, um zu funktionieren. Die Anforderungen an ihre Leistung sind so, dass sie innerhalb weniger Sekunden die unzähligen Regeln abrufen und sie auf die Hunderte von Nachrichten anwenden müssen, die täglich auf ihrem Arbeitscomputer angezeigt werden. Zum Beispiel, um schnell an die Regeln zu erinnern, in deren Emoticon die Erwähnung des Dschihad verboten ist.

Ein Screenshot aus dem Facebook-Handbuch für Moderatoren, der die Anzeichen von Hassreden erklärt. Moderatoren sollten anhand von sechs „unmenschlichen Vergleichen“, einschließlich eines Vergleichs zwischen Juden und Ratten, drei Schweregrade identifizieren. Allgemeiner Leitfaden zum Sprechen von Hass 200 Seiten

Ein Screenshot aus dem Facebook-Handbuch für Moderatoren, der die Anzeichen von Hassreden erklärt. Moderatoren sollten anhand von sechs „unmenschlichen Vergleichen“, einschließlich eines Vergleichs zwischen Juden und Ratten, drei Schweregrade identifizieren. Allgemeiner Leitfaden zum Sprechen von Hass 200 SeitenEinige Moderatoren sagen, dass die Regeln nicht sehr effektiv und manchmal bedeutungslos sind. Das Management des Unternehmens ist jedoch der Ansicht, dass dies nicht anders ist: "Wir haben Milliarden von Nachrichten pro Tag und identifizieren mithilfe unserer technischen Systeme immer mehr potenzielle Verstöße", sagt Monika Bickert, Global Policy Director von Facebook. "Auf einer solchen Skala hinterlässt selbst eine Genauigkeit von 99% viele Fehler."

Das Facebook-Handbuch, das in die Presse kam, sieht nicht nach einer klaren Anleitung aus. Es besteht aus Dutzenden fragmentierter PowerPoint-Präsentationen und Excel-Tabellen mit bürokratischen Überschriften wie „Der westliche Balkan hasst Organisationen und Einzelpersonen“ oder „Explizite Gewalt: Implementierungsstandards“. Dies ist eine Art "Flickenteppich" der Regeln, die von verschiedenen Abteilungen des Unternehmens festgelegt wurden. Facebook bestätigte die Echtheit der Dokumente, sagte jedoch, dass einige von ihnen im Vergleich zu der Version, die in den Besitz der

NY Times gelangte, aktualisiert wurden. Facebook sagt, dass die Dateien nur zu Schulungszwecken sind, aber Moderatoren sagen, dass sie tatsächlich als Referenzmaterial in der täglichen Arbeit verwendet werden.