In den letzten zwanzig Jahren erscheinen Rechenzentren nach Regen wie Pilze, und das ist verständlich. Neben quantitativen Indikatoren entwickeln sich auch qualitative - neue Formen, neue Ansätze zum Aufbau der Umwelt. Eine dieser Innovationen sind modulare Rechenzentren geworden. Zum ersten Mal konnte das Militär die Wirksamkeit von Lösungen anhand eines standardisierten Containers bewerten. Sie waren Pioniere bei der Nutzung modular aufgebauter Rechenzentren. Der schnelle Einsatz von Rechenleistung und die Fähigkeit, Daten in den entlegensten Winkeln der Erde zu speichern, sind zu einem Allheilmittel für das Militär der Welt geworden, da die Menge der generierten Informationen täglich zunimmt. Dank Sun Microsystems wurden bereits 2006 modulare Rechenzentren für zivile Verbraucher verfügbar. Aber es scheint, wer wird sie erwerben? Im Kontext des heftigen Kampfes der IT-Marktteilnehmer um eine hohe Hardwareleistung werden die Vorteile der Modularität von Rechenzentren in den meisten Fällen des zivilen Lebens durch ein ganzes Spektrum von Minuspunkten, die durch diese Modularität entstehen, gnadenlos durchgestrichen. Aber wie die Zeit gezeigt hat, ist zu diesem Thema nicht alles so klar und das Produkt hat seinen Verbraucher gefunden. Einer dieser Verbraucher, egal wie überraschend es war, war CERN. Die Idee der Organisation ist ein großer Hadron-Collider, der mit einigen neuen modularen Rechenzentren bewachsen ist. Eine sehr seltsame Entscheidung? Dies und nicht nur wird weiter diskutiert.

Der Container - alles Geniale ist einfach!

Der Container - alles Geniale ist einfach!Soweit bekannt, wurde diese Idee zum ersten Mal vom Militär mit einem Container umgesetzt - um einen Metallrahmen mit Server-Racks zu füllen, ein Kühlsystem darin zu integrieren und hier eine fertige Lösung. Bei all dem Utilitarismus eines solchen Datencontainers stellen sich jedoch Fragen der Flexibilität und der Effektivität der Funktionsweise seiner Füllung. Wie viel installierte Standardhardware den ausgeführten Aufgaben entspricht, da der Personalisierungsstau der Server-Racks dort sehr begrenzt ist. Einerseits erlaubt der Container-Formfaktor dem Netzwerkadministrator nicht, ihn buchstäblich und im übertragenen Sinne bereitzustellen. Andererseits kann das Ersetzen der Füllung durch eine stärkere die Hilfsbehältersysteme beschädigen: Energieversorgung, Kühlung. Selbst mit der Fähigkeit, die Kapazitäten seiner Serverstruktur durch das Verfahren der Lieferung eines weiteren Containers leicht zu erhöhen, kann das Problem der Steigerung der Effizienz eines bestimmten Racks im Modul in keiner Weise gelöst werden, und dies schränkt den Umfang dieses Entwurfs stark ein.

CERN wählt ein modulares Rechenzentrum aus„Bis Ende 2019 planen wir die Installation von zwei neuen Rechenzentren, von denen jedes ausschließlich seinen eigenen LHC-Detektor bedienen wird. Der mit dem LHCb-Experiment verbundene Detektor erhält sechs Module, der ALISA-Experimentdetektor wird ein Rechenzentrum mit vier Containern bedienen. Die Notwendigkeit, die vorhandene Infrastruktur zu erweitern, wurde durch die Modernisierung dieser Detektoren verursacht. Nach dem Upgrade wird die von den Detektoren generierte Datenmenge erheblich zunehmen “, sagte Niko Neufeld, stellvertretender Direktor eines der CERN-Projekte.

CERN wählt ein modulares Rechenzentrum aus„Bis Ende 2019 planen wir die Installation von zwei neuen Rechenzentren, von denen jedes ausschließlich seinen eigenen LHC-Detektor bedienen wird. Der mit dem LHCb-Experiment verbundene Detektor erhält sechs Module, der ALISA-Experimentdetektor wird ein Rechenzentrum mit vier Containern bedienen. Die Notwendigkeit, die vorhandene Infrastruktur zu erweitern, wurde durch die Modernisierung dieser Detektoren verursacht. Nach dem Upgrade wird die von den Detektoren generierte Datenmenge erheblich zunehmen “, sagte Niko Neufeld, stellvertretender Direktor eines der CERN-Projekte.

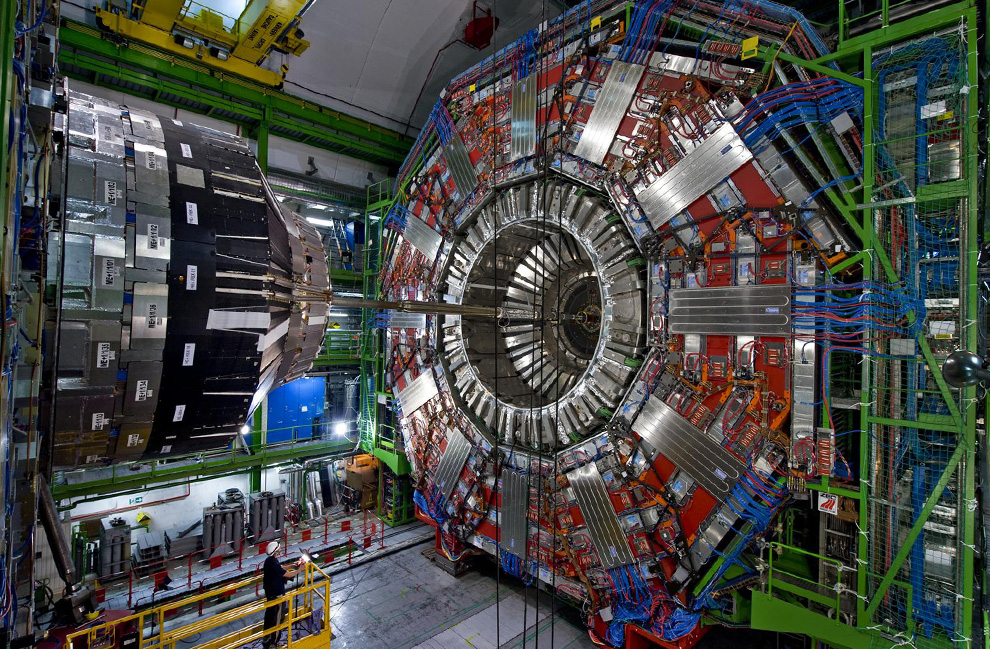

LHC (Large Hadron Collider) - ein Projekt unter der Schirmherrschaft des CERN. Es handelt sich um eine kolossale Struktur, die sich in einer Tiefe von etwa 100 Metern im Herzen Westeuropas auf dem Territorium zweier Staaten befindet - Frankreich und der Schweiz. Mit einem Durchmesser von 8,5 km und einer Länge von etwa 27 km ist es schwierig, dem LHC seine Entfernung von der Zivilisation vorzuwerfen. Das Projekt selbst ist im Wesentlichen der Kern der modernen Wissenschaft, der Motor ihrer grundlegenden Komponente. Darüber hinaus erfüllt die vorhandene IT-Infrastruktur, die den LHC bedient, alle modernen Standards, einschließlich Rechenzentren und Glasfaserrouten, die ihn mit der ganzen Welt verbinden. Was war der Sinn der Entscheidung europäischer Nuklearwissenschaftler vom CERN, die Kapazität der IT-Infrastruktur durch modulare Rechenzentren zu erhöhen?

Derzeit werden die Anforderungen des Colliders direkt von bis zu fünf Rechenzentren bedient. Von diesen sind vier den vier Hauptsensoren jedes der Hauptexperimente zugeordnet: ATLAS, CMS, ALISA und LHCb. Das fünfte Rechenzentrum ist das größte - es ist der zentrale Knotenpunkt für die Verarbeitung und Speicherung von Daten aus dem gesamten wissenschaftlichen Komplex des LHC.

"Im Moment zeichnet der zentrale Detektor, der das LHCb-Experiment bedient, die darin auftretenden Ereignisse mit einer Frequenz von 1 MHz auf. Nach der Modernisierung wird sich die Fixierungsfrequenz um das 40-fache erhöhen und sich 40.000.000 Aufzeichnungen pro Sekunde vorstellen", fuhr Nico fort.Es ist nicht verwunderlich, dass neue Zeiten neue Ausrüstung erforderten. Eine Zunahme des Datenflusses ist ein weit verbreiteter Trend und die Modernisierung der Netzwerkinfrastruktur ist nicht überraschend, aber warum modulare Rechenzentren? Die Antwort ließ nicht lange auf sich warten.

„Dies ist eine Nettoersparnis. Die Besonderheiten der Detektoren sind kurzfristige volumetrische Bursts der Datenerzeugung. Die durch diese Bursts erzeugte Datenmenge ist mit sehr hoher Genauigkeit bekannt, sodass wir genau wissen, wie viel Speicherplatz für die Datenspeicherung wir benötigen, und diese Menge wird bis zur extremen Phase des Experiments relevant sein. Indem wir die Servermodule so nah wie möglich an den Sensoren platzieren, haben wir außerdem die Länge der Glasfaserkommunikation reduziert, die erforderlich ist, um 30 PB Daten in kurzer Zeit zu übertragen. Die Kosten für die Verlegung solcher Kommunikationen sind sehr beeindruckend. “- erklärte Nico.Nach dem vom CERN-Mitarbeiter skizzierten Schema wurde die Situation bei der Wahl der Infrastruktur klarer. Der riesige Datenstrom, der von den LHC-Sensoren generiert wird, erreicht die primären Datenverarbeitungs- und Speicherzentren in kürzester Zeit. Danach werden die gesammelten Informationen nach dem Warten auf den nächsten Start des Sensors schrittweise zum zentralen Rechenzentrum geleitet, ohne die vorhandene Netzwerkinfrastruktur zu überlasten.

Leben nach HiggsTatsächlich wurde all diese megalithische Struktur, der LHC, mit dem Ziel geschaffen, die Existenz des Higgs-Beckens aufzudecken / zu widerlegen. Im Jahr 2013 wurden indirekte Existenzzeichen entdeckt und das ursprüngliche Problem gelöst. Eineinhalb Jahre Ausfallzeit von Kollidern waren für CERN-Mitarbeiter erforderlich, um vorhandene Detektoren zu modernisieren, wodurch bereits neue Probleme gelöst werden konnten. Es sind jedoch nicht mehr als drei Jahre seit dem Datum des neuen Starts vergangen, und derzeit erwartet der LHC eine weitere Modernisierung. Die Abschaltung des Colliders sollte von 2019 bis 2021 dauern.

Wie wir hier sehen, ist es nicht sinnvoll, das Projekt mit einer schweren stationären Infrastruktur zu belasten, da nach einer kurzen Phase der statistischen Datenerfassung die Wahrscheinlichkeit sehr hoch ist, dass es einfach verschwindet. Wie die Praxis zeigt, werden für neue Projekte immer noch neue Infrastrukturen und andere damit verbundene Geräte erforderlich sein. Die jetzt installierten Module können jederzeit problemlos an einen anderen Ort verschoben werden, an dem ihre Verwendung rationaler ist.

„Jetzt wird der Sensor aus dem LHDb-Projekt von einem Server direkt daneben gewartet - unterirdisch. Zwei Faktoren haben uns daran gehindert, diese Site zu modernisieren: der durch den Dungeon begrenzte Platz und die Probleme, die durch die Unfähigkeit verursacht werden, den Server effizient zu kühlen “, sagte Nico.

Der vorhandene Serverraum, der von einem Mitarbeiter des wissenschaftlichen Zentrums erwähnt wurde, befindet sich in einer Tiefe von 100 Metern. In den Momenten der Spitzenlast auf den Servern erfordert die von ihnen erzeugte Wärmemenge die Abgabe von erwärmtem Kühlmittel an die Oberfläche, wo es überschüssige Wärme an die Atmosphäre abgeben und dann auf den Boden zurückkehren kann .

Hohe Kosten für die Kühlung der Server in den Modulen sind eindeutig nicht zu erwarten. Angesichts des kühlen Klimas der Alpenausläufer wird PUE - der Wirkungsgrad des Kühlsystems - weniger als 1,1 betragen (nur 10% der von der Serverausrüstung verbrauchten Energie wird für die Kühlung verwendet).

Bis März 2019 müssen alle zehn Module ihre Designplätze einnehmen. Gegen Ende des Jahres werden Glasfaserleitungen zu den Rechenzentren gebracht, erst danach wird die Infrastruktur funktionsfähig sein. Sie wird sich jedoch frühestens drei Jahre später im Geschäft beweisen können. Der erste Start des größeren Hadron-Colliders nach der Modernisierung ist bereits für 2021 geplant.

„Das Ungewöhnlichste an unseren neuen Rechenzentren ist jedoch, dass wir ihnen keine Backup-Stromversorgung bieten. Während der 6-jährigen Arbeit im wissenschaftlichen Zentrum haben wir noch nie einen Stromausfall im Notfall erlebt “, fasste Nico Newfield zusammen.

Vielen Dank für Ihren Aufenthalt bei uns. Gefällt dir unser Artikel? Möchten Sie weitere interessante Materialien sehen? Unterstützen Sie uns, indem Sie eine Bestellung

aufgeben oder Ihren Freunden empfehlen, einen

Rabatt von 30% für Habr-Benutzer auf ein einzigartiges Analogon von Einstiegsservern, das wir für Sie erfunden haben: Die ganze Wahrheit über VPS (KVM) E5-2650 v4 (6 Kerne) 10 GB DDR4 240 GB SSD 1 Gbit / s von $ 20 oder wie teilt man den Server? (Optionen sind mit RAID1 und RAID10, bis zu 24 Kernen und bis zu 40 GB DDR4 verfügbar).

VPS (KVM) E5-2650 v4 (6 Kerne) 10 GB DDR4 240 GB SSD 1 Gbit / s bis Januar kostenlos, wenn Sie für einen Zeitraum von sechs Monaten bezahlen, können Sie

hier bestellen.

Dell R730xd 2 mal günstiger? Nur wir haben

2 x Intel Dodeca-Core Xeon E5-2650v4 128 GB DDR4 6 x 480 GB SSD 1 Gbit / s 100 TV von 249 US-Dollar in den Niederlanden und den USA! Lesen Sie mehr über

den Aufbau eines Infrastrukturgebäudes. Klasse mit Dell R730xd E5-2650 v4 Servern für 9.000 Euro für einen Cent?