Eine der Bürsten entfernt / fügt Bäume hinzu, die andere - von Menschen usw.Generative Contention Networks (GANs) erzeugen erstaunlich realistische Bilder, die oft nicht von echten zu unterscheiden sind. Seit der Erfindung solcher Netzwerke im Jahr 2014 wurde auf diesem Gebiet viel Forschung betrieben und eine Reihe von Anwendungen geschaffen, darunter für

die Bildmanipulation und die

Videovorhersage . Es wurden mehrere GAN-Varianten entwickelt, und es werden derzeit Experimente durchgeführt.

Trotz dieses enormen Erfolgs bleiben viele Fragen offen. Es ist unklar, was genau die Gründe für die schrecklich unrealistischen Artefakte sind, welches minimale Wissen erforderlich ist, um bestimmte Objekte zu generieren, warum eine GAN-Variante besser funktioniert als eine andere, welche grundlegenden Unterschiede in ihren Maßstäben codiert sind. Um die internen Abläufe von GAN besser zu verstehen, haben Forscher am Massachusetts Institute of Technology, MIT-IBM Watson AI und IBM Research das GANDissection-Framework und das

GANpaint- Programm entwickelt, einen grafischen Editor in einem generativen gegnerischen Netzwerk.

Die Arbeit wird von einem

wissenschaftlichen Artikel begleitet , der die Funktionalität des Frameworks ausführlich erklärt und die Fragen diskutiert, auf die Forscher Antworten finden wollen. Insbesondere versuchen sie, die

internen Repräsentationen generativ-wettbewerbsfähiger Netzwerke zu untersuchen. Die „analytische Struktur zur Visualisierung und zum Verständnis des GAN auf der Ebene von Einheiten, Objekten und Szenen“, dh das GANDissection-Framework, sollte helfen.

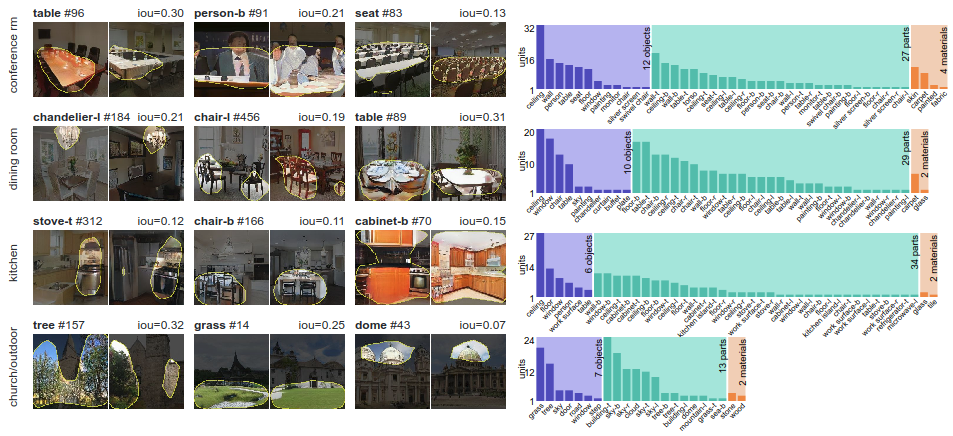

Durch die Aufteilung eines Bildes in Teile (segmentierungsbasierte Netzwerksektion) ermittelt das System Gruppen von „interpretierten Einheiten“, die eng mit den Konzepten von Objekten verbunden sind. Anschließend wird eine quantitative Bewertung der Ursachen durchgeführt, die Änderungen in den interpretierten Einheiten verursachen. Dies geschieht "durch Messen der Fähigkeit von Eingriffen, Objekte am Ausgang zu steuern". Einfach ausgedrückt, untersuchen Forscher die kontextbezogene Beziehung zwischen bestimmten Objekten und ihrer Umgebung, indem sie erkannte Objekte in neue Bilder einfügen.

Das GAN-Dissektions-Framework zeigt, dass bestimmte Neuronen im GAN abhängig von der Art der Szene trainiert werden, die er zeichnen lernt: Beispielsweise erscheint ein Jackenneuron beim Studieren von Konferenzräumen und ein Plattenneuron beim Zeichnen von Küchen

Das GAN-Dissektions-Framework zeigt, dass bestimmte Neuronen im GAN abhängig von der Art der Szene trainiert werden, die er zeichnen lernt: Beispielsweise erscheint ein Jackenneuron beim Studieren von Konferenzräumen und ein Plattenneuron beim Zeichnen von KüchenUm sicherzustellen, dass Neuronensätze das Zeichnen von Objekten steuern und nicht nur korrelieren, greift das Framework in das Netzwerk ein und aktiviert und deaktiviert Neuronen direkt. So funktioniert der grafische Editor GANpaint - dies ist eine visuelle Demonstration des analytischen Frameworks.

GANpaint aktiviert und deaktiviert Neuronen in einem Netzwerk, das für die Erstellung von Bildern trainiert wurde. Jede Schaltfläche im linken Bereich entspricht einem Satz von 20 Neuronen. Nur sieben Tasten:

- ein Baum;

- Gras

- die Tür;

- Himmel;

- eine Wolke;

- Ziegel;

- die Kuppel.

GANpaint kann solche Objekte hinzufügen oder entfernen.

Durch direktes Umschalten von Neuronen können Sie die Struktur der visuellen Welt beobachten, deren Modellierung das neuronale Netzwerk gelernt hat.

Wenn ein Außenstehender die Ergebnisse der Arbeit anderer generativ-wettbewerbsfähiger Netzwerke untersucht, kann er eine Frage stellen: Erstellt die GAN wirklich ein neues Bild oder besteht sie nur aus Szenen, die sie während des Trainings getroffen hat? Vielleicht merkt sich das Netzwerk nur die Bilder und spielt sie dann auf die gleiche Weise ab? Diese Forschungsarbeit und der GANpaint-Editor zeigen, dass Netzwerke einige Aspekte der Komposition wirklich gelernt haben, sagen die Autoren.

Eine interessante Entdeckung ist, dass dieselben Neuronen eine bestimmte Klasse von Objekten in unterschiedlichen Kontexten steuern, selbst wenn das endgültige Erscheinungsbild des Objekts stark variiert. Dieselben Neuronen können zum Konzept der „Tür“ wechseln, unabhängig davon, ob Sie eine schwere Tür an einer großen Steinmauer oder eine kleine Tür an einer winzigen Hütte anbringen müssen. Das GAN versteht auch, wann und wann Objekte nicht erstellt werden können. Wenn beispielsweise Türneuronen aktiviert sind, erscheint die Tür wirklich an der richtigen Stelle im Gebäude. Aber wenn Sie dasselbe am Himmel oder auf einem Baum tun, hat ein solcher Versuch normalerweise keine Wirkung.

Der wissenschaftliche Artikel

„GAN-Dissektion: Visualisierung und Verständnis generativer kontradiktorischer Netzwerke“ wurde am 26. November 2018 auf der Preprint-Website arXiv.org (arXiv: 1811.10597v2) veröffentlicht.

Interaktive Demos, Videos, Codes und Daten werden

auf Github und auf

der MIT-Website veröffentlicht .