Allzweck-Rechenzentrumsarchitekturen (solche Rechenzentren werden heute noch häufig verwendet) haben ihre Aufgaben in der Vergangenheit gut gelöst, aber die meisten von ihnen haben kürzlich ihre Grenzen in Bezug auf Skalierbarkeit, Leistung und Effizienz erreicht. Die Architektur solcher Rechenzentren verwendet normalerweise das Prinzip der aggregierten Ressourcenzuweisung - Prozessoren, Festplatten und Netzwerkkanalbreiten.

In diesem Fall tritt in solchen Rechenzentren diskret eine Änderung des verwendeten Ressourcenvolumens (Zunahme oder Abnahme) mit vorbestimmten Koeffizienten auf. Mit einem Koeffizienten von 2 können wir beispielsweise diese Reihe von Konfigurationen erhalten:

- 2 CPU, 8 GB RAM, 40 GB Speicher;

- 4CPU, 16 GB RAM, 80 GB Speicher;

- 8 CPU, 32 GB RAM, 160 GB Speicher;

- ...

Für viele Aufgaben sind diese Konfigurationen jedoch wirtschaftlich ineffektiv. Oft reicht eine Zwischenkonfiguration für Kunden aus, z. B. - 6 CPU, 16 GB RAM, 100 GB Speicher. Wir kommen daher zu dem Verständnis, dass der oben genannte universelle Ansatz zur Zuweisung von Rechenzentrumsressourcen unwirksam ist, insbesondere wenn intensiv mit Big Data gearbeitet wird (z. B. schnelle Daten, Analysen, künstliche Intelligenz, maschinelles Lernen). Benutzer möchten in solchen Fällen flexiblere Steuerungsmöglichkeiten für die verwendeten Ressourcen haben. Sie müssen in der Lage sein, die Prozessoren, den Speicher und den Datenspeicher sowie die Netzwerkkanäle unabhängig voneinander zu skalieren. Das ultimative Ziel dieser Idee ist die Schaffung einer flexiblen Komponenteninfrastruktur.

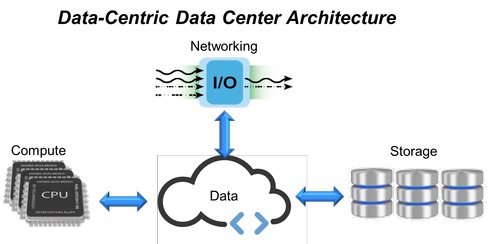

Abb. 1. Datenzentrierte Rechenzentrumsarchitektur.

Abb. 1. Datenzentrierte Rechenzentrumsarchitektur.Als Reaktion auf diese Anforderungen kamen Rechenzentren mit hyperkonvergenter Infrastruktur (HCI, Hyper-Converged Infrastructure), die alle Computerressourcen, Speichersysteme und Netzwerkkanäle in einem einzigen virtualisierten System zusammenfassen (Abb. 1). In dieser Struktur sind jedoch zusätzliche Server erforderlich, um die Grenzen der Skalierbarkeit zu erweitern (Hinzufügen neuer Speichersysteme, Speicher oder Netzwerkkanäle). Dies bestimmte das Auftreten eines Ansatzes, der auf der Erweiterung der HCI-Infrastruktur um feste Module (von denen jedes Prozessoren, Speicher und Datenspeicher enthält) basiert und letztendlich nicht das Maß an Flexibilität und vorhersehbarer Leistung bietet, das in modernen Rechenzentren so gefragt ist.

HCI wird bereits durch nach Komponenten aufgeschlüsselte Infrastrukturen (CDI, Composable-Disaggregated Infrastructures) ersetzt, die die Einschränkungen konvergierter oder hyperkonvergierter IT-Lösungen überwinden und Rechenzentren eine bessere Flexibilität bieten sollen.

Das Aufkommen einer nach Komponenten aufgeschlüsselten InfrastrukturUm die mit der Architektur von Allzweck-Rechenzentren verbundenen Probleme (festes Verhältnis von Ressourcen, Unterauslastung und Redundanz) zu überwinden, wurde zunächst eine konvergierte Infrastruktur entwickelt, die aus vorkonfigurierten Hardwareressourcen in einem einzigen System besteht. Rechenressourcen, Speichersysteme und Netzwerkinteraktionen in ihnen sind diskret und die Mengen ihres Verbrauchs werden programmgesteuert konfiguriert. Anschließend wurden konvergierte Strukturen in hyperkonvergente Strukturen (HCI) umgewandelt, in denen alle Hardwareressourcen virtualisiert werden und die Zuweisung der erforderlichen Mengen an Computerressourcen, Speicher und Netzwerkkanälen auf Softwareebene automatisiert wird.

Trotz der Tatsache, dass HCI alle Ressourcen in ein einziges virtualisiertes System integriert, hat dieser Ansatz auch seine Nachteile. Um dem Client beispielsweise eine wesentlich größere Menge an Speicher, RAM oder eine Erweiterung des Netzwerkkanals in der HCI-Architektur hinzuzufügen, müssen zusätzliche Prozessormodule verwendet werden, auch wenn diese nicht direkt für Rechenvorgänge verwendet werden. Infolgedessen haben wir eine Situation, in der beim Erstellen von Rechenzentren, die flexibler als frühere Architekturen sind, immer noch unflexible Gebäudeelemente verwendet werden.

Umfragen unter IT-Benutzern mittlerer und großer Unternehmens-Rechenzentren zufolge werden ungefähr 50% der gesamten verfügbaren Speicherkapazität für den tatsächlichen Gebrauch zugewiesen, während Anwendungen nur die Hälfte des zugewiesenen Speichervolumens verwenden und die CPU-Zeit ebenfalls von ungefähr 50% genutzt wird. Der Ansatz mit festen Struktursystemen führt daher zu deren Unterlastung und bietet nicht die erforderliche Flexibilität und vorhersehbare Leistung. Um diese Probleme zu lösen, wurde ein disaggregiertes Modell erstellt, das mithilfe von Softwaretools mit einer offenen API einfach aus separaten Funktionsmodulen zusammengesetzt werden kann.

Component Disaggregated Infrastructure (CDI) ist eine Rechenzentrumsarchitektur, in der physische Ressourcen - Rechenleistung, Speicher und Netzwerkkanäle - als Dienste behandelt werden. Die Bereitstellung aller erforderlichen Ressourcen für Benutzeranwendungen zur Erfüllung ihrer aktuellen Last erfolgt in Echtzeit, wodurch eine optimale Leistung im Rechenzentrum erzielt wird.

Komponenten-disaggregiertes Anti-Konvergenz-Modell

Virtuelle Server in einer nach Komponenten aufgeschlüsselten Infrastruktur (Abb. 2) werden erstellt, indem Ressourcen aus unabhängigen Pools von Computersystemen, Speicher- und Netzwerkgeräten verknüpft werden, im Gegensatz zu HCI, bei dem physische Ressourcen an HCI-Server gebunden sind. Auf diese Weise können CDI-Server nach Bedarf entsprechend den Anforderungen einer bestimmten Arbeitslast erstellt und neu konfiguriert werden. Mithilfe des API-Zugriffs auf Virtualisierungssoftware kann die Anwendung alle erforderlichen Ressourcen anfordern und ohne menschliches Eingreifen eine sofortige Serverrekonfiguration in Echtzeit erhalten - ein echter Schritt in Richtung eines selbstverwaltenden Rechenzentrums.

Abb. 2: Hyperconverged Model (HCI) und Component Disaggregated (CDI).

Abb. 2: Hyperconverged Model (HCI) und Component Disaggregated (CDI).Ein wichtiger Teil der CDI-Architektur ist die interne Kommunikationsschnittstelle, die die Trennung (Disaggregation) der Speichergeräte eines bestimmten Servers von seiner Rechenleistung und deren Bereitstellung für die Verwendung durch andere Anwendungen sicherstellt.

NVMe-over-Fabrics wird hier als Hauptprotokoll verwendet. Es bietet die geringsten Verzögerungen bei der Datenübertragung zwischen Anwendungen und Speichergeräten. Auf diese Weise kann CDI den Benutzern alle Vorteile eines direkt angeschlossenen Speichers (geringe Latenz und hohe Leistung) bieten und durch gemeinsame Nutzung von Ressourcen Reaktionsfähigkeit und Flexibilität bieten.

Abb. 3. Die Struktur von NVMe-over-Fabrics.

Abb. 3. Die Struktur von NVMe-over-Fabrics.Die NVMe-Technologie (Non-Volatile Memory Express) selbst ist eine optimierte, leistungsstarke Schnittstelle mit geringer Latenz, die eine Architektur und eine Reihe von Protokollen verwendet, die speziell für die Verbindung von SSDs mit Servern über den PCI Express-Bus entwickelt wurden. Für CDI wurde dieser Standard auf NVMe-over-Fabrics erweitert - über lokale Server hinaus.

Diese Spezifikation ermöglicht Flash-Geräten die Kommunikation über das Netzwerk (unter Verwendung verschiedener Netzwerkprotokolle und Übertragungsmedien - siehe Abbildung 3) und bietet die gleiche hohe Leistung und Übertragungsverzögerung wie lokale NVMe-Geräte. Gleichzeitig gibt es praktisch keine Einschränkungen hinsichtlich der Anzahl der Server, die NVMe-over-Fabrics-Geräte gemeinsam nutzen können, oder hinsichtlich der Anzahl solcher Speichergeräte, auf die ein Server zugreifen kann.

Die Anforderungen heutiger Big-Data-intensiver Anwendungen übertreffen die Fähigkeiten herkömmlicher Rechenzentrumsarchitekturen, insbesondere in Bezug auf Skalierbarkeit, Leistung und Effizienz. Mit dem Aufkommen von CDI (Component Disaggregated Infrastructure) können Rechenzentrumsarchitekten, Cloud-Service-Provider, Systemintegratoren, Speicherentwickler und OEMs Speicher- und Computerdienste kostengünstiger, flexibler, effizienter und einfacher skalierbar machen und dynamisch die erforderliche SLA für alle bereitstellen Arbeitslasten.