Dies ist der zweite Teil einer Einführung in Kubernetes für VMware-Benutzer. Bevor Sie zum praktischen Teil übergehen, lesen Sie den vorherigen Artikel

hier .

Der einfachste und schnellste Weg, Kubernetes ohne besondere Anforderungen kennenzulernen, ist GCP (Google Cloud Platform). Holen Sie sich einfach Testzugriff und lernen Sie Kubernetes. Um die Registrierung zu bestätigen, müssen Sie Informationen auf einer Kreditkarte angeben. GCP zieht nichts ab, bis Sie die Zahlung selbst aktivieren. Erstellen Sie ein Konto und wir werden weiterhin die faszinierende Welt von Kubernetes erkunden.

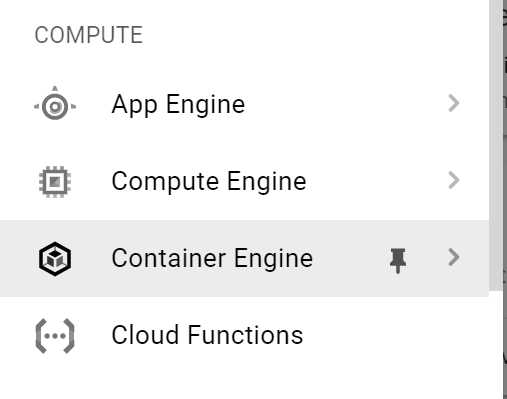

Der erste Schritt besteht darin, eine Verbindung zu GKE (Google Kubernetes Engine) herzustellen. Wählen Sie im linken Menü die Option

Container Engine .

Klicken Sie auf

Cluster erstellen.

Füllen Sie die Felder aus:

- Clustername;

- Zugangsbereich

- Version von Kubernetes;

- Bilddetails usw.

Der Cluster wird in wenigen Minuten erstellt. Wenn Sie fertig sind, klicken Sie auf Verbinden. Ein Befehl zum Verbinden wird angezeigt. Wir werden es benutzen. Kopieren Sie es.

Die einfachste Möglichkeit, eine Verbindung zum Cluster herzustellen, ist die

Google Cloud-Shell .

Klicken Sie in der oberen rechten Ecke auf das Shell-Symbol.

Nach einigen Sekunden startet die Shell auf derselben Seite. Fügen Sie den Befehl ein, den Sie im vorherigen Schritt kopiert haben.

Lassen Sie uns nun die Informationen zu unserem Cluster mit dem

Befehl kubectl cluster-info anzeigen .

Geben Sie den

Geben Sie den Befehl

kubectl get no -o wide ein, um Informationen zu Knoten

abzurufen. Sie sehen eine Liste der Knoten mit Informationen dazu.

Jetzt erhalten wir eine Liste aller funktionierenden Pods in unserem K8s-Cluster. Geben Sie den

Befehl kubectl get po -o wide –all-namespaces ein .

Stellen Sie nun eine Verbindung zu den Clusterknoten her, um deren Netzwerkeinstellungen herauszufinden. Klicken Sie dazu erneut links auf das Hauptmenü und wählen Sie

Compute Engine aus der Dropdown-Liste. Wie Sie dem folgenden Screenshot entnehmen können, ist der k8s-Cluster letztendlich die Anzahl der virtuellen Maschinen.

Klicken Sie auf

SSH , um eine Sitzung mit dem ausgewählten Knoten zu starten. Ein neues Dialogfeld wird angezeigt. Stellen Sie sicher, dass Ihr Browser keine Popups blockiert.

Überprüfen Sie, welche Linux-Distribution verwendet wird. Geben Sie dazu

uname -a und dann

cat / etc / lsb-release ein .

Überprüfen Sie nun die Netzwerkeinstellungen mit

ifconfig -a | mehr . Siehe die

cbr0- Bridge-

Schnittstelle ? Dies ist die, die wir im obigen Netzwerkdiagramm gezeigt haben.

Hier sehen wir auch das diesem Knoten zugewiesene / 24-Netzwerk - 10.40.1.0/24. Daraus erhalten unsere Pods ihre IP-Adressen. Jetzt können Sie das obige Netzwerkdiagramm mit der tatsächlichen Konfiguration auf den Knoten des k8s-Clusters korrelieren. Cool, oder?

Kehren wir nun zum Google Cloud Shell-Fenster zurück und versuchen Sie, eine Testanwendung bereitzustellen. Fahren Sie den

Git-Klon https://github.com/hanymichael/NSX-CNA-Lab.git ein .

Mit diesem Befehl klonen Sie eine meiner Testanwendungen auf GitHub. Gehen Sie nun zum Anwendungsordner und geben Sie

kubectl create -f ein. Damit werden alle YAML-Dateien in diesem Ordner erstellt.

Jetzt zeigen wir die Liste der Pods an und sehen ihren Status. Es ist ersichtlich, dass jeder den Status

ContainerCreating hat . Nach einigen Sekunden ändert sich der Status in "

Laufen" .

Es gibt zwei Bereitstellungen meiner Webanwendung in K8s mit jeweils 4 Replikaten. Überprüfen wir nun die mit dieser Bereitstellung

verknüpften Dienste mit dem Befehl

kubectl get svc .

Als letztes muss der mit dieser Anwendung verbundene Eingang überprüft werden. Der Screenshot oben zeigt, dass wir über eine externe IP eine Verbindung zur Anwendung herstellen. Wenn wir den Abschnitt mit dem Balancer überprüfen, wird der mit dem Eingang verknüpfte Load Balancer angezeigt.

Wenn Sie auf die Anwendung selbst zugreifen möchten, können Sie einen DNS-Eintrag für * .esxcloud.net in der lokalen Hostdatei erstellen.

Öffnen Sie nun eine neue Registerkarte im Browser und folgen Sie den Links

sphinx-v1.esxcloud.net und

sphinx-v2.esxcloud.net . Wir werden zwei Dinge sehen:

- Die Version der Anwendung wird auf jedem Link angezeigt.

- Nach dem Aktualisieren der Webseite ändert sich die IP-Adresse des Containers, was bedeutet, dass der Balancer arbeitet.

Jetzt können Sie die Anwendungskonfiguration mit dem folgenden Diagramm korrelieren und sehen, wie alles in Kubernetes aussieht.

Fazit

Wir haben gesehen, dass Kubernetes wie jedes verteilte System viele Ähnlichkeiten (und einige Unterschiede) mit vSphere aufweist, das uns als VMware-Benutzer bekannt ist. Ich habe versucht, die grundlegenden Konzepte durch einen Vergleich von K8s & vSphere zu erklären. Ich hoffe, dies hilft Ihnen dabei, diese unglaublich leistungsstarke Cloud-Plattform, die bereits die Welt erobert, schnell kennenzulernen.

In den folgenden Beiträgen werde ich mich eingehender mit der Entwicklung unserer Unternehmenslösung zum Starten von Kubernetes im Rechenzentrum befassen. Folgen Sie den Nachrichten!

PS: Sie können die Kubernetes-Funktionen auch in unserem

KuberLine- Service

testen , nachdem Sie eine Probefahrt durchgeführt haben.