Obwohl seit der Einführung der

ersten SATA-SSD 14 Jahre vergangen sind, beziehen sich viele Verbraucher immer noch mit einiger Skepsis auf Solid-State-Laufwerke. Der Hauptgrund für Misstrauen ist die begrenzte Arbeitsressource des Flash-Speichers aufgrund der allmählichen Verschlechterung der Halbleiterstruktur der Chips, wodurch die Geräte früher oder später ihre Fähigkeit verlieren, Informationen aufzuzeichnen und zu speichern. Detaillierte technische Spezifikationen verschärfen die Situation oft nur: Es ist für einen Käufer schwierig zu verstehen, ob die in der 3D-NAND-SATA-SSD-Beschreibung von Western Digital Blue 3D für zwei Terabyte erwähnte TBW 500 TB viel oder wenig ist. Wie lange hält ein solches Laufwerk unter realen Betriebsbedingungen und kann man ihm die wertvollsten Dateien anvertrauen? Lassen Sie uns versuchen, dieses Problem gemeinsam zu verstehen und darüber zu sprechen, wie zuverlässig moderner Flash-Speicher ist.

Genau genommen wurde die Antwort auf die „Hauptfrage des Lebens, des Universums und all das“ bereits im Dezember 2014 erhalten, als die

Mitarbeiter der

TechReport- Netzwerkpublikation das Testen von SSDs für Verbraucher abgeschlossen hatten, das insgesamt ein Jahr dauerte. Am Beispiel von HyperX-, Corsair-, Kingston- und Samsung-Produkten haben sie überzeugend bewiesen, dass das reale Leben von SSDs 1 Petabyte Überspielen übersteigt. Solche Mengen sind nicht nur für den durchschnittlichen Benutzer, sondern auch für professionelle Content-Hersteller fast undenkbar: Das Laufwerk wird moralisch viel früher veraltet sein, als seine Ressourcen erschöpft sind.

Es gibt jedoch eine wesentliche Nuance: Vor vier Jahren wurden MLC-NAND-Chips verwendet, die in der Lage waren, 2 Informationsbits in jeder Zelle zu speichern, und die unter Verwendung einer 25-Nanometer-Prozesstechnologie hergestellt wurden. Zu dieser Zeit war es ein guter Kompromiss zwischen der hochzuverlässigen SLC (Single-Level-Zelle) und der geräumigeren und kostengünstigeren TLC (Triple-Level-Zelle): Chips mit Zwei-Bit-Zellen lieferten eine akzeptable Datenspeicherdichte und hielten bis zu 5.000 Schreib- / Löschzyklen stand (in im Durchschnitt erreicht diese Zahl 3 Tausend). Was man über ihre engsten Brüder nicht sagen kann: Bei allen Vorteilen, zu denen hohe Kapazität und niedrige Kosten gehören, waren die TLCs viel weniger robust, da sie kaum die Grenze von 1.500.000 Programmier- / Löschzyklen überschritten hatten, obwohl die meisten planaren Mikroschaltungen kaum tausend aushalten können.

Der Hauptschuldige in dieser Situation war der Übergang zu einem 15-Nanometer-Verfahren zur Herstellung von Chips. Um zu verstehen, warum dies passiert ist, denken Sie daran, wie der NAND-Speicher funktioniert. Die Codierung von Informationsbits erfolgt durch Ändern der Ladung auf einem schwebenden Gate aufgrund des Quantentunnelns von Elektronen durch die dielektrische Schicht aufgrund der hohen elektrischen Feldstärke.

Floating-Gate-TransistorschaltungAus physikalischer Sicht haben wir es nur mit dem Phänomen eines reversiblen Lawinen-ähnlichen Zusammenbruchs zu tun. Bei einer Beschleunigung in einem elektrischen Feld erhalten die Elektronen ausreichend kinetische Energie für die Stoßionisation der dielektrischen Moleküle, was zu einem Paar von Elementarteilchen führt, die die entgegengesetzte Ladung tragen, die ebenfalls durch ein elektrisches Feld beschleunigt werden, und der Vorgang wiederholt sich, während die Anzahl der Ladungsträger exponentiell zunimmt (daher der Name) ) Es ist leicht zu erraten, dass solche Prozesse einen allmählichen Verschleiß der dielektrischen Schichten verursachen. Infolgedessen steigt die Wahrscheinlichkeit eines Ladungslecks zu benachbarten Zellen, was wiederum zu einer Beschädigung oder sogar zu einem vollständigen Datenverlust führt. Und der Übergang zu einer neuen Prozesstechnologie verschärft die Situation nur: Eine Verringerung der Dicke des Dielektrikums führt dazu, dass die Zellen viel früher versagen.

Wenn das Problem jedoch nur dies wäre, würden normale Verbraucher und Unternehmensbenutzer den Unterschied zwischen MLC und TLC einfach nicht bemerken, und in den technischen Spezifikationen für SSD würden wir viel beeindruckendere Zahlen sehen. In der Realität erscheint vor unseren Augen ein völlig anderes Bild, und die Architektur der Flash-Chips und die Besonderheiten ihrer Arbeit sind der Grund dafür: Einzelne Zellen werden zu Seiten und Seiten zu Blöcken zusammengefasst, während Informationen nur in leere Seiten geschrieben und gelöscht werden können Block für Block.

Was bedeutet das in der Praxis? Angenommen, wir haben einen teilweise gefüllten Block und möchten neue Daten darauf schreiben. Wenn ihre Lautstärke geringer ist als der verbleibende freie Speicherplatz, erfolgt die Aufzeichnung sofort ohne zusätzliche Manipulationen. Wenn nicht genügend Platz vorhanden ist, kommen komplexe mehrstufige Algorithmen ins Spiel. Betrachten Sie die Situation in der folgenden Abbildung.

So werden Daten in den Flash-Speicher geschriebenDie neuen Daten, die wir aufzeichnen möchten, belegen zwei Seiten in einem Block, aber nur eine ist wirklich frei: Obwohl die alte Seite (gelb hervorgehoben) vom Benutzer zuvor gelöscht wurde, sind die aufgezeichneten Informationen tatsächlich nicht verschwunden. Um Platz für neue Daten zu schaffen, initiiert der Controller eine Prozedur, die als Garbage Collection bezeichnet wird. Dabei werden unnötige Daten gelöscht und vorhandene neu verteilt. Zu diesem Zweck werden alle Seiten außer den unnötigen in den zweiten freien Block kopiert, während der erste vollständig gelöscht wird. Dann werden die eigentlichen Seiten zurück in den ersten Block übertragen, aus dem zweiten gelöscht, und erst danach nehmen die neuen Daten ihren rechtmäßigen Platz ein.

Im obigen Beispiel mussten wir zum Aufzeichnen von zwei Seiten zwei Blöcke zweimal mit jeweils sechs Seiten vollständig neu schreiben. Tatsächlich wird der Prozess der „Garbage Collection“ viel komplizierter aussehen und infolgedessen wird die Anzahl der Umschreibungszyklen viel größer sein. Das reale Bild kann nur geschätzt werden, wenn der Schreibverstärkungskoeffizient bekannt ist, der zeigt, wie oft die tatsächliche Belastung des Flash-Speichers die berechnete überschreitet. Dieser Indikator kann nur dann gleich Eins sein, wenn Informationen auf einer absolut sauberen, gerade formatierten Festplatte aufgezeichnet werden. In allen anderen Fällen variiert sein Wert zwischen 2 und 25. Darüber hinaus können identische Laufwerke selbst auf den ersten Blick erheblich variieren abhängig vom Modell des verwendeten Controllers und den Funktionen der Firmware. Die SSD-Fehlertoleranz wird daher nicht nur von der Art des Flash-Speichers bestimmt, sondern auch davon, inwieweit die Entwickler die Leistung der FTL-Schicht (Flash Translation Layer) optimieren konnten.

Warum hat der dramatische Anstieg der Speicherdichte die Zuverlässigkeit des 3D-NAND-Speichers nicht beeinträchtigt?

Jetzt wissen wir also, wie Flash-Speicher funktioniert und welche Faktoren die Zuverlässigkeit eines SSD-Laufwerks bestimmen. Es ist Zeit herauszufinden, welche Vorteile der Übergang von „flachen“ zu dreidimensionalen Chips bietet. Erstens unterscheidet sich 3D NAND von seinen Vorgängern durch die Verwendung der „Ladungsfalle“ (Charge Trap Flash) anstelle der bekannten schwimmenden Fensterläden. Wenn in letzterem Polysilicium mit Dotierstoffen zum Speichern von Ladungen verwendet wird, ist es in CTF ein isolierter Bereich aus nichtleitendem Material, meistens SiN - Siliciumnitrid. Ein solcher Ansatz ermöglichte es, die Wahrscheinlichkeit eines Ladungslecks zu minimieren und infolgedessen die Zellstabilität zu erhöhen.

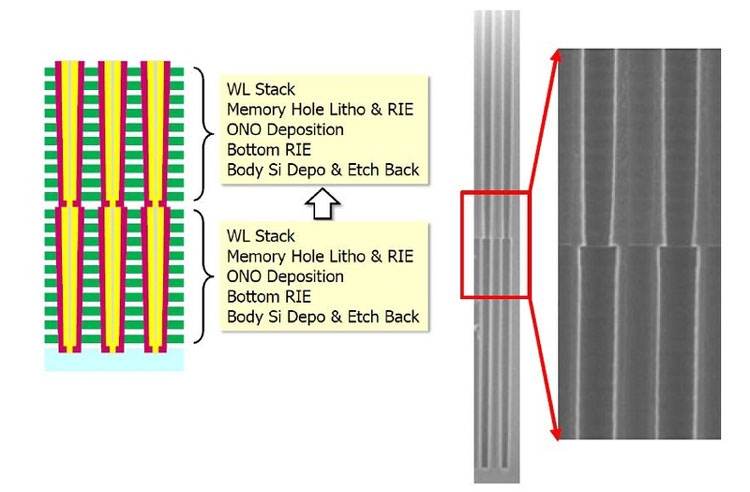

Die Architektur dreidimensionaler Speicherchips hat im Vergleich zu ihrem Vorgänger ebenfalls erhebliche Änderungen erfahren, da jetzt jede Zelle eine zylindrische Struktur aufweist: Die äußere Schicht ist ein Steuergatter und die innere ist ein Isolator. Da sich die Zellen nun übereinander befinden, bilden sie einen Stapel, in dem ein Kanal aus polykristallinem Silizium verläuft. Es ist leicht zu verstehen, dass die Anzahl der Schichten in einem Chip die Anzahl der Zellen im Stapel bestimmt.

3D-NAND-ChipzellengerätDiese Struktur ermöglichte es, Interferenzen zwischen Zellen zu reduzieren und dadurch den Aufzeichnungsalgorithmus zu vereinfachen: Da der Ladezustand nicht überprüft werden musste, begann die Aufzeichnung in der Zelle in einem Schritt. Eine weitere wichtige Nuance: Für die Herstellung von 3D-NAND werden Einlaufverfahren eingesetzt, obwohl die Packungsdichte der Zellen deutlich ansteigen konnte. So wurden beispielsweise sogar 48-Schicht-Chips (die dritte Generation des dreidimensionalen Flash-Speichers) mit einer 40-Nanometer-Prozesstechnologie hergestellt. Dies ermöglichte es nicht nur, ihre Zuverlässigkeit zu erhöhen, sondern auch die Produktionskosten zu senken, da die bestehenden Produktionslinien nur minimal modernisiert werden mussten und der Bedarf an Lithographie im tiefen Ultraviolett vollständig verschwand.

In den modernen

WD Black SN750 NVMe-SSDs , deren Verkaufsstart am 18. Januar 2019 begann, wird das 64-lagige TLC 3D NAND BiCS (Bit Cost Scalable) verwendet, das mit der 28-Nanometer-Prozesstechnologie hergestellt wurde. Neben der Erhöhung der Packungsdichte um das 1,4-fache (das Topmodell hat jetzt eine Kapazität von 2 TB, was der doppelten Größe des Flaggschiffs der vorherigen Generation entspricht), ist die Verwendung von U-förmigen Saiten ein wichtiges Merkmal dieses Chiptyps.

3D NAND BiCS ArchitekturDa sich nun der Schalttransistor und die Source-Leitung im oberen Teil des Chips befinden, sind sie praktisch keinen Hochtemperatureinflüssen ausgesetzt, die selbst zu Fehlern beim Lesen / Schreiben führen können, was die Zuverlässigkeit von Halbleiterantrieben weiter verbessert.

Wie wirken sich Aufzeichnungsalgorithmen auf die Lebensdauer einer SSD aus?

Wir haben bereits oben geschrieben, dass unabhängig davon, wie robust und sicher der Flash-Speicher selbst ist, seine Ressourcen verschwendet werden, wenn sich die Entwickler von SSD nicht die Mühe machen, effektive Aufzeichnungsalgorithmen zu erstellen. Um dieses Verfahren zu optimieren, werden zwei sehr effektive Techniken verwendet: SLC-Caching und Wear Leveling.

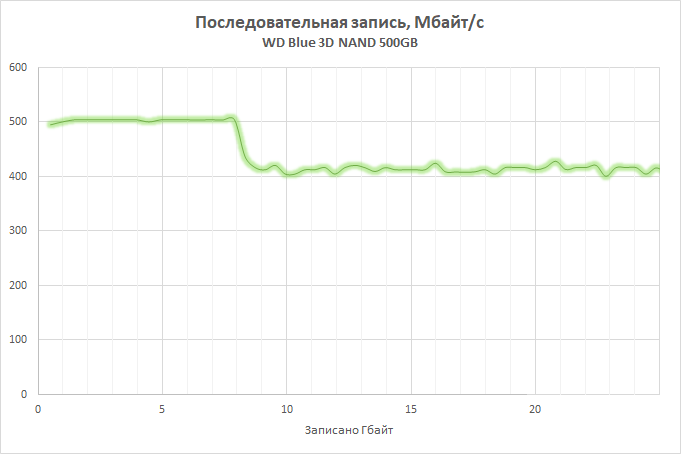

Das Wesentliche des ersten ist, dass ein Teil des verfügbaren Speicherarrays, dessen Größe vom Gesamtvolumen des Laufwerks abhängt (bei der Entwicklung der

WD Blue 3D-NAND-SSD haben wir beispielsweise 4 GB Cache für jeweils 250 GB Kapazität berechnet), in den SLC-Betriebsmodus übertragen wird, d. H. In jeder Zelle wird nur ein Informationsbit aufgezeichnet, wodurch sowohl die Leistung erheblich gesteigert als auch die Verschleißrate verringert werden kann. SLC ist an der Aufzeichnung und Konsolidierung von auf der SSD gespeicherten Daten beteiligt, wodurch nicht nur die Betriebsgeschwindigkeit erhöht, sondern auch die Geschwindigkeit des Zellverschleißes verringert werden kann. In aktuellen Versionen von Western Digital SSDs wird die nCache 3.0-Technologie verwendet, deren neueste Version die Direct-to-TLC-Funktion übernommen hat, mit der ein Gleichgewicht zwischen Caching und Geschwindigkeit gefunden werden konnte: Daten werden unter Umgehung des Caches geschrieben, wenn dieser voll ist oder SLC- Der Puffer ist nicht praktisch. Dies trug einerseits dazu bei, den Cache zu entladen und gleichzeitig einen dramatischen Leistungsabfall beim Befüllen zu vermeiden.

Bei der Technologie zum Nivellieren des Verschleißes wird sichergestellt, dass alle verfügbaren Seitenblöcke so gleichmäßig wie möglich verwendet werden. Wie Sie wissen, verwendet jedes Betriebssystem einen logischen Mechanismus zum Adressieren von Datenblöcken (LBA), während der Controller selbst mit physischen Adressen (PBA) arbeitet und diese mit logischen Adressen korreliert. Infolgedessen spielt es keine Rolle, wo sich die Fragmente der Dateien tatsächlich befinden, wodurch es möglich ist, ein Mikroprogramm zu schreiben, das sicherstellt, dass die Last zwischen den Zellen gleichmäßig verteilt wird.

Die Verschleißnivellierung sorgt für eine gleichmäßige Belastung der ZellenIm allgemeinen Fall ist sein Algorithmus wie folgt. Sie haben eine brandneue SSD gekauft und solange noch freier Speicherplatz vorhanden ist, werden die Informationen in freien Blöcken aufgezeichnet. Während des Betriebs beginnen Sie, unnötige Dateien zu löschen, und der Speicherbereinigungsmechanismus bereinigt sie im Hintergrund. Sie werden jedoch nur dann für die Aufzeichnung verwendet, wenn mindestens einmal kein einziger Block mehr auf der Festplatte vorhanden ist, in den Daten geschrieben wurden. Natürlich ist in Wirklichkeit alles viel komplizierter, aber die Bedeutung ändert sich nicht.

Und hier sollte noch ein wichtiger Hinweis zu Western Digital-Produkten gemacht werden. Als wir beschlossen, den SSD-Markt zu entwickeln, konnten wir zwei Wege gehen: Speicher und Controller von Drittherstellern kaufen, wobei wir uns nur auf die Entwicklung und Optimierung von Firmware konzentrieren, oder eine Produktion mit vollem Zyklus einrichten. Ein solches Projekt von Grund auf neu durchzuführen wäre unpraktisch, und selbst der

Kauf von SanDisk hat uns einen hübschen Cent gekostet. Aber die investierten Mittel haben sich voll und ganz geschlagen: Durch die Kontrolle der Produktion von Chips hatten wir die Möglichkeit, die Mikroprogramme an die Eigenschaften von Mikroschaltungen anzupassen.

Es versteht sich, dass das Schreiben von Informationsbits in Flash-Speicherzellen ein viel komplizierterer Prozess ist, als es auf den ersten Blick erscheinen mag: Es berücksichtigt Hunderte verschiedener Parameter, von denen die wichtigsten die für die Ladungsübertragung erforderliche Spannung und die Aufzeichnungszeit sind. Wenn sich die Chips abnutzen, ändern sich auch ihre physikalischen Eigenschaften: Für eine erfolgreiche Datenaufzeichnung ist weniger Spannung erforderlich, und gleichzeitig wird die erforderliche Zeit ihres Einflusses auf die Zelle verringert. Bei den meisten SSDs sind diese Parameter konstant, bei Western Digital-SSDs ändern sie sich jedoch dynamisch, wenn sich die Zellen abnutzen, wodurch die Lebensdauer jeder einzelnen von ihnen maximiert und die negativen Auswirkungen auf Halbleiterstrukturen minimiert werden können.

QLC 3D NAND - Flash-Speicher der neuesten Generation

Wenn Sie den Nachrichten aus der Welt der Hochtechnologien folgen, wissen Sie wahrscheinlich, dass Western Digital die Produktion des dreidimensionalen Speichers der nächsten Generation - QLC 3D NAND - aktiv beherrscht (die erste Ankündigung erfolgte im Juni 2018). Das Akronym QLC steht für Quad-Level-Zelle. Mit anderen Worten können 16 Ladungspegel in einer Zelle gespeichert werden, die nicht nur drei, sondern vier Informationsbits codieren. Im Vergleich zu TLC 3D NAND stieg die Aufzeichnungsdichte in QLC um 33%: Die Kapazität eines 64-Schicht-Chips stieg somit auf 768 Gbit / s. Dies ist jedoch nicht die Grenze: Im August 2018 haben wir mit der Veröffentlichung von 96-Lagen-Mikroschaltungen begonnen. Durch die Erhöhung der Anzahl der Schichten konnten wir die Kapazität um 50 Prozent steigern und die 1-Tbit-Barriere überwinden: Neue Chips, 3D NAND BiCS4 genannt, können 1,33 Tbit an Informationen aufnehmen, was etwa 166 GB entspricht. Durch die Kombination von zwei 48-Schicht-Kristallen konnte eine so hohe Datenspeicherdichte erreicht werden (heute ist dies der wirtschaftlichste Ansatz).

Die erhöhte Kapazität kann möglicherweise die Leistung von SSDs verringern, aber Sie sollten sich darüber keine Sorgen machen: Der neue 3D-NAND-BiCS4-Flash-Speicher verwendet vier anstelle von zwei physischen Arrays, wodurch das Lesen und Schreiben von Daten durch Parallelisierung von Vorgängen optimiert werden kann. Dies wird dazu beitragen, den Cache effizienter zu nutzen und den Grad des Zellverschleißes zu steuern, während die Lebensdauer von QLC-Chips auf einem Niveau gehalten wird, das mit modernen DC-Lösungen vergleichbar ist. Eine Beschreibung der Technologien, die QLC zugrunde liegen, würde jedoch den Rahmen dieses Materials sprengen und verdient sicherlich einen separaten Artikel.