Hallo Habr!

Als wir dieses Jahr das endgültige Dokument über die Arbeit des Unternehmens für das Jahr verfassten, beschlossen wir, die Nacherzählung der Nachrichten nicht zu verweigern, und obwohl wir die Erinnerungen an das Geschehen nicht vollständig loswerden konnten, möchten wir Ihnen mitteilen, was wir geschafft haben - Gedanken zusammenzustellen und unsere Augen darauf zu richten dorthin, wo wir uns sicherlich in naher Zukunft befinden werden - gegenwärtig.

Wichtige Erkenntnisse aus dem letzten Jahr:

- Die durchschnittliche Dauer von DDoS-Angriffen sank auf 2,5 Stunden.

- Das Jahr 2018 zeigte das Vorhandensein von Rechenleistung, die Angriffe mit einer Intensität von Hunderten von Gigabit pro Sekunde innerhalb eines Landes oder einer Region erzeugen kann, was uns an den Rand der "Quantentheorie der Relativität der Bandbreite" führt .

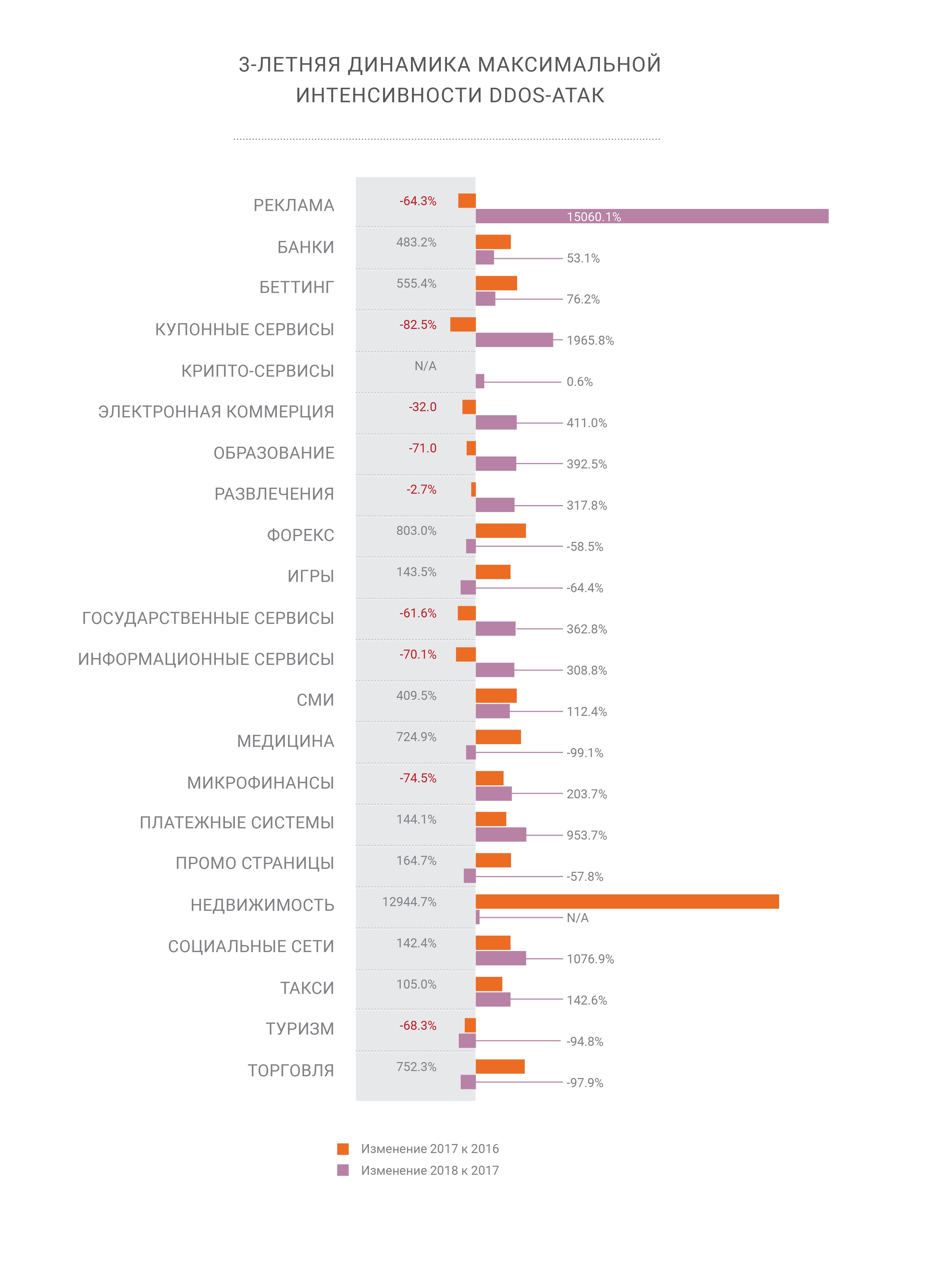

- Die Intensität von DDoS-Angriffen nimmt weiter zu.

- Zusammen mit der gleichzeitigen Erhöhung des Anteils der Angriffe mit HTTPS (SSL);

- PCs sind tot - der größte Teil des modernen Datenverkehrs wird auf Mobilgeräten generiert. Dies ist eine Herausforderung für DDoS-Organisatoren und die nächste Herausforderung für Netzwerksicherheitsunternehmen.

- BGP wurde schließlich zwei Jahre später als erwartet zu einem Angriffsvektor.

- Die DNS-Manipulation ist immer noch der störendste Angriffsvektor.

- Wir erwarten in Zukunft neue Verstärker wie Memcached und CoAP.

- Es gibt keine "sicheren Häfen" mehr im Internet und alle Branchen sind gleichermaßen anfällig für Cyber-Angriffe jeglicher Art.

Unter dem Schnitt haben wir die interessantesten Teile des Berichts an einem Ort gesammelt. Die Vollversion finden Sie

hier . Gute Lektüre.

Rückblick

Die Krypto ist für den Angreifer nicht mehr interessant

Die Krypto ist für den Angreifer nicht mehr interessantIm Jahr 2018 „notierte“ unser Unternehmen zwei Rekordangriffe auf sein eigenes Netzwerk. Die Memcached-Amplification-Angriffe, die wir Ende Februar 2018 ausführlich beschrieben haben, trafen das Qiwi-Zahlungssystem mit 500 Gbit / s, wurden jedoch vom Filternetzwerk erfolgreich neutralisiert. Ende Oktober erlebten wir einen weiteren wegweisenden Angriff - die DNS-Verstärkung mit Quellen, die in einem einzigen Land lokalisiert sind, aber eine beispiellose Macht haben.

Die DNS-Verstärkung war und ist einer der bekanntesten DDoS-Angriffsvektoren auf Verbindungsebene und wirft immer noch zwei scharfe Fragen auf. Bei einem Angriff mit einer Intensität von Hunderten von Gigabit pro Sekunde besteht eine erhebliche Wahrscheinlichkeit, dass die Verbindung zu einem höheren Anbieter überlastet wird. Wie gehe ich damit um? Offensichtlich ist es notwendig, eine solche Last auf so viele Kanäle wie möglich zu verteilen - was uns zum zweiten Problem führt - der zusätzlichen Netzwerkverzögerung infolge von Änderungen der Verkehrspfade zu ihren Verarbeitungsorten. Glücklicherweise haben wir dank der flexiblen Lastausgleichsoptionen im Qrator-Netzwerk auch den zweiten Angriff geschafft.

Auf diese Weise hat uns das Balancing seinen höchsten Wert gezeigt. Da wir ein Anycast-BGP-Netzwerk verwalten, modelliert unser Radar die Verteilung des Datenverkehrs über das Netzwerk nach Änderung des Balancing-Modells. BGP ist ein Distanzvektorprotokoll und wir verstehen die Zustände gut, da der Distanzgraph nahezu statisch bleibt. Durch die Analyse dieser Entfernungen unter Berücksichtigung von LCP und Equal-Cost Multipath können wir AS_path von Punkt A nach Punkt B mit einem hohen Maß an Genauigkeit vorab auswerten.

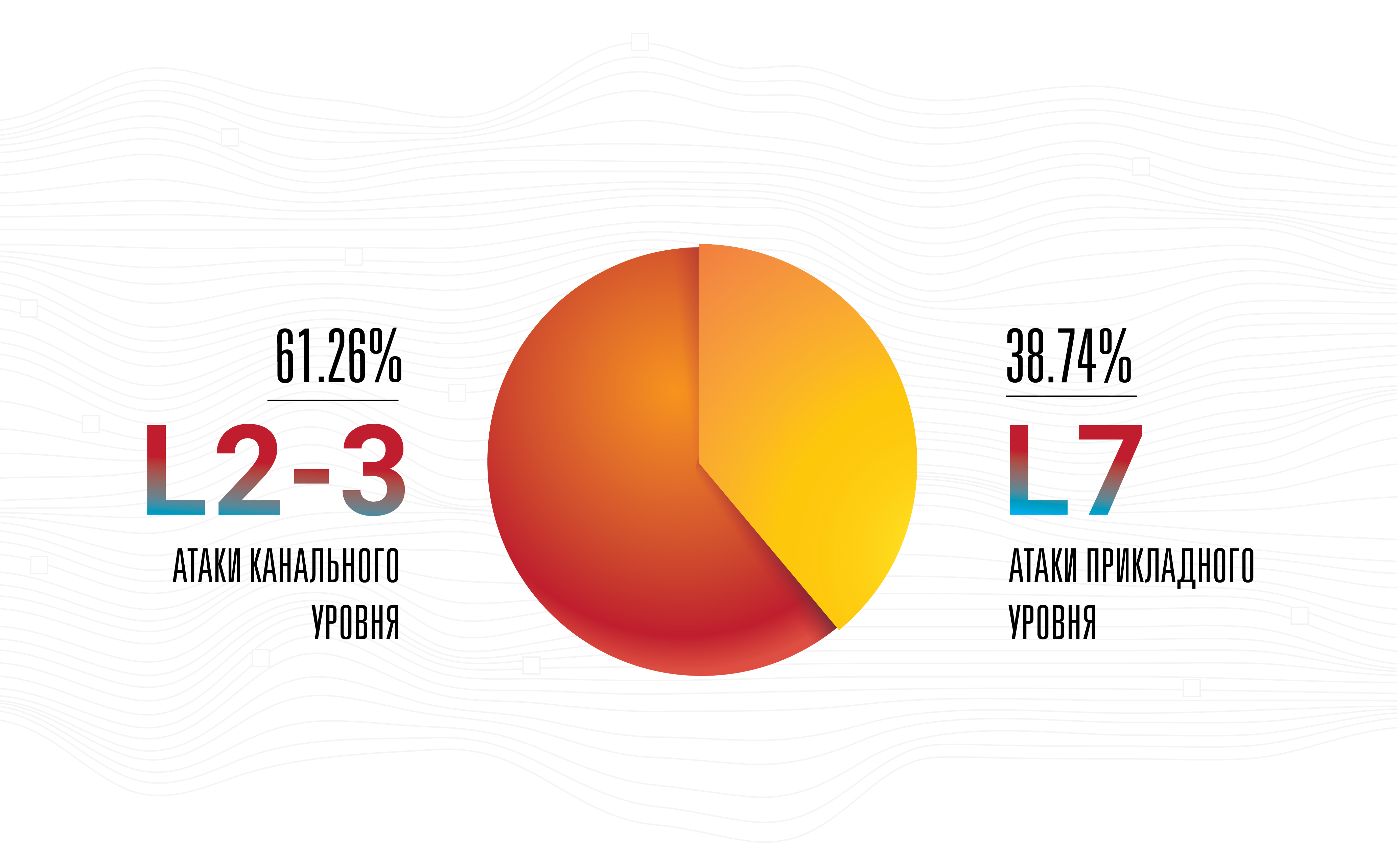

Dies bedeutet nicht, dass die Verstärkung die schwerwiegendste Bedrohung darstellt. Nein, Angriffe auf Anwendungsebene bleiben die erfolgreichste, unsichtbarste und effektivste, da die meisten von ihnen mit einer geringen Intensität des verwendeten Bandes ausgeführt werden.

Dies ist der Hauptgrund, warum unser Unternehmen die Verbindungen zu Betreibern an Präsenzpunkten kompromisslos verbessert und gleichzeitig deren Anzahl erhöht. Ein solcher Schritt ist derzeit für jeden Netzbetreiber logisch, vorausgesetzt, das Geschäft wächst. Wir glauben jedoch weiterhin, dass die meisten Angreifer zuerst ein Botnetz sammeln und erst danach aus der breitesten Liste verfügbarer Verstärker auswählen, die mit maximaler Nachladegeschwindigkeit von allen möglichen Waffen getroffen werden können. Solche Hybridangriffe finden schon lange statt, aber erst vor kurzem begann ihre Intensität sowohl hinsichtlich der Anzahl der Pakete pro Sekunde als auch der damit verbundenen Netzwerkbandbreite zuzunehmen.

Angriffe mit Intensitäten über 100 Gbit / s sind jetzt in der Statistik deutlich sichtbar - dies ist kein Rauschen mehr

Angriffe mit Intensitäten über 100 Gbit / s sind jetzt in der Statistik deutlich sichtbar - dies ist kein Rauschen mehrBotnets entwickelten sich 2018 erheblich und ihre Besitzer entwickelten eine neue Aktivität -

Clickfraud . Mit der Verbesserung der Technologien für maschinelles Lernen und dem Zugriff auf Headless-Browser, die ohne GUI funktionieren, ist Clickfraud in nur zwei Jahren viel einfacher und billiger geworden.

Heutzutage empfängt die durchschnittliche Website 50% bis 65% des Datenverkehrs von Mobilgeräten, ihren Browsern und Anwendungen. Bei einigen Netzwerkdiensten kann dieser Anteil bis zu 90% oder sogar 100% erreichen, während ausschließlich Desktop-Websites praktisch nicht mehr existieren, außer in Unternehmensumgebungen oder in Form hochspezialisierter Fälle.

Tatsächlich verschwanden Personal Computer bis 2019 vom Höhepunkt der Netzwerklandschaft, was einige erfolgreiche Techniken in der Vergangenheit, wie das Verfolgen der Position der Maus, zum Filtern des Datenverkehrs und zum Schutz vor Bots völlig außer Betrieb setzte. Tatsächlich sind nicht nur PCs, sondern auch die meisten Laptops und All-in-One-Boxen selten die Quelle eines erheblichen Anteils an Seitenbesuchen, während sie leicht zu einer Waffe werden. Zu einer Zeit reichte eine einfache Verweigerung des Zugriffs auf alles, was bis vor kurzem einen mobilen Browser falsch darstellte, völlig aus, um Angriffe von Botnetzen fast vollständig zu neutralisieren und den negativen Effekt für wichtige Geschäftsmetriken auf Null zu setzen.

Die Ersteller und Manager von Botnetzen sind bereits daran gewöhnt, Praktiken zu implementieren, die das Verhalten von echten Seitenbesuchern in ihrem eigenen Schadcode nachahmen, genau wie die Besitzer von Webseiten daran gewöhnt sind, dass Browser auf PCs wichtig sind. Beide sind modifiziert, während ersteres schneller ist als letzteres.

Wir haben bereits festgestellt, dass sich 2018 nichts geändert hat, aber der Fortschritt und die Änderungen selbst haben eine bedeutende Entwicklung erfahren. Eines der auffälligsten Beispiele ist das maschinelle Lernen, bei dem Verbesserungen und Fortschritte deutlich sichtbar wurden, insbesondere im Bereich der generativ-wettbewerbsorientierten Netzwerke. Langsam aber sicher erreicht ML den Massenmarkt. Maschinelles Lernen ist bereits ziemlich erschwinglich geworden und, wie die Grenze von 2018-2019 gezeigt hat, keine Branche mehr, die sich auf Akademiker beschränkt.

Obwohl wir das Auftreten der ersten ML-basierten DDoS-Angriffe Anfang 2019 erwartet haben, ist dies bisher nicht geschehen. Dies ändert jedoch nichts an unseren Erwartungen, sondern treibt sie nur an, insbesondere angesichts der sinkenden Kosten für die Verwaltung neuronaler Netze und der ständig steigenden Genauigkeit ihrer Analysen.

Wenn wir andererseits den aktuellen Stand der Branche der „automatisierten menschlichen Individuen“ betrachten, wird klar, dass die Implementierung eines neuronalen Netzwerks in diesem Design eine potenziell bahnbrechende Idee ist. Ein solches Netzwerk kann aus dem Verhalten realer Personen bei der Verwaltung von Webseiten lernen. So etwas wird als "Benutzererfahrung künstlicher Intelligenz" bezeichnet, und natürlich kann ein ähnliches Netzwerk, das mit einem Webbrowser ausgestattet ist, das Arsenal beider Seiten erweitern: Angreifen und Verteidigen.

Das Trainieren eines neuronalen Netzwerks ist ein teurer Prozess, aber das Verteilen und Auslagern eines solchen Systems kann billig, effizient und möglicherweise sogar kostenlos sein - für den Fall, dass bösartiger Code in gehackten Anwendungen, Erweiterungen und vielem mehr versteckt ist. Möglicherweise könnte eine solche Änderung die gesamte Branche auf die gleiche Weise verändern, wie generativ-wettbewerbsorientierte Netzwerke unser Verständnis von „visueller Realität“ und „Authentizität“ verändert haben.

Angesichts des anhaltenden Wettlaufs zwischen Suchmaschinen - vor allem Google und allen anderen, die versuchen, sie zurückzuentwickeln - können Dinge so weit gehen, dass sie fantastische Dinge wie die Nachahmung einer einzelnen, bestimmten Person durch einen Bot tun. In der Regel an einem anfälligen Computer sitzen. Die Versionen des Captcha- und ReCaptcha-Projekts können als Beispiel dafür dienen, wie schnell und stark die angreifende Seite ihre eigenen Angriffswerkzeuge und -techniken entwickelt und verbessert.

Nach dem Memcaching wurde viel über die Wahrscheinlichkeit (oder Unwahrscheinlichkeit) einer völlig neuen Klasse von Waffen für DDoS gesprochen - eine Sicherheitslücke, ein Bot, ein falsch konfigurierter Dienst oder etwas anderes, das endlos Daten für ein bestimmtes vom Angreifer ausgewähltes Ziel senden würde. Ein Befehl des Angreifers verursacht einen kontinuierlichen Verkehrsfluss, z. B. eine Flut oder das Senden von Syslog. Im Moment ist dies eine Theorie. Wir können immer noch nicht sagen, ob es solche Server oder Geräte gibt, aber wenn die Antwort auf diese Frage Ja lautet, wird es eine Unterschätzung der Situation sein, zu sagen, dass so etwas in bösen Händen zu einer unglaublich gefährlichen Waffe werden kann.

Im Jahr 2018 haben wir auch ein wachsendes Interesse von Staaten und gemeinnützigen Organisationen auf der ganzen Welt an der sogenannten „Internet Governance“ und den damit verbundenen Dienstleistungen festgestellt. Wir stehen einer solchen Entwicklung der Ereignisse neutral gegenüber, bis die Unterdrückung der grundlegenden bürgerlichen und individuellen Freiheiten beginnt, von denen wir hoffen, dass sie in den Industrieländern nicht eintreten.

Nach Jahren des Sammelns und Analysierens von Angriffsverkehr auf der ganzen Welt ist Qrator Labs schließlich bereit, das Blockieren bei der ersten Netzwerkanforderung zu implementieren. Die Modelle, mit denen wir böswilliges Verhalten vorhersagen, ermöglichen es uns, die Legitimität des Benutzers für jede bestimmte Seite genau zu bestimmen. Wir bestehen weiterhin auf unserer eigenen Philosophie der barrierefreien Anmeldung für den Benutzer und der untrennbaren Benutzererfahrung ohne JavaScript-Überprüfungen oder Captcha, die ab 2019 noch schneller funktionieren und ein Höchstmaß an Zugänglichkeit für geschützte Dienste bieten.

Die maximale Intensität des Angriffsbandes nimmt stetig zu.

Die maximale Intensität des Angriffsbandes nimmt stetig zu.Mellanox

Unser Unternehmen hat 100G Mellanox-Switches als Ergebnis interner Tests ausgewählt, die über mehrere Jahre durchgeführt wurden. Wir wählen immer noch die Ausrüstung aus, die unseren spezifischen Anforderungen unter bestimmten Bedingungen am besten entspricht. Beispielsweise sollte ein Switch kleine Pakete nicht mit einer Leitungsrate verwerfen - die maximale Geschwindigkeit, selbst eine minimale Verschlechterung, ist nicht akzeptabel. Darüber hinaus haben Mellanox-Schalter einen guten Preis. Dies ist jedoch noch nicht alles - die Fairness des Preises wird durch die Art und Weise bestätigt, wie ein bestimmter Anbieter auf Ihre Anfragen reagiert.

Mellanox-Switches laufen auf Switchdev, wodurch ihre Ports in einfache Schnittstellen unter Linux umgewandelt werden. Als Teil des Haupt-Linux-Kernels bietet Switchdev eine bequeme Möglichkeit, das Gerät mithilfe klarer und vertrauter Schnittstellen unter einer API zu verwalten, die jedem modernen Programmierer, Entwickler und Netzwerktechniker absolut vertraut ist. Jedes Programm, das die Standard-Linux-Netzwerk-API verwendet, kann auf einem Switch ausgeführt werden. Alle für Linux-Server erstellten Überwachungs- und Verwaltungsaktivitäten für Netzwerkaktivitäten, einschließlich möglicher proprietärer Lösungen, sind leicht zugänglich. Um die Änderungen zu veranschaulichen, die bei der aktiven Entwicklung von Switchdev aufgetreten sind, stellen wir fest, dass die Änderung von Routing-Tabellen mit Switchdev um ein Vielfaches schneller und bequemer geworden ist. Bis zur Ebene des Netzwerkchips ist der gesamte Code sichtbar und transparent, sodass Sie lernen und Änderungen vornehmen können, bis Sie wissen müssen, wie der Chip selbst aufgebaut ist oder zumindest die externe Schnittstelle dazu.

Das Mellanox-Gerät mit Switchdev erwies sich als die lang erwartete Kombination, auf die wir so lange gewartet haben, aber noch besser - das produzierende Unternehmen erfüllte alle Erwartungen und Anforderungen, nicht nur hinsichtlich der vollständigen Unterstützung eines sofort einsatzbereiten kostenlosen Betriebssystems.

Beim Testen des Geräts vor der Inbetriebnahme haben wir festgestellt, dass ein Teil des umgeleiteten Datenverkehrs verloren geht. Unsere Untersuchung ergab, dass dies auf die Tatsache zurückzuführen war, dass der Datenverkehr zu einer der Schnittstellen mit einem Steuerprozessor gesendet wurde, der das hohe Volumen nicht bewältigen konnte. Wir konnten die genaue Ursache für dieses Verhalten nicht ermitteln, schlugen jedoch vor, dass dies auf die Verarbeitung von ICMP-Weiterleitungen zurückzuführen ist. Mellanox bestätigte die Ursache des Problems, und deshalb haben wir darum gebeten, etwas mit diesem Verhalten des Geräts zu tun, worauf das Unternehmen sofort reagierte, indem es in kurzer Zeit eine funktionierende Lösung bereitstellte.

Großartige Arbeit, Mellanox!

Protokolle und Open Source

DNS-over-HTTPS ist eine umfassendere Technologie als DNS-over-TLS. Wir beobachten, wie der erste gedeiht, während der zweite langsam vergessen wird. Dieses Beispiel ist gut, da in diesem speziellen Fall „Komplexität“ „Effizienz“ bedeutet, da der DoH-Verkehr von keinem anderen HTTPS zu unterscheiden ist. Dasselbe haben wir bereits bei der RPKI-Datenintegration gesehen, die ursprünglich als Anti-Interception-Lösung positioniert war und infolgedessen nichts Gutes passiert ist. Nach einiger Zeit tauchte RPKI wieder als leistungsstarkes Tool gegen Anomalien wie Routenlecks und falsche Routing-Einstellungen auf. Und jetzt wurde das Rauschen in ein Signal umgewandelt, und RPKI wurde an den größten Verkehrsknotenpunkten unterstützt, was eine gute Nachricht ist.

Angekommen und TLS 1.3. Qrator Labs hat wie die gesamte IT-Branche den Prozess der Entwicklung eines neuen Verschlüsselungsstandards in jeder Phase genau überwacht, vom ersten Entwurf in der IETF bis zu einem verständlichen und verwaltbaren Protokoll, das wir ab 2019 unterstützen können. Der Markt reagierte ähnlich und versprach die schnellste Implementierung eines vertrauenswürdigen Sicherheitsprotokolls. Es ist möglich, dass sich nicht alle Hersteller von DDoS-Neutralisierungslösungen gleich schnell an die veränderte Realität anpassen können, da es aufgrund der technischen Komplexität der Protokollunterstützung zu erklärbaren Verzögerungen bei der Hardware kommen kann.

Wir verfolgen auch die Weiterentwicklung von HTTP / 2. Im Moment unterstützen wir die neue Version des HTTP-Protokolls nicht, hauptsächlich wegen der Unvollkommenheit der aktuellen Codebasis. Fehler und Schwachstellen werden immer noch zu oft in neuem Code gefunden. Als Anbieter von Sicherheitslösungen sind wir noch nicht bereit, dieses Protokoll im Rahmen des SLA zu unterstützen, mit dem unsere Verbraucher einverstanden waren.

Im Jahr 2018 stellten wir uns oft die Frage: „Warum wollen die Leute so viel HTTP / 2?“, Was die Ursache für zahlreiche heftige Debatten war. Die Menschen neigen immer noch dazu, Dinge mit dem Präfix „2“ als „bessere“ Versionen von allem zu betrachten, was insbesondere bei einigen Aspekten der Implementierung dieses Protokolls der Fall ist. Dennoch empfiehlt DoH die Verwendung von HTTP / 2, und es ist durchaus möglich, dass aus dieser Synergie ein hohes Maß an Marktakzeptanz beider Protokolle hervorgeht.

Eine der Sorgen bei der Betrachtung der Entwicklung von Protokollen der nächsten Generation und ihrer geplanten Fähigkeiten ist die Tatsache, dass die Entwicklungen sehr oft nicht über das rein akademische Niveau hinausgehen, ganz zu schweigen von der Berücksichtigung der extremen Fälle von Protokollerstellern wie der Neutralisierung von DDoS-Angriffen. Vielleicht ist dies der Grund, warum Unternehmen, die sich mit Cyber- und Informationssicherheit befassen, wenig Anstrengungen unternehmen, um solche Standards zu entwickeln.

Abschnitt 4.4 des IETF-Entwurfs mit dem Titel „QUIC-Verwaltbarkeit“, der Teil des zukünftigen QUIC-Protokollpakets ist, ist lediglich ein ideales Beispiel für diesen Ansatz: Es heißt, dass „die derzeitigen Praktiken zur Erkennung und Neutralisierung von [DDoS-Angriffen] hauptsächlich passive Messungen beinhalten Netzwerkschichtdaten. " Letzteres wird in der Praxis äußerst selten eingesetzt, außer vielleicht für die Netze von Internetanbietern, und ist in der Praxis kaum ein „häufiger Fall“. In akademischen Forschungsarbeiten werden jedoch auf diese Weise „allgemeine Fälle“ gebildet, aufgrund derer die endgültigen Protokollstandards in der Produktion einfach nicht anwendbar sind, nachdem sie vor der Inbetriebnahme so einfache Manipulationen wie das Testen unter Last und das Simulieren von Angriffen auf Anwendungsebene auf die Anwendung durchgeführt haben mit. Angesichts des laufenden Prozesses der Einführung von TLS in die globale Internetinfrastruktur wird die Behauptung einer passiven Überwachung im Allgemeinen ernsthaft in Frage gestellt. Der Aufbau einer korrekten akademischen Forschung ist ein weiterer Test für Anbieter von Sicherheitslösungen im Jahr 2019.

Gleichzeitig hat Switchdev die vor einem Jahr festgelegten Erwartungen voll erfüllt. Wir hoffen, dass die fortgesetzte Arbeit an Switchdev die Community und die gemeinsamen Früchte der Arbeit in naher Zukunft zu hervorragenden Ergebnissen führen wird.

Die Weiterentwicklung und Implementierung von Linux XDP wird der Branche helfen, eine hohe Effizienz bei der Verarbeitung von Netzwerkpaketen zu erzielen. Der Versand einiger Filtermuster für illegitimen Verkehr vom Zentralprozessor zum Netzwerkprozessor und in einigen Fällen sogar zum Switch sieht bereits vielversprechend aus, und unser Unternehmen setzt seine eigene Forschung und Entwicklung in diesem Bereich fort.

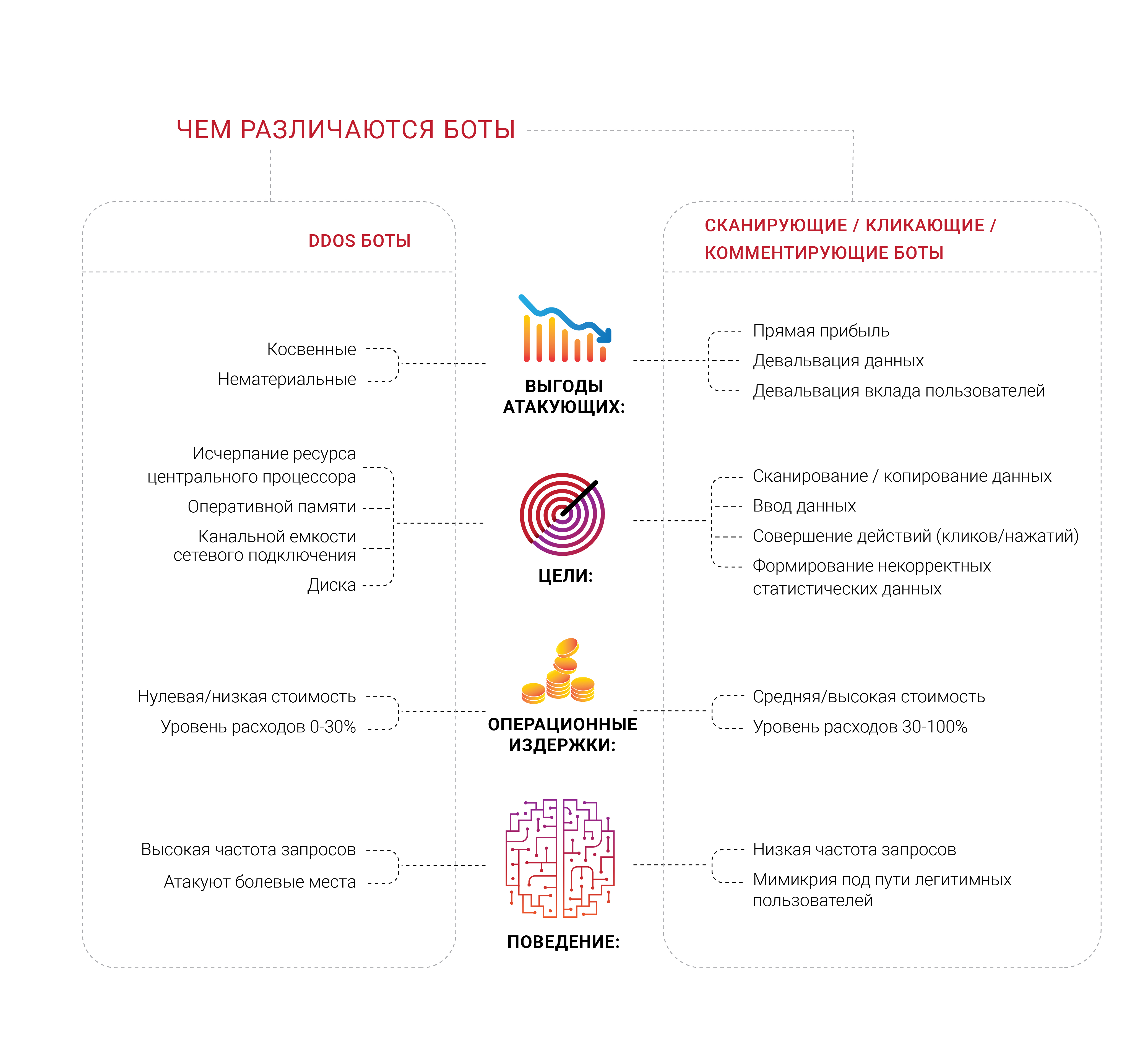

Tief tauchen mit Bots

Viele Unternehmen suchen Schutz vor Bots, und es überrascht nicht, dass wir 2018 eine große Anzahl unterschiedlicher Gruppen von Fachleuten gesehen haben, die an verschiedenen Bereichen dieses Problems gearbeitet haben. Was uns besonders interessant erscheint, ist, dass die meisten Unternehmen, die eine solche Nachfrage generieren, noch nie einen zumindest typischen gezielten DDoS-Angriff erlebt haben, der darauf abzielt, endliche Ressourcen wie Speicher, einen Prozessor oder einen Netzwerkverbindungskanal zu erschöpfen. Sie haben Angst vor Bots, können sie jedoch nicht von legitimen Benutzern unterscheiden oder bestimmen, was genau sie tun. Die meisten Quellen solcher Appelle wollen das Gefühl loswerden, dass nicht lebende Menschen auf ihre Seiten kommen.

Das Problem der Bot-Scanner und vieler anderer Unterarten ist eine sehr wichtige wirtschaftliche Komponente. Wenn 30% des Verkehrs unzulässig sind und aus unerwünschten Quellen stammen, werden 30% der Kosten für die Unterstützung dieses Verkehrs gemäß der Kostenlogik in den Papierkorb geworfen. Heute kann man dies als unvermeidliche „Internetsteuer“ für Unternehmen betrachten. Es ist fast unmöglich, diese Zahl auf Null zu reduzieren, aber Unternehmer möchten diesen Prozentsatz so niedrig wie möglich halten.

Die Identifizierung wird im modernen Internet zu einem äußerst ernsten Problem und einer Herausforderung, da die fortschrittlichsten Bots nicht einmal versuchen, eine Person darzustellen - sie kontrollieren sie und befinden sich auf ähnliche Weise wie Parasiten im selben Raum wie sie. Wir haben lange wiederholt, dass alle Informationen, die ohne Authentifizierung und Autorisierung öffentlich verfügbar sind, vorhanden sind und letztendlich in Form von Public Domain enden werden - niemand kann dies verhindern.

In Anbetracht dieses Problems haben wir uns auf Fragen der Identifizierung und Verwaltung von Bots konzentriert. Unserer Meinung nach ist ein breites Spektrum an Arbeiten jedoch viel interessanter - wir leben in einer Zeit, in der es bereits unmöglich ist herauszufinden, warum ein bestimmter Client etwas vom Server anfordert. Sie lesen alles richtig - am Ende möchte jedes Unternehmen wissen, dass der Verbraucher zum Kauf gekommen ist, denn dies ist das Ziel seines Geschäfts und seiner Existenz. Daher möchten einige Unternehmen genau untersuchen, wer und was von ihren Servern angefordert wird. Steht eine echte Person hinter der Anforderung?Es ist am Ende nicht verwunderlich, dass Geschäftsinhaber häufig feststellen, dass ein erheblicher Teil des Datenverkehrs auf ihrer Website von Robotern und nicht von Käufern generiert wird.Automatisierte Menschen, die wir bereits in einem anderen Kontext erwähnt haben, können auf viel spezifischere Netzwerkressourcen abzielen, indem sie Dinge verwenden, die kaum wahrnehmbar sind, wie z. B. Browsererweiterungen. Wir wissen bereits, dass so viele Erweiterungen, die schwer als "bösartig" zu bezeichnen sind, nur zum Sammeln und Analysieren des Verhaltens eines echten Benutzers existieren. Aber es gibt ganz andere Dinge - wo die Automatisierung den vorgelagerten Zaun nicht passieren kann, erscheinen Leute mit Browser-Modifikationen und führen dieselben einfachen Aktionen aus, die für die Organisatoren vielleicht nur ein wenig teurer sind. Darüber hinaus werden eine Reihe von Aufgaben, wie das Bearbeiten von Werbung und Klickbetrug, mit einer realen Person vor dem Bildschirm wesentlich effizienter ausgeführt. Stellen Sie sich vor, was passieren könnteWenn jemand einen guten Weg findet, es durch maschinelles Lernen zu stärken, im richtigen Teil der Kette.Parser und Scanner, die Teil des umfassenderen Bot-Problems sind, kamen erst 2018 an unseren Horizont und vor allem dank unserer Verbraucher, die uns über ihre eigenen Erfahrungen informierten und die Möglichkeit boten, die Vorgänge in ihren Netzwerkressourcen genauer zu untersuchen und zu analysieren. Solche Bots sind möglicherweise nicht einmal auf der Ebene der Standardmetriken sichtbar, z. B. der durchschnittlich verwendeten Netzwerkbandbreite oder der CPU-Auslastung des Servers. Derzeit testet Qrator Labs verschiedene Ansätze, aber eines ist klar: Unsere Kunden möchten, dass böswillige Bots ihrer Meinung nach bei der ersten Anfrage an den Server blockiert werden.Während der Parsing-Epidemie, die wir in Russland und der GUS in der zweiten Jahreshälfte 2018 beobachteten, wurde deutlich, dass die Bots in Bezug auf Verschlüsselungsprobleme einen langen Weg zurückgelegt hatten. Eine Anfrage pro Minute ist eine ganz normale Intensität für den Bot, die sehr schwer zu bemerken ist, ohne Anfragen und ausgehenden Antwortverkehr zu analysieren. Nach unserer bescheidenen Meinung hat nur der Verbraucher das Recht, nach Analyse und Kennzeichnung des Datenverkehrs zu entscheiden, was mit einer unerwünschten Quelle von Anfragen geschehen soll. Blockieren, überspringen oder betrügen - wir können uns nicht entscheiden. Rein automatische Lösungen, oder wie wir sie als "Bots" bezeichnen, haben jedoch gewisse Schwierigkeiten bei der Interaktion. Wenn Sie sicher sind, dass es der Bot war, der die unerwünschte und ganz bestimmte Anfrage generiert hat, möchten die meisten Leute sie zuerst blockieren, ohne vom Server zu antworten. Wir sind jedoch zu dem Schluss gekommen, dass ein solcher Ansatz bedeutungslos ist, da er sowohl dem Bot als auch seinem Schöpfer zu viel Feedback gibt und Sie dazu ermutigt, nach einer Problemumgehung zu suchen. Wenn Bots nicht versuchen, den Dienst außer Betrieb zu setzen, raten wir Ihnen im Allgemeinen, diesen Ansatz nicht zu predigen. Aufgrund des Katz- und Mausspiels wird ein vernünftig entschlossener Angreifer fast immer um Sie herumgehen, um ein Ziel zu verfolgen, was auch immer es sein mag.Dies ist der Grund, warum Qrator Labs den Ansatz der Kennzeichnung von Malware sowie des gesamten Datenverkehrs im Allgemeinen gewählt hat, um dem Anwendungsinhaber maximale Daten und Möglichkeiten für eine fundierte Entscheidung unter Berücksichtigung der möglichen Konsequenzen für Benutzer und Geschäftsziele zu bieten. Ein gutes Beispiel für die möglichen Folgen sind Werbeblocker. Der Großteil der modernen Werbung im Internet wird in Form von Skripten präsentiert, die blockieren, wobei Sie die Werbung absolut nicht unbedingt blockieren, und nicht beispielsweise die Javascript-Überprüfung des DDoS-Schutzdienstes. Es ist leicht vorstellbar, wohin dieser Weg führen kann, was letztendlich zu einem Rückgang der Gewinne des Internetgeschäfts führt.Wenn die Angreifer blockiert sind und das benötigte Feedback erhalten wird, hindert sie nichts daran, sich anzupassen, zu lernen und erneut anzugreifen. Unsere Technologien basieren auf einer einfachen Philosophie, dass es nicht erforderlich ist, Robotern Feedback zu geben - Sie müssen sie entweder blockieren oder überspringen, sondern sie einfach erkennen und markieren. Nachdem eine solche Kennzeichnung vorgenommen wurde und wir uns ihrer Richtigkeit sicher sind, ist es richtig, die folgende Frage zu stellen: "Was brauchen sie?" und "Warum interessieren sie sich dafür?" Vielleicht reicht es aus, den Inhalt der Webseite nur geringfügig zu ändern, damit keine lebende Person den Unterschied spüren kann, aber die Realität des Bots wird sich auf den Kopf stellen? Wenn es sich um Parser handelt, ist es möglich, dass sich ein bestimmter Prozentsatz der Daten als falsch und falsch herausstellt. In jedem Fall wird jedoch der Schutz von der Suche nach binären Nullen oder Einsen entfernt und etwas angegebenWas wirklich gebraucht wird, ist Zeit.Wir haben dieses Problem im Laufe des Jahres 2018 erörtert und Angriffe genannt, die denen ähneln, die als Angriffe auf Geschäftsmetriken bezeichnet werden. Die Website, die Anwendung und der Server können einwandfrei funktionieren, und kein Benutzer wird sich beschweren, aber Sie spüren immer noch etwas ... wie einen Rückgang der CPA durch Werbung, die Sie auf der programmatischen Plattform platzieren und die Werbetreibenden dazu drängen. nicht einmal deine Konkurrenten.Das Reduzieren der Belohnung eines Angreifers ist der einzige Weg, dem entgegenzuwirken. Der Versuch, die Bots zu stoppen, bringt nur Zeit und Geld. Wenn irgendetwas auf das klickt, was Sie profitiert, brechen Sie diese Klicks ab. Wenn Sie analysiert werden, können Sie eine Schicht "gefälschter" Informationen einfügen, durch die ein gewöhnlicher, neugieriger Benutzer leicht nach korrekten und zuverlässigen Informationen suchen kann.

Rein automatische Lösungen, oder wie wir sie als "Bots" bezeichnen, haben jedoch gewisse Schwierigkeiten bei der Interaktion. Wenn Sie sicher sind, dass es der Bot war, der die unerwünschte und ganz bestimmte Anfrage generiert hat, möchten die meisten Leute sie zuerst blockieren, ohne vom Server zu antworten. Wir sind jedoch zu dem Schluss gekommen, dass ein solcher Ansatz bedeutungslos ist, da er sowohl dem Bot als auch seinem Schöpfer zu viel Feedback gibt und Sie dazu ermutigt, nach einer Problemumgehung zu suchen. Wenn Bots nicht versuchen, den Dienst außer Betrieb zu setzen, raten wir Ihnen im Allgemeinen, diesen Ansatz nicht zu predigen. Aufgrund des Katz- und Mausspiels wird ein vernünftig entschlossener Angreifer fast immer um Sie herumgehen, um ein Ziel zu verfolgen, was auch immer es sein mag.Dies ist der Grund, warum Qrator Labs den Ansatz der Kennzeichnung von Malware sowie des gesamten Datenverkehrs im Allgemeinen gewählt hat, um dem Anwendungsinhaber maximale Daten und Möglichkeiten für eine fundierte Entscheidung unter Berücksichtigung der möglichen Konsequenzen für Benutzer und Geschäftsziele zu bieten. Ein gutes Beispiel für die möglichen Folgen sind Werbeblocker. Der Großteil der modernen Werbung im Internet wird in Form von Skripten präsentiert, die blockieren, wobei Sie die Werbung absolut nicht unbedingt blockieren, und nicht beispielsweise die Javascript-Überprüfung des DDoS-Schutzdienstes. Es ist leicht vorstellbar, wohin dieser Weg führen kann, was letztendlich zu einem Rückgang der Gewinne des Internetgeschäfts führt.Wenn die Angreifer blockiert sind und das benötigte Feedback erhalten wird, hindert sie nichts daran, sich anzupassen, zu lernen und erneut anzugreifen. Unsere Technologien basieren auf einer einfachen Philosophie, dass es nicht erforderlich ist, Robotern Feedback zu geben - Sie müssen sie entweder blockieren oder überspringen, sondern sie einfach erkennen und markieren. Nachdem eine solche Kennzeichnung vorgenommen wurde und wir uns ihrer Richtigkeit sicher sind, ist es richtig, die folgende Frage zu stellen: "Was brauchen sie?" und "Warum interessieren sie sich dafür?" Vielleicht reicht es aus, den Inhalt der Webseite nur geringfügig zu ändern, damit keine lebende Person den Unterschied spüren kann, aber die Realität des Bots wird sich auf den Kopf stellen? Wenn es sich um Parser handelt, ist es möglich, dass sich ein bestimmter Prozentsatz der Daten als falsch und falsch herausstellt. In jedem Fall wird jedoch der Schutz von der Suche nach binären Nullen oder Einsen entfernt und etwas angegebenWas wirklich gebraucht wird, ist Zeit.Wir haben dieses Problem im Laufe des Jahres 2018 erörtert und Angriffe genannt, die denen ähneln, die als Angriffe auf Geschäftsmetriken bezeichnet werden. Die Website, die Anwendung und der Server können einwandfrei funktionieren, und kein Benutzer wird sich beschweren, aber Sie spüren immer noch etwas ... wie einen Rückgang der CPA durch Werbung, die Sie auf der programmatischen Plattform platzieren und die Werbetreibenden dazu drängen. nicht einmal deine Konkurrenten.Das Reduzieren der Belohnung eines Angreifers ist der einzige Weg, dem entgegenzuwirken. Der Versuch, die Bots zu stoppen, bringt nur Zeit und Geld. Wenn irgendetwas auf das klickt, was Sie profitiert, brechen Sie diese Klicks ab. Wenn Sie analysiert werden, können Sie eine Schicht "gefälschter" Informationen einfügen, durch die ein gewöhnlicher, neugieriger Benutzer leicht nach korrekten und zuverlässigen Informationen suchen kann.Clickhouse

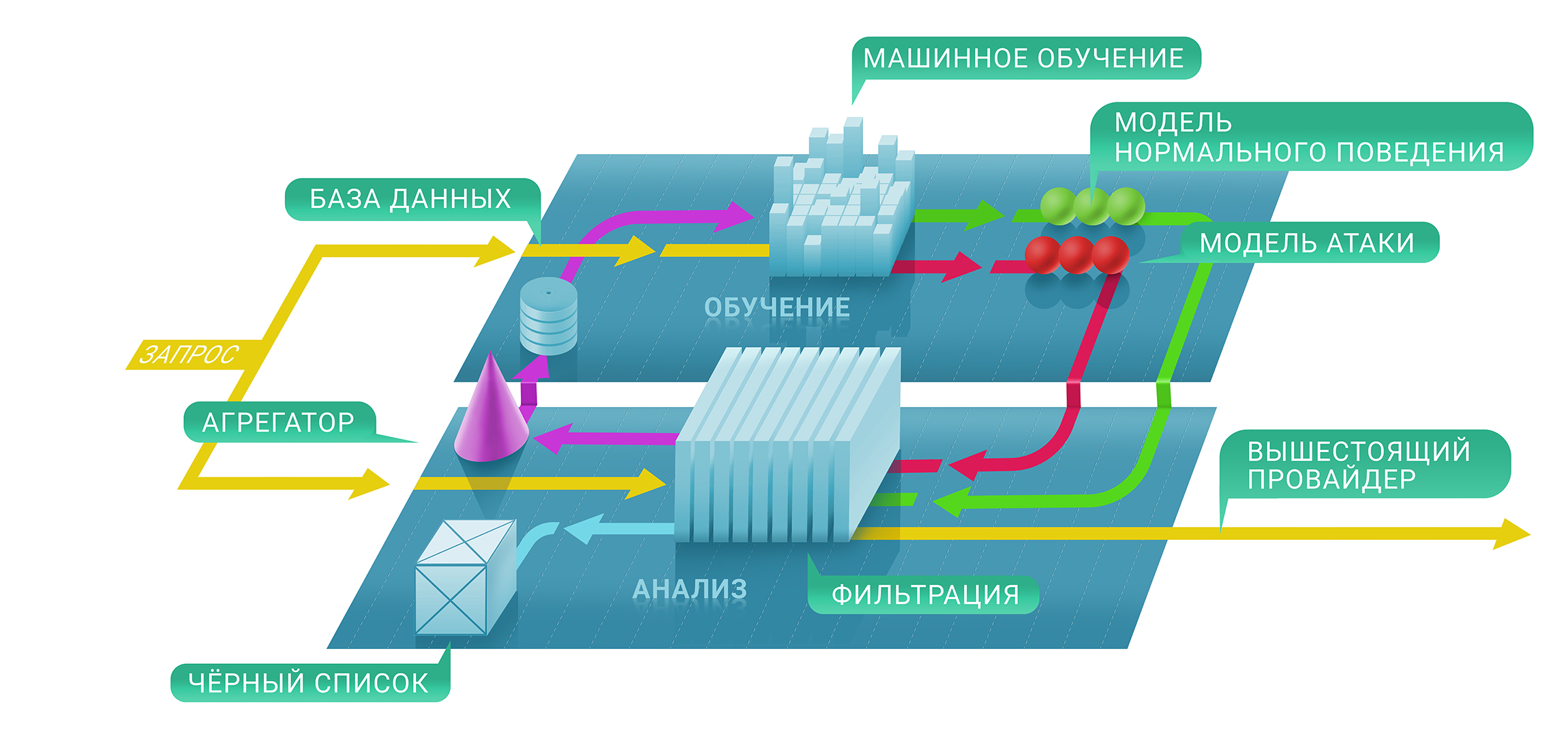

Auf hoher Ebene besteht der Qrator-Filterdienst aus zwei Ebenen: Auf der ersten Ebene wird anhand von Überprüfungen mit und ohne Status sofort bewertet, ob eine bestimmte Anforderung böswillig ist, und auf der zweiten Ebene wird entschieden, ob und wie lange die Quelle auf der schwarzen Liste bleibt . Die resultierende Blacklist kann als eindeutige Tabelle mit IP-Adressen dargestellt werden.In der ersten Phase dieses Prozesses verwenden wir Techniken des maschinellen Lernens, um die natürlichen Ebenen und Merkmale des Datenverkehrs für jede Ressource einzeln besser zu verstehen, da jeder Schutzparameter jedes einzelnen Dienstes basierend auf den von uns erfassten Metriken individuell konfiguriert wird.Hier kommt Clickhouse ins Spiel. Um besser zu verstehen, warum die Kommunikation einer bestimmten IP-Adresse mit der Ressource blockiert wurde, müssen wir den gesamten Weg des maschinellen Lernens bis zur Clickhouse-Datenbank verfolgen. Es funktioniert sehr schnell mit großen Datenmengen (stellen Sie sich einen DDoS-Angriff mit 500 Gbit / s vor und dauert mehrere Stunden reine Zeit außerhalb von Pausen) und speichert sie in einer praktischen Form für das in Qrator Labs verwendete Framework für maschinelles Lernen. Mehr Protokolle und mehr gespeicherter Datenverkehr bei DDoS-Angriffen führen zu genauen Ergebnissen unserer Modelle, mit deren Hilfe der Filterdienst unter den schwerwiegendsten Angriffen in Echtzeit optimiert werden kann.Wir verwenden Clickhouse DB, um alle Protokolle des illegitimen Angriffsverkehrs und der Bot-Verhaltensmuster zu speichern. Diese spezielle Lösung wurde von uns aufgrund des hohen Potenzials ausgewählt, massive Datensätze im Stil einer klassischen Datenbank für die spätere Verarbeitung zu speichern. Die Analyse dieser Daten wird auch verwendet, um Muster von DDoS-Angriffen zu erstellen, die dem maschinellen Lernen helfen, unsere Verkehrsfilterungsalgorithmen ständig zu verbessern.Ein wesentlicher Vorteil von Clickhouse im Vergleich zu anderen Datenbanken besteht darin, dass nicht eine gesamte Zeichenfolgendatenvariable gelesen werden muss. Es kann ein viel kleineres, unbedingt erforderliches Segment erforderlich sein, wenn Sie alles gemäß den Empfehlungen speichern. Und es funktioniert schnell!

Auf hoher Ebene besteht der Qrator-Filterdienst aus zwei Ebenen: Auf der ersten Ebene wird anhand von Überprüfungen mit und ohne Status sofort bewertet, ob eine bestimmte Anforderung böswillig ist, und auf der zweiten Ebene wird entschieden, ob und wie lange die Quelle auf der schwarzen Liste bleibt . Die resultierende Blacklist kann als eindeutige Tabelle mit IP-Adressen dargestellt werden.In der ersten Phase dieses Prozesses verwenden wir Techniken des maschinellen Lernens, um die natürlichen Ebenen und Merkmale des Datenverkehrs für jede Ressource einzeln besser zu verstehen, da jeder Schutzparameter jedes einzelnen Dienstes basierend auf den von uns erfassten Metriken individuell konfiguriert wird.Hier kommt Clickhouse ins Spiel. Um besser zu verstehen, warum die Kommunikation einer bestimmten IP-Adresse mit der Ressource blockiert wurde, müssen wir den gesamten Weg des maschinellen Lernens bis zur Clickhouse-Datenbank verfolgen. Es funktioniert sehr schnell mit großen Datenmengen (stellen Sie sich einen DDoS-Angriff mit 500 Gbit / s vor und dauert mehrere Stunden reine Zeit außerhalb von Pausen) und speichert sie in einer praktischen Form für das in Qrator Labs verwendete Framework für maschinelles Lernen. Mehr Protokolle und mehr gespeicherter Datenverkehr bei DDoS-Angriffen führen zu genauen Ergebnissen unserer Modelle, mit deren Hilfe der Filterdienst unter den schwerwiegendsten Angriffen in Echtzeit optimiert werden kann.Wir verwenden Clickhouse DB, um alle Protokolle des illegitimen Angriffsverkehrs und der Bot-Verhaltensmuster zu speichern. Diese spezielle Lösung wurde von uns aufgrund des hohen Potenzials ausgewählt, massive Datensätze im Stil einer klassischen Datenbank für die spätere Verarbeitung zu speichern. Die Analyse dieser Daten wird auch verwendet, um Muster von DDoS-Angriffen zu erstellen, die dem maschinellen Lernen helfen, unsere Verkehrsfilterungsalgorithmen ständig zu verbessern.Ein wesentlicher Vorteil von Clickhouse im Vergleich zu anderen Datenbanken besteht darin, dass nicht eine gesamte Zeichenfolgendatenvariable gelesen werden muss. Es kann ein viel kleineres, unbedingt erforderliches Segment erforderlich sein, wenn Sie alles gemäß den Empfehlungen speichern. Und es funktioniert schnell!Fazit

Seit langer Zeit leben wir in einer Welt von Multifaktor-Angriffen, die die Angriffsfähigkeiten mehrerer Protokolle gleichzeitig nutzen, um das Ziel aus einem gesunden Zustand zu bringen.

Digitale Hygiene und relevante Sicherheitsmaßnahmen sollten und werden in der Tat etwa 99% der bestehenden Risiken abdecken, denen ein normaler Benutzer ausgesetzt sein kann, außer vielleicht bei hochspezialisierten Angriffen auf bestimmte Ziele.

Andererseits gibt es im modernen Internet Haie, die die Verfügbarkeit ganzer Staaten beeinträchtigen können. Dies gilt nicht für BGP, bei dem es möglich ist, nur einige Punkte auf einer Karte auszuzahlen, die ein Angreifer zeichnen möchte.

Der Wissensstand zur Netzwerksicherheit wächst weiter. Wenn Sie sich jedoch die Anzahl der Verstärker in den Netzwerken ansehen oder nach der Möglichkeit gefälschter Anforderungen suchen, sinkt die Anzahl der anfälligen Dienste und Server nicht. Die tägliche Rate, mit der junge Menschen Kenntnisse über Programmier- und Computernetzwerkmanagementfähigkeiten erwerben, entspricht nicht der Zeit, die erforderlich ist, um relevante Erfahrungen im wirklichen Leben zu sammeln. Das Vertrauen, dass neue Schwachstellen bei neuen Produkten nicht auftreten, dauert lange und vor allem - es tut weh.

Eine der überraschendsten Entdeckungen des vergangenen Jahres war, dass die meisten Menschen von neuen Technologien deutlich mehr erwarten, als sie bieten können. Dies war nicht immer der Fall, aber im Moment beobachten wir eine wachsende Tendenz, dass Menschen unabhängig von den Fähigkeiten von Software und insbesondere Hardware „mehr verlangen“. Dies führt uns in eine Welt ziemlich perverser Marketingkampagnen. Trotzdem „kaufen“ die Menschen weiterhin Versprechen und die Unternehmen fühlen sich verpflichtet, diese zu erfüllen.

Vielleicht ist dies die Essenz von Fortschritt und Evolution. Jetzt sind viele verärgert darüber, dass es keine „Garantie“ gibt und dass die Mittel dafür bezahlt wurden. Aufgrund der Unmöglichkeit, ein Gerät „vollständig“ vom Hersteller zu kaufen, nehmen viele der heutigen Probleme zu, aber die Kosten für „kostenlose“ Dienste können sich als fabelhaft herausstellen, wenn Sie die kumulierten Kosten für Daten berücksichtigen, die von einem Benutzer von einem großen sozialen Netzwerk empfangen werden, für das keine Zahlung erforderlich ist.

Der Konsumismus sagt uns, dass wir, wenn wir wirklich etwas wollen, letztendlich mit unserem eigenen Leben bezahlen werden. Brauchen wir wirklich ähnliche Produkte und Dienstleistungen, die sich nur verbessern, um uns „verbesserte Angebote“ anzubieten, die auf den Daten basieren, die wir über uns gesammelt haben, ob es uns gefällt oder nicht? Dies scheint jedoch die nahe Zukunft zu sein, wie wir kürzlich mit Equifax und Cambridge Analytica gezeigt haben. Es ist nicht verwunderlich, wenn vor uns ein „Urknall“ der Verwendung persönlicher und anderer Daten liegt, die sich auf das individuelle Leben eines jeden beziehen.

Nach zehnjähriger Arbeit haben wir die wichtigsten Grundlagen zur Architektur des Internets nicht geändert. Dies ist der Grund, warum wir das BGP-Anycast-Filternetzwerk mit der Fähigkeit weiterentwickeln, verschlüsselten Datenverkehr in dieser Form zu verarbeiten, um Captcha und andere Hindernisse zu vermeiden, die für einen legitimen Benutzer unerwartet sind.

Wenn wir beobachten, was Experten auf dem Gebiet der Cybersicherheit sowie Unternehmen auf diesem Gebiet weiterhin widerfahren, möchten wir noch einmal das Offensichtliche wiederholen: Ein naiver, einfacher und schneller Ansatz ist nicht anwendbar.

Daher verfügt Qrator Labs nicht über Hunderte oder sogar Dutzende von Präsenzpunkten, die mit CDNs vergleichbar sind. Durch die Verwaltung weniger Filterzentren, von denen jedes mit Internetdienstanbietern einer Klasse verbunden ist, die nicht niedriger als Tier-1 ist, erreichen wir eine echte Dezentralisierung. Aus dem gleichen Grund versuchen wir nicht, eine eigene Firewall zu erstellen, die eine völlig andere Aufgabe hat als die, an der wir arbeiten - die Konnektivität.

Im Laufe der Jahre sagten wir, dass am Ende weder die Überprüfung von Captcha noch von Javascript funktionieren wird, und hier sind wir im Jahr 2019, als die neuronalen Netze bei der Lösung der ersteren hochwirksam wurden und die letzteren für den Angreifer mit dem Gehirn nie ein Problem darstellten.

Ich möchte noch eine interessante Änderung an der Zeitgrenze erwähnen: DDoS-Angriffe waren lange Zeit nur für eine begrenzte Anzahl von Geschäftsbereichen ein ernstes Problem, normalerweise für diejenigen, in denen Geld an der Oberfläche schwankt: E-Commerce, Handel und Tausch, Bank- und Zahlungssysteme. Mit der Weiterentwicklung des Internets sehen wir jedoch DDoS-Angriffe mit erhöhter Intensität und Häufigkeit in absolut allen Teilen des Internets. Die DDoS-Ära begann mit einem bestimmten Schwellenwert für die Bandbreite von Heimroutern, und es ist nicht verwunderlich, dass sich mit dem Aufkommen eines Mikrochips in allen physischen Dingen der Angriffslandschaft ein rascher Wandel vollzog.

Wer das Ende der Entwicklung dieses Trends erwartet, liegt höchstwahrscheinlich falsch. So wie wir uns irren, so viele Vorhersagen geschrieben zu haben. Niemand kann mit Sicherheit sagen, wie genau sich das Internet in den kommenden Jahren entwickeln und seinen eigenen Einfluss verbreiten wird. Wenn wir jedoch auf das zurückblicken, was wir gesehen haben, ist eines klar: Alles wird sich vervielfachen. Im Jahr 2020 sollte die Anzahl der an das Netzwerk angeschlossenen Geräte 30 Milliarden überschreiten, ganz zu schweigen von der einfachen Tatsache, dass Roboter seit langem viel mehr Verkehr erzeugen als Menschen. Sehr bald werden wir entscheiden müssen, was mit all dieser „Intelligenz“ geschehen soll, ob künstlich oder nicht, da wir immer noch in einer Welt existieren, in der das menschliche Individuum für seine Handlungen verantwortlich ist, richtig oder falsch.

2018 war ein Jahr der Chance für die dunkle Seite. Wir haben eine Zunahme von Angriffen festgestellt, während sie gleichzeitig kompliziert wurden und sowohl das Netzwerkvolumen als auch die Häufigkeit erhöht wurden. Die Bösewichte bekamen mächtige Werkzeuge und verbrachten viel Zeit damit, sie zu studieren, während die Guten nichts weiter taten, als ihre Fortschritte zu beobachten. Wir hoffen aufrichtig, dass sich in diesem Jahr zumindest an den schmerzhaftesten Stellen etwas ändert.

→

Link zur Vollversion des Berichts in russischer Sprache.