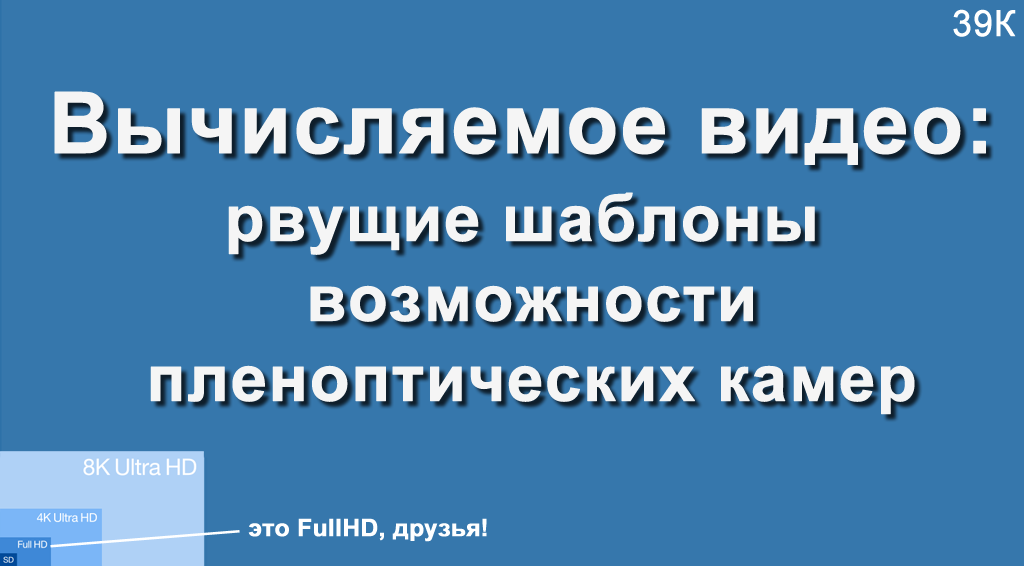

Vor einiger Zeit hatte der Autor die Gelegenheit, einen Vortrag bei VGIK zu halten, und es waren viele Leute aus dem Kamerahaus im Publikum. Das Publikum wurde gefragt: „Mit welcher maximalen Auflösung haben Sie geschossen?“, Und es stellte sich heraus, dass etwa eine dritte Aufnahme 4K oder 8 Megapixel, der Rest - nicht mehr als 2K oder 2 Megapixel. Es war eine Herausforderung! Ich musste über die Kamera mit einer Auflösung von 755 Megapixeln (Rohauflösung, um genau zu sein, da sie eine endgültige 4K hat) und welche bezaubernden Möglichkeiten dies für professionelle Aufnahmen bietet, erzählen.

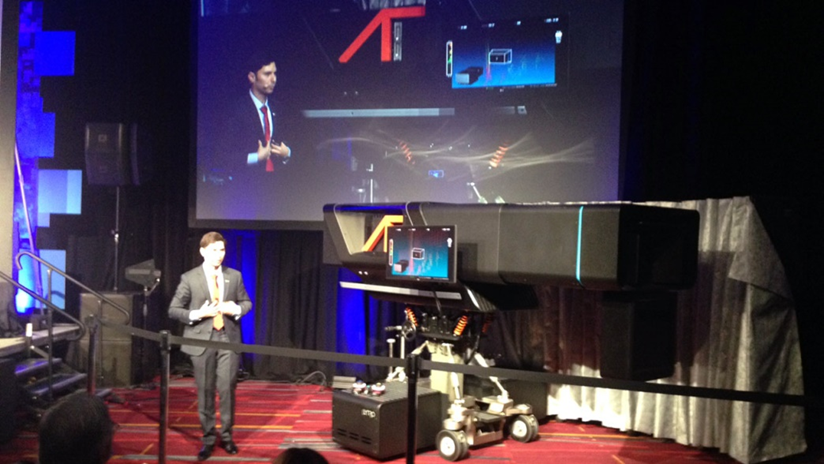

Die Kamera selbst sieht so aus (eine Art kleiner Elefant):

Außerdem werde ich ein schreckliches Geheimnis eröffnen, um dieses Bild aufzunehmen, suchten wir nach einem besseren Blickwinkel und einer größeren Person. Ich habe diese Kamera zufällig live gespürt, ich werde sagen, dass sie

viel größer aussieht. Das Bild unten mit Yon Karafin, mit dem wir ungefähr gleich groß sind, spiegelt das Ausmaß der Katastrophe genauer wider:

Wer kümmert sich im Prinzip um die Fähigkeiten des berechneten Videos, über das sie selten schreiben - die ganze Wahrheit ist unter dem Strich! )

Diskussionen über die Möglichkeiten der Plenoptik erinnern mich an Diskussionen über das erste Flugzeug:

Was die Leute sagten:

-

Es ist sehr teuer ...-

JA!-

Es ist völlig unpraktisch und zahlt sich jetzt nicht aus ...-

JA!-

Es ist gefährlich zu benutzen ...-

Verdammt, JA!-

Es sieht elend aus!-

Verdammt, JA, aber es fliegt, siehst du, LE-TA-ET !!!

Nach 50 Jahren führten diese Experimente zu einer grundlegend neuen, bequemen und ziemlich sicheren Art, sich über die Ozeane zu bewegen (und nicht nur).

Die Situation ist hier die gleiche. Absolut das gleiche! Jetzt erfordert es unvernünftige Kosten, die verdammt unpraktisch zu bedienen sind und elend aussehen, aber es fliegt wirklich! Und sich der Prinzipien und neuen Perspektiven bewusst zu sein - es ist einfach unglaublich inspirierend (zumindest Ihr bescheidener Diener)!

Das Monster auf dem Foto oben erinnert etwas an die ersten Kameras, die ebenfalls groß waren, ein riesiges Objektiv hatten und auf einem speziellen Rahmen gedreht wurden:

Quelle: Fernsehaufnahmen der Olympischen Spiele 1936 zu Beginn des Fernsehens

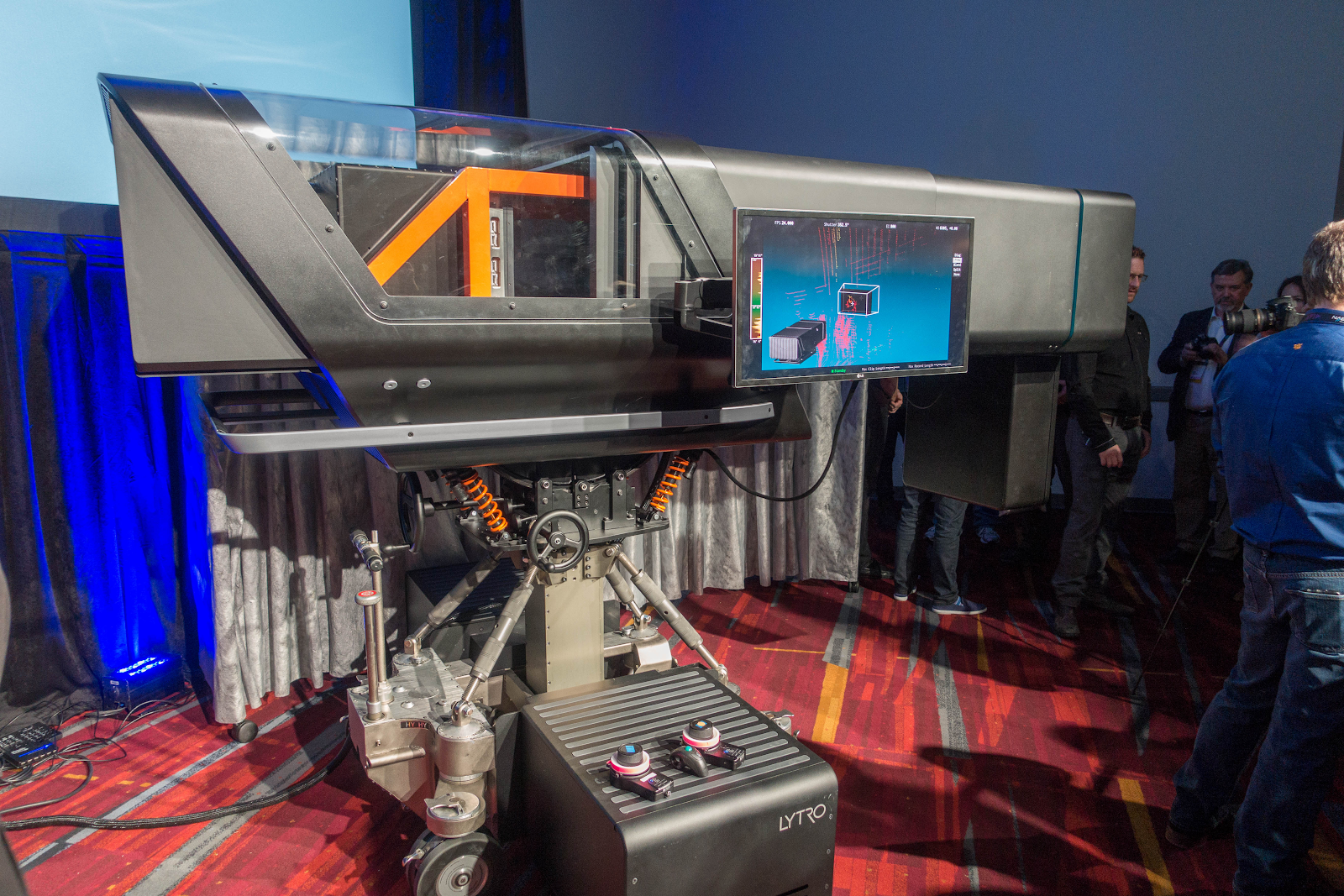

Quelle: Fernsehaufnahmen der Olympischen Spiele 1936 zu Beginn des FernsehensHier sieht viel aus, auch ein riesiges Objektiv (weil es auch nicht genug Licht gibt), eine schwere Kamera mit einer speziellen Federung, riesige Größen:

Quelle: Lytro ist bereit, das Filmemachen für immer zu verändern

Quelle: Lytro ist bereit, das Filmemachen für immer zu verändernAus dem Interessanten: Der „Koffer“ unten ist ein Flüssigkeitskühlsystem, bei dessen Ausfall die Kamera keine weiteren Bilder aufnehmen kann.

Das große Rechteck unter dem Objektiv (auf dem ersten Foto oben deutlich sichtbar) ist nicht die Hintergrundbeleuchtung, sondern das Lidar - ein Laser-Entfernungsmesser, der eine dreidimensionale Szene vor der Kamera liefert.

Ein dickes schwarzes Tourniquet unten links im Hintergrund ist ein Bündel von Glasfaserkabeln mit einem Durchmesser von etwa 4 Zentimetern, durch das die Kamera einen ungeheuren Informationsstrom an einen speziellen Speicher sendet.

Diejenigen in diesem Thema haben bereits das

Lytro-Kino erkannt, von dem 3 Stücke geschaffen wurden. Die erste, die normalerweise in allen Bildern erscheint, ist an einem

Lidar unter der Linse leicht zu erkennen. Nach 1,5 Jahren wurde eine zweite Kammer mit korrigierten strukturellen Problemen des ersten und der beiden Lidare geschaffen (und leider schreibt fast niemand darüber). Darüber hinaus war der Entwicklungsfortschritt beispielsweise von Lidaren in 1,5 Jahren so groß, dass zwei Lidare der zweiten Kammer zehnmal mehr Punkte ergaben als ein Lidar der ersten. Die dritte Kamera sollte ungefähr die gleichen Auflösungseigenschaften haben (um die Anforderungen der Filmemacher zu erfüllen), aber halb so groß sein (was für den praktischen Gebrauch entscheidend ist). Aber ... aber dazu später mehr.

In jedem Fall möchte ich darauf hinweisen, dass das Licht nicht darauf konvergierte, da es die herausragende Rolle, die Lytro bei der Popularisierung der

plenoptischen Schießtechnologie gespielt hat, in jeder Hinsicht anerkannte. Eine ähnliche Kamera wurde am

Fraunhofer-Institut hergestellt .

Raytrix , ein Hersteller von plenoptischen Kameras

, existiert sicher , und ich durfte das Lytro-Kino nicht fotografieren, da ich große Angst vor mehreren chinesischen Unternehmen hatte, die aktiv in dieser Richtung arbeiteten (es wurden keine neuen Informationen darüber gefunden).

Schreiben wir daher die Punkte auf, die alle Vorteile der Plenoptik bieten und über die sie fast nicht schreiben. Aber gerade deshalb ist es garantiert erfolgreich.

Anstatt vorzustellen

Nur auf Habré und nur auf Lytro wird

auf ca. 300 Seiten erwähnt , daher werden wir kurz sein.

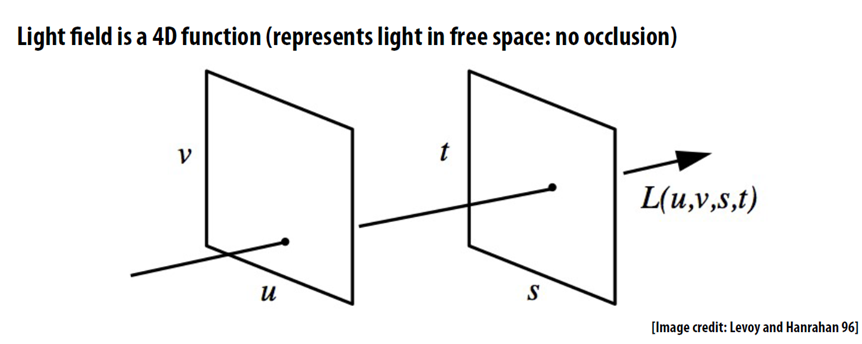

Das Schlüsselkonzept für die plenoptische Aufnahme ist das Lichtfeld, dh wir fixieren nicht die Pixelfarbe an jedem Punkt, sondern eine zweidimensionale Pixelmatrix, die aus einem miserablen zweidimensionalen Rahmen einen normalen vierdimensionalen Rahmen macht (normalerweise mit sehr geringer Auflösung in t und s):

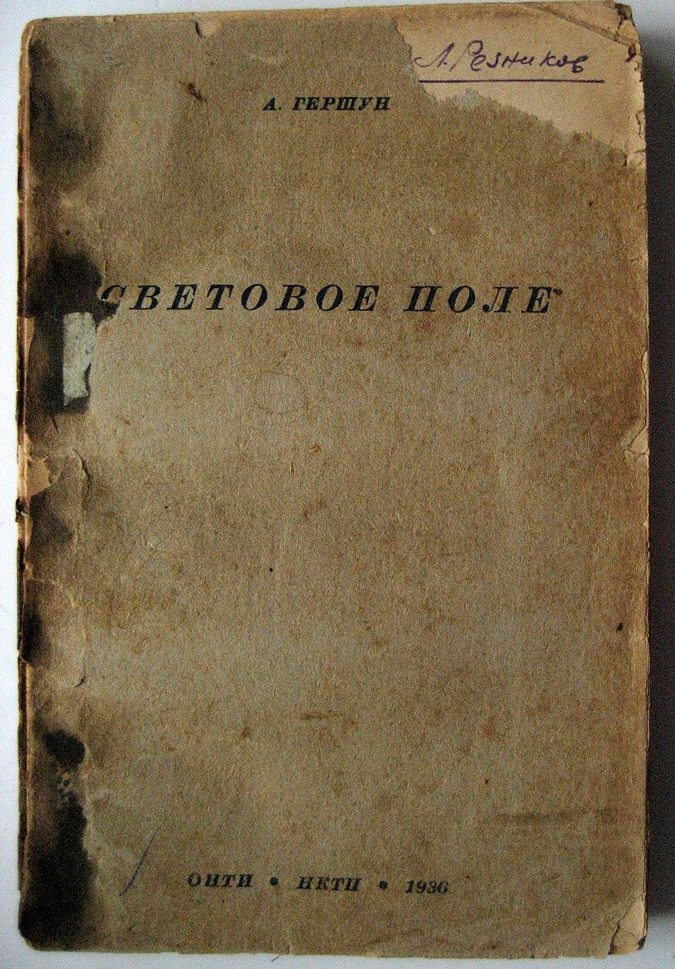

In der

englischen Wikipedia und

dann in der russischen in Artikeln über das Lichtfeld heißt es, dass "der Ausdruck" Lichtfeld "

von A. Gershun im Jahr 1936 verwendet wurde." Fairerweise stellen wir fest, dass dies nicht

zufällig eine „verwendete Phrase“ war, sondern der Name eines

kleinen Buches mit 178 Seiten , das „Lichtfeld“ genannt wurde:

Und schon damals waren diese Werke durchaus in der Natur angewendet und der Autor erhielt 6 Jahre später auf dem Höhepunkt des Krieges 1942 den Stalin-Preis zweiten Grades für die Blackout-Methode.

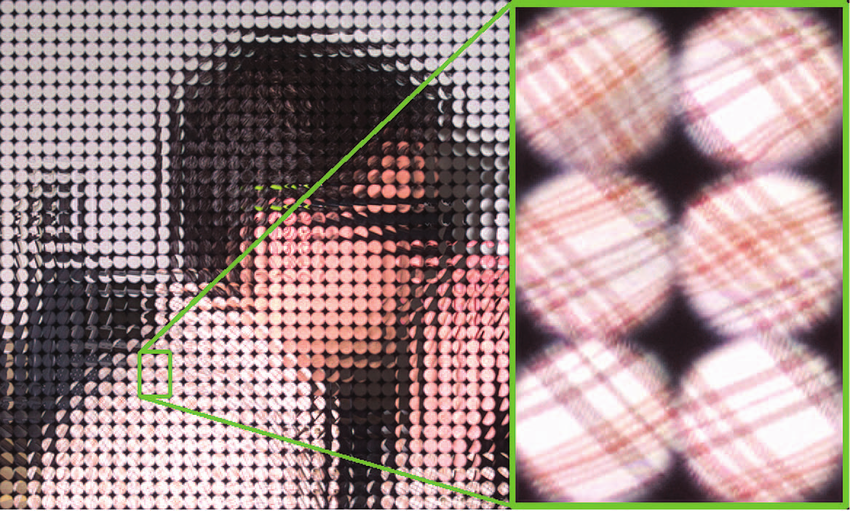

In der Praxis bietet das Aufnehmen eines vierdimensionalen Rahmens des Lichtfelds eine Reihe von Mikrolinsen vor dem Sensor der Kamera:

Quelle: plenoptic.inf (Sie können klicken und in voller Auflösung sehen)

Quelle: plenoptic.inf (Sie können klicken und in voller Auflösung sehen)Gerade weil wir eine Reihe von Mikrolinsen mit einem geringen Abstand zwischen ihnen haben, war es möglich, Lytro Cinema zu erstellen, dessen Sensor aus einer Reihe von Sensoren zusammengesetzt wurde, deren Grenzen an den Rand der Linsen fallen. Eine Flüssigkeitskühlung war erforderlich, um ein sehr heißes Massiv abzukühlen.

Quelle: Verwenden fokussierter plenoptischer Kameras für die Erfassung umfassender Bilder

Quelle: Verwenden fokussierter plenoptischer Kameras für die Erfassung umfassender BilderAls Ergebnis erhalten wir die berühmteste Möglichkeit von Plenoptikkameras, über die nur die Faulen nicht geschrieben haben - um die Fokussierentfernung nach der Aufnahme zu ändern (diese niedlichen Vögel würden nicht auf den Fokus warten):

Quelle: Lytro

Quelle: LytroUnd es wurde wenig darüber geschrieben, wie Plenoptik in einer für einen Film geeigneten Auflösung aussieht (wird durch Klicken geöffnet):

Quelle: Watch Lytro Change Cinematography Forever

Quelle: Watch Lytro Change Cinematography ForeverIch öffne ein weiteres Geheimnis: Der berechnete Fokus ist die Spitze des Eisbergs der Plenoptik. Noch interessanter sind die 90% der Möglichkeiten, die meiner Meinung nach unter dem Interesse von Journalisten liegen. Viele von ihnen verdienen separate Artikel, aber lassen Sie uns zumindest die Ungerechtigkeit korrigieren und sie zumindest nennen. Lass uns gehen!

Berechnete Aperturform

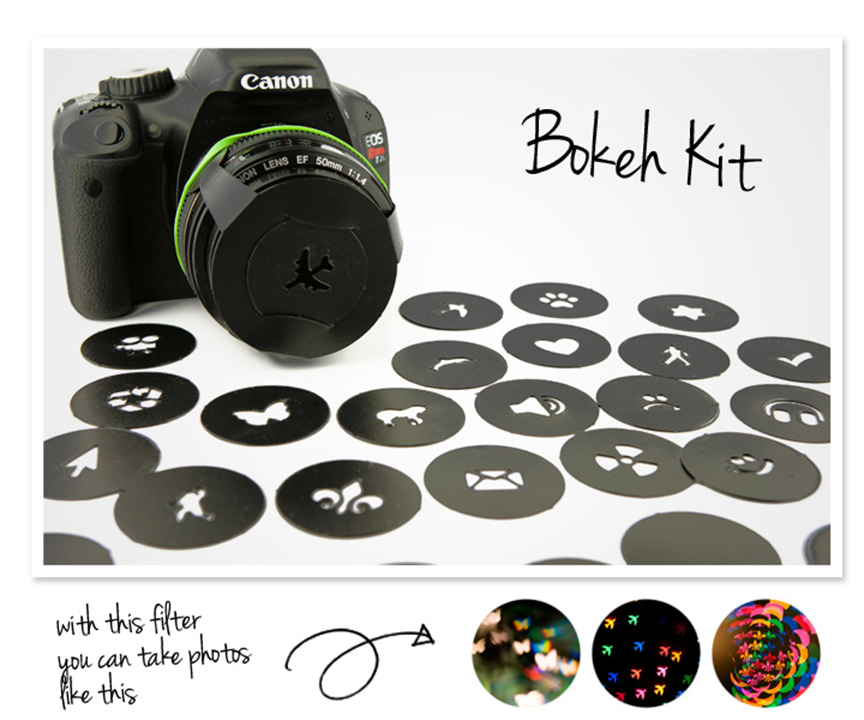

Da es sich um Defokussierung handelt, ist der sogenannte

Bokeh-Effekt zu erwähnen, bei dem die Blendung nicht unbedingt rund ist

Für Fotografen ist das sogenannte

Bokeh Kit erhältlich , mit dem Sie verschiedene Formen blenden können:

Auf diese Weise erhalten Sie hübsche Bilder, und das Foto unten zeigt deutlich, dass die Glitzer in Form von Herzen sogar Steine im Vordergrund haben, nur die Herzen sind kleiner. Und es ist klar, dass es äußerst schwierig ist, in Photoshop auf ähnliche Weise auf natürliche Weise zu verwischen. Zumindest ist es ratsam, eine Tiefenkarte zu verwenden:

Gleichzeitig ist es für die Plenoptik relativ einfach, eine andere Blende zu „berechnen“:

Also! Wir haben die Fokussierentfernung berechnet, die Form der Blende berechnet, sind weiter gegangen, es ist dort interessanter!

Berechnetes Stereo

Ein sehr nützliches Merkmal des plenoptischen Sensors, von dem fast niemand spricht, das ihm aber bereits ein zweites Leben gibt, ist die Fähigkeit, ein Bild aus verschiedenen Punkten zu berechnen. Die Position des Punktes wird tatsächlich durch die Größe der Linse bestimmt. Wenn das Objektiv klein ist, kann sich der Rahmen wie in diesem Beispiel leicht nach links und rechts verschieben (dieses Stereofoto ist sichtbar, wenn Sie auf die Brust des nächsten Vogels schauen):

Quelle: Lytro

Quelle: LytroWenn das Objektiv groß ist, wie zum Beispiel Lytro Cinema, kann der Aufnahmepunkt um 10 Zentimeter verschoben werden. Ich möchte Sie daran erinnern, dass wir zwischen unseren Augen ungefähr 6,5 Zentimeter haben, dh mit einem maximalen Abstand von 10 cm können Sie sowohl den allgemeinen Plan (und er ist „dreidimensional“ als wenn Sie mit Ihren Augen schauen) als auch die Nahaufnahme (mit jeder Parallaxe ohne Unbehagen) aufnehmen. Tatsächlich bedeutet dies, dass wir mit einem Objektiv vollständige Stereovideos aufnehmen können. Darüber hinaus wird es nicht nur Stereo sein, sondern Stereo mit perfekter Qualität, und das klingt heute fantastisch - mit einem variablen Abstand zwischen den optischen Achsen virtueller Kameras NACH der Aufnahme. Sowohl das als auch eine andere - absolut undenkbare Möglichkeiten, die eine Situation mit Stereoaufnahmen in Zukunft grundlegend verändern können.

Da die Zukunft irgendwie im dreidimensionalen Schießen liegt, wollen wir uns näher mit diesen beiden Punkten befassen. Es ist kein Geheimnis, dass heute die meisten 3D-Filme, insbesondere Blockbuster, nicht entfernt, sondern in 3D konvertiert werden. Dies geschieht, weil beim Aufnehmen eine lange Liste von Problemen auftritt (unten ist ein Teil der Liste):

- Die Frames können relativ zueinander gedreht, vertikal verschoben oder vergrößert werden (sagen Sie nicht, dass dies leicht zu beheben ist, sehen Sie, wie oft solche Frames in Filmveröffentlichungen fallen - dies ist ein leiser Horror ... und Kopfschmerzen). Also - die plenoptische Stereoanlage ist PERFEKT ausgerichtet, selbst wenn der Bediener beschlossen hat, den Plan zu vergrößern (aufgrund der Mechanik der beiden Kameras ist es äußerst schwierig, die Annäherung streng synchron zu machen).

- Die Farbe der Bilder kann variieren , insbesondere wenn für die Aufnahme ein geringer Abstand zwischen den optischen Achsen der Kameras erforderlich ist und Sie einen Strahlteiler verwenden müssen (es gab einen ausführlichen Beitrag dazu). Es stellt sich heraus, dass wir in einer Situation, in der wir bei der Aufnahme eines Fackelobjekts (das Auto im Hintergrund an einem sonnigen Tag) mit der überwiegenden Mehrheit der Kameras zur Unterhaltung in der Postproduktion verdammt sind und mit Plenoptik ein PERFEKTES Bild mit jeglicher Blendung erhalten. Dies ist ein Feiertag!

- Die Schärfe der Rahmen kann variieren - wiederum ein spürbares Problem bei Strahlteilern, das bei der Plenoptik völlig fehlt. Mit welcher Schärfe benötigt wird, berechnen wir damit absolut PERFEKT aus den Winkeln.

- Frames können in der Zeit schweben . Kollegen, die mit dem Stalingrad-Material gearbeitet haben, sprachen über die Diskrepanz zwischen den Zeitstempeln der Tracks um 4 Frames, weshalb der Cracker immer noch relevant ist. Wir haben in 105 Filmen mehr als 500 Szenen mit Zeitunterschieden gefunden. Der Zeitunterschied ist leider schwer zu erkennen, insbesondere in Szenen mit Zeitlupe, und gleichzeitig das schmerzhafteste Artefakt nach unseren Messungen. Im Falle der Plenoptik haben wir eine PERFEKTE Zeitsynchronisation.

- Ein weiteres Problem beim Aufnehmen von 3D sind zu große Parallaxen, die beim Betrachten auf einem großen Bildschirm unangenehm sind , wenn Ihre Augen bei Objekten „jenseits der Unendlichkeit“ zur Seite divergieren oder bei einigen Objekten im Vordergrund zu konvergieren können. Die korrekte Parallaxenberechnung ist ein separates schwieriges Thema, über das die Bediener gut verfügen sollten, und ein Objekt, das versehentlich in den Rahmen gelangt, kann die Aufnahme ruinieren und es unangenehm machen. Bei der Plenoptik wählen wir selbst die Parallaxe NACH der Aufnahme, sodass jede Szene mit der PERFEKTEN Parallaxe berechnet werden kann. Darüber hinaus kann dieselbe bereits aufgenommene Szene problemlos für große und kleine Bildschirme berechnet werden. Dies ist die sogenannte Parallaxenänderung, die in der Regel äußerst schwierig und teuer ist, ohne Qualitätsverlust zu verursachen, insbesondere wenn Sie durchscheinende Objekte oder Ränder im Vordergrund hatten.

Im Allgemeinen ist die Fähigkeit, die perfekte Stereoanlage zu berechnen, die eigentliche Grundlage für die nächste Welle der 3D-Popularität, da in den letzten 100 Jahren 5 solcher Wellen unterschieden wurden. Gemessen an den Fortschritten bei Laserprojektion und Plenoptik werden wir für maximal 10 Jahre (wenn die Hauptpatente von Lytro in China auslaufen oder etwas früher) in China ein neues Eisen und ein neues Qualitätsniveau für 3D-Filme erwarten.

Also! Sie haben die perfekt berechnete Stereoanlage von einem Objektiv (was für die meisten übrigens unmöglich ist). Und sie haben es nicht nur verstanden, sondern auch die Parallaxe nacherzählt, selbst wenn das Objekt im Vordergrund unscharf ist. Lass uns tiefer gehen!

Berechneter Aufnahmepunkt

Das Ändern des Aufnahmepunkts hat eine Anwendung in normalen 2D-Videos.

Wenn Sie am Set waren oder zumindest Fotos gesehen haben, haben Sie wahrscheinlich auf die Schienen geachtet, auf denen die Kamera fährt. Oft muss man sie für eine Szene in mehrere Richtungen legen, was eine spürbare Zeit in Anspruch nimmt. Schienen sorgen für einen reibungslosen Betrieb der Kamera. Ja, natürlich gibt es eine

Steadicam , aber in vielen Fällen haben die Schienen leider keine Alternative.

Die Möglichkeit, den Aufnahmepunkt in Lytro zu ändern, wurde verwendet, um zu demonstrieren, dass genügend Räder vorhanden sind. Wenn sich die Kamera bewegt, bilden wir eine virtuelle „Röhre“ mit einem Raumdurchmesser von 10 cm, in der wir den Aufnahmepunkt ändern können. Mit diesem Rohr können Sie kleine Schwankungen ausgleichen. Dies wird in diesem Video gut gezeigt:

Darüber hinaus müssen Sie manchmal das umgekehrte Problem lösen, dh während der Bewegung Schwingungen hinzufügen. Zum Beispiel gab es nicht genug Dynamik und der Regisseur entschied sich für eine Explosion. Es dauert nicht lange, einen Ton anzulegen, aber es ist ratsam, die Kamera synchron zu schütteln, und es ist besser, das Bild nicht nur flach zu bewegen, es wird sichtbar, sondern es „ehrlich“ zu schütteln. Mit der Plenoptik kann der Aufnahmepunkt vollständig „ehrlich“ geschüttelt werden - mit einer Änderung des Aufnahmepunkts, des Winkels, der Bewegungsunschärfe usw. Es wird eine völlige Illusion geben, dass die Kamera heftig zitterte, die sanft und sicher auf Rädern fuhr. Stimmen Sie zu - eine erstaunliche Gelegenheit! Die Steadicam der nächsten Generation wird Wunder zeigen.

Damit dies Realität wird, müssen Sie natürlich warten, bis die Größe der plenoptischen Kamera auf einen vernünftigen Wert reduziert ist. Angesichts der Tatsache, wie viel Geld in die Miniaturisierung und die Erhöhung der Auflösung von Sensoren für Smartphones und Tablets investiert wird, scheint das Warten nicht so lange zu dauern. Und es wird möglich sein, eine neue plenoptische Kamera zu erstellen! Jedes Jahr wird es einfacher und einfacher.

Also! Der Aufnahmepunkt wurde berechnet und gegebenenfalls bewegt, wodurch die Kamera stabilisiert oder destabilisiert wurde. Lass uns weiter gehen!

Berechnete Beleuchtung

Da wir über eine Explosion in der Nähe sprechen ...

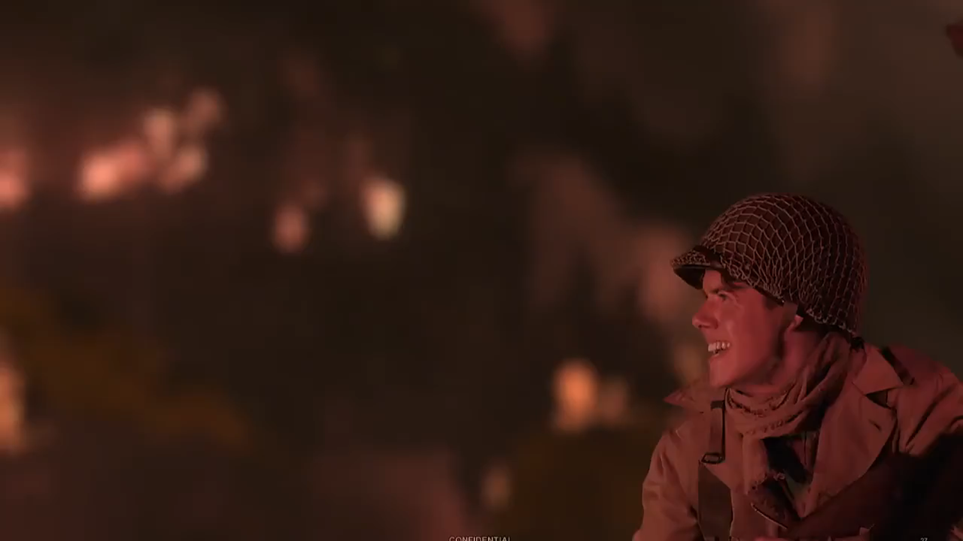

Manchmal ist es notwendig, die Beleuchtung des Motivs zu ändern, z. B. einen Blitz realistisch hinzuzufügen. Postproduktionsstudios wissen genau, was für ein schwieriges Problem dies ist, auch wenn die Kleidung unseres Charakters relativ einfach ist.

Hier ist ein Beispiel für ein Video mit einer Blitzüberlagerung unter Berücksichtigung der Kleidung, ihrer Schatten usw. (wird durch Klicken geöffnet):

Quelle: Interview mit Yon Karafin

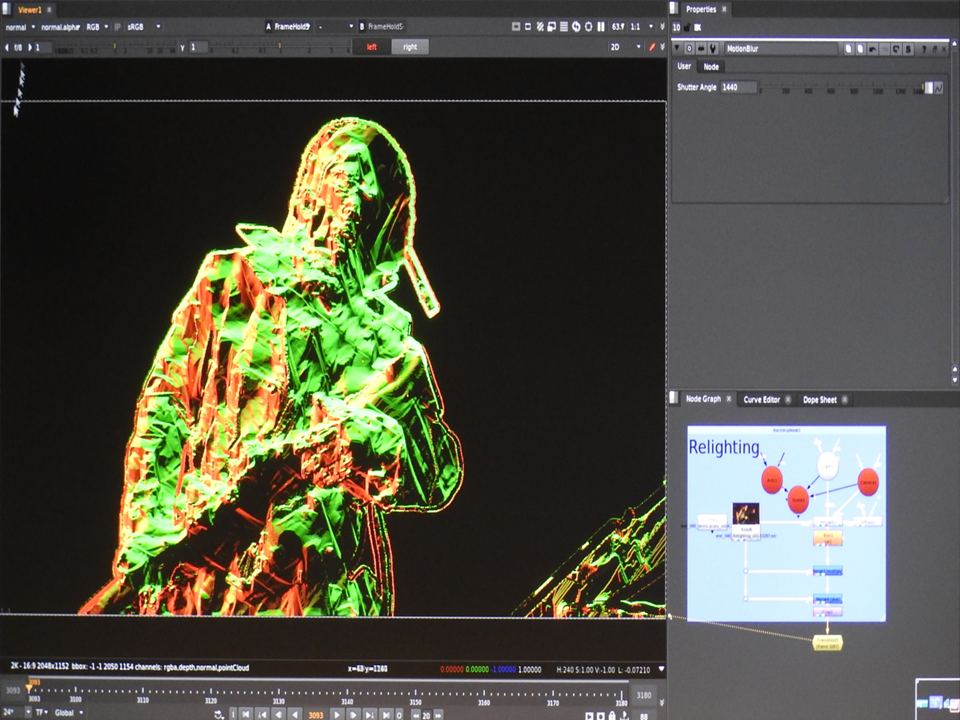

Quelle: Interview mit Yon KarafinUnter der Haube sieht es aus wie ein Plug-In für Nuke, das mit einem vollständigen dreidimensionalen Modell des Schauspielers arbeitet und es unter Berücksichtigung der normalen Karte, Materialien, Bewegungsunschärfe usw. neu beleuchtet:

Quelle: Lytro Materials

Quelle: Lytro MaterialsAlso! Die neue Beleuchtung des bereits erfassten Objekts wurde berechnet. Lass uns weiter gehen!

Berechnete Auflösung

Diejenigen, die mit dem ersten Lytro experimentierten, bemerkten oft - ja, das Spielzeug ist cool, aber die Auflösung ist für normale Fotografie völlig unzureichend.

In

unserem letzten Artikel über Habr wurde beschrieben, wie kleine Verschiebungen des Aufnahmepunkts dazu beitragen können, die Auflösung signifikant zu erhöhen. Frage: Sind diese Algorithmen auf die Plenoptik anwendbar? Antwort: Ja! Darüber hinaus lassen sich Super-Resolution-Algorithmen leichter mit plenoptischen Bildern bearbeiten, da eine Tiefenkarte vorhanden ist, alle Pixel gleichzeitig aufgenommen werden und die Verschiebungen recht genau bekannt sind. Das heißt, die Situation der Plenoptik ist einfach magisch im Vergleich zu den Bedingungen, unter denen Super Resolution-Algorithmen in gewöhnlichem 2D arbeiten. Das Ergebnis ist entsprechend:

Quelle: Naive, intelligente und hochauflösende plenoptische Rahmenwiederherstellung aus dem technischen Bericht von Adobe „Superauflösung mit plenoptischer Kamera 2.0“

Quelle: Naive, intelligente und hochauflösende plenoptische Rahmenwiederherstellung aus dem technischen Bericht von Adobe „Superauflösung mit plenoptischer Kamera 2.0“Das einzige große Problem (wirklich groß!) Ist die Datenmenge und der Rechenaufwand, der erforderlich ist. Trotzdem ist es heute völlig realistisch, eine Computerfarm nachts zu laden und morgen dort, wo sie benötigt wird, doppelt so viel Auflösung zu erhalten.

Also - die berechnete Auflösung herausgefunden! Lass uns weiter gehen!

Berechnete Umgebung

Eine separate Aufgabe, die sich in der Postproduktion ergibt, insbesondere wenn es sich um ein fantastisches oder Fantasy-Projekt handelt, besteht darin, die aufgenommenen Objekte sorgfältig in eine dreidimensionale Szene zu kleben. Weltweit gibt es kein großes Problem. Heutzutage ist das dreidimensionale Scannen des Aufnahmebereichs die Norm. Alles, was übrig bleibt, ist, das Aufnahmemodell und die dreidimensionale Szene sorgfältig zu kombinieren, damit es keine Klassiker des Genres gibt, wenn die Beine der Schauspieler manchmal leicht in den bemalten unebenen Boden fallen (dieser Pfosten ist auf dem kleinen Bildschirm nicht sehr sichtbar, aber deutlich zu sehen im Kino, besonders irgendwo in IMAX).

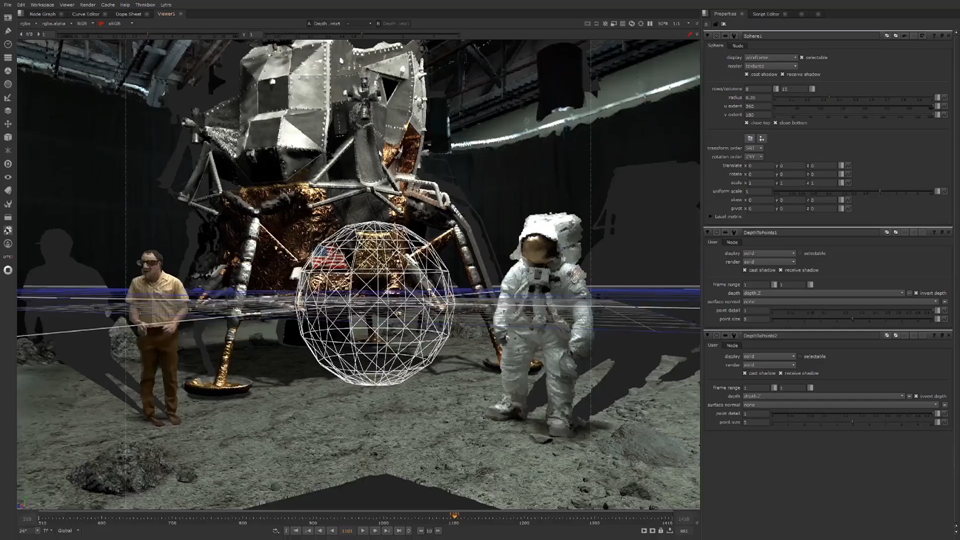

Nicht ohne Humor wurde als Beispiel für den Betrieb der Kamera die Szene verwendet, in der die Mondlandung aufgenommen wurde („dreidimensionale Schatten“ sind an Stellen deutlich sichtbar, die die Kamera nicht sieht):

Quelle: Mond | Lytro | VR Playhouse | Lightfield Postproduktion

Quelle: Mond | Lytro | VR Playhouse | Lightfield PostproduktionDa ein Mehrwinkelvideo per Definition in einer plenoptischen Kamera aufgenommen wird, ist das Erstellen einer Tiefenkarte kein großes Problem. Und wenn die Kamera mit dem Lidar kombiniert wird, nehmen wir sofort eine dreidimensionale Szene auf, was die Kombination von echten Aufnahmen und Grafiken in der nächsten Phase kategorisch vereinfacht.

Also haben wir die dreidimensionale Szene gezählt (Lidar-Daten und Plenoptik-Daten kombiniert). Nun, Sie haben es erraten, wird die Darstellung der Mondvermessung noch besser sein! Mach weiter.

Berechneter Chroma Key

Das ist aber noch nicht alles!

Die übliche Technologie eines modernen Filmsets sind

grüne Bildschirme , wenn an Orten, an denen ein Computerhintergrund auf grünen Sperrholzschildern angebracht werden soll, oder grüne Banner gezogen werden. Dies geschieht so, dass es keine Probleme an den durchscheinenden Rändern gibt, wenn sich der Hintergrund ändert. 4 — ( ) .

, , , , . , , :

:

: Lytro , (

- — !), ( challenge), , ( , , ):

, ? . , , ( ). ,

.

« », . . , 2D . .

, , !

— . , , , , . , «» .

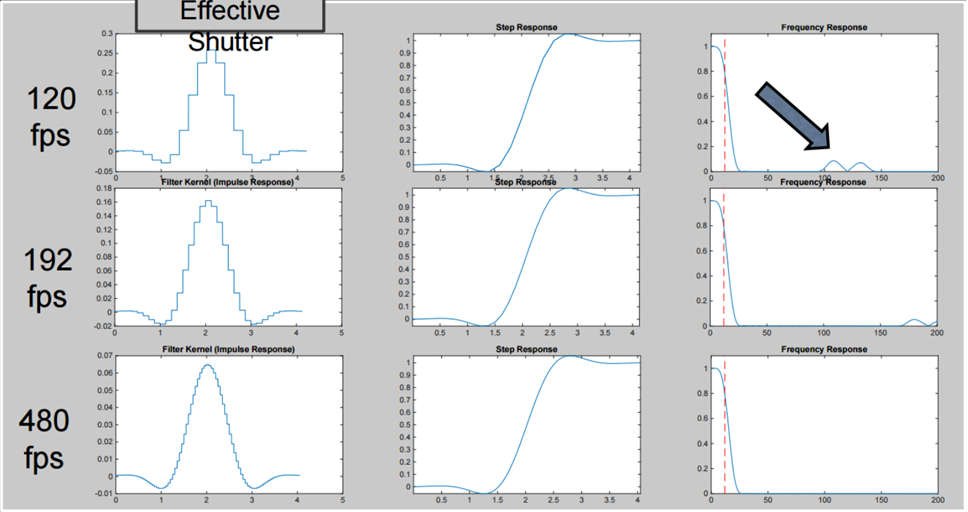

, «» «» , , , , , , ( Lytro Cinema 300 fps, , ):

«» , , , «» «» , ( , , ):

: https://vimeo.com/114743605

: https://vimeo.com/114743605, , :

: https://vimeo.com/114743605

: https://vimeo.com/114743605, . !

Wenn es heute um Plenoptik geht, gibt es normalerweise typische Gespräche im Stil von

„Der Chef ist weg: Der Gips wird entfernt, der Kunde geht!“. Lytro hat Google letztes Jahr günstig gekauft, die Pelican Imaging-Experimente gingen nicht in die Massenproduktion und im Allgemeinen blieb alles nur eine schöne Theorie ...

Quelle: Pelican Imaging: Smartphone Plenoptic Camera Module für 20 Dollar

Quelle: Pelican Imaging: Smartphone Plenoptic Camera Module für 20 DollarAlso! Gerüchte über den Tod von Plenoptikern sind stark übertrieben. Sehr stark!

Im Gegenteil, derzeit werden plenoptische Sensoren in einem noch

nie dagewesenen Maßstab hergestellt und eingesetzt.

Das berüchtigte Google-Unternehmen ohne große Fanfare veröffentlichte Google Pixel 2 und Google Pixel 3 mit plenoptischen Sensoren. Wenn Sie auf das Telefon schauen, können Sie deutlich sehen, dass die Kamera eine Kamera hat:

Gleichzeitig verwischt das Telefon den Hintergrund jedoch sehr gut, im Allgemeinen nicht schlechter als seine Kollegen mit zwei, drei, drei und vier Augen (stimmen Sie zu, dass das folgende Foto besonders von diesem Effekt profitiert):

Quelle: AI Google Blog (Sie können klicken und eine größere Größe sehen, hauptsächlich an den Rändern des Vordergrundobjekts)

Quelle: AI Google Blog (Sie können klicken und eine größere Größe sehen, hauptsächlich an den Rändern des Vordergrundobjekts)Wie machen sie das ?!

Eine Quelle magischer Wunder, die in letzter Zeit unvermeidlich war, wird genutzt - nicht-kindliche Magie neuronaler Netze?

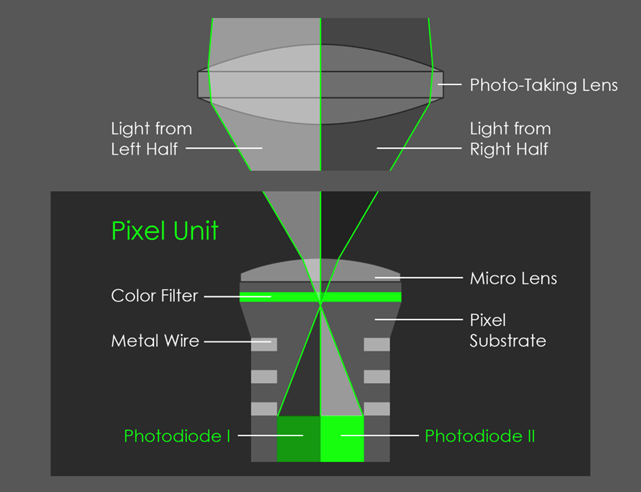

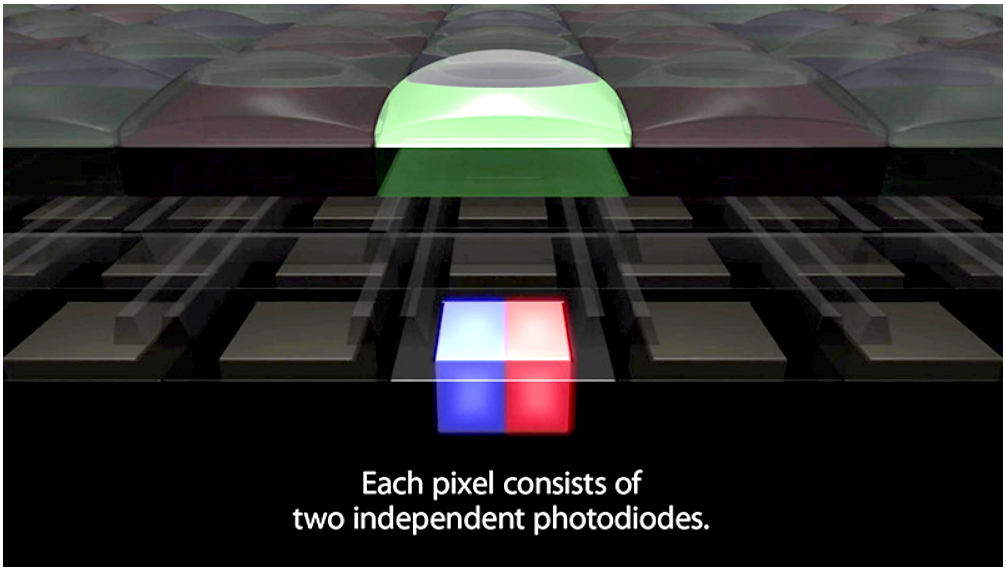

Neuronale Netze, insbesondere in Pixel 3, werden bei dieser Aufgabe ebenfalls aktiv verwendet, dazu später mehr. Das Geheimnis der Effektqualität besteht darin, dass der Sensor des Smartphones plenoptisch ist, obwohl das Objektiv nur zwei Pixel abdeckt, wie im Bild gezeigt:

Quelle: AI Google Blog

Quelle: AI Google BlogAls Ergebnis erhalten wir ein Mikrostereobild, hier ist eine sehr leichte Verschiebung in der Bewegung sichtbar (das rechte Bild ist animiert und bewegt sich auf und ab, da das Telefon beim Aufnehmen so gehalten wurde):

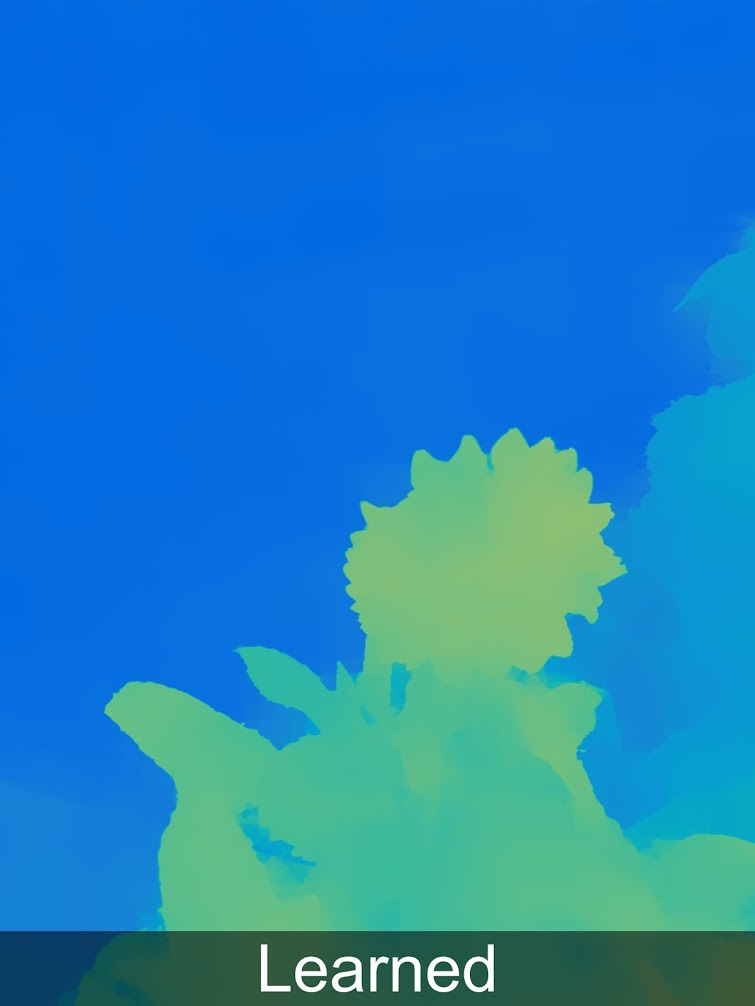

Aber selbst diese extrem kleine Verschiebung reicht aus, um eine Tiefenkarte für das aufgenommene Foto zu erstellen (über die Verwendung von Subpixel-Verschiebungen wurde

in einem früheren Artikel berichtet ):

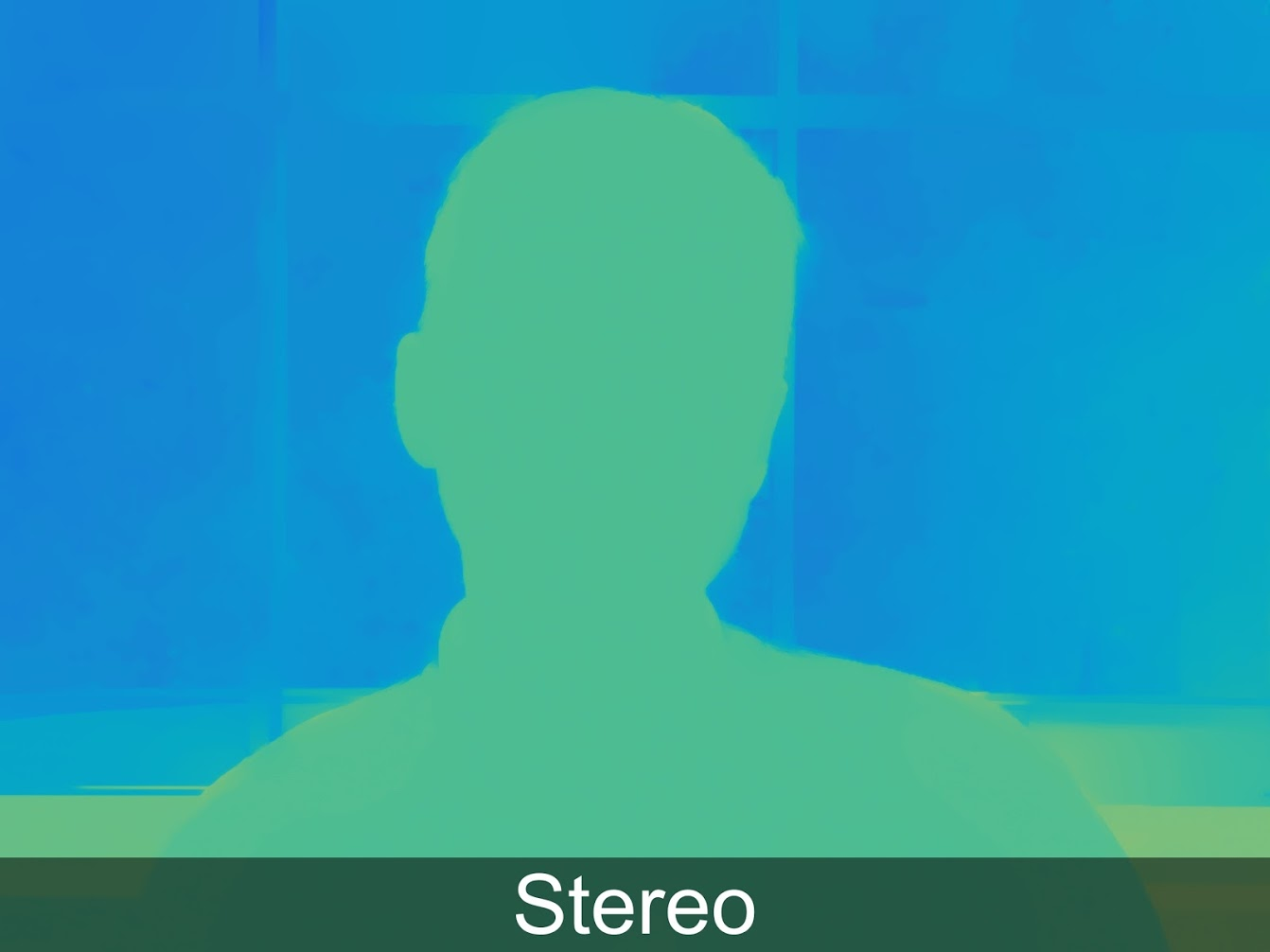

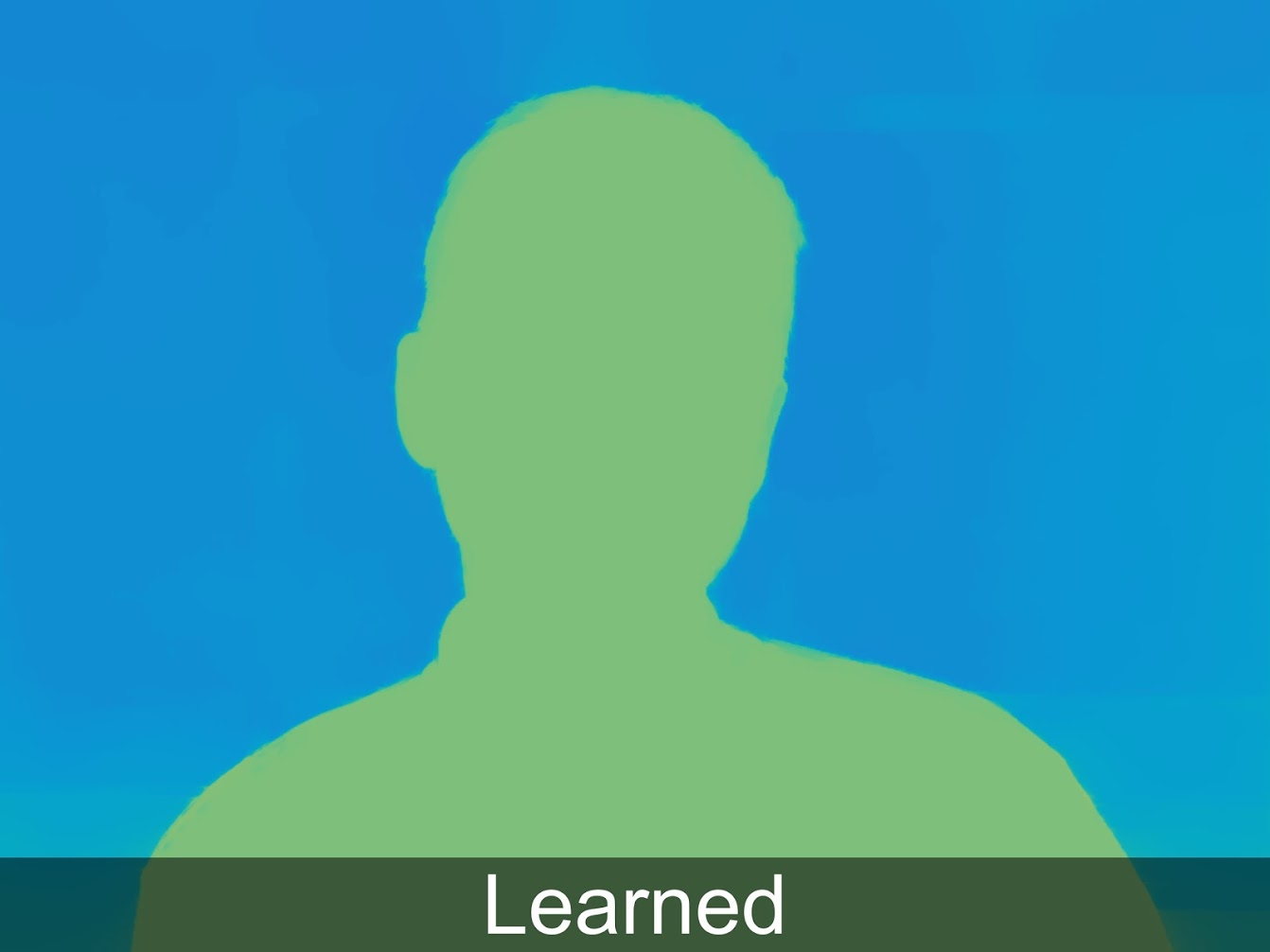

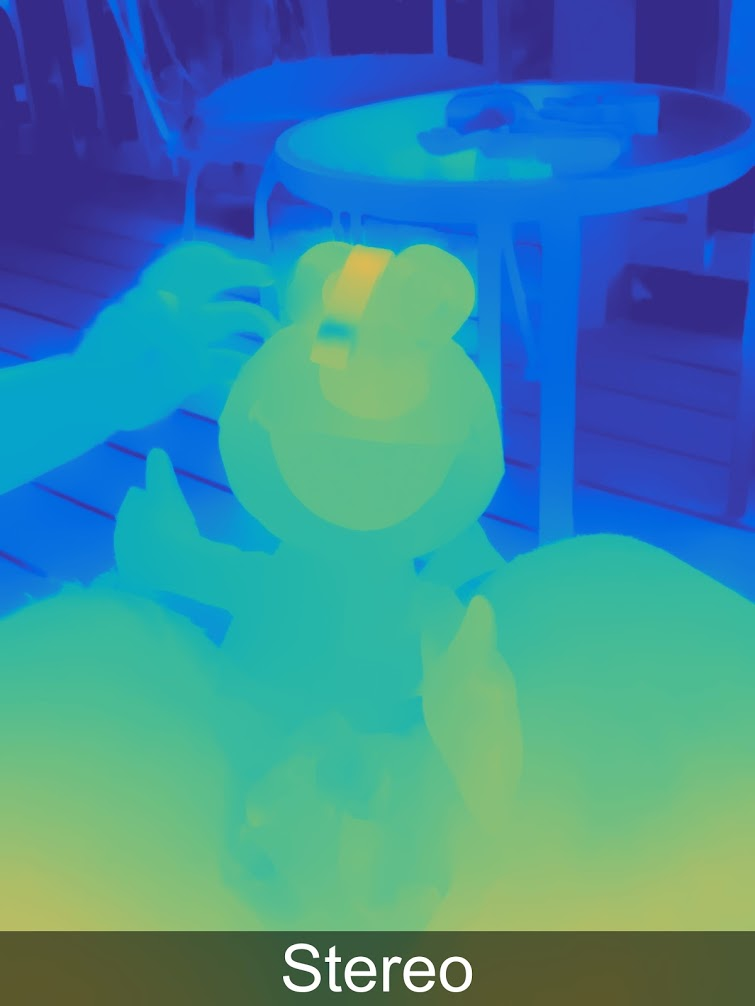

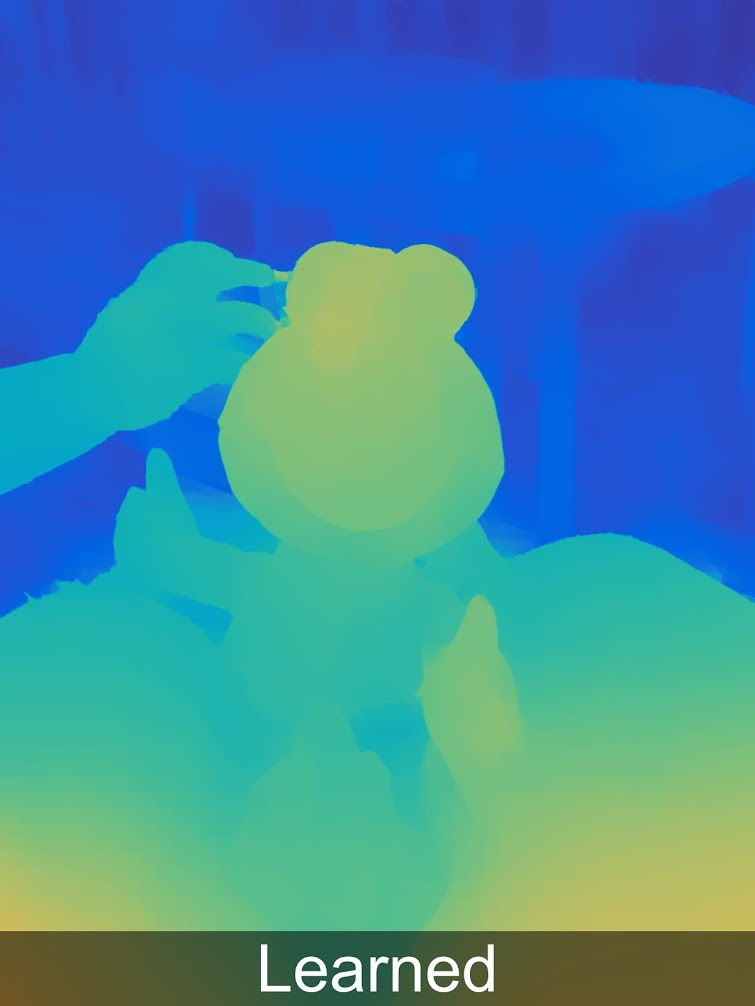

Gleichzeitig können durch den Einsatz von maschinellem Lernen die Ergebnisse erheblich verbessert werden, und dies ist bereits in Pixel 3 implementiert. Im folgenden Beispiel bedeutet "Gelernt" Stereo + Gelernt. Mehr dazu gibt es hoffentlich einen separaten Beitrag:

Für diejenigen, die die Tiefe in voller Auflösung betrachten möchten, gibt es weitere Beispiele

in einer speziellen Galerie .

Es ist deutlich zu sehen, dass nicht alles perfekt ist, und wir haben typische Artefakte, die typisch für die Erstellung einer Tiefenkarte aus Stereo sind (die übrigens auch bei Pixels zweiäugigen Kollegen verfügbar sind), und ein wenig Parallaxeneffekte. Es ist jedoch bereits klar, dass die Qualität der Tiefe völlig ausreicht, um das Bild sicher nach Tiefe zu segmentieren und weitere Effekte zu erzielen, Objekte sicherer zur Szene hinzuzufügen und so weiter. Die Ergebnisse der gemessenen Tiefe sind um eine Größenordnung besser als die Ergebnisse, die auf verschiedenen Annahmen basieren (willkürlich neuronale Netze).

Herzlichen Glückwunsch an alle, die bis zu diesem Punkt gelesen haben! Sie leben während der Veröffentlichung von plenoptischen Kameras in einem erfolgreichen Massenmarktprodukt, auch wenn Sie nicht einmal davon wissen!

Die Geschichte endet natürlich nicht dort:

- Erstens ist es interessant, dass die Plenoptik „fast kostenlos“ war, da bei modernen Smartphone-Kameras mit Miniaturisierung des Sensors und einer Erhöhung der Auflösung ein katastrophaler Mangel an Lichtfluss auftritt, sodass jedes Pixel mit einer Mikrolinse bedeckt ist. Das heißt, ein solcher Sensor kostet nicht mehr (das ist sehr wichtig!), Obwohl wir eine Auflösung, die wir gerade aufgrund einer anderen Technologie erhöht haben, etwas opfern. Durch die Anwendung von zwei Technologien wird das Ergebnis in 2D besser (weniger Rauschen, höhere Auflösung, HDR) und gleichzeitig durch die gemessene Tiefe ergänzt, dh es wird 3D. Der Preis der Ausgabe ist ein dramatischer Anstieg der Anzahl der Berechnungen pro Frame. Aber für Fotos ist dies bereits heute möglich und funktioniert bereits in echten Smartphones.

- Zweitens sagte ein Google-Mitarbeiter auf einer Konferenz, dass er daran denke, 4 Pixel mit einem Objektiv abzudecken. Danach wird die Qualität der Tiefenkarte dramatisch höher sein, da es 2 Stereopaare mit einer 1,4-mal größeren Stereobasis (zwei Diagonalen) geben wird. Dies wird die Qualität der Tiefenkarte dramatisch verbessern. darunter viele Stereo-Artefakte an den Grenzen. Mitbewerber können diese Qualität nur erreichen, wenn sie mindestens 3 Kameras hintereinander platzieren. Eine solche Qualitätssteigerung ist für AR wichtig.

- Drittens ist Google nicht mehr allein. Hier ist ein Beispiel für eine Beschreibung einer ähnlichen Technologie im Vivo V11 Pro. Sie haben gerade ein ähnliches Bild gesehen:

Quelle: Was ist Dual Pixel-Technologie?

Quelle: Was ist Dual Pixel-Technologie?Plenoptics wird auch im Autofokus von professionellen Kameras verwendet, beispielsweise bei

Canon (Google

DPAF - Dual Pixel Auto Focus). Wer hätte gedacht, dass ein theoretischer Witz von vor 30 Jahren - die Fähigkeit, Stereo mit einem Objektiv aufzunehmen - die erste Massenanwendung von Plenoptik wäre ...

Generell - das Thema ging an die Produkte!

Sie fliegt schon! Sie sehen,

LE-TA-ET!

Zusammenfassend

Filmoptik im Kino

Oben haben wir zwei Fälle des Einsatzes von Plenoptik untersucht - in der Filmproduktion und in Smartphones. Dies ist keine vollständige Liste. Beispielsweise ist die Plenoptik in der

Mikroskopie sehr relevant. Sie können

berechnete Stereomikroskopaufnahmen mit einer großen "ehrlichen" Schärfentiefe erstellen. Die Plenoptik ist für Industriekameras relevant, insbesondere wenn Sie Fotos von durchscheinenden mehrstufigen Objekten usw. aufnehmen müssen. Aber irgendwie ein anderes Mal.

Denken Sie daran, dass für die Verwendung in der Filmproduktion relevant sind:

- Berechnete Fokusentfernung

- Berechnetes Bokeh

- Berechnete Auflösung

- Computed Perfect Stereo

- Berechneter Aufnahmepunkt

- Berechnete Beleuchtung

- Berechnete Umgebung

- Berechneter Greenscreen

- Berechneter Verschluss

In den kommenden Jahren kann durch Miniaturisierung und erhöhte Auflösung von Sensoren eine Technologie entwickelt werden, mit der eine praktische, grundlegend neue Filmkamera erstellt werden kann, mit der Sie Material zum Anwenden von Spezialeffekten schneller (ohne Greenscreen) und mit weniger Einstellungen entfernen können (mehr Punkte sind einfacher zu reparieren). Die neuen Funktionen sind so interessant, dass solche Kameras zum Erfolg verurteilt sind, wenn der plenoptische Sensor mit einer geeigneten Filmauflösung kompakt gemacht werden kann.

Wann kann eine solche Kamera erscheinen?Eine vorsichtige Antwort ist in den nächsten 10 Jahren.

Wovon hängt der Begriff ab?Aus vielen Faktoren. Gute Frage: Wie wird die Situation mit der Möglichkeit sein, Lytro-Patente zu lizenzieren, die Google jetzt besitzt? Dies kann kritisch sein. Glücklicherweise laufen die wichtigsten in 10 Jahren ab (hier erinnern wir uns nicht höflich an die chinesischen Lytro-Kollegen, die den Prozess beschleunigen können). Auch die Arbeit mit riesigen Datenmengen, die von der plenoptischen Kamera erzeugt werden, sollte vereinfacht werden: Mit modernen Wolken wird dies immer einfacher. Von den guten Nachrichten - einmal dank Lytro, in einem

sehr beliebten Kompositionsprogramm , das in einer Vielzahl von Studios für die Stereoverarbeitung verwendet wird, wurde das plenoptische Datenformat unterstützt. Wie sie sagen, ist Lytro gestorben, aber die Möglichkeit, Plug-Ins für Nuke mit Unterstützung für plenoptische Videos zu schreiben, blieb uns erhalten. Dies vereinfacht den „Eintritt“ in diesen Markt mit einem professionellen Produkt, da es wichtig ist, dass die Studios sofort mit dem Format neuer Kameras arbeiten können, ohne Personal und in denselben Programmen zu schulen.

Plenoptika in Smartphones

Wenn wir über Smartphones sprechen, sieht alles noch besser aus. Am relevantesten für diese Branche ist die Fähigkeit der plenoptischen Kamera, die Tiefe mit einem einzigen Sensor (möglicherweise schnell) zu messen, und diese Funktion wird bald eine große Nachfrage sein.

Wann kann eine solche Kamera erscheinen?Existiert bereits. Und morgen wird die Technologie von anderen Herstellern wiederholt. Darüber hinaus wird

Augmented Reality auf Smartphones und Tablets der Haupttreiber der nächsten Stufe sein, der es heute an Genauigkeit und der Fähigkeit mangelt, eine dreidimensionale Szene zu "sehen".

Wovon hängt der Begriff ab?Die Möglichkeit, die Entfernung mit dem Hauptsensor in Echtzeit zu messen, wird mit Google Pixel wahrscheinlich bald verfügbar sein, da sich Google seit langem in diese Richtung entwickelt (siehe

Projekt Tango , das geschlossen ist, dessen Geschäft jedoch weiterlebt). Und

ARCore sieht ebenso vielversprechend aus wie das konkurrierende

ARKit . Und der Durchbruch muss, wie Sie jetzt erraten haben, nicht lange warten, da der Wert des Sensorpixels exponentiell abfällt, die Durchschnittsgeschwindigkeit in 10 Jahren 10-mal genannt wird und wir einen 2-mal-Abfall benötigen. Dann zählen Sie selbst. Nicht morgen, aber nicht lange.

Anstelle einer Schlussfolgerung

Denken Sie daran, dass wir ganz am Anfang über einen Vortrag bei VGIK gesprochen haben? Ich muss sagen, dass ich nicht mit der Reaktion darauf gerechnet habe, die am Ende war. Um es in einem Wort auszudrücken, es war Trauer. Wenn in zwei Worten, dann universelle Trauer. Und zuerst verstand ich nicht, was los war. Der Operator, der nach der Vorlesung auftauchte, erklärte mir die Situation sehr gut. Es war nicht einmal so, dass die Kamerakunst nachließ. Obwohl es ein großartiges Beispiel gab: Ein Filmfragment für ungefähr 6 Sekunden, wenn sich eine Person der Tür der Wohnung nähert, klopft, eine andere Person die Tür öffnet, grüßt und sich ein wenig vorwärts bewegt, während die Kamera auf den Korridor, dann auf den Türrahmen fokussiert und dann sofort fokussiert auf die Person, die es entdeckt hat, und dann in den Raum. Und der Bediener muss die Kamera perfekt beherrschen, damit er bei einer

kinoähnlichen geringen Schärfentiefe den Zoom meisterhaft bedienen und dabei die Hintergrundbeleuchtung, die Zusammensetzung des Rahmens, die Reisekrankheit beim Fotografieren mit den Händen und weitere 1000 wichtige Kleinigkeiten berücksichtigen kann. Also. Es ist nicht einmal so, dass dies einfacher wird. Das ist sogar gut. Weniger Aufnahmen werden durch die Tatsache verdorben, dass der Bediener irgendwo keine Zeit hatte oder versäumt hat. Er erzählte, wie kürzlich er eine Serie in 4K für den Sender gedreht hat. Und der Bestand an Auflösungen erwies sich als groß. Infolgedessen schnitt der Regisseur die Rahmen in der Postproduktion, und an einigen Stellen wurden nur Fragmente des Rahmens für Unterbrechungen verwendet. Infolgedessen war die Komposition einfach schrecklich und dieser Betreiber wollte seinen Namen aus dem Abspann entfernen.

Die oben beschriebenen Merkmale von Kameras für Filmemacher bedeuten die Übertragung vieler Effekte von der Drehphase auf die Postproduktion. Und es wird sehr traurig sein, wenn diejenigen, die die aufgenommenen Szenen verarbeiten, Analphabeten in Sachen Komposition, Fokusentfernungskontrolle usw. sind. Wenn sie lesen und schreiben können, sind dies neue fantastische Möglichkeiten.

Wir wünschen uns allen mehr Kompetenz, was in dieser sich schnell verändernden Welt nicht immer einfach ist!Und Karthago wird ... bis zum Ende des Jahrhunderts wird das gesamte Video dreidimensional sein!Danksagung

Ich möchte mich herzlich bedanken bei:

- Labor für Computergrafik VMK Moscow State University MV Lomonosov für seinen Beitrag zur Entwicklung der Computergrafik in Russland und nicht nur

- Unsere Kollegen aus der Videogruppe, dank derer Sie diesen Artikel gesehen haben,

- persönlich Konstantin Kozhemyakov, der viel getan hat, um diesen Artikel besser und visueller zu machen,

- Jon Karafin, als er Leiter des Lichtfeldvideos in Lytro war, dank dessen wir fast angefangen haben, an der Verbesserung ihres Produkts zu arbeiten (und nicht aus Gründen gestartet sind, die außerhalb unserer Kontrolle oder von uns liegen),

- Lytro für ihren Beitrag zur Popularisierung von Lichtfeldern und ihre Fähigkeiten, Google, das die fallende Flagge eroberte, und andere Unternehmen, die Produkte auf der Basis dieser interessanten Technologie herstellen,

- und schließlich vielen Dank an Sergey Lavrushkin, Roman Kazantsev, Ivan Molodetsky, Evgeny Kuptsov, Jegor Sklyarov, Evgeny Lyapustin und Denis Kondranin für eine große Anzahl vernünftiger Kommentare und Korrekturen, die diesen Text viel besser gemacht haben!