Die achtundzwanzigste RSA-Konferenz fand letzte Woche statt, und wenn dieses größte Branchenereignis der Branche im Jahr 2018 von einigen

Schwierigkeiten bei der Suche nach neuen Bedeutungen geprägt war, ist diesmal wieder alles in Ordnung. Die Eröffnungspräsentation von RSA-Präsident Rohit Gai war der „Landschaft des Vertrauens“ gewidmet, und im Verlauf der Präsentation wurde versucht, ein positives Szenario für die Zukunft zu zeichnen, insbesondere im Jahr 2049.

Es ist positiv, weil es gelungen ist, viele Probleme von heute zu lösen, darunter nicht einmal Cybersicherheitsprobleme, sondern Schwierigkeiten mit einem neuen Modell für die Entwicklung der Gesellschaft, das fast vollständig mit dem Internet und digitalen Diensten verbunden ist. Wenn Sie versuchen, dieses Thema von oben zu betrachten (was sie traditionell gerne auf RSA tun), geht es nicht nur um die Fähigkeit, den Computer oder Server einer Person zu hacken. Es gibt zum Beispiel das Problem der Manipulation in sozialen Netzwerken, und manchmal entwickeln sich die Dienste selbst manchmal in die falsche Richtung. In diesem Zusammenhang ist die Idee des Vertrauens - Benutzer für Unternehmen, Menschen für künstliche Intelligenz - wirklich wichtig.

Wenn Sie daran interessiert sind, wie sie über Sicherheit bei Geschäftsveranstaltungen sprechen, sehen Sie sich das Video an.Eine weitere interessante Idee wurde in der Präsentation zum Ausdruck gebracht: Künstliche Intelligenz muss nicht gezwungen werden, Aufgaben auszuführen, die nur Menschen ausführen können, bei denen Fakten eine geringere Rolle spielen als Emotionen und beispielsweise ethische Fragen. Und umgekehrt: Entscheidungen, die eine strikte Einhaltung von Fakten erfordern, sollten häufig den Maschinen überlassen werden, die (vermutlich) weniger fehleranfällig sind. Entscheidungen darüber, ob einer Informationsquelle im Netzwerk vertraut werden soll oder nicht, sollten auf der Reputation beruhen. Eine ähnliche Idee kann auf das Problem von Cyber-Vorfällen angewendet werden: Ja, früher oder später passieren sie jedem, aber der Vorteil wird Organisationen verschafft, deren Bemühungen zum Schutz von Kundendaten die Folgen von Hacking überwiegen.

Theoretische Angriffe auf Algorithmen für maschinelles LernenRSA zeigt jedoch immer noch, wie komplex die Beziehung innerhalb der Branche zwischen denen, die neue Probleme finden, und denen, die Lösungen anbieten, ist. Abgesehen von einigen Protokollreden sind die interessantesten Reden auf der Konferenz, wenn sie die Zukunft malen, in einigen nicht sehr optimistischen Tönen. Bemerkenswert ist die Präsentation von Google-Sprecher Nicolas Carlini (

News ). Er fasste die Erfahrungen mit Angriffen auf Algorithmen für maschinelles Lernen zusammen, beginnend mit diesem bereits klassischen Beispiel aus dem Jahr 2017:

Das Originalbild einer Katze wird für den Menschen völlig unsichtbar verändert, aber der Erkennungsalgorithmus klassifiziert dieses Bild auf eine völlig andere Weise. Welche Bedrohung stellt diese Änderung dar? Ein weiteres nicht aktuelles, aber informatives Beispiel:

Das Straßenschild scheint ein wenig unter den Vandalen gelitten zu haben, aber für eine Person ist es ziemlich verständlich. Das Auto kann das Zeichen mit solchen Änderungen als ein völlig anderes Zeichen erkennen - mit Informationen über das Tempolimit - und hält nicht an der Kreuzung an. Weiter interessanter:

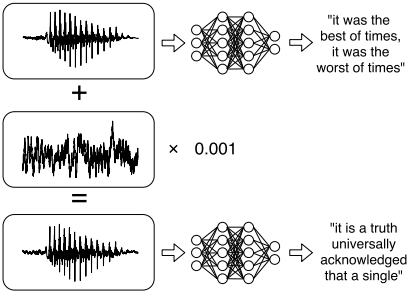

Die gleiche Methode kann auf Schall angewendet werden, was in der Praxis demonstriert wurde. Im ersten Beispiel "erkannte" das Spracherkennungssystem den Text in einem Musikfragment. Im zweiten Fall führte die unsichtbare Manipulation der Sprachaufzeichnung zur Erkennung eines völlig anderen Satzes von Wörtern (wie im Bild). Im dritten Fall wurde der Text erkannt und war völlig bedeutungslos. Dies ist eine interessante Situation: Irgendwann beginnen Menschen und ihre digitalen Assistenten, ganz andere Dinge zu sehen und zu hören. Schließlich können Algorithmen für maschinelles Lernen theoretisch die persönlichen Daten, auf denen sie trainiert wurden, bei weiterer Verwendung offenlegen. Das einfachste und verständlichste Beispiel ist das Predictive Typing System, auch bekannt als „Damned T9“.

Sicherheit von MedizinproduktenDie Sicherheit in der Medizin wurde kürzlich in den Bereichen unglaublich veraltete Software und das Fehlen von Budgets für die Entwicklung der IT diskutiert. Infolgedessen sind die Folgen von

Cyberangriffen schwerwiegender als gewöhnlich, und wir sprechen über den Verlust oder das Auslaufen sehr sensibler Patientendaten. Auf der RSA-Konferenz

teilten Experten von Check Point Software

die Ergebnisse einer Studie über das Computernetzwerk eines echten Krankenhauses in Israel mit. In den meisten medizinischen Einrichtungen ist das Computernetzwerk nicht in Zonen unterteilt, so dass es einfach genug war, spezielle Geräte zu finden, in diesem Fall ein Ultraschallgerät.

Die Geschichte über die Suche nach Schwachstellen im Computerteil des Geräts war sehr kurz. In Ultrasound wird Windows 2000 ausgeführt, und es war nicht schwierig, einen Exploit für eine der kritischen Sicherheitslücken in diesem Betriebssystem zu finden. Die Forscher erhielten Zugang zum Bildarchiv mit den Namen der Patienten, konnten diese Informationen bearbeiten und hatten die Möglichkeit, den Ransomware-Trojaner zu aktivieren. Der Gerätehersteller sagte, dass modernere Modelle auf moderner Software basieren, dass dort regelmäßig Software-Updates bereitgestellt werden (aber nicht die Tatsache, dass sie installiert sind), aber das Aktualisieren von Medizinprodukten kostet (viel) Geld, und was bringt es, wenn alte Geräte funktionieren?

Die Empfehlungen für medizinische Organisationen sind klar: Segmentierung des lokalen Netzwerks, Trennung von Geräten, die private Daten speichern, von allen anderen. Interessanterweise wird für die Entwicklung maschineller Lerntechnologien in der Medizin im Gegenteil ein möglichst breiter Zugang zu Patientendaten benötigt - für Trainingsalgorithmen.

Haftungsausschluss: Die in dieser Übersicht geäußerten Meinungen stimmen möglicherweise nicht immer mit der offiziellen Position von Kaspersky Lab überein. Sehr geehrte Redakteure empfehlen generell, Meinungen mit gesunder Skepsis zu behandeln.