Gestern, den 02.04.19, hat Intel das lang erwartete Update für die Intel® Xeon® Scalable Processors-Familie angekündigt, das Mitte 2017 eingeführt wurde. Die neuen Prozessoren basieren auf der Mikroarchitektur mit dem Codenamen Cascade Lake und basieren auf einem verbesserten 14-nm-Prozess.

Merkmale der neuen Prozessoren

Schauen Sie sich zunächst die Unterschiede in der Kennzeichnung an. Im vorherigen Artikel über Skylake-SP haben wir bereits erwähnt, dass alle Prozessoren in 4 Serien unterteilt sind -

Bronze ,

Silber ,

Gold und

Platin . Die erste Ziffer der Zahl gibt an, zu welcher Serie das Prozessormodell gehört:

- 3 - Bronze,

- 4 - Silber,

- 5, 6 - Gold,

- 8 - Platin.

Die zweite Ziffer gibt die Erzeugung des Prozessors an. Für die Intel® Xeon® Scalable Processors-Familie werden Generationen mit Codenamen verwendet:

- 1 - Skylake,

- 2 - Cascade Lake.

Die nächsten beiden Ziffern geben die sogenannte SKU (Stock Keeping Unit) an. Tatsächlich ist dies nur eine CPU-Kennung mit einem bestimmten Satz verfügbarer Funktionen.

Nach der Modellnummer können sich auch Indizes befinden, die mit einem oder zwei Buchstaben gekennzeichnet sind. Der erste Buchstabe des Index gibt die Merkmale der Architektur oder Optimierung des Prozessors selbst an, der zweite die Speicherkapazität des Sockets.

Nehmen Sie zum Beispiel einen Prozessor mit der Bezeichnung

Intel® Xeon® 6240 . Entschlüsseln:

- 6 - Prozessor der Gold-Serie,

- 2 - die Generation von Cascade Lake,

- 40 - SKU.

Leistung

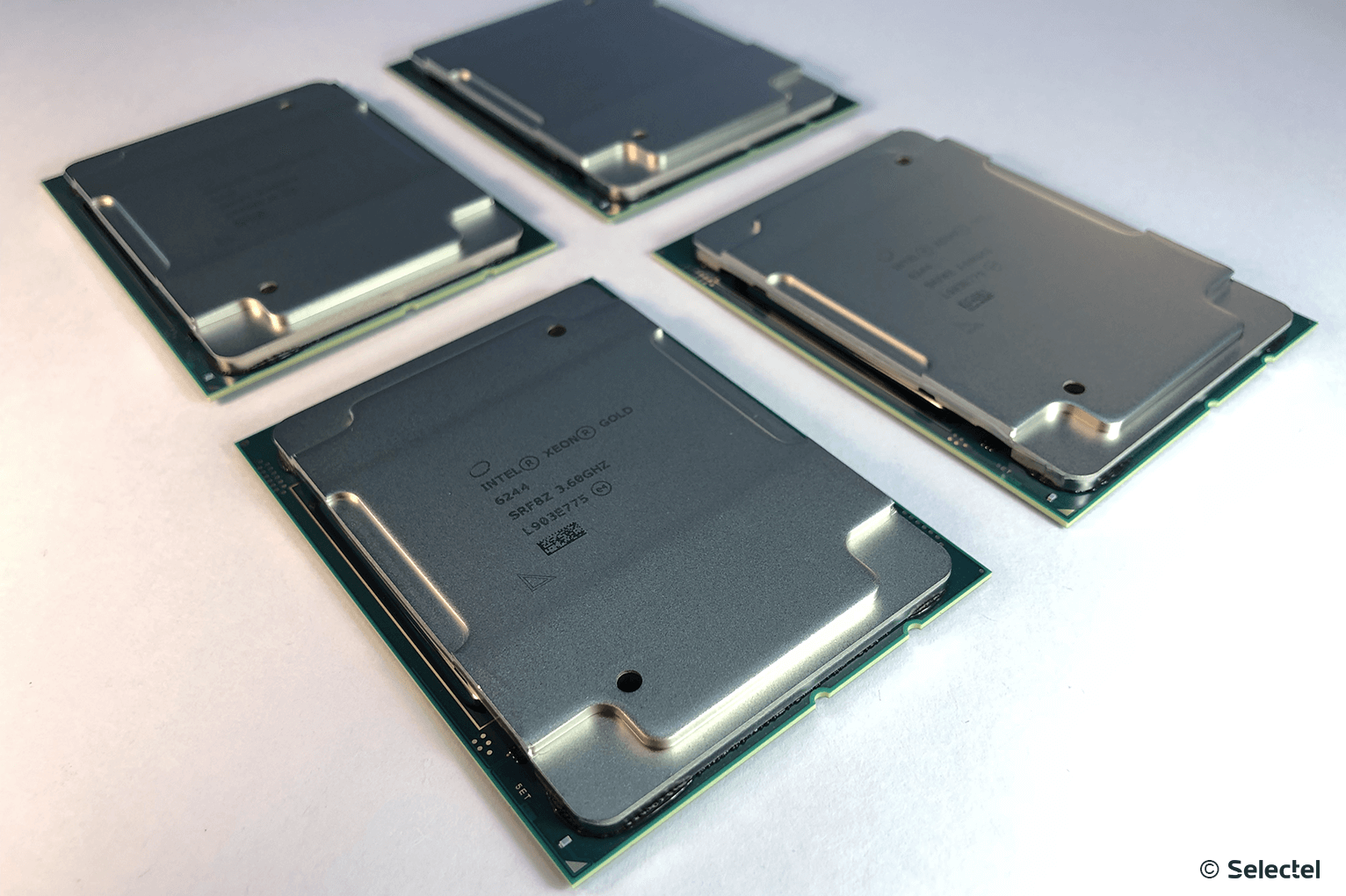

Die Prozessoren der neuen Generation wurden mit der Erwartung entwickelt, in den Bereichen Virtualisierung, künstliche Intelligenz sowie Hochleistungsrechnen eingesetzt zu werden. Die erste spürbare Änderung war die Erhöhung der Taktfrequenz. Dies wurde durchaus erwartet, da es eine große Anzahl von Serveranwendungen gibt, für die die Taktrate wichtiger ist als die Anzahl der Prozessorkerne. Zum Beispiel das Finanzprodukt 1C, dessen Systemanforderungen eindeutig besagen, dass der Endbenutzer das Ergebnis umso schneller erhält, je höher die Prozessorfrequenz ist.

In einigen Fällen wurde die Anzahl der Kerne erhöht. Aus Gründen der Übersichtlichkeit haben wir Vergleichstabellen mehrerer Prozessoren der Intel® Xeon® Scalable Processors-Familie der ersten und zweiten Generation zusammengestellt:

Eine Erhöhung der Taktfrequenz führt zwangsläufig zu einer Erhöhung der Wärmeableitung. Für die Flaggschiff-Prozessoren der Platinum-Serie kann es

205 W erreichen, was ein sehr ernsthafter Test für ein herkömmliches Luftkühlsystem ist. Es ist davon auszugehen, dass Serverplattformen in absehbarer Zeit eine Flüssigkeitskühlung benötigen.

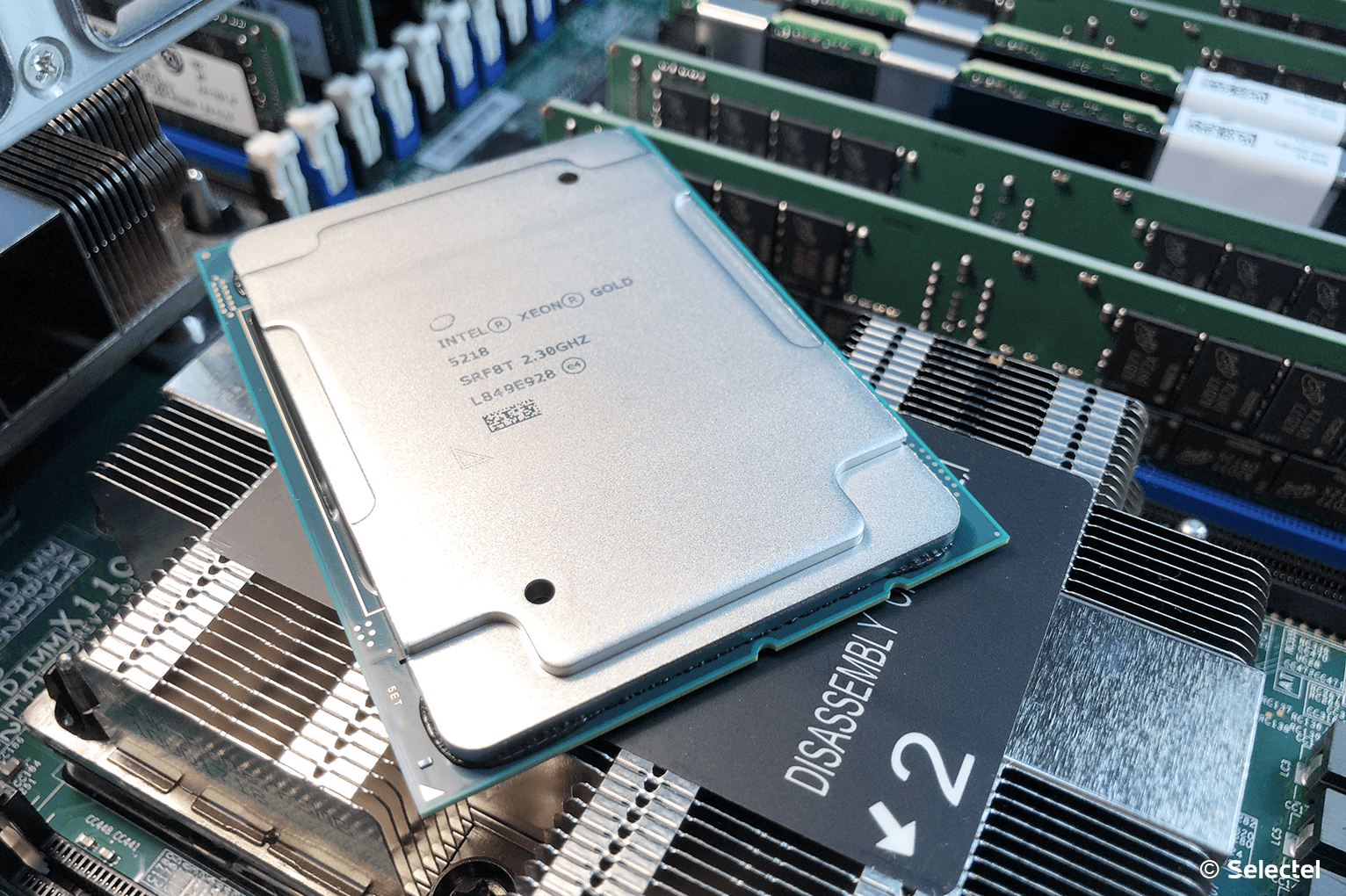

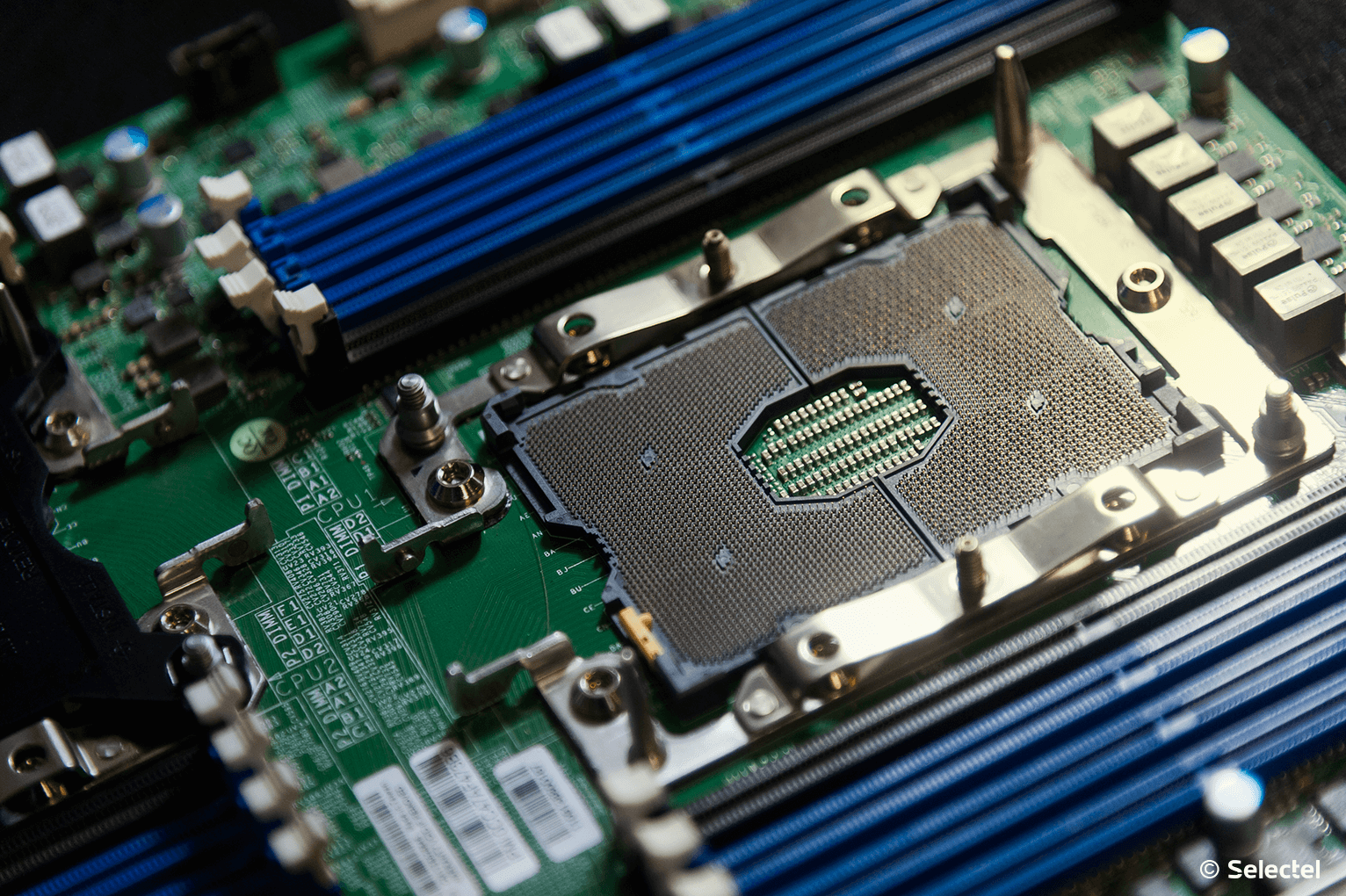

Wie bei der vorherigen Generation von Skylake SP sind Prozessoren im

LGA3647- Sockel (Sockel P) installiert, was auf die Verwendung eines 6-Kanal-Speichercontrollers zurückzuführen ist (maximal 2 Speichermodule pro Kanal). Die Speicherfrequenz beträgt

2666 MT / s . Bei Verwendung von Prozessoren der Serien 6000 und 8000 können Sie den Speicher jedoch mit einer Frequenz von

2933 MT / s verwenden (nicht mehr als 1 Modul pro Kanal).

Der

Ultra-Path Interconnect- Bus, der erfolgreich in Intel Xeon SP-Prozessoren der ersten Generation eingesetzt wurde, blieb in der zweiten Generation und ermöglichte den Datenaustausch zwischen Prozessoren mit Geschwindigkeiten von 9,6 GT / s oder 10,4 GT / s für jeden Kanal. Auf diese Weise können Sie die Hardwareplattform effektiv auf 8 physische Prozessoren skalieren und so die Bandbreite und Energieeffizienz optimieren.

Tests

Wir haben begonnen, die Prozessoren der neuen Generation mit Hilfe der

SPEC -Testsuite zu testen, die die Last basierend auf der Lösung der dringendsten Lebensaufgaben simuliert. Diese Tests stellen sowohl die einfachsten Berechnungen als auch die Berechnung verschiedener physikalischer Prozesse dar, beispielsweise zur Lösung von Problemen der Molekularphysik und Hydrodynamik.

Derzeit haben wir die Ergebnisse einiger SPEC-Tests für Ganzzahlberechnungen am Beispiel der Prozessoren Intel® Xeon® Gold 6140 und Intel® Xeon® Gold 6240 vorbereitet.

Testbeschreibung- perlbench_r ist eine abgespeckte Version der Perl-Sprache. Die Testlast imitiert die Arbeit des beliebten SpamAssassin-Anti-Spam-Systems.

- deepsjeng_r - Simulation einer Schachpartie. Der Server führt eine eingehende Untersuchung der Spielpositionen mithilfe des Alpha-Beta-Clipping-Algorithmus durch.

- leela_r - Simulation eines Spiels in go. Während des Testens werden Bewegungsmuster analysiert und im Baum anhand der oberen Konfidenzgrenzen selektiv gesucht.

- exchange2_r - Generator für nicht triviale Sudoku-Rätsel. Es wurde in Fortran 95 geschrieben und verwendet die meisten Array-Verarbeitungsfunktionen.

- gcc_s C-Sprachcompiler: Die Testlast „kompiliert“ den GCC-Compiler aus Quellcodes für die IA-32-Mikroprozessorarchitektur.

Aus den Testergebnissen geht hervor, dass die Prozessoren der neuen Generation ganzzahlige Berechnungen schneller durchführen als die vorherige Generation. Wir werden die Ergebnisse anderer Tests in einem der folgenden Artikel veröffentlichen.

Intel® Optane ™ DC-Unterstützung für persistenten Speicher

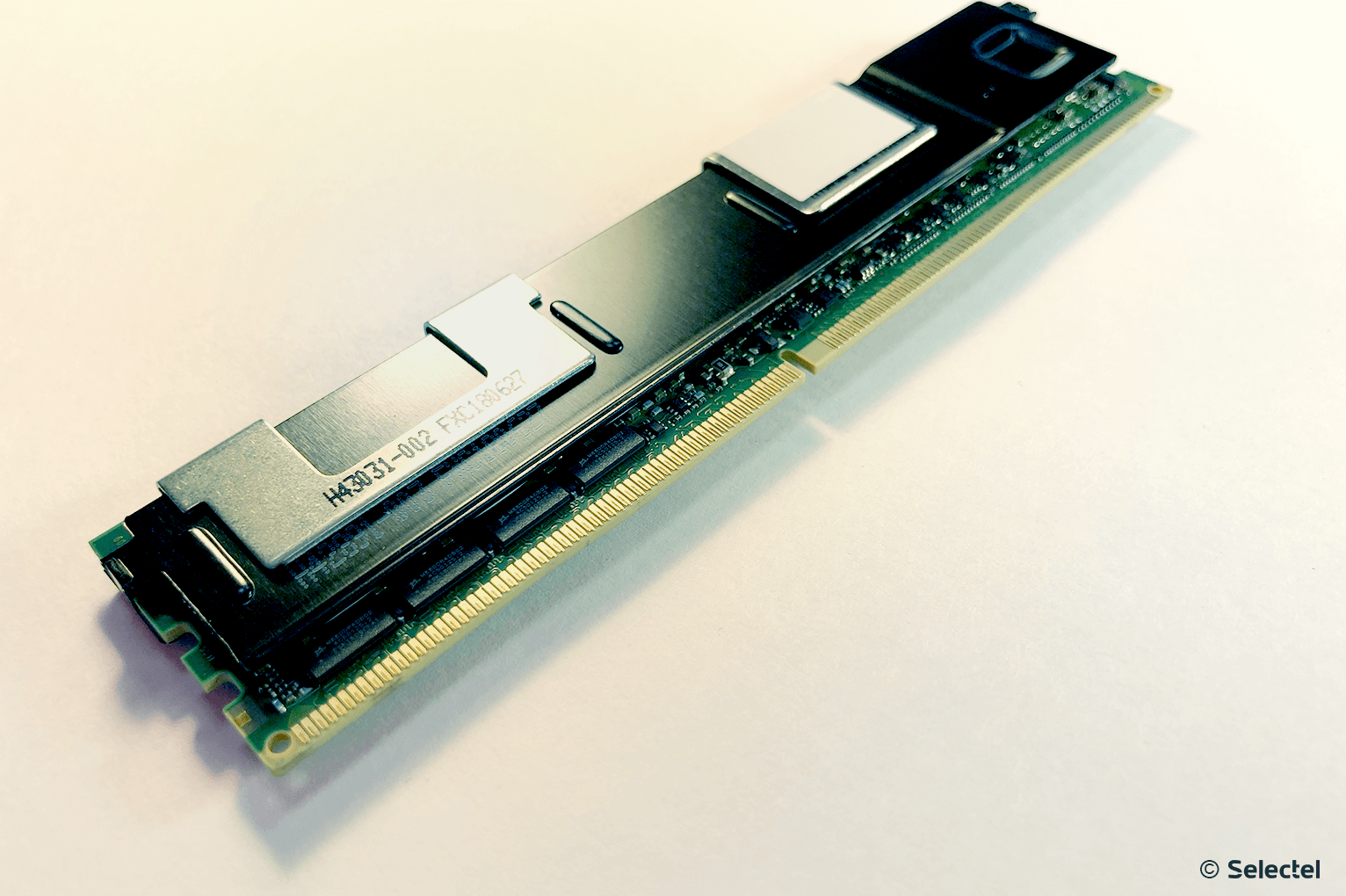

Beschleunigung der Arbeitslast hoch geladener Datenbanken und Anwendungen - das haben alle Kunden von dem bevorstehenden Update erwartet. Eine wichtige Neuerung war daher die Unterstützung von Intel® Optane ™ DC Persistent Memory, besser bekannt unter dem Codenamen Apache Pass.

Dieser Speicher soll eine universelle Lösung für das Problem darstellen, wenn die Verwendung der richtigen DRAM-Menge wirtschaftlich nachteilig ist und die Geschwindigkeitseigenschaften selbst der Flaggschiff-SSDs unzureichend sind.

Ein anschauliches Beispiel ist die Platzierung von Datenbanken direkt im permanenten Intel® Optane ™ DC-Speicher, wodurch kein ständiger Datenaustausch zwischen RAM und einem Speichergerät erforderlich ist (eine Funktion, die herkömmlichen Systemen eigen ist).

Ein neuer Speichertyp wird direkt im DIMM-Steckplatz installiert und ist vollständig mit diesem kompatibel. Module mit folgendem Volumen sind verfügbar:

Mit solch bedeutenden Modulvolumina können Sie die Hardwareplattform flexibel konfigurieren, da Sie einen sehr großen und sehr schnellen Speicherplatz für hoch ausgelastete Systeme erhalten haben. Intel® Optane ™ DC Persistent Memory bietet ein enormes Anwendungspotential, einschließlich maschinellem Lernen.

Schnelleres tiefes Lernen

Neben der Unterstützung eines neuen Speichertyps sorgten die Intel-Ingenieure dafür, den Prozess des Deep Learning zu beschleunigen. Da Faltungs-Neuronale Netze häufig eine Mehrfachmultiplikation von 8- und 16-Bit-Werten erfordern, erhielten die neuen Prozessoren Unterstützung für die

AVX-512-VNNI-Befehle (Vector Neural Network Instructions). Auf diese Weise können Sie die Berechnung mehrmals optimieren und beschleunigen.

Die beste Effizienz wird durch die Implementierung der folgenden Anweisungen erzielt:

- VPDPBUSD (für INT8-Berechnungen),

- VPDPWSSD (für INT16-Berechnungen).

Unter dem Strich soll die Anzahl der pro Zyklus verarbeiteten Artikel reduziert werden. Der

VPDPWSSD- Befehl kombiniert die beiden INT16-Befehle und verwendet auch die INT32-Konstante, um die beiden aktuellen Befehle

PMADDWD und

VPADDD zu ersetzen. Der

VPDPUSB- Befehl reduziert ebenfalls die Anzahl der Elemente, indem die drei vorhandenen Befehle

VPMADDUSBW ,

VPMADDWD und

VPADDD ersetzt werden .

Mit der korrekten Anwendung des neuen Befehlssatzes ist es somit möglich, die Anzahl der verarbeiteten Elemente pro Zyklus um das Zwei- bis Dreifache zu reduzieren und die Geschwindigkeit der Datenverarbeitung zu erhöhen. Ein geeigneter Rahmen für neue Anweisungen wird Teil so beliebter Softwarebibliotheken für maschinelles Lernen wie:

Lastausgleichsoptimierung

Das gleichmäßige Laden von Computerressourcen wurde mit der Intel® Speed Select-Technologie (auf Prozessoren mit einem Index von Y) einfacher. Das Fazit ist, dass jede Operation mit der Anzahl der beteiligten Kerne und der Taktrate verknüpft wird. Abhängig vom ausgewählten Profil jeder Operation werden die Ressourcen wie folgt zugewiesen:

- mehr Kerne, aber mit einer niedrigeren Taktrate;

- weniger Kerne, aber mit erhöhter Taktrate.

Mit diesem Ansatz können Sie Ressourcen vollständig nutzen, was besonders bei der Verwendung virtualisierter Umgebungen wichtig ist. Dies reduziert die Kosten, indem die Belastung der Virtualisierungshosts optimiert wird.

Beschleunigung des wissenschaftlichen Rechnens

Die Verarbeitung wissenschaftlicher Daten, insbesondere bei der Modellierung physikalischer Prozesse auf Partikelebene (z. B. bei der Berechnung elektromagnetischer Wechselwirkungen), erfordert einen enormen parallelen Rechenaufwand. Dieses Problem kann mit einer CPU, GPU oder einem FPGA gelöst werden.

Multi-Core-CPUs sind aufgrund der Vielzahl von Softwaretools und Bibliotheken für die Datenverarbeitung universell einsetzbar. Die Verwendung einer GPU für diese Zwecke ist ebenfalls sehr effektiv, da Sie Tausende paralleler Threads direkt auf Hardware-Grafikkernen ausführen können. Es gibt praktische Frameworks für die Entwicklung wie OpenCL oder CUDA, mit denen Sie mithilfe von

GPU-Computing Anwendungen beliebiger Komplexität erstellen können.

Es gibt jedoch ein anderes Hardware-Tool, über das wir bereits

in früheren Artikeln gesprochen haben - FPGA. Durch die Möglichkeit, solche Geräte für die Durchführung bestimmter Berechnungen zu programmieren, können Sie die Datenverarbeitung beschleunigen und die CPU teilweise entlasten. Ein ähnliches Szenario kann auf neuen Cascade Lake-Prozessoren in Verbindung mit diskreten Intel® Stratix® 10 SX-FPGAs implementiert werden.

Trotz der im Vergleich zu herkömmlichen CPUs niedrigeren Taktrate kann FPGA eine zehnmal höhere Leistung erzielen. Für einige Arten von Aufgaben, wie z. B. die digitale Signalverarbeitung, kann der Intel® Stratix® 10 SX Ergebnisse mit bis zu 10 TFLOPS (Tera-Gleitkommaoperationen pro Sekunde) anzeigen.

Plattformskalierung

Geschäfte in Echtzeit zu tätigen bedeutet nicht nur Stabilität, sondern auch die Fähigkeit, bei Bedarf zu skalieren. Ein gutes Beispiel ist die leistungsstarke SAP-HANA-Plattform zur Datenspeicherung und -verarbeitung. Die physische Bereitstellung dieser Plattform erfordert sehr leistungsfähige Hardwareressourcen.

Intel® Xeon® Scalable-Prozessoren sind so konzipiert, dass Multi-Socket-Systeme zu Kernelementen der IT-Infrastruktur werden und Skalierbarkeit bieten, um den Anforderungen von Geschäftsanwendungen gerecht zu werden.

Dies wird in Form der Unterstützung für externe Knotencontroller implementiert, mit denen Sie Konfigurationen auf einer höheren Ebene erstellen können, als eine einzelne Plattform bieten kann. Sie können beispielsweise eine Konfiguration von 32 physischen Prozessoren erstellen, indem Sie die Ressourcen mehrerer Multi-Socket-Plattformen zu einem Ganzen zusammenfassen.

Fazit

Eine Erhöhung der Betriebsfrequenzen und Prozessorkerne, eine Steigerung der Produktivität und die Unterstützung von Intel® Optane ™ DC Persistent Memory - all diese Verbesserungen erhöhen die Rechenleistung jeder Plattform erheblich, senken die Kosten für die Menge der verwendeten Geräte und erhöhen die Effizienz der Datenverarbeitung. Das auf Architekturebene festgelegte Prinzip der Skalierbarkeit ermöglicht es Ihnen, eine IT-Infrastruktur beliebiger Komplexität aufzubauen und eine hohe Leistung und Energieeffizienz zu erzielen.

Da Selectel ein Intel Platinum-Partner ist, können unsere Kunden

jetzt Intel® Xeon® Scalable-Prozessoren der nächsten Generation auf beliebigen Konfigurationsservern bestellen.

Das Mieten eines Servers mit Prozessoren der nächsten Generation ist einfach! Gehen Sie einfach

zur Konfiguratorseite und wählen Sie die erforderlichen Komponenten aus. Alle Fragen zum Betrieb von Diensten können unseren Spezialisten gestellt werden,

indem Sie ein Ticket im Control Panel

erstellen . Wenn Sie einen Server mehrere Monate im Voraus bezahlen, erhalten Sie einen Rabatt von bis zu 15%.

Wenn Sie daran interessiert sind, die neuesten Technologien zu testen,

treten Sie unserem Selectel Lab bei.

Wir freuen uns über Ihre Fragen und Anregungen in den Kommentaren.