tl; dr:

- Maschinelles Lernen sucht nach Mustern in Daten. Künstliche Intelligenz kann jedoch „voreingenommen“ sein - das heißt, die falschen Muster finden. Beispielsweise kann ein Hautkrebserkennungssystem anhand von Fotos Bildern, die in einer Arztpraxis aufgenommen wurden, besondere Aufmerksamkeit widmen. Maschinelles Lernen weiß nicht, wie es geht : Seine Algorithmen zeigen nur Muster in Zahlen an, und wenn die Daten nicht repräsentativ sind, wird dies auch das Ergebnis ihrer Verarbeitung sein. Und das Auffinden solcher Fehler kann aufgrund der Mechanik des maschinellen Lernens schwierig sein.

- Der offensichtlichste und beängstigendste Problembereich ist die menschliche Vielfalt. Es gibt viele Gründe, warum Daten über Personen bereits in der Erfassungsphase ihre Objektivität verlieren können. Sie sollten jedoch nicht glauben, dass dieses Problem nur Menschen betrifft: Genau die gleichen Schwierigkeiten treten auf, wenn Sie versuchen, eine Überschwemmung in einem Lagerhaus oder einer ausgefallenen Gasturbine zu finden. Einige Systeme weisen möglicherweise Vorurteile hinsichtlich der Hautfarbe auf, andere sind gegen Siemens-Sensoren voreingenommen.

- Solche Probleme sind für maschinelles Lernen nicht neu und für ihn alles andere als einzigartig. In komplexen Strukturen werden falsche Annahmen getroffen, und es ist immer schwer zu verstehen, warum eine Entscheidung getroffen wurde. Es ist notwendig, auf komplexe Weise damit umzugehen: Erstellen Sie Tools und Prozesse zur Überprüfung - und schulen Sie die Benutzer, damit sie den Empfehlungen der KI nicht blind folgen. Maschinelles Lernen macht einige Dinge wirklich viel besser als wir, aber Hunde sind zum Beispiel viel effektiver als Menschen beim Aufspüren von Drogen, was kein Grund ist, sie als Zeugen zu bringen und aufgrund ihrer Aussagen Urteile zu fällen. Und Hunde sind übrigens viel schlauer als jedes maschinelle Lernsystem.

Maschinelles Lernen ist heute einer der wichtigsten grundlegenden Technologietrends. Dies ist eine der wichtigsten Möglichkeiten, wie Technologie die Welt um uns herum im nächsten Jahrzehnt verändern wird. Einige Aspekte dieser Änderungen sind besorgniserregend. Zum Beispiel die möglichen Auswirkungen des maschinellen Lernens auf den Arbeitsmarkt oder seine Verwendung für unethische Zwecke (zum Beispiel autoritäre Regime). Es gibt ein weiteres Problem, dem dieser Beitrag gewidmet ist: die Tendenz der künstlichen Intelligenz .

Das ist eine schwierige Geschichte.

Google AI kann Katzen finden. Diese Nachricht von 2012 war dann etwas Besonderes.

Was ist KI-Voreingenommenheit?

"Rohdaten" sind sowohl ein Widerspruch als auch eine schlechte Idee. Daten müssen gut und sorgfältig aufbereitet werden. - Jeffrey Boker

Irgendwann vor 2013 mussten Sie die logischen Schritte beschreiben, um ein System zu schaffen, das beispielsweise Katzen auf Fotos erkennt. So finden Sie Ecken in einem Bild, erkennen Augen, analysieren Texturen auf Fell, zählen Pfoten usw. Sammeln Sie dann alle Komponenten - und stellen Sie fest, dass dies alles nicht wirklich funktioniert. So etwas wie ein mechanisches Pferd - theoretisch kann es gemacht werden, aber in der Praxis ist es zu kompliziert zu beschreiben. Am Ausgang haben Sie Hunderte (oder sogar Tausende) handgeschriebene Regeln. Und kein einziges Arbeitsmodell.

Mit dem Aufkommen des maschinellen Lernens haben wir aufgehört, „manuelle“ Regeln zum Erkennen eines Objekts zu verwenden. Stattdessen nehmen wir tausend Stichproben des „einen“ X, tausend Stichproben des „anderen“ Y und zwingen den Computer, auf der Grundlage ihrer statistischen Analyse ein Modell zu erstellen. Dann geben wir diesem Modell einige Beispieldaten und es bestimmt mit einiger Genauigkeit, ob es zu einem der Sätze passt. Maschinelles Lernen generiert ein Modell basierend auf Daten, nicht mit Hilfe der Person, die es schreibt. Die Ergebnisse sind beeindruckend, insbesondere im Bereich der Bild- und Mustererkennung. Deshalb setzt die gesamte Tech-Industrie jetzt auf maschinelles Lernen (ML).

Aber nicht so einfach. In der realen Welt enthalten Ihre Tausenden von Beispielen für X oder Y auch A, B, J, L, O, R und sogar L. Sie können ungleichmäßig verteilt sein, und einige von ihnen können so oft gefunden werden, dass das System ihnen mehr Aufmerksamkeit schenkt als zu Objekten, die Sie interessieren.

Was bedeutet das in der Praxis? Mein Lieblingsbeispiel ist, wenn Bilderkennungssysteme auf einen grasbewachsenen Hügel schauen und „Schaf“ sagen . Es ist verständlich, warum: Die meisten Beispielfotos der „Schafe“ wurden auf den Wiesen aufgenommen, auf denen sie leben, und in diesen Bildern nimmt das Gras viel mehr Platz ein als die kleinen weißen Flusen, und es ist das Gras des Systems, das als das wichtigste angesehen wird.

Es gibt ernstere Beispiele. Aus jüngster Zeit - ein Projekt zur Erkennung von Hautkrebs auf Fotografien. Es stellte sich heraus, dass Dermatologen die Aufstellung häufig zusammen mit den Manifestationen von Hautkrebs fotografieren, um die Größe der Formationen zu bestimmen. Auf Beispielen von Fotografien gesunder Haut gibt es keine Lineale. Für das KI-System sind solche Lineale (genauer gesagt Pixel, die wir als „Lineal“ definieren) zu einem der Unterschiede zwischen Beispielsätzen geworden und manchmal wichtiger als ein kleiner Hautausschlag. So erkannte ein System zur Identifizierung von Hautkrebs manchmal stattdessen die Linie.

Der entscheidende Punkt hierbei ist, dass das System kein semantisches Verständnis dafür hat, was es betrachtet. Wir betrachten eine Reihe von Pixeln und sehen ein Schaf, eine Haut oder Herrscher in ihnen und das System - nur eine Zahlenreihe. Sie sieht keinen dreidimensionalen Raum, sie sieht weder Objekte noch Texturen noch Schafe. Sie sieht nur Muster in den Daten.

Die Schwierigkeit bei der Diagnose solcher Probleme besteht darin, dass das neuronale Netzwerk (das von Ihrem maschinellen Lernsystem generierte Modell) aus Tausenden von Hunderttausenden von Knoten besteht. Es gibt keine einfache Möglichkeit, in ein Modell zu schauen und zu sehen, wie es eine Entscheidung trifft. Das Vorhandensein einer solchen Methode würde bedeuten, dass der Prozess einfach genug ist, um alle Regeln manuell zu beschreiben, ohne maschinelles Lernen zu verwenden. Die Menschen befürchten, dass maschinelles Lernen zu einer Art Black Box geworden ist. (Ich werde etwas später erklären, warum dieser Vergleich immer noch zu viel ist.)

Im Allgemeinen ist dies das Problem der Verzerrung der künstlichen Intelligenz oder des maschinellen Lernens: Ein System zum Auffinden von Mustern in Daten kann falsche Muster finden, aber Sie bemerken es möglicherweise nicht. Dies ist ein grundlegendes Merkmal der Technologie, und es ist für jeden offensichtlich, der in der wissenschaftlichen Gemeinschaft und in großen Technologieunternehmen damit arbeitet. Aber seine Konsequenzen sind komplex, ebenso wie unsere möglichen Lösungen für diese Konsequenzen.

Lassen Sie uns zuerst über die Konsequenzen sprechen.

KI kann für uns implizit eine Entscheidung zugunsten bestimmter Personengruppen treffen, basierend auf einer großen Anzahl unauffälliger Signale

KI-Bias-Szenarien

Das offensichtlichste und beängstigendste ist, dass sich dieses Problem in Bezug auf die menschliche Vielfalt manifestieren kann. Vor kurzem wurde das Gerücht verbreitet , Amazon habe versucht, ein maschinelles Lernsystem für das erste Screening von Bewerbern aufzubauen. Da es unter Amazon-Arbeitnehmern mehr Männer gibt, gibt es auch häufiger Beispiele für „erfolgreiche Einstellungen“ als Männer, und es gab mehr Männer bei der Auswahl der vom System vorgeschlagenen Lebensläufe. Amazon hat dies bemerkt und das System nicht in der Produktion freigegeben.

Das Wichtigste in diesem Beispiel ist, dass das System angeblich männliche Kandidaten bevorzugt hat, obwohl das Geschlecht nicht im Lebenslauf aufgeführt war. Das System sah andere Muster in Beispielen für „erfolgreiche Einstellung“: Beispielsweise können Frauen spezielle Wörter verwenden, um Erfolge zu beschreiben, oder spezielle Hobbys haben. Natürlich wusste das System nicht, was „Hockey“ ist, wer „Menschen“ sind oder was „Erfolg“ ist - es führte lediglich eine statistische Analyse des Textes durch. Aber die Muster, die sie sah, wären höchstwahrscheinlich von der Person unbemerkt geblieben, und einige von ihnen (zum Beispiel die Tatsache, dass Menschen unterschiedlichen Geschlechts den Erfolg unterschiedlich beschreiben), wäre für uns wahrscheinlich schwierig zu sehen, selbst wenn wir sie betrachten.

Weiter schlimmer. Ein maschinelles Lernsystem, das Krebs auf blasser Haut sehr gut findet, kann bei dunkler Haut schlechter funktionieren oder umgekehrt. Nicht unbedingt aufgrund von Voreingenommenheit, sondern weil Sie wahrscheinlich ein separates Modell für eine andere Hautfarbe erstellen müssen, indem Sie andere Eigenschaften auswählen. Maschinelle Lernsysteme sind selbst in einem so engen Bereich wie der Bilderkennung nicht austauschbar. Sie müssen das System einrichten, manchmal einfach durch Ausprobieren, um die Funktionen in den Daten, an denen Sie interessiert sind, gut zu erkennen, bis Sie die gewünschte Genauigkeit erreicht haben. Möglicherweise bemerken Sie jedoch nicht, dass das System in 98% der Fälle genau ist, wenn Sie mit einer Gruppe arbeiten, und nur in 91% (obwohl dies genauer ist als die von einer Person durchgeführte Analyse) in der anderen.

Bisher habe ich hauptsächlich Beispiele in Bezug auf Menschen und ihre Eigenschaften verwendet. Die Diskussion um dieses Problem konzentriert sich hauptsächlich auf dieses Thema. Es ist jedoch wichtig zu verstehen, dass die Voreingenommenheit gegenüber Menschen nur ein Teil des Problems ist. Wir werden maschinelles Lernen für viele Dinge verwenden, und ein Stichprobenfehler wird für alle relevant sein. Wenn Sie jedoch mit Personen arbeiten, hängt die Datenverzerrung möglicherweise nicht mit diesen zusammen.

Um dies zu verstehen, kehren wir zum Beispiel mit Hautkrebs zurück und betrachten drei hypothetische Möglichkeiten des Systemausfalls.

- Inhomogene Verteilung von Menschen: Eine unausgewogene Anzahl von Hautaufnahmen in verschiedenen Farbtönen, die zu falsch positiven oder falsch negativen Ergebnissen im Zusammenhang mit der Pigmentierung führen.

- Die Daten, auf denen das System trainiert wird, enthalten ein häufig anzutreffendes und heterogen verteiltes Merkmal, das nicht mit Menschen zusammenhängt und keinen diagnostischen Wert hat: ein Lineal auf Fotos von Hautkrebsmanifestationen oder Gras auf Fotos von Schafen. In diesem Fall ist das Ergebnis anders, wenn das System Pixel im Bild von etwas findet, das das menschliche Auge als „Lineal“ definiert.

- Die Daten enthalten ein Merkmal eines Drittanbieters, das eine Person nicht sehen kann, selbst wenn sie danach sucht.

Was bedeutet das? Wir wissen a priori, dass Daten von verschiedenen Personengruppen unterschiedlich dargestellt werden können, und wir können zumindest planen, nach solchen Ausnahmen zu suchen. Mit anderen Worten, es gibt eine Reihe sozialer Gründe anzunehmen, dass Daten zu Personengruppen bereits eine gewisse Verzerrung enthalten. Wenn wir uns das Foto mit dem Lineal ansehen, werden wir dieses Lineal sehen - wir haben es zuvor einfach ignoriert, wissend, dass es keine Rolle spielt, und vergessen, dass das System nichts weiß.

Aber was wäre, wenn alle Ihre Fotos von ungesunder Haut in einem Büro aufgenommen würden, in dem Glühbirnen verwendet werden, und das bei fluoreszierendem Licht gesund ist? Was ist, wenn Sie nach dem Entfernen gesunder Haut vor dem Aufnehmen ungesunder Aufnahmen das Betriebssystem des Telefons aktualisiert haben und Apple oder Google den Rauschunterdrückungsalgorithmus ein wenig geändert haben? Eine Person kann dies nicht bemerken, egal wie sehr sie nach solchen Merkmalen sucht. Aber dann wird das Maschinennutzungssystem es sofort sehen und verwenden. Sie weiß nichts.

Während wir über falsche Korrelationen gesprochen haben, kann es vorkommen, dass die Daten korrekt und die Ergebnisse korrekt sind, Sie sie jedoch aus ethischen, rechtlichen oder administrativen Gründen nicht verwenden möchten. In einigen Ländern ist es beispielsweise nicht möglich, Frauen einen Rabatt auf die Versicherung zu gewähren, obwohl Frauen beim Fahren möglicherweise sicherer sind. Wir können uns leicht ein System vorstellen, das bei der Analyse historischer Daten weiblichen Namen geringere Risikofaktoren zuweist. Ok, lassen Sie uns die Namen aus der Auswahl entfernen. Denken Sie jedoch an das Beispiel bei Amazon: Das System kann das Geschlecht anhand anderer Faktoren bestimmen (obwohl es nicht weiß, welches Geschlecht und welche Maschine es ist), und Sie werden dies erst bemerken, wenn die Regulierungsbehörde die von Ihnen angebotenen Tarife rückwirkend analysiert und Ihnen keine Gebühren berechnet dir geht es gut

Schließlich wird oft impliziert, dass wir solche Systeme nur für Projekte verwenden, die sich auf Menschen und soziale Interaktionen beziehen. Es ist nicht so. Wenn Sie Gasturbinen herstellen, möchten Sie wahrscheinlich maschinelles Lernen auf Telemetrie anwenden, die von Dutzenden oder Hunderten von Sensoren auf Ihrem Produkt übertragen wird (Audio, Video, Temperatur und andere Sensoren erzeugen Daten, die sehr einfach angepasst werden können, um ein Modell für maschinelles Lernen zu erstellen ) Hypothetisch kann man sagen: „Hier sind die Daten von tausend ausgefallenen Turbinen, die vor ihrem Ausfall erhalten wurden, aber hier sind die Daten von tausend ausgefallenen Turbinen, die nicht kaputt gegangen sind. Erstellen Sie ein Modell, um zu sagen, was der Unterschied zwischen ihnen ist. “ Stellen Sie sich nun vor, dass Siemens-Sensoren 75% der schlechten und nur 12% der guten Turbinen kosten (es besteht kein Zusammenhang mit Ausfällen). Das System wird ein Modell zur Lokalisierung von Turbinen mit Siemens-Sensoren erstellen. Ups!

Bild - Moritz Hardt, UC Berkeley

AI Bias Management

Was können wir dagegen tun? Sie können das Problem von drei Seiten angehen:

- Methodische Genauigkeit bei der Erfassung und Verwaltung von Daten für das Training des Systems.

- Technische Werkzeuge zur Analyse und Diagnose des Modellverhaltens.

- Schulung, Ausbildung und Vorsicht bei der Einführung von maschinellem Lernen in Produkte.

In Molieres Buch "Der Händler im Adel" gibt es einen Witz: Einem Mann wurde gesagt, dass Literatur in Prosa und Poesie unterteilt ist, und er bewundert mit Bewunderung, dass er sein ganzes Leben lang Prosa gesprochen hat, ohne es zu wissen. Wahrscheinlich fühlen sich Statistiker heute irgendwie so: Ohne es zu merken, widmeten sie ihre Karriere der künstlichen Intelligenz und Stichprobenfehlern. Um nach einem Stichprobenfehler zu suchen und sich darüber Sorgen zu machen, ist dies kein neues Problem. Wir müssen uns nur systematisch seiner Lösung nähern. Wie oben erwähnt, ist es in einigen Fällen wirklich einfacher, dies zu tun, indem die mit Personendaten verbundenen Probleme untersucht werden. Wir gehen a priori davon aus, dass wir Vorurteile über verschiedene Personengruppen haben, aber es fällt uns schwer, uns ein Vorurteil über Siemens-Sensoren vorzustellen.

Das Neue daran ist natürlich, dass die Menschen nicht mehr direkt an statistischen Analysen beteiligt sind. Es wird von Maschinen ausgeführt, die große komplexe Modelle erstellen, die schwer zu verstehen sind. Das Thema Transparenz ist einer der Hauptaspekte des Bias-Problems. Wir befürchten, dass das System nicht nur voreingenommen ist, sondern dass es keine Möglichkeit gibt, seine Voreingenommenheit zu erkennen, und dass sich maschinelles Lernen von anderen Formen der Automatisierung unterscheidet, die aus klaren logischen Schritten bestehen sollen, die überprüft werden können.

Hier gibt es zwei Probleme. Vielleicht können wir trotzdem ein Audit von maschinellen Lernsystemen durchführen. Und die Prüfung eines anderen Systems ist eigentlich gar nicht einfacher.

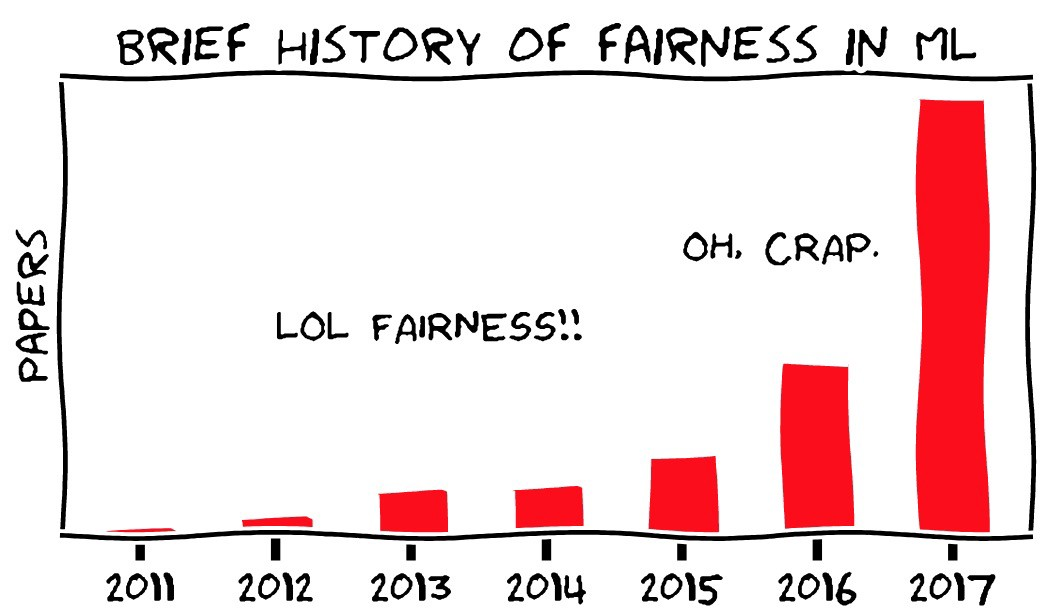

Erstens ist einer der Bereiche der modernen Forschung auf dem Gebiet des maschinellen Lernens die Suche nach Methoden zur Identifizierung der wichtigen Funktionalität maschineller Lernsysteme. Gleichzeitig ist maschinelles Lernen (in seinem gegenwärtigen Zustand) ein völlig neues Gebiet der Wissenschaft, das sich schnell verändert. Sie sollten also nicht glauben, dass Dinge, die heute unmöglich sind, nicht bald ganz real werden können. Das OpenAI- Projekt ist ein interessantes Beispiel dafür.

Zweitens ist die Idee, dass es möglich ist, den Entscheidungsprozess in bestehenden Systemen oder Organisationen zu überprüfen und zu verstehen, theoretisch gut, in der Praxis jedoch mittelmäßig. Zu verstehen, wie Entscheidungen in einer großen Organisation getroffen werden, ist alles andere als einfach. Selbst wenn es dort einen formalen Entscheidungsprozess gibt, spiegelt dieser nicht wider, wie Menschen tatsächlich interagieren, und tatsächlich haben sie oft keinen logischen systematischen Ansatz, um ihre Entscheidungen zu treffen. Wie mein Kollege Vijay Pande sagte , sind Menschen auch Black Boxes .

Nehmen Sie tausend Menschen in mehreren sich überschneidenden Unternehmen und Institutionen, und das Problem wird noch komplizierter. Wir wissen nach der Tatsache, dass das Space Shuttle bei ihrer Rückkehr auseinanderfallen sollte und einige Leute innerhalb der NASA Informationen hatten, die ihnen Grund zu der Annahme gaben, dass etwas Schlimmes passieren könnte, aber das gesamte System wusste es nicht. Die NASA hat sogar gerade ein ähnliches Audit bestanden, nachdem sie das vorherige Shuttle verloren hatte, und dennoch ein weiteres - aus einem sehr ähnlichen Grund. Es ist leicht zu sagen, dass Organisationen und Menschen klare logische Regeln befolgen, die überprüft, verstanden und geändert werden können - aber die Erfahrung beweist das Gegenteil. Dies ist der " Fehler der staatlichen Planungskommission ".

Ich vergleiche maschinelles Lernen oft mit Datenbanken, insbesondere relationalen - einer neuen grundlegenden Technologie, die die Möglichkeiten der Informatik und der Welt um sie herum verändert hat und zu einem Teil von allem geworden ist, was wir ständig nutzen, ohne es zu merken. Datenbanken haben ebenfalls Probleme und eine ähnliche Eigenschaft: Das System kann auf falschen Annahmen oder auf schlechten Daten basieren, ist jedoch schwer zu bemerken, und Benutzer des Systems tun das, was es ihnen sagt, ohne Fragen zu stellen. Es gibt eine Menge alter Witze über Steuerarbeiter, die Ihren Namen einmal falsch geschrieben haben, und es ist viel schwieriger, sie davon zu überzeugen, den Fehler zu korrigieren, als den Namen tatsächlich zu ändern. Dies kann auf verschiedene Arten gedacht werden, aber es ist nicht klar, wie am besten: wie wäre es mit einem technischen Problem in SQL oder mit einem Fehler in der Oracle-Version oder mit dem Ausfall bürokratischer Institutionen? Wie schwierig ist es, einen Fehler im Prozess zu finden, der dazu geführt hat, dass das System nicht über eine Funktion wie die Korrektur von Tippfehlern verfügt? Könnte dies verstanden werden, bevor sich Leute beschweren?

Noch einfacher ist dieses Problem, das durch Geschichten veranschaulicht wird, wenn Fahrer aufgrund veralteter Daten im Navigator zu den Flüssen fahren. Ok, Karten müssen ständig aktualisiert werden. Aber wie viel ist TomTom dafür verantwortlich, dass Ihr Auto ins Meer bläst?

Ich sage dies zu der Tatsache, dass ja - die Tendenz des maschinellen Lernens Probleme verursachen wird. Diese Probleme ähneln jedoch denen, auf die wir in der Vergangenheit gestoßen sind, und sie können ungefähr so gut wahrgenommen und gelöst werden (oder auch nicht) wie in der Vergangenheit. , , , , . , - - , , . “ ” , , , , . . , . .

Fazit

, , — , .

, « » . , — . HAL9000 Skynet — -, . Aber nein. , , , . , , … . . , , , - . , — , , .

, — , — . , , .

, , « — , » . , « ». , , , . , . , — , , , . , , .

Übersetzung: Diana Letskaya .

Redaktion: Alexey Ivanov .

Community: @PonchikNews .