IEEE P802.3ba, ein Standard für die Übertragung von Daten über 100-Gigabit-Ethernet-Kanäle (100 GbE), wurde von 2007 bis 2010 entwickelt [3], wurde jedoch erst 2018 weit verbreitet [5]. Warum 2018 und nicht früher? Und warum sofort in Scharen? Es gibt mindestens fünf Gründe ...

IEEE P802.3ba wurde in erster Linie entwickelt, um die Anforderungen von Rechenzentren und die Anforderungen von Internet-Verkehrsaustauschstellen (zwischen unabhängigen Betreibern) zu erfüllen. sowie um den reibungslosen Betrieb ressourcenintensiver Webdienste wie Portale mit einer großen Menge an Videoinhalten (z. B. YouTube) sicherzustellen; und für Hochleistungsrechnen. [3] Normale Internetnutzer tragen auch dazu bei, die Bandbreitenanforderungen zu ändern: Viele verfügen über Digitalkameras, und die Benutzer möchten die von ihnen aufgenommenen Inhalte über das Internet übertragen. T.O. Das Volumen der Inhalte, die im Laufe der Zeit über das Internet verbreitet werden, wird immer größer. Sowohl auf professioneller als auch auf Verbraucherebene. In all diesen Fällen hat die Gesamtbandbreite der wichtigsten Netzwerkknoten beim Übertragen von Daten von einer Domäne in eine andere die Funktionen von 10-GbE-Ports lange überschritten. [1] Dies ist der Grund für das Erscheinen eines neuen Standards: 100 GbE.

Große Rechenzentren und Cloud-Service-Provider nutzen 100 GbE bereits aktiv und planen, in einigen Jahren schrittweise auf 200 GbE und 400 GbE umzusteigen. Gleichzeitig beobachten sie bereits Geschwindigkeiten, die über Terabit hinausgehen. [6] Obwohl es einige große Anbieter gibt, die erst im letzten Jahr auf 100 GbE umsteigen (z. B. Microsoft Azure). Rechenzentren, die Hochleistungs-Computing für Finanzdienstleistungen, Regierungsplattformen, Öl- und Gasplattformen und Versorgungsunternehmen durchführen, haben ebenfalls mit der Umstellung auf 100 GbE begonnen. [5]

In Unternehmens-Rechenzentren ist die Bandbreitennachfrage etwas geringer: 10 GbE sind hier erst seit kurzem ein dringender Bedarf und kein Luxus. Da der Verkehrsverbrauch jedoch schneller zunimmt, ist es zweifelhaft, dass 10 GbE mindestens 10 oder sogar 5 Jahre in Rechenzentren von Unternehmen leben wird. Stattdessen werden wir einen schnellen Übergang zu 25 GbE und noch schneller zu 100 GbE sehen. [6] Laut Intel-Analysten steigt die Verkehrsintensität im Rechenzentrum jährlich um 25%. [5]

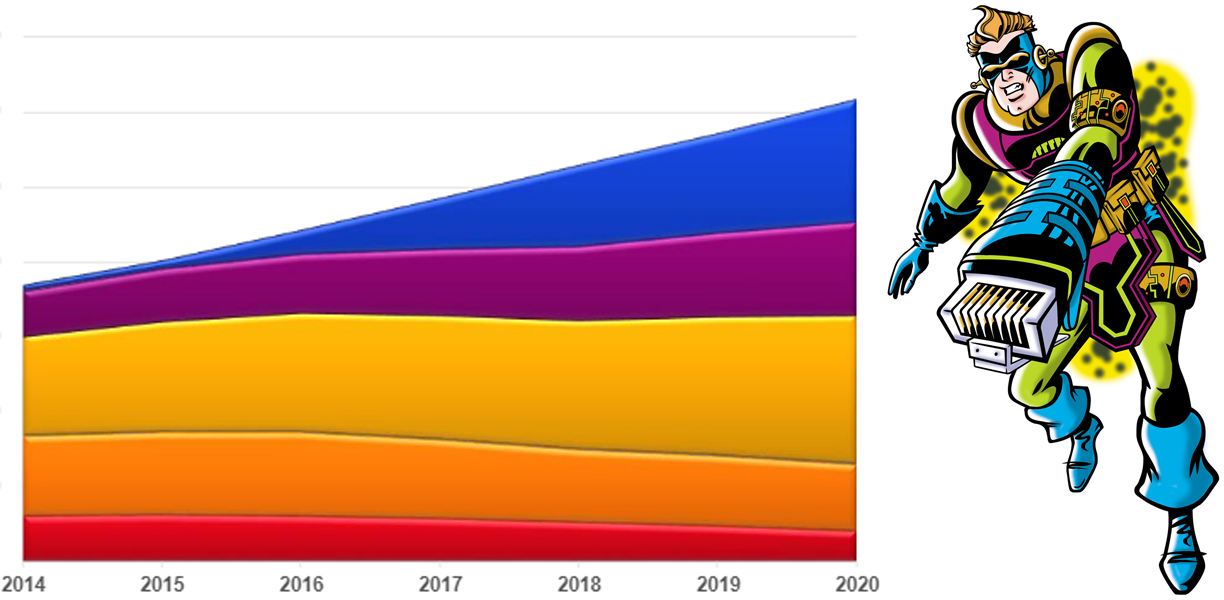

Analysten von Dell und Hewlett Packard [4] geben an, dass 2018 das Jahr von 100 GbE für Rechenzentren ist. Bereits im August 2018 verdoppelten die Lieferungen von 100-GbE-Geräten die Lieferungen für das gesamte Jahr 2017. Und das Angebotstempo wächst weiter, da sich Rechenzentren massenhaft von 40 GbE entfernen. Es wird erwartet, dass bis 2022 jährlich 19,4 Millionen 100-GbE-Ports ausgeliefert werden (im Vergleich dazu waren es 2017 4,6 Millionen). [4] In Bezug auf die Kosten wurden 2017 7 Mrd. USD für 100-GbE-Häfen ausgegeben, und für 2020 werden voraussichtlich 20 Mrd. USD ausgegeben (siehe Abbildung 1). [1]

Abbildung 1. Statistiken und Prognosen zur Nachfrage nach Netzwerkgeräten

Warum jetzt? 100 GbE ist keine so neue Technologie. Warum herrscht derzeit so viel Aufsehen?

1) Weil diese Technologie ausgereift und billiger geworden ist. 2018 haben wir die Grenze überschritten, als die Verwendung von Plattformen mit 100-Gigabit-Ports im Rechenzentrum kostengünstiger wurde als das „Stapeln“ mehrerer 10-Gigabit-Plattformen. Beispiel: Ciena 5170 (siehe Abbildung 2) ist eine kompakte Plattform mit einem Gesamtdurchsatz von 800 GbE (4 x 100 GbE, 40 x 10 GbE). Wenn mehrere 10-Gigabit-Ports erforderlich sind, um den erforderlichen Durchsatz zu erzielen, summieren sich die Kosten für zusätzliches Bügeleisen, zusätzlichen Platz, übermäßigen Stromverbrauch, Wartung, zusätzliche Ersatzteile und zusätzliche Kühlsysteme zu einer recht ordentlichen Summe. [1] Zum Beispiel kamen die Spezialisten von Hewlett Packard, die die potenziellen Vorteile einer Umstellung von 10 GbE auf 100 GbE analysierten, zu folgenden Zahlen: höhere Leistung (56%), geringere Gesamtkosten (27%), weniger Stromverbrauch (31%), Vereinfachung Kabelverbindungen (um 38%). [5]

Abbildung 2. Ciena 5170: Eine Beispielplattform mit 100 Gigabit-Ports

2) Juniper und Cisco haben endlich ihre eigenen ASIC-Chips für 100-GbE-Switches entwickelt. [5] Dies ist eine beredte Bestätigung dafür, dass die 100-GbE-Technologie wirklich reif ist. Tatsache ist, dass es kostengünstig ist, ASIC-Mikroschaltungen nur dann zu erstellen, wenn zum einen die auf ihnen implementierte Logik in absehbarer Zukunft keine Änderungen erfordert und zum anderen eine große Anzahl identischer Mikroschaltungen hergestellt wird. Juniper und Cisco würden diese ASICs nicht produzieren, ohne von der Reife von 100 GbE überzeugt zu sein.

3) Weil Broadcom, Cavium und Mellanox Technologie damit begonnen haben, Prozessoren mit 100-GbE-Unterstützung zu lochen, und diese Prozessoren bereits in Switches von Herstellern wie Dell, Hewlett Packard, Huawei Technologies, Lenovo Group usw. verwendet werden. [5]

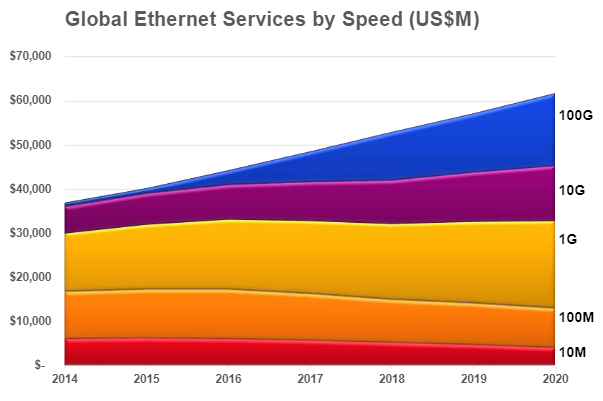

4) Da Server in Server-Racks zunehmend mit den neuesten Intel-Netzwerkadaptern (siehe Abbildung 3) mit zwei 25-Gigabit-Ports und manchmal sogar konvergierten Netzwerkadaptern mit zwei 40-Gigabit-Ports (XXV710 und XL710) ausgestattet sind .

Abbildung 3. Neueste Intel-Netzwerkadapter: XXV710 und XL710

5) Da 100-GbE-Geräte abwärtskompatibel sind, was die Bereitstellung vereinfacht: Sie können bereits verdrahtete Kabel wiederverwenden (schließen Sie einfach einen neuen Transceiver an diese an).

Darüber hinaus bereitet uns die Verfügbarkeit von 100 GbE auf neue Technologien wie NVMe over Fabrics vor (z. B. Samsung Evo Pro 256 GB NVMe PCIe SSD; siehe Abb. 4) [8, 10], Storage Area Network (SAN) / „Software Defined Storage“ (siehe Abb. 5) [7], RDMA [11], die ohne 100 GbE ihr volles Potenzial nicht erreichen könnten.

Abbildung 4. Samsung Evo Pro 256 GB NVMe PCIe SSD

Abbildung 5. „Storage Area Network“ (SAN) / „Software Defined Storage“

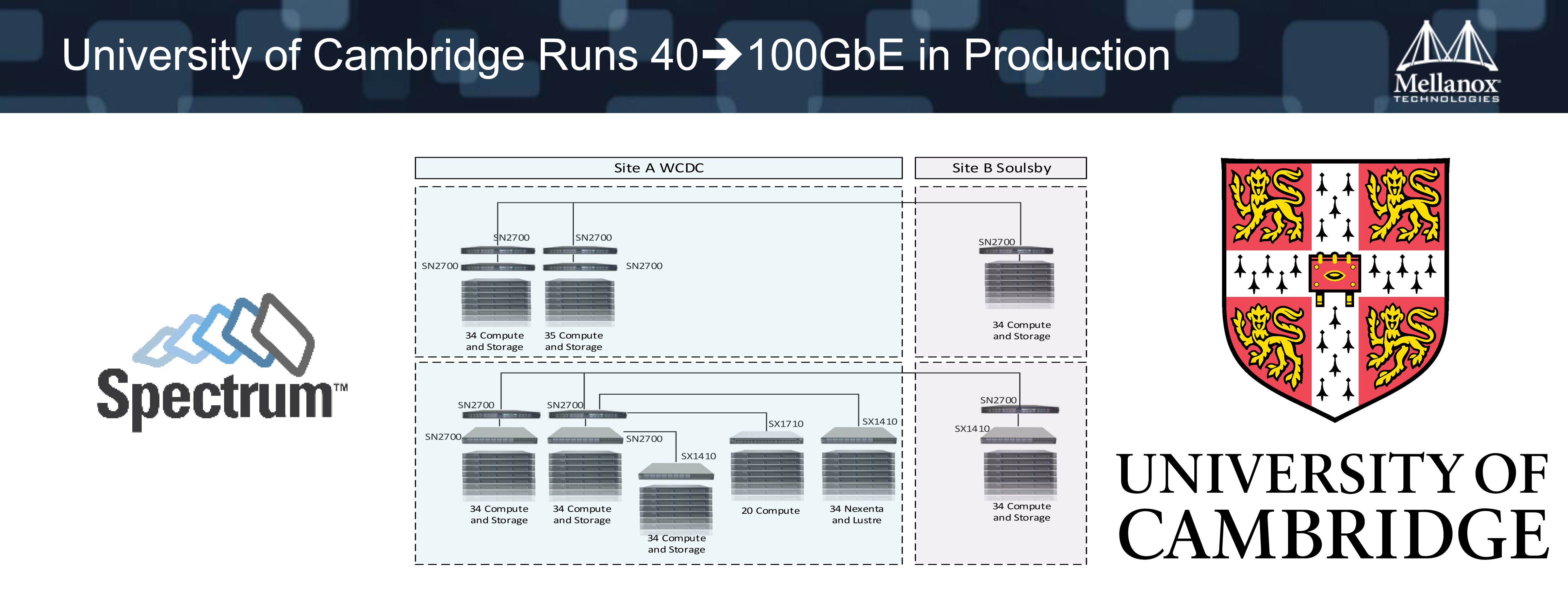

Als exotisches Beispiel für die praktische Relevanz der Verwendung von 100 GbE und verwandten Hochgeschwindigkeitstechnologien können wir schließlich die wissenschaftliche Cloud der Universität Cambridge (siehe Abb. 6) anführen, die auf der Basis von 100 GbE (Spectrum SN2700 Ethernet-Switches) aufgebaut ist. Stellen Sie den effizienten Betrieb des verteilten NexentaEdge SDS-Festplattenspeichers sicher, der ein 10/40-GbE-Netzwerk leicht überlasten kann. [2] Solche wissenschaftlichen Hochleistungswolken werden eingesetzt, um eine Vielzahl angewandter wissenschaftlicher Probleme zu lösen [9, 12]. Beispielsweise verwenden Mediziner solche Wolken, um das menschliche Genom zu entschlüsseln, und 100-GbE-Kanäle werden verwendet, um Informationen zwischen Forschungsgruppen von Universitäten zu übertragen.

Abbildung 6. Fragment einer wissenschaftlichen Wolke an der Universität Cambridge