Wir sprechen von zwei Regeln, die ebenfalls an Relevanz verlieren.

/ Foto Laura Ockel Unsplash

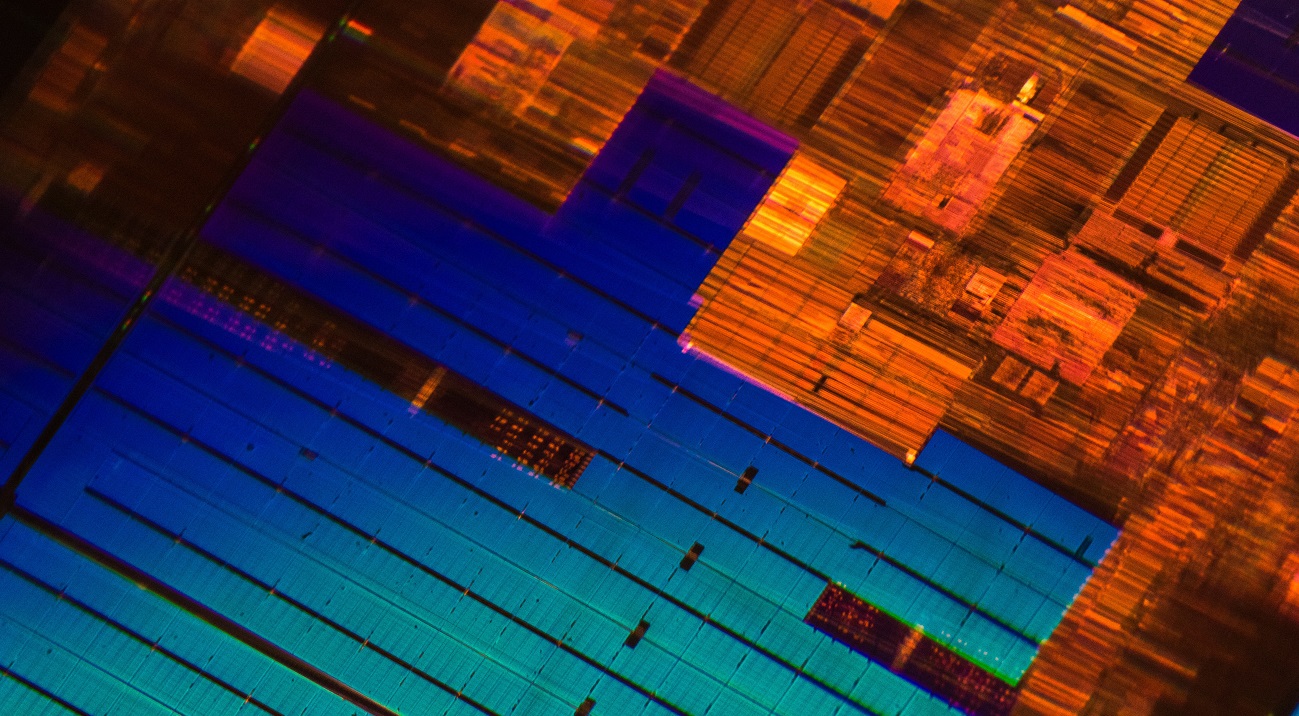

/ Foto Laura Ockel UnsplashMoores Gesetz wurde vor mehr als fünfzig Jahren formuliert. Während dieser ganzen Zeit blieb er größtenteils fair. Selbst heute, wenn von einem technologischen Prozess zu einem anderen gewechselt wird,

steigt die Dichte der Transistoren auf einem Chip

ungefähr zweimal an . Es gibt jedoch ein Problem: Die Geschwindigkeit der Entwicklung neuer technologischer Prozesse verlangsamt sich.

Zum Beispiel hat Intel die Massenproduktion seiner 10-Nanometer-Ice-Lake-Prozessoren schon lange eingestellt. Obwohl der IT-Riese nächsten Monat mit dem Versand von Geräten beginnen wird, erfolgte die Ankündigung der Architektur vor etwa

zweieinhalb Jahren. Ebenfalls im August letzten Jahres hat der Hersteller von integrierten Schaltkreisen von GlobalFoundries, der mit AMD zusammengearbeitet hat,

die Entwicklung der 7-nm-Prozesstechnologie eingestellt (die Gründe für diese Entscheidung haben wir

in unserem Blog auf Habr besprochen).

Journalisten und

Führungskräfte großer IT-Unternehmen prophezeien seit Jahren den Tod für Moores Gesetz. Sogar Gordon selbst hat

einmal erklärt, dass die von ihm formulierte Regel nicht mehr gelten würde. Das Gesetz von Moore ist jedoch nicht das einzige Gesetz, das an Relevanz verliert und bei dem Hersteller von Prozessoren gleich sind.

Dennards Skalierungsgesetz

Es wurde 1974 von Robert Dennard, Ingenieur und Entwickler von DRAM mit dynamischem Speicher, zusammen mit Kollegen von IBM formuliert. Die Regel lautet wie folgt:

"Durch Verringern der Größe des Transistors und Erhöhen der Prozessortaktgeschwindigkeit können wir seine Leistung leicht steigern."

Die Dennard-Regel legte die Verringerung der Leiterbreite (Prozesstechnologie) als Hauptindikator für den Fortschritt in der Mikroprozessortechnologie fest. Das Skalierungsgesetz von Dennard galt jedoch um 2006 nicht mehr. Die Anzahl der Transistoren in den Chips nimmt weiter zu, aber diese Tatsache

führt nicht zu einer signifikanten Steigerung der Geräteleistung.

Zum Beispiel sagen Vertreter von TSMC (einem Halbleiterhersteller), dass die Umstellung von der 7-nm-Prozesstechnologie auf 5-nm die Prozessortaktrate nur um 15%

erhöht .

Der Grund für die Verlangsamung des Frequenzwachstums ist der Verlust von Strömen, den Dennard Ende der 70er Jahre nicht berücksichtigt hat. Mit einer Verringerung der Größe des Transistors und einer Erhöhung der Frequenz beginnt der Strom, die Mikroschaltung stärker zu erwärmen, was sie beschädigen kann. Daher müssen die Hersteller die vom Prozessor zugewiesene Leistung ausgleichen. Infolgedessen wurde die Frequenz von Massenchips seit 2006 auf etwa 4 bis 5 GHz festgelegt.

/ Foto von Jason Leung Unsplash

/ Foto von Jason Leung UnsplashHeute arbeiten Ingenieure an neuen Technologien, die das Problem lösen und die Leistung von Mikrochips steigern. Zum Beispiel entwickeln Experten aus Australien

einen Metall-Luft-Transistor mit einer Frequenz von mehreren hundert Gigahertz. Der Transistor besteht aus zwei Metallelektroden, die als Drain und Source dienen und sich in einem Abstand von 35 nm befinden. Sie tauschen aufgrund des Phänomens der

Feldemission Elektronen miteinander aus.

Laut den Entwicklern können Sie mit ihrem Gerät aufhören, die Reduzierung technologischer Prozesse zu verfolgen, und sich darauf konzentrieren, leistungsstarke 3D-Strukturen mit einer großen Anzahl von Transistoren auf einem Chip zu erstellen.

Kumi-Regel

Es wurde 2011 von Stanford-Professor Jonathan Koomey formuliert. Zusammen mit Kollegen von Microsoft, Intel und der Carnegie Mellon University

analysierte er Informationen über den Energieverbrauch von Computersystemen, beginnend mit dem 1946 gebauten ENIAC-Computer. Infolgedessen kam Kumi zu folgendem Schluss:

„Das Rechenvolumen pro Kilowatt Energie unter statischer Last verdoppelt sich alle anderthalb Jahre.“

Gleichzeitig stellte er fest, dass der Energieverbrauch von Computern in den letzten Jahren ebenfalls gestiegen ist.

2015 kehrte Kumi zu seiner Arbeit zurück und ergänzte die Studie mit neuen Daten. Er stellte fest, dass sich der von ihm beschriebene Trend verlangsamt hatte. Die durchschnittliche Chipleistung pro Kilowatt Energie begann sich ungefähr alle drei Jahre zu verdoppeln. Der Trend hat sich aufgrund der Schwierigkeiten beim Kühlen der Chips geändert (

Seite 4 ), da es mit der Verringerung der Größe der Transistoren schwieriger wird, Wärme abzuleiten.

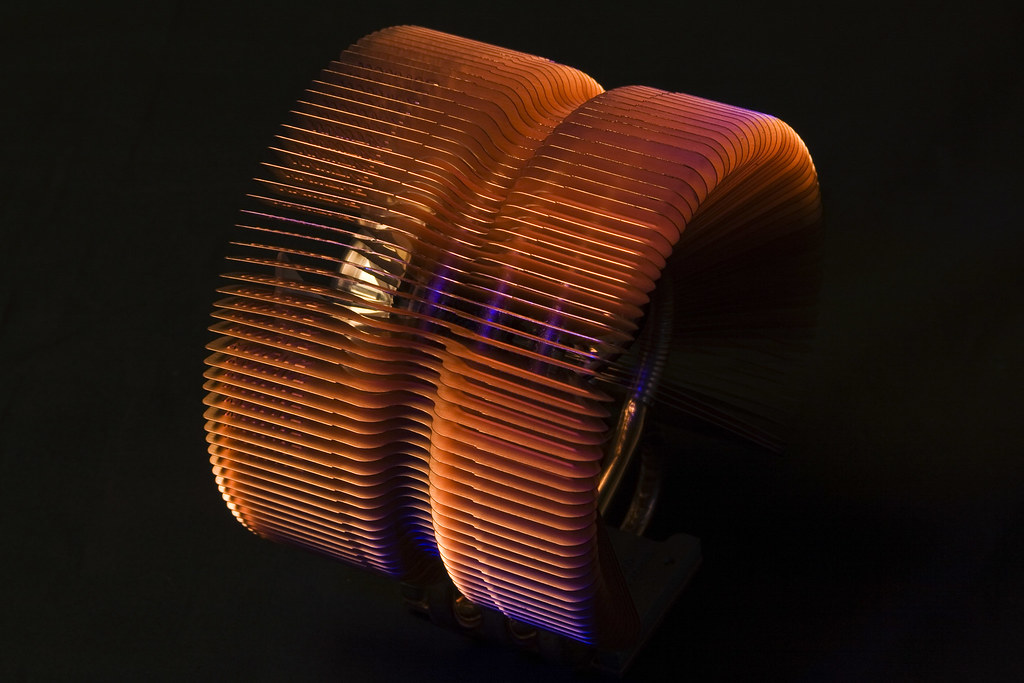

/ Foto Derek Thomas CC BY-ND

/ Foto Derek Thomas CC BY-NDDerzeit werden neue Chipkühlungstechnologien entwickelt, über deren Massenimplementierung muss jedoch nicht gesprochen werden. Beispielsweise schlugen Entwickler einer Universität in New York vor,

mithilfe des 3D-Laserdrucks eine dünne wärmeleitende Schicht aus Titan, Zinn und Silber auf einen Kristall aufzubringen. Die Wärmeleitfähigkeit eines solchen Materials ist siebenmal besser als die anderer thermischer Grenzflächen (Wärmeleitpaste und Polymere).

Trotz aller Faktoren ist die theoretische Energiebegrenzung

laut Kumi noch weit entfernt. Er bezieht sich auf eine Studie des Physikers Richard Feynman, der 1985 feststellte, dass der Energieeffizienzindex von Prozessoren um das 100-Milliarden-fache steigen wird. Zum Zeitpunkt des Jahres 2011 stieg diese Zahl nur um das 40.000-fache.

Die IT-Branche ist an ein hohes Wachstum der Rechenleistung gewöhnt. Daher suchen Ingenieure nach Möglichkeiten, das Gesetz von Moore zu erweitern und die Schwierigkeiten zu überwinden, die durch die Regeln von Kumi und Dennard vorgegeben sind. Insbesondere Unternehmen und Forschungsinstitute suchen nach einem Ersatz für traditionelle Transistortechnologie und Silizium. Wir werden beim nächsten Mal über einige der möglichen Alternativen sprechen.

Worüber wir in einem Unternehmensblog schreiben:

Unsere Berichte mit VMware EMPOWER 2019 über Habré: