Der Begriff Big Data wird durch moderne, fantastische Übertreibung neuer Dinge verdorben. Wenn KI Menschen versklavt und die Blockchain eine ideale Wirtschaft aufbaut, können Sie mit Big Data absolut alles über alle wissen und die Zukunft sehen.

Aber die Realität ist wie immer langweiliger und pragmatischer. Big Data ist nicht magisch - wie nirgendwo - es gibt einfach so viele Informationen und Verbindungen zwischen verschiedenen Daten, dass es zu lange dauert, alles auf die alte Weise zu verarbeiten und zu analysieren.

Neue Methoden entstehen. Neue Berufe sind bei ihnen. Der Dekan

der Abteilung für Big Data-Analyse bei GeekBrains, Sergey Shirkin, erklärte, welche Art von Beruf sie sind, wo sie gebraucht werden, was sie tun müssen und was sie tun müssen. Welche Tools werden verwendet und wie viel zahlen sie normalerweise an Spezialisten?

Was ist Big Data?

Die Frage „Wie nennt man Big Data?“ Ist ziemlich verwirrend. Auch in wissenschaftlichen Fachzeitschriften unterscheiden sich die Beschreibungen. Irgendwo werden Millionen von Beobachtungen als „normale“ Daten betrachtet, und irgendwo anders werden Hunderttausende als groß bezeichnet, da jede der Beobachtungen tausend Zeichen hat. Daher beschlossen sie, die Daten nach dem einfachsten Prinzip in drei Teile zu unterteilen - klein, mittel und groß -: das Volumen, das sie belegen.

Kleine Daten sind einige Gigabyte. Mittel - alles über ein Terabyte. Bei Big Data geht es um ein Petabyte. Dies beseitigte jedoch nicht die Verwirrung. Daher ist das Kriterium noch einfacher: Alles, was nicht auf denselben Server passt, sind Big Data.

Kleine, mittlere und große Datenmengen haben unterschiedliche Funktionsprinzipien. Big Data wird normalerweise in einem Cluster auf mehreren Servern gleichzeitig gespeichert. Aus diesem Grund sind selbst einfache Aktionen komplizierter.

Eine einfache Aufgabe besteht beispielsweise darin, den Durchschnittswert einer Menge zu ermitteln. Wenn es sich um kleine Daten handelt, addieren und dividieren wir einfach durch die Menge. Und in Big Data können wir nicht alle Informationen von allen Servern gleichzeitig erfassen. Das ist schwer. Oft müssen Sie keine Daten zu sich selbst ziehen, sondern müssen jedem Server ein separates Programm senden. Nach der Arbeit dieser Programme werden Zwischenergebnisse gebildet und der Durchschnittswert von ihnen bestimmt.

Sergey Shirkin

Sergey ShirkinWas für Big-Data-Unternehmen

Die erste mit Big Data begann, Mobilfunkbetreiber und Suchmaschinen zu betreiben. Suchmaschinen wurden immer mehr Anfragen, und der Text ist schwerer als Zahlen. Das Arbeiten mit einem Textabschnitt dauert länger als bei einer Finanztransaktion. Der Benutzer erwartet, dass die Suchmaschine die Anforderung in Sekundenbruchteilen abschließt - es ist nicht akzeptabel, dass sie auch nur eine halbe Minute lang funktioniert. Daher begannen die Suchmaschinen beim Arbeiten mit Daten zunächst mit Parallelisierung zu arbeiten.

Wenig später schlossen sich verschiedene Finanzorganisationen und der Einzelhandel an. Die Transaktionen selbst sind nicht so umfangreich, aber Big Data erscheint aufgrund der Tatsache, dass es viele Transaktionen gibt.

Die Datenmenge wächst überhaupt. Zum Beispiel hatten Banken früher viele Daten, aber sie erforderten nicht immer Arbeitsprinzipien, wie bei großen. Dann begannen die Banken mehr mit Kundendaten zu arbeiten. Sie begannen, flexiblere Einlagen, Kredite und unterschiedliche Tarife zu entwickeln, und sie begannen, Transaktionen genauer zu analysieren. Dies erforderte bereits schnelle Arbeitsweisen.

Jetzt wollen Banken nicht nur interne, sondern auch externe Informationen analysieren. Sie möchten Daten vom selben Einzelhandel erhalten, sie möchten wissen, wofür eine Person Geld ausgibt. Basierend auf diesen Informationen versuchen sie, kommerzielle Angebote zu machen.

Jetzt sind alle Informationen miteinander verbunden. Einzelhandel, Banken, Telekommunikationsbetreiber und sogar Suchmaschinen - jetzt interessieren sich alle für die Daten des anderen.

Was für ein Big Data-Spezialist sein sollte

Da sich die Daten auf einem Cluster von Servern befinden, wird eine komplexere Infrastruktur verwendet, um mit ihnen zu arbeiten. Dies stellt eine große Belastung für die Person dar, die mit ihr arbeitet - das System muss sehr zuverlässig sein.

Es ist einfach, einen Server zuverlässig zu machen. Wenn es jedoch mehrere davon gibt, steigt die Wahrscheinlichkeit eines Sturzes proportional zur Anzahl, und die Verantwortung des Dateningenieurs, der mit diesen Daten arbeitet, wächst ebenfalls.

Der Analyst muss verstehen, dass er immer unvollständige oder sogar falsche Daten erhalten kann. Er schrieb das Programm, vertraute auf seine Ergebnisse und stellte dann fest, dass aufgrund des Ausfalls eines Servers von tausend ein Teil der Daten getrennt wurde und alle Schlussfolgerungen falsch waren.

Nehmen Sie zum Beispiel eine Textsuche. Nehmen wir an, alle Wörter sind auf mehreren Servern in alphabetischer Reihenfolge angeordnet (wenn wir sehr einfach und bedingt sprechen). Und einer von ihnen trennte sich, alle Wörter im Buchstaben „K“ verschwanden. Die Suche hörte auf, das Wort "Kino" herauszugeben. Alle Nachrichten der Nachrichten verschwinden und der Analyst kommt zu dem falschen Schluss, dass die Leute nicht mehr an Kinos interessiert sind.

Daher sollte ein Spezialist für Big Data die Arbeitsprinzipien von den niedrigsten Ebenen - Servern, Ökosystemen, Aufgabenplanern - bis zu den Programmen der höchsten Ebene - Bibliotheken für maschinelles Lernen, statistische Analysen und mehr - kennen. Er muss die Prinzipien von Eisen, Computerausrüstung und allem, was darauf konfiguriert ist, verstehen.

Im Übrigen müssen Sie alles genau so wissen wie beim Arbeiten mit kleinen Daten. Sie benötigen Mathematik, Sie müssen in der Lage sein, verteilte Computeralgorithmen zu programmieren und besonders gut zu kennen, um sie auf die üblichen Prinzipien der Arbeit mit Daten und maschinellem Lernen anwenden zu können.

Welche Werkzeuge werden verwendet?

Da die Daten im Cluster gespeichert sind, ist eine spezielle Infrastruktur erforderlich, um damit arbeiten zu können. Das beliebteste Ökosystem ist Hadoop. Darin können viele verschiedene Systeme arbeiten: spezielle Bibliotheken, Planer, Werkzeuge für maschinelles Lernen und vieles mehr. Zuallererst wird dieses System jedoch benötigt, um große Datenmengen aufgrund verteilter Datenverarbeitung zu bewältigen.

Zum Beispiel suchen wir nach dem beliebtesten Tweet unter Daten, die auf tausend Servern kaputt sind. Auf einem Server würden wir einfach eine Tabelle erstellen und fertig. Hier können wir alle Daten zu uns ziehen und nachzählen. Das ist aber nicht richtig, denn für eine sehr lange Zeit.

Daher gibt es einen Hadoop mit Map Reduce-Paradigmen und dem Spark-Framework. Anstatt Daten zu sich selbst zu ziehen, senden sie Programmabschnitte an diese Daten. Die Arbeit läuft parallel in tausend Fäden. Dann erhalten wir eine Auswahl von Tausenden von Servern, auf deren Grundlage Sie den beliebtesten Tweet auswählen können.

Map Reduce ist ein älteres Paradigma, Spark ist neuer. Mit seiner Hilfe werden Daten aus Clustern extrahiert und Modelle für maschinelles Lernen erstellt.

Welche Berufe gibt es im Bereich Big Data?

Die beiden Hauptberufe sind Analysten und Dateningenieure.

Der Analyst arbeitet hauptsächlich mit Informationen. Er interessiert sich für tabellarische Daten, er beschäftigt sich mit Modellen. Zu seinen Aufgaben gehören die Aggregation, Reinigung, Hinzufügung und Visualisierung von Daten. Das heißt, der Analyst ist das Bindeglied zwischen Rohdaten und Geschäft.

Der Analyst hat zwei Hauptarbeitsbereiche. Erstens kann er die erhaltenen Informationen transformieren, Schlussfolgerungen ziehen und sie auf verständliche Weise präsentieren.

Das zweite ist, dass Analysten Anwendungen entwickeln, die funktionieren und das Ergebnis automatisch produzieren. Machen Sie beispielsweise jeden Tag eine Prognose auf dem Wertpapiermarkt.

Data Engineer ist eine Spezialität auf niedrigerer Ebene. Dies ist eine Person, die die Speicherung, Verarbeitung und Übermittlung von Informationen an den Analysten sicherstellen muss. Aber wo es Versorgung und Reinigung gibt - ihre Verantwortlichkeiten können sich überschneiden.

Der Dateningenieur bekommt die ganze harte Arbeit. Wenn die Systeme ausgefallen sind oder einer der Server aus dem Cluster verschwunden ist, wird eine Verbindung hergestellt. Dies ist ein sehr verantwortungsbewusster und stressiger Job. Das System kann sowohl am Wochenende als auch außerhalb der Geschäftszeiten heruntergefahren werden, und der Techniker muss umgehend Maßnahmen ergreifen.

Dies sind zwei Hauptberufe, aber es gibt andere. Sie erscheinen, wenn parallele Rechenalgorithmen zu Aufgaben im Zusammenhang mit künstlicher Intelligenz hinzugefügt werden. Zum Beispiel ein NLP-Ingenieur. Dies ist ein Programmierer, der sich mit der Verarbeitung natürlicher Sprache beschäftigt, insbesondere in Fällen, in denen Sie nicht nur Wörter finden, sondern auch die Bedeutung des Textes erfassen müssen. Solche Ingenieure schreiben Programme für Chatbots und Konversationssysteme, Sprachassistenten und automatisierte Call Center.

Es gibt Situationen, in denen es notwendig ist, Milliarden von Bildern zu klassifizieren, zu moderieren, den Überschuss herauszufiltern und ein ähnliches zu finden. Diese Berufe überschneiden sich mehr mit Computer Vision.

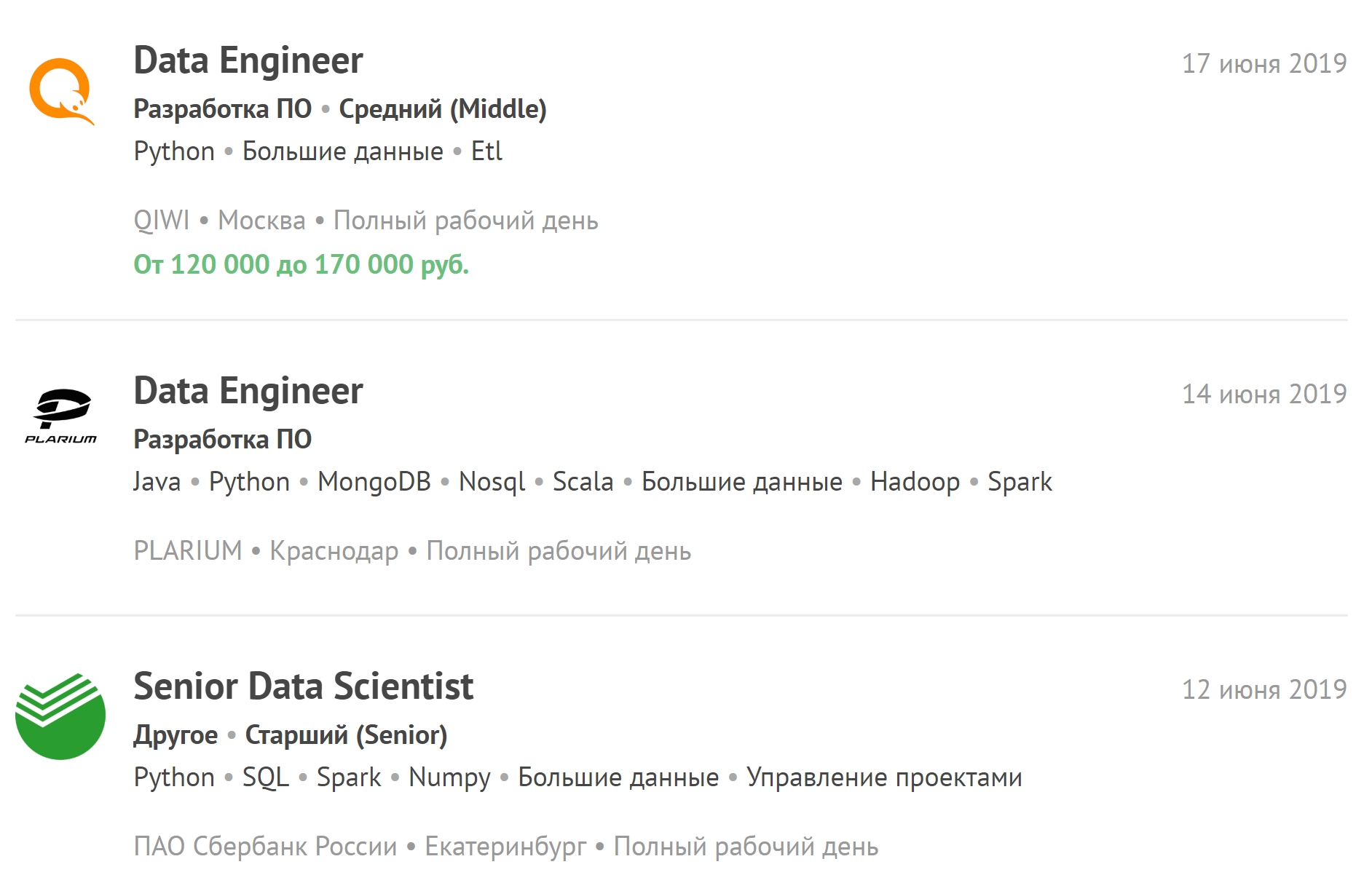

Sie können sich die neuesten Stellenangebote im Zusammenhang mit Big Data ansehen und neue Stellenangebote abonnieren.

Wie lange dauert das Training?

Wir studieren seit anderthalb Jahren. Sie sind in sechs Viertel unterteilt. In einigen liegt der Schwerpunkt auf der Programmierung, in anderen auf der Arbeit mit Datenbanken und im dritten auf der Mathematik.

Im Gegensatz dazu gibt es beispielsweise an der Fakultät für KI weniger Mathematik. Die mathematische Analyse und die lineare Algebra werden nicht so stark betont. Kenntnisse über verteilte Computeralgorithmen sind mehr erforderlich als die Prinzipien der Matanalyse.

Eineinhalb Jahre reichen jedoch nur dann für eine echte Arbeit mit Big Data aus, wenn die Person Erfahrung mit normalen Daten und allgemein mit IT hat. Den verbleibenden Studenten nach dem Abschluss wird empfohlen, mit kleinen und mittleren Daten zu arbeiten. Erst danach dürfen Spezialisten mit großen arbeiten. Nach der Ausbildung sollten Sie als Datenwissenschaftler arbeiten - maschinelles Lernen auf verschiedene Datenmengen anwenden.

Wenn eine Person einen Job in einem großen Unternehmen bekommt - selbst wenn sie Erfahrung hat -, darf sie meistens nicht sofort auf Big Data zugreifen, da der Preis für einen Fehler dort viel höher ist. Fehler in den Algorithmen werden möglicherweise nicht sofort erkannt, was zu großen Verlusten führt.

Welches Gehalt wird für Big Data-Spezialisten als angemessen angesehen?

Jetzt besteht unter den Dateningenieuren ein sehr großer Personalmangel. Die Arbeit ist schwierig, viel Verantwortung liegt bei einer Person, viel Stress. Daher erhält ein Spezialist mit durchschnittlicher Erfahrung etwa zweihunderttausend. Junior - von einhundert bis zweihundert.

Ein Datenanalyst hat möglicherweise ein etwas niedrigeres Anfangsgehalt. Es gibt jedoch keine Arbeit, die über die Arbeitszeit hinausgeht, und er wird aufgrund von Notfällen nicht außerhalb der Arbeitszeit angerufen.

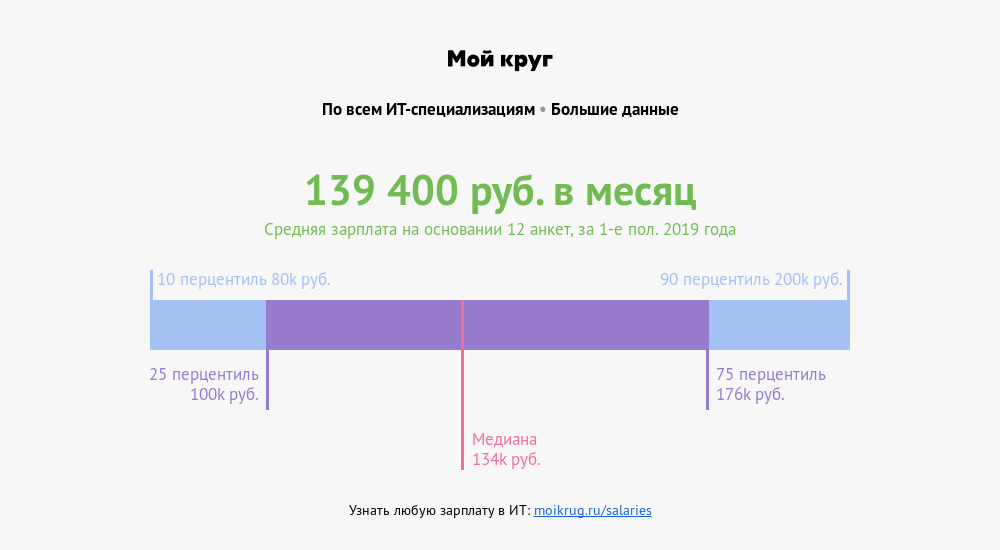

Laut dem Gehaltskultivator „My Circle“ beträgt das durchschnittliche Gehalt von Spezialisten, deren Berufe mit Big Data verbunden sind, 139.400 Rubel . Ein Viertel der Spezialisten verdient mehr als 176.000 Rubel. Ein Zehntel - mehr als 200.000 Rubel.

So bereiten Sie sich auf Interviews vor

Sie müssen sich nicht nur mit einem Thema befassen. Bei Interviews stellen sie Fragen zu Statistik, maschinellem Lernen und Programmierung. Sie fragen möglicherweise nach Datenstrukturen, Algorithmen und Fällen aus dem wirklichen Leben: Der Server ist abgestürzt, ein Unfall ist passiert - wie kann er behoben werden? Möglicherweise gibt es Fragen zum Themenbereich - etwas, das näher am Geschäft liegt.

Und wenn eine Person zu tief in eine Mathematik vertieft ist und beim Interview keine einfache Programmieraufgabe erledigt hat, sind die Chancen, einen Job zu finden, geringer. Es ist besser, in jeder Richtung ein Durchschnittsniveau zu haben, als sich in der einen gut zu zeigen und in der anderen völlig zu versagen.

Bei 80 Prozent der Interviews wird eine Liste mit Fragen gestellt. Wenn dies maschinelles Lernen ist, werden sie definitiv nach dem Gefälle fragen. Bei Statistiken müssen Sie über Korrelations- und Hypothesentests sprechen. Die Programmierung ist wahrscheinlich eine kleine Aufgabe mittlerer Komplexität. Und Sie können ganz einfach Aufgaben in die Hand nehmen - lösen Sie sie einfach weiter.

Wo Sie selbst Erfahrungen sammeln können

Python kann auf

Pitontutyu aufgerufen werden , mit der Datenbank arbeiten - auf

SQL-EX . Es gibt vorgegebene Aufgaben, für die sie in der Praxis lernen, Anfragen zu stellen.

Höhere Mathematik -

Mathprofi . Dort erhalten Sie klare Informationen zu mathematischer Analyse, Statistik und linearer Algebra. Und wenn es schlecht mit dem Lehrplan der Schule ist, dann

youclever.org .

Distributed Computing funktioniert nur in der Praxis. Erstens erfordert dies eine Infrastruktur, und zweitens können Algorithmen schnell veraltet sein. Jetzt taucht ständig etwas Neues auf.

Welche Trends diskutiert die Community?

Ein weiterer Bereich gewinnt allmählich an Stärke, was zu einem raschen Anstieg der Datenmenge führen kann - das Internet der Dinge (Internet of Things, IoT). Daten dieser Art stammen von den Sensoren der in einem Netzwerk angeschlossenen Geräte, und die Anzahl der Sensoren zu Beginn des nächsten Jahrzehnts sollte mehrere zehn Milliarden erreichen.

Die Geräte sind sehr unterschiedlich - von Haushaltsgeräten bis hin zu Fahrzeugen und Industriemaschinen. Ein kontinuierlicher Informationsfluss erfordert zusätzliche Infrastruktur und eine große Anzahl hochqualifizierter Spezialisten. Dies bedeutet, dass es in naher Zukunft einen akuten Mangel an Dateningenieuren und Big-Data-Analysten geben wird.