Kürzlich habe ich beschrieben, dank welcher Roboter morgen VIEL besser zu denken beginnen wird (ein Beitrag über die

Hardwarebeschleunigung neuronaler Netze ). Heute werden wir sehen, warum Roboter bald viel besser zu sehen sein werden. In manchen Situationen viel besser als eine Person.

Wir werden über Tiefenkameras sprechen, die Videos aufnehmen, in denen an diesem Punkt nicht die Farbe, sondern die Entfernung zum Objekt gespeichert ist. Solche Kameras gibt es seit mehr als 20 Jahren, aber in den letzten Jahren ist die Geschwindigkeit ihrer Entwicklung um ein Vielfaches gestiegen, und wir können bereits über die Revolution sprechen. Und Multi-Vektor. In folgenden Bereichen findet eine rasche Entwicklung statt:

Wen interessiert es, wie es aussehen wird, sowie einen Vergleich verschiedener Ansätze und ihrer aktuellen und morgigen Anwendung - willkommen unter dem Schnitt!

Also! Wir werden die Hauptrichtungen der Entwicklung von Tiefenkammern oder tatsächlich verschiedene Prinzipien zur Tiefenmessung analysieren. Mit ihren Vor- und Nachteilen.

Methode 1: Strukturierte Lichtkamera

Beginnen wir mit einer der einfachsten, ältesten und relativ billigen Methoden zur Messung von tiefenstrukturiertem Licht. Dieses Verfahren erschien im wesentlichen sofort, sobald Digitalkameras erschienen, d.h. Vor über 40 Jahren und etwas später mit dem Aufkommen digitaler Projektoren stark vereinfacht.

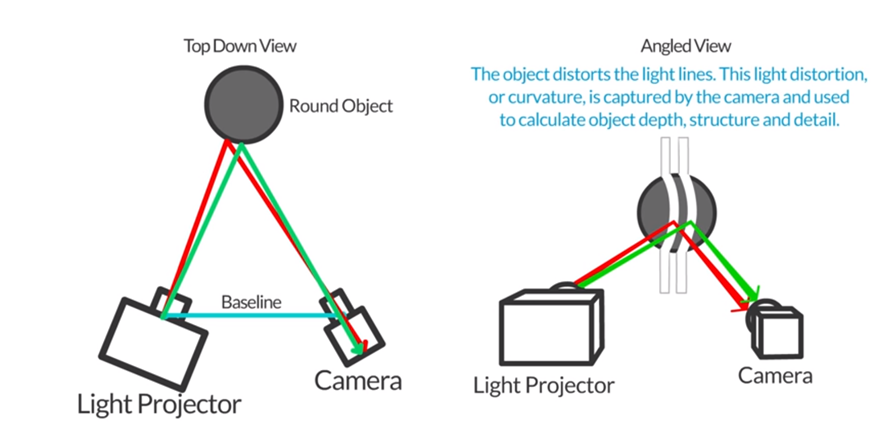

Die Grundidee ist sehr einfach. Wir platzieren neben dem Projektor, der zum Beispiel horizontale (und dann vertikale) Streifen erzeugt, und neben der Kamera, die ein Bild mit Streifen aufnimmt, wie in dieser Abbildung gezeigt:

Quelle: Autodesk: Strukturiertes Licht 3D-Scannen

Quelle: Autodesk: Strukturiertes Licht 3D-ScannenDa Kamera und Projektor zueinander versetzt sind, werden die Streifen auch proportional zum Abstand zum Motiv verschoben. Durch Messen dieser Verschiebung können wir den Abstand zum Objekt berechnen:

Quelle: http://www.vision-systems.com/

Quelle: http://www.vision-systems.com/Mit dem billigsten Projektor (und der Preis beginnt bei 3.000 Rubel) und einem Smartphone können Sie die Tiefe statischer Szenen in einem dunklen Raum messen:

Quelle: Autodesk: Strukturiertes Licht 3D-Scannen

Quelle: Autodesk: Strukturiertes Licht 3D-ScannenEs ist klar, dass in diesem Fall eine ganze Reihe von Problemen gelöst werden müssen - dies ist Projektorkalibrierung, Telefonkamera-Kalibrierung, Streifenverschiebungserkennung usw., aber all diese Aufgaben sind selbst für fortgeschrittene Schüler, die Programmieren lernen, durchaus möglich.

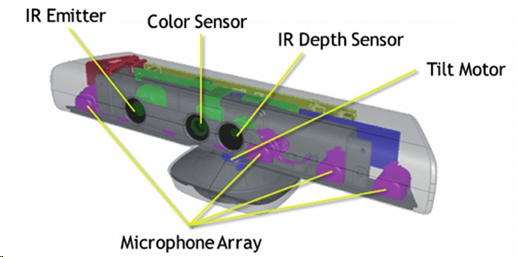

Dieses Prinzip der Tiefenmessung wurde am bekanntesten, als Microsoft 2010 den

MS Kinect-Tiefensensor für 150 US-Dollar herausbrachte, der zu dieser Zeit revolutionär billig war.

Quelle: Teilweise okkludierte Objektrekonstruktion mit mehreren Kinect-Sensoren

Quelle: Teilweise okkludierte Objektrekonstruktion mit mehreren Kinect-SensorenTrotz der Tatsache, dass Kinect nicht nur die Tiefe mit einem IR-Projektor und einer IR-Kamera maß, sondern auch reguläres RGB-Video aufnahm, vier Mikrofone mit Rauschunterdrückung hatte und sich an eine Person in der Größe anpassen konnte, die automatisch nach oben oder unten kippte, wurde es sofort in das Gerät integriert Datenverarbeitung, die der Konsole sofort eine fertige Tiefenkarte ausgab:

Quelle: Implementierung natürlicher Schaltflächen für die Benutzeroberfläche mit Kinect

Quelle: Implementierung natürlicher Schaltflächen für die Benutzeroberfläche mit KinectInsgesamt wurden rund 35 Millionen Geräte verkauft, was Kinect zur ersten Massentiefenkamera in der Geschichte macht. Und wenn man bedenkt, dass es sicherlich Tiefenkameras gab, die normalerweise höchstens zu Hunderten verkauft wurden und mindestens eine Größenordnung teurer waren - dies war eine Revolution, die große Investitionen in diesem Bereich ermöglichte.

Ein wichtiger Grund für den Erfolg war, dass es zum Zeitpunkt der Veröffentlichung der Xbox 360 durch Microsoft bereits einige Spiele gab, die Kinect aktiv als Sensor verwendeten. Der Start war schnell:

Darüber hinaus gelang es Kinect sogar, als am schnellsten verkauftes Gerät der Geschichte in das Guinness-Buch der Rekorde einzutreten. Zwar hat Apple Microsoft bald von diesem Ort verdrängt, aber dennoch. Für einen neuen experimentellen Sensor, der neben dem Hauptgerät zum am schnellsten verkauften elektronischen Gerät in der Geschichte wird, ist dies einfach eine großartige Leistung:

In Vorträgen frage ich das Publikum gerne, woher all diese Millionen Kunden kommen. Wer waren all diese Leute?

In der Regel ahnt niemand, aber manchmal, besonders wenn das Publikum älter und erfahrener ist, geben sie die richtige Antwort: Der Verkauf wurde von amerikanischen Eltern getrieben, die mit Freude sahen, dass ihre Kinder auf der Konsole spielen und nicht mit einer dicken Beute auf der Couch sitzen konnten. und vor den Fernseher springen. Es war ein Durchbruch !!! Millionen von Müttern und Vätern beeilten sich, ein Gerät für ihre Kinder zu bestellen.

Wenn es um die Gestenerkennung geht, glauben die Leute im Allgemeinen naiv, dass nur Daten von einer 2D-Kamera ausreichen. Immerhin haben sie viele schöne Demos gesehen! Die Realität ist viel strenger. Die Erkennungsgenauigkeit von Gesten aus einem 2D-Videostream von einer Kamera und die Erkennungsgenauigkeit von Gesten aus einer Kameratiefe unterscheiden sich um eine Größenordnung. Mit einer Tiefenkamera oder besser gesagt mit einer RGB-Kamera in Kombination mit einer Tiefenkamera (letztere ist wichtig) können Sie Gesten viel genauer und kostengünstiger erkennen (auch wenn der Raum dunkel ist), und dies hat der ersten Massentiefenkamera Erfolg gebracht.

Über Kinect auf Habré zu der Zeit haben sie

viel geschrieben , also ganz kurz, wie es funktioniert.

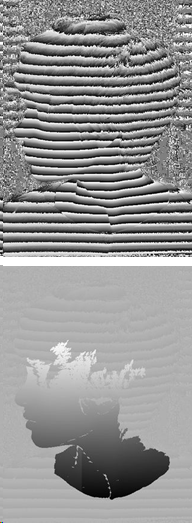

Ein Infrarotprojektor liefert eine pseudozufällige Menge von Punkten im Raum, deren Verschiebung die Tiefe in einem bestimmten Pixel bestimmt:

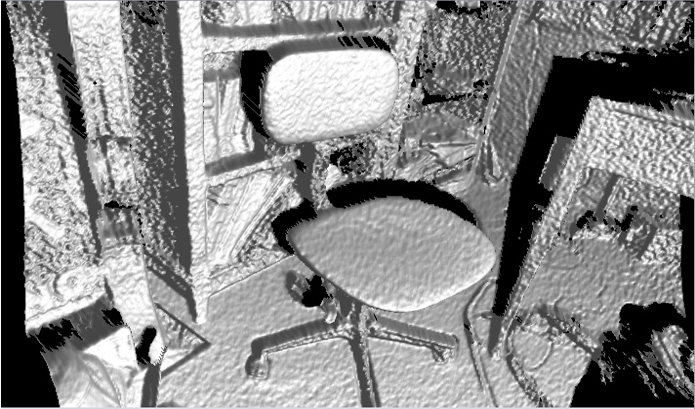

Quelle: Depth Sensing Planar Structures: Erkennung von Büromöbelkonfigurationen

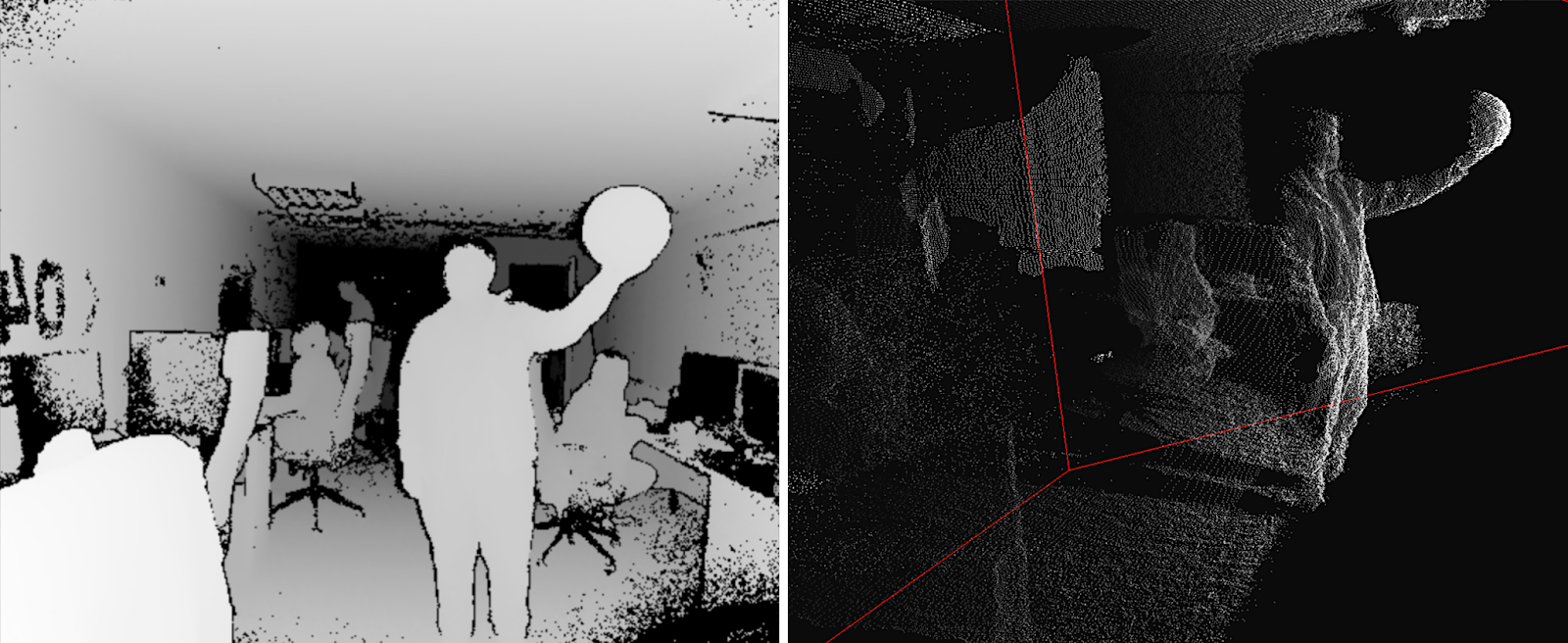

Quelle: Depth Sensing Planar Structures: Erkennung von BüromöbelkonfigurationenDie Kameraauflösung ist als 640 x 480 deklariert, aber tatsächlich gibt es ungefähr 320 x 240 mit ziemlich starker Filterung, und das Bild in realen Beispielen sieht so aus (das ist ziemlich beängstigend):

Quelle: Teilweise okkludierte Objektrekonstruktion mit mehreren Kinect-Sensoren

Quelle: Teilweise okkludierte Objektrekonstruktion mit mehreren Kinect-SensorenDie „Schatten“ der Objekte sind deutlich sichtbar, da Kamera und Projektor weit genug voneinander entfernt sind. Es ist ersichtlich, dass Verschiebungen mehrerer Punkte des Projektors vorgenommen werden, um die Tiefe vorherzusagen. Darüber hinaus gibt es eine (harte) Filterung durch unmittelbare Nachbarn, aber die Tiefenkarte ist immer noch ziemlich verrauscht, insbesondere an den Grenzen. Dies führt zu einem ziemlich wahrnehmbaren Geräusch auf der Oberfläche der resultierenden Objekte, das zusätzlich und nicht trivial geglättet werden muss:

Quelle: J4K Java Library für das Kinect SDK von Microsoft

Quelle: J4K Java Library für das Kinect SDK von MicrosoftTrotzdem nur 150 US-Dollar (

heute sind es bereits 69 US-Dollar , obwohl

es natürlich

näher an 200 US-Dollar liegt) - und Sie "sehen" die Tiefe! Es gibt

wirklich viele Serienprodukte.

Übrigens wurde im Februar dieses Jahres ein neuer

Azure Kinect angekündigt:

Quelle: Microsoft kündigt Azure Kinect an, das ab sofort vorbestellt werden kann

Quelle: Microsoft kündigt Azure Kinect an, das ab sofort vorbestellt werden kannDie Auslieferung an Entwickler in den USA und in China sollte am 27. Juni beginnen, d. H. buchstäblich jetzt. Von den Funktionen wird neben der deutlich besseren Auflösung von RGB und der besseren Qualität von Tiefenkameras (sie versprechen

1024 x 1024 bei 15 FPS und 512 x 512 bei 30 FPS und eine höhere Qualität ist in

der Demo deutlich sichtbar , die ToF-Kamera deutlich zu unterstützen) die Unterstützung für die Zusammenarbeit mehrerer Geräte sofort erklärt, weniger Exposition gegenüber Bei der Sonne beträgt der Fehler weniger als 1 cm in einer Entfernung von 4 Metern und 1-2 mm in einer Entfernung von weniger als 1 Meter, was äußerst interessant klingt. Wir warten also, wir warten:

Quelle: Einführung in Azure Kinect DK

Quelle: Einführung in Azure Kinect DKDas nächste

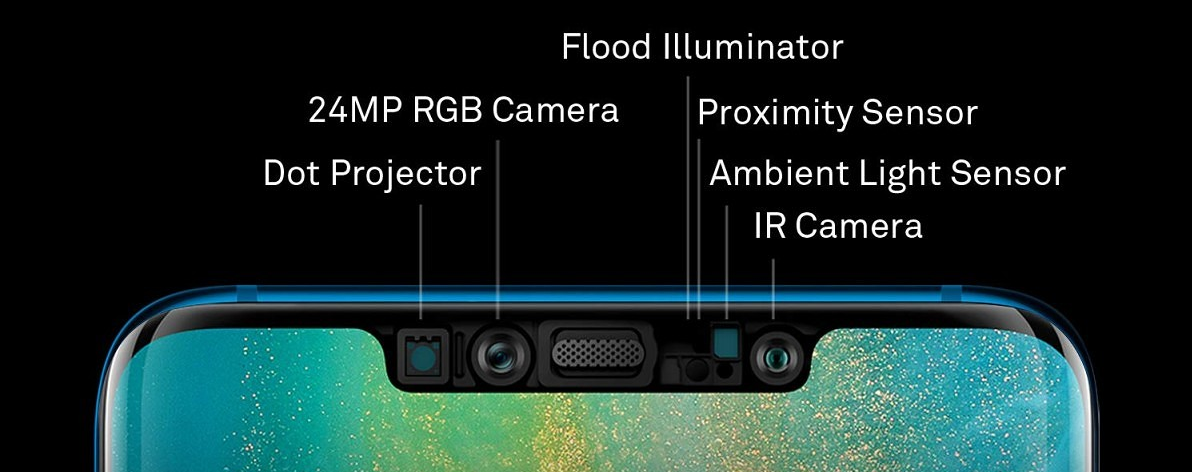

Massenprodukt , bei dem eine Tiefenkamera in einem strukturierten Licht realisiert wurde, war keine Spielekonsole, sondern ... (Trommelwirbel) richtig -

iPhone X !

Die Face ID-Technologie ist eine typische Tiefenkamera mit einem typischen Infrarot-Punktprojektor und einer Infrarotkamera (jetzt verstehen Sie übrigens, warum sie sich an den Rändern der Pony befinden und so weit wie möglich voneinander entfernt sind - dies ist eine

Stereobasis ):

Die Auflösung der Tiefenkarte ist sogar geringer als die von Kinect - ungefähr 150x200. Es ist klar, dass, wenn Sie sagen: "Unsere Auflösung beträgt etwa 150 x 200 Pixel oder 0,03 Megapixel", die Leute kurz und prägnant sagen werden: "Sucks!" Und wenn Sie sagen

"Punktprojektor: Mehr als 30.000 unsichtbare Punkte werden auf Ihr Gesicht projiziert" , sagen die Leute: "Wow,

30.000 unsichtbare Punkte , cool!". Einige Blondinen werden fragen, ob Sommersprossen an unsichtbaren Stellen auftreten. Und das Thema wird an die Massen gehen! Daher war die zweite Option in der Werbung weitsichtig. Die Auflösung ist aus drei Gründen gering: Erstens die Anforderungen an Miniatur, zweitens den Energieverbrauch und drittens die Preise.

Trotzdem ist dies eine weitere Tiefenkamera in einem strukturierten Licht, die in eine Reihe von Millionen von Exemplaren eingedrungen ist und bereits von anderen Smartphone-Herstellern wiederholt wurde,

zum Beispiel (Überraschung-Überraschung!) Huawei (das Apple im vergangenen Jahr beim Smartphone-Verkauf umgangen hat). Nur Huawei hat rechts eine Kamera und links den Projektor, aber natürlich auch entlang der Ränder der „Pony“:

Quelle: Mit dem Huawei Mate 20 Pro-Update können Benutzer ein zweites Gesicht für die Gesichtsentsperrung hinzufügen

Quelle: Mit dem Huawei Mate 20 Pro-Update können Benutzer ein zweites Gesicht für die Gesichtsentsperrung hinzufügenGleichzeitig werden 300.000 Punkte deklariert,

dh zehnmal mehr als bei Apple , und die Frontkamera ist besser

und die Schrift ist größer . Gibt es eine Übertreibung in Bezug auf 300.000 - es ist schwer zu sagen, aber Huawei demonstriert einen sehr guten

3D-Scan von Objekten mit einer Frontkamera . Unabhängige Tests sind

beängstigender , aber dies ist eindeutig der Anfang des Themas, und die Anfänge der Technologie energieeffizienter Miniatur-Tiefenkameras und Kameraankündigungen Ende dieses Jahres weisen bereits eine deutlich bessere Leistung auf.

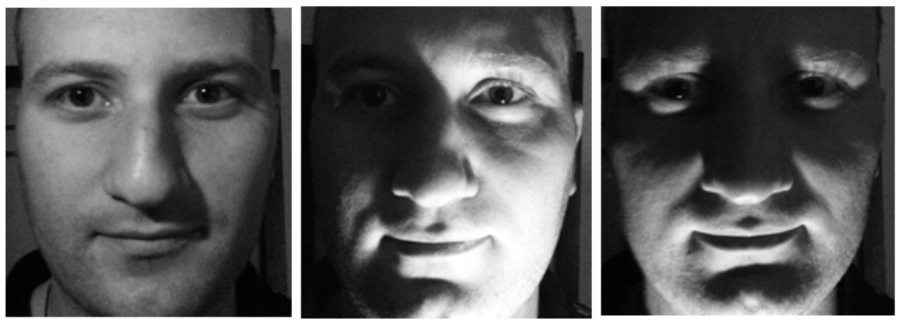

Gleichzeitig ist es verständlich, warum die Gesichtserkennungstechnologie in Telefonen verwendet wurde. Erstens können Sie den Detektor jetzt nicht täuschen, indem Sie ein Foto Ihres Gesichts (oder ein Video vom Tablet) anzeigen. Zweitens ändert sich das Gesicht stark, wenn sich die Beleuchtung ändert, aber seine Form nicht, wodurch wir die Person zusammen mit den Daten der RGB-Kamera genauer identifizieren können:

Quelle: TI Foto derselben Person

Quelle: TI Foto derselben PersonOffensichtlich weist der Infrarotsensor inhärente Probleme auf. Erstens scheint unser relativ schwacher Projektor ein oder zwei Mal auf die Sonne, sodass diese Kameras auf der Straße nicht funktionieren. Selbst im Schatten können große Probleme mit der Gesichtserkennung auftreten, wenn die weiße Wand eines Gebäudes von der Sonne beleuchtet wird. Der Geräuschpegel in Kinect rollt auch dann über, wenn die Sonne von Wolken bedeckt ist:

Quelle: dieses und die nächsten beiden Bilder

Quelle: dieses und die nächsten beiden Bilder -

Materialien Basler AGEin weiteres großes Problem ist Reflexion und Reflexion. Da auch Infrarotlicht reflektiert wird, ist es problematisch, mit Kinect einen teuren Edelstahlkessel, einen lackierten Tisch oder einen Glasschirm aufzunehmen:

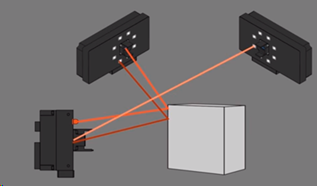

Und schließlich können sich zwei Kameras, die ein Objekt aufnehmen, gegenseitig stören. Interessanterweise können Sie bei strukturiertem Licht den Projektor flackern lassen und verstehen, wo sich unsere Punkte befinden und wo nicht, aber dies ist eine separate und ziemlich komplizierte Geschichte:

Jetzt wissen Sie, wie man FaceID bricht ...

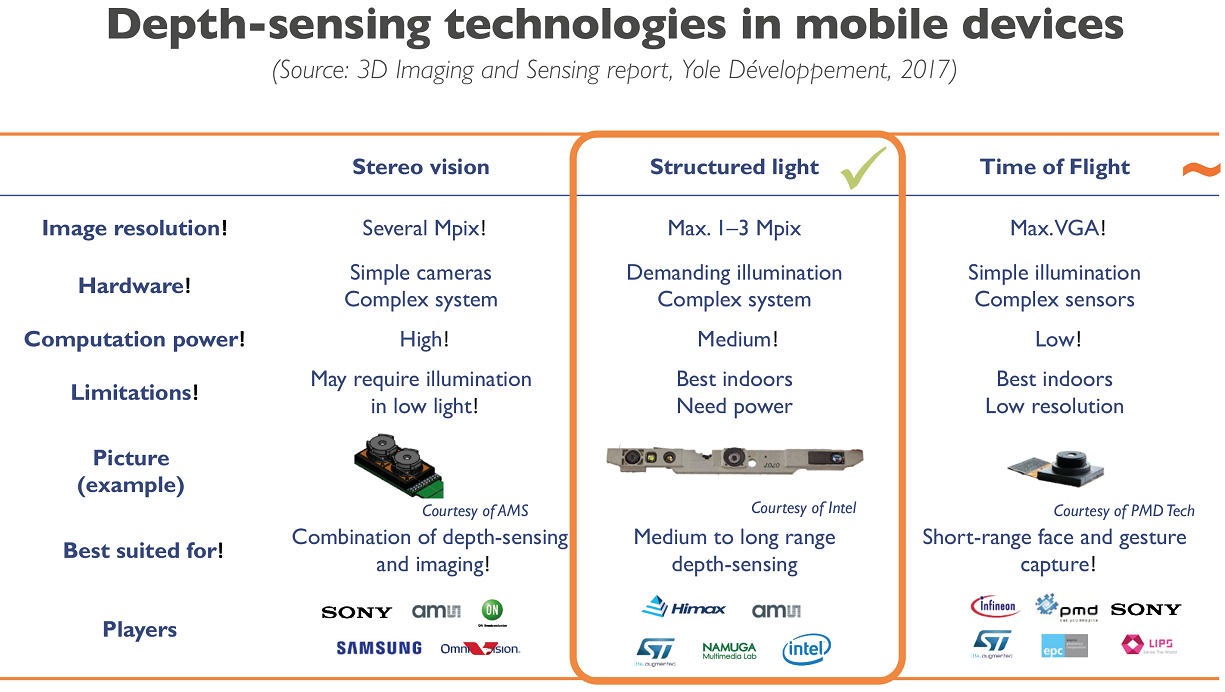

Für mobile Geräte scheint strukturiertes Licht jedoch heute der vernünftigste Kompromiss zu sein:

Quelle: Smartphone-Unternehmen, die sich bemühen, die Leistung und die Kosten der Apple 3D-Kamera anzupassen

Quelle: Smartphone-Unternehmen, die sich bemühen, die Leistung und die Kosten der Apple 3D-Kamera anzupassenFür strukturiertes Licht ist die Billigkeit eines herkömmlichen Sensors so, dass seine Verwendung in den meisten Fällen mehr als gerechtfertigt ist. Was eine große Anzahl von Startups zum Leben erweckte, die nach der Formel arbeiteten: billiger Sensor + komplexe Software = durchaus akzeptables Ergebnis.

Zum Beispiel hat unser ehemaliger Doktorand

Maxim Fedyukov , der sich seit 2004 mit 3D-Rekonstruktion beschäftigt,

Texel entwickelt , dessen Hauptprodukt eine Plattform mit 4 Kinect-Kameras und -Software ist, die eine Person in 30 Sekunden in ein potenzielles Denkmal verwandelt. Nun, oder eine Desktop-Figur. Das ist, wer genug Geld hat. Oder Sie können Ihren Freunden billige und fröhliche Fotos von Freunden Ihres 3D-Modells senden (aus irgendeinem Grund der beliebteste Fall aus irgendeinem Grund). Jetzt senden sie ihre Plattformen und Software aus Großbritannien nach Australien:

Quelle: Erstellen eines 3D-Modells einer Person in 30 SekundenAls Ballerina kann ich nicht schön stehen, deshalb schaue ich nur nachdenklich auf die Flosse eines vorbeischwimmenden Hais:

Quelle: Materialien des Autors

Quelle: Materialien des AutorsIm Allgemeinen brachte eine neue Art von Sensoren neue Kunstprojekte hervor. Im Winter sah ich einen ziemlich neugierigen VR-Film, der mit Kinect gedreht wurde. Im Folgenden finden Sie eine interessante Visualisierung des Tanzes, der ebenfalls mit Kinect erstellt wurde (anscheinend wurden 4 Kameras verwendet). Im Gegensatz zum vorherigen Beispiel haben sie nicht mit Lärm gekämpft, sondern eher lustige Details hinzugefügt:

Quelle: Eine Tanzperformance, die mit einem Kinect-Sensor aufgenommen und mit 3D-Software visualisiert wurde

Quelle: Eine Tanzperformance, die mit einem Kinect-Sensor aufgenommen und mit 3D-Software visualisiert wurdeWelche Trends sind in der Region zu beobachten:

- Wie Sie wissen, sind digitale Sensoren moderner Kameras empfindlich gegenüber Infrarotstrahlung. Daher müssen Sie spezielle Sperrfilter verwenden, damit das Bild nicht durch Infrarotrauschen beeinträchtigt wird (selbst die Richtung der künstlerischen Aufnahme im Infrarotbereich wird angezeigt, auch wenn der Filter vom Sensor entfernt wird). Dies bedeutet, dass enorme Geldbeträge in Miniaturisierung, höhere Auflösung und billigere Sensoren investiert werden, die als Infrarot (mit einem speziellen Filter ) verwendet werden können.

- In ähnlicher Weise verbessern sich die Algorithmen zur Verarbeitung von Tiefenkarten jetzt schnell, einschließlich der Methoden der sogenannten Kreuzfilterung, wenn Daten von einem RGB-Sensor und verrauschte Daten nach Tiefe es Ihnen ermöglichen, ein sehr gutes Tiefenvideo zusammen zu erhalten. Gleichzeitig wird es mithilfe neuronaler Netzwerkansätze möglich, die Geschwindigkeit, mit der ein gutes Ergebnis erzielt wird, drastisch zu erhöhen.

- In diesem Bereich arbeiten alle Top-Unternehmen, insbesondere Smartphone-Hersteller.

Als Konsequenz:

- Wir können in den nächsten 5 Jahren einen dramatischen Anstieg der Auflösung und Genauigkeit von Tiefenkameras mit strukturiertem Licht erwarten.

- Der Energieverbrauch mobiler Sensoren wird (wenn auch langsamer) gesenkt, was die Verwendung von Sensoren der nächsten Generation in Smartphones, Tablets und anderen mobilen Geräten vereinfacht.

Auf jeden Fall sehen wir jetzt die Kindheit der Technologie. Die ersten Massenprodukte, bei denen das Debuggen der Produktion und Verwendung eines neuen ungewöhnlichen Datentyps gerade gestartet wird - Video mit Tiefe.

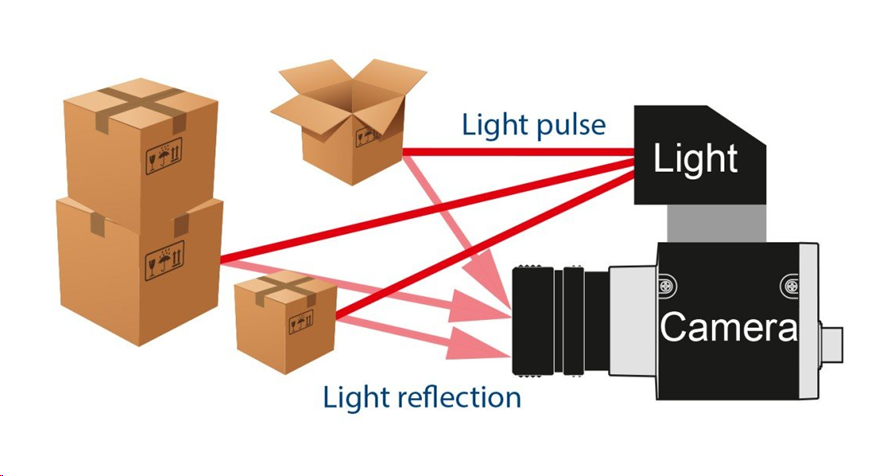

Methode 2: Flugzeitkamera

Der nächste Weg, um Tiefe zu bekommen, ist interessanter. Es basiert auf der Messung der Umlauflichtverzögerung (ToF -

Time-of-Flight ). Wie Sie wissen, ist die Geschwindigkeit moderner Prozessoren hoch und die Lichtgeschwindigkeit gering. In einem Taktzyklus des Prozessors bei 3 GHz schafft es das Licht, nur 10 Zentimeter zu fliegen. Oder 10 Maßnahmen pro Meter. Viel Zeit, wenn jemand mit der Optimierung auf niedriger Ebene beschäftigt war. Dementsprechend installieren wir eine gepulste Lichtquelle und eine spezielle Kamera:

Quelle: Die Basler-Flugzeitkamera (ToF)

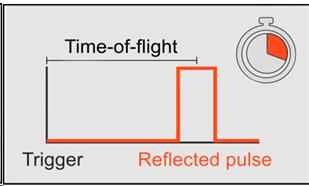

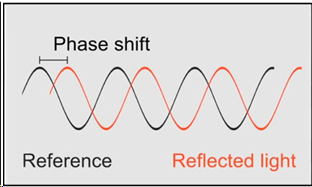

Quelle: Die Basler-Flugzeitkamera (ToF)Tatsächlich müssen wir die Verzögerung messen, mit der das Licht zu jedem Punkt zurückkehrt:

Quelle: Die Basler-Flugzeitkamera (ToF)

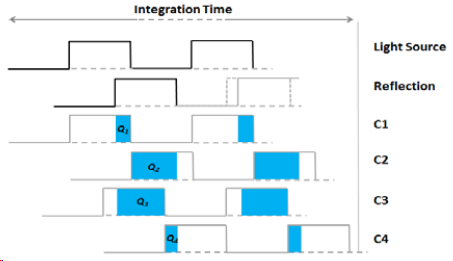

Quelle: Die Basler-Flugzeitkamera (ToF)Wenn wir mehrere Sensoren mit unterschiedlichen Ladungsakkumulationszeiten haben, können wir bei Kenntnis der Zeitverschiebung relativ zur Quelle für jeden Sensor und der Blitzhelligkeit die Verschiebung und dementsprechend die Entfernung zum Objekt berechnen und die Anzahl der Sensoren erhöhen, um die Genauigkeit zu erhöhen:

Quelle: Larry Li Flugzeitkamera - Eine Einführung

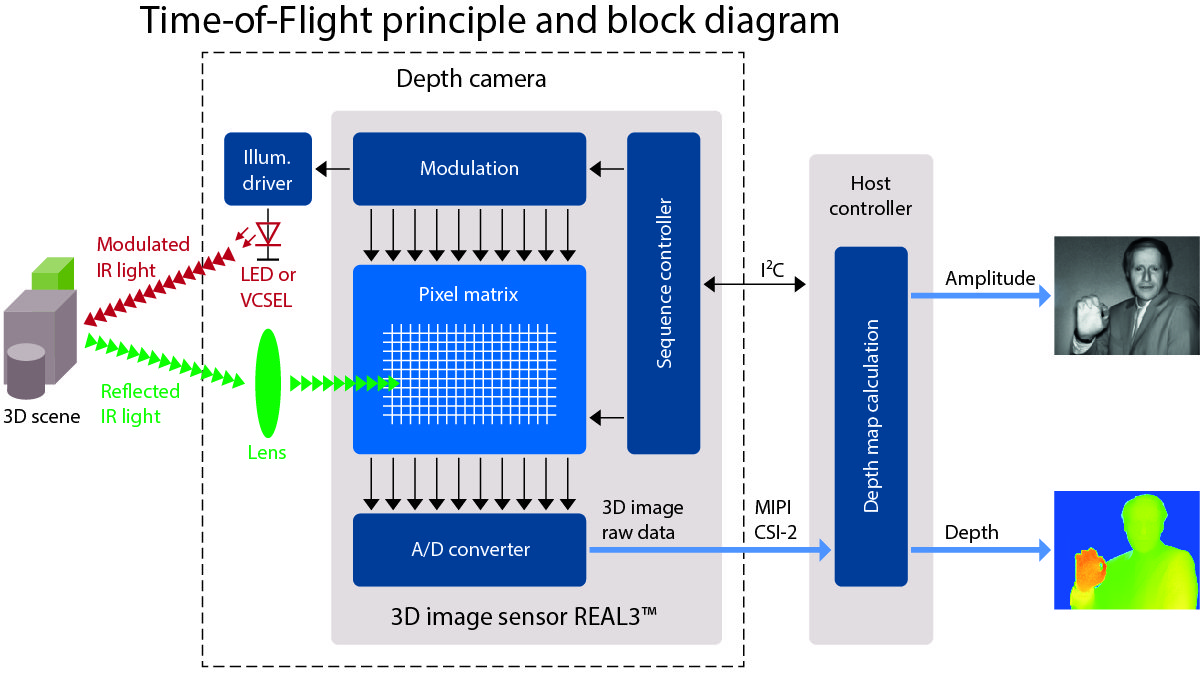

Quelle: Larry Li Flugzeitkamera - Eine EinführungDas Ergebnis ist ein solches Schema der Kamera mit LED- oder seltener Laser (

VCSEL ) -Infrarotbeleuchtung:

Quelle: Eine sehr gute Stellenbeschreibung von ToF bei allaboutcircuits.com

Quelle: Eine sehr gute Stellenbeschreibung von ToF bei allaboutcircuits.comIn diesem Fall wird das Bild mit einer relativ niedrigen Auflösung erhalten (da mehrere Sensoren mit unterschiedlichen Abrufzeiten nebeneinander platziert werden müssen), möglicherweise jedoch mit hoher FPS. Und die Probleme liegen hauptsächlich an den Grenzen von Objekten (was typisch für alle Tiefenkameras ist). Aber ohne die für strukturiertes Licht typischen „Schatten“:

Quelle: Video der Basler AG

Quelle: Video der Basler AGInsbesondere dieser Kameratyp (ToF) hat Google einmal aktiv im

Google Tango- Projekt getestet, das in

diesem Video gut vertreten war. Die Bedeutung war einfach: Die Daten von Gyroskop, Beschleunigungsmesser, RGB-Kamera und Tiefenkamera zu kombinieren und eine dreidimensionale Szene vor dem Smartphone zu erstellen:

Quelle: Googles Projekt Tango ist jetzt für Smartphones ausgelegt

Quelle: Googles Projekt Tango ist jetzt für Smartphones ausgelegtDas Projekt selbst ist nicht gelaufen (meiner Meinung nach war es seiner Zeit etwas voraus), aber es hat wichtige Voraussetzungen geschaffen, um eine Welle des Interesses an AR - Augmented Reality - zu erzeugen und dementsprechend Sensoren zu entwickeln, die damit arbeiten können. Jetzt

fließen alle seine Erfolge in Googles

ARCore ein .

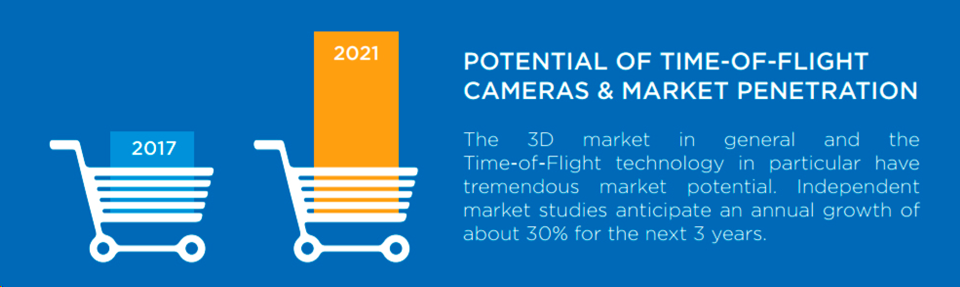

Im Allgemeinen wächst das Marktvolumen von ToF-Kameras alle drei Jahre um etwa 30%, was ein ziemlich exponentielles Wachstum darstellt, und nur wenige Märkte wachsen so schnell:

Quelle: Potenzial von Flugzeitkameras und Marktdurchdringung

Quelle: Potenzial von Flugzeitkameras und MarktdurchdringungEin ernstzunehmender Treiber des heutigen Marktes ist die schnelle (und auch exponentielle) Entwicklung von Industrierobotern, für die ToF-Kameras eine ideale Lösung sind. Wenn Ihr Roboter beispielsweise Kartons verpackt, ist es mit einer normalen 2D-Kamera äußerst untrivial festzustellen, ob Sie anfangen, den Karton zu blockieren. Und für eine ToF-Kamera ist es trivial, sie zu „sehen“ und zu verarbeiten. Und sehr schnell. Infolgedessen sehen wir einen

Boom bei industriellen ToF-Kameras :

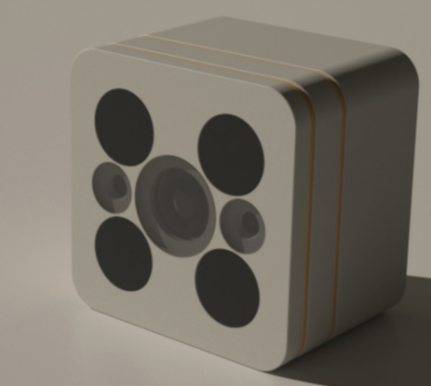

Dies führt natürlich auch dazu, dass hausgemachte Produkte mit Tiefenkameras erscheinen. Zum Beispiel eine Überwachungskamera mit einer Nachtvideoeinheit und einer ToF-Tiefenkamera von der deutschen

PMD Technologies , die seit

mehr als 20 Jahren 3D-Kameras entwickelt:

Quelle: 3D-Flugzeit-Tiefenmessung bringt Magie in die neue Lighthouse Smart Home-Kamera

Quelle: 3D-Flugzeit-Tiefenmessung bringt Magie in die neue Lighthouse Smart Home-KameraErinnerst du dich an den Unsichtbarkeitsumhang, unter dem sich Harry Potter versteckte?

Quelle: Harry Potters Unsichtbarkeitsumhang erhält eine Ursprungsgeschichte und kann bald im wirklichen Leben existieren

Quelle: Harry Potters Unsichtbarkeitsumhang erhält eine Ursprungsgeschichte und kann bald im wirklichen Leben existierenIch befürchte, dass die deutsche Kamera es ein- oder zweimal erkennt. Und es wird schwierig sein, einen Bildschirm mit einem Bild vor eine solche Kamera zu stellen (dies ist kein ablenkender Schutz für Sie):

Quelle: Fragment des Films „Mission Impossible: Phantom Protocol“

Quelle: Fragment des Films „Mission Impossible: Phantom Protocol“Es scheint, dass für die neuen CCTV-Kameras Hogwarts 'nicht-kindische Magie erforderlich sein wird, um sie mit einer ToF-Tiefenkamera auszutricksen, die ein solches Video in völliger Dunkelheit aufnehmen kann:

Das Vorgeben, eine Wand, ein Bildschirm und andere Möglichkeiten zu sein, sich vor der Tatsache zu schützen, dass die kombinierte ToF + RGB-Kamera einen Fremdkörper erkennt, wird technisch schwieriger.

Eine weitere massive friedliche Anwendung für Tiefenkameras ist die Gestenerkennung. In naher Zukunft erwarten Sie Fernseher, Konsolen und Staubsaugerroboter, die nicht nur Sprachbefehle als intelligente Lautsprecher wahrnehmen können, sondern auch das nachlässige „Clean it!“ mit einer Handbewegung. Dann wird die Fernbedienung (auch bekannt als faul) des Smart-TV völlig unnötig und Science-Fiction wird zum Leben erweckt. Infolgedessen wurde das, was

2002 fantastisch war, 2013 experimentell und schließlich

2019 seriell (obwohl die Leute nicht wissen werden, dass sich eine Tiefenkamera im Inneren befindet,

welchen Unterschied macht es, wie funktioniert diese Magie? ):

Quelle: Artikel , Experimente und Produkt

Quelle: Artikel , Experimente und ProduktUnd das gesamte Anwendungsspektrum ist natürlich noch breiter:

Quelle: Video von Tiefensensoren von Terabee (übrigens, welche Art von Mäusen laufen sie für 2 und 3 Videos auf dem Boden? Sehen Sie sie? Nur ein Scherz, es liegt Staub in der Luft - eine Gebühr für die geringe Größe des Sensors und die Nähe der Lichtquelle zum Sensor)

Quelle: Video von Tiefensensoren von Terabee (übrigens, welche Art von Mäusen laufen sie für 2 und 3 Videos auf dem Boden? Sehen Sie sie? Nur ein Scherz, es liegt Staub in der Luft - eine Gebühr für die geringe Größe des Sensors und die Nähe der Lichtquelle zum Sensor)Übrigens - in den berühmten "Läden ohne Kassierer" von Amazon Go gibt es auch viele Kameras unter der Decke:

Quelle: Im überwachungsbetriebenen Supermarkt von Amazon ohne Kasse

Quelle: Im überwachungsbetriebenen Supermarkt von Amazon ohne KasseDarüber hinaus schreibt

TechCrunch :

„Sie werden durch separate Tiefenerkennungskameras (unter Verwendung einer Flugzeittechnik , wie ich von Kumar verstanden habe) ergänzt, die wie die anderen in den Hintergrund passen, alle mattschwarz.“ Das heißt, das Wunder, aus welchem Regal der Joghurt entnommen wird, wird unter anderem von den mysteriösen schwarz-matten ToF-Kameras bereitgestellt (eine gute Frage, sind sie auf dem Foto):

Leider sind direkte Informationen oft schwer zu finden. Aber es gibt eine indirekte. Zum Beispiel gab es eine Firma

Softkinetic , die seit 2007 ToF-Kameras entwickelt. 8 Jahre später wurden sie

von Sony gekauft (das übrigens bereit ist, neue Märkte unter der Marke

Sony Depthsensing zu erobern). Einer der

besten Softkinetic-

Mitarbeiter arbeitet jetzt nur noch bei Amazon Go. So ein Zufall! Innerhalb von ein paar Jahren, wenn die Technologie eingeführt und die Hauptpatente angemeldet werden, werden die Details höchstwahrscheinlich bekannt gegeben.

Nun, wie immer entzünden sich die Chinesen.

Pico Zense zum Beispiel präsentierte auf der CES 2019 eine sehr beeindruckende Reihe von ToF-Kameras, auch für den Außenbereich:

Sie versprechen überall eine Revolution. LKWs werden durch automatisiertes Laden dichter beladen, Geldautomaten werden sicherer, durch Tiefenkameras in jedem wird die Navigation von Robotern einfacher und genauer, Menschen (und vor allem Kinder!) Werden im Stream um eine Größenordnung besser gezählt, neue Fitness-Simulatoren werden erscheinen. C. die Fähigkeit, die Richtigkeit der Übungen ohne einen Ausbilder zu kontrollieren, und so weiter und so fort. Natürlich sind billige chinesische Kameras einer neuen Generationstiefe bereits bereit für all diese Pracht. Nehmen Sie und bauen Sie ein!

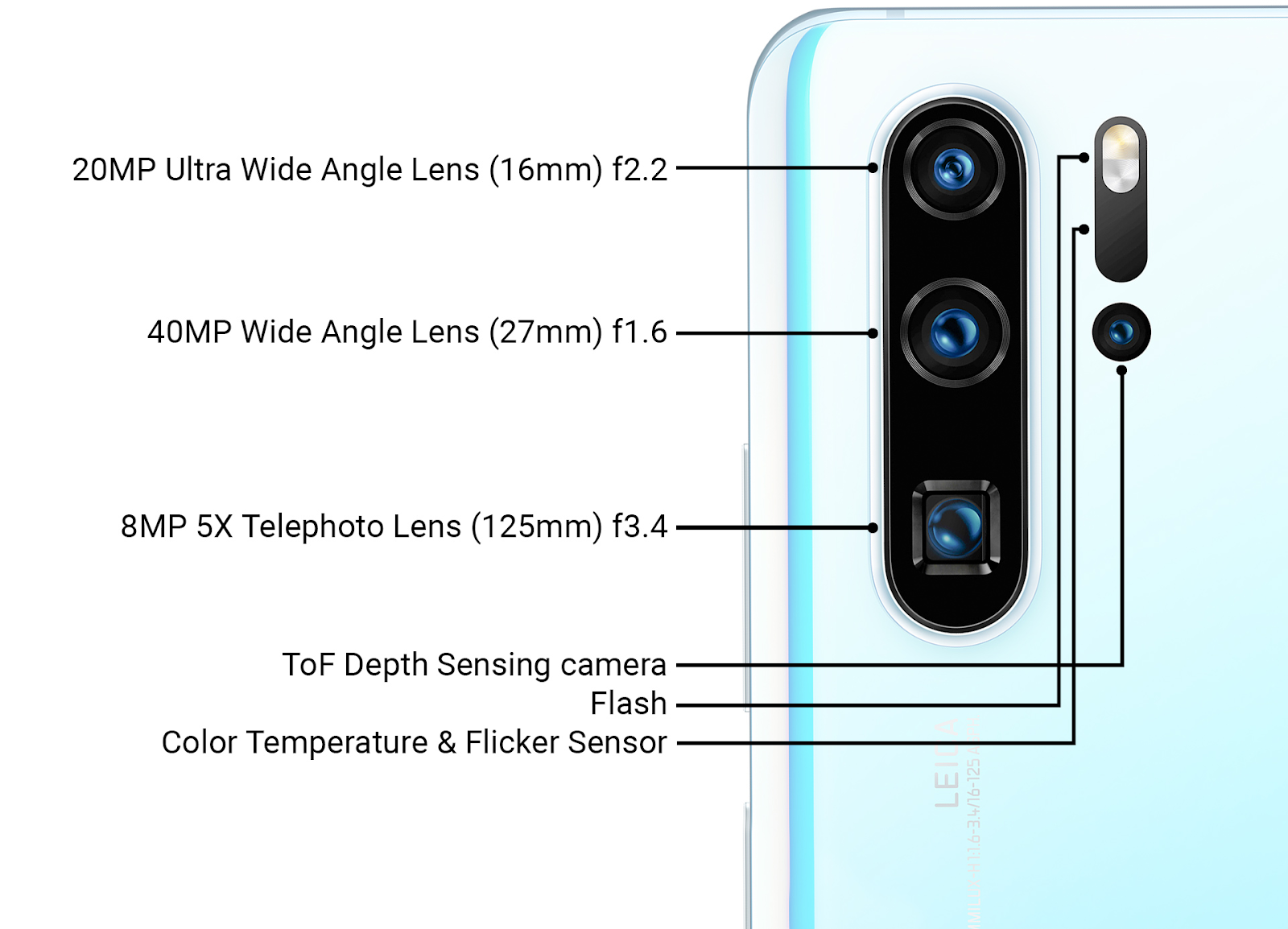

Interessanterweise verfügt das neueste serielle Huawei P30 Pro über einen ToF-Sensor neben den Hauptkameras, d. H. Das langmütige Huawei ist besser in der Lage, Apple dazu zu bringen, frontal strukturierte Lichtsensoren herzustellen, und anscheinend hat Google (Project Tango, das

geschlossen wurde ) erfolgreicher eine Kamera neben den wichtigsten ToF-Kameras implementiert:

Quelle: Ars Technica Huawei neuer Technologiebericht Ende März 2019

Quelle: Ars Technica Huawei neuer Technologiebericht Ende März 2019Details der Verwendung werden natürlich nicht bekannt gegeben, aber zusätzlich zur Beschleunigung der Fokussierung (die für die drei Hauptkameras mit unterschiedlichen Objektiven wichtig ist) kann dieser Sensor verwendet werden, um die Qualität der Unschärfe des Hintergrunds von Fotos zu verbessern (Simulation einer geringen

Schärfentiefe ).

Es ist auch offensichtlich, dass die nächste Generation von Tiefensensoren neben den Hauptkameras in AR-Anwendungen verwendet wird, wodurch die Genauigkeit des AR vom aktuellen „coolen, aber häufig fehlerhaften“ auf ein Massenarbeitsniveau erhöht wird. Angesichts der chinesischen Erfolge ist die große Frage natürlich, inwieweit Google revolutionäre chinesische Hardware in

ARCore unterstützen

möchte . Patentkriege können den Technologiemarkt erheblich verlangsamen. Die Entwicklung dieser dramatischen Geschichte werden wir in den nächsten zwei Jahren buchstäblich sehen.

Zwischensummen

Vor ungefähr 25 Jahren, als die ersten automatischen Türen auftauchten, habe ich persönlich beobachtet, wie respektable Onkel vor solchen Türen regelmäßig beschleunigten. Erfolgreich zu öffnen oder hat keine Zeit? Sie ist groß, schwer, Glas! Ungefähr das Gleiche habe ich kürzlich bei einer Tour durch angesehene Professoren in einer automatischen Fabrik in China beobachtet. Sie blieben etwas hinter der Gruppe zurück, um zu sehen, was passieren würde, wenn Sie am Roboter stehen, friedlich Teile tragen und unterwegs eine ruhige, angenehme Melodie spielen würden. Auch ich bereue, konnte nicht widerstehen ... Weißt du, es hört auf! Vielleicht reibungslos. Vielleicht als toter Mann. Tiefensensoren funktionieren!

Quelle: Auf dem neuen Campus von Huawei Technology

Quelle: Auf dem neuen Campus von Huawei TechnologyDas Hotel arbeitete auch als Reinigungsroboter, was ungefähr so aussah:

Gleichzeitig wurden sie in der Fabrik stärker gemobbt als Roboter. Natürlich nicht so hart wie im

Unmenschlichen in jeder Hinsicht von

Bosstown Dynamics . Aber ich persönlich habe beobachtet, wie sie auf der Straße aufgestanden sind, der Roboter hat versucht, eine Person zu umgehen, die Person hat sich bewegt und die Straße blockiert ... Eine Art Katz und Maus. Im Allgemeinen scheint es so zu sein, dass unbemannte Fahrzeuge, wenn sie auf den Straßen auftauchen, zum ersten Mal häufiger als gewöhnlich geschnitten werden ... Oh, Leute-Leute ... Hmmm ... Wir waren jedoch abgelenkt.

Zusammenfassung der wichtigsten Punkte:

- Aufgrund eines anderen Funktionsprinzips können wir die Lichtquelle in der ToF-Kamera so nah wie möglich am Sensor positionieren (auch unter demselben Objektiv). Darüber hinaus verfügen viele Industriemodelle über LEDs, die sich um den Sensor befinden. Infolgedessen werden die „Schatten“ auf der Tiefenkarte radikal reduziert oder verschwinden sogar. Das heißt, Vereinfachte Arbeit mit komplexen Geometrieobjekten, was für Industrieroboter wichtig ist.

- Da die gepulste Beleuchtung in der Regel Infrarot bleibt, bleiben alle im letzten Abschnitt beschriebenen Nachteile der Infrarotkamera erhalten: Sonneneinstrahlung, Schwierigkeiten, wenn zwei Kameras nebeneinander arbeiten usw. Industrieroboter arbeiten jedoch häufig in Innenräumen, und Kameras mit Laserbeleuchtung werden entwickelt.

- Leider ist es für ToF-Sensoren schwieriger, die allgemeine Verbesserung der Sensoren von RGB-Kameras zu erfassen. Daher ist ihre Entwicklung langsamer, aber überraschenderweise gibt es SEHR viele Neuigkeiten über die Einführung von ToF-Kameras, und es gibt nichts (die nur die Integration von Sensoren in Smartphones angekündigt haben) Samsung, Google Pixel und Sony Xperia ...).

- Das neue Sony-Versprechen, dass 2 von 8 Telefonkameras (!!!) ToF-Tiefenkameras (!) Sein werden, d. H. Tiefenkameras befinden sich auf beiden Seiten des Telefons:

Quelle: Hexa-Cam Sony-Handy erhält Kamera-Spezifikationen enthüllt

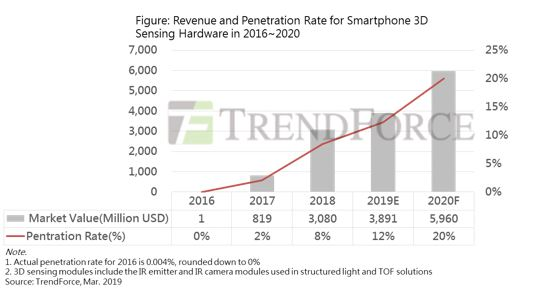

- Infolgedessen werden wir auch im kommenden Jahr viele interessante Dinge in diesem Bereich finden! Und nächstes Jahr werden bis zu 20% der neuen Telefone mit Tiefenkameras (Structured Light + ToF) ausgestattet sein. Angesichts der Tatsache, dass 2017 nur Apple mit „30.000 Punkten“ in hervorragender Isolation auf dem Markt war und jetzt nicht weniger als 300.000 Punkte setzen, ist das Thema eindeutig gut gelaufen:

Quelle: Begrenztes Wachstum des Marktes für Smartphone-3D-Sensorik im Jahr 2019; Apple wird 2020 der wichtigste Wachstumsförderer sein

Zweifelst du immer noch an der anhaltenden Revolution?

Dies war der erste Teil! Ein allgemeiner Vergleich wird im zweiten sein.

Warten Sie in der nächsten Serie:

- Methode 3, klassisch: Tiefe der Stereoanlage;

- Methode 4, neu gefangen: Tiefe aus der Plenoptik;

- Methode 5, schnell wachsend: Lidare, einschließlich Festkörperlidare;

- Einige Probleme bei der Verarbeitung von Videos mit Tiefe;

- Und zum Schluss ein kurzer Vergleich aller 5 Methoden und allgemeine Schlussfolgerungen.

Karthago muss kaputt sein ... Das ganze Video wird bis Ende des Jahrhunderts dreidimensional sein!Bleib dran! (Wenn ich genug Zeit habe, werde ich bis Ende des Jahres neue Kameras beschreiben, einschließlich Tests von frischem Kinect.)

Teil 2DanksagungIch möchte mich herzlich bedanken bei:

- Labor für Computergrafik VMK Moscow State University MV Lomonosov für seinen Beitrag zur Entwicklung der Computergrafik in Russland im Allgemeinen und für die Arbeit mit Tiefenkameras im Besonderen,

- Microsoft, Apple, Huawei und Amazon für kamerabasierte Produkte mit großer Tiefe,

- Texel für die Entwicklung russischer Hightech-Produkte mit Tiefenkameras,

- persönlich Konstantin Kozhemyakov, der viel getan hat, um diesen Artikel besser und visueller zu machen,

- und schließlich vielen Dank an Roman Kazantsev, Eugene Lyapustin, Egor Sklyarov, Maxim Fedyukov, Nikolai Oplachko und Ivan Molodetsky für eine große Anzahl vernünftiger Kommentare und Korrekturen, die diesen Text viel besser gemacht haben!